基于深度學(xué)習(xí)的非合作目標(biāo)裝配位姿視覺檢測

葉晗鳴,蘇 寧,王逍遙

(1. 北京航空航天大學(xué) 機(jī)械工程及其自動(dòng)化學(xué)院,北京 100191;2. 江南造船(集團(tuán))有限責(zé)任公司,上海 201913)

0 引言

隨著數(shù)字化相關(guān)技術(shù)的快速發(fā)展,數(shù)字化裝配技術(shù)憑借其智能、高效、高精度的特點(diǎn),在工業(yè)領(lǐng)域的應(yīng)用日益廣泛[1]。目前針對(duì)數(shù)字化裝配過程中的目標(biāo)位姿測量問題,主要的測量手段包括使用全站儀、激光跟蹤儀等大型測量設(shè)備進(jìn)行測量和機(jī)器視覺位姿測量兩種。其中,使用全站儀、激光跟蹤儀等大型測量設(shè)備進(jìn)行測量的目標(biāo)位姿測量方法,測量范圍大,測量精度高,但均為接觸式測量方法,需要為此設(shè)計(jì)工裝以固定靶球,并在待測部件上安置工裝[2-3],方法較為繁雜,且會(huì)對(duì)裝配過程造成一定的干擾,同時(shí)測量過程操作復(fù)雜,難以實(shí)現(xiàn)實(shí)時(shí)測量。而屬于非接觸測量的機(jī)器視覺位姿測量方法,以其系統(tǒng)結(jié)構(gòu)簡單,測量過程操作方便,實(shí)時(shí)性強(qiáng)的特點(diǎn),被廣泛應(yīng)用于各種工業(yè)裝配過程的實(shí)時(shí)裝配測量中[4]。

根據(jù)位姿測量過程中是否使用人工靶標(biāo)進(jìn)行劃分,機(jī)器視覺位姿測量可以分為合作目標(biāo)位姿檢測[5]和非合作目標(biāo)位姿檢測[6]。合作目標(biāo)檢測通過視覺測量單元識(shí)別人工設(shè)計(jì)靶標(biāo)解算相對(duì)位姿,而非合作目標(biāo)位姿檢測,通過解析物體的自然特征,給出相對(duì)位姿估計(jì)結(jié)果。合作目標(biāo)位姿測量的精度一般較高,需要的圖像處理算法也較為簡單,但在機(jī)器人自動(dòng)化裝配等復(fù)雜裝配場景下,由于場景復(fù)雜,裝配空間有限,并不一定具備安裝人工靶標(biāo)的條件。在這種情況下,非合作目標(biāo)位姿測量成為機(jī)器視覺位姿測量的最佳選擇。

傳統(tǒng)的非合作目標(biāo)位姿視覺檢測方法大多依賴于圖像處理算法對(duì)物體自身低層次特征的提取效果,一般首先需要提取圖像中的低層次特征,如圖像邊緣點(diǎn)、角點(diǎn)、直線等顯著特征,再根據(jù)特征點(diǎn)自身的性質(zhì)構(gòu)造不同的特征描述子,對(duì)特征描述子進(jìn)行匹配,在根據(jù)計(jì)算機(jī)視覺多視圖幾何的原理,解算目標(biāo)的相對(duì)位姿。如P,David等人[7]將直線匹配問題和位姿問題有機(jī)結(jié)合,建立一個(gè)全局目標(biāo)函數(shù)來解決位姿估計(jì)問題;張政等人[8]參照點(diǎn)特征的正交迭代方法,提出直線特征的位姿估計(jì)正交迭代方法求解目標(biāo)位姿;Markus Ulrich[9]等通過獲取目標(biāo)物體 CAD不同姿態(tài)下的成像以建立模板庫,然后將待測圖像與模板進(jìn)行相似性匹配獲取目標(biāo)位姿;桂陽[10]將目標(biāo)的三維模型投影生成不同姿態(tài)下的二維圖像,計(jì)算圖像中目標(biāo)輪廓的 MSA 矩,利用距離圖迭代最小二乘法得到最終的位姿參數(shù)。但是,依賴于圖像處理算法非合作目標(biāo)位姿視覺檢測方法往往魯棒性不足,其具體算法實(shí)現(xiàn)與物體結(jié)構(gòu)、顏色等相關(guān),因此在實(shí)現(xiàn)上需對(duì)某種或某類物體定制算法,方法的普適性、泛化能力相對(duì)較低。當(dāng)待檢測目標(biāo)處于復(fù)雜背景或光照情況多變時(shí),難以實(shí)現(xiàn)對(duì)特征的準(zhǔn)確提取[11]。如何在復(fù)雜裝配場景下,實(shí)現(xiàn)對(duì)非合作目標(biāo)特征的精確提取,成為相關(guān)研究人員研究的重點(diǎn)。

近年來,深度學(xué)習(xí)技術(shù)以其數(shù)據(jù)驅(qū)動(dòng)、魯棒性較強(qiáng)、擬合能力強(qiáng)大、適用場景多樣的特點(diǎn)在機(jī)器視覺領(lǐng)域的應(yīng)用愈加廣泛,并在圖像分類、目標(biāo)檢測、目標(biāo)跟蹤等領(lǐng)域取得了良好的效果。相比于傳統(tǒng)圖像處理算法,基于深度學(xué)習(xí)的視覺算法模型能夠提取圖像中高層次的語義特征,受背景條件或光照情況的影響較小,更適用于復(fù)雜裝配場景中待裝配目標(biāo)的特征提取。為探究深度學(xué)習(xí)技術(shù)在視覺位姿檢測中的應(yīng)用,本文提出了一種基于深度學(xué)習(xí)的裝配位姿非合作目標(biāo)視覺檢測方法。利用SingleshotPose深度學(xué)習(xí)模型對(duì)待裝配目標(biāo)的軸對(duì)齊包圍盒特征點(diǎn)的像素坐標(biāo)進(jìn)行估計(jì),再結(jié)合Opencascade軟件對(duì)目標(biāo)數(shù)字模型的軸對(duì)齊包圍盒特征點(diǎn)在目標(biāo)坐標(biāo)系下三維坐標(biāo)的求解結(jié)果,進(jìn)行PnP求解,得到裝配目標(biāo)坐標(biāo)系相對(duì)于相機(jī)坐標(biāo)系的位姿關(guān)系,進(jìn)而實(shí)現(xiàn)在裝配坐標(biāo)系下對(duì)目標(biāo)位姿的實(shí)時(shí)檢測。

1 基于深度學(xué)習(xí)的位姿檢測原理

1.1 裝配過程位姿視覺檢測原理

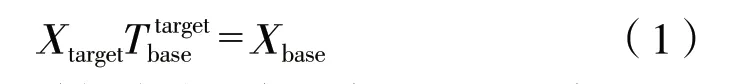

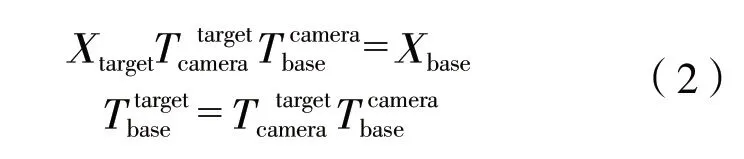

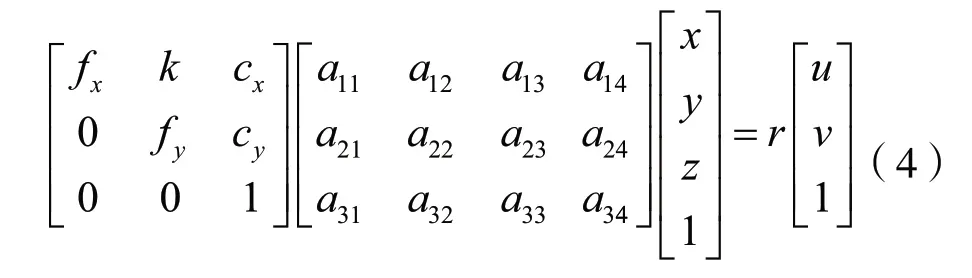

裝配過程中目標(biāo)位姿檢測的目的是得到待裝配目標(biāo)上裝配關(guān)鍵點(diǎn)在指定的裝配過程基坐標(biāo)系下的坐標(biāo)后執(zhí)行后續(xù)裝配操作,也即求得位姿轉(zhuǎn)換矩陣,使得下式成立:

式中Xtarget為裝配關(guān)鍵點(diǎn)在目標(biāo)坐標(biāo)系下的坐標(biāo)Xbase為裝配關(guān)鍵點(diǎn)在基坐標(biāo)系下的坐標(biāo)。

根據(jù)相機(jī)成像過程,有:

式中,K為相機(jī)內(nèi)參矩陣,Q為三維坐標(biāo)的齊次化表示形式,r為尺度常量因子,q為二維像素坐標(biāo)的齊次化形式,將上式寫為矩陣形式,即有:

內(nèi)參矩陣K可由內(nèi)參標(biāo)定獲得,則由上式可知,中的12個(gè)未知參數(shù),通過構(gòu)建包含n≥6的3D-2D點(diǎn)對(duì)的PnP問題即可解出,進(jìn)而結(jié)合標(biāo)定得到的,求得,完成對(duì)目標(biāo)位姿的檢測。

因此,解決目標(biāo)位姿視覺檢測問題,關(guān)鍵在于找到n≥6的3D-2D點(diǎn)對(duì)。本方法是通過深度學(xué)習(xí)和數(shù)字模型結(jié)合的手段,找到9對(duì)3D-2D點(diǎn)對(duì),構(gòu)建PnP問題求出,實(shí)現(xiàn)目標(biāo)位姿檢測。

1.2 非合作目標(biāo)位姿視覺檢測方法

在非合作目標(biāo)位姿的估算中,選擇目標(biāo)的特征點(diǎn)構(gòu)建PnP問題,決定了后續(xù)特征提取算法和位姿計(jì)算方法。一般可選擇的特征包括點(diǎn)特征、直線特征、邊緣特征等。由于實(shí)際生產(chǎn)過程中,不同待檢測目標(biāo)的形狀尺寸各不相同,需要使用一種對(duì)不同形狀目標(biāo)都適用的特征,作為進(jìn)行非合作目標(biāo)位姿估算的依據(jù)。為此,本文選擇目標(biāo)物體的軸對(duì)齊包圍盒的8個(gè)角點(diǎn)和1個(gè)中心點(diǎn),作為非合作目標(biāo)特征。

軸對(duì)齊包圍盒采用一個(gè)長方體將物體包圍,長方體的各條棱均與坐標(biāo)系的某個(gè)軸平行,因此稱其為軸對(duì)齊包圍盒。因此,在目標(biāo)坐標(biāo)系下,軸對(duì)齊包圍盒8個(gè)角點(diǎn)的三維坐標(biāo)為:{xmin,ymin,zmin},{xmin,ymin,zmax},{xmin,ymax,zmin},{xmin,ymax,zmax},{xmax,ymin,zmin},{xmax,ymin,zmax},{xmax,ymax,zmin},{xmax,ymax,zmax}:中 心點(diǎn)三維坐標(biāo)為:。

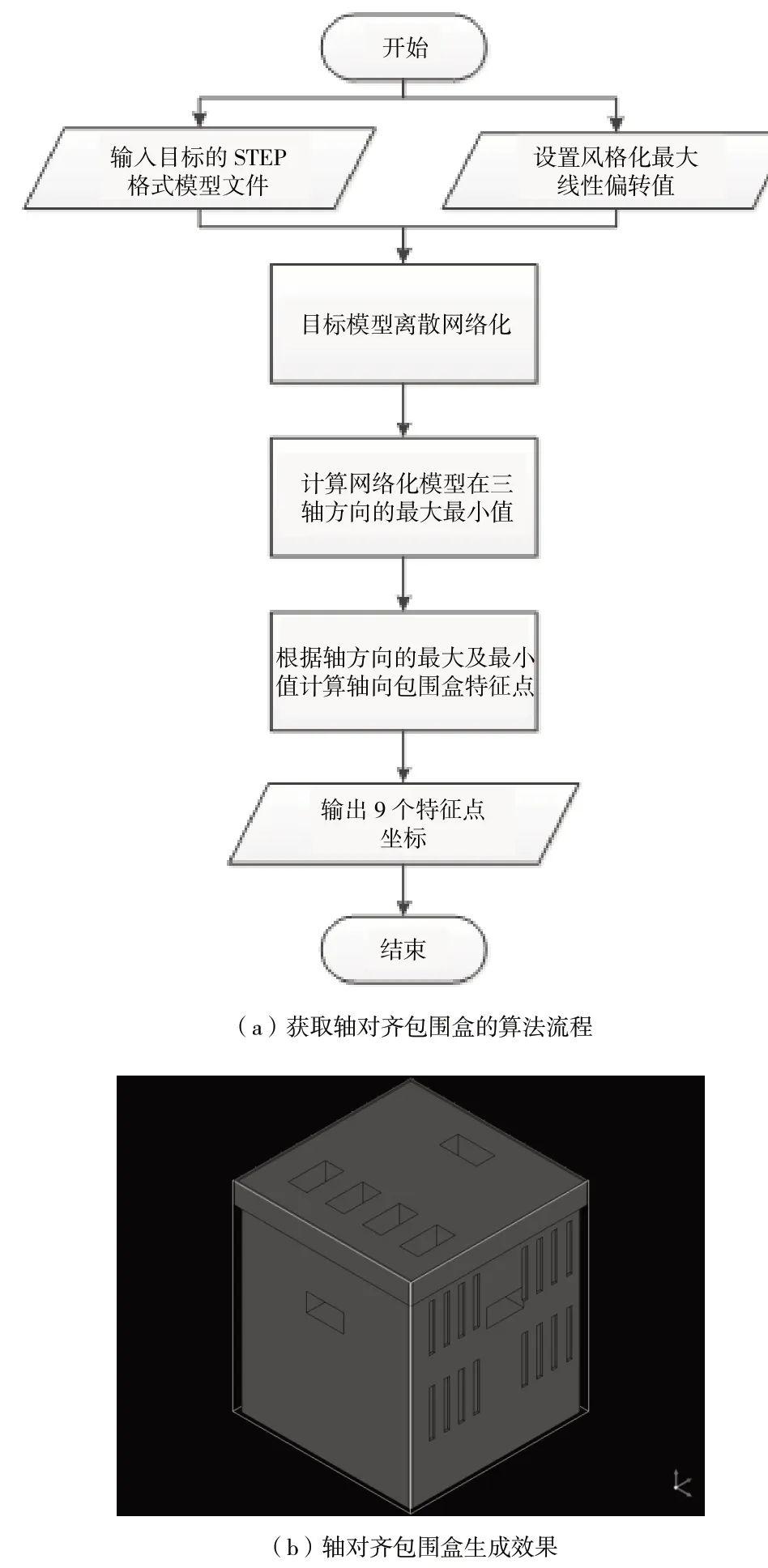

在工業(yè)生產(chǎn)過程中,待檢測目標(biāo)的三維數(shù)字模型一般是可以得到的。通過Opencascade對(duì)目標(biāo)的三維模型進(jìn)行離散網(wǎng)格化,再調(diào)用軸對(duì)齊包圍盒計(jì)算相關(guān)的功能函數(shù),就可精確獲得目標(biāo)坐標(biāo)系下9個(gè)特征點(diǎn)的三維坐標(biāo)。Opencascade獲取軸對(duì)齊包圍盒的算法流程及效果圖像如圖 1所示。

圖1 Opencascade生成軸對(duì)齊包圍盒流程及效果

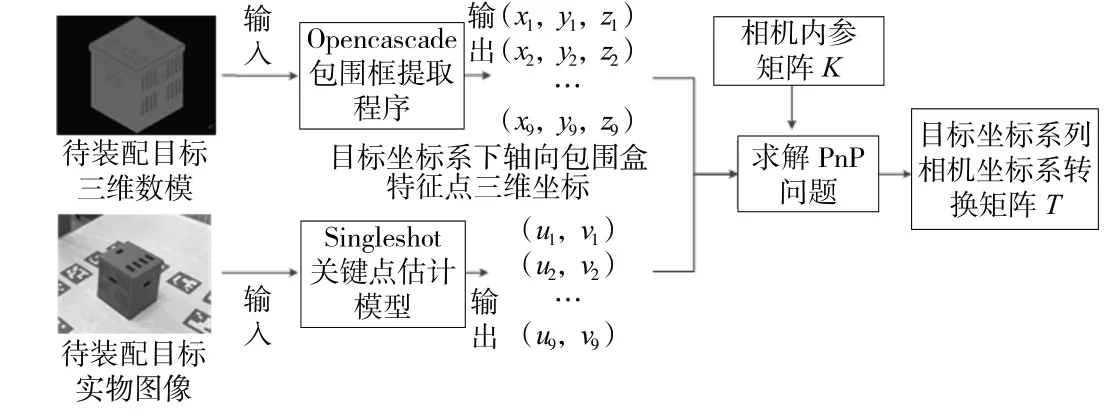

設(shè)目標(biāo)的軸對(duì)齊包圍盒8個(gè)角點(diǎn)及1個(gè)中心點(diǎn)在像素坐標(biāo)系下的坐標(biāo)為{ui,vi},i=1,2,…,9。本文通過SingleShot關(guān)鍵點(diǎn)回歸模型[12]獲取9個(gè)三維特征點(diǎn)在圖像上的對(duì)應(yīng)的二維點(diǎn)坐標(biāo),方法流程如圖 2所示。

圖2 相對(duì)位姿關(guān)系矩陣求取流程

SingleShot關(guān)鍵點(diǎn)回歸模型是在目標(biāo)檢測模型YOLO的基礎(chǔ)上發(fā)展而來的,模型的輸入為RGB圖像,輸出為圖像中物體的類別編碼,以及該物體的軸對(duì)齊包圍盒8個(gè)角點(diǎn)和1個(gè)中心點(diǎn)的二維像素坐標(biāo)。

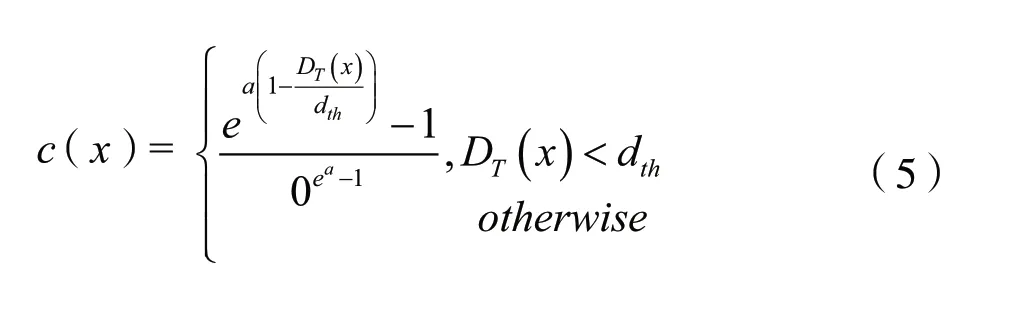

在YOLO網(wǎng)絡(luò)中,由于預(yù)測量為2D包圍盒,因此,采用預(yù)測包圍盒和真實(shí)包圍盒的重疊區(qū)域分?jǐn)?shù)(IoU Score)作為評(píng)判置信概率的標(biāo)準(zhǔn)。由于研究在三維的3D包圍盒的重疊區(qū)域分?jǐn)?shù)難以計(jì)算,極大地影響了訓(xùn)練速度。因此,本文采用如下置信函數(shù):

式中,DT(x)表示預(yù)測的2D點(diǎn)x到其真實(shí)值的歐式距離值,a表示指數(shù)函數(shù)的陡峭程度,dth為閾值。預(yù)測點(diǎn)距離真實(shí)點(diǎn)越近,DT(x)越小,函數(shù)c(x)的值越大,預(yù)測的置信度越高;反之,DT(x)越大,函數(shù)c(x)的值越小。對(duì)所有預(yù)測的2D點(diǎn)都進(jìn)行如上的計(jì)算,取其均值作為該次訓(xùn)練的置信值。當(dāng)DT(x)大于閾值時(shí),令其置信度為0。

在通過SingleShot關(guān)鍵點(diǎn)回歸模型得到物體的3D包圍盒8個(gè)角點(diǎn)和1個(gè)中心點(diǎn)的二維像素坐標(biāo)后,構(gòu)建9對(duì)3D-2D點(diǎn)對(duì)進(jìn)行 PnP求解,即可解得相機(jī)與目標(biāo)之間的相對(duì)位姿關(guān)系矩陣,結(jié)合相機(jī)標(biāo)定的結(jié)果,即可得到代表目標(biāo)位姿的矩陣。

2 非合作目標(biāo)位姿視覺檢測試驗(yàn)

2.1 深度學(xué)習(xí)數(shù)據(jù)集制作

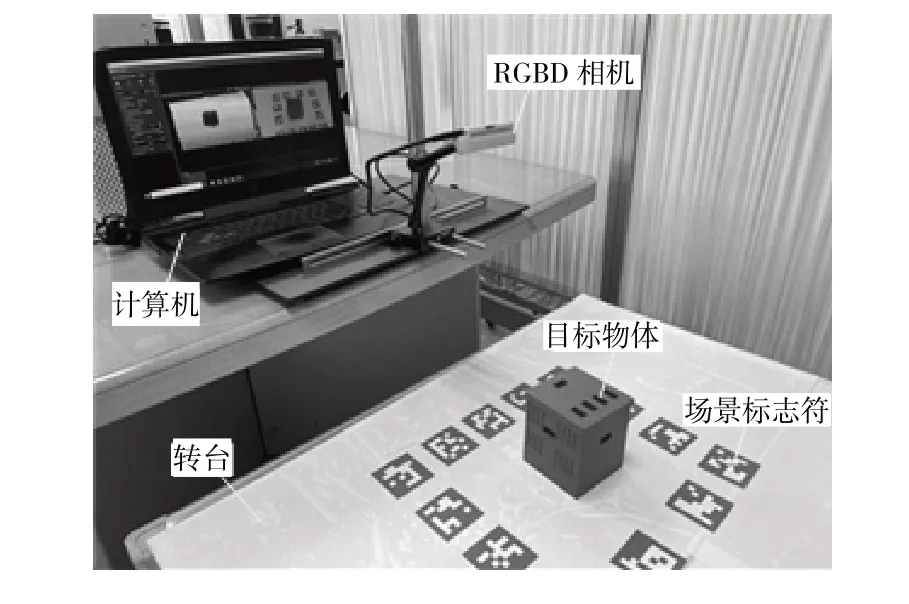

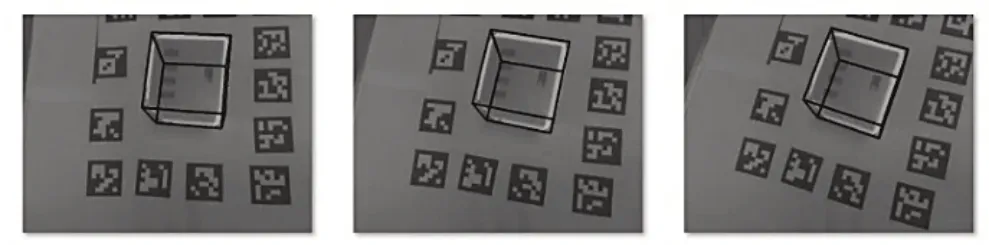

作為數(shù)據(jù)驅(qū)動(dòng)的算法,深度學(xué)習(xí)算法模型需要規(guī)模較大的數(shù)據(jù)集才能達(dá)到理想的算法效果。考慮到人工制作標(biāo)注SingleShot關(guān)鍵點(diǎn)回歸模型數(shù)據(jù)集不僅費(fèi)時(shí)費(fèi)力,而且難以保證特征點(diǎn)標(biāo)注的準(zhǔn)確性,本文設(shè)計(jì)了一種自動(dòng)化的標(biāo)注方法,以RGBD相機(jī)采集數(shù)據(jù),通過場景標(biāo)志符的輔助,結(jié)合圖像信息與深度信息,通過算法自動(dòng)標(biāo)注各幀圖像中目標(biāo)物體的軸對(duì)齊包圍盒。本文試驗(yàn)的數(shù)據(jù)集制作實(shí)驗(yàn)場景如圖 3所示。

圖3 SingleShot關(guān)鍵點(diǎn)回歸模型數(shù)據(jù)集采集場景

進(jìn)行數(shù)據(jù)集采集時(shí),首先要在轉(zhuǎn)臺(tái)平板上粘貼場景標(biāo)志(共計(jì)13個(gè)),并將目標(biāo)物體放置中央;將RGBD相機(jī)固定在平板上方,轉(zhuǎn)動(dòng)轉(zhuǎn)臺(tái),采集物體在不同角度的RGB圖像和點(diǎn)云數(shù)據(jù);完成環(huán)繞物體360°的圖像采集之后,改變相機(jī)的俯仰角,重復(fù)以上操作,由此得到目標(biāo)物體在不同視點(diǎn)下的RGBD數(shù)據(jù)。本文試驗(yàn)共計(jì)采集了626組數(shù)據(jù)。

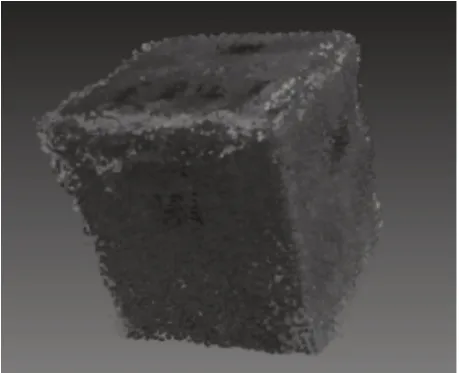

進(jìn)行數(shù)據(jù)集自動(dòng)標(biāo)注時(shí),通過識(shí)別每張圖片中的場景標(biāo)志符,即可解算出各幀圖像相對(duì)于第一幀圖像的位姿變換矩陣。再通過拼接各幀圖像點(diǎn)云,得到第一幀圖像的場景點(diǎn)云,剔除場景點(diǎn)云中多余的點(diǎn),即可得到較為完整的目標(biāo)物體3D點(diǎn)云,如圖 4所示。

圖4 目標(biāo)物體3D點(diǎn)云

根據(jù)目標(biāo)物體目標(biāo)點(diǎn)云,轉(zhuǎn)化為step格式文件,并使用Opencascade求取物體軸對(duì)齊包圍盒角點(diǎn)的三維坐標(biāo)。根據(jù)第一幀圖像中的場景標(biāo)志符,解算出RGBD相機(jī)的內(nèi)參矩陣和在第一幀圖像下的外參矩陣;根據(jù)內(nèi)參矩陣、外參矩陣,將包圍盒角點(diǎn)的三維坐標(biāo)投影為第一幀圖像中的二維像素坐標(biāo);再根據(jù)已知的各幀圖像的位姿變換矩陣,可將軸對(duì)齊包圍盒角點(diǎn)投影至各幀圖像上,得到各幀圖像的標(biāo)注結(jié)果,如圖 5所示。

圖5 軸對(duì)齊包圍盒標(biāo)注效果圖

2.2 深度學(xué)習(xí)模型訓(xùn)練

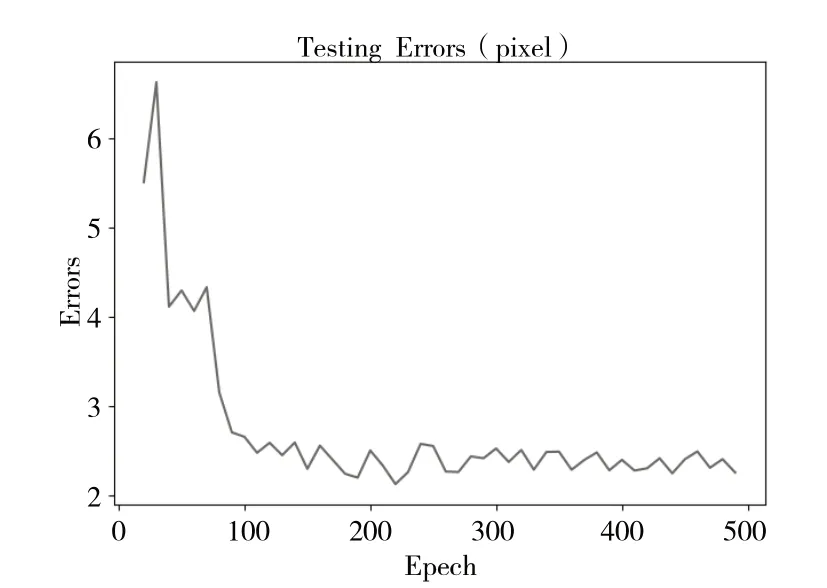

為了對(duì)深度學(xué)習(xí)模型進(jìn)行訓(xùn)練和測試,試驗(yàn)將采集到的數(shù)據(jù)劃分為訓(xùn)練集和測試集,其中訓(xùn)練集包含500組數(shù)據(jù),測試集包含126組數(shù)據(jù)。試驗(yàn)設(shè)置了500個(gè)訓(xùn)練周期,在每個(gè)周期只向SingleShot關(guān)鍵點(diǎn)回歸模型輸入訓(xùn)練集中的樣本進(jìn)行訓(xùn)練,并保存該周期時(shí)SingleShot關(guān)鍵點(diǎn)回歸模型的權(quán)重文件。從第20個(gè)周期開始,每訓(xùn)練10個(gè)周期,在測試集上對(duì)模型效果進(jìn)行測試,通過計(jì)算軸對(duì)齊包圍盒9個(gè)特征點(diǎn)像素坐標(biāo)預(yù)測值與真值的平均像素誤差來對(duì)模型效果進(jìn)行評(píng)估。測試像素誤差曲線如圖 6所示。

圖6 軸對(duì)齊包圍盒特征點(diǎn)坐標(biāo)測試像素誤差

由圖 6可知,自第100個(gè)訓(xùn)練周期后,模型的特征點(diǎn)坐標(biāo)平均像素誤差開始收斂,并在第220個(gè)訓(xùn)練周期時(shí)達(dá)到了最小值,故選擇第220個(gè)訓(xùn)練周期下模型的權(quán)重文件作為時(shí)SingleShot關(guān)鍵點(diǎn)回歸模型最佳權(quán)重,進(jìn)行目標(biāo)位姿檢測試驗(yàn)。

2.3 目標(biāo)位姿檢測試驗(yàn)

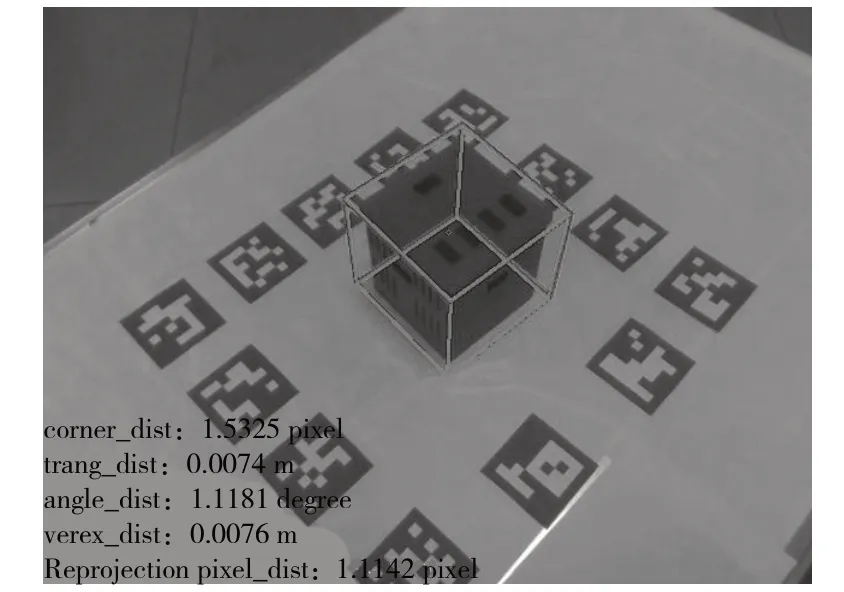

利用訓(xùn)練得到的SingleShot關(guān)鍵點(diǎn)回歸模型最佳權(quán)重,結(jié)合前文所述方法,進(jìn)行目標(biāo)位姿檢測試驗(yàn)。SingleShot關(guān)鍵點(diǎn)回歸模型對(duì)軸對(duì)齊包圍盒特征點(diǎn)的輸出可視化如圖 7所示。其中,綠色框?yàn)檩S對(duì)齊包圍盒8個(gè)角點(diǎn)連接得到的對(duì)軸對(duì)齊包圍盒在像素坐標(biāo)系下的投影。

圖7 SingleShot模型輸出可視化結(jié)果

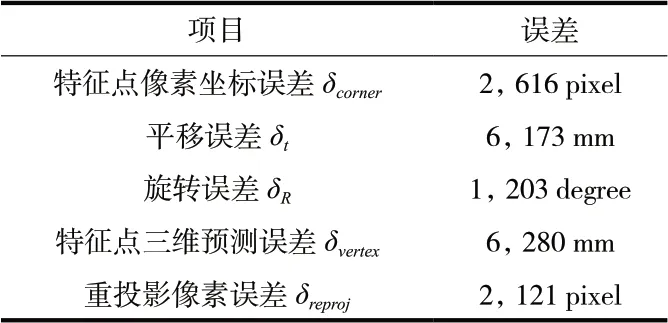

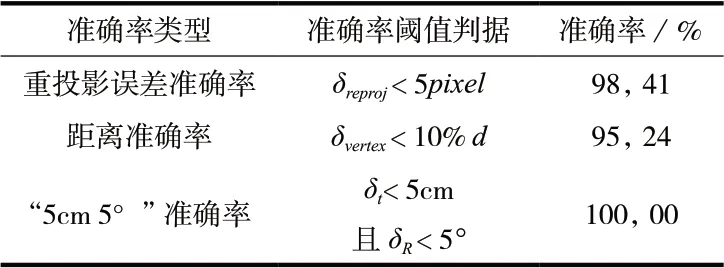

考慮到目標(biāo)裝配位姿視覺檢測過程中,誤差主要來自相機(jī)與目標(biāo)實(shí)時(shí)位姿解算的過程,即對(duì)的估計(jì)過程,而由標(biāo)定得到,誤差一般較小。因此,可從相機(jī)與目標(biāo)相對(duì)位姿估計(jì)誤差和相對(duì)位姿預(yù)測準(zhǔn)確率兩方面評(píng)估的估計(jì)精度,進(jìn)而評(píng)估目標(biāo)位姿檢測的精度。對(duì)測試集數(shù)據(jù)進(jìn)行分析和統(tǒng)計(jì)后,相機(jī)與目標(biāo)相對(duì)位姿平均誤差結(jié)果見表 1,位姿估計(jì)準(zhǔn)確率結(jié)果見表 2。

表 1 測試集相對(duì)位姿估計(jì)平均誤差統(tǒng)計(jì)表

表2 測試集相對(duì)位姿估計(jì)準(zhǔn)確率統(tǒng)計(jì)表

由表 1和表 2可知,在測試集上,本方法的距離準(zhǔn)確率達(dá)到了95.24%。可以認(rèn)為,本方法能夠?qū)δ繕?biāo)與相機(jī)間相對(duì)位姿進(jìn)行較精確的檢測,即保證的精度;進(jìn)而可以認(rèn)為,在標(biāo)定精度得到保證的情況下,本文方法能夠?qū)δ繕?biāo)裝配位姿進(jìn)行較精確的檢測。

3 總結(jié)

本文以非合作目標(biāo)的位姿估計(jì)問題為研究對(duì)象,提出一種基于深度學(xué)習(xí)方法的非合作目標(biāo)相對(duì)位姿估計(jì)方法。本文的主要工作包括:

(1)提出了基于SingleShot關(guān)鍵點(diǎn)估計(jì)模型的非合作目標(biāo)位姿估計(jì)方法,通過SingleShot模型輸出待裝配目標(biāo)軸對(duì)齊包圍盒9個(gè)特征點(diǎn)的二維像素坐標(biāo),再利用Opencascade獲取目標(biāo)軸對(duì)齊包圍盒特征點(diǎn)在目標(biāo)坐標(biāo)系下的三維坐標(biāo),求解PnP問題,得到目標(biāo)和相機(jī)之間的相對(duì)位姿,進(jìn)而完成目標(biāo)在基坐標(biāo)系下的位姿檢測。

(2)設(shè)計(jì)了一種基于RGBD相機(jī)的自動(dòng)化標(biāo)注算法,通過目標(biāo)點(diǎn)云數(shù)據(jù)與三維模型的匹配和坐標(biāo)系轉(zhuǎn)換,實(shí)現(xiàn)對(duì)SingleShot關(guān)鍵點(diǎn)估計(jì)模型所需數(shù)據(jù)集的自動(dòng)標(biāo)注。利用實(shí)驗(yàn)室條件下采集和標(biāo)注的數(shù)據(jù)集,對(duì)本文提出方法進(jìn)行了試驗(yàn)驗(yàn)證。實(shí)驗(yàn)結(jié)果表明,本文方法能夠在一定精度范圍內(nèi)基本滿足位姿估計(jì)需求。

本研究目前仍存在一定不足,深度學(xué)習(xí)模型數(shù)據(jù)需求量較大,且位姿估計(jì)的精度仍有提升空間。未來的研究中,需要對(duì)本方法進(jìn)行優(yōu)化,以盡量小的深度學(xué)習(xí)數(shù)據(jù)集,實(shí)現(xiàn)精度更高的目標(biāo)位姿檢測。