增強可分離卷積通道特征的表情識別研究

梁華剛,雷毅雄

長安大學 電子與控制工程學院,西安 710064

機器視覺是人工智能領域的一個飛速發展的分支,隨著科學技術不斷進步,人臉表情識別(facial expression recognition,FER)技術正在經歷前所未有的發展。人們在日常生活中經常會聽到“表情”這個詞,它是面部肌肉的動作或狀態的結果,是一種非語言交流的形式。面部表情是日常生活中最為重要的一種信息傳遞方式,人們在日常生活中可以通過面部表情進行交流,傳遞大量的信息。當人們面對面交流時,55%的信息是通過面部表情傳遞的[1]。目前人類主要有七種情感:憤怒、高興、悲傷、驚訝、厭惡、恐懼和自然。面部表情識別的研究從未停止過,人臉面部表情識別是人臉識別技術中的重要組成部分,近年來在人機交互、安全、機器人制造、自動化、醫療、通信和駕駛等領域得到了廣泛的關注,成為學術界和工業界的研究熱點。

人臉表情識別主要包括人臉圖像采集、人臉圖像預處理、特征提取和表情識別四個步驟,其中特征提取是最重要的步驟,一個好的特征提取方法可以直接決定人臉面部表情識別的準確率。傳統的人臉表情識別方法主要采用手動提取特征的方式,比如提取表情幾何特征的ASM[2]方法,提取表情邊緣特征的HOG[3]方法和表情紋理特征的LBP[4]方法等,再用SVM[5]進行分類。傳統的人臉表情特征提取方法受人為因素影響識別率不高,而卷積神經網絡面臨大數據樣本時更易訓練,并能提取到人臉表情的高維特征,用在人臉表情識別的特征提取當中可以取得相當不錯的效果。

LeCun等人[6]首次提出第一個真正意義上的卷積神經網絡,并于1998年提出了應用卷積神經網絡的算法解決手寫數字識別的視覺任務。深度卷積神經網絡起源于2012年的AlexNet網絡[7],與以前的卷積神經網絡相比,AlexNet網絡最顯著的特點是層次更深,參數規模更大,使用了新的激活函數修正線性單元(the rectified linear unit,ReLU),并且引入dropout機制。2014年,Simonyan等人[8]提出VGGNet,通過不斷加深網絡來提升性能,證明了深度對模型性能的重要性。隨后Szegedy等人[9]提出GoogleNet模型,不僅增加了網絡模型的深度,還增加了網絡模型的寬度,在沒有增加計算代價的同時反而能提取到更多的特征,從而提升訓練結果。深度卷積神經網絡是一種深度學習方法,也是一種特征學習的方法,可以提取到更深的圖像特征,使得表情識別的準確率也得以提升,已經取得了相當不錯的成果。王建霞等人[10]通過增加卷積神經網絡的深度和寬度來增強特征提取能力,將高層次與低層次的特征進行融合,取得了較好的表情識別效果。杜進等人[11]在網絡結構中引入了殘差學習模塊,目的是解決隨著網絡深度的增加神經網絡出現的退化問題,從而導致表情識別精度下降。呂誨等人[12]使用超級精簡的輕量化網絡,網絡只有66 000個參數,主要是保證網絡的實時性需求。這些方法雖然取得了較好的效果,但也面臨著一些問題:(1)隨著網絡層數的加深,網絡結構的復雜程度也越高,計算代價會越來越昂貴;(2)網絡參數降低后精度卻得不到一定的保證。

因此,本文采用深度學習方法,設計并訓練輕量化的卷積神經網絡表情識別模型,將可以增強特征提取能力的Squeeze-and-Excitation(SE)[13]模塊與深度可分離卷積神經網絡相結合,來減少網絡模型參數,同時更高效地提取人臉表情特征。在網絡結構通道數不同的層加入的SE模塊的壓縮率是不同的,可以更好地將通道間的相關性結合起來,增強特征提取能力。

1 基于深度可分離卷積的表情識別

1.1 卷積神經網絡

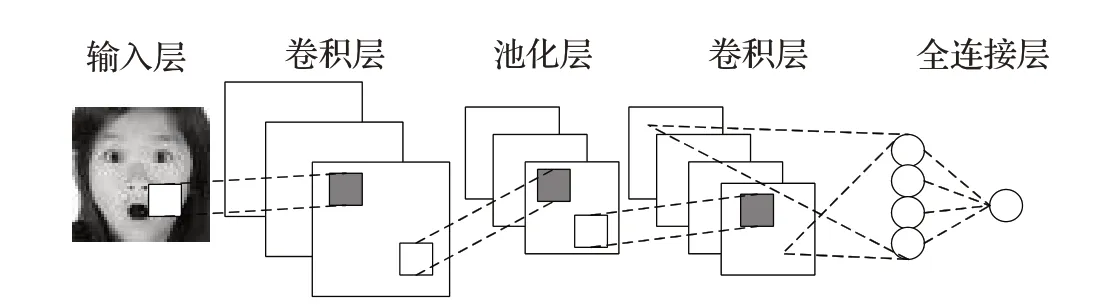

卷積神經網絡(convolutional neural network,CNN)在分類問題中表現優異,對其進行訓練,可以學習到輸入和輸出之間的多層非線性關系。卷積神經網絡的結構一般由卷積層、池化層和全連接層組成,如圖1所示。

圖1 卷積神經網絡結構Fig.1 Structure of convolutional neural network

1.1.1 卷積層

卷積層即卷積操作,在圖像處理中,卷積操作其實就是對一組多維矩陣的不同局部與卷積核每個位置的元素相乘,然后求和,計算表達式如公式(1)所示:

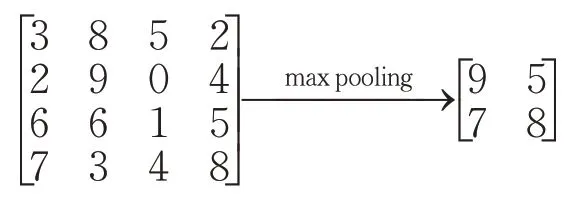

1.1.2 池化層

池化層常見的兩種方式為平均池化和最大池化,即取對應區域的平均值或最大值作為池化后的元素值。例如,對一個4×4的輸入,使用2×2的核進行最大池化操作的過程為:

1.1.3 全連接層

全連接層的每個結點與前一層所有結點進行連接,將前一層所提取到的各個特征結合起來,使網絡學習到的特征圖轉換為一個多維特征向量,送入分類器后可以實現圖像的分類與識別。假設全連接層輸入為X,輸出為Y,計算表達式如公式(2)所示:

式中,Yi表示輸出Y中的元素,Xj表示輸入X中的元素,wij表示權重系數,Q表示輸入X的元素總數,b為偏置。

1.2 深度可分離卷積

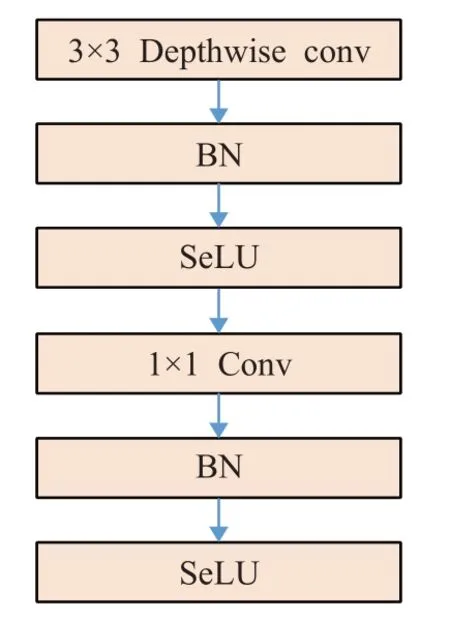

深度可分離卷積實質上將卷積分為兩個階段:深度卷積DW(depthwise convolution)和點卷積PW(pointwise convolution)。DW屬于深度可分離卷積濾波階段,每一個通道上有對應的卷積核進行卷積操作;PW是深度可分離卷積的組合階段,整合多個特征圖信息。深度可分離卷積能夠大幅度減少參數,因而其計算量較傳統卷積大幅縮減,并且在深度卷積和1×1卷積后都增加了BN(batch normalization)[14]層和激活層。深度可分離卷積的結構如圖2所示,BN層用于對數據進行歸一化,以保證每層的數據分布穩定,避免輸入數據的偏移造成的影響。激活層增加了神經網絡各層之間的非線性關系,通過激活函數稀疏后的模型能夠更好地提取相關特征、擬合訓練數據,同時有效地抑制了梯度消失的問題。

圖2 深度可分離卷積結構圖Fig.2 Structure diagram of depthwise separable convolution

1.3 激活函數

激活函數在神經網絡中主要用來解決線性不可分問題,它可以增強神經網絡模型的非線性能力,以及提升網絡模型的學習和表達能力。ReLU激活函數是其中效果比較好的一種,根據公式(3)可看出,首先輸入在正區間內,只有線性關系,可以讓神經網絡的訓練速度提升數倍,不會對模型的泛化產生影響。其次,ReLU的非負區間的梯度為一個常數,所以梯度消失的問題基本上是不存在的,使得模型的收斂速率相對穩定。但是ReLU也有其局限性,由于其函數在負半軸上置0,此操作也稱作單側抑制,使得神經網絡中的神經單元具備了稀疏激活性。但是,隨著訓練的進行,可能會出現神經單元的死亡,相應的參數不再更新的情況,而且ReLU函數的輸出不是以0為中心的。

式中,x是來自上一層神經網絡的輸入向量。

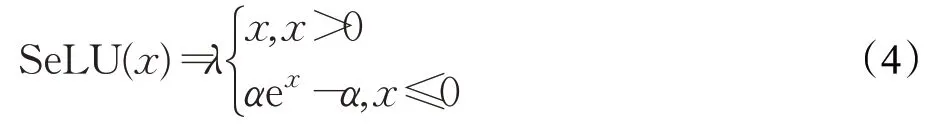

放縮指數線性單元(scaled exponential linear units,SeLU)[15]激活函數就是解決上述問題而產生的,如公式(4),使用該激活函數后可以使得樣本的分布自動地歸一化到零均值和單位方差,并且經過許多層的前向傳播后還是會收斂到零均值和單位方差,即使是存在噪聲和擾動的情況下依然如此。與ReLU函數相比較,在輸入為負數的情況下,此時是有一定的輸出能力的,并且這部分輸出還具備抗干擾的能力。這樣可以解決ReLU神經單元死掉的問題,因此,SeLU函數更有利于訓練多層的深度神經網絡,訓練過程中梯度也不會爆炸或消失。

其中,λ=1.050 700 987 355 480 493 419 334 985 294 6,α=1.673 263 242 354 377 284 817 042 991 671 7。

1.4 Squeeze-and-Excitation

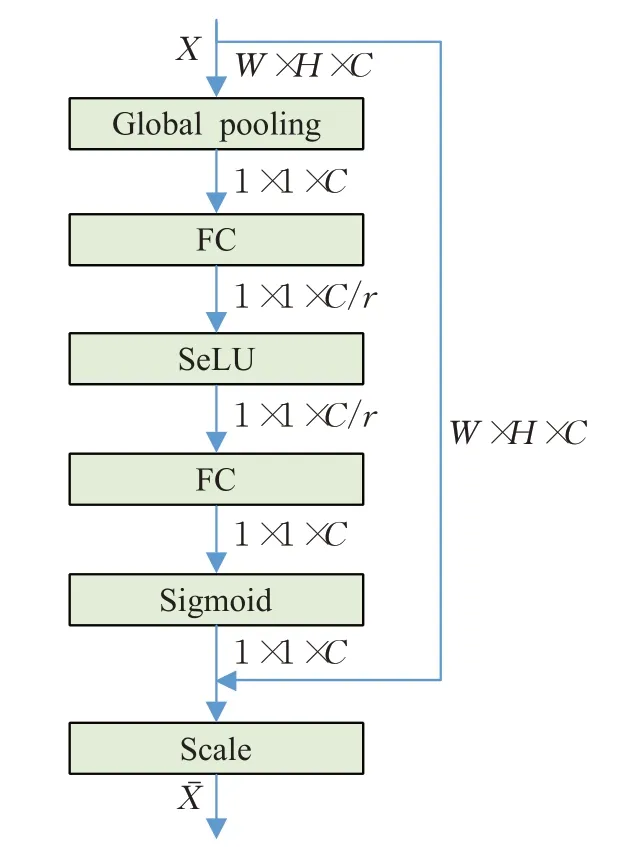

SE模塊是一種基于注意力機制的網絡子結構,是本文網絡結構的核心模塊,它通過對特征通道間的相關性進行建模,把重要通道的特征強化,非重要通道的特征弱化,以此來提升準確率,可以嵌入到各種分類網絡模型當中,增強特征提取層的感受野,提升卷積神經網絡的性能。模塊主要由Squeeze(壓縮)、Excitation(激發)和Scale(加權)三部分構成,當上一層網絡結構輸出一個寬為W、高為H、通道數為C的特征X時,SE模塊可以學習到該特征不同通道的重要性并進行加權,最終輸出一個表征能力更強的特征,SE模塊結構如圖3所示。

圖3 SE模塊結構圖Fig.3 SE module structure diagram

一般來說,卷積神經網絡的每個通道使用的濾波器都在局部感受野上工作,因此每個特征圖不能有效地利用其他特征圖的上下文信息,而且在網絡的較低層次上,其感受野的尺寸都是較小的,這樣情況就會變得糟糕。壓縮操作是首先順著空間維度來進行特征壓縮,使用全局平均池化(global average pooling,GAP)進行壓縮操作,將C個W×H大小的特征圖提取成長度為C的實數列。這個實數列其實是擁有全局的感受野,輸入的特征通道數和輸出的維度是相互對應的。它表征著在特征通道上響應的全局分布,而且使得靠近輸入的層獲得全局的感受野成為可能。緊接著將實數列送入兩個全連接層去建模通道間的相關性,并輸出和輸入特征同樣數目的權重。具體的,首先通過一個全連接層將特征維度降低到輸入的1/r,其中r為壓縮率,然后經過SeLU激活后再通過一個全連接層升回到原始維度。這樣做比直接用一個全連接層的好處在于:(1)非線性度更高,能更好地擬合通道間復雜的相關性;(2)極大地減少了參數量和計算量。然后通過一個Sigmoid的門獲得0到1之間歸一化的權重,最后通過一個Scale的操作來將歸一化后的權重加權到每個通道的特征上。

1.5 網絡架構

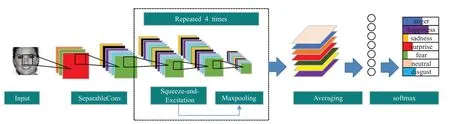

本文提出了一種增強可分離卷積通道特征的表情識別研究方法,網絡框架如圖4所示。將輸入圖像送入卷積層進行一系列卷積操作提取特征后進行分類,為了提取到更好的特征,網絡的結構設計借鑒了Xception[16]網絡結構的輕量化設計思想,在通道數過大的卷積層采取深度可分離卷積取代一部分普通卷積,減少網絡結構參數量。但是與Xception網絡不同的是,本文網絡結構沒有大量堆疊深度可分離卷積,主要是因為在實驗過程中發現堆疊太多深度可分離卷積并沒有對表情識別精度的提升有明顯幫助。此外,對網絡進行改進的同時引入可以增強特征提取能力的SE模塊來高效地提取人臉表情識別特征,在通道數不同的卷積層SE模塊的壓縮率是不同的。

圖4 網絡框架圖Fig.4 Network structure diagram

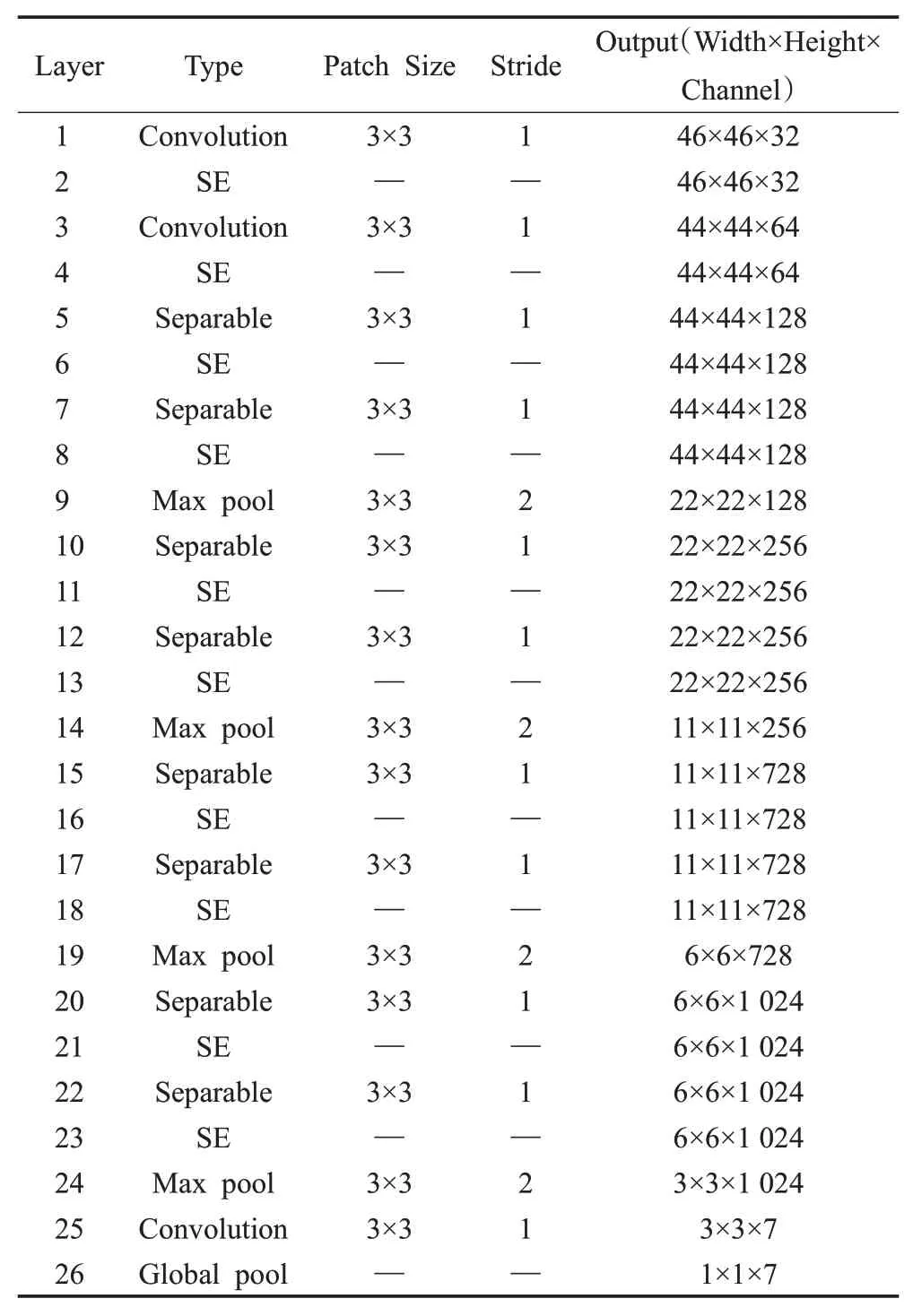

所提網絡結構及詳細參數信息如表1所示。網絡主要由11個卷積層依次相連組成,第3個卷積層至第10個卷積層采用深度可分離卷積,卷積層的所有卷積核大小為3×3,步長為1,初始通道數為64,通道數依次遞增,最高可達1 024個通道。最后接一個全局平均池化,分別累加每個特征圖所有像素值并求平均,得到7個數值,將這7個數值輸入到softmax分類器中,得到7個概率值,即這張圖片屬于每個類別的概率值,用于對七類表情的預測。網絡中的部分卷積層后依次使用批量歸一化、放縮指數線性單元和SE模塊,并且分別在第4、6、8、10個SE模塊后嵌入了窗口大小為3、步長為2的最大池化層。

表1 網絡結構及參數表Table 1 Network structure and parameter table

2 實驗結果及分析

2.1 實驗數據集

本實驗分別采用FER2013[17]表情數據集和The Extended Cohn-Kanade Dataset(CK+)[18]表情數據集進行實驗。

(1)FER2013數據集。該數據集共包含了35 887幅圖像,其中有28 709幅圖像為訓練集,測試集和驗證集分別為3 589幅圖片。每幅圖片是由48×48固定大小的灰度圖像組成,共有7種表情,分別為:憤怒、厭惡、恐懼、高興、悲傷、驚訝和自然。圖5為FER2013表情數據集中部分表情樣例,包含了不同年齡、膚色、性別的人臉表情。

圖5 FER2013數據集部分圖像Fig.5 Partial images of FER2013 dataset

(2)CK+數據集。該數據集總共包含了123個人的593段表情序列,但是有效標注表情的標簽數據只有327個表情序列,本實驗抽取了其中的1 101個比較明顯的圖片,檢測到人臉并且將人臉裁剪到大小固定為48×48的灰度圖像,分為7種表情:憤怒、厭惡、恐懼、高興、悲傷、驚訝和自然。圖6為CK+表情數據集中部分表情樣例,包含了不同種族、膚色、性別的人臉表情。

圖6 CK+數據集部分圖像Fig.6 Partial images of CK+dataset

為了減少訓練過程中的過擬合,在實驗中進行了數據增強處理如圖7所示,具體參數設置如表2所示。其中,“Rotation_range”表示將圖像按順時針或逆時針方向隨機旋轉一定角度;“Rescale”表示隨機縮放圖片;“Shear_range”表示逆時針方向的剪切變換角度;“Zoom_range”表示隨機縮放圖片的幅度;“Horizontal_flip”表示進行隨機水平翻轉圖片;“Fill_mode”表示進行變換時若超出邊界的點,會按照選擇設置的參數進行處理。

圖7 數據增強圖Fig.7 Data augmentation diagram

表2 數據增強參數表Table 2 Data augmentation parameter table

2.2 實驗結果與分析

本文使用Python3.6.5進行實驗,操作系統為Windows 10,硬件平臺為英特爾Core i9-9820X CPU,內存為32 GB,GPU為11 GB的NVIDIA GeForce RTX 2080 Ti。網絡的batch為32,初始學習率為0.1,如果驗證損失在10輪內都沒有改善,則按照10倍的速率將學習率降低,最低降為0.000 1,采用交叉熵損失函數,并在實驗中用Adam優化器優化訓練過程。

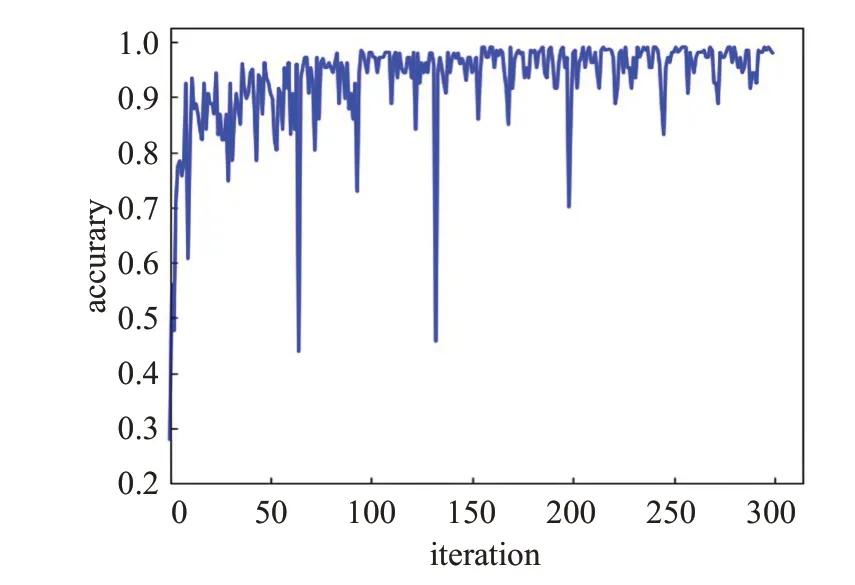

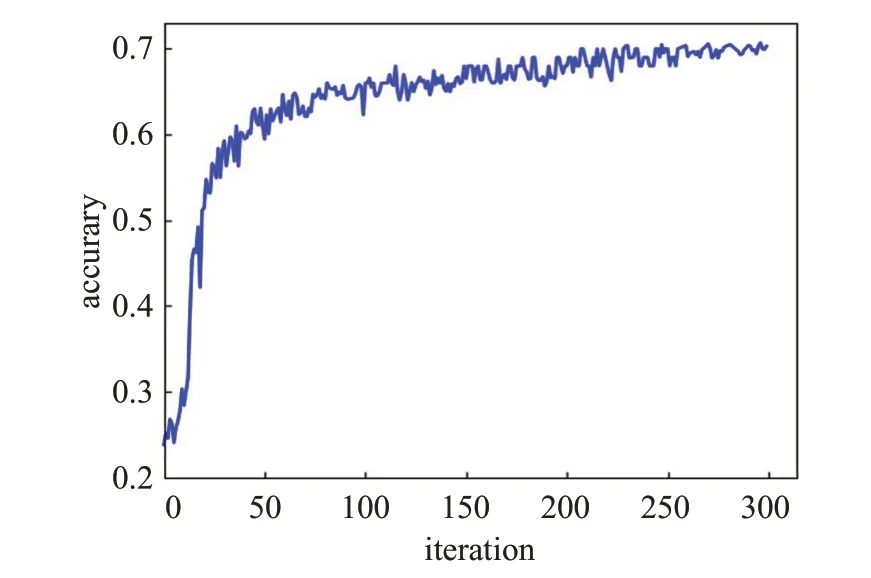

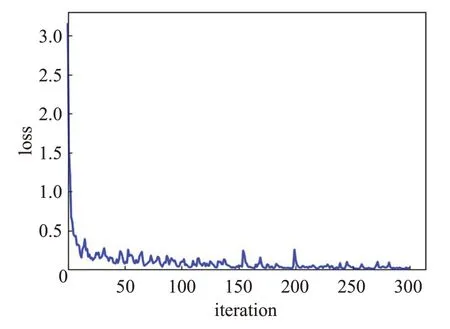

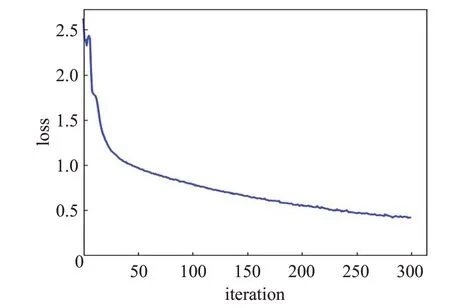

圖8和圖9分別為CK+和FER2013數據集上的準確率迭代收斂曲線,圖10和圖11分別為CK+和FER2013數據集上的損失函數迭代收斂曲線。

圖8 CK+準確率曲線圖Fig.8 CK+accuracy curve

圖9 FER2013準確率曲線圖Fig.9 FER2013 accuracy curve

圖10 CK+損失曲線圖Fig.10 CK+loss curve

圖11 FER2013損失曲線圖Fig.11 FER2013 loss curve

網絡在CK+數據集上得到的最終準確率為98.95%,在FER2013數據集上得到的最終準確率為70.30%。由準確率迭代收斂曲線圖可以看出,隨著迭代次數的增加,準確率逐漸上升,雖然迭代過程中會產生一些波動變化,但是總體是趨于穩定收斂狀態的。由損失函數迭代收斂曲線圖可以看出,在迭代過程中損失值會逐漸下降,最終收斂到一個接近于0的值,并保持穩定狀態。

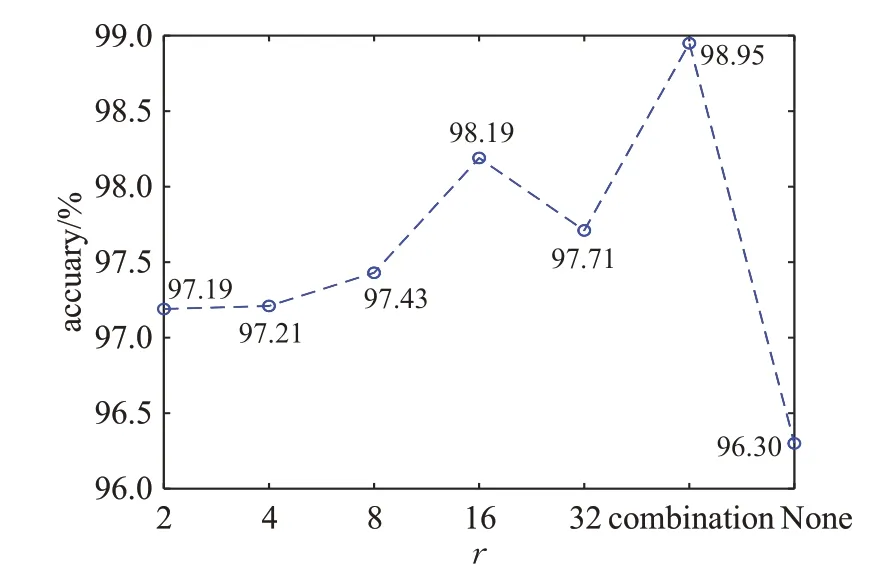

2.2.1 壓縮率對比實驗

本文引入了SE模塊來提高人臉表情識別精度,選擇不同的壓縮率r可以使得模塊具有不同效果的通道加權能力。實驗中分別將壓縮率r設置為2,4,8,16,32,與本文所提出的在網絡結構的不同層采用不同的壓縮率進行對比實驗,實驗結果如圖12和圖13所示,combination代表本文方法,None代表在網絡結構中不加入SE模塊。可以看到引入SE模塊會提高表情識別準確率,且本文方法效果優于所有模塊使用同一個壓縮率。

圖12 FER2013表情識別準確率Fig.12 Expression recognition accuracy rate with FER2013

圖13 CK+表情識別準確率Fig.13 Expression recognition accuracy rate with CK+

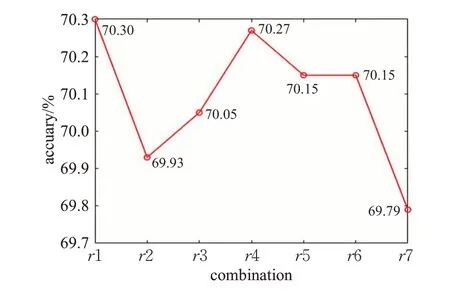

選擇不同的壓縮率會影響最終的人臉表情識別精度,因此壓縮率的選取很關鍵。基于此在不同層采用不同的壓縮率,由于初始層通道數較少,所以設置的壓縮率小,隨著通道數的增多,逐漸增加SE模塊壓縮率到網絡結構的不同層。網絡結構從第三個SE模塊開始,每隔兩個SE模塊的通道數是一樣的,所以選擇壓縮率的時候將這些通道數一樣的SE模塊的壓縮率設置為同一個壓縮率。進行實驗對比后,實驗結果如圖14和圖15所示,圖中為7組效果較好的不同壓縮率組合方式,選擇了性能最佳的壓縮率組合方式r1。圖中網絡結構的SE模塊壓縮率r1至r7具體設置如表3所示,表中總共10個SE模塊,分別對應其壓縮率取值。選擇合適的壓縮率主要是為了更好地利用兩個全連接層來擬合通道間的相關性,利用通道間的相關性來增強特征提取能力,從而提升表情識別精度。

圖14 FER2013不同壓縮率組合方式識別準確率Fig.14 Recognition accuracy of different squeeze ratio combinations with FER2013

圖15 CK+不同壓縮率組合方式識別準確率Fig.15 Recognition accuracy of different squeeze ratio combinations with CK+

表3 壓縮率取值Table 3 Squeeze ratio value

2.2.2 不同方法對比實驗

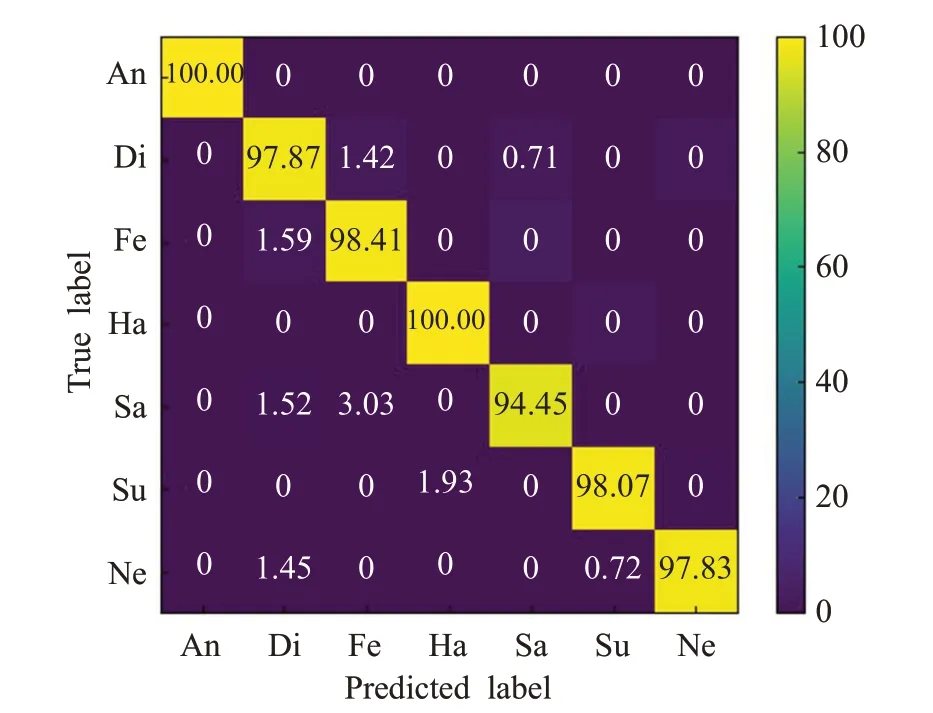

通過多次實驗后得出實驗結果,FER2013和CK+數據集上七類表情的混淆矩陣如圖16和圖17所示。

圖16 FER2013數據集上七類表情的混淆矩陣Fig.16 Confusion matrix of 7 types of expressions on FER2013 dataset

圖17 CK+數據集上七類表情的混淆矩陣Fig.17 Confusion matrix of 7 types of expressions on CK+dataset

由圖16可以看出,FER2013數據集中表情識別率最高的是高興和驚訝,可能原因是高興和驚訝的表情特征辨識度更高。憤怒和恐懼表情識別率相對較低,可能原因是這兩種表情特征很相似,具有相同的嘴角、眉毛等特征,很容易發生混淆,從而導致表情識別率不高。由圖17可以看出,CK+數據集的整體表情識別準確率可以達到95%以上,其中識別率最高的為憤怒和高興,可能原因是由于CK+數據集中憤怒和高興的表情特征相對于其他表情區別更大一些,識別率較低的是悲傷類,因為在數據集特征都相對明顯的情況下,悲傷表情和厭惡表情特征相近似,使其識別率有所影響。圖18和圖19為FER2013和CK+數據集中容易發生混淆的表情示例。

圖18 FE(Rb20)13恐數懼據表集情易混示淆例圖片對比Fig.18 Confusing expression contrast on FER2013 dataset

圖19 CK+數據集易混淆圖片對比Fig.19 Confusing expression contrast on CK+dataset

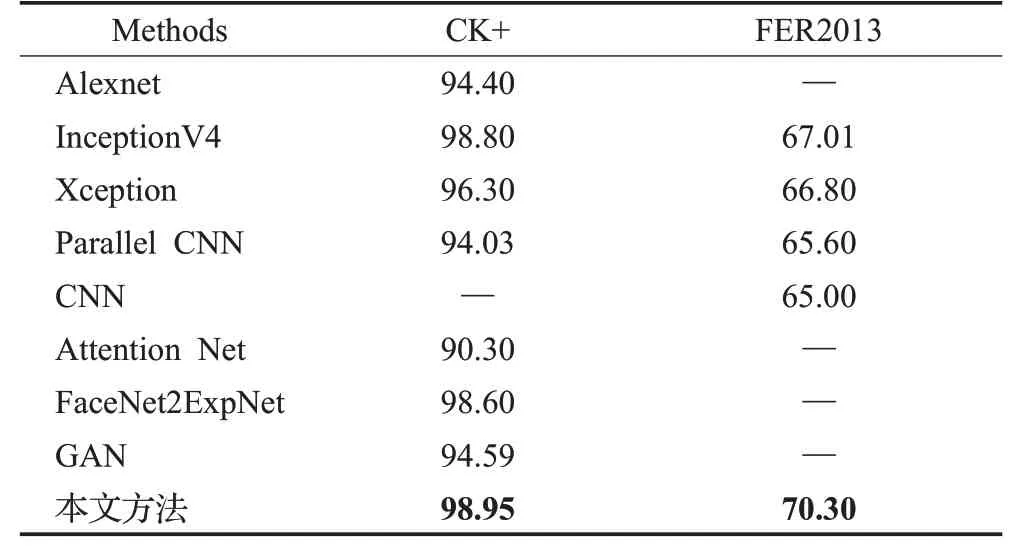

為了驗證本文提出方法的有效性,在CK+和FER2013數據庫上,對比本文算法與表情識別經典算法的準確率和網絡參數量,參與對比實驗的經典算法有Alexnet[19]、InceptionV4[20]、Xception[16]。除此之外,還與近幾年最新的表情識別算法進行了比較,參與對比實驗的最新算法有Parallel CNN[21]、CNN[22]、Attention Net[23]、FaceNet2ExpNet[24]、GAN[25],對比結果如表4所示。Alexnet是2012年ImageNet大賽上的冠軍網絡,InceptionV4是Inception系列網絡中的一個性價比較高的網絡,本文網絡是根據Xception設計思想進行改進的,這三個經典網絡都具有典型的代表性。Parallel CNN方法設計的網絡結構具有兩個并行的卷積池化結構,分成三個不同的并行路徑來提取三種不同的圖像特征。CNN方法主要考慮核大小和濾波器數目對分類精度的影響,設計了兩種新穎的CNN網絡結構來提取人臉表情特征。Attention Net方法將注意力集中在人臉上,用高斯空間表示來進行人臉表情識別。FaceNet2ExpNet方法提出一種基于靜態圖像訓練表情識別網絡的新思路,首先提出一種新的分布函數來模擬表達網絡的神經元,在此基礎上設計了兩個階段的訓練算法,先預訓練一個表情網絡,在正式訓練時將全連接層與預先訓練的卷積層相結合并共同訓練。GAN方法在StarGAN的基礎上,改進重構誤差,用生成器進行下采樣,由某一個人的一種表情可以生成其他不同表情。

表4 不同方法在數據集上的識別結果Table 4 Recognition results of different methods on dataset %

目前人類在FER2013數據集上的識別率平均約為65%±5%[17],本文模型在CK+數據集上取得了98.95%的識別準確率,在FER2013數據集上取得了70.30%的識別準確率,已經能夠達到平均識別的效果。與現有方法相比,本文提出的網絡結構在CK+和FER2013數據集上,識別率分別提高了0.15個百分點和3.29個百分點,證明本文模型具有一定的穩定性和泛化能力。CK+數據集的識別率相對FER2013表情數據集整體提高了許多,主要原因是FER2013數據集中存在很多錯誤標簽以及非正常表情圖片,圖20為FER2013數據集中部分非正常表情示例。

圖20 FER2013數據集中非正常表情示例Fig.20 Example of abnormal expressions on FER2013 dataset

此外,為了進一步驗證本文網絡模型的輕量性,對比了表4中與本文實驗結果準確率相近的部分網絡結構參數量,如表5所示,本文提出的神經網絡結構的參數量是最少的,且與改進前的Xception網絡相比,參數少了75%,并且在服務端進行了測試,算法的平均識別速度可以達到137 frame/s,滿足實時性(30 frame/s以上)的要求。

表5 不同方法的網絡結構參數量Table 5 Network structure parameters of different methods

3 結語

針對目前人臉表情識別準確率不高、網絡模型參數復雜等問題,本文提出了一種可以增強可分離卷積通道特征的神經網絡,吸取了Xception網絡的輕量化設計思想,并且引入了SE模塊使得特征提取更加有效。最后在CK+和FER2013數據集上進行了對比實驗,各自取得較高的識別率,表明本文提出的人臉表情識別方法能夠在降低網絡參數量的同時,提高表情識別精度,實現網絡模型的輕量化。深度學習需要大量的訓練數據支撐,希望在今后的工作中能夠盡可能多地收集訓練樣本,建立自己的數據庫,并且在以后的研究工作中將遮擋、人臉姿勢變換等問題考慮進去,如何在面臨這些問題的情況下還能保證人臉表情識別的準確率將是進一步的研究方向。