改進的M2det內(nèi)窺鏡息肉檢測方法

王 博,張麗媛,師為禮,楊華民,蔣振剛

長春理工大學(xué) 計算機科學(xué)技術(shù)學(xué)院,長春 130022

結(jié)直腸癌已成為世界上第三大常見的惡性腫瘤,其中90%是由腸腺瘤引起的[1]。腸腺瘤屬于腫瘤性息肉,在臨床上腫瘤性和非腫瘤性息肉不易區(qū)分,所以息肉都會被摘除,待病理學(xué)確診后再進一步分類。如果早期發(fā)現(xiàn)息肉并且進行醫(yī)學(xué)干預(yù),可以有效降低結(jié)直腸癌的發(fā)病率和病死率。醫(yī)生通過內(nèi)窺鏡來檢查患者的腸道,這項工作面臨著兩大挑戰(zhàn),其一,腸道內(nèi)部環(huán)境極其復(fù)雜、不同患者的生理結(jié)構(gòu)存在巨大差異、早期的息肉一般比較隱蔽等因素會給醫(yī)生在做內(nèi)窺鏡檢查時帶來息肉漏檢。其二,胃腸道疾病患者增多,導(dǎo)致內(nèi)窺鏡影像數(shù)據(jù)劇增,不易于人工處理,內(nèi)窺鏡檢測技術(shù)十分依賴于內(nèi)科醫(yī)生的經(jīng)驗與能力,年輕醫(yī)生可能無法勝任,因此在時間和精力上會給醫(yī)生造成大量損耗。有科學(xué)依據(jù)表明,目前內(nèi)窺鏡檢測技術(shù)誤診率高達26%[2],因此通過開發(fā)計算機輔助診斷技術(shù)去幫助內(nèi)科醫(yī)生進行息肉檢測具有重大意義。

通過計算機輔助診斷實現(xiàn)內(nèi)窺鏡影像異常檢測的方法分為兩類:基于圖像特征的方法和基于卷積神經(jīng)網(wǎng)絡(luò)(convolutional neural network,CNN)[3]的方法。早期很多內(nèi)窺鏡病灶檢測都是基于圖像特征的,整體流程可以概括為:圖像預(yù)處理、特征提取、病灶檢測。Shen等人[4]采用顏色直方圖的統(tǒng)計變量作為特征,對檢測單元的各通道進行輪廓波變換,在產(chǎn)生的子帶中得到紋理特征和灰度共生矩陣,最后進行目標檢測,該方法應(yīng)用多尺度方法更好地實現(xiàn)了異常檢測,但錯誤率高達13.99%。Tajbakhsh等人[5]提出了一種基于形狀和上下文信息的息肉檢測模型,首先利用上下文信息刪除非息肉結(jié)構(gòu),之后采用形狀信息進行息肉定位,實驗結(jié)果表明敏感度為88%,有待提升。基于圖像特征的方法首先需要大量的圖像預(yù)處理,這是一個費時又費力的工作,其次需要提取圖像的顏色特征和紋理特征,該方法不能充分地利用圖像特征,導(dǎo)致識別精度較低,達不到臨床要求。目前已經(jīng)有很多國內(nèi)外學(xué)者基于CNN的方法來實現(xiàn)病灶檢測,該方法可以略去大量的圖像預(yù)處理,自動地提取內(nèi)窺鏡圖像特征,病灶檢測的精度較高。Yuan等人[6]提出了一個旋轉(zhuǎn)不變和圖像相似性約束的密集連接卷積網(wǎng)絡(luò)(RIIS-DenseNet),增強了訓(xùn)練樣本學(xué)習特征和對應(yīng)旋轉(zhuǎn)版本之間的映射關(guān)系,將圖像類別信息強加于特征上,以保持類內(nèi)的小分散性,該方法精度達到了95.62%,但是沒有標記出病灶的位置,本質(zhì)上是一個分類任務(wù)。Mo等人[7]提出了一種更快的基于區(qū)域的卷積神經(jīng)網(wǎng)絡(luò)(Faster R-CNN),首先通過主干網(wǎng)絡(luò)進行特征提取,其次采用區(qū)域生成網(wǎng)絡(luò)(region proposal network,RPN)對圖像進行粗略篩選,得到候選框,最后用基于區(qū)域的卷積神經(jīng)網(wǎng)絡(luò)(Fast R-CNN)[8]進行精確的識別與定位,可以有效地檢測出息肉,但是對小型息肉存在漏檢。基于CNN的息肉檢測方法可以達到較為理想的精度和速度,但是一些方法只是對息肉進行分類操作,沒有框出息肉位置,另一些方法對小型息肉檢測不敏感。

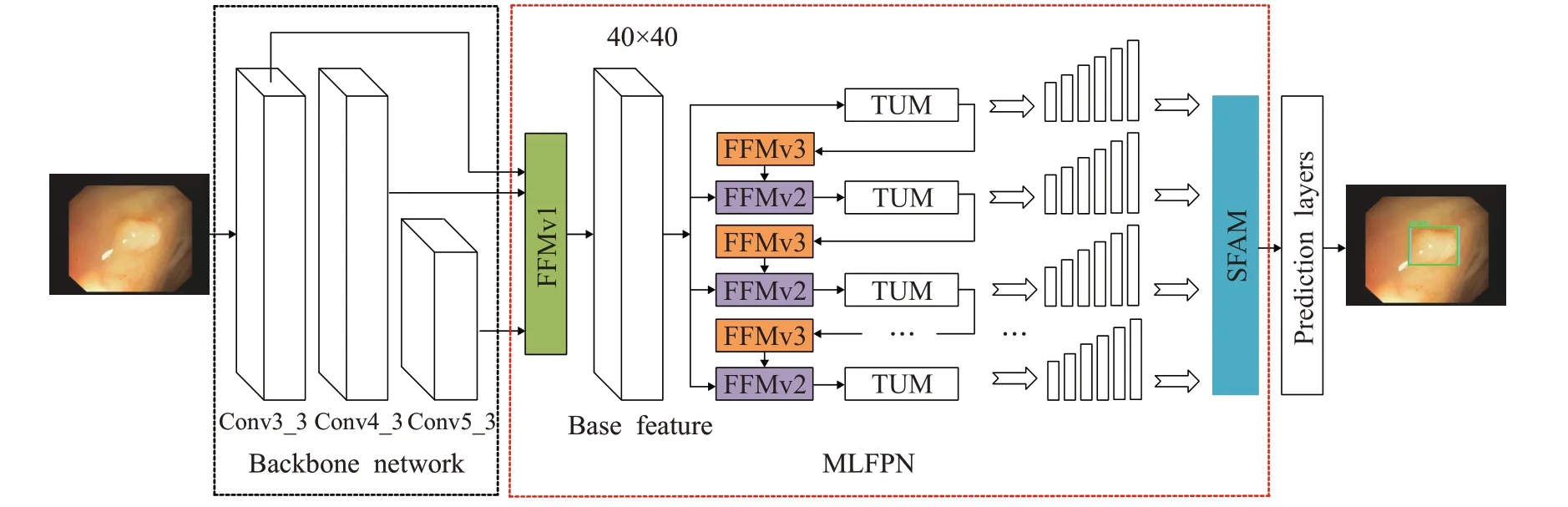

本文采用基于CNN的方法來實現(xiàn)內(nèi)窺鏡影像異常檢測,基于CNN的目標檢測算法主要分為兩大部分one stage類型[9]和two stage類型[10]。One stage網(wǎng)絡(luò)首先將數(shù)據(jù)輸入到模塊中進行特征提取,然后將得到的特征用等同的網(wǎng)格進行劃分,最后對每一個網(wǎng)格分別進行回歸與分類,檢測速度較快,但是存在正負樣本不平衡問題。two stage網(wǎng)絡(luò)首先通過主干網(wǎng)絡(luò)進行特征提取,然后采用RPN篩選候選框,最后結(jié)合主網(wǎng)絡(luò)進行精準的識別與定位,可以達到較高的目標檢測精度,但是檢測速度較慢。基于多級特征金字塔網(wǎng)絡(luò)的單鏡頭目標檢測器(a single-shot object detector based on multilevel feature pyramid network,M2det)[11]屬于one stage類型網(wǎng)絡(luò),在自然場景下目標檢測精度達到了較優(yōu)的效果。本文采用改進的M2det方法進行息肉檢測,實驗結(jié)果表明本文方法優(yōu)于其他方法,mAP達到了98.25%,本文貢獻如下:

采用特征融合模塊v1(feature fusion module v1,F(xiàn)FMv1)將三個不同層次的特征進行融合,用特征融合模塊v3(feature fusion module v3,F(xiàn)FMv3)將稀疏U型模塊(thinned U-shape module,TUM)生成的兩個最大的有效特征層進行融合,該方法充分利用了圖像特征,增強了圖像特征的魯棒性,從而提高了檢測的精度。

在規(guī)模化特征聚合模塊(scale-wise feature aggregation module,SFAM)中采用改進的壓縮激勵網(wǎng)絡(luò)(squeeze-and-excitation network,SENet)[12],即空間和通道上的壓縮激勵網(wǎng)絡(luò)(spatial and channel squeeze-andexcitation network,scSENet)[13],該方法可以給特征金字塔在通道和空間上分配權(quán)重,使有效的特征得到充分利用,抑制無用特征。

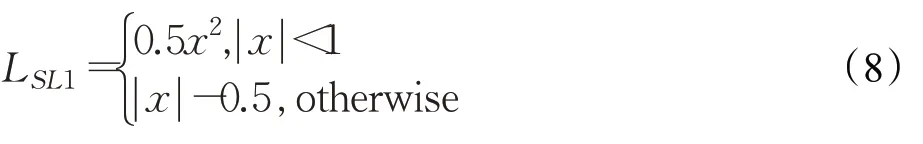

采用遷移學(xué)習來微調(diào)網(wǎng)絡(luò),用早停法(early stopping)[14]防止過擬合,用焦點損失函數(shù)(Focal loss)[15]計算分類損失,解決了正負樣本不平衡問題,在多層特征金字塔網(wǎng)絡(luò)(multi-level feature pyramid network,MLFPN)中采用Mish[16]激活函數(shù)。

1 實驗方法

本文采用改進的M2det用于內(nèi)窺鏡息肉檢測,首先進行內(nèi)窺鏡圖像預(yù)處理,采用letterbox_image方法將尺寸不一的內(nèi)窺鏡圖像變換到320×320,該方法不會產(chǎn)生圖像信息丟失、圖像形變,通過縮放、翻轉(zhuǎn)、扭曲進行數(shù)據(jù)增強,M2det利用主干網(wǎng)絡(luò)(backbone network)和多層特征金字塔網(wǎng)絡(luò)(MLFPN)從輸入的圖像提取特征,根據(jù)學(xué)習到的特征生成邊界框和類別分數(shù)。在MLFPN中,首先通過FFMv1模塊將主干網(wǎng)絡(luò)中的三個不同層次的特征進行融合,得到基礎(chǔ)特征,其次將TUM模塊生成的兩個最大的有效特征層通過FFMv3模塊進行特征融合,F(xiàn)FMv3融合的結(jié)果和基礎(chǔ)特征通過FFMv2模塊進行融合,得到多層次多尺度特征,最后通過SFAM模塊將特征聚合成多層次的特征金字塔。在實驗中,使用了8個TUM模塊,采用VGG[17]作為主干網(wǎng)絡(luò),在MLFPN中引入了Mish激活函數(shù),改進的M2det網(wǎng)絡(luò)模型如圖1所示。

圖1 改進的M2det網(wǎng)絡(luò)模型Fig.1 Improved M2det network model

1.1 改進的M2det

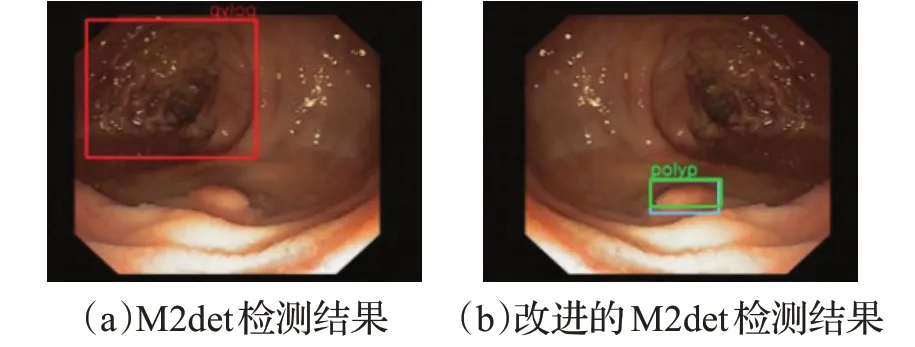

M2det是由特征融合模塊(FFMs)、稀疏U型模塊(TUMs)、規(guī)劃特征聚合模塊(SFAM)三部分組成。如圖2(a)所示M2det在小型息肉以及復(fù)雜環(huán)境下具有漏檢和誤檢,導(dǎo)致真陽性和檢測精度降低,因此針對這個問題提出了改進的M2det方法,在主干網(wǎng)絡(luò)中加入淺層特征Conv_3,特征融合模塊中加入FFMv3模塊,使特征得到了充分利用,在規(guī)模化特征聚合模塊中加入scSENet注意力機制,使有用特征得到充分利用,抑制無用特征,在損失函數(shù)中加入Focal loss,解決了正負樣本不平衡問題,如圖2(b)所示,在復(fù)雜的環(huán)境下成功地識別出了小型息肉,基于M2det改進的細節(jié)具體如下。

圖2 比對結(jié)果Fig.2 Comparison result

1.2 特征融合模塊(feature fusion module,F(xiàn)FMs)

FFMs由FFMv1、FFMv2、FFMv3三部分組成,目的是進行特征融合。在FFMv1模塊中,本文新增了淺層特征并且通過FFMv1模塊將淺層特征、中層特征和深層特征進行融合,融合之前采用卷積來壓縮通道數(shù)量,上采樣操作增大特征尺寸,使其達到融合的標準,最后得到基礎(chǔ)特征,該基礎(chǔ)特征包含了三種不同深度的特征。FFMv2原理類似于FFMv1,差別是融合的特征不同,先通過1×1的卷積操作來壓縮基礎(chǔ)特征的通道,之后通過FFMv2模塊將基礎(chǔ)特征與FFMv3模塊生成的特征進行融合,并將結(jié)果用作下一個TUM模塊的輸入,該操作可以充分地利用前面的有效特征和基礎(chǔ)特征,本文新增FFMv3模塊將TUM模塊生成的最大的有效特征進行融合,在融合前,先將較小的有效特征進行上采樣,使其達到同樣尺寸,融合之后進行1×1的卷積操作,壓縮通道大小為128,該操作可以充分地利用TUM模塊生成的有效特征層。FFMv1、FFMv2和FFMv3模塊的操作細節(jié)分別如圖3(a)、(b)、(c)所示,其中藍色模塊的四個參數(shù)分別為輸入通道、卷積核尺寸、步長大小、輸出通道。

圖3 特征融合模塊Fig.3 FFMs model

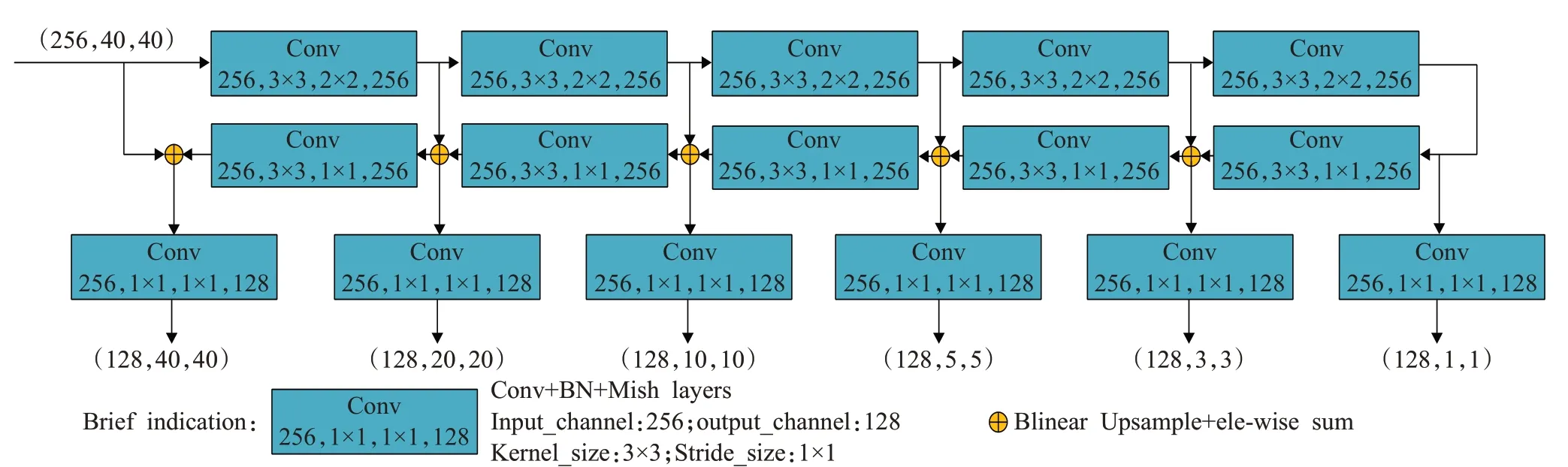

1.3 稀疏U型模塊(TUMs)

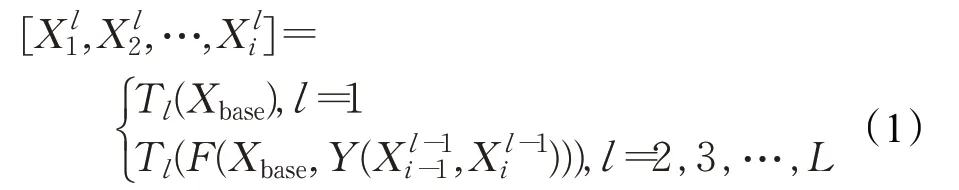

TUM模塊采用了稀疏的U型結(jié)構(gòu),TUM模塊分為編碼操作和解碼操作,編碼由步長為2的一系列3×3卷積組成,在解碼操作中將上采樣的結(jié)果和在解碼操作中同等尺寸的特征進行融合,此外,通過1×1的卷積層,增強學(xué)習能力,壓縮通道數(shù),每一個TUM模塊都能輸出多尺度特征,8個TUM模塊就可以輸出8個不同深度的多尺度特征,其中第一個TUM模塊的輸入只有基礎(chǔ)特征,剩下的TUM模塊的輸入通過FFMv2和FFMv3來實現(xiàn),多層次多尺度特征輸出的計算公式如下:

其中,Xbase為基礎(chǔ)特征,為第l個TUM模塊輸出的最大尺度的特征,和分別為第l-1個TUM模塊輸出的次大尺度和最大尺度的特征,L為TUM最大數(shù),Tl為第l個TUM模塊的操作,F(xiàn)為FFMv2操作,Y為FFMv3操作,具體操作細節(jié)如圖4所示。

圖4 稀疏U型模塊Fig.4 TUM model

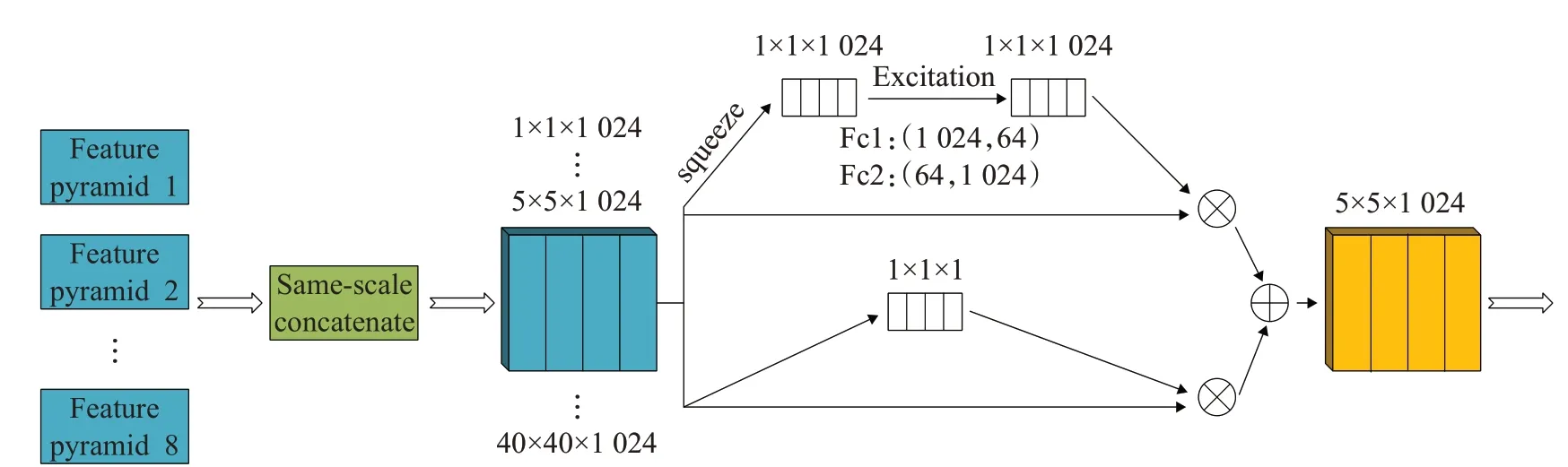

1.4 規(guī)模化特征聚合模塊(SFAM)

SFAM模塊的目的是將TUMs生成的多層次多尺度特征聚合成多層次特征金字塔,如圖5所示。首先SFAM模塊將尺寸相同的有效特征層進行聚合,聚合后的特征金字塔可以表示為X=[X1,X2,…,Xi],其中Xi=為第i個尺度的特征,l為層數(shù),Concat為聚合操作,RWi×Hi為空間大小,因此每一個特征金字塔都包含不同深度的特征。然后對特征金字塔通過注意力機制(SENet)進行通道上的權(quán)值分配,首先對各個通道上的注意力機制進行調(diào)整,判斷每一個通道數(shù)應(yīng)該有的權(quán)重,在squeeze步用全局平均池化來生成通道統(tǒng)計信息z∈RC,為了更好地獲得通道依賴,通過兩個1×1的全連接層學(xué)習注意力機制,得到通道上的權(quán)重分配Sc:

圖5 規(guī)模化特征聚合模塊Fig.5 SFAM model

其中,δ為ReLU激活函數(shù),σ為sigmoid激活函數(shù),W1、W2為通道上的權(quán)重,Sc為通道上的權(quán)重分配。通過對輸入的Xi使用激活Sc重新加權(quán)得到通道上的注意力機制Yc:

其中,Xi為輸入,Sc為通道上的權(quán)重分配,Yc為通道上的注意力機制,F(xiàn)c為通道上的操作。

本文新增了特征金字塔在空間上的權(quán)值分配,首先對各個空間上的注意力機制進行調(diào)整,判斷每一個空間應(yīng)該有的權(quán)重,統(tǒng)計空間信息z∈RS,然后進行1×1×1的卷積操作,得到空間上的權(quán)重分配Ss:

其中,σ為sigmoid激活函數(shù),W3為空間上的權(quán)重,Ss為空間上的權(quán)重分配。通過對輸入的Xi使用激活Ss重新加權(quán)得到空間上的注意力機制Ys:

其中,Xi為輸入,Ss為空間上的權(quán)重分配,F(xiàn)s為空間上的操作,Ys為空間上的注意力機制。

最后,將特征金字塔在通道上的注意力機制Yc和空間上的注意力機制Ys進行張量上的相加,得到最終的注意力機制Ysc:

1.5 損失函數(shù)

One stage目標檢測方法存在正負樣本不平衡問題,本文新增Focal loss解決以上問題,在訓(xùn)練時采用Focal loss計算分類損失,降低分類損失,F(xiàn)ocal loss計算如下:

其中,y′是預(yù)測輸出,y是真實樣本的標簽,α是正負樣本權(quán)重,γ是易分類樣本和難分類樣本權(quán)重。

采用Smooth L1[10]計算回歸損失,當預(yù)測框與真實樣本標簽差值過大時,梯度值不至于過大,當預(yù)測框與真實樣本標簽差值很小時,梯度足夠小,訓(xùn)練時可以收斂得更快,loss對離群點、異常值不敏感,可控制梯度的量級使訓(xùn)練時不容易跑飛,計算公式如下:

其中,x是預(yù)測框與真實樣本標簽的差值。最終本文采用的損失函數(shù)是Focal loss與Smooth L1的結(jié)合體:

2 實驗

2.1 實驗數(shù)據(jù)集

本文采用的數(shù)據(jù)集是CVC-Clinic(CVC15)[18],由西班牙巴塞羅那醫(yī)院從29個內(nèi)窺鏡視頻中挑選出來612個384×288的靜止幀,標簽是由西班牙巴塞羅那計算機視覺中心(CVC)標記,該數(shù)據(jù)集用于內(nèi)窺鏡視頻息肉檢測的MICCAI2015和SBI2015子挑戰(zhàn)。

2.2 模型訓(xùn)練

在訓(xùn)練數(shù)據(jù)集不足以表征所有樣本特征的情況下,會導(dǎo)致網(wǎng)絡(luò)過擬合,因此本文采用遷移學(xué)習的方法來訓(xùn)練網(wǎng)絡(luò),首先用VOC數(shù)據(jù)集訓(xùn)練M2det模型,得到相應(yīng)的權(quán)重,然后用CVC15數(shù)據(jù)集來微調(diào)參數(shù)即可。采用早停法(early stopping)來避免繼續(xù)訓(xùn)練導(dǎo)致的過擬合,將原始的訓(xùn)練數(shù)據(jù)集劃分為訓(xùn)練集和驗證集,比例為9∶1,每次迭代都計算驗證損失,當驗證損失值達到局部最優(yōu)時,繼續(xù)迭代6次,如果模型不再收斂就停止訓(xùn)練。模型參數(shù)采用Adam[19]進行優(yōu)化,batch size設(shè)置為2,學(xué)習率初始化為1×E-4,當2次迭代優(yōu)化指標不下降時,使學(xué)習率衰減5×E-5,循環(huán)迭代步數(shù)設(shè)置為50,當?shù)綌?shù)達到30時,重新設(shè)置學(xué)習率為1×E-5,采用python的keras框架在DGX-Station上訓(xùn)練。

2.3 模型檢測

通過SFAM模塊得到6個特征金字塔,每一個特征金字塔包含不同深度的特征,即獲得了6個有效的特征,對每個有效特征層都進行priors×4的卷積和priors×classes的卷積,其中priors、classes分別為先驗框個數(shù)和息肉類別加背景數(shù)量,實驗中設(shè)置priors、classes分別為6和2,priors×4卷積用來預(yù)測每個網(wǎng)格上每一個先驗框的變化情況,priors×classes卷積用來預(yù)測每個網(wǎng)格上每一個預(yù)測框中目標對應(yīng)的類別。

通過先驗框與prioris×4的卷積操作得到了預(yù)測結(jié)果,然后將預(yù)測結(jié)果對應(yīng)真實框進行調(diào)整,其中4個參數(shù)分別為先驗框中心相對于真實框中心的偏移值x、y,先驗框?qū)捀呦鄬τ谡鎸嵖虻钠浦祑、h。在特征圖上進行等同大小的網(wǎng)格劃分,用網(wǎng)格中心坐標加上x、y偏移量得到候選預(yù)測框中心,再將先驗框的寬高進行w、h尺度偏移,就可以得到候選預(yù)測框。由于候選預(yù)測框數(shù)量比較大,因此要將候選預(yù)測框按照分數(shù)進行排序并且進行非極大值抑制(NMS)[20]操作得到最終的預(yù)測框。

2.4 模型評估指標

根據(jù)測試樣本的輸出類別與真實標簽的類別進行對比,得到四種結(jié)果,真陽性(TP)表示正確判斷出息肉,假陽性(FP)表示把背景誤判為息肉,真陰性(TN)表示正確判斷出背景區(qū)域,假陰性(FN)表示把息肉誤判為背景。精確率(precision,P)表示為正確檢測到的息肉(TP)占被檢測到的息肉(TP+FP)的比例,召回率(recall,R)表示為被正確檢測到的息肉(TP)占應(yīng)該被檢測到的息肉(TP+FN)的比例,計算公式如下所示:

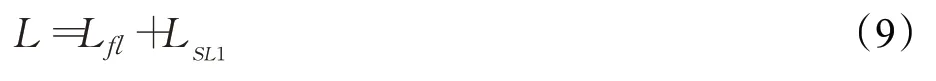

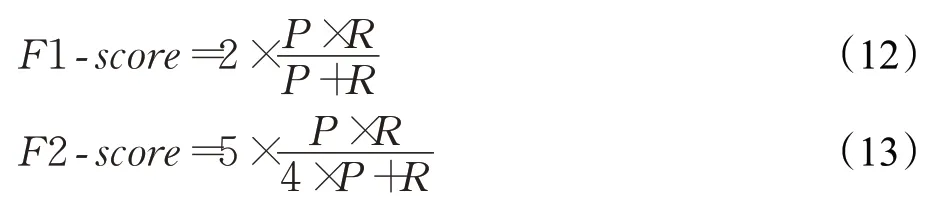

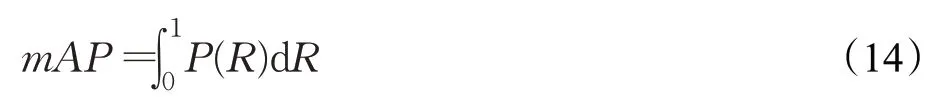

由于精確率和召回率是相互制約的,因此采用Fsorce進行調(diào)和,F(xiàn)1-score中P和R的權(quán)重相同,因此精確率和召回率都重要,F(xiàn)2-score更加看重召回率,計算公式如下:

平均精度均值(mean average precision,mAP)是目標檢測方法最重要的評估指標,在不同置信度閾值下獲得精確率和召回率,以P、R為橫縱作標軸繪制PR曲線,PR曲線與橫縱作標軸圍成的面積就是mAP值,mAP計算公式如下:

對數(shù)平均誤檢率(log-average miss rate,Lamr),xn是第n個圖像的誤檢率,計算公式如下:

2.5 實驗結(jié)果與分析

超參數(shù)設(shè)置的好壞對網(wǎng)絡(luò)至關(guān)重要,本文對比了在不同置信度(confidence)和批量大小(batch size)設(shè)置下對網(wǎng)絡(luò)性能的影響。置信度和類別分數(shù)都介于0到1之間,若預(yù)測框包含某類別目標分數(shù)大于置信度,則保留該分數(shù),當置信度較大時,真陽性會下降,當置信度較小時,假陽性會上升,因此選擇一個合適的置信度至關(guān)重要,設(shè)置置信度分別為0.3、0.4、0.5進行實驗性能對比,綜合各項評估指標,置信度取值0.4最為合適,實驗結(jié)果如表1所示。

表1 不同confidence的實驗對比Table 1 Experimental comparison of different confidence

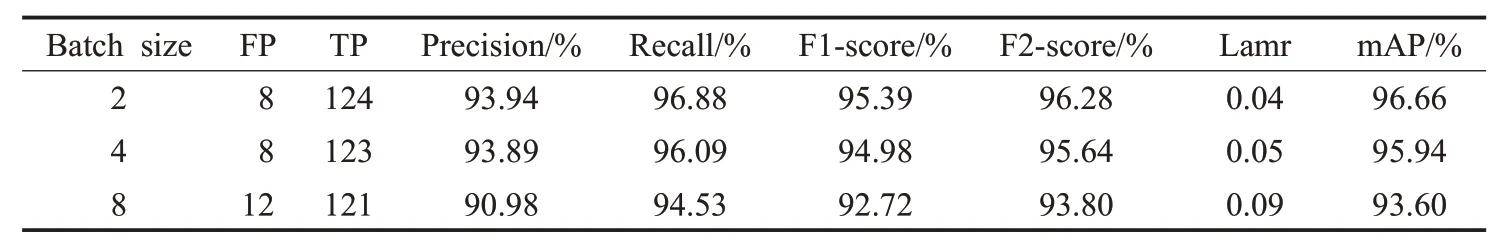

batch size的取值會直接影響模型的泛化性能,決定梯度下降的方向,大的batch size更新量不足,泛化能力差,梯度不易修正,小的batch size訓(xùn)練速度慢,網(wǎng)絡(luò)不易收斂,因此選擇一個合適的batch size至關(guān)重要,由于網(wǎng)絡(luò)對2的次冪的batch size訓(xùn)練最優(yōu),因此在置信度取值0.4的情況下,batch size分別取值2、4、8,對比結(jié)果如表2所示,當batch size為2時,各項評估指標都達到了最優(yōu)。

表2 不同batch size的實驗對比Table 2 Experimental comparison of different batch sizes

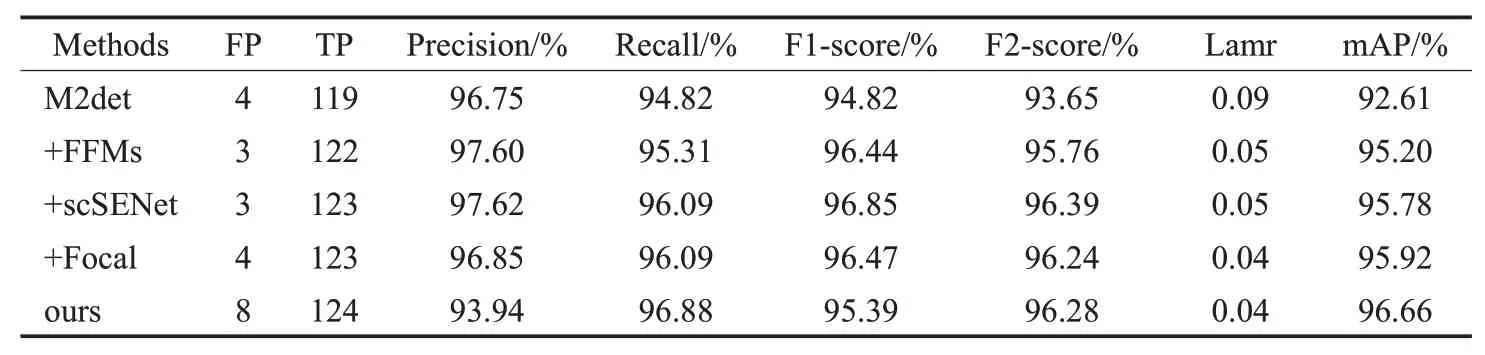

改進的M2det是由三部分組成的,因此要分別驗證每一部分的改進對模型性能的影響:其一,F(xiàn)FMs模塊的目的是實現(xiàn)特征融合,將淺層、中層、深層特征進行融合,達到了不同特征之間的優(yōu)勢互補效果,增強了圖像特征的魯棒性,充分利用了圖像的特征信息。其二,在SFAM模塊中通過scSENet在特征金字塔的通道和空間上增加注意力機制,使更有效的信息得到較大的權(quán)重,抑制無用的信息。其三,在訓(xùn)練時采用Focal loss計算分類損失,可以有效地解決正負樣本不平衡問題。對比結(jié)果如表3所示,在M2det基礎(chǔ)上分別單獨加入FFMs、scSENet、Focal loss各項評估指標均有較大提升,最后將這三個部分進行整合,TP、Recall、Lamr、mAP都達到了最優(yōu),除了Precision評估指標較低外,其他評估指標均有提升。

表3 改進的M2det結(jié)果對比Table 3 Improved M2det result comparison

一個TUM模塊生成六個有效特征層,當TUM數(shù)量較小時,生成的有效特征層較少,存在圖像特征利用不足的情況,當TUM數(shù)量較大時,參數(shù)計算量較大,會對網(wǎng)絡(luò)運行速度產(chǎn)生影響,針對TUM模塊個數(shù)對網(wǎng)絡(luò)性能產(chǎn)生影響問題,TUM個數(shù)分別采用4、8進行訓(xùn)練,實驗結(jié)果如表4所示,當TUM個數(shù)取8時各項指標達到了最優(yōu)。

表4 不同TUM個數(shù)的實驗對比Table 4 Experimental comparison of different TUM Numbers

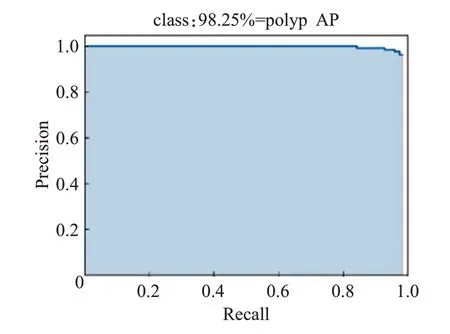

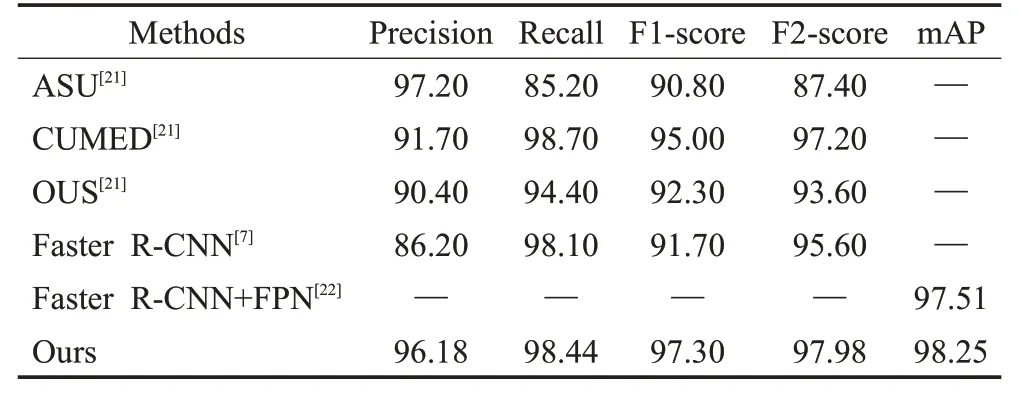

通過前面的實驗,本文設(shè)置confidence為0.4,batch size為2,TUM個數(shù)為8,采用改進的M2det進行訓(xùn)練,與目前主流的息肉目標檢測算法進行比較,其中ASU、CUMED、OUS[21]方法都來自于內(nèi)窺鏡視頻息肉檢測的MICCAI子挑戰(zhàn)賽,對比實驗結(jié)果如表5所示,在Precision、Recall評估指標上分別略低于ASU、CUMED方法,但是本文在F1-score、F2-score、mAP評估指標上都達到了最優(yōu),表明本文方法可以有效地檢測出息肉,PR曲線如圖6所示。

圖6 PR曲線Fig.6 PR curve

表5 不同算法的檢測性能對比Table 5 Comparison of detection performance of different algorithms %

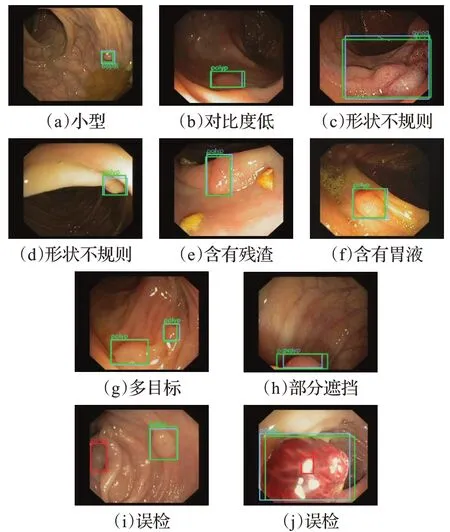

本文具有代表性的檢測結(jié)果如圖7所示,其中綠色框是真實標簽,藍色框是預(yù)測結(jié)果,紅色框是誤檢結(jié)果。文獻[7]對于小型結(jié)腸息肉存在漏檢,本文通過FFMs進行特征融合,得到多層次多尺度特征,從而充分地利用了圖像特征,可以有效地檢測出小型和對比度低的息肉,如圖7(a)、(b)所示;在特征通道和空間上采用scSENet注意力機制,將有用的特征保留下來,抑制無用特征,在形狀不規(guī)則、含有食物殘渣和胃液的場景下可以正確地檢測出息肉,如圖7(c)、(d)、(e)、(f)所示;在不止一個息肉和息肉被部分遮擋的場景下還可以成功地檢測出息肉,如圖7(g)、(h)所示,由此可見本文的M2det具有較強的魯棒性。總體來看本文在內(nèi)窺鏡息肉檢測方向取得了一些成果,但是也存在一些不足,對于對比度低且形狀不規(guī)則的圖像存在誤檢,如圖7(i)所示;對于含有高強度反光且形狀類似息肉的圖像存在誤檢,如圖7(j)所示,這些誤檢會造成假陽率增大,進而影響檢測精度。在今后的研究工作中,針對圖7(j)的場景,打算加入顏色特征,通過控制閾值的方法濾除掉高強的反光特征,方法可行性有待商榷。

圖7 檢測結(jié)果Fig.7 Detection results

3 結(jié)束語

本文提出一個有效的內(nèi)窺鏡息肉檢測方法,通過FFMs模塊融合不同深度特征,可以增強圖像特征的魯棒性,在SFAM模塊中加入scSENet注意力機制,給有用的特征分配較大的權(quán)重,抑制無用特征,在分類損失函數(shù)中采用Focal loss解決了正負樣本不平衡問題,實驗結(jié)果表明,該方法可以有效地識別和定位出息肉,并取得了較高的精確度,在CVC15數(shù)據(jù)集上mAP、F1-score、F2-score分別達到了98.25%,97.30%,97.98%,因此在內(nèi)窺鏡檢查時應(yīng)用該方法可以有效地降低息肉漏檢的風險。