基于Kinect V3深度傳感器的田間植株點云配準方法

李修華,魏 鵬,何嘉西,李民贊,張木清,溫標堂

基于Kinect V3深度傳感器的田間植株點云配準方法

李修華1,2,魏 鵬1,何嘉西1,李民贊3,張木清2,溫標堂4

(1. 廣西大學電氣工程學院,南寧 530004; 2. 廣西甘蔗生物學重點實驗室,南寧 530004;3. 中國農業大學現代精細農業系統集成研究教育部重點實驗室,北京 100083; 4. 捷佳潤科技集團股份有限公司,南寧 530001)

準確建立植物的三維點云是以點云方式高通量獲取植株各部位物理參數的前提。為實現田間復雜環境下的植株三維點云配準,該研究提出了一種基于多標定球的田間植株點云自動配準方法,并分別在室內簡單場景及大田復雜場景下從不同角度對多種作物采集的點云數據進行驗證。該方法采用隨機抽樣一致性算法(Random Sample Consensus, RANSAC)結合點云減法的概念從下采樣后的點云中實現多標定球的自動提取,彌補了RANSAC一次只能提取單個物體的缺點。然后基于各標定球的球心距離信息實現三維點集的自動匹配。最后使用奇異值分解算法解算旋轉平移矩陣,實現點云的自動配準。不同場景下各作物的配準結果表明,各植株的水平90°、180°、270°以及垂直方向上的點云配準到水平0°點云下的平均軸向誤差在5.8~17.4 mm之間,平均點位誤差在13.1~28.9 mm之間,與手動配準的商用同類軟件LiDAR360的配準結果相當,但配準過程的自動化程度明顯提高,效率提高了67%。該文所提出的方法可在田間復雜環境下對低成本深度相機獲取的植株點云實現高精度的自動配準,為田間植物表型參數的提取提供了低成本的可行方案。

自動化;傳感器;點云;植株三維建模;點匹配;RANSAC;Kinect

0 引 言

三維重建是指在計算機中建立表達客觀世界的一種虛擬現實技術,廣泛應用于醫學治療、文物保護、游戲開發、工業設計、航天航海等領域[1]。在現代化農業中,三維重建技術在提取植株表型參數、提取土壤表面形狀、建立植株生長模型等研究領域也發揮著越來越重要的作用[2-3]。

Kinect V3是一款基于飛行時間算法(Time of Flight,ToF)的深度傳感器,可以同時采集目標物體的RGB圖像和深度圖像,體積更小、精度更高、抗干擾能力更強,更適合在田間環境下采集植株點云數據。

點云配準是點云三維重建的核心步驟,按原理可分為:基于重疊區域的點云配準和基于標定物的點云配準。基于重疊區域的點云配準主要通過計算源點云與目標點云的特征描述符進行配準,但需要源點云與目標點云高度重疊才能達到較好的配準效果。主要的特征描述符有自選圖像描述符(Spin Image,SI)[4]、形狀上下文描述符(3D Shape Context,3DSC)[5]、方向直方圖描述符(Signature of Histogram of Orientation, SHOT)[6]、旋轉投影統計描述符(Rotational Projection Statistics, RoPS)[7]、快速點特征直方圖描述符(Fast Point Feature Histogram, FPFH)[8]。楊玉澤等[9]使用了基于快速點特征直方圖(Fast Point Feature Histogram,FPFH)和正態分布變換(Normal Distributions Transform,NDT)的算法對水曲柳進行了點云配準;鄭立華等[10]使用FPFH描述符結合法線對齊的徑向特征(Normal aligned radial feature,NARF)對兩個角度的蘋果樹點云進行了配準。Garrido等[11]使用激光雷達和移動小車對玉米點云進行了多步融合。由于植物的各向異性生長,使得植物帶有不斷變化的拓撲結構,因此除了通過計算特征描述的方法之外,還可以通過提取植物點云的骨架進行配準。Chebrolu等[12]利用隱馬爾科夫模型(Hidden Markov Model,HMM)對土豆和玉米植株進行了點云配準。

基于重疊區域的點云配準方法受環境影響大,不適合應用于田間復雜環境,為克服這種情況,Yu等[13]使用紅色標定球按其顏色信息進行點云配準,但其標定球的匹配過程缺乏自動化功能;Zhou等[14]使用標定球按其幾何信息對室外植株進行了點云配準,但該方法不適用于田間地面起伏較大的情況。

激光掃描儀或激光雷達所獲取的點云數據精度高、噪點少,但價格昂貴(數十萬元),隨著深度傳感器技術的進步,其測量精度逐漸提高,且價格低廉(千元級),成為農業上作物點云采集的低成本方案。另外目前可獲取的大部分點云處理軟件如Cloudcompare、Meshlab等均需要人為尋找同名點對進行手動配準,自動化程度低。

針對三維點云采集成本高、配準自動化程度低等問題,本文開發了1個基于Kinect V3深度傳感器的低成本點云數據采集平臺,提出了一種自動提取多個標定球并利用距離信息自動配準點云的算法,以實現大田復雜場景下植株點云數據的快速采集及自動配準,為作物表型參數的準確提取提供技術支撐。

1 材料與方法

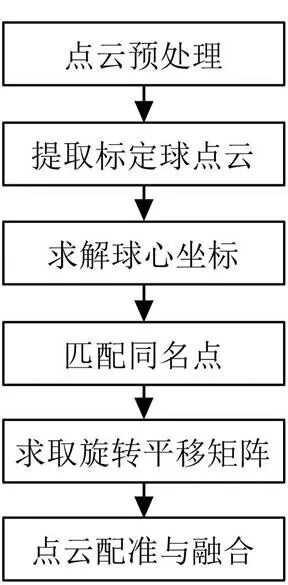

本試驗通過Kinect V3采集香蕉植株的原始點云并對其進行數據處理。原始點云數據的處理流程如圖1所示。首先進行預處理,降低數據量,濾除噪點;然后根據隨機抽樣一致性算法(Random Sample Consensus, RANSAC)提取標定球點云,并解出球心坐標;接著采用本文提出的方法自動匹配不同角度同名球的球心坐標,從而解出各角度的旋轉平移矩陣;最后進行點云融合及點云平滑,建立香蕉幼株3D模型。

圖1 點云處理流程圖

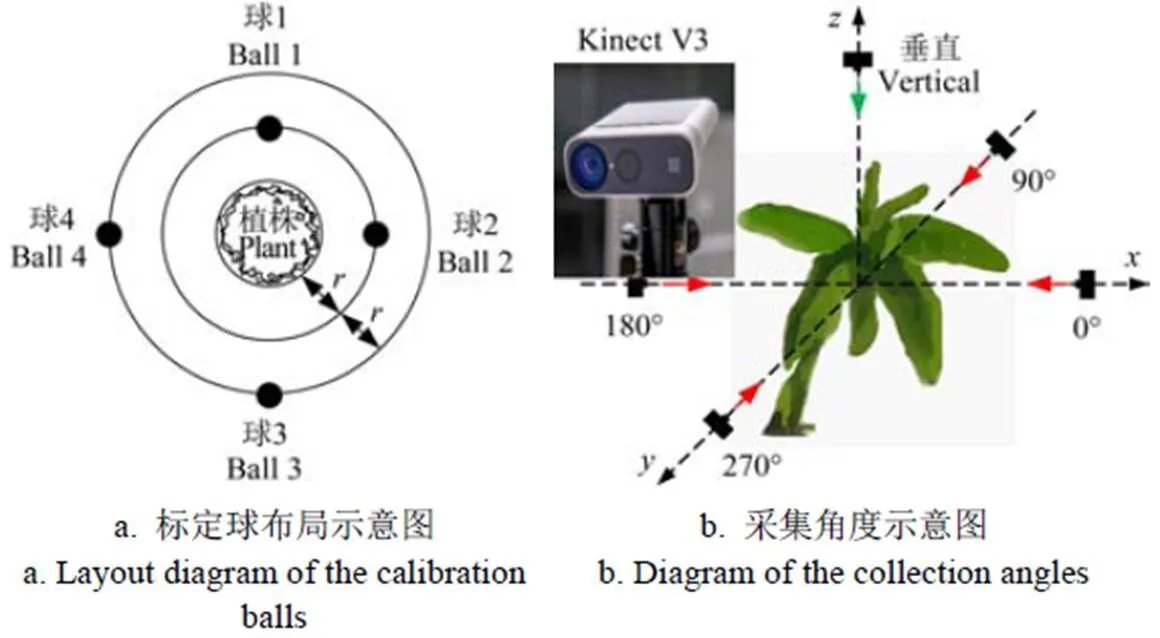

1.1 數據采集

為驗證系統和算法的有效性和穩定性,分別針對室內簡單場景及大田復雜場景對多種作物進行試驗。Kinect V3及其拍攝角度如圖2所示。Kinect V3深度相機采用NFOV非壓縮模式,分辨率為640×576(像素);彩色相機采用32位RGBA模式,分辨率為1 280×720(像素);幀率30幀/s。試驗采用直徑為14 cm的4個白色標定球為配準輔件,使用Dell Precision 7530專業圖形移動工作站(CPU:Intel(R) Core(TM) i9-8950HK;GPU:NVIDIA Quadro P2000)作為數據采集及處理平臺。要實現標定球的自動匹配,標定球的數量和擺放方式需滿足一定規則,即需要3個以上的標定球擺放于不同的方位,兩兩距離不等且不共面。本文提出了一種簡單易操作的四標定球擺放方式,如圖2a所示。從俯視角度看,球1~4分別按90°的角度差順時針擺放于植株(圖中以香蕉苗為例)周邊,球1、球2與植株外圍的距離約為,球3、球4與植株外圍的距離約為2。球2和球3擺放高度與Kinect V3傳感器的放置高度保持基本一致,球1和球4的擺放高度分別適當高于或低于球2和球3。以該方式擺放的標定球,可確保兩兩距離不等,滿足準確計算轉換矩陣的必要條件,且方便拍攝。試驗時,Kinect V3分別從拍攝對象的4個水平方向及垂直向下共5個方向進行點云采集。

注:r為標定球與植株的距離,cm。

1)室內簡單場景:分別選取單株甘蔗苗和高粱苗放置于空曠的室內,通過上述規則擺放標定球后,從水平及垂直5個方向進行點云采集。試驗場景如圖3a所示。

2)大田復雜場景:選擇廣西扶綏縣廣西大學農科新城的一處香蕉種植園作為拍攝地點。香蕉是當地的主要經濟作物之一,屬于芭蕉科芭蕉屬的大型草本植物,主要通過母株球莖處抽生的吸芽進行繁殖。田間試驗采用Kinect V3在原地從5個不同方向對3株香蕉幼苗(6~8葉期)進行拍攝,現場如圖3b所示。由于Kinect V3深度傳感器易受外部強光的影響,在白天陽光較強時采集的數據具有較大噪聲,因此本試驗選擇在傍晚陽光較弱時進行。水平方向各角度拍攝得到點云數量約為20萬點,垂直向下方向點云數量約為27萬點。可視化原始點云如圖4所示。

1.2 點云數據預處理

由于Kinect V3的IR(Infrared Radiation)信號飽和、IR信號強度低、多路徑干擾等原因可能會導致原始香蕉點云數據存在一定的噪聲。另外,田間環境復雜,采集得到的點云數據量大,若直接進行標定球提取,不僅耗時長,且容易導致誤提取。因此,首先需對點云進行直通濾波和點云下采樣等預處理。

1.2.1 直通濾波

直通濾波是常見的點云濾波方法,其基于點云空間坐標系設定空間閾值,僅保留空間閾值內的點云。根據現場獲得的經驗值設置、、軸方向上的閾值min、max、min、max、min和max分別為–700、700、–700、700、0和1400 mm。

1.2.2 下采樣

采用包圍盒壓縮算法進行下采樣。圖5展示了包圍盒壓縮點云的原理。首先構建整體點云的一個大包圍盒(假設其邊長為1),如圖5a所示;再按照2的邊長構建小包圍盒(2可根據需求設定),選擇每個小包圍盒中最靠近其質心的點作為該包圍盒的采樣點,如圖5b所示。通過多次嘗試,本文的2設置為10 mm。

1.3 提取標定球

本文采用隨機采樣一致性算法(Random Sample Consensus,RANSAC)[15]對標定球進行提取。該算法可以從一組包含噪點的數據集中,通過迭代的方式找出符合預設數學模型的點,其準確率隨著迭代次數的增加而增加。已知標定球外形的數學模型為半徑7 cm的球體,一個球體模型需要至少4個空間中的點才可確定,因此隨機采樣的最小子集(初始局內點)為4。本文RANSAC算法提取標定球的具體過程如下:

1)隨機抽取點云數據中的4個點作為初始局內點;

2)計算其決定的球體模型的半徑和球心(,,),若在6~8 cm內,則認為該初始點集接近預設模型,進入下一步,否則回到步驟1);

3)計算其他點到球心的距離,將距離在±5 mm內的點認定為此模型的局內點,并統計所有局內點的數量;

4)重復步驟1)~3),直到達到最大迭代次數 (500000次)為止,局內點最多的點云集即為最終輸出。

RANSAC算法在一個場景里一次只能提取出一個球體。針對這一問題,本文引入點云減法的概念,設計了一種自動提取所有球體的方法。定義兩點云的減法為:在兩片包含關系的點云中,在目標點云中除去被包含的那部分點云。假設存在圖6a所示一目標點云,圖6b為被包含的點云1,則-1結果如圖6c所示。

假設存在一個包含多個標定球的目標點云,自動提取所有標定球的方法如下:

1)采用RANSAC算法提取出第一個球體點云1并保存;

2)對與1做減法操作(在PCL點云庫中不存在對兩片包含關系點云做減法的方法)。首先對1建立kd-tree拓撲關系[16];接著遍歷1中的點,用p表示,并搜尋中與p距離為0的點用q表示,則q即為包含點;將中所有的包含點去除,剩下的點云集合即為兩點云相減的結果;

3)用更新重復步驟1)~3),直至提取完場景中所有標定球或達到RANSAC算法的最大迭代次數為止。

1.4 匹配標定球

在提取出同一場景不同視角的標定球及其球心坐標后進行同名標定球的匹配。本文提出一種基于距離特征描述符的同名點對自動匹配方法。該描述符不隨剛性變換而變換,能唯一指定一個三維點,具體如下:

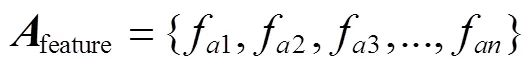

假設存在一點集如式(1)所示,中包含個特征點,兩兩特征點的距離不等。本文一特征點代表一個標定球球心。

將每個點與其他各點的距離作為該點的特征,那么點集的個特征點就可表示為個距離特征的集合,即為距離特征描述符,記為feature,如式(2)所示。

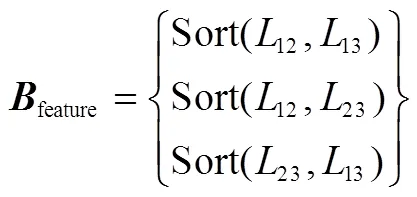

以包含3個特征點的點集(如圖7所示)舉例說明該算法的原理。設存在兩點集、,點集由點集經過一定旋轉平移得到。

構建點集中每個點的距離特征為該點到其他所有點之間的距離集合。如點集中1點的距離特征為集合為{12,13};同時為了使得構建的距離特征不受排序的影響,需對距離特征集合做排序(本文采用從小到大的順序),用Sort表示,即a1=Sort(12,13),那么點集的距離特征描述符feature即可表示為式(3)。同理可得點集的特征描述符feature如式(4)所示。

由上述分析不難得出,當||a1–b1||=0、||a1–b2||與||a1–b3||均不為0時,即可確定b1所對應的1點為1點經旋轉平移得到,即1與1為同名點對。該方法可進一步推廣到包含更多特征點的一般情況,此處不再重復闡述。

1.5 求解旋轉平移矩陣

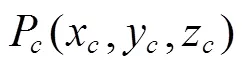

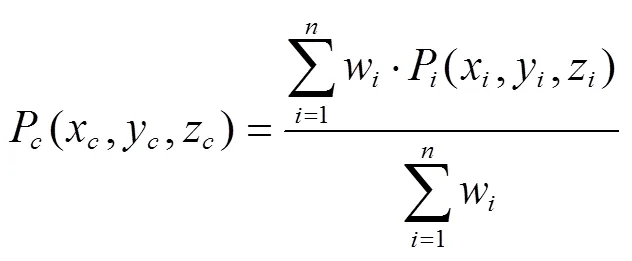

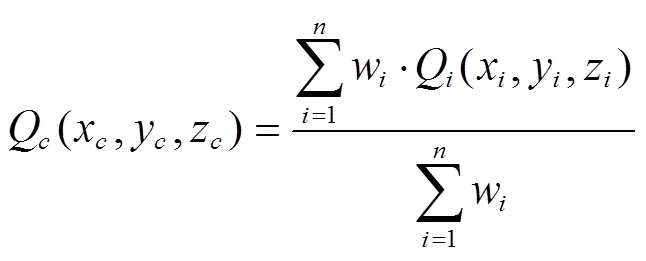

確定同名點集后,使用奇異值分解法(Singular value decomposition,SVD)近似求解旋轉平移矩陣[17]。假設兩同名點集、,求解、之間旋轉平移矩陣的具體步驟如下:

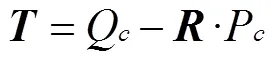

式中w表示權重;P(x,y,z),Q(x,y,z)為點集內各點三維坐標。

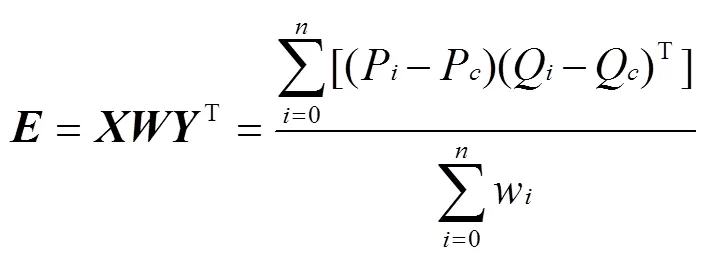

2) 根據式(7)計算協方差矩陣,其中為×維矩陣;,為×維矩陣;=diag(1,2,3,…,w)。

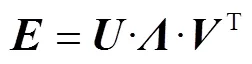

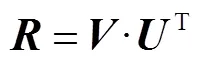

3) 根據式(8)對協方差矩陣進行奇異值分解,和矩陣均為對角矩陣,則推得旋轉矩陣,平移矩陣如式(9)~(10)所示。

1.6 點云平滑

由于環境中風、光線等引起的系統誤差以及配準過程中產生的配準誤差,疊加、配準后的點云表面通常較為粗糙。本文進一步使用移動最小二乘法對點云曲面進行平滑[18],以達到優化三維模型的效果。

2 結果與分析

2.1 點云預處理結果

以香蕉園某株香蕉苗的0°原始點云為例,其直通濾波后的效果如圖8a所示,下采樣結果如圖8b所示。可以看出,直通濾波有效濾除了原始點云中的背景。下采樣后,點云變得稀疏,點云量減少了約91%,可極大提高后續算法的處理速度。

2.2 標定球提取結果

本文方法得到的多標定球自動提取結果如圖9所示(以0°點云為例)。可以看出,該方法可將經過直通濾波和下采樣之后場景中所有球體點云準確地提取出來。4個標定球的提取時間約為2.3 s。

圖9 標定球提取結果示例

2.3 配準結果及誤差分析

以水平0°點云為源點云,將水平90°、180°、270°及垂直向下角度的點云分別變換到0°點云坐標系下進行配準。室內場景下的甘蔗和高粱植株自動配準的結果如圖10a所示。可以看出,各方向的點云成功配準到0°點云坐標系中,植株形態完整,沒有出現明顯分層。進一步采用商用點云處理軟件LiDAR360對點云進行手動配準,結果如圖10b所示。可以看出,二者的配準效果非常接近。

受復雜環境的影響,田間場景下的配準難度更高。圖11和圖12分別展示了采用本方法及LiDAR360對大田場景下香蕉幼株的其他角度點云自動配準到0°點云的結果。可以看出,本文自動配準方法成功地實現了配準,與LiDAR360的手動配準基本一致。從提取標定球到得出配準結果這一個過程所需的運算時間上比較,本文自動匹配方法平均耗時約50 s,LiDAR360在人工選擇同名點的情況下耗時約150 s。本方法效率提高了67%。

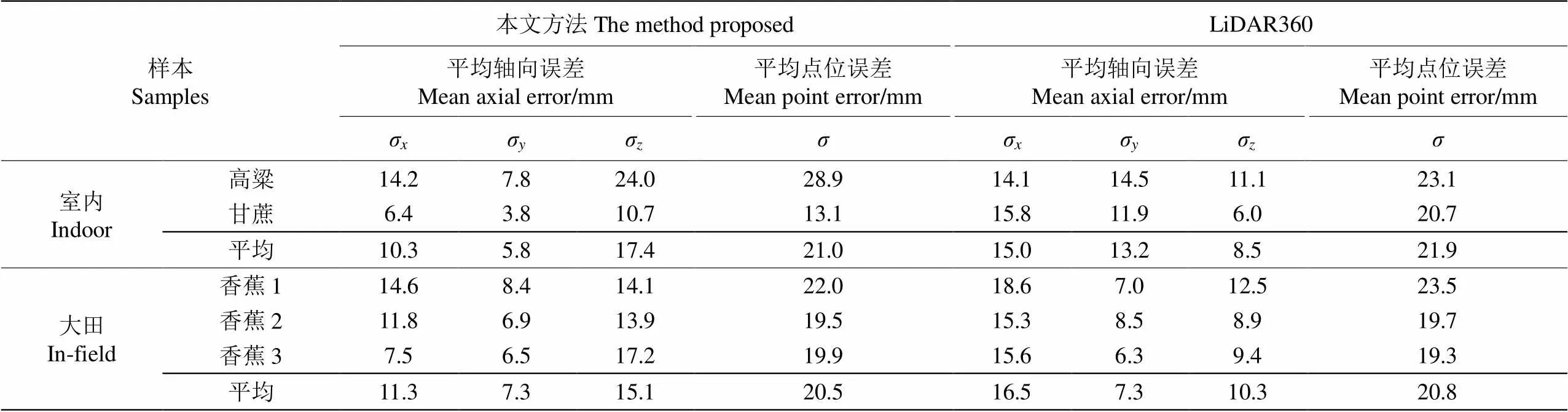

為進一步量化評價配準結果,以標定球的球心坐標為參考依據,分別計算各角度點云轉換到0°源點云坐標下的新球心坐標與源點云球心坐標之差,得到平均軸向誤差及平均點位誤差如表1所示。

Fig.11 Automatic registration results with the method proposed in this study

表1 本文提出的自動配準方法與LiDAR360手動配準方法的誤差對比

從表1可以看出,室內場景下,本文方法的平均軸向誤差最小值為5.8 mm,平均點位誤差為21.0 mm;LiDAR360手動配準的平均軸向誤差最小值為8.5 mm,平均點位誤差為21.9 mm。大田場景下,本文自動配準方法的平均軸向誤差最小值為7.3 mm,平均點位誤差為20.5 mm;LiDAR360手動配準的平均軸向誤差最小值為7.3 mm,平均點位誤差為20.8 mm。室內場景和大田場景下本文自動配準方法的平均軸向誤差在5.8~17.4 mm之間,平均點位誤差在13.1~28.9 mm之間;平均點位誤差分別比LiDAR360手動配準的結果低0.9 mm、0.3 mm。表明本文提出的方法在不同場景下均達到了商業化軟件配準水平。

經點云平滑后,香蕉幼株的三維重建結果如圖13所示,可以看出,本文方法所提取的香蕉幼株三維模型包含了清晰的立體植株幾何信息,為全面檢測植株的生長狀態奠定了技術基礎。

3 討 論

本文方法在大田環境下的平均點位誤差為20.5 mm,比LiDAR360的配準誤差略低。尤其是香蕉植株1的現場背景最復雜、環境干擾最大,但其平均點位誤差為 22.0 mm,比LiDAR360的配準誤差小4.26%,顯示出本方法針對復雜場景的良好性能。但是,從室內簡單場景下的配準結果可以看出,本文方法針對2種植株所得的平均點位誤差相差2倍以上,而LiDAR360的平均點位誤差在20~23 mm的范圍內,本文方法的穩定性還有待進一步提高。余秀麗[19]針對Kinect采集的點云,采用最小二乘法求取球面點云球心、三點法求取轉換矩陣進行粗配準,然后應用最近點迭代(Iterative Closest Point, ICP)進行精配準,最大距離誤差為18.6 mm,最小距 離誤差為7.2 mm;邵小寧[20]針對Kinect采集的點云,采用顏色分割提取待配準數據中的標定物,并去除了離散點與不符合配準要求的標定物,最后用基于歐氏距離約束的ICP算法進行精配準,最小的距離誤差為 7.13 mm。而本文提出的方法在未進行精配準的情況下,最小平均點位誤差為13.1 mm,接近以上文獻中精配準的效果。

進一步分析本文方法的誤差來源主要包括:

1)Kinect V3深度傳感器本身的設備誤差以及獲取數據的距離限制,使得原始點云數據存在一些空洞和噪點。

2)隨機采樣一致性算法具有一定的不確定性,可能會將一些并不是標定球的點歸類為靶球,從而導致提取的圓心存在偏差。

3)旋轉平移矩陣求取過程中,采用了泰勒展開,忽略了高階項,也引入一定誤差。

4)陽光、香蕉樹表面材質等環境因素會影響IR信號的反射,進而導致原始點云采集時出現一定的誤差。

本研究通過提出的多標定球自動提取方法及基于距離特征信息的同名點自動匹配方法實現了不同點云的自動化配準,相較于目前大部分商業軟件需要人工參與才能實現較好配準的情況,在配準效率上具有較大的優勢。不同植株的配準結果充分反映了本方法自動化程度高、配準誤差低,能有效滿足農作物三維建模的需求。本文方法還可結合更高精度的其他點云獲取設備實現更高質量的配準。

下一步可繼續優化算法,進一步降低點云配準的速度;還可結合改進的ICP算法等進行精配準,進一步提高點云配準的精度。

4 結 論

本文采用低成本的Kinect V3深度傳感器結合標定球實現田間復雜環境下香蕉作物植株的多角度點云采集,并通過點云預處理、自動提取標定球、自動匹配標定球、求解旋轉平移矩陣以及點云平滑等步驟實現了自動配準及香蕉植株的三維重建,主要結論如下:

1)通過直通濾波和下采樣可大量濾除背景和冗余信息,在保持原始點云特征不變的前提下顯著減少了點云的數量(減少約91%),提高了處理速度。

2)提出了一種基于距離的同名點匹配算法,并將其運用于標定球的匹配中,點云配準的效率提高了67%。

本文方法同基于公共重疊區域的配準方法相比, 能夠實現大角度的點云配準,適合在復雜多變的田間 環境作業;同基于標定球的手動配準方法相比更加自 動化。

[1] 張彥雯,胡凱,王鵬盛. 三維重建算法研究綜述[J]. 南京信息工程大學學報:自然科學版,2020,12(5):591-602.

Zhang Yanwen, Hu Kai, Wang Pengsheng. Review of 3D reconstruction algorithms[J]. Journal of Nanjing University of Information Science & Technology: Natural Science, 2020, 12(5): 591-602. (in Chinese with English abstract)

[2] 唐麗玉,張浩,黃洪宇,等. 基于點云數據的樹木三維重建方法改進[J]. 農業機械學報,2017,48(2):186-194.

Tang Liyu, Zhang Hao, Huang Hongyu, et al. Improved method for 3D reconstruction of tree model based on point cloud data[J]. Transactions of the Chinese Society for Agricultural Machinery, 2017, 48(2): 186-194. (in Chinese with English abstract)

[3] 劉振,楊瑋,李民贊,等. 基于Kinect相機的土壤表面三維點云配準方法[J]. 農業機械學報,2019,50(S1):144-149.

Liu Zhen, Yang Wei, Li Minzan, et al. Three-dimensional point cloud registration method for soil surface based on Kinect camera[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(S1): 144-149. (in Chinese with English abstract)

[4] Johnson A E, Hebert M. Using spin images for efficient object recognition in cluttered 3D scenes[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2002, 21(5): 433-449.

[5] Frome A, Huber D, Kolluri R, et al. Recognizing objects in range data using regional point descriptors[C]// European Conference on Computer Vision. Springer, Berlin, Heidelberg, 2004.

[6] Salti S, Tombari F, Stefano L D. SHOT: Unique signatures of histograms for surface and texture description[J]. Computer Vision & Image Understanding, 2014, 125: 251-264.

[7] Guo Y, Ferdous S, Bennamoun M, et al. Rotational projection statistics for 3D local surface description and object recognition[J]. International Journal of Computer Vision, 2013, 105(1): 63-86.

[8] Rusu R B, Blodow N, Beetz M. Fast point feature histograms (FPFH) for 3D registration[C]// IEEE International Conference on Robotics & Automation. IEEE, 2009.

[9] 楊玉澤,孫英偉,林文樹. 基于FPFH特征和NDT算法 的樹木點云配準[J]. 西北林學院學報,2019,34(5):141-146.

Yang Yuze, Sun Yingwei, Lin Wenshu. Tree point cloud registration based on FPFH feature and NDT algorithm[J]. Journal of Northwest Forestry University, 2019, 34(5): 141-146. (in Chinese with English abstract)

[10] 鄭立華,麥春艷,廖崴,等. 基于Kinect相機的蘋果樹三維點云配準[J]. 農業機械學報,2016,47(5):9-14.

Zheng Lihua, Mai Chunyan, Liao Wei, et al. 3D point cloud registration for apple tree base on Kinect camera[J]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(5): 9-14. (in Chinese with English abstract)

[11] Garrido M, Paraforos D, Reiser D, et al. 3D maize plant reconstruction based on georeferenced overlapping LiDAR point clouds[J]. Remote Sensing, 2015, 7(12): 17077-17096.

[12] Chebrolu N, Magistri F, L?be T, et al. Registration of spatio-temporal point clouds of plants for phenotyping[J]. PLoS One, 2021, 16(2): e0247243.

[13] Yu X, Song H, Wang S. Capture of multi-view point clouds and registration of plants based on Kinect[J]. International Agricultural Engineering Journal, 2016, 25(1): 74-84.

[14] Zhou S, Kang F, Li W, et al. Point cloud registration for agriculture and forestry crops based on calibration balls using Kinect V2[J]. International Journal of Agricultural and Biological Engineering, 2020, 13(1): 198-205.

[15] Fischler M A, Bolles R C. Random sample consensus: A paradigm for model fitting with applications to image analysis and automated cartography[J]. Communications of the ACM, 1981, 24(6): 381-395.

[16] 鄒際祥. 基于KD-TREE加速的點云數據配準技術研究[D]. 合肥:安徽大學,2013.

Zou Jixiang. The Research of Point Cloud Data Registration Technique Based on KD-Tree Acceleration[D]. Hefei:Anhui University, 2013. (in Chinese with English abstract)

[17] Sorkine O, Rabinovich M. Least-squares rigid motion using SVD [J]. Computing, 2017, 1(1): 1-5.

[18] 曾清紅,盧德唐. 基于移動最小二乘法的曲線曲面擬合[J]. 工程圖學學報,2004,25(1):84-89.

Zeng Qinghong, Lu Detang. Curve and surface fitting based on moving least square method[J]. Journal of Engineering Graphics, 2004, 25(1): 84-89. (in Chinese with English abstract)

[19] 余秀麗. 基于Kinect的蘋果樹三維重建方法研究[D]. 楊凌:西北農林科技大學,2016.

Yu Xiuli. Reconstruction of Apple Tree Based on Kinect[D]. Yangling: Northwest A&F University, 2016. (in Chinese with English abstract)

[20] 邵小寧. 基于Kinect的植物三維點云獲取與重建方法研究[D]. 楊凌:西北農林科技大學,2016.

Shao Xiaoning. Research on 3D Point Cloud Acquisition and Reconstruction of Plants Based on Kinect[D]. Yangling: Northwest A&F University, 2016. (in Chinese with English abstract)

Field plant point cloud registration method based on Kinect V3 depth sensors

Li Xiuhua1,2, Wei Peng1, He Jiaxi1, Li Minzan3, Zhang Muqing2, Wen Biaotang4

(1.530004,;2.530004,; 3.100083,; 4.530001,)

An accurate modeling of three-dimensional (3D) point cloud has been a crucial step to extract the physical phenotyping parameters of plants, such as the plant height, leaf quantity, and leaf area. In this study, an automatic registration of point clouds with multiple calibration balls was proposed to realize the 3D modeling of plants under a complex background in the field. A low-cost depth sensor (such as Kinect V3) was also selected to capture the images. The performance of the registration was then evaluated using the multiple angles of several plants under the indoor and in-field scenes. Four procedures were included the point cloud filtering and down sampling, multiple calibration balls extraction, correspondence points matching, as well as the calculation and registration of transformation matrix. 1) The pass-through filtering with only several boundary thresholds was used to reduce the noises, while the bounding box compression was used to down sampling the point clouds. 2) A Random Sampling Consistency (RANSAC) was also used in the multiple calibration balls extraction. Furthermore, a concept of point cloud subtraction was proposed to combine with the RANSAC, in order to form an automatic extraction of multiple calibration balls. Among them, the RANSAC was utilized to extract one single object at one time. As such, the center coordinates of each calibration ball were then calculated as the featured points. 3) The distances of any two feature points were calculated in the correspondence points matching. An automatic matching of correspondence points using the distance information was also proposed to realize the self-matching of the calibration balls. 4) The singular value decomposition was adopted to solve the transformation (rotation and translation) matrix, and then the registration of two pieces of point clouds was realized eventually. The experiments were carried out in two scenes: one was the indoor scene with the flat and clean surface, and another was the field scene with the uneven and complex conditions. Five plants were chosen as the research objects, including one sugarcane (indoor), one sorghum (indoor), and three young banana plants (in-field). The Kinect V3 sensor was utilized to capture the point clouds of each object in five orientations (the horizontal orientation of 0o, 90o, 180o, 270o, and one vertical orientation). A commercial point cloud processing software named LiDAR360 was adopted for comparison with the man-aid registration. After that, the object point clouds (horizontal 90°, 180°, 270°, and vertical) of each plant was used to implement the registration into the coordinate system of the source point cloud (horizontal 0°). The registration performance was evaluated to calculate the axial errors and point errors of the transformed coordinates, as well as the source coordinates of the centers of all the calibration balls. The results showed that the registration of different point clouds was successfully implemented in the different orientations, no matter in the indoor or in-field environment. Particularly, the generated 3D model of the plant was clear in shape. Specifically, there were an average axial error of 5.8-17.4 mm and an average point position error of 13.1-28.9 mm for the registration in the different scenes, similar to the registration in the manual registration software LiDAR360. In the required calculation time, the automatic matching took about 50 s on average for the process from the extraction of calibration sphere to the registration, whereas, the LiDAR360 took about 150 s with the manual selection of the correspondence points, indicating the efficiency increased by 67%. Consequently, it can be widely expected to serve a high-precision and automatic registration of plant point clouds acquired by low-cost depth cameras in complex field environments. The finding can provide a low-cost feasible solution for the 3D modeling and the extraction of phenotyping parameters of field plants.

automation; sensors; point cloud; plant 3D modeling; point matching; RANSAC; Kinect

10.11975/j.issn.1002-6819.2021.21.006

S24

A

1002-6819(2021)-21-0045-08

李修華,魏鵬,何嘉西,等.基于Kinect V3深度傳感器的田間植株點云配準方法[J]. 農業工程學報,2021,37(21):45-52.doi:10.11975/j.issn.1002-6819.2021.21.006 http://www.tcsae.org

Li Xiuhua, Wei Peng, He Jiaxi, et al. Field plant point cloud registration method based on Kinect V3 depth sensors[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(21): 45-52. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.21.006 http://www.tcsae.org

2021-07-14

2021-10-15

廣西科技重大專項(桂科AA18118037、桂科2018-266-Z01);國家自然科學基金項目(31760342)

李修華,博士,副教授,研究方向為作物長勢及表型檢測。Email:lixh@gxu.edu.cn