基于Faster-RCNN的肝細胞癌與肝內膽管細胞癌多模態MR影像智能腫瘤識別與分類診斷模型構建

雷 磊,李俊杰,王倩梅,趙 鵬,劉傳明

肝癌是世界范圍內病死率最高的惡性腫瘤[1-3],每年有800 000~1 000 000死于肝細胞肝癌(HCC)及相關疾病[4]。原發性肝癌(PLC)從組織學類型上可分為HCC和肝內膽管細胞癌(ICC)[5-6]。由于兩種腫瘤治療策略不同,科學合理的鑒別診斷,對疾病后續治療有著重要的指導意義。MR增強掃描因具有軟組織分辨率高、對比度高、成像參數多等優勢,在HCC/ICC的鑒別診斷中起重要作用[7]。但MR增強掃描在臨床應用中仍存在一些問題,一方面人工影像鑒別準確率有進一步提升的空間,另一方面其模式多、時相多,在一定程度上增加了判讀的復雜性。當前,以區域卷積神經網絡(RCNN)為代表的深度學習方法已廣泛應用于醫學圖像識別領域,在病變識別和性質判斷上取得了諸多成果。Faster-RCNN是在RCNN基礎上的重要改進,其將特征提取、邊框回歸、分類等任務整合到同一個網絡中,極大提高了網絡的綜合性能[5]。本研究擬將不同時相的MR圖像進行配準、融合,以Faster-RCNN為主要方法,對HCC和ICC的MR增強掃描圖像進行腫瘤范圍識別及性質分類,旨在為臨床轉化、協助診療工作提供幫助。

1 資料與方法

1.1一般資料 選取2017年1月—2020年1月于我院接受肝臟切除手術治療,經術后病理明確診斷為HCC或ICC(不包括HCC-ICC混合型),且術前4周內于我院接受腹部MR增強掃描156例。排除標準:①合并肝臟良性占位性病變(肝血管瘤、肝囊腫、肝臟局灶性結節增生等)者;②患者在采集圖像過程中出現較大體位變化,導致MR不同時期圖像之間難以配準;③圖像質量不佳。

1.2圖像采集 所有入組患者使用3.0T MR儀進行掃描。增強掃描序列包括動脈期、靜脈期、延遲期。序列切片厚度為5 mm、間隔1.5 cm、圖像大小510×420像素。所有圖片使用DICOM格式收集并存儲。存儲時,以患者手術標本的病理診斷為訓練標簽。

1.3圖像標注及配準 使用MR圖像中的動脈期、靜脈期、延遲期圖像及融合圖像進行訓練。所有圖像感興趣區域(ROI)由有經驗的專科醫師使用SLICE軟件進行標注。標注時,首先選取一個序列的影像,在橫斷面、冠狀面、矢狀面中任選兩個方向(SLICE軟件可以通過一個方向的圖像序列,根據切片厚度生成其他方向的圖像),在腫瘤截面積最大的層面對腫瘤進行矩形標注。標注原則:①矩形標注框應完全包含腫瘤范圍;②在滿足①的前提下,標注框面積應盡可能小;③當腫瘤邊界不清時,標注框應盡可能完整包含疑似腫瘤的部分。在完成一個序列的標注后,SLICE軟件可以生成立方體的三維標注框。在同一患者其他序列的影像標注中,不調整該立方體標注框的大小,僅調整其空間位置,使其可以包含新序列中的腫瘤區域。必要時調整標注框。標注完成后輸出標注框在影像序列中的坐標位置并保存。

使用image_registration軟件中的chi2_shift方法對圖像進行配準。為提高配準的準確性,首先將不同模態的影像依次沿X軸連接,配準后融合動脈期、靜脈期及延遲期圖像,按圖像尺寸裁剪。最終獲得融合后的420×510×3矩陣用于訓練。

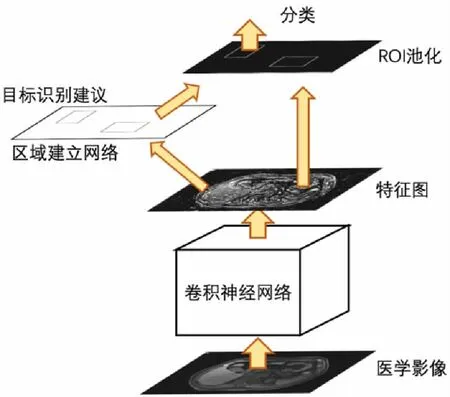

1.4Faster-RCNN模型訓練 結合MR影像數據特征采用Faster-RCNN模型訓練[8]。Faster-RCNN基本原理是將選擇候選區域、提取特征、分類與邊界回歸等步驟融合到一個神經網絡中進行,其結構包括Faster-RCNN、區域建立網絡(RPN)和卷積神經網絡(CNN),見圖1。在訓練過程中,當圖片輸入模型后,通過CNN提取圖像特征,一個分支將特征圖輸入池化層,另一個分支將特征圖輸入RPN,得到2000個候選框后送入池化層,分別提取各候選框特征。最后通過全連接層進行分類計算和邊框回歸確定候選范圍。

圖1 Faster-RCNN基本結構

1.6統計學方法 使用Dice系數作為腫瘤目標識別準確性的評價指標,當測試結果框選范圍與預先標記的腫瘤范圍Dice系數≥50%時,認為腫瘤位置判斷準確;隨后判斷該區域的分類是否準確,以精確率及召回率作為評價指標。精確率=真陽性/(真陽性+假陽性)×100%,召回率=真陽性/(真陽性+假陰性)×100%。臨床數據的統計學分析使用SPSS 23.0軟件,計數資料以率(%)表示,比較采用χ2檢驗。α=0.05為檢驗水準。

2 結果

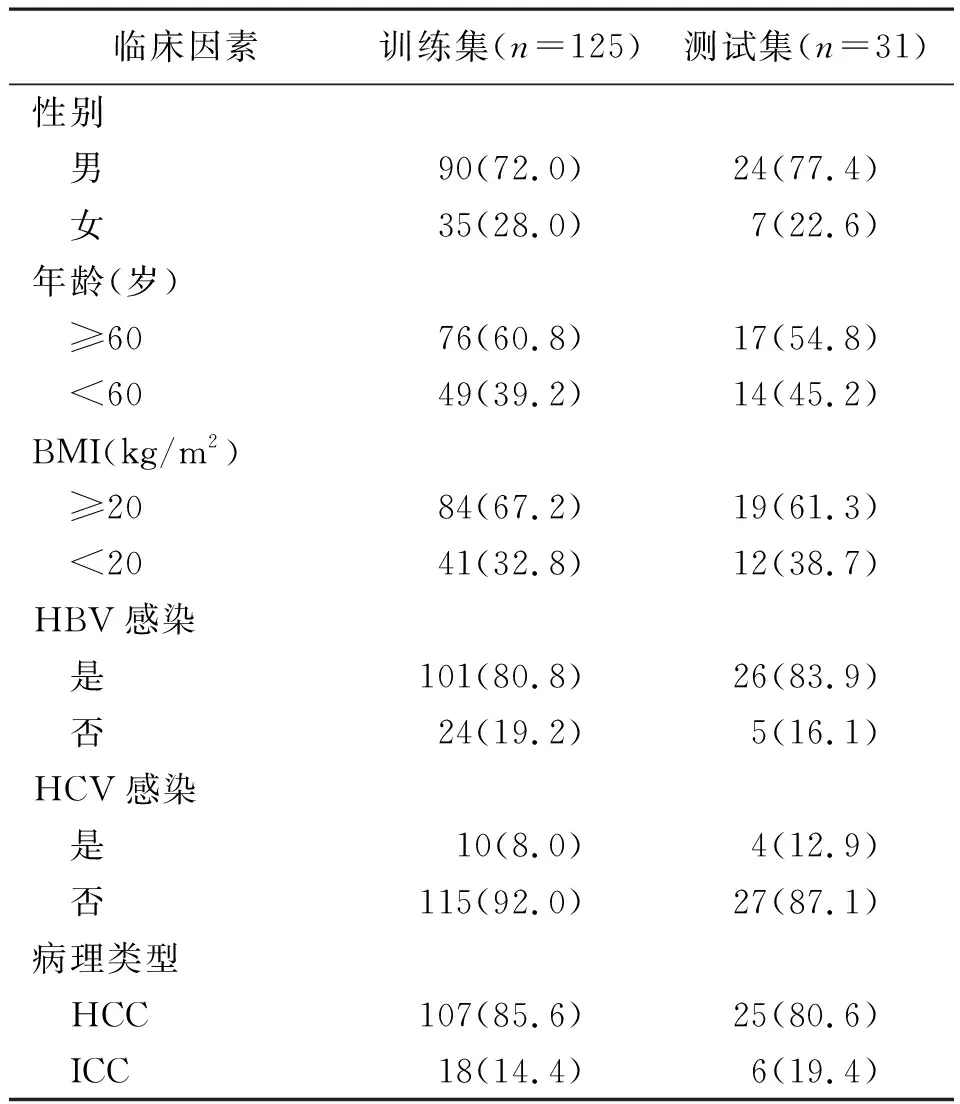

2.1訓練集和測試集患者臨床資料比較 納入訓練集和測試集影像數據來自156例患者,隨機選取其中125例(80.1%)作為訓練集,31例(19.9%)作為測試集。患者動脈期、靜脈期、延遲期圖像序列均包含88張圖像。訓練集和測試集患者在性別、年齡、體質量指數、乙型肝炎病毒感染、丙型肝炎病毒感染及病理類型構成上均無顯著差異(P>0.05),見表1。

表1 訓練集和測試集患者臨床資料比較[例(%)]

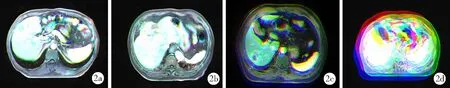

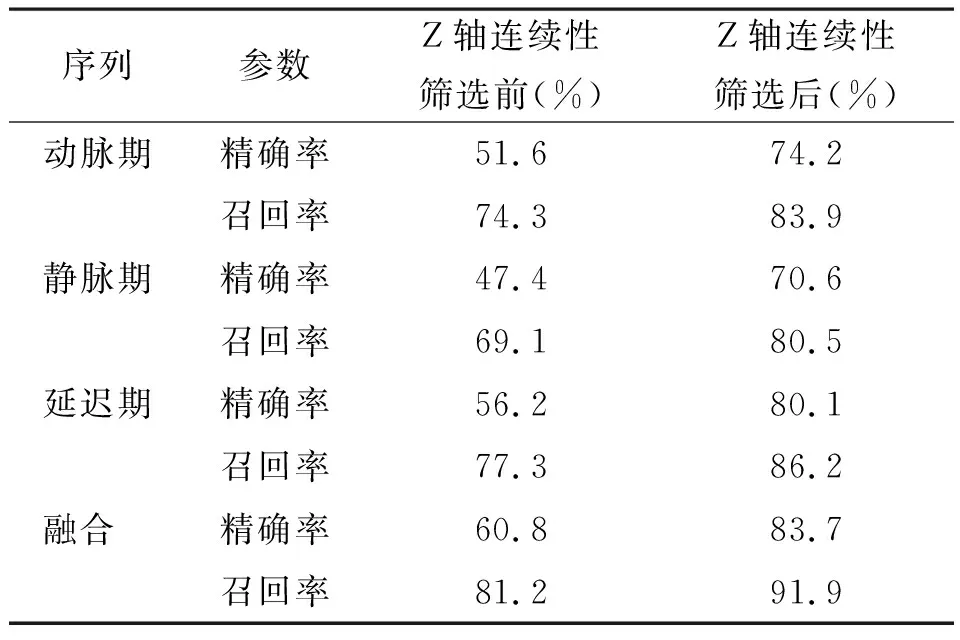

2.2目標識別測試結果 Faster-RCNN使用TensorFlow實現。分別針對單一序列圖像及融合后圖像(圖2)進行訓練,以學習率=10-4進行優化。在單一序列訓練中,最終迭代次數為20 000次;在融合圖像訓練中,迭代次數為30 000次。Faster-RCNN在每張圖片中輸出2000個候選框,保留其中置信度>0.7的候選框。在Z軸連續性篩選中,如連續2個層面中識別的腫瘤候選框范圍Dice系數≥50%認為是真陽性,否則判斷為假陽性(圖3)。目標識別準確性判斷中,使用輸出的識別框與預先標記的識別框比較,如二者Dice系數≥50%認為判斷正確,否則認為判斷錯誤。目標識別結果見表2。結果可見無論是單一序列圖像還是融合圖像,Z軸連續性篩選均提高了精確率和召回率。在單一序列測試中,延遲期圖像在經Z軸連續性篩選前、篩選后均獲得了最高的精確率和召回率。

圖2 圖像配準及融合示例

圖3 腫瘤目標范圍識別示例

表2 目標區域識別結果

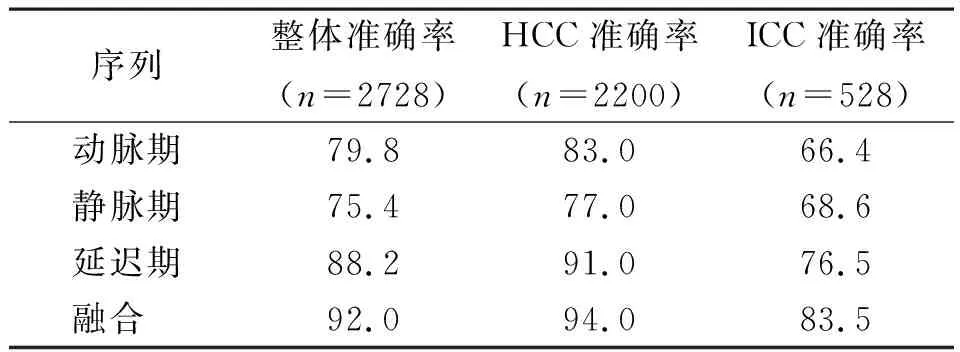

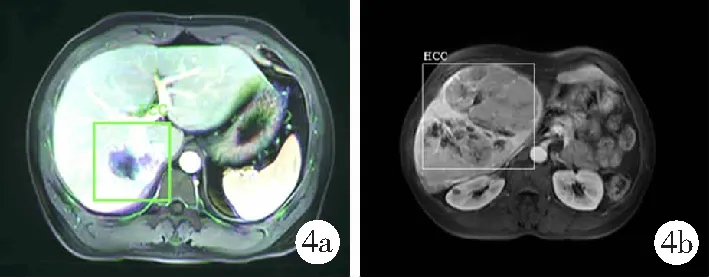

2.3分類診斷測試結果 測試中,存在部分圖像ROI區域識別結果錯誤,但分類診斷結果正確。實際應用中此類識別結果不具有價值,因此僅當ROI區域識別結果正確且分類診斷結果正確時,才認為判斷結果正確(圖4)。在單一序列判別結果中,延遲期圖像整體分類診斷準確率及HCC、ICC分類診斷準確率均最高,而融合圖像準確率則高于單一序列圖像。見表3。

表3 圖像層面分類診斷測試結果(%)

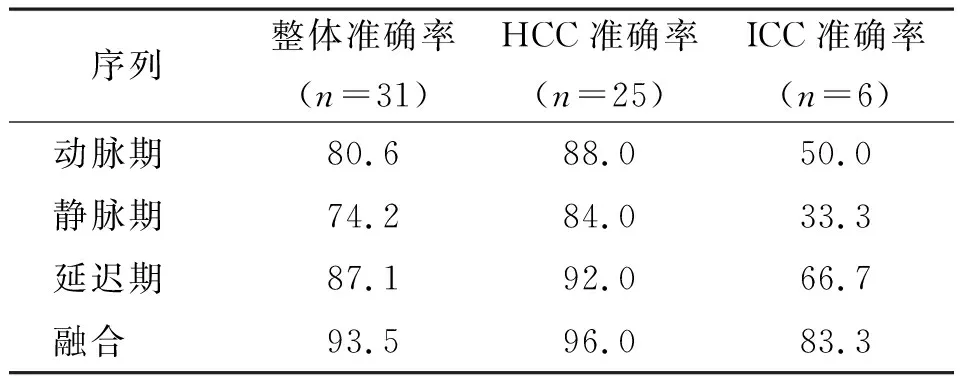

因同一位患者的不同層面結果可能存在差異,使用加權投票法對患者層面分類診斷結果進行綜合判斷,即以各層面分類診斷結果置信度作為投票權重,以最終的投票結果作為患者的疾病診斷結果。加權投票后,動脈期、靜脈期、延遲期HCC分類準確率均高于加權投票前,ICC分類準確率低于加權投票前,加權投票提高了整體準確率。見表3、4。融合圖像整體分類診斷準確率為93.5%,HCC分類診斷準確率達96.0%,ICC分類診斷準確率達83.3%。見表4。

圖4 腫瘤分類結果示例

表4 患者層面(加權投票后)分類診斷測試結果(%)

3 討論

近年來,以深度神經網絡為代表的人工智能技術在醫學領域展現出巨大的應用潛能。相較于傳統統計分析方法,神經網絡更善于挖掘高維度、復雜數據間的內在聯系,目前已經在臨床診斷、預后分析等領域得到應用。CNN具有良好的圖像特征提取及分類能力[9-10]。ESTEVA等[11]使用深度神經網絡對皮膚惡性腫瘤分型進行圖像識別,受試者工作特征曲線下面積(AUC)、診斷特異度和敏感度均較高。而利用遷移學習法對眼科影像進行智能識別,在提高AUC的同時,還極大降低了模型訓練對樣本量的要求[12]。

RCNN是第一個成功將深度學習應用到目標檢測中的方法。RCNN的檢測思路與傳統目標檢測方法類似,均使用框提取、特征提取、圖像分類、非極大值抑制4個步驟[13]。在特征提取步驟中,由于使用CNN,可以提取更多的圖像信息,因此較傳統方法大幅提高了目標檢測的準確率。RCNN發明者Girshick于2016年提出了Faster-RCNN模型,在網絡結構上將特征提取、邊框回歸、分類任務整合在一個網絡中,極大提高了檢測速度及模型綜合性能[14]。本研究的目標識別及分類任務基于Faster-RCNN模型,該模型在單一圖像的目標識別中可以識別多個目標。由于HCC/ICC患者常合并肝囊腫、肝血管瘤等良性疾病;同時由于合并肝硬化患者較多,常在肝臟圖像中出現異常成像區域。因此在單層面圖像水平的目標識別中可能存在較多假陽性結果。為解決這一問題,本研究采用Z軸連續性篩選,根據腫瘤的形態特征,將在Z軸中孤立的識別結果判斷為假陽性,經過Z軸連續性篩選后的識別精確率和召回率均顯著高于篩選前,尤其精確率得到大幅提高,證實該方法可以有效降低識別的假陽性率。

MR增強掃描較MR平掃可以顯著提高診斷準確率。在臨床工作中,HCC與ICC在MR增強掃描中的鑒別診斷需要結合不同序列影像進行判斷。本研究在對單一序列圖像進行識別的同時,提出將動脈期、靜脈期及延遲期影像進行融合,旨在增加單一圖像所包含的信息,以提高目標識別和分類的準確性[15]。為解決單一層面圖像配準效果不理想的問題,本研究將一個序列中的圖像按順序連接后進行圖像配準,該方法增加了單一圖像中的特征,在不改變圖像基本形狀的同時,獲得了較為理想的配準效果,融合后的圖像無論在目標識別和分類性能方面均優于單一序列。

為進一步提升模型性能,結合患者臨床特征,本研究提出使用加權投票的方法對患者腫瘤分類進行整體判斷[16-17]。盡管該方法提高了整體判斷準確率,尤其是在融合圖像中整體準確率達93.5%、HCC判斷準確率達96.0%;但在ICC的判斷中,準確率卻出現下降,單一序列的判斷結果不理想,只有融合圖像判斷準確率達到了83.3%,可能原因為ICC測試集中患者水平樣本量較少(6例),導致結果波動較大;訓練中HCC與ICC樣本量不平衡(85.6% vs 14.4%)。更加平衡的數據可能會獲得更好的分類性能,這是本研究的主要局限性之一;此外,本研究還需進一步擴大樣本量以提升模型的穩定性和可靠性。

綜上,本研究通過Faster-RCNN模型,使用經配準、融合后的多模態MR影像數據,結合Z軸連續性篩選、加權投票方法,構建了一種可以高效、準確對HCC/ICC患者進行腫瘤區域識別及分類診斷的模型。該模型具有較強的臨床轉化潛力,進一步完善后有望協助相關醫生進行HCC/ICC的識別及鑒別診斷工作。