基于視差優化的立體匹配網絡

劉建國,紀 郭,顏伏伍,沈建宏,孫云飛

(1.先進能源科學與技術廣東省實驗室佛山分中心(佛山仙湖實驗室),廣東 佛山 528200;2.武漢理工大學 現代汽車零部件技術湖北省重點實驗室,武漢 430070;3.汽車零部件技術湖北省協同創新中心,武漢 430070;4.湖北省新能源與智能網聯車工程技術研究中心,武漢 430070;5.寧波華德汽車零部件有限公司,浙江 寧波 315000)

0 概述

隨著圖像處理技術的發展,基于視覺的深度估計逐漸發展成為無人駕駛、機器人等領域的重要測距方法之一,其中基于立體匹配的雙目測距方法以兼顧精度、速度和成本的優勢受到廣泛關注,該方法通過匹配同一場景的左右視點兩幅圖像中的相應像素點來計算視差,并根據相似三角形原理計算深度距離。傳統的立體匹配算法將匹配過程劃分為匹配代價計算、代價聚合、視差計算和視差優化4 個部分[1],并基于代價函數的約束范圍及搜索策略分為局部、全局和半全局立體匹配算法[2]。但傳統算法采用手工設計的特征描述符,缺乏全局上下文信息,且受經驗參數的影響,算法魯棒性較差,不適合在復雜環境下應用[3]。

近年來,隨著深度學習在計算機視覺領域中的發展,研究人員開始基于深度學習方法解決立體匹配問題。LECUN 等[4]引入卷積神經網絡提取左右圖特征,通過學習兩者的相似性計算匹配代價,有效提高了算法魯棒性,但該方案仍然需要配合傳統算法中的十字交叉代價聚合[5]、半全局優化[6-7]及濾波操作等完成立體匹配。LUO 等[8]在此基礎上將匹配代價計算轉化為多分類問題,訓練網絡直接輸出所有潛在視差值下的匹配代價,大大提高算法效率。

上述方法利用卷積神經網絡計算匹配代價減少了傳統算法中手工設計特征的誤差,但仍需結合傳統算法中的其他步驟求解視差圖,運行速度較低。因此基于卷積神經網絡的端到端立體匹配算法應運而生。MAYER 等[9]提出以左右圖像為輸入,以視差圖為輸出的端到端立體匹配網絡DispNet,并發布一個帶有真實視差圖的大型合成數據集用于訓練網絡。在此基礎上,KENDALL 等[10]提出GCNet,首次通過級聯不同視差值下的特征圖構建匹配代價卷,并通過3D 卷積進行代價聚合,最終通過視差回歸的方式計算視差圖,為后續算法發展提供重要思路。PANG 等[11]提出一種兩階段網絡結構,第1 階段學習初始視差,第2 階段學習修正初始視差的殘差,最終將兩階段的和作為結果輸出,有效提高匹配精度。CHANG 等[12]提出PSMNet 網絡,利用空間金字塔池化(Spatial Pyramid Pooling,SPP)模塊[13]融合不同尺度特征,同時采用堆疊的編碼解碼結構進行代價聚合,有效提高了視差預測精度。ZHANG 等[14]基于傳統的半全局匹配算法提出GANet,設計了半全局,引導聚合層從不同方向對代價卷進行聚合取代3D 卷積,并結合局部引導聚合層,有效提升立體匹配的性能。MA 等[15]結合光流、視差估計及實例分割3 種任務,將各個實例的光流、視差及語義線索編碼成能量函數進行最小化求解,實現多任務間互相融合,但運行時間過長。XU 等[16]采用3D 代價卷并設計尺度內及尺度間代價聚合模塊代替3D 卷積,有效提高算法實時性,但匹配精度相對較低。ZHU 等[17]基于多尺度特征,設計十字形空間金字塔模塊以不同的比例和位置聚合上下文信息構建代價卷,并設計多尺度3D 特征匹配和融合模塊聚合代價卷,有效提高算法在不適定區域的匹配精度。

隨著高性能計算平臺的發展,立體匹配的網絡結構更加復雜,特征提取及代價聚合網絡不斷加深。深層網絡有助于提取更加抽象的特征,對于目標檢測、語義分割等對語義信息要求較高的視覺任務具有重要意義。但立體匹配作為低層級視覺任務,除了依賴深層特征完成前景物體的基本匹配,還需要淺層特征和局部上下文信息細化小物體、邊緣等區域的匹配。而大多數立體匹配網絡采用深層特征提取網絡和堆疊的編碼解碼結構,在反復上下采樣過程中造成淺層特征中的細節信息丟失。同時,傳統的代價卷構造方式對每個像素的完整視差范圍都構建匹配代價進行計算,雖然通過稀疏化視差的方式可以降低計算量,但是仍然造成代價卷在非真實視差處的計算冗余。

針對上述問題,本文引入視差優化思想,基于PSMNet 構建一種改進網絡CTFNet。采用特征提取網絡分別提取下采樣程度不同的淺層和深層特征,基于深層特征構建所有潛在視差值范圍內的全局稀疏代價卷,并通過代價聚合和視差計算預測初始視差圖。此外,基于局部上下文信息豐富的淺層特征和初始視差圖,對每個像素點構建初始預測視差鄰域范圍內的局部稠密代價卷,并通過簡單的代價聚合和視差計算進行視差優化。在損失函數部分,本文基于文獻[18]引入softmax 操作后的概率分布損失函數,在預測初始視差圖過程中通過限制每個像素點處視差值概率,使其分布在真實視差值附近,形成高斯分布,提高初始視差圖精度,保證視差優化階段利用初始視差圖構造局部稠密代價卷的可靠性,從而優化視差圖精度。

1 網絡結構

本文以PSMNet 作為骨干網絡進行改進,其網絡結構如圖1(a)所示(彩色效果見《計算機工程》官網HTML 版)。PSMNet 采用殘差網絡和空間金字塔池化(SPP)模塊提取特征,其中殘差網絡由3 個3×3 卷積層和4 個殘差塊共53 層卷積層構成,配合SPP 模塊可以得到多尺度深層特征,基于左右特征圖構建的匹配代價卷通過3 個相同的編碼-解碼結構進行聚合并實現多級監督,最終視差回歸得到預測視差圖。PSMNet 的特征提取網絡相對復雜,計算成本高,且三次編碼-解碼結構始終對完整視差范圍的代價卷進行聚合,造成計算冗余。基于上述問題,本文提出一種改進后的立體匹配網絡CTFNet,其網絡結構如圖1(b)所示,由特征提取、初始視差圖預測和視差優化3 部分構成。

圖1 PSMNet 與CTFNet 網絡結構對比Fig.1 Comparison of PSMNet CTFNet network structures

1.1 特征提取

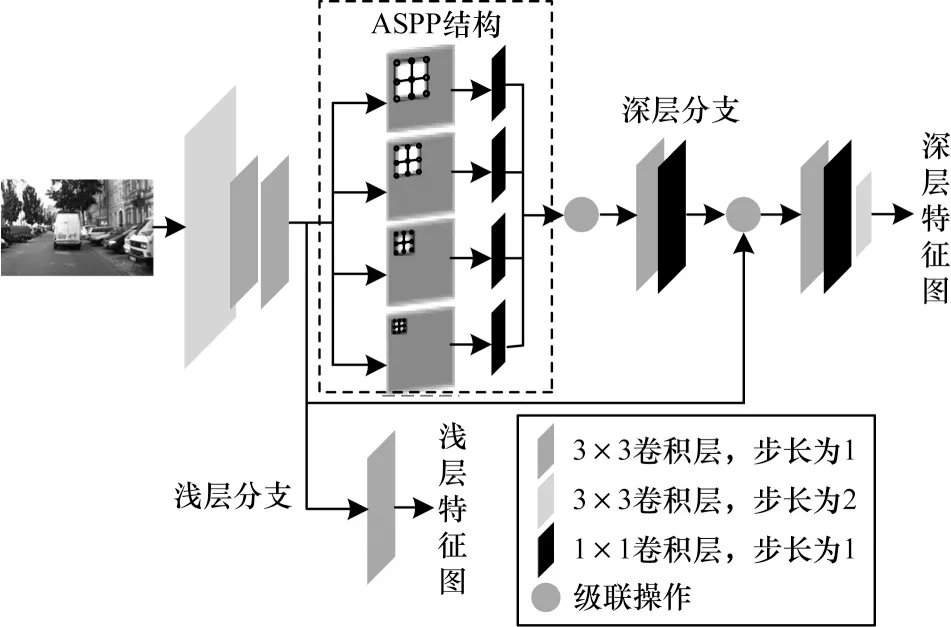

相對于目標檢測、語義分割等視覺任務,立體匹配對于特征的抽象程度要求相對較低,而且更加注重全局信息與局部細節信息的結合,全局信息有利于保證前景物體匹配精度和視差的連續性,局部細節信息對于提高不適應區域如小物體、邊緣等區域的匹配精度具有重要作用。因此與PSMNet 網絡所采用的復雜特征提取結構不同,本文采用深淺層特征兩階段輸出的特征提取網絡。具體來說,由淺層特征提取結構和深層特征提取結構組成,如圖2所示。

圖2 特征提取網絡結構Fig.2 Structure of feature extraction network

淺層特征提取結構由3 個卷積核尺寸為3×3 的卷積層構成,每個卷積層后都跟隨著批標準化層和ReLU 激活函數層,其中第1 個卷積層步長為2,將圖像下采樣尺寸設置為原圖尺寸的1/2,其他卷積層步長均為1,以保留更多的空間細節信息。將淺層特征提取模塊輸出的初始特征圖用來繼續提取深層多尺度特征,同時也經過卷積核尺寸為3×3 卷積層對通道進行調整,并將得到的淺層特征圖輸出到視差優化階段,從而構建局部稠密代價卷。

將深層特征提取結構引入多孔空間金字塔池化(ASPP)結構[19],以提取多尺度空間信息,并分別通過卷積核尺寸為1×1 的卷積操作實現跨通道信息整合。每個卷積操作后面都同樣跟隨批標準化層和激活函數層,最終采用級聯的方式將包含不同尺度信息的特征圖級聯起來。ASPP 結構的使用可以保證使用較少的卷積層實現較大的感受野,有利于匹配對全局信息要求較高的前景物體。級聯后的多尺度特征經過卷積核尺寸為3×3 及1×1 的卷積層后與初始特征圖級聯,再通過卷積核尺寸為3×3 及1×1 的卷積層以及一個卷積核大小為3、步長為2 的卷積層下采樣得到最終輸出的1/4 原圖大小的深層特征圖,并用作初始視差圖預測。

1.2 初始視差圖預測

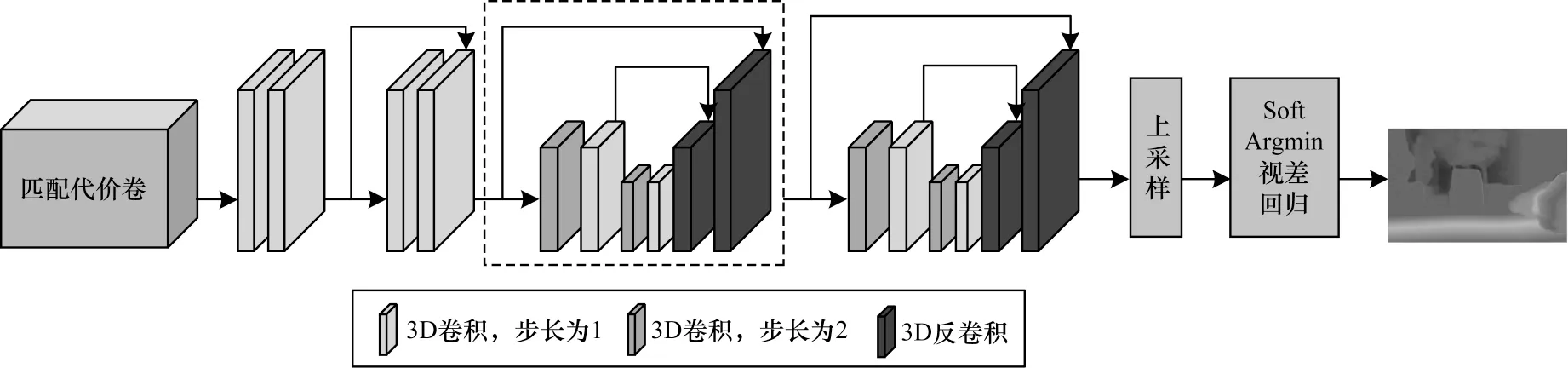

經過共享權重的特征提取網絡得到左右特征圖后,本文將每個潛在視差值下的左圖特征和對應右圖下的特征級聯起來,封裝成一個4 維的匹配代價卷。針對4 維代價卷,本文采用3D 卷積來聚合上下文信息并通過編碼-解碼結構聚合匹配代價卷。如圖3 所示,通過4 個3D 卷積層對匹配代價卷進行初步的代價聚合,為了補充淺層特征信息,將第2 次卷積的結果與第4 次卷積的結果進行跳躍連接。接著,采用基于3D 卷積的編碼-解碼結構對代價卷進行聚合。編碼-解碼結構如圖3 中虛線框所示,編碼與解碼階段分別使用2 個步長為2 的3D 卷積與3D反卷積進行下/上采樣,提高對全局信息的利用程度并降低計算量。為彌補上下采樣引起的局部上下文信息的損失,在反卷積時將編碼階段對應尺寸大小的代價卷通過跳躍連接與解碼階段的代價卷進行連接。本文采用2 個編碼-解碼結構串聯使用進行代價聚合和多級監督,將每個編碼-解碼結構輸出的匹配代價卷,通過線性插值的方式上采樣到原圖尺寸,用作視差回歸。

圖3 初始視差圖預測網絡結構Fig.3 Structure of initial disparity map prediction network

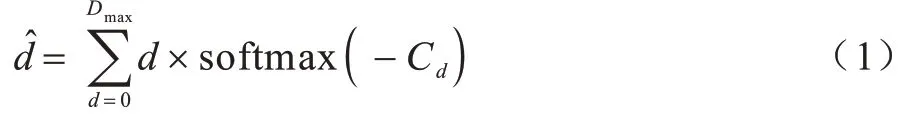

本文采用完全可微的Soft Argmin[10]操作進行視差回歸,將預測的匹配代價Cd取負,把匹配代價轉化為匹配可能性(匹配代價越高,可能性越低),然后使用softmax 操作進行歸一化,輸出每個像素在不同視差值d下的概率,最終基于概率對視差進行加權求和得到預測視差值,如式(1)所示:

其中:d表示預測視差值;Dmax表示最大視差;Cd表示在視差d下的匹配代價;soft max(·)表示softmax 操作,其數學表達式如下:

1.3 視差優化

網絡采用左右特征圖構造全局稀疏視差值(0,4,…,Dmax,Dmax=192)下的代價卷,經過2 個沙漏結構聚合后通過上采樣和視差回歸得到與原圖分辨率相同的初始視差圖。代價聚合過程中,用于視差回歸的代價卷需要通過插值的方式恢復到原圖尺寸和完整稠密視差值范圍(0,1,…,Dmax,Dmax=192),這就使最終的視差結果在目標邊緣、小物體等細節區域引入大量誤差。同時,由于特征圖經過多次編碼-解碼結構,其特征隨著網絡的加深不斷抽象,最終的結果在前景物體的匹配精度指標上表現良好,但是針對背景物體或小物體,由于其對上下文細節信息要求較高,因此匹配誤差率會顯著增大。基于上述問題,本文提出基于淺層特征和局部稠密代價卷的視差優化模塊。

為降低反復上下采樣對局部細節信息造成的損失,本文在視差優化階段采用特征提取階段的1/2 原圖尺寸的淺層特征圖構造新代價卷。為減少冗余計算,提高視差回歸精度,本文利用初始視差圖預測階段輸出的原圖尺寸的視差圖構造局部稠密代價卷,僅針對預測視差值附近的視差范圍求解詳細的概率分布。基于初始預測的視差圖,本文將每個像素的預測視差值線性擴展為其鄰域內的2n個視差從而構造預測視差卷,其中n為超參數。假設某像素點初始預測視差為d′,則以[d′-n,d′+n]作為該點的局部視差范圍,并限制其不超出[0,Dmax]。然后將該視差范圍平均劃分為2n個視差值作為候選視差。由于初始視差值是亞像素級的,而傳統構造方式只能對視差值為整數的情況進行代價卷構造,因此本文采用一種新的代價卷構造方式,如圖4 所示(彩色效果見《計算機工程》官網HTML 版)。

圖4 新代價卷構造方式示意圖Fig.4 Schematic diagram of construction mode of new price volume

如圖4 所示,假設左右特征圖組通道數均為C,以同為C0通道的左右特征圖為例,由于特征圖尺寸為原圖的1/2,因此首先需要將視差卷下采樣至原圖的1/2 尺寸,同時所有視差值相應除以2。然后將C0通道的左特征圖復制2n次作為第C0通道的代價卷,將右特征圖基于視差卷進行warp 翹曲操作[20]得到第C+C0通道的代價卷。其中warp 翹曲操作如圖5所示。首先,根據視差圖計算得到1 個與左特征圖尺寸相同的坐標網格,網格中每一點(x,y)的值為左特征圖中(x,y)處的像素點在右特征圖中的對應匹配點的坐標(x-d,y),其中d代表該點候選視差值。然后,利用坐標網格將右特征圖中匹配點(x-d,y)處的像素值全部填充到左特征圖的(x,y)處,從而產生1 張新的特征圖。由于視差值d為亞像素級,則計算得到的坐標(x-d,y)不一定是整數值,因此要用插值的方式從(x-d,y)鄰域的像素值得到(x-d,y)處的像素值。將第C0通道的右特征圖基于所有候選視差產生的2n個特征圖作為第C+C0通道的代價卷。最終對所有特征通道的特征圖構造代價卷即可得到1 個的4 維代價卷,其中H和W分別代表原圖尺寸的高和寬。

圖5 warp 翹曲操作示意圖Fig.5 Sketch mapnew of warp operation

為保存細節信息,本文僅使用1 次編碼-解碼結構對新代價卷進行聚合,聚合后的代價卷僅需通過1 次上采樣即可恢復成原圖尺寸。對于聚合后的代價卷,本文同樣采用Soft Argmin 操作進行視差回歸,輸出每個像素在不同視差值d下的概率,但由于此時代價卷代表的不再是全局范圍的視差,而是基于初始視差圖構造的鄰域局部范圍內的視差。因此,本文利用事先構造的視差卷,針對每個像素,僅在預測視差值d′鄰域范圍[d′-n,d′+n]內進行視差回歸,達到視差優化的目的。

1.4 損失函數

本文的損失函數由2 部分構成,如式(3)所示,一部分是基于多級監督的視差損失,另一部分是初始視差圖預測階段的softmax 后概率分布損失。

1.4.1 視差損失

本文采用兼具魯棒性和穩定性的Smooth L1函數作為網絡的基礎視差損失函數,如式(4)所示:

其中:N表示有效像素點個數;dn表示真實視差值;表示預測視差值;Smooth L1(·)表示平滑的L1 損失,其表達式如下:

本文采用多級監督的訓練方式,對網絡每個編碼-解碼結構輸出的代價卷進行視差回歸并計算損失,最終通過加權求和的方式計算總的視差損失,從而實現視差逐級細化,如式(6)所示:

其中:wi表示不同階段輸出的視差損失的權重;M表示視差結果受監督的層級數;和參考文獻[12]相同,i取3;各視差結果對應權重參數分別為w1=0.5,w2=0.7,w3=1。

1.4.2 softmax 后概率分布損失

由于新代價卷的構造對初始預測的視差圖精度提出較高的要求,即需要初始預測視差圖中每個像素的預測視差值能夠在真實視差值鄰域范圍內。為約束初始視差圖,本文引入softmax 操作后的概率分布損失。匹配代價卷被用以反映候選匹配像素對之間的相似度,代價卷經過softmax 操作后輸出每個像素在不同視差值d下的概率,其中真實視差值具有最高概率,且概率值應隨與真實視差值的距離增大而迅速下降。根據該屬性,本文基于真實視差值,采用高斯分布構建真實視差概率分布,對代價卷softmax 后的概率分布進行監督,約束預測視差值概率在真實視差值附近成單峰分布。基于真實視差值構建的真實視差概率分布如下:

其中:d表示候選視差值,d∈[0,Dmax];dgt表示真實視差值;σ表示方差,用來控制視差概率分布的離散程度,σ越小則視差概率分布越集中于真實視差值附近,σ>0,基于參考文獻[18],本文σ取1.2。

根據真實視差值構建真實視差概率分布P(d),同時在視差預測階段,計算softmax 后的概率分布,通過交叉熵定義分布損失,如式(8)所示:

其中:N表示有效像素點個數;d表示候選視差值;H(·)表示交叉熵損失函數。H(·)的表達式如式(9)所示:

為防止過擬合,本文中softmax 后概率分布損失僅針對初始視差預測階段的初始視差圖進行計算。

2 實驗與結果分析

為測試算法的性能,本文基于PyTorch 深度學習架構實現提出的CTFNet 模型,使用NVIDIA 1080Ti GPU訓練及測試網絡,研究網絡各組成部分不同參數配置對視差圖預測的影響,并將其與參考算法進行比較。

2.1 數據集

采用SceneFlow 數據集[9]和KITTI 2015 數據集[21]對網絡進行訓練和測試,其中SceneFlow 數據集為合成數據集,包含圖像尺寸為960×540 像素分辨率的立體圖像對,其中35 454 張用于訓練,4 370 張用于測試,所有圖片提供稠密視差圖作為真實值。KITTI 2015 數據集為真實道路場景下采集的數據集,包含200 張訓練集圖片和200 張驗證集圖片,圖像尺寸為1 240×376 像素,其中訓練集提供稀疏視差圖作為真實值,驗證集僅提供左右圖像對,預測視差圖精度需將圖片上傳至KITTI網站進行評估。對于KITTI 數據集,本文隨機選取訓練集中的160 個圖像對進行訓練,剩余40 個圖像對用于測試。

2.2 實施細節

CTFNet 的訓練過程包含2 個步驟,首先在SceneFlow 數據集上預訓練模型,在輸入網絡之前,對每個原始圖像對進行歸一化處理,將圖像RGB 值歸一化到[-1,1]區間內,并隨機裁剪成512×256 分辨率的圖像補丁輸入到網絡。網絡使用Adam 優化器,優化參數β1、β2的值分別為0.90、0.99,批尺寸和最大視差(Dmax)分別設置為3 和192,學習率固定為0.001,訓練10 個周期。在得到SceneFlow 數據集上的預訓練模型后,利用KITTI2015 數據集對模型進行優化微調,模型訓練300 個周期,其中前200 個周期的學習率為0.001,之后學習率調整為0.000 1。

2.3 測試及評價指標

為評估網絡性能,本文基于真實視差值,分別計算SceneFlow 數據集的每個訓練周期的終點誤差及KITTI2015 訓練集的三像素誤差。完成訓練后,使用誤差最低的訓練參數預測KITTI2015 驗證集的視差圖,并將結果提交至KITTI 網站進行評估。

對于SceneFlow 數據集,本文計算所有像素點的預測視差值與真實視差值之間的歐氏距離并求取平均值作為終點誤差(End-Point Error,EPE),誤差越小則匹配精度越高。終點誤差的定義如下:

其中:N表示總像素點個數;di表示第i個像素點處的真實視差值;表示第i個像素點處的預測視差值。

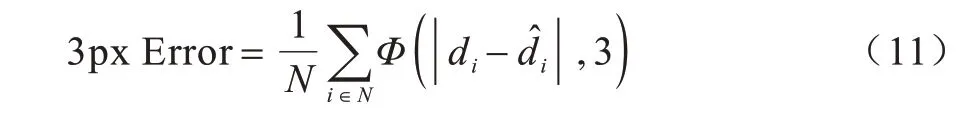

對于KITTI2015 數據集,本文采用三像素誤差(3px Error)表征匹配的準確率,三像素誤差是指預測視差值與真實視差值之間差值的絕對值超過3 的像素點的數量占整幅圖像的比例,比例越高說明誤匹配點的數量越多,匹配準確率越低。三像素誤差的定義如式(11)所示:

其中:

其中:N表示總像素點個數;di表示第i個像素點處的真實視差值;表示第i個像素點處的預測視差值。

2.4 實驗對比

針對CTFNet 各組成部分對視差圖預測的影響進行研究,并測試不同網絡結構及參數配置對于視差精度及運行速度的影響。本文在SceneFlow 和KITTI2015 數據集上評估CTFNet 網絡,并在最終實驗中,與本文網絡相似的PSMNet 進行對比。分別針對特征提取結構、局部稠密代價卷、視差優化結構、softmax 操作后的概率分布損失函數等進行實驗,分析其對視差結果的影響。

2.4.1 特征提取結構實驗

針對構造局部代價卷時所用特征圖的輸出位置進行實驗,結果如表1 所示。在表1 中,特征圖輸出位置代表構建局部代價卷所用的淺層特征圖的輸出位置,其中淺層表示圖2 中淺層分支的最后1 層卷積層,深層表示圖2 中特征提取網絡的倒數第2 層卷積層。

表1 特征圖輸出位置的實驗結果Table 1 Experimental results of the output location of the feature map

由表1 可知,使用淺層特征構造局部代價卷使視差圖的誤匹配率在SceneFlow 數據集上降低了12.0%,在KITTI 數據集上降低了9.7%,說明淺層特征能夠保留更多細節信息,在視差優化過程中能夠有效地改善局部細節區域的匹配結果。

本文還針對特征提取結構輸出的2 組特征圖的尺寸大小對視差圖的影響進行實驗,通過添加步長為2、卷積核尺寸為3×3 的卷積層配合批標準化層和ReLU激活函數層實現特征圖尺寸的調節,結果如表2 所示。表2 中深層和淺層特征圖的尺寸分別代表用來構造稀疏代價卷和稠密代價卷的特征圖尺寸與原圖尺寸的比例。通過對比表2 中實驗結果可知,不論對于構造稀疏代價卷還是稠密代價卷,用作構造代價卷的特征圖尺寸越大,局部細節信息越豐富,視差估計的誤差越小。但一味增大特征圖尺寸會造成代價聚合階段的計算量過大,訓練無法正常進行。通過結合視差優化的方法,采用1/4 原圖尺寸的特征圖構造初始代價卷,同時采用1/2 原圖尺寸的特征圖構造稠密代價卷既能保證網絡正常訓練,也能有效提高預測視差圖精度。

表2 不同特征圖尺寸的實驗結果Table 2 Experimental results of different feature map sizes

2.4.2 對局部稠密代價卷的實驗

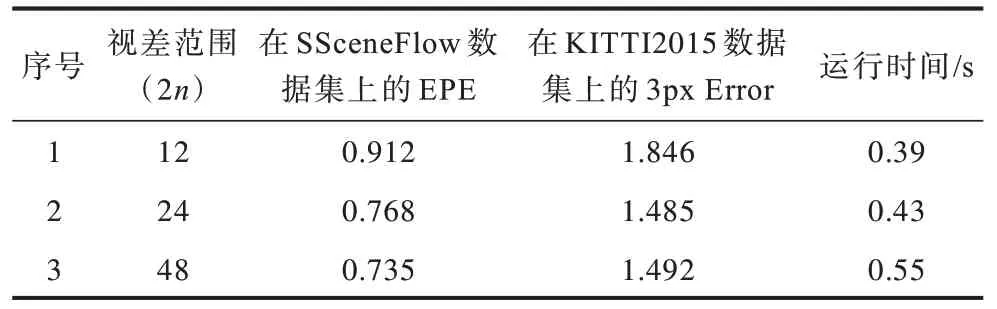

為減少冗余計算及細化視差概率計算,在視差優化階段針對每個像素,以其初始視差鄰域內的2n個視差值構造局部稠密代價卷,其中2n是需要人為確定的超參數。為實現最優化,針對此局部視差范圍參數進行實驗,結果如表3 所示。

表3 對局部視差范圍的實驗結果Table 3 Experimental results of the local disparity range

由表3 可知,初始視差鄰域范圍2n對視差估計和網絡運行速度有一定影響。如果用于構造局部稠密代價卷的視差鄰域范圍過小,則經過多次上下采樣,會引入過大的誤差。如果視差鄰域范圍過大,最終沙漏結構進行代價聚合所需的計算時間就會增加,且對于誤差率的改善收效甚微。由實驗結果可知,本文選擇基于初始視差構造鄰域范圍為24 的局部稠密代價卷。

2.4.3 視差優化結構實驗

為驗證視差優化方案的可行性,本文通過采用相同的特征提取結構,對比視差優化方案與傳統的通過3 個編碼-解碼結構直接預測視差圖方案間的匹配誤差率,結果如表4 所示。由表4 可知,使用視差優化結構相對傳統方案,視差圖的誤匹配率在SceneFlow 數據集上降低了10.3%,在KITTI 數據集上降低了11.9%。由此可知,本文提出的視差優化方案對視差圖預測具有一定的提升作用。

表4 對視差優化結構的實驗結果Table 4 Experimental results of the disparity optimization structure

2.4.4 softmax 后概率分布損失函數實驗

為探究本文損失函數的改進對視差預測結果的影響,對CTFNet 網絡進行測試,驗證添加和去除softmax 后的概率分布損失函數對網絡預測精度的影響。由表5 可知,添加概率分布損失函數后,網絡的視差預測精度得到了一定程度的提升。

表5 損失函數的實驗結果Table 5 Experimental results of loss function

通過softmax 操作,代價卷被計算成每個潛在視差值的概率,所有概率和為1。本文對特征不明顯區域的不同像素點在視差回歸過程中計算的視差概率分布進行可視化,結果如圖6 所示。圖中橫坐標表示所有潛在視差值,縱坐標表示對應預測概率,虛線表示真實視差值。由圖6 可知,添加softmax 后的概率分布損失函數,其視差預測的概率分布會傾向于在真實視差值附近呈現單峰分布,有效降低了其他視差值的干擾,這對于部分特征不明顯區域的視差預測具有良好的改善作用。

圖6 視差值概率分布圖Fig.6 Probability distribution of disparity

2.5 KITTI2015 排名結果

將CTFNet 網絡對KITTI 驗證集生成的視差圖上傳至KITTI 評測網站,表6 展示了KITTI2015 數據集上本文網絡及其他主流網絡的實驗結果對比。其中,D1表示視差圖中誤匹配點所占的比例,bg 表示背景區域,fg 表示前景區域,all表示整個區域。由表6 可知,本文所提網絡與之前的網絡[10-12,15-17]相比在精度上有一定提高。與同樣基于兩階段進行視差優化的CRL 算法相比,誤匹配率降低了17.6%。與算力要求相近的PSMNet網絡相比,整體的誤匹配率由2.32%下降至2.20%。在運行時間方面,為保證數據的準確性,本文在Nvidia 1080Ti GPU 上測試PSMNet 和CTFNet 網絡的運行時間,PSMNet的運行時間為0.52 s,所提網絡的計算時間為0.43 s,降低了約17%。

表6 KITTI2015 立體匹配排名Table 6 KITTI2015 stereo matching ranking

圖7 中第1 列和第2 列分別展示了本文所提CTFNet 與PSMNet 針對同一組圖片預測視差圖的對比,第3 列為第4 列的局部位置放大圖。誤差圖中藍色點表示正確匹配點,黃色點表示錯誤匹配點,黑色點表示忽略的點(彩色效果見《計算機工程》官網HTML 版)。通過觀察2 種算法在圖中黑色橢圓標記位置處的視差結果可以發現,與PSMNet 網絡相比,CTFNet 網絡能夠準確預測圖中細鐵索處的視差,同時在預測交通標志邊緣處的視差時更加精確。實驗結果表明,通過淺層特征和視差優化的方式能夠有效改善特征不明顯區域的匹配結果,提高小物體及邊緣等病態區域的匹配精度。

圖7 視差圖結果對比Fig.7 Comparison of disparity map results

3 結束語

本文設計一個基于淺層特征的立體匹配網絡CTFNet,通過構建稠密代價卷進行視差優化。由于深層特征網絡的感受野較大,能夠獲取更多全局信息,從而構建全局稀疏代價卷以獲取前景物體的初始視差圖。淺層結構的特征提取網絡減少了圖像的上下采樣,保留了更加完整的局部上下文信息,配合基于預測視差值構建的稠密代價卷,能夠進一步細化視差。此外,softmax 操作后概率分布損失函數的引入,能夠對視差概率分布進行監督,有效提高了算法的魯棒性。實驗結果表明,與PSMNet 網絡相比,本文網絡在部分病態區域如邊緣及小物體處匹配效果更好,匹配精度得到一定提升。下一步將通過采用多任務網絡及引入邊緣檢測或語義分割任務,提高算法對邊緣及弱紋理區域的匹配能力,同時,還將進一步優化網絡結構,降低網絡參數和計算量,以實現算法在TX2 等嵌入式設備上的穩定運行。