面向社交群問答對獲取的深度學習模型

張民航 蔡東風 李紹鳴

(沈陽航空航天大學人機智能研究中心 遼寧 沈陽 110135)

0 引 言

近幾年關于中文問答系統的研究日漸火熱,也暴露出了一些問題,如問答語料匱乏、人工構建語料困難、高質量問答領域單一或廣域問答質量不高等。實際上,網絡上存在大量的問答資源,若能好好利用這些資源,可為問答系統的研究提供豐富的語料資源。當前有關問答對抽取的研究如文獻[1-4]都集中于網頁資源,如論壇、社區、貼吧和網站FAQ等。除了上述網頁資源,網絡上還存在其他問答資源,比如各類社交群資源。隨著各類社交群如微信群、QQ群和微博群的興起,其中積累了大量的問答資源,但是這些資源尚未得到研究者的重視。面對這一狀況本文開展了面向社交群的問答對獲取研究。

社交群資源不同于網頁資源,后者多是一問一答或一問多答,社交群成員眾多、發言自由,大都是多問多答。本文著重研究了問句識別、回答順序、候選答案范圍等影響問答對獲取質量的關鍵因素,提出了通用的問句識別方法和新的問答對獲取方法。該問句識別方法不僅可用于問答對獲取,也能在問答系統中過濾非問題干擾;所提問答對獲取方法基于問答匹配策略實現,亦能用于問答系統的答案匹配過程。

1 相關工作

問答對獲取,即從含有問答內容的文本中自動地獲取問題和答案。通常,問答對獲取分為兩步完成:問題識別(又名問句識別)和答案識別。

目前,關于中文問句識別的研究可以大致分為兩個類型:(1) 從語言學的角度識別問句,該類方法大多借助特征詞、句式、句法結構和語法單位等特征判別問句。(2) 從文本分類的角度識別問句,這類方法大多借助機器學習,通過有監督訓練的方式將問句識別視作二分類問題。周飛云[5]總結了設問句和反問句的類型及特征,并分析了設問句與反問句嵌套的特殊情況。殷樹林[6]提出了反問句的三個基本特征:無疑而問、不需要回答和表示否定,進一步細化了反問句的句法結構,總結了17類反問句特有的句法結構。與上述研究從語言學角度分析反問句特征從而人工判斷反問句不同,文治等[7]分析了反問句的句式特點,將反問句的句式結構融入到卷積神級網絡的構建中,實現了中文反問句的自動識別。其在微博反問句上的識別準確率、召回率和F1值分別達到了89.5%、84.2%和86.7%。熊作平[8]分析了漢語是非問句的類型,并從語法層面歸納了3種肯定是非句格式和7種否定是非句格式。陳彩霞[9]著重分析了標點符號、語氣詞、語調等特征在是非句識別中的作用。侯永帥等[10]針對問答系統中部分問句對時效敏感的特性,設計了時間敏感問句的識別和檢索方法。實驗表明該方法是有效的,使用C5.0決策樹識別時間敏感問句準確率可達0.901。

在識別問句的前提下進一步識別答案才能獲得完整的問答對。文獻[1-2]根據HTML內容建立DOM樹,將樹中各個節點識別為問題(q)、其他(o)和答案(a)三類,取樹中以QA順序出現且距離最近的一對為問答對。文獻[3-4]研究社區問答對獲取,從用戶回帖中識別答案,通過對回帖分段劃分再使用文本特征和非文本特征訓練機器學習模型,進而預測答案概率。當前,越來越多的研究者開始使用深度學習算法開展問答匹配研究,這類方法不需要太多的人為干預,可以自動學習問答匹配特征并加以利用。此外,詞向量和注意力機制的引入進一步加強了深度學習處理問答匹配的能力。使用深度學習進行問答匹配需解決兩個關鍵問題[11]:(1) 實現自然語言問句及答案的語義表示;(2) 實現問句及答案間的語義匹配。榮光輝等[12]面向中文問答匹配任務,提出了基于組合模型的問答匹配方法。邢超[13]通過問句向量生成模型和答案向量生成模型分別將問句和答案表示為特征向量,同時將兩個模型組合成混合向量模型用于問答匹配。Shen等[14]針對詞袋模型難以在短文本匹配中捕獲重要的詞序列信息這一問題,提出了一種新的體系架構。Yang等[15]將問答對匹配視為二分類任務,并提出了對抗性訓練框架來減輕標簽不平衡問題。Wu等[16]提出了FACM模型,該模型通過使用匹配策略擴展卷積神經網絡(CNN)來對涉及多方面主題的QAP(問答對)進行注釋。Lima等[17]提出了一種基于知識的問答框架,該框架將多級標簽推薦與外部知識庫集成在一起,以檢索最相關的知識庫文章來回答用戶發布的問題。

綜上所述,當前的問句識別研究主要集中于特殊問句的識別,并沒有適用于一般問句的識別方法,而社交群中的問句類型豐富不僅包含特殊問句。因此,本文提出了通用的問句識別方法。鑒于目前問答對獲取的相關工作并未考慮候選答案范圍和答案順序,本文分析了候選答案范圍對問答對獲取質量的影響,提出了結合答案順序的問答匹配框架。

2 社交群問答對特性分析

面向社交群的問答對獲取,即從源于社交群的文本(一般是群聊記錄)中成對地找到問題及其答案。為此,需要解決兩個關鍵問題:問句識別;候選答案范圍的確定。各類社交群的文本,如微信群文本、QQ群文本、釘釘群文本等,以下簡稱群記錄。

2.1 問句特點

問句和非問句的區別主要體現在詞語、句式、符號、句尾和短語搭配等方面,此外,出于易于理解的目的,問句一般都比較簡短。本文歸納了問句的一般特征,在此結合統計結果予以說明。

由經驗不難發現,某些詞出現在問句中的比例遠高于在非問句中的比例,如各類疑問詞“誰、哪里、何時、為什么、怎么樣”等。問句有自己特有的句式結構:(1) 一般疑問句,疑問詞多出現在句子首尾,[疑問詞,句中,句尾]或[句首,句中,疑問詞]。(2) 反問句,句法結構較多可參考文獻[6]。(3) 選擇疑問句,是A還是B(A、B均為字符串)。(4) 是否疑問句,...CDC...結構(C為詞語D為否定字或詞),如“電影票還有沒有”、“這衣服好看不好看”。問句的符號特征主要是“?”,句尾特征主要有“嗎”、“么”、“沒”、“不”等。實際上句尾特征“沒”和“不”屬于句式特征(2)的省略用法,如“你吃飯沒吃飯?”,省略后為“你吃飯沒?”;“你買不買某物?”,省略后為“你買不?”。

本文將中文問句分為兩大類:顯性問句和隱性問句,其中顯性問句又分為強制問句和一般問句兩小類。顯性問句指含有顯性特征的問句,隱性問句指不包含顯性特征的問句。

顯性特征主要有符號特征和句尾特征,除錯誤使用符號和句尾字的情況外,一般含有此類特征的句子皆可視為問句。在真實的交流情景中,人們可能會通過語氣而非泛指信息表達疑問。比如“我要是不去,你來。”表達的是疑問語氣“難道你來?”,這類情況通過語氣強行使之成為問句,若不通過語氣(語調)僅從字面上則無法判斷是否為問句。

與上述口語現象對應,書面語也有類似現象,即通過“?”使句子強行成為問句,一旦去除問號則難以判斷其為問句。比如“大米5元1斤?”是詢問大米的價格,而“大米5元1斤”通常都不會被視為問句。同時,這類情況也難以使人判斷此處是否存在符號誤用,也許他人正是想通過此類方式表達疑問。這種通過問號強行變成問句的句子即為強制問句。而一般問句大多含有疑問詞或疑問句句式特征,即使去除問號,也基本可以判定為問句,如“大米多少錢一斤?”“你去不去買大米?”。

顯性問句可通過顯性特征來判斷,問句識別的主要工作也由此轉為隱性問句識別。

2.2 答案特點

候選答案范圍(即用于獲取答案的文本片段)的確定對正確獲取問答對有重要意義,其決定了是否可以獲取答案以及獲取答案的效率。為便于說明,引入三個定義:(1) 話語角色,即問答的角色,主要有提問者和回答者。(2) 角色職能,提問者提出問題,回答者回答問題。(3) 答案窗口,即候選答案的范圍。群記錄中話語角色的數量即是群成員的數量,每個成員既可能是提問者也可能是回答者。群記錄中的問答存在以下幾個特點:(1) 答案不一定存在,問答皆是自由的,某些問題無人回答。(2) 答案源于問題之后的若干人次發言,其與群規模無必然聯系,與活躍人數關聯較大。(3) 問題之后的發言不一定都是回答,很可能有其他問題。(4) 很多問題都是對某些信息進行確定,因此答案多是短文本。(5) 同一問題,可能有多個相同或不同的回答,應獲取最適合的回答。

本文在確定答案窗口時,依據兩個假設:答案范圍不超過問題之后最近的10人次發言;不能以問題來回答問題,即答案不會出現在問句中。通常,答案窗口越大越可能獲得更多的問答對;同時,越大的答案窗口包含了越多的干擾,獲取問答對的質量有可能降低。

3 問句識別

3.1 方法介紹

3.1.1基于規則的問句識別方法

問句和非問句在句式、用詞、符號、短語搭配等方面有明顯的區別,本文總結了中文問句的一般特征,由此提出了基于規則的問句識別方法RBQR(Rule Based Question Recognition)。實際上雖然句尾特征和“?”存在誤用的情況,但其比例非常小,因此本文直接將句尾含有顯性特征的句子視為問句,所提出的基于規則的問句識別方法也主要用于識別隱性問句。本文所用規則主要包括三部分:顯性特征、“是”規則與“否”規則。識別問句的基本思路是:(1) 含有顯性特征“嗎”“?”“么”“不”“沒”的句子直接被判定為問句。(2) 通過“是”規則集初步判斷候選問句集。(3) 使用“否”規則集過濾候選問句集,得到最終問句集。“是”規則主要包括八大特征:符號、句尾詞、特征詞、句法特征、固定短語、用語習慣、句長、特征詞詞序。“否”規則主要包括固定搭配和否定特征詞兩類特征,如,特征詞+<都,也>,否定動詞+特征詞。

符號特征,即句尾是否含有問號。

句尾詞,主要有<嗎,么,沒,不>。

特征詞,主要有<什么,誰,哪,怎么,多少,幾,咋,哪個,哪里,請問,誰家,怎么樣,咋樣,為什么,如何,什么樣,多久,怎么辦,哪些,哪家,哪位,多大,多長,多寬,多高,多遠,多重,多快>。

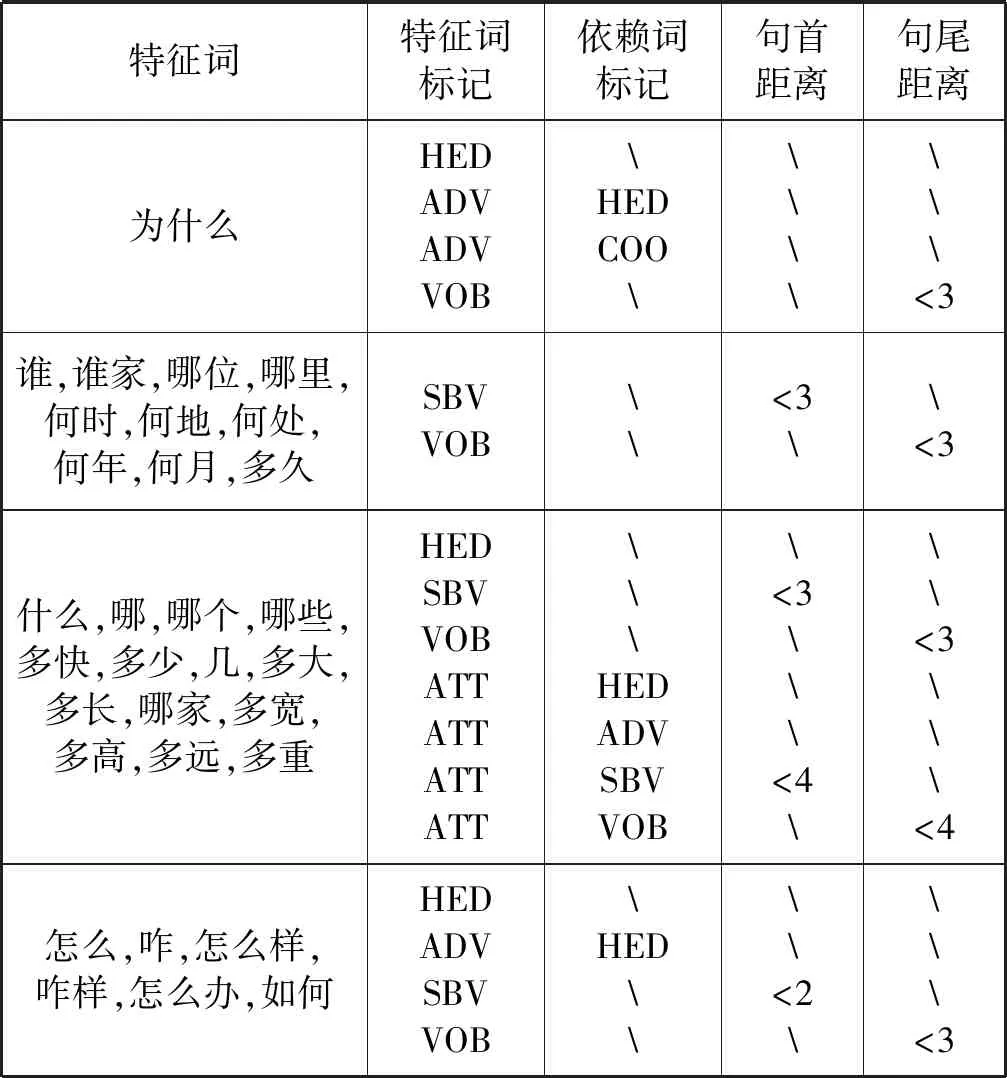

句法特征,主要包括特征詞的句法標記和其下一級依賴詞的句法標記;詞序,主要是句首和句尾特征。句法特征與詞序特征配合使用,大體分為四種情況,具體關系見表1。

表1 句法特征與詞序特征搭配的規則

表1說明如下:(1) 特征詞,用于問句識別的關鍵詞。(2) 依賴詞,特征詞在句法分析中的后繼。(3) 標記,即詞的句法標記,表示當前詞與其所指詞的句法關系。其中,HED為核心關系;SBV為主謂關系;VOB為動賓關系;ADV為狀中結構;ATT為定中關系;COO為并列關系。(4) 句首距離,表示特征詞在當前子句(以“?!,;。”對長句切分所得即為子句)中的順序詞序。如“還有 誰 沒來 ?”,“誰”的句首距離為2。(5) 句尾距離,表示特征詞在當前子句中的倒序詞序。如“你 喜歡 吃 什么 水果 ?”,“什么”的句尾距離為3。(6) “”表示該項為空。規則使用示例如圖1所示。

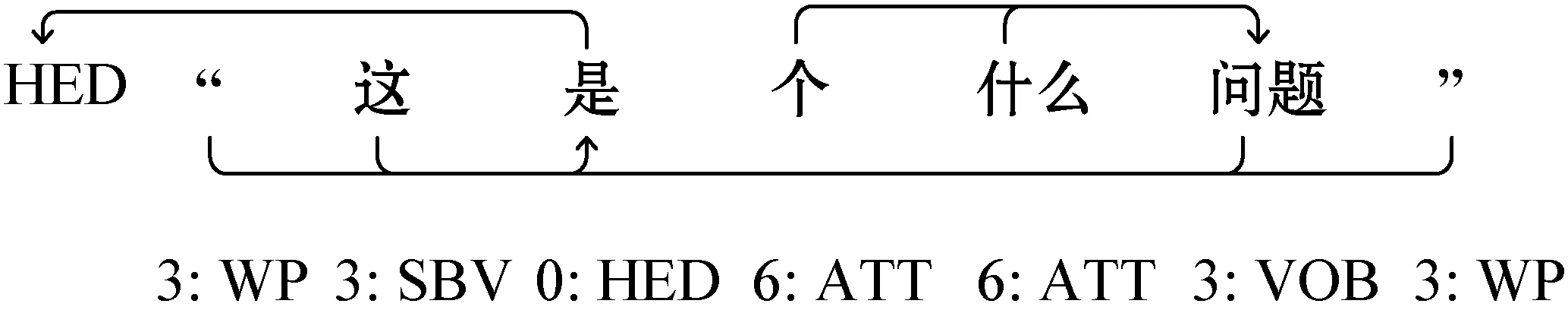

圖1 規則使用示例

示例:

圖1中上半部為分詞后的待判斷句子,下半部為各詞對應的[依賴詞位置:當前詞句法標記]。特征詞是“什么”,其句法標記“ATT”,依賴詞為“問題”,依賴詞屬于賓語成分句法標記“VOB”,特征詞句尾距離為2。因此,此句按規則判斷為問句。

固定短語,僅憑特征詞還無法直接判斷一個句子是否為問句,但是當特征詞與某些詞形成搭配短語時,基本可以斷定一個句子為問句。比如<誰有,誰知道,誰的,干嘛,是什么,有什么,想問一下>。

我國地域遼闊,各地的人用語習慣不同,這些口語上的習慣也會反映在文字上。比如東北地區的特有用語習慣<干啥,是不,吃飯沒,出去沒>;四川省的特有用語習慣<干啥子,你曉得…,哪個(誰)>。這些用語習慣或為句式特征或為短語特征,可作為重要的問句識別特征。在對一些來自局部地區的文本特別是口語化較重的文本進行問句識別時,用語習慣特征會有很大作用。

句長特征,為使被問者清楚地了解自己的意圖,提問者通常會用較為簡潔的語言描述問題,這也使得問句文本一般較短。可以通過對顯性的問句統計,適當估計問句的長度,以此篩選掉過長的句子,從而提升問句識別的精度。

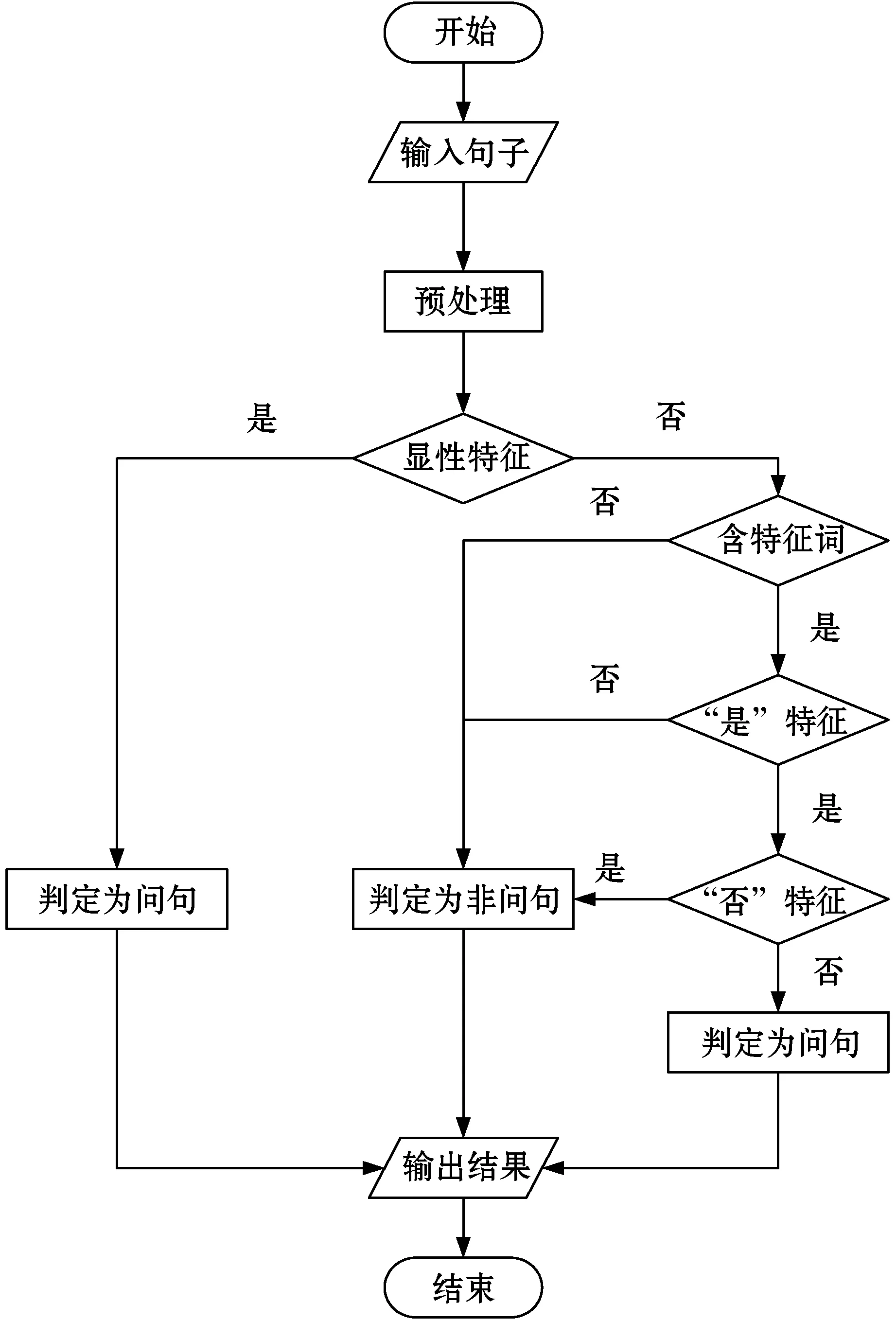

基于規則的問句識別流程如圖2所示。

圖2 基于規則的問句識別流程

對于任意新輸入的句子,先對句子進行分詞、詞性標注和句法分析等預處理,隨后判斷句子中是否含有顯性特征,含有顯性特征則判定為問句,否則進入后續流程。在后續處理過程中將不含特征詞的句子直接過濾掉,反之判斷是否包含“是”特征,再接著判斷是否含有“否”特征。經過多重處理,最后得到的句子就判定為問句。

3.1.2基于深度學習的問句識別方法

基于規則的問句識別方法可以借助規則準確地識別問句,但是規則由人工制定擴展亦需耗費人力,且規則不易覆蓋所有問句類型。為了從不同角度探索問句識別的特性和效果,本文亦使用深度學習的方法開展問句識別研究,主要包括基于CNN的問句識別方法和基于LSTM的問句識別方法。

目前,CNN網絡和LSTM網絡已被廣泛應用于自然語言處理領域且表現出色,前者具備較強的局部特征學習能力,后者具備較好的整體語義把握能力。本文將問句識別視為二分類任務,使用有監督學習的方式,分別訓練CNN模型和LSTM模型預測待識別句子,以0.5為閾值將大于此值的句子判定為問句,反之為非問句。

3.1.3規則與深度學習相結合的問句識別方法

基于規則的問句識別方法和基于深度學習的問句識別方法各有所長,本文將兩者結合在一起用于問句識別。該結合方式并非將兩種方法融合為第三種方法再進行問句識別,而是由兩類方法分別預測出候選問句集,取兩個候選集的并集作為最終預測結果,其結果構成見圖3。

圖3 結合方法問句識別結果構成圖

具體結合方式如下:(1) 由RBQR方法預測出候選問句集Can_1,即圖3左半部;(2) 由CNN模型或LSTM模型預測出候選問句集Can_2,即圖3右半部;(3) 對Can_1和Can_2取并集Can,即圖3整體,以此作為最終識別結果。

3.2 實驗與結果分析

3.2.1數據集和評價指標

實驗所用數據集共包含三部分:小區群聊語料CMY,百度公開的開放域問答數據WebQA[18]和NLPCC-ICCPOL2016開放域問答數據Dbqa。其中,CMY為本文收集整理的真實語料,源自某小區微信群聊記錄,主要包含了用戶的提問和相關的回答,夾雜了少量閑聊內容。為保護隱私所有數據均進行了脫敏處理。此三種語料皆是開放域問答數據,所含的問題類型豐富、涉及領域廣泛,能夠很好地體現問句特點代表性強。

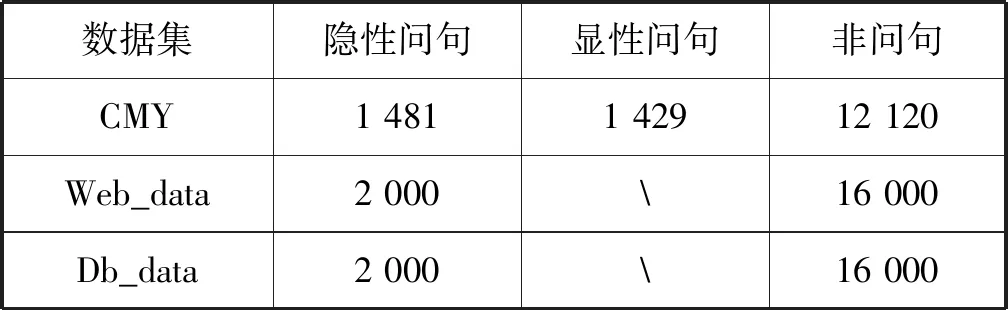

CMY、WebQA和Dbqa的基本構成如表2所示。

表2 問句識別數據集簡介 單位:個

問句識別實驗分別在CMY、Web_data和Db_data三個數據集上進行,采用查準率P(Precision)、召回率R(recall)和F值(F-Measure)作為評價指標。

3.2.2實驗設置

問句識別實驗分別使用基于規則的方法、基于CNN模型和基于LSTM模型的方法在CMY、Web_data和Db_data數據集上進行,共計9組實驗。其中,基于規則的方法采用本文提出的中文問句識別方法RBQR。

CNN模型基本設置:(1) 輸入層,采用嵌入層,詞向量維度128。(2) 卷積層,256個卷積核,卷積核大小為10,激活函數為ReLU。(3) 池化層,采用最大池化方式。(4) 輸出層,采用全連接層,維度為1(二分類,輸出層即是1維),激活函數為sigmoid。(5) 損失函數loss=‘binary_crossentropy’,優化器optimizer=‘Adam’。

LSTM模型基本設置:(1) 掩蔽層,timesteps=50。(2) 輸入層,采用嵌入層,詞向量維度128。(3) LSTM層,維度64,dropout=0.2,recurrent_dropout=0.2。(4) 輸出層,采用全連接層,維度為1(二分類,輸出層即是1維),激活函數為sigmoid。(5) 損失函數loss=‘binary_crossentropy’,優化器optimizer=‘Adam’。

3.2.3結果分析

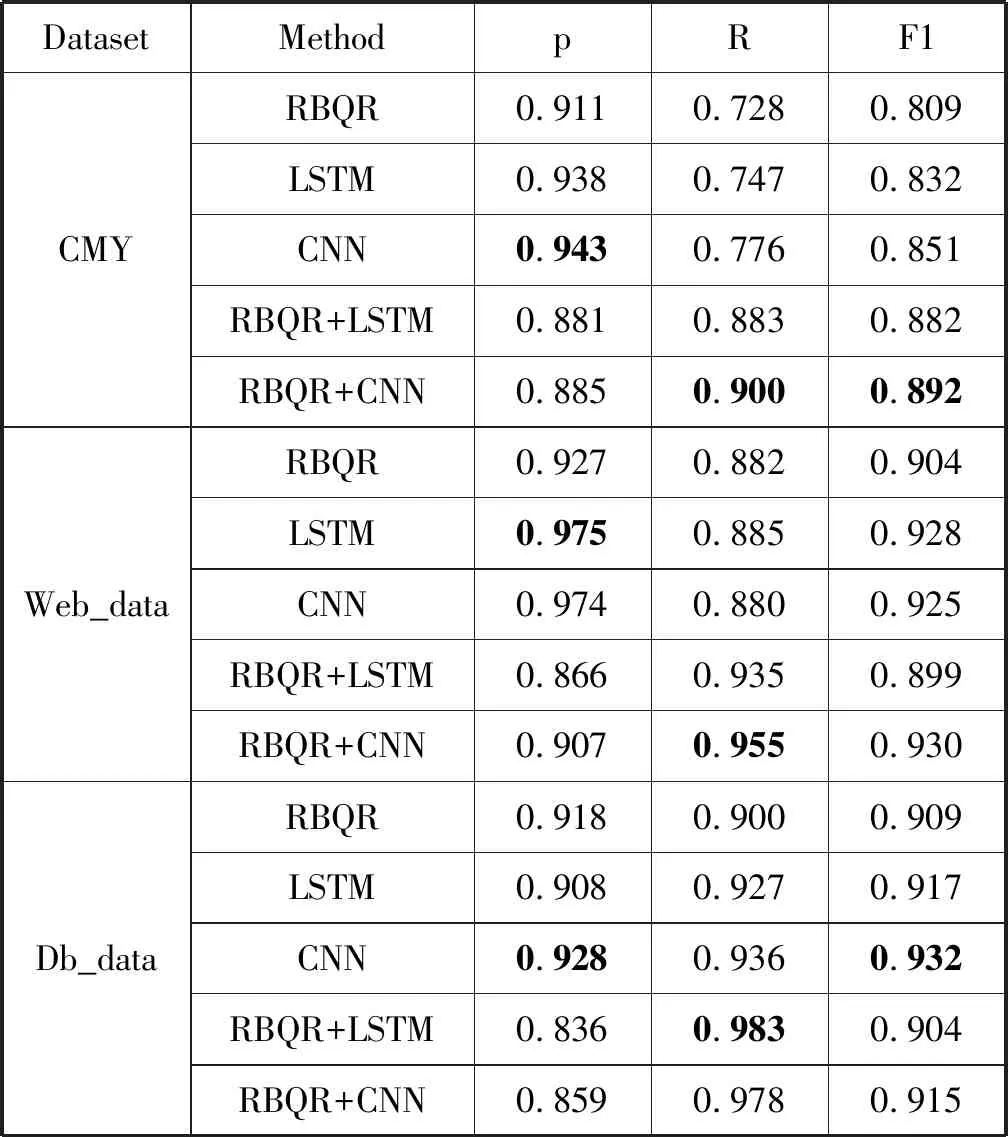

問句識別結果如表3所示。

表3 問句識別結果

從表3中可以得到:

(1) 選擇Web_QA和Dbqa數據與CMY對比以及對應的數據抽取策略是合理的,三種問句識別方法在各個數據集上的表現基本一致:識別準確率均大于0.9,CNN識別效果與LSTM識別效果接近且CNN方法略強于后者。

(2) 基于規則的方法RBQR在問句識別任務上識別準確率較高,召回率較低。主要原因有:RBQR針對問句特性設計規則,可以充分利用問句特征;RBQR判別標準較為嚴格,部分不符合標準即可能被判定為非問句;規則很難完全覆蓋各類情況,一些不符合規則卻是問句的句子難以識別。

(3) 將問句識別視作文本分類任務是可行的,在所測試數據集上基于深度學習的方法CNN和LSTM均有良好表現,其中CNN方法基本在各個數據集上達到了最佳識別效果。主要原因有:LSTM模型能很好地從整體上把握問句,問句大都是短文本,大部分在30個詞以內,LSTM的記憶特性在此可以得到較好的發揮;問句的特征較為明顯,如疑問詞、固定短語等特征,CNN可以輕松地卷積出此類特征,所以CNN模型在問句識別任務中表現很好;相比句子的整體特性,問句識別對局部特征更為敏感,這使得CNN模型比LSTM模型表現更好。

(4) 基于規則的問句識別方法與基于深度學習的問句識別方法具有較好的互補性,其結合方法召回率最高。當單一方法召回率較低時,其能顯著提高召回率且可能因此提升F1值,CMY和Web_data的最大F1值皆源于結合方法可體現此特性。隨著召回率的提升,融合方法的提升效果也隨之減弱。

整體而言,問句特征和語義都在問句識別中起重要作用。RBQR可以針對問對特性設計規則具備較高的“判正性”,但是規則較為嚴格且對非問句沒有針對性處理;CNN和RNN可以學到問句和非問句特征,能在具備較高識別準確率的同時具備較高召回率。將二者結合起來,可在適當犧牲準確率的情況下提升召回率,在召回率較低時提升效果尤為顯著。

識別錯誤的問句大體可分為兩種:(1) 強制問句去除問號后不含任何問句特征,幾乎不可識別。如CMY中“你買房子?”變成“你買房子”,則無法識別為問句。(2) 非強制問句疑問詞省略,去除問號后同問題(1)。如Web_data中“愛因斯坦的老婆是(誰)?”變成“愛因斯坦的老婆是”,“誰”被省略則無法識別為問句。

4 問答對獲取

4.1 基于深度學習的問答對獲取方法

將問題與答案進行匹配的過程即為問答匹配,本文通過基于深度學習的問答匹配方法來獲取問答對。當前關于問答匹配的研究大多是利用詞向量將問題與答案映射到語義空間,再通過深度學習模型學習兩者間的匹配特征,進而判斷兩者是否相符,這類方法將問答匹配視為分類問題;或通過深度學習模型計算問題與答案的匹配度,對問題與多個候選答案的匹配度打分排序,將其作為排序問題處理。由于一個問題可能對應多個候選答案,僅以問答是否相符為衡量標準是無法區分復數個候選答案優劣的,因此本文將問答匹配視為排序問題處理,將排在第一位的候選答案作為匹配結果。先通過深度學習模型對問題的各個候選答案打分排序,以此作為基本排序;再引入候選答案順序、共現詞等特征對候選答案二次打分排序。

通過雙向LSTM實現孿生神經網絡模型TwM,以此學習問題和答案的深層特征。該模型的主要學習目標是區分錯誤答案和正確答案與問題之間的距離,即使得正確答案與問題的聯系更緊密,而錯誤答案與問題的聯系更疏遠。實際上,問答匹配多數是從含有一個答案句子多個非答案句子的段落中獲取答案,為了使模型較充分地學習到正例與負例的區別,通常應是一個問題對應一個正例和多個負例。

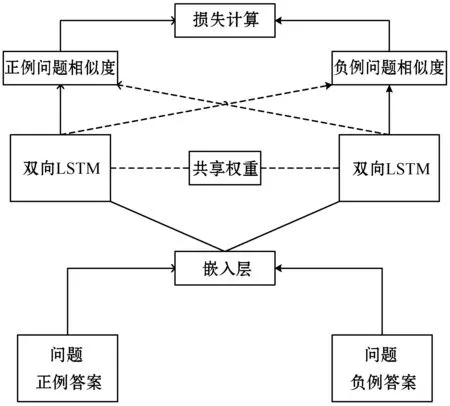

TwM的網絡結構如圖4所示。

圖4 TwM網絡結構

采用孿生網絡結構,共包含五層,自底向上依次是輸入層、嵌入層、雙向LSTM層、問答相似度計算層和損失計算層。該孿生網絡一部分用于生成問題的特征向量,另一部分用于生成正反例的特征向量。圖4中空心箭頭代表問題和正例答案的工作流,實心箭頭代表問題和負例答案的工作流。

輸入層每次接受兩個輸入,一個是問句另一個是候選答案句子(正例或負例)。問題和正例是重復使用的,以便與負例數目配平。如1個問題、1個正例和3個負例時,{[(q,Ta),(q,Fa1)];[(q,Ta),(q,Fa2)];[(q,Ta),(q,Fa3)]}為一個完整樣本,q表示問題,Ta表示正例,Fa1、Fa2、Fa3依次對應三個負例。

嵌入層負責將輸入層的句子(問句或正反例)表征為句子向量,以便映射到語義空間。句子向量由句子中的詞對應的詞向量相加后除以詞數得到,詞向量使用了基于中文維基百科預訓練的詞向量。

兩個雙向LSTM層通過共享權重實現權重一致,以保證對問句和正(反)例進行同樣的特征提取。問題和正(反)例通過該層后將被表示為兩個特征向量,進入下一層計算相似度。

問答相似度計算層也是實質上的輸出層,實際使用模型時所需的即是該層計算的相似度。以上一層輸出的兩個特征向量的余弦距離來衡量問題與正(反)例的相似度,并以此作為TwM對候選答案的打分,記為D_score,0≤D_score≤1,其計算方式如下:

D_score=cos(a,q)

(1)

式中:a是候選答案經LSTM層輸出的向量,q是問題經LSTM層輸出的向量。

最后一層是損失計算層,主要用于計算損失函數。與一般有監督訓練模型不同,TwM屬于無監督訓練,并無標簽可用,只能在每次計算出問題正例相似度和問題負例相似度后再計算損失。損失函數loss定義如下:

loss=max{0,margin-(t_sim-f_sim)}

(2)

式中:margin為設置的閾值,t_sim為問題正例相似度,f_sim為問題負例相似度。loss的計算分為三步:(1) 計算問題正例相似度與問題負例相似度的差。(2) 計算margin與步驟(1)結果的差。(3) 取0和步驟(2)結果這二者中最大的作為損失。

以D_score的打分直接排序作為基本排序,記為Rank。在此基礎上結合候選答案順序進行二次打分排序,記為Re_rank,二次打分得分記為Re_score。基本原則有二:(1) 候選答案的次序距離問題越近,其成為答案的可能性越高。(2) 候選答案的次序距離問題越近,其在二次打分中得到的增幅越大。

Re_score的計算方式如下:

Re_score=D_score×(1+λ)ord

(3)

此計算方式對各個候選答案的增幅隨次序呈指數級變化。式中:λ(一般取0~0.1)為基本增幅,ord為窗口中各候選答案到窗口底端的次序。如窗口為4時,有例子1:Rank=[0.5,0.4,0.6,0.3],取λ=0.1,則Re_rank=[0.5×1.13,0.4×1.12,0.6×1.11,0.3×1]。

為便于表述,引入一些說明:以Rank排序為基準,若答案在候選答案中得分最高標記為g,否則標記為m,其余候選答案標記為n。二次打分排序的目的就是使得排序靠前的候選答案m有機會借助順序優勢變成g,從而獲得更多的正確問答對。在例1中,若Rank標記為[m,n,n,n]即第一候選答案是答案,則Re_rank標記為[g,n,n,n]。在基本排序中答案的得分0.5<0.6不是最大的,而在二次打分排序中,答案的得分成了所有候選答案中最高的,因此可與問題配對為正確的問答對。

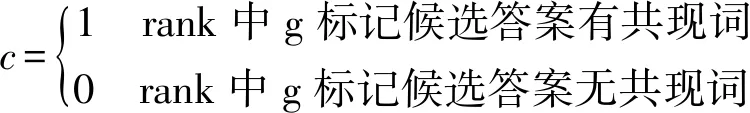

Re_rank對順序靠前的候選答案有所偏好,在二次排序時會導致原本標記為g,但順序靠后的答案失去高分優勢,從而導致答案得分不再是最高的以致問答對獲取失敗。如例1中,若Rank標記為[n,n,g,n]即第三候選答案是答案,則Re_rank標記為[n,n,m,n],這將導致原本可以正確獲得的答案因排序靠后而獲取失敗。以本文所用數據CMY為例:窗口為4時Rank的排序結果中標記“g”422個,標記“m”0個(排序結果取各組得分最高者,標記m非最高,不會被選中);Re_rank的排序結果中標記“g”382個,標記“m”52個(二次排序后,標記m可能變成最高分被選中)。在二次打分排序后正確獲取的問答對共434個,較Rank結果422多出12個,其中標記“m”的問答對增加了52個,但是標記為“g”的問答度丟失了40個。為了減少在二次排序中損失的“g”問答對,本文引入了共現詞特征。統計結果表明,大多數標記為“g”的候選答案與問題有公共詞語(即共現詞),而標記為“m”的候選答案大都不含共現詞。結合共現詞的二次打分排序記為Re_rank_com,其得分記為C_score,基本原則是維持Rank中有共現詞的“g”標記候選答案,具體計算方式如下:

C_score=D_score×c+(1-c)×Re_score

(4)

(5)

式中:c為共現詞標記。

以CMY為例,結合了共現詞的二次打分排序中標記“g”415個,標記“m”30個,正確獲取的問答對共計445個較Rank排序422多出23個。可見,引入共現詞化解Rank和Re_rank的沖突還是有效的。

4.2 數據集和評價指標

問答對獲取實驗在CMY數據集上進行,使用準確率查準率P(Precision)、召回率R(recall)和F1值(F1-Measure)作為評價指標。在假設的前提下統計了答案在不同窗口中的分布比例,具體結果見表4。

從表4中可以發現窗口4中已包含了92.7%問題的答案,答案分布在窗口4以外的僅有7.3%。有些問題可能回答得較晚,也可能無人回答。此外,部分問句的距離(其在文本中的順序)較近,這使得各個問題的候選答案可能有交集。在窗口為4的前提下,本文選取了有答案的2 643個問題和對應候選答案作為實驗數據,其中2 000組為訓練集,643組為測試集。

4.3 實驗結果

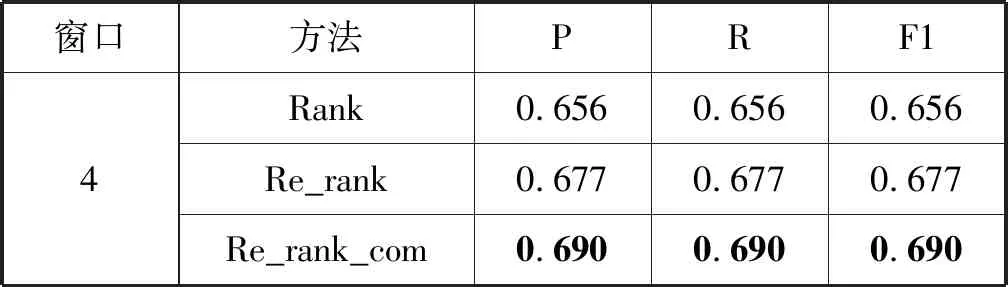

問答對獲取結果如表5所示。

表5 問答對獲取結果

從表5我們可以得出:

候選答案的次序對問答對獲取有明顯的影響,考慮次序加權的候選答案排序Re_rank比rank提升了2.1百分點。

使用共現詞策略化解Rank與Re_rank的沖突是有效的,Re_rank_com的各項指標均比Re_rank有了明顯提升。

對問答對獲取失敗的數據進行統計分析,總結了兩個主要因素:(1) 答案的初始得分過低。(2) 答案的回答順序過于靠后。答案的初始得分過低時,即便其回答順序靠前也無法通過Re_rank獲得較大的“加分”;答案的回答順序靠后時,會在Re_rank中喪失原本的得分優勢,等同于被“減分”;若一個答案同時受此二因素影響,幾乎都無法得到正確匹配。

5 結 語

經過本文的分析與研究可得到如下結論:(1) 基于規則的問句識別方法所用規則是有效的,具有較高的識別準確率。(2) 問句識別任務可以當作文本分類任務來處理,且CNN網絡和LSTM網絡可以較好地處理此類問題。(3) 規則與深度學習相結合的問句識別方法具有較強的魯棒性,其召回率較單一方法均有較大提升,可以適應更豐富的任務類型。(4) 回答順序在社交群問答對獲取中有重要意義,合理使用此特征可提升問答對獲取質量。

本文的工作仍有改進余地,未來可以適當考慮省略、指代等因素對問答對獲取的影響。此外,可以考慮使用共現詞之外的特征化解Re_rank與Rank的沖突,進一步提升問答對獲取質量。