基于膠囊網(wǎng)絡(luò)的動(dòng)態(tài)路由研究與改進(jìn)

陳 珊,孫仁誠(chéng),邵峰晶,隋 毅

(青島大學(xué)計(jì)算機(jī)科學(xué)技術(shù)學(xué)院,山東青島 266071)

0 概述

隨著人工智能技術(shù)的發(fā)展,目前卷積神經(jīng)網(wǎng)絡(luò)(CNN)在圖像識(shí)別[1]、圖像分割[2]、文本分類[3]等領(lǐng)域中獲得了巨大的成功。但是隨著CNN 應(yīng)用,發(fā)現(xiàn)其存在識(shí)別物體空間關(guān)系的能力不強(qiáng)和對(duì)物體旋轉(zhuǎn)后的特征識(shí)別能力較弱兩大缺陷。因?yàn)镃NN 通過(guò)池化選取一個(gè)區(qū)域中最活躍的點(diǎn)或者平均聚合所有特征,這種降采樣操作會(huì)丟失物體的空間信息,不利于圖像的正確分類。CNN 采取的解決方案是增加網(wǎng)絡(luò)層數(shù)或數(shù)據(jù)量來(lái)提升性能,但這會(huì)造成模型參數(shù)量和訓(xùn)練時(shí)間的增加。

為了彌補(bǔ)CNN 在圖像處理中丟失物體部件間的相對(duì)位置關(guān)系及旋轉(zhuǎn)不變性差的缺點(diǎn),SABΟUR等[4]提出了膠囊網(wǎng)絡(luò)(Capsule Network,CapsNet)模型。CapsNet 在借鑒CNN 空間特征提取方面優(yōu)勢(shì)的基礎(chǔ)上,提出了膠囊的結(jié)構(gòu)及動(dòng)態(tài)路由的特征選擇方式。在膠囊網(wǎng)絡(luò)中,低層膠囊用來(lái)刻畫物體的局部特征,高層膠囊用來(lái)表達(dá)整體抽象特征,然后使用動(dòng)態(tài)路由機(jī)制聚合低層膠囊信息更新高層膠囊。與CNN 相比,膠囊網(wǎng)絡(luò)僅需少量訓(xùn)練數(shù)據(jù)即可在小規(guī)模圖像分類中取得更好的訓(xùn)練效果,并具有更佳的泛化性[5-6]和可解釋性[7-8]。

然而,膠囊網(wǎng)絡(luò)在特征提取和動(dòng)態(tài)路由機(jī)制中仍有較多亟需改進(jìn)之處。首先,CapsNet 在特征提取部分僅使用了一層卷積提取特征,感受野太小,提取不到足夠的圖像信息,導(dǎo)致生成的初級(jí)膠囊質(zhì)量不高,從而影響模型的分類精度。其次,CapsNet 的動(dòng)態(tài)路由機(jī)制在將低層膠囊中的信息傳遞到高層膠囊時(shí)使用了相同的優(yōu)先級(jí),但對(duì)于場(chǎng)景比較復(fù)雜的圖像,動(dòng)態(tài)路由則需要更多的迭代次數(shù)不斷調(diào)整膠囊之間的匹配程度,才能提取到幫助圖像分類的有效特征[9]。隨后,在迭代過(guò)程中,每個(gè)低層膠囊還只能隸屬于一個(gè)高層膠囊,耦合系數(shù)會(huì)抑制一個(gè)有效特征對(duì)多個(gè)高層膠囊的支持,由此導(dǎo)致一些有效特征不能表達(dá),最終影響圖像的分類效率和準(zhǔn)確率[10]。最后,關(guān)于動(dòng)態(tài)路由的研究均是從低層膠囊和高層膠囊之間的相似性來(lái)篩選特征,忽略了同層膠囊不同位置的像素之間的空間相關(guān)性,從而損失掉有益于圖像分類的重要特征。此外,目前關(guān)于膠囊網(wǎng)絡(luò)的大部分研究,均是在通過(guò)增加網(wǎng)絡(luò)層數(shù)來(lái)提升性能,但是這會(huì)增加模型的參數(shù)量,從而造成模型在計(jì)算資源受限的環(huán)境下不適用。

本文提出一種基于點(diǎn)乘注意力的膠囊圖網(wǎng)絡(luò)(Dot-Product Attention Capsule Graph Network,DPACapsGraph)分類模型。該模型主要由特征提取模塊、膠囊層部分以及重構(gòu)部分組成,模型目標(biāo)是以較小的參數(shù)量實(shí)現(xiàn)更多的有效特征能被高效地傳遞到高層膠囊,從而達(dá)到更高的分類精度,以增加模型的泛化性和魯棒性。

1 相關(guān)工作

膠囊網(wǎng)絡(luò)使用向量神經(jīng)元而非標(biāo)量表示物體在某一位置的特征,其中向量的姿態(tài)表示特征實(shí)體類別的屬性,輸出向量的長(zhǎng)度表示某一類別實(shí)體存在可能性的大小。向量膠囊將物體的位置和姿態(tài)信息封裝在膠囊內(nèi)部,低層膠囊用來(lái)刻畫物體的具體特性,而高層膠囊用來(lái)提取物體的總體抽象特征。隨機(jī)動(dòng)態(tài)路由迭代更新低層膠囊和高層膠囊的耦合系數(shù)Cij,最后通過(guò)壓縮函數(shù)得到表示物體類別信息的高級(jí)膠囊。最終將向量長(zhǎng)度最大的高級(jí)膠囊輸入到重構(gòu)部分,得到模型編解碼后輸出的圖像。為提升膠囊網(wǎng)絡(luò)在圖像分類領(lǐng)域的分類準(zhǔn)確率,目前的研究主要分為創(chuàng)新膠囊結(jié)構(gòu)形式來(lái)優(yōu)化膠囊質(zhì)量,或提出新型動(dòng)態(tài)路由機(jī)制來(lái)選擇特征兩個(gè)方面。

為提高膠囊網(wǎng)絡(luò)在特征提取方面的表現(xiàn)能力,文獻(xiàn)[11]通過(guò)多尺度特征提取獲得結(jié)構(gòu)和語(yǔ)義信息構(gòu)建不同尺度的初級(jí)膠囊,用不同維度的轉(zhuǎn)換矩陣生成相同維度的預(yù)測(cè)膠囊,增加了可學(xué)習(xí)的參數(shù)量。文獻(xiàn)[12]通過(guò)可學(xué)習(xí)的轉(zhuǎn)換矩陣將輸入的特征向量正交投影到膠囊子空間上來(lái)創(chuàng)建膠囊,使其可以學(xué)習(xí)到更多隱層的特征信息。文獻(xiàn)[13]通過(guò)提出使用兩種類型的可變形膠囊,增加特征提取的感受野并增強(qiáng)膠囊對(duì)于數(shù)據(jù)的自適應(yīng)性。文獻(xiàn)[14]將多個(gè)相似的初級(jí)膠囊通過(guò)卷積操作得到張量膠囊,并通過(guò)增加膠囊層數(shù)提升模型效果。但是動(dòng)態(tài)路由因?yàn)榈碌奶匦圆荒茉诰W(wǎng)絡(luò)層中并行執(zhí)行,順序執(zhí)行多個(gè)膠囊層增加了模型的參數(shù)量和計(jì)算時(shí)間。文獻(xiàn)[15]使用兩個(gè)密集殘差網(wǎng)絡(luò)分別構(gòu)造膠囊的姿態(tài)矩陣和預(yù)測(cè)矩陣,然后用奇異值分解檢測(cè)實(shí)體在一維線性子空間上提取的特征,替換了原始的動(dòng)態(tài)路由策略。

同時(shí),關(guān)于隨機(jī)動(dòng)態(tài)路由的改進(jìn)也得到了廣泛關(guān)注,不同的動(dòng)態(tài)路由表示低層膠囊聚合到高層膠囊的方式不同。文獻(xiàn)[16]通過(guò)多組消融實(shí)驗(yàn)證明,隨機(jī)動(dòng)態(tài)路由會(huì)削弱模型的健壯性。因此,有些學(xué)者從聚類最優(yōu)化的角度來(lái)改進(jìn)動(dòng)態(tài)路由過(guò)程。文獻(xiàn)[17]通過(guò)最小化初級(jí)膠囊分布與高級(jí)膠囊的聚類損失和KL 正則化的組合,使動(dòng)態(tài)路由過(guò)程更平滑。文獻(xiàn)[18]運(yùn)用最大-最小正則化標(biāo)準(zhǔn)化耦合系數(shù),從而允許初級(jí)膠囊可以對(duì)多個(gè)高級(jí)膠囊具有高分配概率。上述研究的動(dòng)態(tài)路由都是聚焦于高層膠囊和低層膠囊之間的一致性,忽略了同層膠囊之間的內(nèi)在聯(lián)系,對(duì)于圖像分類問(wèn)題,同層膠囊之間的空間關(guān)系會(huì)影響到分類的準(zhǔn)確性。

注意力機(jī)制[19]則允許模型動(dòng)態(tài)地捕獲更多與解決問(wèn)題相關(guān)的特征信息。TSAI 等[10]稍微改變了原始的動(dòng)態(tài)路由,通過(guò)倒點(diǎn)積機(jī)制計(jì)算高水平膠囊的姿勢(shì)和低水平膠囊的投票之間的一致性,并提出使用并行迭代路由取代順序執(zhí)行,在所有膠囊層之間同時(shí)執(zhí)行路由過(guò)程。但是由于含有多個(gè)膠囊層并發(fā)執(zhí)行動(dòng)態(tài)路由機(jī)制,大幅增加了模型的訓(xùn)練時(shí)間,并對(duì)設(shè)備內(nèi)存提出了較高的要求。文獻(xiàn)[20]是在初級(jí)膠囊層前增加使用注意力機(jī)制的網(wǎng)絡(luò)層,提升模型在特定數(shù)據(jù)集上的分類精度。文獻(xiàn)[21-22]通過(guò)在網(wǎng)絡(luò)中加入注意力模塊來(lái)提升膠囊網(wǎng)絡(luò)在特征提取部分的能力。基于以上研究發(fā)現(xiàn),注意力機(jī)制在膠囊網(wǎng)絡(luò)中大多被用在特征提取部分。本文將點(diǎn)乘注意力機(jī)制用來(lái)改進(jìn)膠囊層之間的路由機(jī)制,利用圖卷積層式傳播的思想來(lái)探究同級(jí)膠囊間所包含的大量特征對(duì)于提升分類準(zhǔn)確性的重要性,從而充分利用同級(jí)特征來(lái)提升模型的分類效果。

本文在MNIST、FashionMNIST、CIFAR10 和SVHN 4 種數(shù)據(jù)集上進(jìn)行了多次實(shí)驗(yàn),通過(guò)和6 個(gè)膠囊網(wǎng)絡(luò)模型的變體進(jìn)行對(duì)比,DPA-CapsGraph 不僅降低了模型的參數(shù)量,而且在4 種數(shù)據(jù)集上均取得了更高的分類準(zhǔn)確率。

本文的主要貢獻(xiàn)包括以下兩個(gè)部分:

1)為了優(yōu)化初級(jí)膠囊的質(zhì)量,使膠囊表達(dá)更多的特征信息,模型在特征提取部分加入跳躍連接來(lái)增加初級(jí)膠囊對(duì)特征的表達(dá)能力,為模型的訓(xùn)練提供更多的信息。

2)為減少參數(shù)量,提高特征選擇的效率以及質(zhì)量,本文采用圖卷積的層式傳播方式代替動(dòng)態(tài)路由進(jìn)行特征選擇,可以在控制網(wǎng)絡(luò)層數(shù)增長(zhǎng)的同時(shí)提升模型的分類準(zhǔn)確度。利用點(diǎn)乘注意力機(jī)制獲得同層膠囊之間的特征依賴關(guān)系,綜合評(píng)估當(dāng)前層中所有膠囊內(nèi)部隱藏狀態(tài)之間的異同點(diǎn),然后通過(guò)特征映射的方式使特征在空間上自動(dòng)聚類,提高模型的分類準(zhǔn)確率。

2 基于點(diǎn)乘注意力圖卷積路由的膠囊網(wǎng)絡(luò)分類模型

針對(duì)CapsNet 的卷積層提取特征部分和動(dòng)態(tài)路由部分存在的問(wèn)題,本文通過(guò)借鑒殘差網(wǎng)絡(luò)和圖卷積網(wǎng)絡(luò)的思想,設(shè)計(jì)了DPA-CapsGraph。

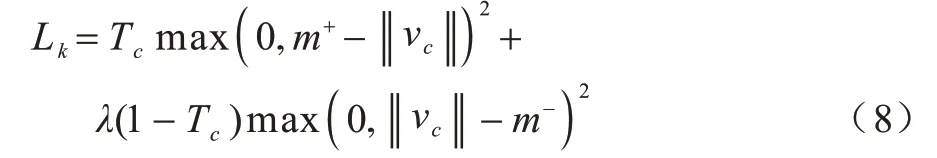

基于點(diǎn)乘注意力的圖卷積路由的膠囊網(wǎng)絡(luò)的模型框架如圖1 所示。

圖1 DPA-CapsGraph 模型框架Fig.1 DPA-CapsGraph model framwork

DPA-CapsGraph 主要分為3 個(gè)部分:

1)特征提取部分,利用去掉池化層的殘差網(wǎng)絡(luò)來(lái)提取既有具體的實(shí)體屬性特征又有概括的抽象特征。

2)膠囊網(wǎng)絡(luò)層,先對(duì)特征提取部分傳入的特征進(jìn)行通道卷積得到膠囊結(jié)構(gòu),然后通過(guò)路由過(guò)程得到高級(jí)膠囊。本文的重點(diǎn)是使用點(diǎn)乘注意力機(jī)制在同層膠囊間構(gòu)建全連通圖,以此獲得同級(jí)膠囊中的豐富特征以及空間依賴關(guān)系,即將原始的動(dòng)態(tài)路由機(jī)制改為利用注意力機(jī)制的圖卷積來(lái)實(shí)現(xiàn)圖像的正確分類。

3)重構(gòu)層,將分類正確的高級(jí)膠囊重構(gòu)成原始的圖像。

2.1 特征提取模塊

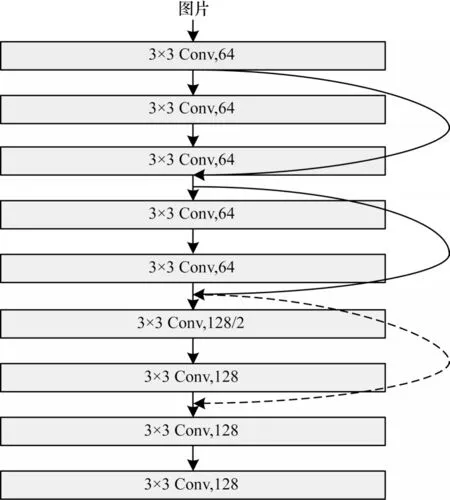

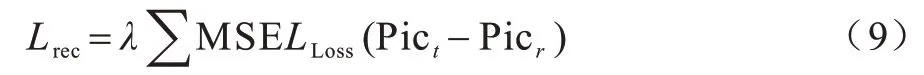

本文在特征提取部分加入恒等映射構(gòu)建殘差網(wǎng)絡(luò),訓(xùn)練時(shí)只需學(xué)習(xí)殘差,解決了傳統(tǒng)卷積層的特征丟失、損耗等問(wèn)題,在一定程度上保護(hù)了信息的完整性。跳躍連接使得特征提取部分的輸出不僅包含特定實(shí)體的屬性信息,還包含圖像整體結(jié)構(gòu)的抽象信息。其次去掉池化層以保留實(shí)體特征之間的空間依賴關(guān)系,最后將提取到的具體屬性和空間信息輸入到初級(jí)膠囊層,增強(qiáng)膠囊的特征表達(dá)能力,優(yōu)化膠囊質(zhì)量,具體結(jié)構(gòu)如圖2 所示。

圖2 特征提取部分結(jié)構(gòu)Fig.2 Structure of feature extraction part

在圖2 中,實(shí)線是在通道數(shù)量一致時(shí)使用Y=F(x)+x的計(jì)算方式,虛線部分是通道數(shù)不一致,需要通過(guò)權(quán)重矩陣進(jìn)行調(diào)整,采用Y=F(x)+Wx的計(jì)算方式。此時(shí)的特征提取部分只需進(jìn)行簡(jiǎn)單的非線性變換而無(wú)需過(guò)度參數(shù)化,在提升模型精度的同時(shí)還能抑制模型過(guò)大。

2.2 DPA-CapsGraph 路由

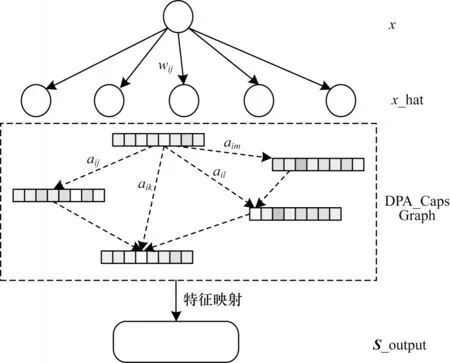

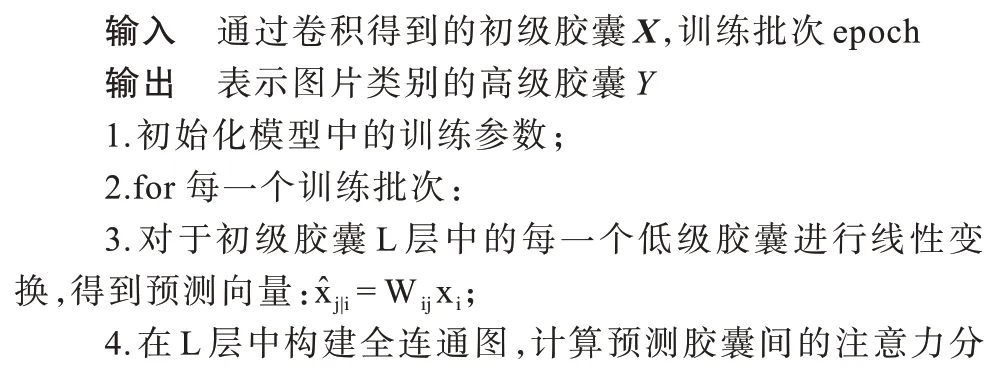

動(dòng)態(tài)路由是在膠囊層間迭代進(jìn)行特征提取的過(guò)程,當(dāng)?shù)蛯幽z囊和高層膠囊的一致性分?jǐn)?shù)較大時(shí),高層膠囊就聚合此低層膠囊中的特征并更新自身狀態(tài),反之則抑制其一致性分?jǐn)?shù)的增長(zhǎng)。為使路由過(guò)程簡(jiǎn)單且有效,本文利用注意力分?jǐn)?shù)代替迭代循環(huán)的耦合系數(shù),不僅可以獲得膠囊層全局上下文的信息,還可以通過(guò)對(duì)高質(zhì)量的膠囊賦予更大的權(quán)重來(lái)提取更多有效的特征信息。本文使用基于圖注意力的特征處理方式,每個(gè)膠囊僅在特征選擇期間捕獲某一位置的特征,取消了模型對(duì)于數(shù)據(jù)源的依賴。膠囊層間的注意力特征提取部分如圖3 所示。

圖3 DPA-CapsGraph 路由過(guò)程Fig.3 DPA-CapsGraph routing process

首先將模型在特征提取部分得到的信息進(jìn)行通道維度的卷積得到初級(jí)膠囊,然后進(jìn)行線性變換得到DPA-CapsGraph 路由過(guò)程中的預(yù)測(cè)膠囊,即利用注意力機(jī)制的圖卷積中的結(jié)點(diǎn)。

其中:Wij∈[8,16]是膠囊層之間做線性變化的權(quán)重矩陣,初級(jí)膠囊是8 維的向量,通過(guò)線性映射得到16 維的預(yù)測(cè)膠囊膠囊的維度越高,表示的圖像信息也就越多,為膠囊間的特征選擇提供更多的特征信息。

在圖像分類任務(wù)中,不同的膠囊提取圖像不同位置的特征,本文使用點(diǎn)積注意力[21]以無(wú)監(jiān)督的方式動(dòng)態(tài)獲取膠囊之間的相似度,為不同鄰居的信息重要性賦予不同權(quán)值,在信息聚合時(shí)重點(diǎn)突出關(guān)鍵性較強(qiáng)的周圍膠囊。

其中:A為預(yù)測(cè)膠囊之間的相似度矩陣,將小于零的權(quán)重置為零,對(duì)相似度矩陣進(jìn)行稀疏化,減少噪音信息的干擾,既可以提高分類的準(zhǔn)確度,還能減輕模型對(duì)設(shè)備計(jì)算資源的壓力,加快計(jì)算速度。

圖結(jié)構(gòu)在特征提取中具有關(guān)于節(jié)點(diǎn)度的傾向性,因?yàn)槎仍酱蟮哪z囊,節(jié)點(diǎn)的重要性越大,即節(jié)點(diǎn)度越大,聚合的信息量就越大。

di即注意力分?jǐn)?shù)矩陣A的每一行元素之和,度矩陣D是di組成的n×n對(duì)角矩陣。

通過(guò)上述運(yùn)算可以獲得像素之間的依賴關(guān)系以及圖像的結(jié)構(gòu)信息,根據(jù)拉普拉斯特征映射的方式得到層式特征傳播算子,將預(yù)測(cè)膠囊中包含的特征在空間上自動(dòng)聚類,從而得到高級(jí)膠囊。

為了提煉每個(gè)膠囊封裝的通道特征信息,得到更加精確的全局特征表達(dá),使用Squashing()函數(shù)得到最終的高級(jí)膠囊vj,使高級(jí)膠囊的模長(zhǎng)限制在[0,1]之間。在膠囊網(wǎng)絡(luò)中,高級(jí)膠囊的長(zhǎng)度用來(lái)表示某個(gè)類別存在的概率大小,膠囊長(zhǎng)度越長(zhǎng),存在的可能性越大,反之則越小。

其中:矢量vj表示高級(jí)膠囊的輸出,長(zhǎng)度代表j類別存在的概率大小;姿態(tài)表示物體的顏色等特征。

2.3 重構(gòu)層及損失函數(shù)

取出輸出Digit-Caps 層中長(zhǎng)度最大的高級(jí)膠囊,將其輸入到三層全連接網(wǎng)絡(luò)層進(jìn)行重構(gòu),得到模型最后輸出的重構(gòu)圖片。

本文的損失函數(shù)由編碼損失和重構(gòu)損失兩部分構(gòu)成,訓(xùn)練目標(biāo)是損失加和最小化,公式如下:

在模型的分類部分使用margin loss 對(duì)每一個(gè)表征數(shù)字c的膠囊分別給出邊緣損失函數(shù)。

其中:m+=0.9;m-=0.1;λ=0.005;Tc表示c類別是否存在,存在取值為1,否則為0。

重構(gòu)損失是原始圖像和重構(gòu)圖像之間的差距,公式如下:

其中:Pict表示原始圖像;Picr表示重構(gòu)出來(lái)的圖像,是預(yù)防模型過(guò)擬合的縮放系數(shù)。

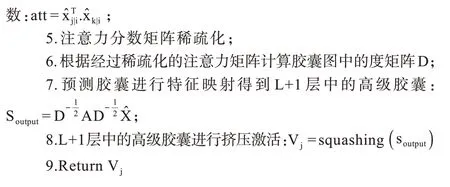

2.4 DPA-CapsGraph 模型算法描述

DPA-CapsGraph 模型的算法學(xué)習(xí)過(guò)程如下:

算法DPA-CapsGraph 學(xué)習(xí)算法

3 實(shí)驗(yàn)結(jié)果與分析

3.1 數(shù)據(jù)預(yù)處理

3.1.1 數(shù)據(jù)集

為了充分驗(yàn)證DPA-CapsGraph 的分類效果,本文選取 了 MNIST、FashionMNIST、CIFAR10 和SVHN 4 種公開數(shù)據(jù)進(jìn)行實(shí)驗(yàn)。FashionMNIST 和CIFAR10 是各類衣物、動(dòng)物、交通工具類的圖像,其中包含更復(fù)雜的背景和物體結(jié)構(gòu)信息,也更符合真實(shí)世界中的圖像。MNIST 和SVHN 都是數(shù)字?jǐn)?shù)據(jù)集,而SVHN 是來(lái)源于谷歌街景門牌號(hào)碼的彩色圖片,含有較多的噪音數(shù)字。本文選取的數(shù)據(jù)集類型和樣本大小均是多樣化的,MNIST 和FashionMNIST是尺寸大小為28×28 像素的灰度圖,CIFAR10 和SVHN 是32×32 像素的RGB 圖像。

3.1.2 實(shí)驗(yàn)環(huán)境及參數(shù)設(shè)置

本文模型是在Ubuntu18.04 操作系統(tǒng)的平臺(tái)上采用Pytorch 框架進(jìn)行開發(fā),編程語(yǔ)言為Python3.6,并使用NVIDIA GeForce GTX 1080Ti顯卡來(lái)加速模型訓(xùn)練。

DPA-CapsGraph 由特征提取部分、初級(jí)膠囊層、高級(jí)膠囊層和重構(gòu)層四部分構(gòu)成,基于注意力機(jī)制的圖卷積層間信息提取過(guò)程應(yīng)用于初級(jí)膠囊層和高級(jí)膠囊層之間。在特征提取部分采用ResNet18 的前3 個(gè)Block,去掉池化層共有13 層3×3 的卷積用來(lái)提取圖像的特征,其通道數(shù)分別為64、128 和256。然后將特征提取部分的輸出特征圖經(jīng)過(guò)通道卷積得到32 個(gè)8 維的低級(jí)向量膠囊。最后經(jīng)過(guò)特征映射篩選出10 個(gè)16 維的高級(jí)膠囊。

3.1.3 評(píng)價(jià)指標(biāo)

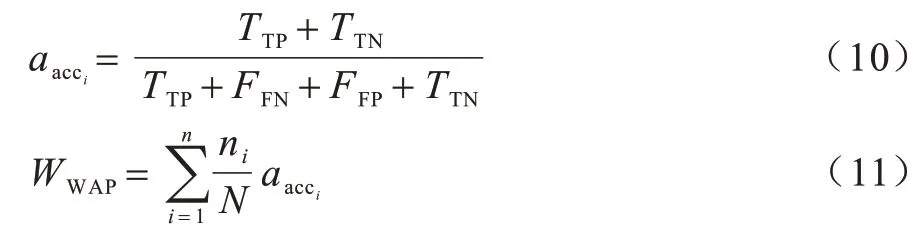

本文使用加權(quán)平均精確度(Weighted Average Accuracy,WAA)作為評(píng)價(jià)指標(biāo)。在各類樣本中,該指標(biāo)可以更有效地評(píng)估模型的分類能力。

其中:aacci表示類別i的分類準(zhǔn)確率;TTP是將真樣本正確分類為真樣本的數(shù)量;TTN是將假樣本預(yù)測(cè)為假樣本的數(shù)量;FFN是將真樣本預(yù)測(cè)為假樣本的數(shù)量;FFP是將假樣本預(yù)測(cè)為真樣本的數(shù)量;ni是類別i的樣本總數(shù);N是樣本總量。準(zhǔn)確度越高,模型的分類效果越好。

3.2 實(shí)驗(yàn)結(jié)果

3.2.1 DPA-CapsGraph 消融實(shí)驗(yàn)

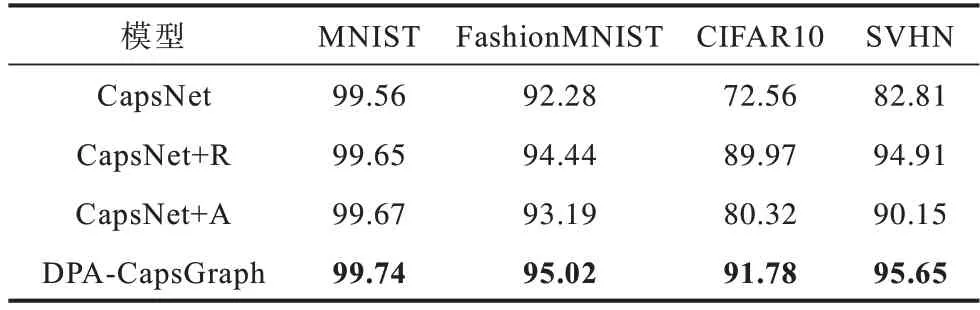

對(duì)CapsNet模型的改進(jìn)包括兩部分,為了準(zhǔn)確評(píng)估各部分改進(jìn)的效果,本文設(shè)置了如下消融實(shí)驗(yàn)對(duì)比分析不同改進(jìn)對(duì)模型分類效果的影響,如表1 所示,其中粗體表示結(jié)果最優(yōu)。消融實(shí)驗(yàn)共分為3 個(gè)部分:

表1 DPA-CapsGraph 消融實(shí)驗(yàn)準(zhǔn)確率Table 1 Accuracy of DPA-CapsGraph ablation experiment %

1)CapsNet+R。改善模型的特征提取部分來(lái)優(yōu)化初級(jí)膠囊的質(zhì)量,在CapsNet 的基礎(chǔ)上只將原始的特征提取部分更改為具有跳躍連接的殘差網(wǎng)絡(luò)。

2)CapsNet+A。優(yōu)化動(dòng)態(tài)路由,在CapsNet 上僅更改動(dòng)態(tài)路由部分。

3)DPA-CapsGraph。在CapsNet 添加殘 差塊和替換動(dòng)態(tài)路由兩部分。

由表1 可知,增加特征提取部分和更換路由機(jī)制的優(yōu)化方法均會(huì)提高模型的分類準(zhǔn)確率,其中優(yōu)化特征提取部分對(duì)模型的改進(jìn)效果更為明顯。對(duì)于FashionMNIST 數(shù)據(jù)集來(lái)說(shuō),只改進(jìn)路由機(jī)制對(duì)模型效果提升較小,但是在綜合優(yōu)化膠囊質(zhì)量的優(yōu)勢(shì)之后,效果提升較大。因?yàn)镕ashionMNIST 是結(jié)構(gòu)較復(fù)雜的灰度圖,CapsNet 中的卷積層提取不到足夠的特征,所以優(yōu)化膠囊質(zhì)量表達(dá)更多的特征是必不可少的。對(duì)于CIFAR10 和SVHN 兩種彩色數(shù)據(jù)集,動(dòng)態(tài)路由機(jī)制的改進(jìn)使模型準(zhǔn)確率分別提升了7.76%和7.34%,效果明顯,消融實(shí)驗(yàn)證明了本文提出的路由機(jī)制利用注意力機(jī)制可以關(guān)注到特征圖中距離較遠(yuǎn)的膠囊信息,得到關(guān)于圖像全局的結(jié)構(gòu)信息,從而使模型能夠有效地選擇特征進(jìn)行圖像分類。綜合優(yōu)化膠囊質(zhì)量和更換路由機(jī)制兩方面的優(yōu)勢(shì),模型在4 種數(shù)據(jù)集上分別提升了0.18%、2.74%、19.22% 和12.84%。此外,DPA-CapsGraph 在訓(xùn)練輪數(shù)上也有一定的表現(xiàn)結(jié)果,如圖4 所示。

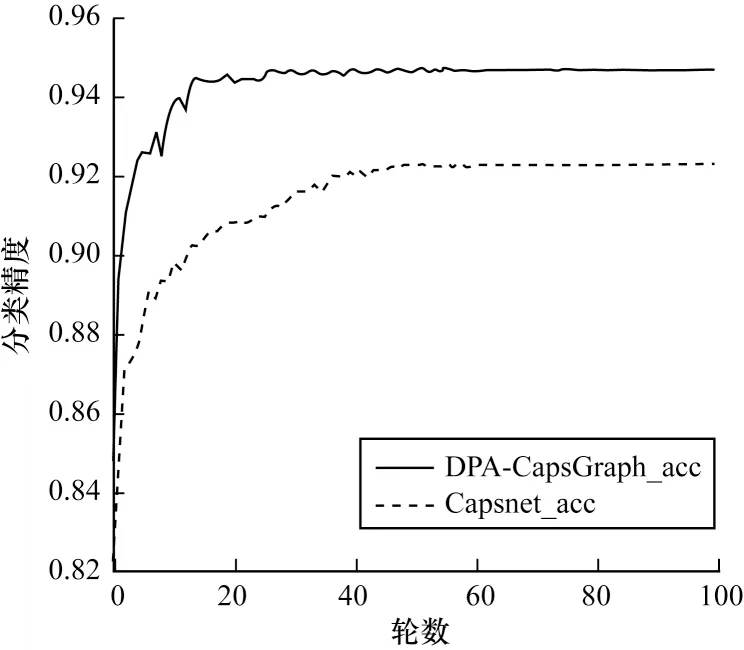

圖4 DPA-CapsGraph 在FashionMNIST 中的分類精度Fig.4 Classification accuracy of DPA-CapsGraph in FashionMNIST

由圖4可知,在相同的實(shí)驗(yàn)環(huán)境下,DPA-CapsGraph在訓(xùn)練初始階段能夠取得較好的分類精度,是因?yàn)楸疚哪P涂梢蕴崛「嗟奶卣鲙椭P瓦M(jìn)行分類。但是根據(jù)多次實(shí)驗(yàn)可知,DPA-CapsGraph 在每一輪訓(xùn)練時(shí)間上是Capsnet的兩倍,但是在模型訓(xùn)練的輪數(shù)上,DPACapsGraph 只需更少的訓(xùn)練輪數(shù)就能收斂到更高的分類精度,所以總的訓(xùn)練時(shí)間是在可接受范圍內(nèi)。此外對(duì)于分類模型,適當(dāng)增加訓(xùn)練時(shí)間來(lái)提升模型的分類精度是可取的,由此證明本文提出的改進(jìn)方法有一定的實(shí)用價(jià)值。

3.2.2 DPA-CapsGraph 與其他模型的對(duì)比

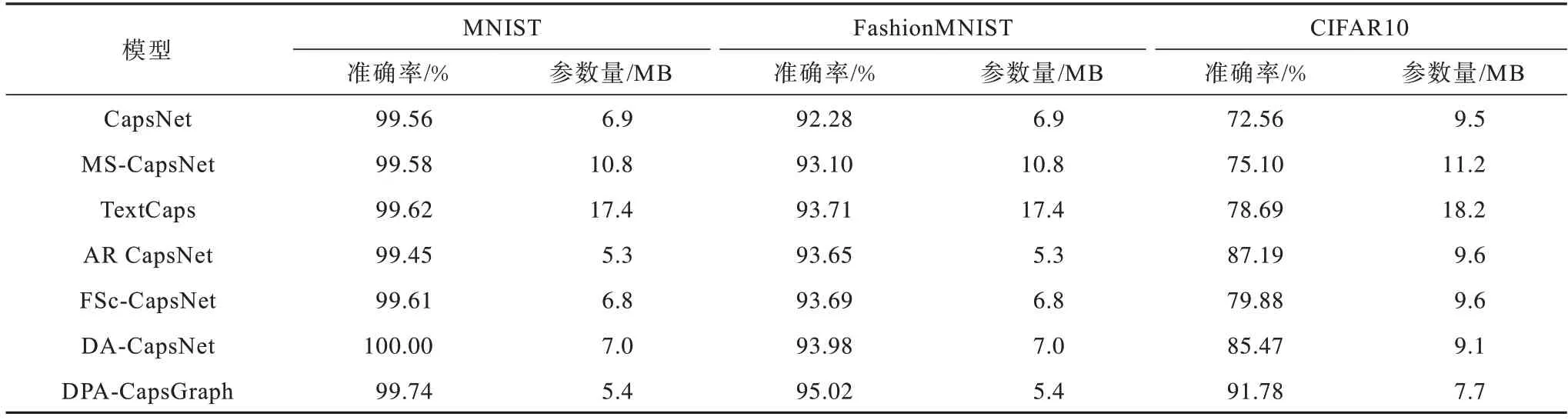

為充分評(píng)估DPA-CapsGraph 在圖像分類任務(wù)中的效果,本文選取了MS-CapsNet[11]、TextCaps[23]、AR CapsNet[24]、FSc-CapsNet[25]和DA-CapsNet[21]5 個(gè)對(duì)比模型。為確保對(duì)比模型的準(zhǔn)確性,以上模型均是從膠囊的結(jié)構(gòu)和動(dòng)態(tài)路由兩方面來(lái)改進(jìn)向量膠囊網(wǎng)絡(luò),在實(shí)驗(yàn)過(guò)程中盡可能地使用了相同的參數(shù)設(shè)置,對(duì)比結(jié)果如表2 所示。

表2 DPA-CapsGraph 與不同模型的分類準(zhǔn)確率和參數(shù)規(guī)模對(duì)比Table 2 Comparison of classification accuracy and parameter scale between DPA-CapsGraph and different models

由表2可知,DPA-CapsGraph 在 MNIST、FashionMNIST 和CIFAR10 3 種數(shù)據(jù)集上的準(zhǔn)確率分別達(dá)到到99.74%、95.02%和91.78%,在除MNIST以外的另外兩種數(shù)據(jù)集上,比表現(xiàn)最好的模型分別高出1.04 和4.59 個(gè)百分點(diǎn)。而且DPA-CapsGraph 在達(dá)到最優(yōu)分類準(zhǔn)確率時(shí),在 MNIST 和FashionMNIST 上僅使用了5.4 MB 的參數(shù)量,相比CapsNet 減少了51%,在CIFAR10 數(shù)據(jù)集上也僅使用了7.7 MB 的數(shù)據(jù),參數(shù)量也減少了36.4%。以上參數(shù)量的減少主要是因?yàn)槟P驮谔卣魈崛〔糠痔崛〉郊扔袑?shí)體的具體屬性也有抽象的特征,保證了路由階段所需的有效特征。所以可以通過(guò)減少初級(jí)膠囊的數(shù)量,使得模型的參數(shù)量有了一定程度的下降。綜上所述,膠囊結(jié)構(gòu)因包含更多的特征結(jié)構(gòu),過(guò)多的膠囊會(huì)增加模型的參數(shù)量,造成特征檢測(cè)器的冗余,所以本文在提升膠囊質(zhì)量的同時(shí),在同層膠囊間用全局注意力構(gòu)建圖結(jié)構(gòu),篩選出圖像中含有豐富特征的膠囊,從而能夠在參數(shù)量小于對(duì)比模型的情況下,在3 種數(shù)據(jù)集上均達(dá)到了更高的分類精度。DPA-CapsGraph 模型能夠充分利用原始數(shù)據(jù)的信息,而且還捕捉到了同級(jí)膠囊之間的相互影響程度,由此可以證明空間依賴關(guān)系對(duì)于圖像分類的準(zhǔn)確率有一定的幫助。因此,本文的改進(jìn)模型在圖像分類領(lǐng)域是合理可行的。

4 結(jié)束語(yǔ)

膠囊網(wǎng)絡(luò)可以較少的網(wǎng)絡(luò)層和相對(duì)較少的參數(shù)量,達(dá)到標(biāo)準(zhǔn)卷積神經(jīng)網(wǎng)絡(luò)在圖像分類上的效果。為進(jìn)一步提高膠囊網(wǎng)絡(luò)在圖像分類領(lǐng)域的分類準(zhǔn)確率,本文通過(guò)點(diǎn)乘注意力構(gòu)建膠囊圖,獲得同層膠囊之間的依賴關(guān)系。DPA_CapsGraph 不僅彌補(bǔ)了原始路由過(guò)程忽略同級(jí)特征的不足,而且還實(shí)現(xiàn)了提升模型的整體表現(xiàn),在特征提取部分加入跳躍連接進(jìn)行特征提取,提高了初級(jí)膠囊的特征表達(dá)能力;使用點(diǎn)乘注意力構(gòu)建同層膠囊之間的關(guān)系圖代替動(dòng)態(tài)路由,提高了膠囊層間的特征選擇能力。實(shí)驗(yàn)結(jié)果表明,DPA-CapsGraph 相比于傳統(tǒng)膠囊網(wǎng)絡(luò)模型,不但減少了模型的參數(shù)量,而且在CIFAR10 等多種數(shù)據(jù)集上均取得了更高的分類準(zhǔn)確率。但DPACapsGraph 相比其他模型考慮了更多的圖像信息,會(huì)存在部分冗余特征,模型在計(jì)算方面的時(shí)間相對(duì)會(huì)增加,下一步將在確保準(zhǔn)確率的前提下精簡(jiǎn)特征,加快模型訓(xùn)練速度。