快速魯棒高光譜目標跟蹤算法

徐清宇 李冬冬 蒯楊柳 盛衛東 鄧新蒲

摘 要:????? 針對傳統目標跟蹤的難點如目標與背景混淆及目標外觀急劇變化等問題,利用高光譜視頻包含的二維空域信息和豐富的一維頻譜信息,提出一種快速魯棒目標跟蹤算法FRHT。首先,在傳統的空域注意力機制上基于高光譜數據的特點引入頻譜注意力機制,設計了相關濾波框架下自適應更新學習的跟蹤器; 其次,手工設計高光譜運動目標特征以加快跟蹤器運算速度; 最后,提出一種運動目標異常檢測機制,以增強跟蹤器對各種干擾的魯棒性。仿真結果表明,在高光譜數據集上,跟蹤器FRHT的速度和精度顯著優于KCF,SAMF和CSR-DCF等傳統跟蹤算法,精度提升2%以上; 引入運動目標檢測機制后,算法魯棒性得到改善。

關鍵詞:???? 目標跟蹤; 目標特征; 高光譜; 相關濾波; 注意力機制; 魯棒性

中圖分類號:???? TJ760; TN911.73

文獻標識碼:??? A

文章編號:???? 1673-5048(2022)02-0039-06

DOI: 10.12132/ISSN.1673-5048.2021.0131

0 引? 言

隨著人類航天活動的增加,空間運動目標檢測跟蹤在軍事領域、航天測控等方面發揮著越來越重要的作用[1]。目前,對空間物體的全鏈路監視跟蹤是天基光學監視系統急需解決的問題[2-3]。空間目標體積小,速度快,導致遠距離觀測條件下目標能量極為微弱,沒有與背景進行區分的顯著特征。因此,基于對目標分辨率和檢測靈敏度的要求,高光譜目標檢測跟蹤受到人們的關注[4]。

由于傳統視覺目標跟蹤不能滿足某些極端條件下的跟蹤要求,在目標與背景相似或者跟蹤目標快速變化時,跟蹤器難以快速更新跟蹤器。準確獲取目標信息,及時更新跟蹤器對于快速準確跟蹤目標至關重要。一般而言,當下目標跟蹤主要有兩種框架: (1)深度學習框架; (2)相關濾波框架。本研究重點關注后者,即在相關濾波框架下,將空域目標傅里葉變換到頻域后進行跟蹤的方法。

基于高光譜數據的目標跟蹤是目標跟蹤領域中一個新興的研究方向,其包含多譜段的豐富信息,對于實現精確目標跟蹤具有特殊的優勢。與可見光圖像數據(RGB)或者單通道圖像不同,高光譜數據(HSI)包含空間二維信息和豐富的一維頻域信息,可以在可見光或是紅外光難以辨識目標的情況下,將不同的物體區分開,比如白色的卡片和白色的紙。特斯拉汽車由于使用RGB視覺目標跟蹤系統,將白色的卡車誤認為白色的天空,致使發生車禍[5]。從另一方面,可以看出高光譜目標跟蹤在現實世界中頗具應用前景,如瓦斯檢測[6]等。

目前,針對高光譜目標跟蹤的研究仍十分有限。Xiong等[7]提出的目標跟蹤器 MHT(Material-Based Hyperspectral Tracker)利用基于空間頻譜直方圖統計的手工特征(Spectral-Spatial Histogram of Multidimensional Gradients, SSHMG),模擬目標物質信息,實現目標跟蹤。為了促進這個新興領域的發展,熊鳳超等人在2020年組織了高光譜數據目標跟蹤競賽,并提供了一個精心制作的高光譜數據集 Whisper[7],供學者進行研究對比。該數據集共有40段訓練視頻和35段測試視頻,平均每個視頻序列的長度達 425幀。每個視頻序列都標記了面臨的挑戰因素,所有的標記因素共11類, 分別為尺度變化(Scale Variation, SV)、運動模糊(Motion Blur, MB)、遮擋(Occlusion, OCC)、快速移動(Fast Motion, FM)、低分辨率(Low Resolution, LR)、面內運動(In-Plane Rotation, IPR)、面外運動(Out-of-Plane Rotation, OPR)、形變(Deformation, DEF)、背景模糊(Background Clutters,? BC)、 光照變化(Illumination? Variation, IV)和目標丟失

(Out-of-View, OV)。與其他傳統的基于相關濾波的跟蹤器[8-12]相比,MHT在高光譜數據集Whisper上的表現更為優異。但是SSHMG 特征通過3D直方梯度圖提取,需要在高維度空間進行大量計算,降低了目標跟蹤的速度。

針對高光譜圖像數據維度高、處理耗時的特點,本文提出了一個新穎的高光譜圖像快速跟蹤算法FRHT(Fast and Robust Hyperspectral Tracker),在相關濾波跟蹤的框架下,融合空間注意力和頻域注意力機制,實現快速魯棒目標跟蹤。

與MHT使用的3D梯度特征不一樣,本文使用的特征是壓縮后的灰度圖像特征,可以在速度和精度兩者間取得平衡。在跟蹤過程中,利用空間注意力機制,二值分割出一個自適應調整的目標分割模板,使跟蹤器可以用目標圖像塊進行更新。對高維圖像特征,頻譜注意力機制可以通過學習權重,不同頻域通道加權后進行定位跟蹤。不僅如此,本文還設計了運動目標異常檢測算法,用于對異常目標進行檢測,及時糾正跟蹤器。

本文創新點如下: (1)針對高光譜數據特點,提出了一個基于相關濾波的高光譜目標跟蹤器FRHT; (2)提出了高光譜運動目標異常檢測算法,用于及時糾偏高光譜跟蹤器; (3)在當下最新的高光譜基準數據集 Whisper 上做了大量仿真實驗,結果表明所提方法跟蹤精度優于可見光跟蹤算法,同時跟蹤速度大幅提升。

1 相關濾波跟蹤

目標跟蹤是計算機視覺領域最富有挑戰性的任務之一,目前主流有兩個跟蹤框架,一個是基于相關濾波框架,一個是基于孿生網絡的深度學習框架。基于深度孿生網絡的跟蹤方法,需要大量樣本來訓練網絡參數,以學習運動目標的空間特征表示,

因此,在訓練和實時測試兩個階段,該方法耗時多[13-15]。相比之下,基于相關濾波的跟蹤將目標信息根據傅立葉變換從空域到頻域進行相關跟蹤,大大提升了計算效率。

Bolme等[16]首先富有開創性地將相關濾波的原理引入了目標跟蹤領域,提出最小輸出平方和濾波跟蹤器MOSSE(Minimum Output Sum of Squared Error Filter)。由于相關濾波跟蹤器將空域計算轉換到頻域進行,基于相關濾波的跟蹤器計算效率通常都很高。MOSSE能夠以每秒數百幀的速度實現精確魯棒地跟蹤目標,將目標跟蹤的研究向前推進了一大步。Henriques等[17]提出的核相關濾波器KCF(Kernel Correlation Filter),通過對提取的目標特征施加線性核的方法,提升跟蹤器將目標與環境背景的區分能力。該方法在目標相鄰區域采樣大量圖像塊,由于圖像塊包含目標與背景,且有偏移真值,相關濾波器經過訓練后可以提升識別目標能力。圖像塊組成的循環矩陣會帶來邊緣效應,為了消除這種影響,Danelljan等 [18]提出跟蹤器ECO(Efficient Convolution Operators)來消除這種負面影響。Lukeic等[12]提出CSR-DCF(Channel and Spatial Reliability-Discriminative Correlation Filter)跟蹤器,可以在空域和特征維度同時學習權重參數,針對性進行跟蹤。2017年的視覺目標跟蹤競賽VOT2017[19]中,ECO和 CSR-DCF 表現最為出色。

本文的基本框架主要是CSR-DCF,為更好介紹FRHT,下面對CSR-DCF的具體實現細節進行回顧。

目標跟蹤的主要問題是要在時間t和取樣點坐標i找到合適的濾波器,在給定的輸入xi∈Rdw×dh×p上得到想要的輸出y i∈Rdw×dh×1,其中dw和dh分別表示搜索區域的長和寬,p代表輸入數據的維度;? 基于相關濾波的跟蹤器根據上一幀預測結果在目標點周圍密集采樣。由于采樣點隨機,裁取的圖像塊隨機覆蓋跟蹤目標,若圖像塊中包含目標則此樣本為正例,若不包含目標則為負例。濾波器的目的是使算法在所有采樣圖像塊中跟蹤偏差最小。對該問題的優化求解是一個嶺回歸問題[20],即

minhL(h; xi, yi) =yi -hTfi2 + λh2(1)

式中: 常數λ用來正則化優化過程,防止濾波器過擬合表示提取出的圖像塊特征。

針對經典目標跟蹤器SRDCF[21]利用大量采樣圖像塊構成循環矩陣學習目標特征時易引入環境背景噪聲的問題,CSR-DCF通過學習目標與背景特征分割出模板m,將目標周圍環境背景遮擋,來解決優化過程中產生的圖像邊緣效應。將上述問題式(1)轉化為一個有約束的優化問題,即

minhL(h; xi,yi)=yi-hTmfi2 + λh2(2)

Lukeic等[12]引入變量hc≡m⊙h將這個優化問題轉化為增廣拉格朗日求解問題,即

minh^Hcdiag(f^)-y^2+λ2h2+μh^c-h^2+

[I^H(h^c-h^)+I^H(h^c-h^)](3)

為了簡潔,令hm=m⊙h。可以通過 Boyd等[22]的方法分兩步循環解決該問題,如式(4)~(5)所示。

h^i+1c=(f^⊙y^+(μh^im-I^i))⊙-1(f^⊙f^+μi) (4)

hi+1=m⊙F-1(I^i+μih^i+1c)/λ2D+μi(5)

濾波器h按式(4)和式(5)就可以分兩步實現更新。這里操作符a^= vec (F[a])主要用于將矩陣變量a轉化到頻域一維向量,長度為圖片所含像素數量a^∈RD×1,D=dw·dh,I^是為一個復數的拉格朗日乘子。

2 快速魯棒跟蹤器

高光譜(HSI)數據相對于可見光(RGB)數據維度高,相同時間長度對跟蹤器的計算負擔更重。CSR-DCF針對可見光圖像設計了梯度特征(HOG)、顏色特征(CN)和灰度特征(grayscale),并在特征維度進行疊加作為目標特征。針對高光譜數據,在CSR-DCF跟蹤器的基礎上,設計了高光譜特征及高光譜運動目標異常檢測機制。

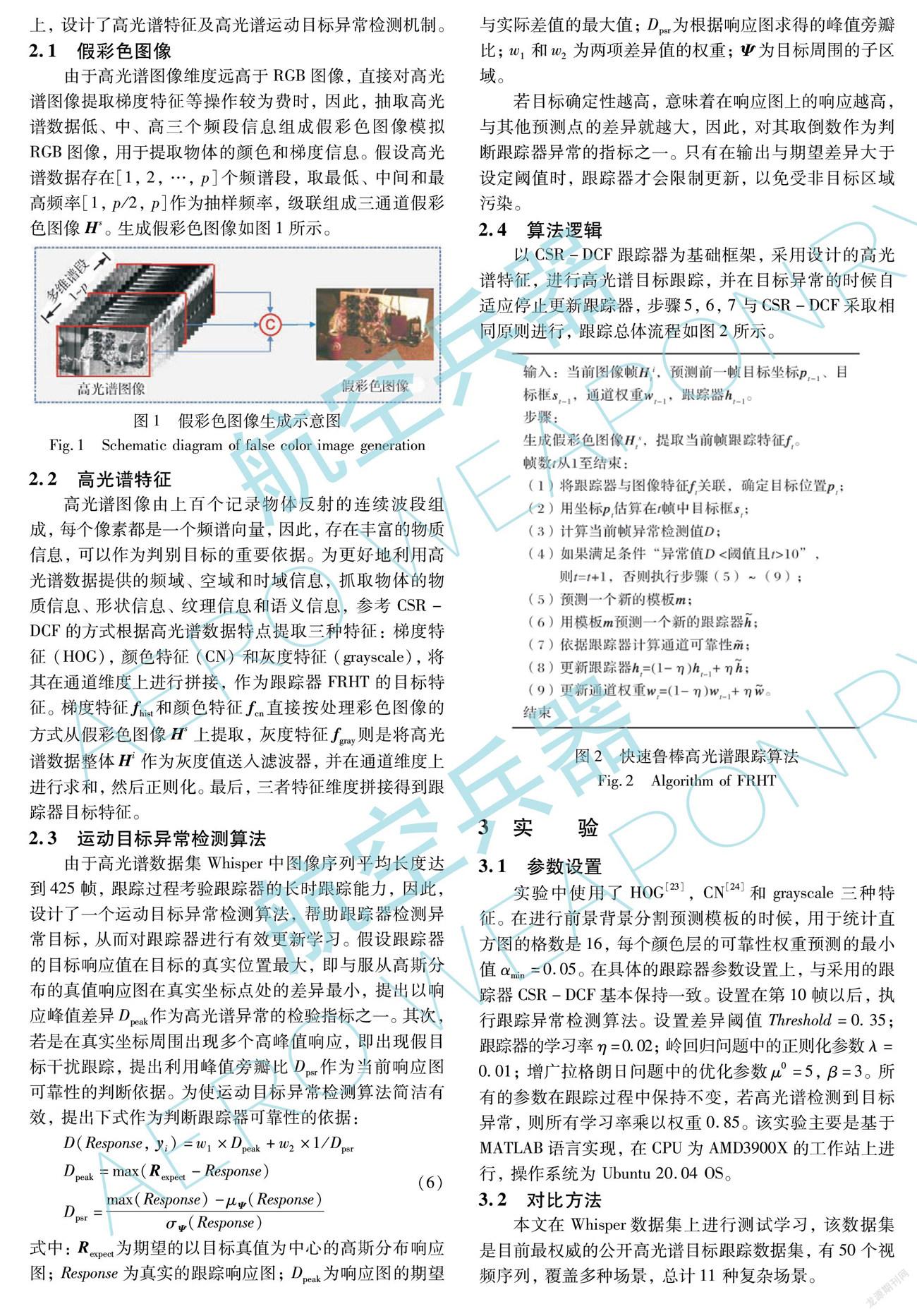

2.1 假彩色圖像

由于高光譜圖像維度遠高于RGB圖像,直接對高光譜圖像提取梯度特征等操作較為費時,因此,抽取高光譜數據低、中、高三個頻段信息組成假彩色圖像模擬RGB圖像,用于提取物體的顏色和梯度信息。假設高光譜數據存在[1, 2, …, p]個頻譜段,取最低、中間和最高頻率[1, p/2, p]作為抽樣頻率,級聯組成三通道假彩色圖像Hs。生成假彩色圖像如圖1所示。

2.2 高光譜特征

高光譜圖像由上百個記錄物體反射的連續波段組成,每個像素都是一個頻譜向量,因此,存在豐富的物質信息,可以作為判別目標的重要依據。為更好地利用高光譜數據提供的頻域、空域和時域信息,抓取物體的物質信息、形狀信息、紋理信息和語義信息,參考CSR-DCF的方式根據高光譜數據特點提取三種特征: 梯度特征 (HOG),顏色特征 (CN) 和灰度特征 (grayscale),將其在通道維度上進行拼接,作為跟蹤器FRHT的目標特征。梯度特征fhist和顏色特征fcn直接按處理彩色圖像的方式從假彩色圖像Hs上提取,灰度特征fgray則是將高光譜數據整體Hi作為灰度值送入濾波器,并在通道維度上進行求和,然后正則化。最后,三者特征維度拼接得到跟蹤器目標特征。

2.3 運動目標異常檢測算法

由于高光譜數據集Whisper中圖像序列平均長度達到425幀,跟蹤過程考驗跟蹤器的長時跟蹤能力,因此,設計了一個運動目標異常檢測算法,幫助跟蹤器檢測異常目標,從而對跟蹤器進行有效更新學習。假設跟蹤器的目標響應值在目標的真實位置最大,即與服從高斯分布的真值響應圖在真實坐標點處的差異最小,提出以響應峰值差異Dpeak作為高光譜異常的檢驗指標之一。其次,若是在真實坐標周圍出現多個高峰值響應,即出現假目標干擾跟蹤,提出利用峰值旁瓣比Dpsr作為當前響應圖可靠性的判斷依據。為使運動目標異常檢測算法簡潔有效,提出下式作為判斷跟蹤器可靠性的依據:

D(Response, yi)=w1×Dpeak+w2×1/Dpsr

Dpeak=max(Rexpect-Response)

Dpsr=max(Response)-μΨ(Response)σΨ(Response)(6)

式中: Rexpect為期望的以目標真值為中心的高斯分布響應圖; Response為真實的跟蹤響應圖; Dpeak為響應圖的期望與實際差值的最大值; Dpsr為根據響應圖求得的峰值旁瓣比; w1和w2為兩項差異值的權重; Ψ為目標周圍的子區域。

若目標確定性越高,意味著在響應圖上的響應越高,與其他預測點的差異就越大,因此,對其取倒數作為判斷跟蹤器異常的指標之一。只有在輸出與期望差異大于設定閾值時,跟蹤器才會限制更新,以免受非目標區域污染。

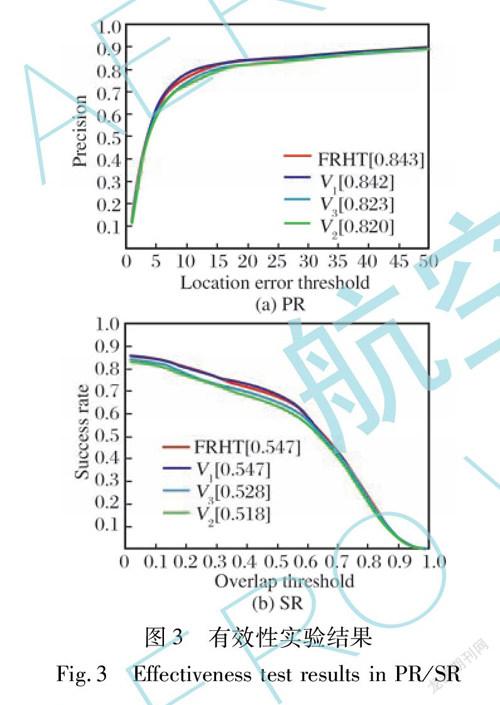

2.4 算法邏輯

以CSR-DCF跟蹤器為基礎框架,采用設計的高光譜特征,進行高光譜目標跟蹤,并在目標異常的時候自適應停止更新跟蹤器,步驟5,6,7與CSR-DCF采取相同原則進行,跟蹤總體流程如圖2所示。

3 實? 驗

3.1 參數設置

實驗中使用了HOG[23],CN[24]和grayscale三種特征。在進行前景背景分割預測模板的時候,用于統計直方圖的格數是16,每個顏色層的可靠性權重預測的最小值αmin=0.05。在具體的跟蹤器參數設置上,與采用的跟蹤器CSR-DCF基本保持一致。設置在第10幀以后,執行跟蹤異常檢測算法。設置差異閾值Threshold=0.35; 跟蹤器的學習率η=0.02; 嶺回歸問題中的正則化參數λ=0.01; 增廣拉格朗日問題中的優化參數μ0=5,β=3。所有的參數在跟蹤過程中保持不變,若高光譜檢測到目標異常,則所有學習率乘以權重0.85。該實驗主要是基于MATLAB語言實現,在CPU為AMD3900X的工作站上進行,操作系統為 Ubuntu 20.04 OS。

3.2 對比方法

本文在 Whisper數據集上進行測試學習,該數據集是目前最權威的公開高光譜目標跟蹤數據集,有50個視頻序列,覆蓋多種場景,總計11 種復雜場景。

選取當下性能最優的8種跟蹤器作為對比跟蹤的方法, 分別是 MHT[7], Staple[8], DSST[9], SAMF[11], CSR-DCF[12], KCF [17], BACF[18], fDSST[25]。除 MHT 和本文提出的快速魯棒跟蹤器 FRHT 外,其余跟蹤器均是針對可見光視頻序列設計,因此,在Whisper提供的 RGB 圖像上測試 RGB 跟蹤器的性能。采用跟蹤精確度 PR (Precision Rate)和跟蹤成功率 SR (Success Rate)評價跟蹤器的性能。PR 是視頻序列中跟蹤器與真值的誤差在一定范圍的幀數與總幀數的比值,文中將像素距離設置為20。SR 是跟蹤器的預測目標框與真值目標框重合度大于一定閾值的幀數與總幀數的比值。

3.3 有效性測試

為了驗證所提方法的有效性,使用三種變體V1,V2,V3。其中: 變體V1將FRHT中的高光譜異常檢測機制去除; 變體V2不在通道維度壓縮FRHT所使用的grayscale特征fgray,保持維度不變,仍為p; 變體V3同時采取變體V1和V2相對于FRHT所做改變。圖3展示了對比結果。

可以看出,采取本文的算法取得性能最優,與之相對的變體V1和V2在PR指標上分別下降0.1%和2.3%,V2在SR指標上下降2.9%。V3在 PR和SR上分別下降 2.0%和1.9%。FRHT將高光譜灰度特征fgray壓縮至1通道,相對于V2性能更優,是由于多譜段目標位置存在偏移,將其在特征提取階段進行預融合,降低了跟蹤器跟蹤目標的難度。V1表現不及本文所提算法,可以看出高光譜異常檢測機制的有效性。

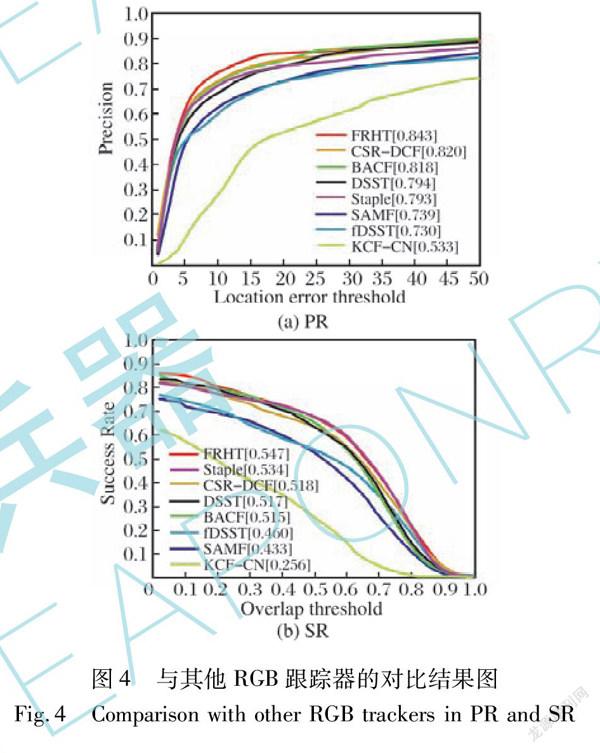

3.4 性能分析

為了證明所提方法的性能,與當下性能最優的幾種跟蹤算法進行比較。KCF跟蹤器對提取的圖像特征施加了一個線性核,將其映射到新的維度空間,提高了跟蹤器在背景中辨識目標的能力,文中設置提取的圖像特征為CN,故實驗中表示為KCF-CN; BACF通過將所有的背景圖像塊視作負例,可以針對相關濾波器裁圖像塊進行訓練產生的邊界效應進行抑制,MHT采取 BACF作為其基礎跟蹤器; DSST和fDSST是Danelljan等人提出的可以精確預測目標尺寸的跟蹤器,在跟蹤過程針對目標尺寸變化可以保持魯棒性; Staple 通過提取目標復合信息可以使跟蹤器更魯棒。本文的跟蹤器 FRHT采用CSR-DCF作為基礎跟蹤器。FRHT性能略低于MHT的原因在于追求跟蹤器運行效率,簡化特征,但損失了部分信息量。與其他7種算法相比,本文方法取得了更優的性能,如圖4所示。 FRHT與 KCF和fDSST相比,在 PR 上分別提升31%和11.3%,在 SR 上分別提升29.1%和8.7%,增益效果顯著。主要原因在于KCF和fDSST在目標偏移時不具有糾偏能力,對于長序列跟蹤能力不足。與基礎算法 CSR-DCF相比,在 PS和SR 上分別提升了2.3%和2.9%。FRHT提取的特征是高光譜灰度特征、梯度特征和顏色特征,相對于CSR-DCF特征細節更加豐富。

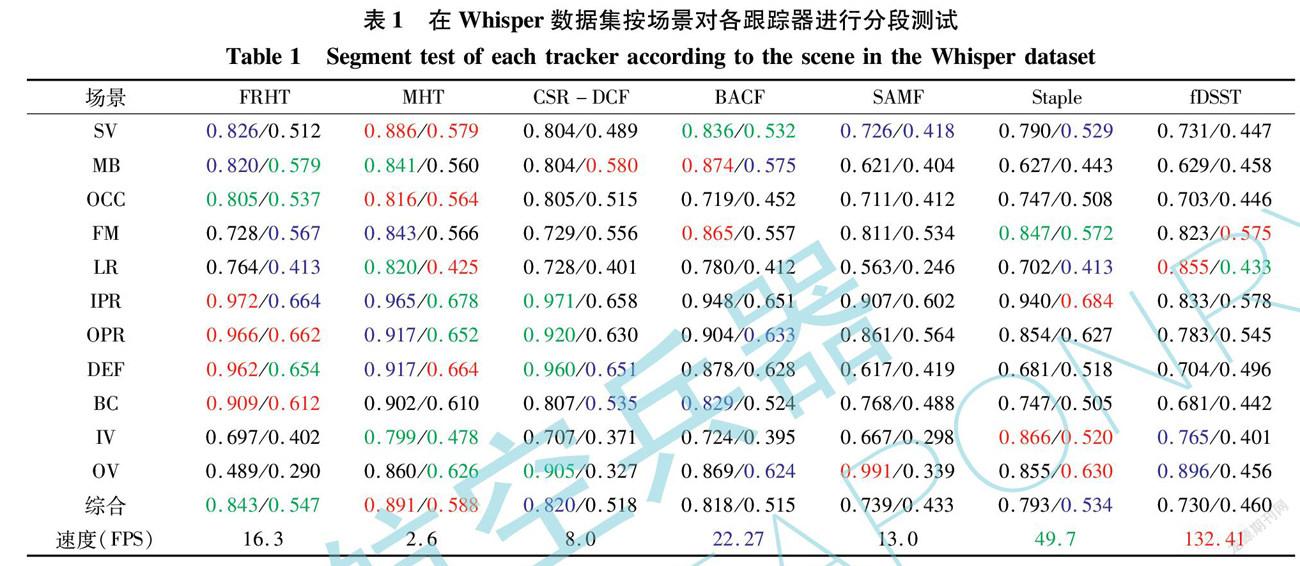

為了更全面地對比FRHT與其他跟蹤器在各種挑戰下的性能,將結果展示在表1中(略去效果較差的兩種跟蹤器),最好的三種跟蹤器依次用紅、綠、藍三種顏色標記。可以看出,FRHT在挑戰 OPR,IPR,BC,DEF下取得了性能最優的成績。相對于MHT 跟蹤器采取的復雜目標特征,FRHT的目標特征更加高效,在保持跟蹤效果相近的情形下,處理速度相對于MHT大幅提升(FPS: 16.3 vs 2.6)。不僅如此,FRHT采取的運動目標異常檢測機制可以及時檢測當前幀的目標狀態,從而抑制跟蹤器的更新,使跟蹤器免于污染。

同樣,為了體現跟蹤效果,將FRHT與其他跟蹤器在數據集上的表現體現在圖5中。FRHT,SAMF,KCF-CN和目標真值框在Whisper數據集上的表現,分別用綠色、紅色、黃色和藍色進行標記。可以看出,本文的跟蹤器在長時或短時序列上均可以取得精確的目標跟蹤結果。

4 結? 論

在復雜環境下的準確跟蹤是高光譜目標跟蹤區別于傳統視覺目標跟蹤的重要特質。本文針對當前提出的高光譜算法不能實現快速跟蹤的缺點,設計了一個快速魯棒算法FRHT。該方法通過生成假彩色圖像模擬RGB圖像的梯度和顏色特征,利用原始灰度圖像在通道維度壓縮正則化得到灰度特征,最終生成低維高光譜特征,能夠壓縮高光譜數據并保留充分目標信息。同時,設計了高光譜運動目標異常檢測機制,針對高光譜長序列做出針對性改善,在檢測到目標漂移或目標丟失等情況時,降低跟蹤器學習率,減少跟蹤器污染問題。采用基于相關濾波的跟蹤框架,處理速度達到16.3 FPS,接近實時,滿足實際應用場景。

參考文獻:

[1] 高晉占. 微弱信號檢測[M]. 北京: 清華大學出版社, 2004.

Gao Jinzhan. Detection of Weak Signals[M]. Beijing: Tsinghua University Press, 2004. (in Chinese)

[2] 毛銀盾, 唐正宏, 于涌, 等. 地球同步軌道動態監視光學系統研制進展[J]. 天文學進展, 2018, 36(1): 57-67.

Mao Yindun, Tang Zhenghong, Yu Yong, et al. Introduction and Development of Geosynchronous Orbit Dynamic Monitoring Optical System[J]. Progress in Astronomy, 2018, 36(1): 57-67.(in Chinese)

[3] 王敏. 復雜背景下的空間目標自動識別技術[D]. 長春: 中國科學院長春光學精密機械與物理研究所, 2017.

Wang Min. Automatic Recognition of Space Targets in Complex Background[D]. Changchun: Changchun Institute of Optics, Fine Mechanics and Physics, Chinese Academy of Sciences, 2017. (in Chinese)

[4] 劉志剛, 盧云龍, 魏一葦. 有監督的高光譜圖像偽裝目標檢測方法[J]. 紅外與激光工程, 2013, 42(11): 3076-3081.

Liu Zhigang, Lu Yunlong, Wei Yiwei. Supervised Method for Hyperspectral Image Camouflage Target Detection[J]. Infrared and Laser Engineering, 2013, 42(11): 3076-3081.(in Chinese)

[5] The Tesla Team. A Tragic Loss [EB/OL]. (2016-06-30)[2021-07-16]. https:∥www.tesla.com/blog/tragic-loss.

[6] Tochon G, Chanussot J, Dalla Mura M, et al. Object Tracking by Hierarchical Decomposition of Hyperspectral Video Sequences: Application to Chemical Gas Plume Tracking[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(8): 4567-4585.

[7] Xiong F C, Zhou J, Qian Y T. Material Based Object Tracking in Hyperspectral Videos[J]. IEEE Transactions on Image Processing, 2020, 29: 3719-3733.

[8] Bertinetto L, Valmadre J, Golodetz S, et al. Staple: Complementary Learners for Real-Time Tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2016: 1401-1409.

[9] Danelljan M, Hger G, Khan F S, et al. Accurate Scale Estimation for Robust Visual Tracking[C]∥British Machine Vision Conference, 2014.

[10] Galoogahi H K, Fagg A, Lucey S. Learning Background-Aware Correlation Filters for Visual Tracking[C]∥IEEE International Conference on Computer Vision (ICCV), 2017: 1144-1152.

[11] Li Y, Zhu J K. A Scale Adaptive Kernel Correlation Filter Tracker with Feature Integration[C]∥European Conference on Computer Vision, 2014: 254-265.

[12] Lukeicˇ? A, Vojír T, Cˇ ehovin L, et al. Discriminative Correlation Filter Tracker with Channel and Spatial Reliability[J]. International Journal of Computer Vision, 2018, 126(7): 671-688.

[13] Li B, Yan J J, Wu W, et al. High Performance Visual Tracking with Siamese Region Proposal Network[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2018: 8971-8980.

[14] Li B, Wu W, Wang Q, et al. SiamRPN++: Evolution of Siamese Visual Tracking with Very Deep Networks[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2019: 4277-4286.

[15] Voigtlaender P, Luiten J, Torr P H S, et al. Siam R-CNN: Visual Tracking by Re-Detection[C]∥IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), 2020: 6577-6587.

[16] Bolme D S, Beveridge J R, Draper B A, et al. Visual Object Tracking Using Adaptive Correlation Filters[C]∥IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2010: 2544-2550.

[17] Henriques J F, Caseiro R, Martins P, et al. High-Speed Tracking with Kernelized Correlation Filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[18] Danelljan M, Bhat G, Khan F S, et al. ECO: Efficient Convolution Operators for Tracking[C]∥IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017: 6931-6939.

[19] Kristan M, Leonardis A, Matas J, et al. The Visual Object Tracking VOT2017 Challenge Results[C]∥IEEE International Conference on Computer Vision Workshops (ICCVW), 2017: 1949-1972.

[20] Kart U, Kmrinen J K, Matas J, et al. Depth Masked Discriminative Correlation Filter[C]∥24th International Conference on Pattern Recognition (ICPR), 2018: 2112-2117.

[21] Danelljan M, Hger G, Khan F S, et al. Learning Spatially Regularized Correlation Filters for Visual Tracking[C]∥IEEE International Conference on Computer Vision (ICCV), 2015: 4310-4318.

[22] Boyd S, Parikh N, Chu E, et al. Distributed Optimization and Statistical Learning via the Alternating Direction Method of Multipliers[M]. Now Publishers Inc., 2011.

[23] Dalal N, Triggs B. Histograms of Oriented Gradients for Human Detection[C]∥IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR), 2005: 886-893.

[24] van de Weijer J, Schmid C, Verbeek J, et al. Learning Color Names for Real-World Applications[J]. IEEE Transactions on Image Processing, 2009, 18(7): 1512-1523.

[25] Danelljan M, Hger G, Khan F S, et al. Discriminative Scale Space Tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575.

Fast and Robust Hyperspectral Object Tracking Algorithm

Xu Qingyu1,Li Dongdong1, Kuai Yangliu2*, Sheng Weidong1, Deng Xinpu1

(1. College of Electronic Science and Technology, National University of Defense Technology, Changsha 410073, China;

2. Mechanical Service Center for Vocational Education, National University of Defense Technology, Changsha 410073, China)

Abstract: Aiming at the problems encountered by traditional object tracking, such as confusion between object and background and rapid change of target appearance, a fast and robust object tracking algorithm (FRHT) is proposed based on the 2D spatial information and rich 1D spectral information included in hyperspectral video. Firstly, based on the characteristics of hyperspectral data, spectral attention mechanism is introduced into the traditional spatial attention mechanism, and an adaptive update learning tracker under the framework of correlation filtering is designed. Secondly, hyperspectral moving object features are designed manually to speed up the operation of the tracker. Finally, a moving object anomaly detection mechanism is proposed to improve the robustness of the tracker. The simulation results show that the speed and accuracy of the tracker FRHT are significantly better than the traditional tracking algorithms such as KCF, SAMF and CSR-DCF on hyperspectral data sets, and the accuracy is improved by more than 2%. After introducing the moving object detection mechanism, the robustness of the algorithm is improved.

Key words:? object tracking; object feature;? hyperspectral; correlation filter; attention mechanism;robustness