改進殘差網絡結合遷移學習的SAR目標識別

崔亞楠,吳建平,2,3,朱辰龍,閆相如

(1.云南大學 信息學院,云南 昆明 650504;2.云南省電子計算中心,云南 昆明 650223;3.云南省高校數字媒體技術重點實驗室,云南 昆明 650223)

0 引 言

合成孔徑雷達(synthetic aperture radar,SAR)是一種與紅外光、可見光等傳統光學成像系統截然不同的主動微波成像雷達系統。基于多平臺協同工作的SAR具有全天候,全天時,不受環境因素影響等諸多獨特優勢。目前,隨著SAR系統成像技術的發展,在情報搜集、目標偵察等方面具有重大意義。高效、準確的SAR圖像目標自動識別成為當前研究熱點。

早期對SAR圖像目標識別分類的研究重心在于特征的提取和分類器的設計。如汪洪橋等人[1]運用多鄰域正交基實現對SAR圖像的多級濾波采樣,獲取SAR多級Gauss差分圖像的空間尺度并應用于SAR圖像特征的提取。然后運用多尺度核的支持向量機(SVM)模型對不同層級的圖像特征進行多尺度核函數映射,最后進行合成,實現SAR圖像目標的識別分類;Liu Haicang等人[2]提出一種基于稀疏表示融合支持向量機決策的方法。利用FSR-C分類器對圖像進行分類檢測,并通過檢測SR系數中非零元素的位置對SAR圖像目標進行識別分類。利用SVM-C提取圖像的PCA特征。最后融合FSR-C和SVM-C提取的特征實現SAR圖像目標的分類;吳天寶等人[3]基于SVM和稀疏表示分類(SRC)級聯決策融合的方法,首先運用SVM對圖像進行分類,獲取圖像的后驗概率,然后通過門限判決方法得到置信度較高的類別圖像,最后利用SRC對SAR圖像進行分類,并結合SVM和SRC的決策值實現SAR圖像目標識別分類。近幾年,深度學習[4]的出現使得圖像識別研究取得突破性的進展。AlexNet[5]、VGG[6]、GoogleNet[7]、ResNet[8]等神經網絡模型相繼出現,并在ImageNet大賽中展露鋒芒。因此,深度學習的方法必然被引入到SAR圖像目標識別分類的研究中。

在深度學習研究中,胡顯等人[9]提出一種基于SAR圖像識別的CMNet網絡模型。該模型運用較小的卷積核設計四個卷積池化層完成特征提取,利用Softmax損失與中心損失共同監督網絡訓練,以此來提高網絡模型的泛化能力,提高SAR圖像識別的準確率。但面對場景復雜的SAR圖像,淺層神經網絡學習能力有限,泛化能力較差,對SAR圖像識別率提高有限。該文前期實驗將遷移學習與Inception-Resnet-v2網絡模型相結合,通過遷移預訓練仿真SAR圖像的網絡參數作為目標網絡的初始參數,然后使用Inception-Resnet-v2目標網絡對SAR圖像進行訓練,實現目標圖像特征的提取。最后,通過Softmax分類器對SAR圖像進行識別分類。該方法選用網絡層次較深的Inception-Resnet-v2模型對SAR圖像進行訓練,以便獲取更深層次的圖像特征。并利用遷移學習提高模型泛化能力,解決小樣本問題。該方法相比文獻[9],網絡學習能力得到加強,對SAR圖像識別率有明顯提高。但深層網絡訓練更加注重圖像的語義信息,訓練過程中圖像細節特征丟失嚴重,對提高SAR圖像識別的準確率有一定的影響。任碩良等人[10]將遷移學習與VGG16網絡模型相結合,通過遷移VGG16網絡的預訓練模型完成目標圖像特征的提取。該文選用VGG16深層神經網絡,訓練過程中仍然存在圖像細節丟失的問題。

針對以上SAR圖像識別的深度學習方法所存在的問題,研究并提出一種基于遷移學習改進ResNet101下SAR圖像識別研究方法。其思路是:采用ResNet101卷積神經網絡[8]作為網絡總體框架,并針對小樣本SAR圖像在深層卷積神經網絡訓練中細節特征丟失嚴重的問題,將卷積注意力模塊(CBAM)[11],特征金字塔網絡(FPN)[12]與ResNet101神經網絡相結合,構成RCF(ResNet101-CBAM-FPN)神經網絡模型,以充分提取SAR圖像的特征。針對卷積神經網絡訓練小樣本數據集出現過擬合的問題,利用仿真SAR圖像數據集對RCF神經網絡模型進行預訓練,得到相應的網絡結構參數。將得到的網絡結構參數遷移至目標RCF網絡模型上,再對SAR圖像數據進行訓練。該文在前期研究實驗的基礎上,將深層神經網絡與FPN結合,并在網絡中引入CBAM,一定程度上增強了網絡對圖像關鍵特征的學習,減少了深度神經網絡訓練小樣本圖像細節特征的丟失。實驗結果表明,該算法相較以往研究方法具有更佳的識別效果,進一步提高了SAR識別的應用價值。

1 理論基礎

1.1 卷積神經網絡

卷積神經網絡是深度學習中具有層次模型的監督學習神經網絡,核心結構包含卷積層、池化層以及全連接層。卷積神經網絡利用卷積層和池化層,實現特征提取。與傳統機器學習相比,卷積神經網絡在訓練過程中可自動提取目標特征。同時,模型參數量很大程度得到減少,模型泛化能力得到提高。

卷積核作為卷積層的核心部分,通過神經元進行矩陣變換計算,將特征信息傳遞至下一層,實現特征提取。通常神經網絡模型中會存在多種尺度的卷積核,多種尺度的卷積核逐一進行特征提取才能充分提取特征信息。其卷積過程如下所示:

(1)

當卷積層完成特征提取后,會將提取的特征信息傳輸到池化層,進一步縮減來自卷積層的特征矩陣,優化對特征信息的提取。同時能有效降低特征維度,減少網絡模型的運算量。

全連接層作為卷積神經網絡的核心結構,相當于神經網絡的“分類器”。全連接層通過對模型學習到的特征信息進行加權求和,并與樣本空間中的標簽數據進行映射,進而對學習到的特征信息加以區分。

1.2 卷積注意力模塊

卷積注意力模塊(CBAM)[11]在2018ECCV會議上被Woo等人提出。CBAM由通道注意力(channel attention)和空間注意力(spatial attention)聯合構成,是一種輕量級模塊。其中,通道注意力模塊注重全局信息,通過分析每條通道之間的相互關系,確定每個特征通道的重要程度,再對每個通道獲取的特征信息進行重要程度劃分,以獲取目標圖像的顯著特征。

假定F為通道注意力輸入的特征圖,則該模塊權重系數MC(F)表達如下:

MC(F)=σ(MLP(AvgPool(F))+

MLP(MaxPool(F)))=

(2)

空間注意力模塊注重局部信息,通過分析上下文信息的相互關系,確定特征對應空間位置信息的重要程度,以獲取目標圖像的顯著特征

假定F為通道注意力輸入的特征圖,則該模塊權重系數MS(F)表達如下:

MS(F)=σ(f7×7([AvgPool(F);MaxPool(F)]))=

(3)

CBAM首先將給定的特征圖F∈RC×H×W與通道注意力模塊的權重MC(F)相乘得到通道優化的特征圖F',再將通道特征圖F'作為空間注意力的輸入與空間注意力模塊的權重MS(F)相乘得到優化的空間位置信息特征圖。CBMA實現過程可表示為:

F'=MC(F)?F

(4)

F''=MS(F')?F'

(5)

1.3 特征金字塔網絡

對于卷積神經網絡,淺層網絡更注重細節特征,深層網絡更注重語義信息。通過深層語義信息可以更準確檢測目標,因此傳統網絡模型通常利用最后一層卷積特征圖實現檢測。其缺點是只關注特征圖的最后一層,而忽略了其他層所包含的細節特征。特征金字塔網絡(FPN)作為一種端到端的網絡[12],能夠將含有豐富語義的高層特征傳遞至底層,實現低分辨率的高層特征與高分辨率的底層特征相融合,使得網絡每一層都具有豐富的特征信息。特征金字塔結構以損失少量的運算效率為代價,能夠有效提升目標識別的準確率,更有利于小樣本實現目標檢測。

2 相關工作準備

2.1 SAR圖像去噪

由于SAR成像系統受到相干輻射的影響,導致生成的圖像存在較大的相干斑噪聲,后期對SAR圖像的處理、解釋具有嚴重干擾,一定程度增加了卷積神經網絡訓練的難度,不利于卷積神經網絡性能的最大化利用。因此,該文預先采用增強的Lee濾波算法[13]對SAR圖像進行濾波去噪,盡可能減少噪聲對神經網絡模型學習過程的影響,確保網絡性能達到最佳。

2.2 SAR圖像仿真

仿真SAR圖像通過電磁散射模型與場景模型獲取SAR圖像掃頻數據,再結合時頻變換與成像算法得到[14]。利用射線追蹤方法獲取地面與目標場景的空間幾何關系,初步建立3D仿真SAR場景模型。利用粗糙面散射理論等技術實現真實場景粗糙特性的建模。利用射線彈跳法等方法建立地面及目標場景的電磁散射模型,獲取SAR圖像目標的掃頻數據。最后通過時頻變換與成像技術得到仿真SAR目標圖像。

以往的SAR圖像識別研究都采用ImageNet數據集進行遷移訓練,但ImageNet數據集中的圖像特征與SAR圖像特征相似度不高,訓練出來的網絡參數不太適合作為訓練SAR圖像網絡模型的初始化參數。仿真SAR圖像與MSTAR數據集提供的SAR圖像相比,特征相似度高,相干斑噪聲小,相比ImageNet圖像更適合作為預訓練樣本。仿真SAR圖像與真實SAR圖像對比如圖1所示。

3 SAR圖像目標識別模型

3.1 結合卷積注意力的殘差網絡模塊

卷積注意力模塊在通道和空間上對圖像重要特征進行篩選,使得引入CBAM的網絡模型能夠更加準確提取目標的主要特征。該文將CBAM應用到殘差網絡中,在ResNet101網絡的殘差節點分別加入四個卷積注意力模塊,對各殘差模塊學習到的圖像特征進行分析,通過對特征圖分配不同的權重,引導網絡在訓練過程中有針對性地提取目標圖像上關鍵的特征信息,從而提高網絡模型對SAR圖像目標的特征表達能力。結合CBAM的殘差網絡模型如圖2所示。

圖1 SAR圖像與仿真SAR圖像對比

圖2 融合CBAM的殘差模塊

3.2 RCF神經網絡

使用ResNet101網絡模型作為RCF網絡的主干部分,網絡總體框架如圖3所示。與ResNet101網絡不同,RCF網絡模型在主干ResNet101網絡的中間層加入了四個CBAM模塊,從而提升網絡對圖像重要特征的學習能力。結合特征金子塔網絡,RCF網絡在每個CBAM模塊后,將上一層學習到的圖像特征經過1×1的卷積塊提取,通過上采樣方法將高層特征傳遞至底層,實現高層特征與底層特征的融合,最大程度上保留圖像的細節特征。最終將融合的特征通過全局平均池化(AVG pooling)操作輸入到全連接層。同時,在全連接層之前加入Dropout層防止過擬合,有利于提升網絡模型的泛化能力。

圖3 RCF網絡總體結構

3.3 遷移學習模型

遷移學習是一種利用某一領域現存的知識或在該領域學習到的經驗對相關領域存在的問題進行求解的機器學習方法[15]。傳統機器學習需要大量數據訓練,得到性能良好的模型,遷移學習能有效解決神經網絡對訓練樣本需求量大的缺陷,對于提升小樣本數據圖像分類識別的準確率有較大貢獻。實現的模型遷移過程如圖4所示。

4 實驗設置與結果分析

4.1 實驗數據

選用的MSTAR數據集相對完整,并且數據集建模時充分考慮了目標形態變化以及影響目標的不確定因素。該數據集包含兩種方向角下十種目標圖像,共計5 172張SAR圖像。實驗將兩個方位角下的同類目標圖像打亂,并在每類中隨機抽取80%作為訓練集,剩余的20%作為測試集,具體如表1所示。

圖4 遷移學習模型

預訓練過程使用SAR仿真數據集[16],該仿真數據集包含多個同場景下的七種SAR目標圖像,共計21 168幅仿真SAR圖像。

4.2 實驗結果

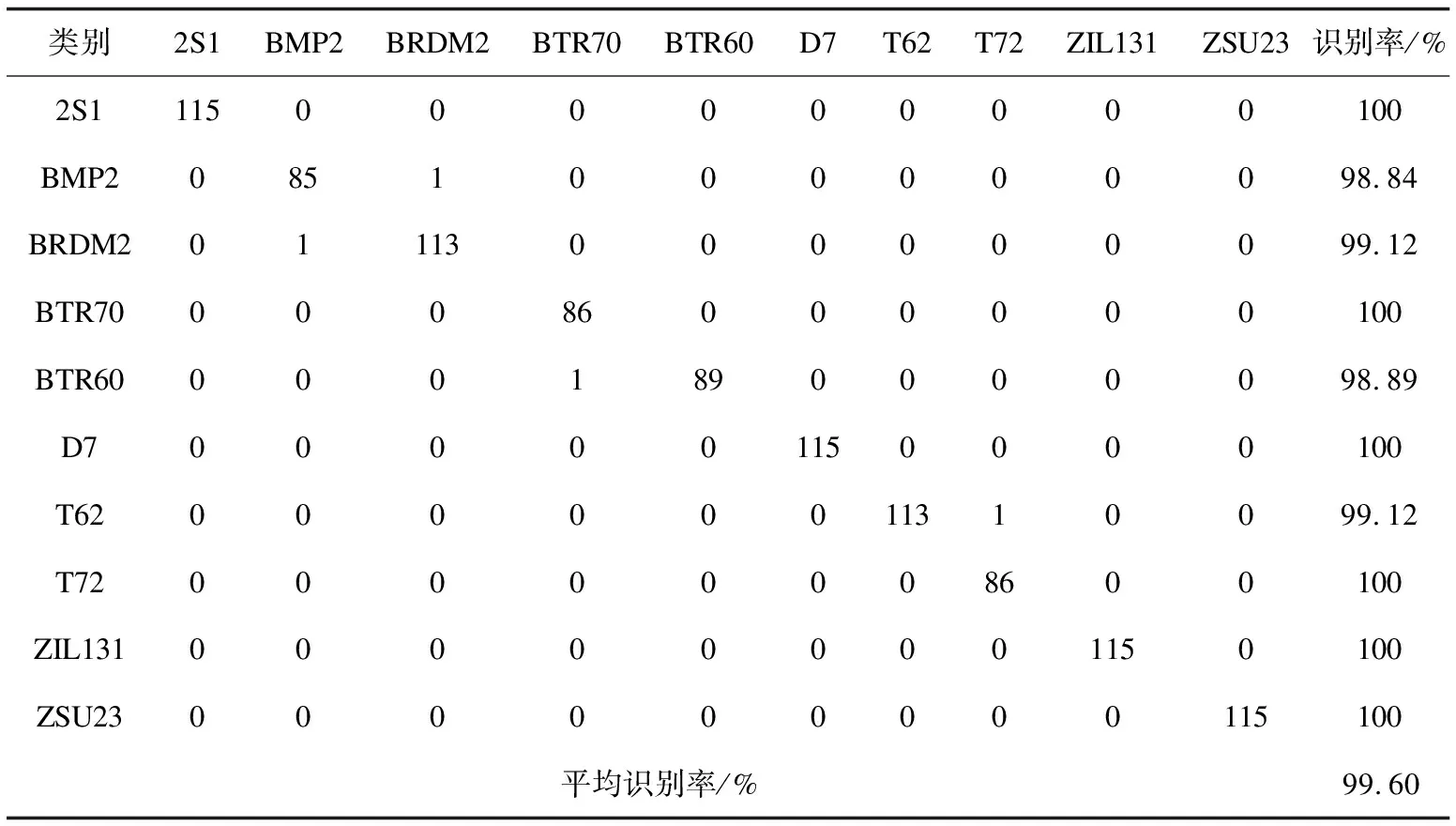

訓練輸入大小為224×224的圖片;dropout值設置為0.8;batchsize值設置為12;學習率設置為0.000 1;訓練共計迭代10 340次。MSTAR十類目標圖像識別率如表2混淆矩陣所示。其中,2S1、BTR70、D7、T72、ZIL131、ZSU23這六種類別的SAR目標圖像都取得100%的識別率。最終,十類SAR目標圖像的平均識別率達到99.60%。

表1 SAR實驗數據

表2 MSTAR十類目標圖像識別結果

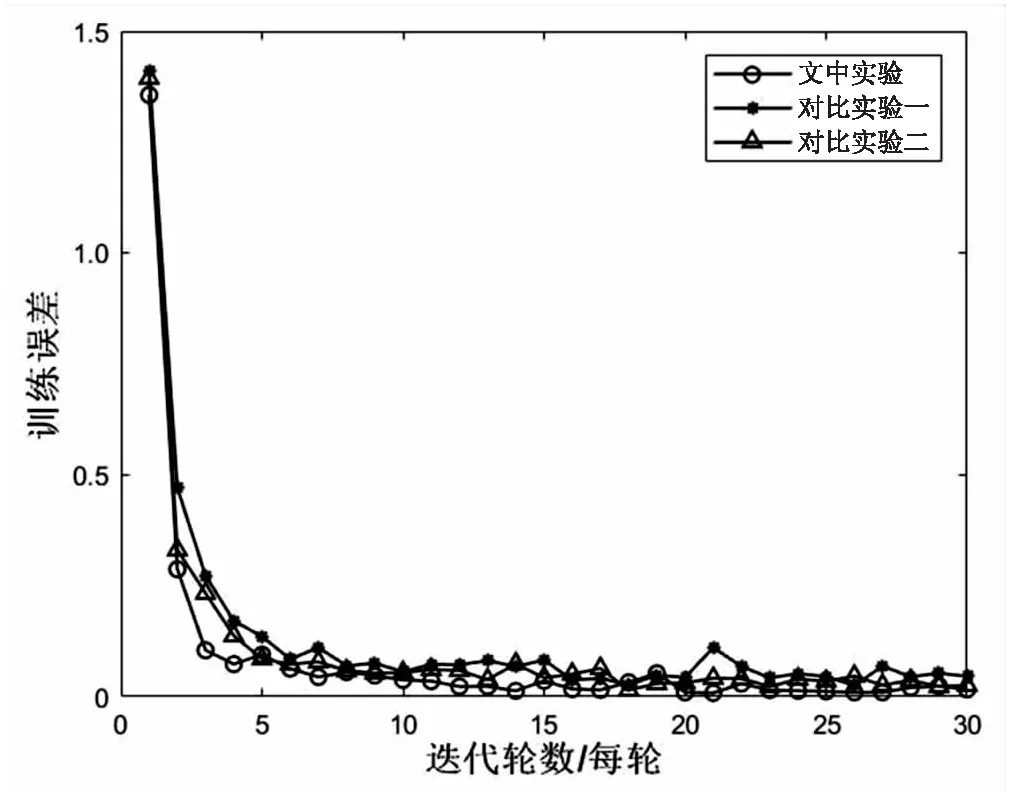

4.3 對比實驗設置與結果分析

為驗證該算法的有效性,在原有實驗基礎上預先設置兩組對比實驗。

(1)實驗一:ResNet101網絡模型遷移實驗。

選用ResNet101網絡替換RCF網絡模型,并實現文中遷移學習訓練。訓練集和驗證集的獲取方式、輸入圖像的大小、dropout值、batchsize大小、學習率與文中實驗相同。最終在MSTAR數據集上僅實現了96.43%的識別率。

該實驗驗證了構造的RCF網絡模型能夠更有效地提取圖像的特征。不僅能夠減少圖像細節特征的消失,而且能夠使模型更加專注于重要特征的學習,提高模型的學習能力。

(2)實驗二:ImageNet數據集預訓練RCF網絡。

選取ImageNet數據集對RCF網絡進行預訓練。再利用遷移學習方法,將預訓練模型的網絡參數作為目標訓練網絡初始化參數,并完成目標網絡對MSTAR圖像目標的訓練。該實驗僅替換掉原預訓練過程使用的數據集,實驗參數與文中實驗選取的參數保持一致。最終在MSTAR數據集圖像識別上獲得98.81%的準確率,仍低于文中方法。

該實驗證明仿真SAR圖像與SAR圖像具有更高的特征相似度,使用仿真SAR圖像對網絡模型進行預訓練,在有效抑制網絡過擬合的同時很大程度上提升了模型的泛化能力。

SAR圖像識別準確率以及訓練誤差對比如圖5、圖6所示。

圖5 SAR識別準確率對比

圖6 SAR訓練誤差對比

為進一步驗證文中方法的有效性,將其與其他方法的SAR圖像識別效果進行對比,結果如表3所示。

表3 不同方法下SAR圖像識別率對比

5 結束語

在不擴充SAR訓練樣本(小樣本)的前提下,提出RCF神經網絡模型。RCF以ResNet101網絡作為主干網,并在主干網的中間層加入了四個CBAM模塊,增強網絡模型對SAR圖像關鍵特征的學習,從而提升網絡模型對SAR圖像識別的準確率。同時,為了解決網絡過深而導致SAR圖像細節特征嚴重丟失的問題,引入了FPN網絡,實現圖像高層特征與底層特征融合,豐富圖像特征信息,提升分類器對小樣本識別分類能力。其中,使用了RCF網絡模型先對仿真SAR圖像進行預訓練,將預訓練得到的網絡參數作為RCF網絡模型的初始化參數訓練SAR圖像,有效解決深度網絡訓練小樣本數據集易導致過擬合的問題。最終在測試集上獲得99.60%的識別率,驗證了該改進方法具有較好的有效性及可行性。

該方法相較于現有深度神經網絡方法,有效解決了深層神經網絡訓練小樣本SAR圖像細節特征丟失嚴重的技術問題,為SAR圖像目標的識別研究和進一步應用提供理論和技術參考。