基于DDR-CycleGAN的紅外圖像數據增強

張 浩,楊堅華,李啟航,花海洋

(1.中國科學院光電信息處理重點實驗室,遼寧 沈陽 110016;2.中國科學院沈陽自動化研究所,遼寧 沈陽 110016;3.中國科學院機器人與智能制造創新研究院,遼寧 沈陽 110169;4.中國科學院大學,北京 100049;5.西北大學信息科學與技術學院,陜西 西安 710127)

1 引 言

隨著深度學習的快速發展,在紅外和可見光圖像融合應用中已開展了廣泛應用,由于深度學習在訓練時需要大量成對的紅外和可見光圖像,而目前實際情況是可見光圖像較易獲取,而紅外數據集較少。因此,通過數據增強方法來擴充成對數據集來實現紅外和可見光圖像融合是非常有必要的。

常用的數據增強算法包括傳統方法:幾何變換,色彩空間增強[1],核濾波器[2],混合圖像[3],隨機擦除[4];深度學習方法:特征空間增強[5],生成對抗網絡[6],元學習[7]。

其中幾何變換和色彩空間增強會損失圖像信息,影響圖像的標簽;核濾波器和神經網絡內部機制非常相似,其作為網絡架構的一層較好,而不是通過數據增強對數據集增廣;混合圖像方法很難去解釋其意義;隨機擦除的缺點是其并不是總保存標簽進行變換;特征空間擴展的一個缺點是矢量數據很難解釋;元學習作為一個新概念沒有經過大量實驗的驗證[8]。深度學習中的生成對抗網絡以其優秀的計算速度和生成圖像的高質量性備受關注,然而 pix2pix[9]網絡需要成對的圖像數據進行訓練,Zhu J Y在2017年提出了循環一致性生成對抗網絡[10]由于其不需要成對的數據就可以進行訓練實現風格遷移,為解決數據集稀缺問題提供了解決方案。

受循環一致性對抗網絡的啟發,胡麟苗[11]運用循環一致性對抗網進行短波紅外-可見光人臉圖像翻譯,實現了紅外圖像與可見光圖像的相互轉化,然而其方法生成器性能極易飽和,針對于該問題,本文提出了一種紅外圖像數據增強網絡:雙鑒別器相對循環一致性對抗網絡,這種增強只需要少量不成對的數據就可以訓練出從可見光圖像到紅外圖像更高質量的映射,實現紅外圖像數據增強。本文方法主要有兩個創新點:第一,對于雙鑒別器循環一致性生成對抗網絡的生成器在不斷優化過程中會脫離鑒別器水平而產生過度優化的問題,加入了相對概率的思想,用鑒別器鑒別圖像相對真實概率取代絕對真實概率,解決生成器在不斷優化過程中會脫離鑒別器水平而產生過度優化的問題。第二,對于DDR-CycleGAN提出了Four-stage訓練方法,相比于One-stage訓練方法更大程度地提升了生成器性能。

2 雙監督機制的相對循環一致性生成對抗網絡

2.1 雙鑒別器監督機制

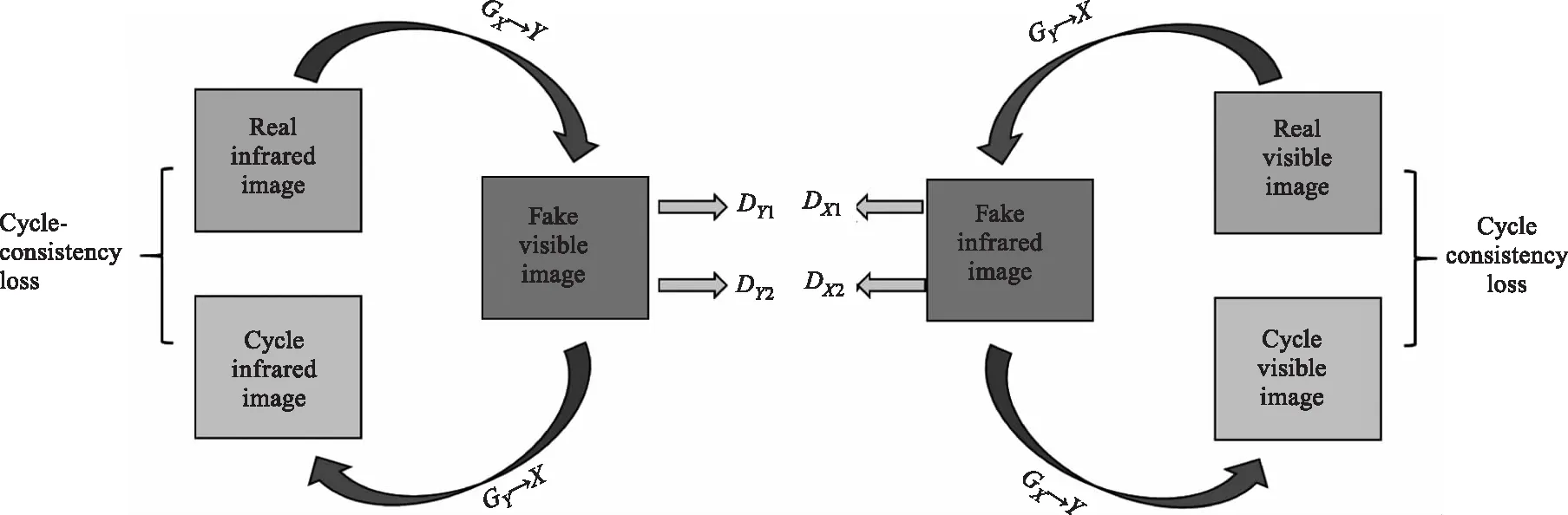

CycleGAN 引入了循環一致性損失[10,12],從未配對的數據集中學習域間映射可以減少對配對數據的需求,學習的域間映射是一種風格轉化,即為圖像到圖像的轉化,通過結合一個圖像的內容和另一個圖像的風格來生成新的圖像。可見光圖像是依據物體反射率不同成像,紅外圖像主要是依據物體的溫度或者輻射率不同成像。可見光圖像的內容是圖像的結構,紅外圖像的風格是紅外輻射特征。本文主要是利用可見光圖像擴充紅外圖像數據集,本質上是結合可見光圖像的結構和紅外圖像的紅外輻射特征實現可見光圖像到紅外圖像的風格轉化[13]。

CycleGAN模型包含兩個生成器GX→Y(X→Y)和GY→X(Y→X)和兩個鑒別器DX和DY,鑒別器DX的作用是鑒別輸入的紅外圖像的真假,其損失函數為:

dxloss=[DX(realir)-label(realir)]+[DX(fakeir)-label(fakeir)]

(1)

其中,DX(a)為鑒別器對圖像a的鑒別結果;label(a)為圖像a的真實標簽;鑒別器DY的作用是鑒別輸入的可見光圖像的真假,其損失函數為:

dyloss=[DY(realvi)-label(realvi)]+[DY(fakevi)-label(fakevi)]

(2)

在和鑒別器DY對抗過程中生成器GX→Y使紅外圖像吸收可見光圖像的風格轉化為更真實的可見光圖像,在和DX對抗過程中生成器GY→X使可見光圖像吸收紅外圖像的風格轉化為更真實的紅外圖像。為了規范生成對抗網絡,使生成的圖像在獲得新風格的同時不要失去原圖像的內容,CycleGAN引進了循環一致性損失。原理即為利用生成器GX→Y將紅外圖像轉化為可見光圖像之后還可以利用生成器GY→X將其轉化為原來的紅外圖像:X→GX→Y(X)→GY→X(GX→Y(X))≈X。

雙鑒別器的循環一致性生成對抗網絡原理如圖1所示,在 CycleGAN 的基礎上添加了兩個鑒別器DX2和DY2,其中DX2和DX1的結構完全一樣,DY1和DY2的結構完全一樣,但是他們的初始化不同。當其中一個鑒別器達到收斂,在另一個鑒別器的作用下生成器仍不會停止學習[14-15]。雙鑒別器結構有利于生成器得到充分訓練,解決傳統對抗網絡的不穩定的過早飽和問題。

圖1 DD-CycleGAN 原理圖Fig.1 The schematic diagram of DD-CycleGAN

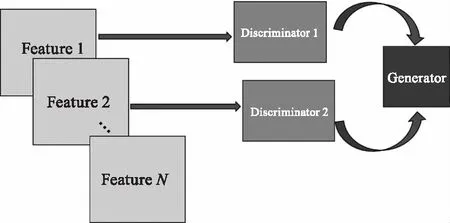

在實際訓練中,對于不同的鑒別器,其鑒別方式不同,即提取的特征不同,因此生成器需要學習利用不同的特征去干擾鑒別器,這也會使得生成器訓練地更加全面,性能得到更大的提升。可以這樣理解,鑒別器是生成器的老師,生成器通過鑒別器學習特征,生成器訓練流程如圖2所示,理想來說,只要鑒別器足夠多,生成器就可以學習所有特征進而生成最逼真的圖像。

圖2 DD-CycleGAN 生成器訓練流程圖Fig.2 The generator training diagram of DD-CycleGAN

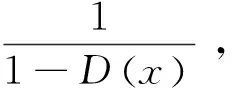

2.2 鑒別器相對概率損失函數

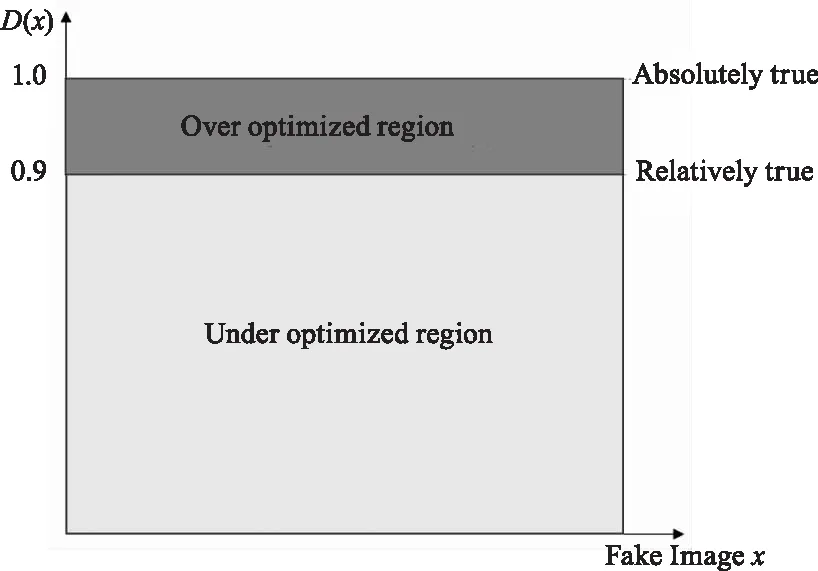

雖然雙鑒別器會使得生成器得到充分訓練,但也導致生成器出現了過度優化的問題。鑒別器是為了區分真假圖片,生成器是為了生成讓鑒別器區分不開的假圖片。例如,當鑒別器鑒別一個真圖片是真的概率是 0.9 時,同時也鑒別假圖片真實的概率是 0.9,那么這時候就可以認為鑒別器已經區分不開真假圖片了,生成器效果已經達到最優了,但是根據 CycleGAN 的損失函數來看,生成器在這時候還要繼續優化其網絡結構進而生成接近于D(fake)=1 的圖片,這就出現了過度優化的問題,D(fake)=1 的假圖片在鑒別器鑒別下已經非常真實,但是其已經脫離了D(real)=0.9 的真實圖片,反而不真實,圖3為在D(real)=0.9 時的相對概率圖,在欠優化區域和過度優化區域的生成圖片都是不真實的,因此為了基于鑒別器的能力水平來訓練生成器,本文加入了相對真實概率的思想[17]。

圖3 D(real)=0.9相對概率Fig.3 D(real)=0.9 relative probability diagram

加入相對概率后的損失函數修改為:

dloss=E(real,fake)~(R,F)[f(D(real)-D(fake))]

(3)

其中,f是端到端的函數;R是真實圖像的分布;F是生成圖像的分布,同理,生成器的損失函數修改為:

gloss=E(real,fake)~(R,F)[f(D(fake)-D(real))]+

losscycle-consistency

(4)

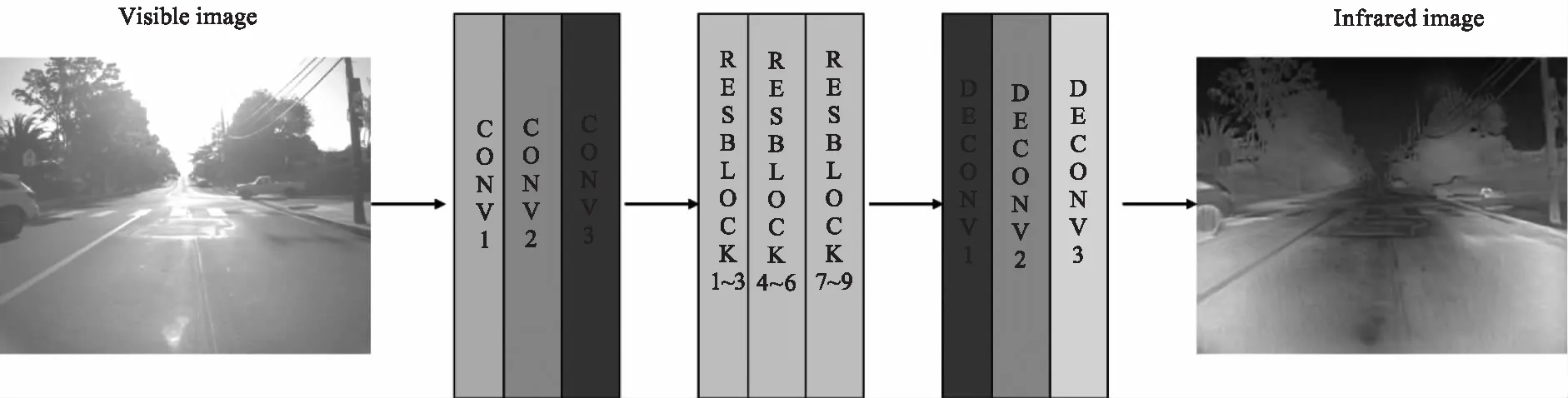

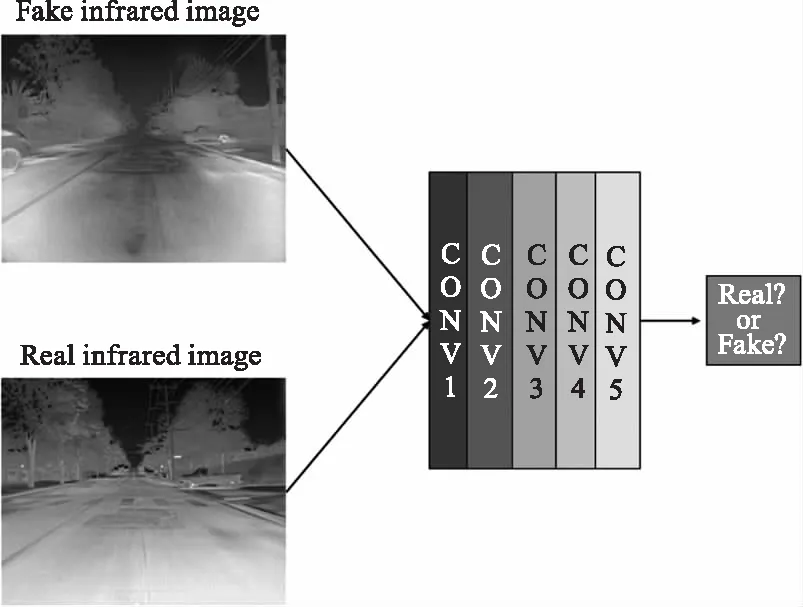

在相對概率思想的影響下,可以保證生成器生成和真圖像一樣真實的圖像,而不是脫離鑒別器的鑒別能力生成過度真實的偽真實圖片。最后,雙鑒別器相對循環一致性生成對抗網絡的生成器網絡結構設計如圖4和表1,鑒別器網絡結構設計如圖5和表2。

圖4 DDR-CycleGAN 生成器結構圖Fig.4 The generator structure diagram of DDR-CycleGAN

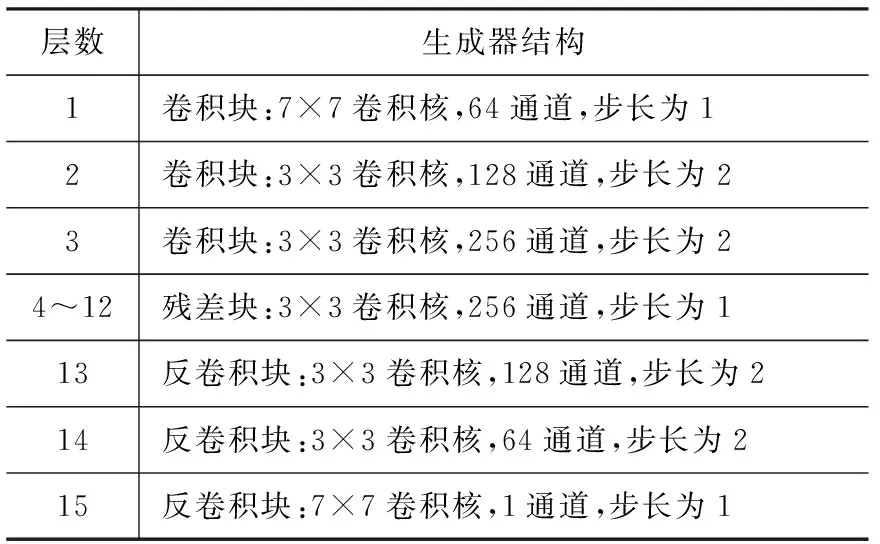

表1 生成器的編解碼神經網絡結構Tab.1 Encoder-decoder neural network structure of generator

圖5 DDR-CycleGAN 鑒別器結構圖Fig.5 The discriminator structure diagram of DDR-CycleGAN

表2 鑒別器的二分類神經網絡結構Tab.2 Two-classification neural network structure of discriminator

2.3 Four-stage訓練方法

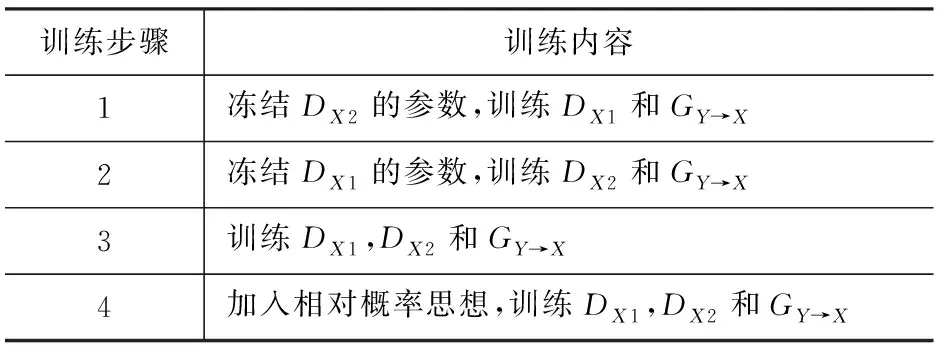

在前面提到,在實際訓練中,對于不同的鑒別器,其鑒別方式不同,即提取的特征不同,因此生成器需要學習利用不同的特征去干擾鑒別器,這也會使得生成器訓練地更加全面,性能得到更大的提升。但是鑒別器在面對鑒別任務會趨向于提取最有利的鑒別特征,在隨機初始化的前提下,兩個鑒別器面臨相同的鑒別任務,會趨向于提取同一類鑒別特征,進而造成生成器性能在某一類特征上表現極佳,在其他特征上表現不好,為了促進生成器性能全面提升,對此提出了Four-stage訓練方法,如表3所示。

表3 Four-stage訓練步驟Tab.3 Four-stage training steps

3 實驗驗證

3.1 實驗設計

本文的實驗基于 Python3.6 和 Tensorflow1.14 版本,在實驗中,設置兩個鑒別器相同的權重,batchsize 設為 1,每 5000 步輸出一次圖像質量評價結果,初始學習率為 0.0002,之后余弦退火衰減到0.00001。鑒別器損失函數為:

dloss=(D(real)-D(fake)-1)2+(D(fake)-D(real)+1)2

生成器損失函數為:

gloss=(D(real)-D(fake)+1)2+(D(fake)-D(real)-1)2+λ|real-Cycle|

圖像質量評價指標采用峰值信噪比(PSNR)和FID(Frechet Inception Distance score)兩個指標。峰值信噪比是基于圖像像素灰度值進行統計分析的衡量信號失真的指標:

(5)

(6)

FID由Heusel[18]等提出,其使用Inception v3模型的編碼層提取圖像特征,然后將真實數據分布和生成數據分布分別建模為均值為μr,μg,方差為Σr,Σg的高維高斯分布,通過計算真實數據分布和生成數據分布之間的Frechet距離來表征兩個分布的差別:

(7)

FID具有良好的判別能力,是GAN的優秀判別指標。FID越小,說明生成的圖像特征分布與真實圖像特征分布越接近,生成器效果越好。

在FLIR數據集進行訓練和測試,其共包含14000張圖像,其中10000張來自短視頻片段,另外4000張BONUS圖像來自一段140 s視頻。視頻以30 Hz幀率記錄,數據集序列以2 f/s或1 f/s速率采樣。

3.2 相對概率作用分析

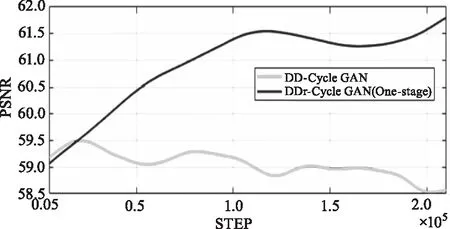

從圖6中可以看出,DD-CycleGAN方法隨著迭代次數增加,峰值信噪比先上升,在20000次時達到峰值59.5而后下降最終穩定在58.74。而加入相對概率的思想后,DDR-CycleGAN(One-stage)方法隨著迭代次數的增加,峰值信噪比一直增加最終穩定在61.87,并一直高于DD-CycleGAN方法的峰值信噪比水平。說明加入相對概率的損失函數后有效避免優化過剩,也有利于避免圖像失真現象的出現,提高了網絡結構的穩定性。

圖6 DD-CycleGAN 和DDR-CycleGAN(One-stage)峰值信噪比隨迭代次數增加的變化曲線Fig.6 The PSNR of DD-CycleGAN and DDR-CycleGAN (One-stage)with the increase of iteration times

3.3 性能分析

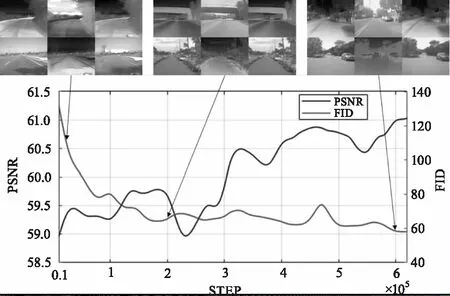

DDR-CycleGAN(Four-stage)PSNR和FID隨迭代次數變化曲線如圖7所示,第一列分別為訓練 5000次、200000 次、600000 次的輸出圖像。由圖像可知,隨著訓練次數的增加,PSNR震蕩上升最后達到穩定,穩定時PSNR為61.04,相比DD-CycleGAN提升了3.92 %,FID一直減少最后達到穩定,穩定時FID為61.18,相比DD-CycleGAN降低了3.81 %。說明加入相對概率的損失函數后有效避免優化過剩,也有利于避免圖像失真現象的出現,提高了網絡結構的穩定性。

圖7 DDR-CycleGAN FID和PSNR隨迭代次數增加的變化曲線Fig.7 The FID and PSNR of DDR-CycleGAN with the increase of iteration times

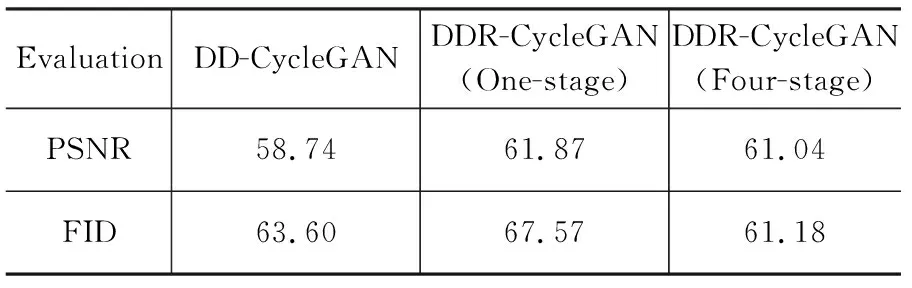

如表4所示,本文方法生成圖像的峰值信噪比較高,而FID比較小,相比于雙鑒別器CycleGAN 在生成紅外圖像質量上峰值信噪比提高了3.91 %,FID(Frechet Inception Distance score)降低了3.81 %,性能有著很大程度的提升,這代表著生成的紅外圖像與目標圖像有著更高的相似度。

表4 訓練結果評價指標Tab.4 Evaluation index of training results

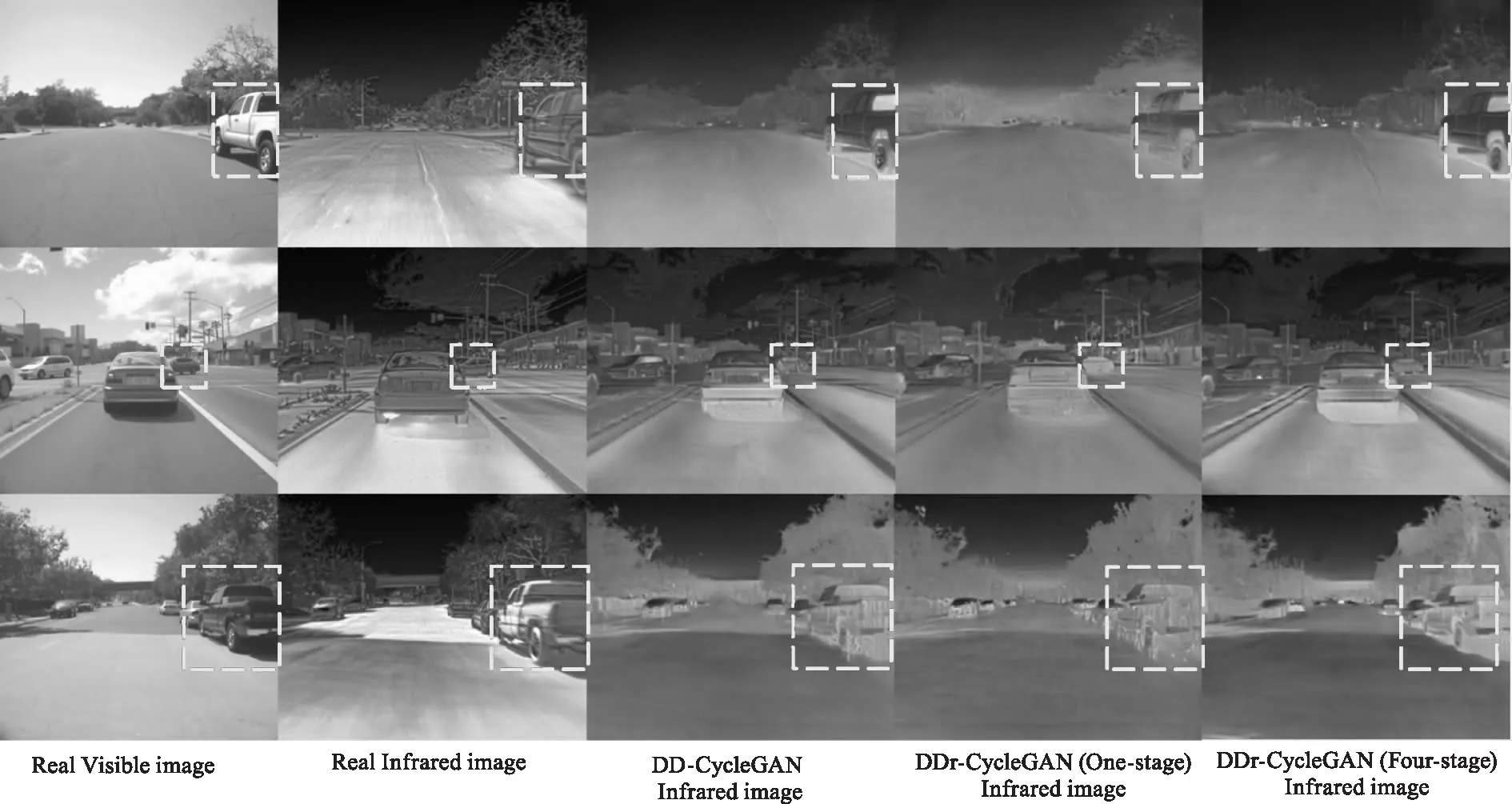

圖8展示了DD-CycleGAN、DDR-CycleGAN(One-stage)、DDR-CycleGAN(Four-stage)三種方法生成紅外圖像的比較,在圖中標注的虛線框處可以明顯看出DDR-CycleGAN(One-stage)方法生成的紅外圖像相比于DD-CycleGAN更加接近于紅外圖像,但是其紋理特征和邊緣特征還原的較差,而DDR-CycleGAN(Four-stage)方法生成的紅外圖像全面還原了各種特征,圖片質量最好。

圖8 FLIR數據集在不同方法下的測試結果Fig.8 Test results of FLIR data sets under different methods

3.4 真實場景驗證

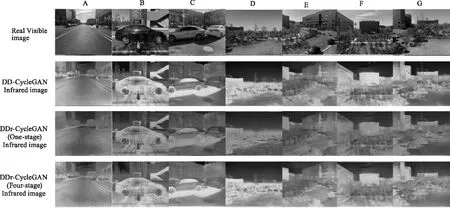

為了測試本方法在實際場景的適用能力,選用了七組不同真實場景進行了性能測試,結果如圖9所示。

圖9 真實場景在不同方法下的測試結果Fig.9 Test results of real scene under different methods

本文的方法應用到真實場景中得到的結果見圖9,經過對比三種方法的結果可以得到,DD-CycleGAN方法得到的紅外圖像雖然擺脫了可見光風格,但是其紅外風格已經超越了真實的紅外風格,看起來不真實;DDR-CycleGAN(One-stage)相比于它們既擺脫了可見光風格,又沒有不真實的紅外風格,但是邊緣模糊;DDR-CycleGAN(Four-stage)方法不僅生成了較真實的紅外圖像,邊緣也比較清晰,證明了該方法的可行性。

4 結 論

本文提出了DDR-CycleGAN(Double Discriminator relative Cycle-Consistent Generative Adversarial Network),即雙鑒別器相對循環一致性對抗網絡進行紅外數據增強,有效地解決了科研過程中紅外圖像數據數量不充足的問題。本文方法主要有兩個貢獻:第一,在雙鑒別器可能存在過度優化的問題上利用相對真實概率的思想,保證了網絡性能不下降,確保了網絡的穩定性。第二,對于DDR-CycleGAN,設計了Four-stage的訓練方法,使得生成器可以更全面地學習特征,確保其性能全面提升。盡管該方法在紅外圖像數據增強方面取得了進步,但是這項任務仍然具有巨大的挑戰性,接下來的工作將圍繞鑒別器數量與生成圖片質量的關系展開研究,以增強實際復雜場景下的生成器性能,進一步提高生成的紅外圖像質量。