人群計數研究綜述

盧振坤,劉 勝,鐘 樂,劉紹航,張 甜

廣西民族大學 電子信息學院,南寧 530000

隨著人口增長,許多場景下人群數量過大容易發生事故。著名的上海外灘踩踏事件后果慘重,最終造成36人死亡、49人受傷。另外演唱會、體育館、火車站、地鐵站等地方人口流量較大,需運用人群計數系統實時檢測人群的數量和分布,控制人口流動,避免出現意外。人群計數領域在公共安防、智慧城市建設和視頻監控上應用廣泛,因此,研究這一領域具有重要的現實意義。

過去,研究人員采用基于檢測、回歸等傳統方法估計人群數量。基于整體檢測的方法用哈爾小波[1]、方向梯度直方圖(histogram of oriented gradient,HOG)[2]、Shapelet[3]訓練器,用支持向量機(support vector machine,SVM)[4]、提高算法[5-6]、隨機森林、集群[7]等算法來完成人群計數任務的檢測或分類。基于回歸的方法通過特征提取和回歸建模展開,特征提取包括前景提取、像素統計[8]、紋理提取[9]、邊緣提取等,提取特征后用不同的回歸算法計數,這兩種方法在稀疏場景下效果良好,但是不適用高密度場景。相比傳統方法,基于卷積神經網絡的計數方法分為直接回歸法[10]和密度圖法。CNN擁有強大的網絡,輸出密度圖后用損失函數來提高精度,用優化器來減少計算復雜度,在處理跨場景、多尺度、部分遮擋等問題時,展現出獨特的優勢。根據常見的網絡模型,可以分為尺度感知計數模型、上下文感知計數模型、多任務計數模型、注意力感知計數模型等類型,本文將重點分析這幾種計數模型。TransCrowd采用ViT來研究人群計數任務,試圖用其他方法代替CNN,相比基于CNN的弱監督人群計數方法提高了網絡性能,這次嘗試在人群計數領域具有非凡的意義。

本文查閱了相關文獻,論述了人群計數領域的研究進展,對基于傳統方法、基于CNN方法和新提出的基于ViT方法的人群計數進行了綜述,提出當前研究方向上亟待解決的問題。

本文貢獻如下:(1)梳理了人群計數領域的傳統方法、基于CNN的方法和基于ViT的方法,對比不同方法的優劣,總結了當前方法的特點和研究現狀,闡述了人群計數的發展進程。(2)介紹了常用數據集,系統性回顧了計數網絡的發展歷程,比較模型在常用數據集上的評價指標,指明研究人員下一步改進方向。(3)首次在綜述中引入基于ViT的弱監督人群計數方法,為未來該領域研究提供一個新思路。

1 基于傳統方法的人群計數

1.1 基于檢測的方法

早期人群計數方法大多是基于檢測,用特定的檢測器提取特征來實現計數目標。特征提取方法可分為基于整體的和基于局部兩種。基于整體的檢測方法適用于低密度人群,在高密度人群中效果不理想。為了解決這個問題,研究者提出基于局部的提取特征方法[11-13],其目的不是檢測一個完整的行人對象,而是檢測行人的部位。研究發現,在大多數密集人群場景中,使用局部特征比使用全局特征可以大大提高計數性能。許多研究工作[14-17]是基于局部特征的,近來Laradji等人[18]和Liu等人[19]繼續致力于基于檢測的方法。前者不需要估計目標的大小和形狀,而是提出了一種新的損失函數,建議網絡僅使用點級注釋輸出每個目標實例的單個屬性。后者避免了昂貴成本的邊界框,僅使用點的監督信息來訓練模型。與基于整體特征的檢測相比,部分局部檢測的魯棒性更好,但在高密度場景中同樣收效甚微。基于檢測的計數方法在稀疏場景中有著出色的檢測精度,雖然為了適應高密度、復雜的場景做了許多嘗試,但是效果仍然有待提高。

1.2 基于回歸的方法

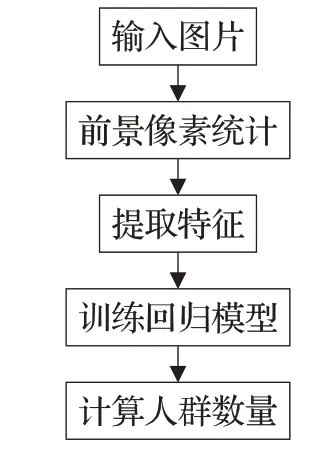

基于檢測的方法在極端密集的人群和高背景雜波的情況下并不成功,為了克服這個問題,研究人員試圖通過回歸來計數,從中學習從局部圖像斑塊中提取的特征與它們的計數之間的映射[20-22],避免了對檢測器的依賴。基于回歸模型方法的主要思想是先從圖像中提取前景區域,提取多個特征,然后選擇合適的回歸模型進行訓練,最后從測試樣本中預測人口密度。過程如圖1所示。當全局和局部特征被提取出來,不同的回歸技術,如線性回歸[23]、分段線性回歸[24]、嶺回歸[25]、高斯過程回歸和神經網絡[26]用來學習從低級特征到人群數量的映射。與基于檢測的方法類似,回歸方法也可以分為基于整體[27-29]和基于塊[30-33]兩類。基于整體的回歸方法難以處理大尺度和密度變化,而基于塊的回歸方法包含更多圖像的局部信息,受尺度和密度變化的影響較小。通過回歸技術來實現可以有效地解決個體遮擋和特征跟蹤的問題,使用人群的整體描述來估計人群密度。相比于基于檢測的方法受到了高密度場景的限制,基于回歸的方法不需要明確的界限和個體的跟蹤,能夠較有效地估計更復雜場景的人群密度,但是計算過程也相對復雜。

圖1 基于回歸模型的人群計數過程Fig.1 Flow chart of pixel statistical algorithm

1.3 基于密度圖的方法

雖然早期的方法能較好解決遮擋和雜波問題,但大多數方法忽略了重要的空間信息,因為它們是對全局計數的回歸。隨著研究的深入,Lempitsky和Zisserman[34]提出的密度圖概念引起了研究者的廣泛關注。Lempitsky等人提出了一種估計圖像密度的新方法,將局部像素特征學習線性映射到對應的目標密度圖。該方法可用于訓練一個回歸模型,模型在學習過程中基于圖像的像素點提取特征,直接學習從像素點特征到目標密度分布圖的映射關系。它的目標為生成這樣的密度圖,不僅包含了密度信息還附帶了圖像中目標空間分布信息,同時該密度圖中任意區域的積分給出了該區域對象的數量,所以還可以通過區域密度求和得到任意區域的目標數目。通過學習圖像到密度圖的映射,避免了對檢測器的依賴。Rodriguez等人[35]證實使用密度圖計數可以極大地提高計數性能。由于密度圖既能反映人群的空間分布信息,又能提高計數精度,基于密度圖的回歸逐漸成為一種流行的分類。

傳統的人群計數方法依賴于多源和手工制作的表示,只適用于稀疏場景,在部分遮擋、前景透視、多尺度和跨場景等情況下,效果不盡人意。CNN在各種計算機視覺任務中的成功應用,使得許多基于CNN的方法被用來解決人群計數問題。

2 基于卷積神經網絡的人群計數

2.1 尺度感知計數網絡

2.1.1 單分支結構

Wang等人[36]和Fu等人[37]最早在人群計數領域中使用CNN,Wang等人提出了一個端到端的CNN回歸模型直接預測人群數量,能從極度密集人群的圖像中統計人數。架構中采用了AlexNet網絡[38],其完全連接層被用于預測計數的單個神經元層取代。此外,為了減少圖像不相關背景的錯誤響應,訓練數據增加了附加的樣本,其真實數值設為零。AlexNet網絡不適用于跨場景計數,因此準確度不高。

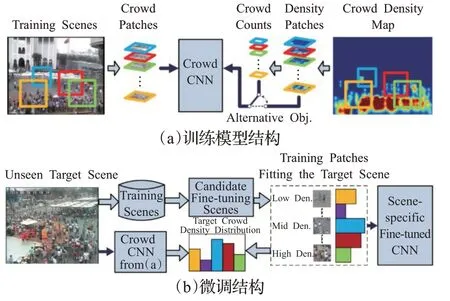

為了克服跨場景的難題,Zhang等人[39]整理了現有方法,改進了AlexNet網絡提出的單分支計數模型CrowdCNN,最先應用人群密度圖。如圖2(a)所示,通過交替訓練兩個目標函數:人群計數和密度估計,對這些目標函數進行交替優化,可以獲得更好的局部最優解。如圖2(b)所示,為了使該網絡適應新場景,達到跨場景計數的目的,使用與目標場景相似的訓練樣本對網絡進行微調。圖2(b)提出了一種結合透視信息生成真實密度圖的方法,使網絡能夠執行透視歸一化,從而提高比例和透視變化的魯棒性。此外,他們引入了一個新的數據集WorldExpo’10,用于評估跨場景人群計數。

圖2 CrowdCNN計數網絡Fig.2 Architecture of CrowdCNN

2.1.2 多分支結構

目標遭受嚴重遮擋時,透視問題導致拍攝角度差異大,目標尺度變化不均勻。一般情況下,靠近攝像機的人群有完整的細節信息,遠離攝像機的人群細節信息缺失。此外,手工制作的圖像特征(scale-invariant feature transform,SIFT[40])通常在遮擋和大尺度變化情況下魯棒性較差。

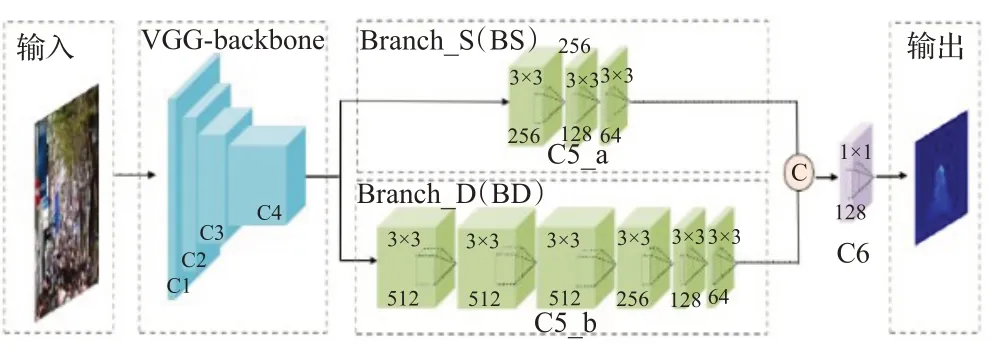

為了解決多尺度的問題,Boominathan等人[41]把一個深層網絡和一個淺層網絡相結合,提出雙分支結構計數模型CrowdNet。但是當目標尺度很小時,深層網絡結構很難提取目標特征。受到Boominathan等人的啟發,有人提出改進VGG16模型[42]作為雙分支結構,把VGG前10層作為主干網絡,如圖3所示。為了解決尺度變換的問題,用淺層網絡(Branch_S,BS)提取低級語義信息,深層網絡(Branch_D,BD)提取高級語義信息。并使用1×1卷積層對提取的特征圖進行處理。以獲得最終的人群密度預測。通過引入多分支網絡,用不同尺寸的卷積核提取不同尺度的特征,可以有效解決多尺度問題。

圖3 基于VGG主干的雙分支網絡Fig.3 Double branch network based on VGG backbone

人群計數領域不斷創新,逐漸衍生許多基于CNN的多分支網絡模型,適用于稀疏、密集場景。由于圖像中人群密度分布極不均勻,研究人員利用多列卷積神經網絡來提取不同尺度的頭部特征。通過多分支網絡,使用不同尺寸的感受野提取不同尺度特征,可有效解決多尺度問題。

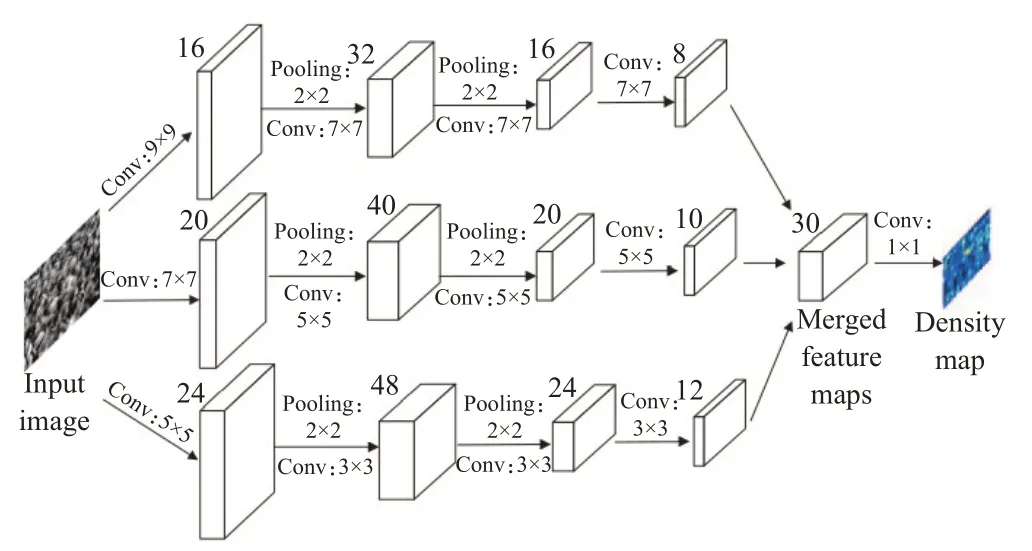

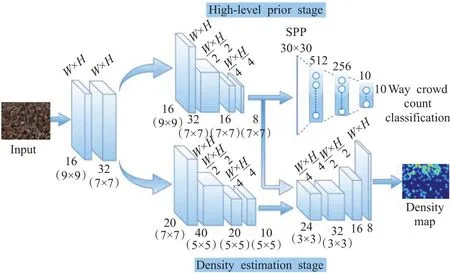

Zhang等人[43]為了解決多尺度問題,在2016年提出多列卷積神經網絡(multi-column CNN,MCNN),其網絡結構如圖4所示。MCNN允許輸入圖像有任意大小的分辨率,利用具有不同大小感受野的濾波器提取特征,舍棄固定高斯核,采用自適應高斯核來生成高質量密度圖,減少視角變化引起的目標大小不一致導致的計數誤差。MCNN每列所學習的特征,能夠適應由于透視效果或圖像分辨率[44]形成的目標尺寸變化。MCNN模型通過1×1卷積層加權平均[45]融合CNN多列的特征圖來預測人群的密度圖。MCNN還引入了新的數據集ShanghaiTech,該數據集已成為人群計數領域的經典數據集之一。

圖4 多列人群計數網絡Fig.4 Structure of multi-column crowd counting network

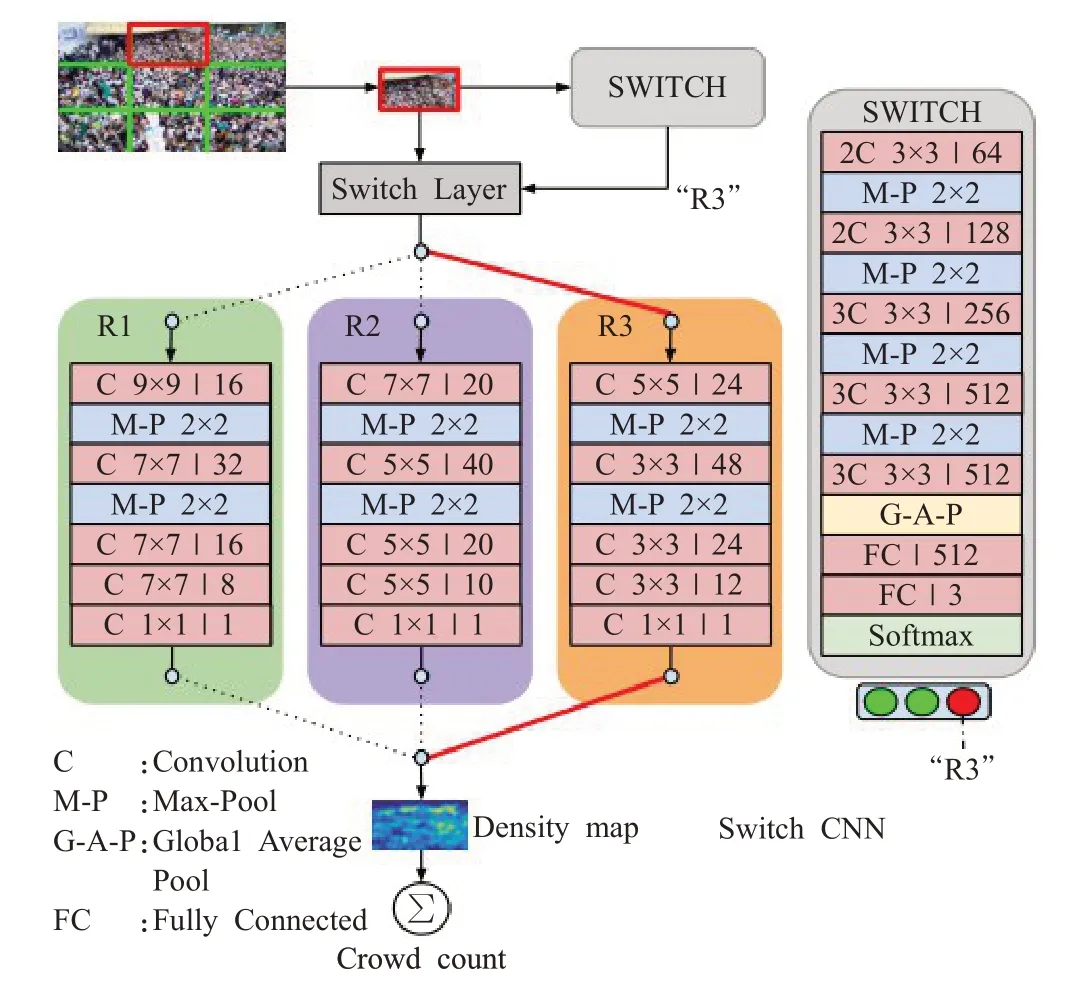

Sam等人[46]在多列卷積神經的基礎上,提出了基于塊的選擇結構,即多列選擇卷積神經網絡(switch convolution neural network,Switch-CNN),計數模型如圖5所示。Switch-CNN能有效利用場景中的局部人群密度變化。此網絡由三個不同體系結構的CNN回歸器和一個分類器(Switch)組成,為輸入圖片塊選擇最佳回歸器。輸入圖像被分成9個不重疊的小塊,每個小塊是圖像的1/3。選擇分類器與多個CNN回歸器交替訓練,準確地將塊傳遞給特定回歸器,這個模型擁有人群分析的顯著性能:(1)模擬大尺度變化的能力強;(2)合理利用人群場景中密度的局部變化[47]。Switch-CNN有一個缺陷,一旦分支選擇錯誤將會嚴重影響計數準確度。

圖5 Switch-CNN結構Fig.5 Structure of Switch-CNN

Cheng等人[48]分析MCNN、CSRNet[49]、BSAD[50]和ic-CNN[51]四個網絡,發現有的多列體系結構沒有監督體系來指導學習不同尺度的特征,而且列間存在大量冗余參數。為了解決這兩個問題,Cheng等人提出了一種新的多列互學習策略(multi-column mutual learning,McML)來提高多列網絡的學習性能,如圖6所示。McML使用互信息來近似表示來自不同列的特征之間的尺度相關性,通過最小化列間的互信息,還可以引導每列聚焦不同的圖像尺度信息。McML的核心思想是相互學習。許多網絡模型同時更新多個列的參數,但McML依次優化更新每個列,直至收斂。每一列學習過程中,先估計列間的互信息作為先驗知識來指導參數更新。McML借助列與列之間的互信息,交替地使每一列都受到其他列的引導,從而學習不同的圖像比例和分辨率。結果顯示,這種互學習方案可以顯著減少冗余參數的數量,避免過擬合。

圖6 多列互學習(McML)網絡結構Fig.6 Structure of McML

除了上述文獻,還有很多研究試圖解決變尺度問題。Chen等人[52]使用多列卷積網絡架構和梯度融合進行人群計數。Deb和Ventura[53]使用多列擴張卷積網絡聚合來融合不同層次的特征。但是,多列網絡仍然存在一些固有的缺點,如計算量大、實時計數困難、生成的密度圖清晰度不夠高。因此,一些研究者開始研究如何利用單一網絡融合多尺度特征。Liu等人[54]利用側向連提出了單列計數網絡,該系統由多個專用模塊、四個殘差接的特征金字塔網絡融合高級特征和低級特征。Wang等人[55]由融合模塊(用于多尺度特征提取)、一個金字塔池模塊(用于信息融合)和一個亞像素卷積模塊(用于分辨率恢復)組成。Dai等人[56]使用密集擴張卷積塊提取尺度連續變化的信息。Kang和Chan[57]采用圖像金字塔法進行多尺度采樣。Gao等人[58]通過引入前/背景分割來約束密度圖。一些研究者也使用類似Inception的模塊來提取密度圖,如Zeng等人[59]引入了不同核大小的多尺度來提取不同層次的特征。圖像中人頭尺度的巨大跨度一直是人群計數的一個主要問題。目前的大多數解決方案都是基于多尺度的特征融合。本節提到的這些方法只是簡單地將特征疊加在一起,而不使用權重信息。

2.2 上下文感知計數網絡

多分支結構方法[43,46,60]在高密度復雜場景中效果顯著,不過,這些方法容易在高密度人群圖像情況下過低計數,在低密度人群圖像情況下過高計數。多分支計數網絡的分支之間缺少聯系,平均各分支結果生成的密度圖質量不高。于是有研究者提出,用圖像的上下文語義來指導計數過程。該方法主要利用人群場景的上下文和語義信息對密度圖進行約束,減少特征信息丟失,以獲得更好的性能,適用于稀疏、密集場景,不過它的結構往往比較復雜。

前面提過MCNN[43]采用自適應高斯核來提高密度圖的質量,計數性能的一個關鍵就是密度圖質量。由于研究人員在語義分割[61]、場景解析[62]和視覺顯著性[63]中使用上下文信息取得了突出效果,為了解決上述問題,Sindagi等人[64]提出了上下文金字塔卷積神經網絡模型(contextual pyramid CNN,CP-CNN)。通過結合人群圖像的全局和局部上下文信息來生成高質量的人群密度圖。如圖7所示,其結構由4個模塊組成。全局上下文估計器(global context estimator,GCE)是一個基于VGG 16的CNN,它對全局上下文進行編碼,通過訓練對輸入圖像進行密度級別分類。局部上下文估計器(local context estimator,LCE)對局部上下文信息進行編碼,作用也是對輸入圖像進行密度級別分類。密度圖估計器(density map estimator,DME)借鑒了文獻[43]的網絡架構,將輸入圖像轉換為一組高維特征圖。融合卷積神經網絡(fusion-CNN,F-CNN)將這些特征圖和GCE與L2CE提供的上下文信息相融合。與現有方法相比,CP-CNN的突破是生成了質量更好的密度圖,計數誤差更低,并通過優化對抗損失和像素歐幾里德損失的加權組合,F-CNN以端到端的方式與DME一起訓練。

圖7 CP-CNN結構Fig.7 Structure of CP-CNN

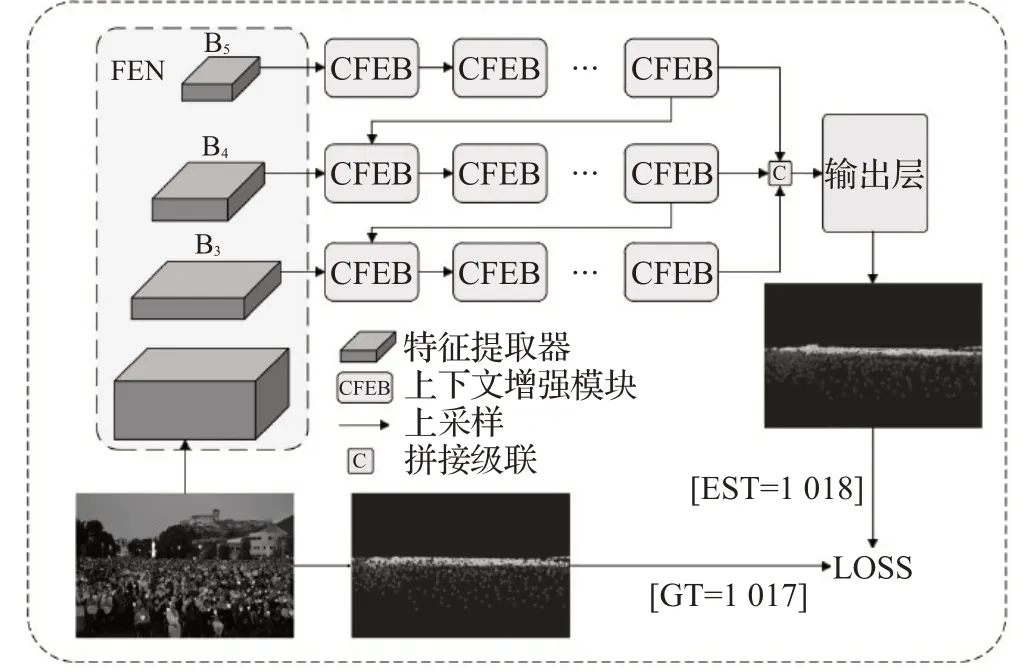

為解決密度估計圖中目標的空間信息丟失問題,郝曉亮等人[65]提出基于上下文特征重聚合的人群計數網絡(context-aware feature reaggregation network for crowd counting,CFRNet),CFRNet由三個模塊構成,算法結構如圖8所示。特征提取器(feature extraction network,FEN)用于提取特征。上下文特征增強模塊(context-aware feature enhance block,CFEB)引入空洞卷積層,強化提取的特征,為了同時兼顧小尺度的人群信息,池化操作用空洞卷積層替換。多尺度特征融合結構(multi-scale feature fusion model,MSFM)融合特征圖后,進一步增強特征,最后輸出高質量的密度圖。CFRNet通過二次聚合增強后的特征,提高了算法性能。

圖8 CFRNet算法結構Fig.8 CFRNet algorithm structure

除了上述的工作,Shang等人[66]并沒有直接根據整幅圖像計算人群數量,而是使用重疊區域的共享計算來估計最終的個體數量。Liu等人[67]將多個接收域大小和每個圖像位置的特征結合起來,然后使用端到端可訓練網絡對其進行訓練。最后,該網絡輸出高質量的密度圖。

2.3 多任務計數網絡

考慮到尺度問題是實現更高精度的限制因素,一些基于CNN的方法通過多列或多分辨率網絡專門解決尺度變化的問題。盡管這些方法顯示出了對尺度變化的魯棒性,但它們在訓練中仍然受到尺度的限制,并且學習廣義模型的能力不足。最近,多任務學習在計算機視覺任務中取得較好的效果,例如將密度估計與分類、檢測、分割等任務相結合,表現出了更好的性能,而且還適用于稀疏、擁擠嘈雜的場景。基于多任務的方法通常設計有多個子網,所以與單列網絡相比,不同的任務可能會有對應的分支。綜上所述,多任務體系結構可以看作是多列和單列的交叉融合,但又不同于任何一種。

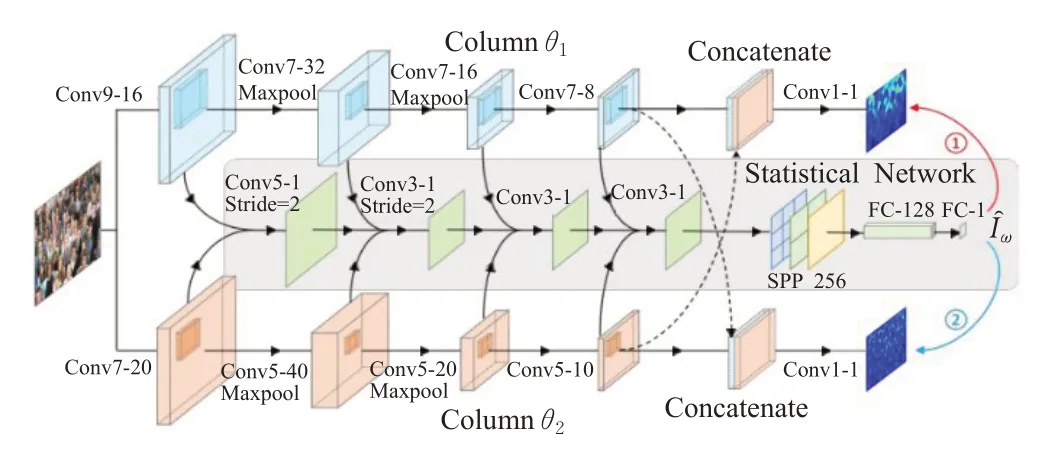

在估計密度圖的部分方法中,池化層的存在降低了輸出密度圖的分辨率,從而影響了在全分辨率密度圖上的回歸。這導致關鍵細節的丟失,尤其是在包含大尺度變化的圖像中。文獻[68-70]成功把級聯卷積網絡應用于多任務中,Sindagi等人[71]為了解決現存問題,提出了一種新的端到端的級聯神經網絡,以級聯方式學習兩個相關子任務:人群計數分類(也叫高級先驗)和密度圖估計,其網絡結構如圖9所示。級聯網絡具有對應于兩個子任務的兩個階段,第一階段是學習高級先驗,該階段的卷積層和空間金字塔池化層,用于處理任意尺寸的圖像,末端是全連接層,交叉熵誤差作為該階段的損失層。高級先驗學習將計數分類不同的組,這些到組的類標簽是基于圖像中出現的人數。通過利用計數標簽,高階先驗能夠粗略估計出整個圖像中不受尺度變化影響的人數,從而使網絡能夠學習到差異更大的全局特征。第二階段是密度圖估計,該階段由一組卷積層組成,其中分數階卷積層對前一層的輸出進行上采樣,來解決池化層產生的細節損失問題,標準像素歐幾里德損失作為該階段的損失層。兩個階段共享一組卷積特征,共享網絡由兩個卷積層組成,每層后面有一個參數校正線性單元激活函數。

圖9 Sindagi等人提出的級聯網絡結構Fig.9 Cascading network structure proposed by Sindagi et al.

除上述文獻以外,還有許多研究嘗試把多任務學習應用到人群計數領域。

(1)CMTL[71]。將人群計數分類和密度圖估計結合到端到端的級聯框架中。

(2)Decidenet[72]。分別通過生成基于檢測和回歸的密度圖來預測人群數量。它可以自動切換檢測模式和回歸模式,在網絡中采用注意力模塊來分配相關權重,從而選擇合適的模式。如果用多列網絡來實現模式轉變可能會產生大量的參數,用多任務學習則避免了這個問題。

(3)ACSCP[73]。ACSCP引入了一種對抗性損失使模糊密度圖變得清晰。此外,還設計了一個尺度一致性正則化器,以保證跨尺度模型的標定和不同尺度路徑之間的協同。

(4)CL[74]。同時完成人群計數,密度圖估計和定位三個任務,這三個任務相互關聯,使得深度CNN中優化的損失函數是可分解的。

(5)ATCNN[75]。把幾何屬性、語義屬性和數字屬性這三種異構屬性作為輔助任務來實現人群計數任務。

(6)NetVLAD[76-77]。是一個多尺度多任務框架,把從輸入圖像中捕獲的多尺度特征集合成一個緊密的特征向量。此外,為了網絡提高性能,底層使用了“深度監督”來提供額外的信息。

2.4 注意力感知計數網絡

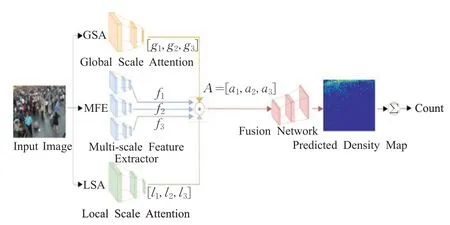

多尺度問題造成了位于不同景深的目標尺寸區別過大,人群計數模型的建模能力需要進一步強化,而加入注意力機制可適用于不同尺度、復雜強度和視角變化等場景。Hossain等人[78]為了解決尺度變化問題,在受到Chen等人[79]的啟示后,提出了多分支的尺度感知注意力網絡(scale-aware attention network,SAAN),其結構如圖10所示。這是人群計數領域第一次引入注意力機制。該網絡中的注意力扮演著與Switch-CNN[46]中的“開關”(即密度分類器)類似的角色。SAAN有四個模塊,全局尺度注意力(global scale attentions,GSA)和局部尺度注意力(local scale attention,LSA)分別提取圖像密度的全局上下文信息和局部上下文信息。此外,GSA根據注意力評分把圖像密度分成3個等級,LSA將生成三個像素級注意力圖。生成多尺度特征提取器(multiscale feature extractor,MFE)借鑒了MCNN[43]的多分支網絡,旨在從輸入圖像中提取多尺度特征。融合網絡(fusion network,FN)從圖像中提取特征圖,為輸入圖像生成最終的密度圖。與Switch-CNN和CP-CNN相比,SAAN運用注意力機制進行尺度選擇的方式更靈活,不過它的計算量大、參數多、訓練時間長。

圖10 SAAN結構Fig.10 Architecture of SAAN

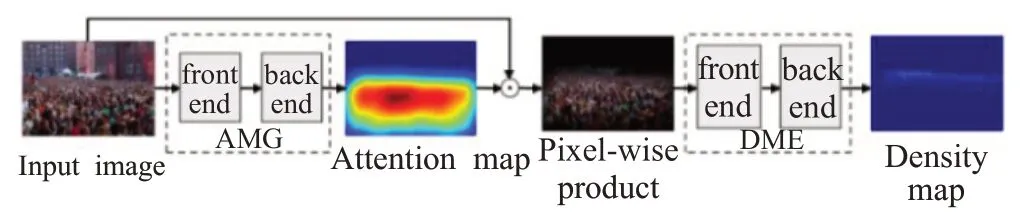

盡管基于CNN的人群計數結果取得了顯著進步,但在高擁擠場景中,會受到遮擋、背景噪聲的干擾。為解決這個問題,Liu等人[80]提出了加入注意力的可形變卷積網絡,稱為ADCrowdNet,如圖11所示。它采用兩個級聯網絡:AMG(attention map generator)和DME(density map estimator),AMG是基于完全卷積架構的分類網絡,用于生成注意力圖,而DME是基于可變形卷積層的多尺度網絡,用于生成密度圖。由于加入了注意力,可形變卷積添加了方向參數,卷積核在注意力引導下,提高了建模能力,更好地適應視角失真和人群分布差異,提高了高擁擠場景中人群密度圖的質量。卷積核在訓練DME之前,用人群圖片和背景圖片來訓練AMG模塊,接著用訓練好的AMG來生成輸入圖片的注意力圖。然后,用輸入圖片和相應注意力圖之間的像素積來訓練DME模塊。AME前端使用前10層訓練好的VGG-16模型[40]提取低級特征,后端使用多尺度可形變卷積層,采用多個空洞率不同的空洞卷積層擴大感受野,來應對不同尺度的人群分布。

圖11 ADCrowdNet結構Fig.11 Architecture of ADCrowdNet

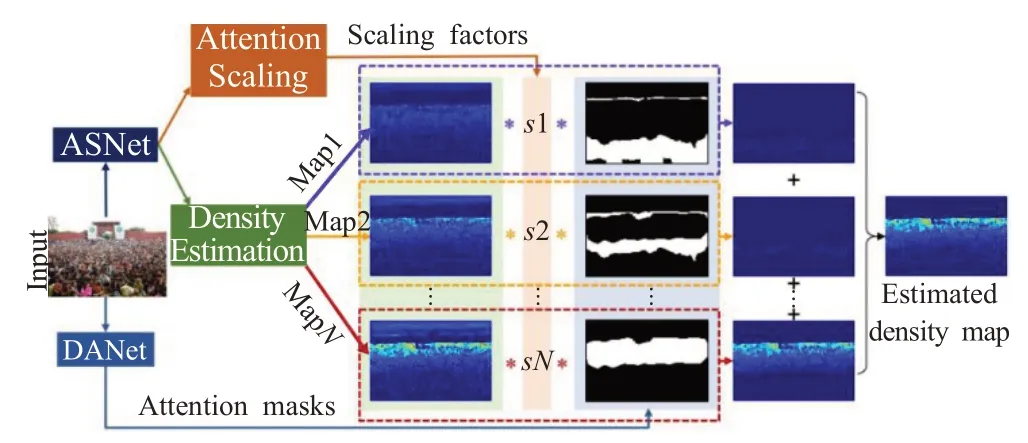

數據驅動型的計數網絡效果顯著,不過容易高估或低估不同密度區域的人數,從而降低整體計數精度。為了克服這個問題,Jiang等人[81]提出了一種方法,能夠處理不同密度分布的擁擠場景。網絡結構由密度注意力網絡(density attention network,DANet)和注意力尺度網絡(attention scaling network,ASNet)組成,如圖12所示。DANet為ASNet提供了與不同密度級別的區域相關的注意力掩碼。ASNet生成比例因子,這些比例因子有助于微調相應局部區域的總體人群計數,然后將它們乘以注意力掩碼,以輸出單獨的基于注意力的密度圖。這些密度圖相加得到最終的密度圖。此外,該方法還提出了一種新的自適應金字塔損失函數(adaptive pyramid loss,APLoss)來分層計算子區域的估計損失,從而減輕了訓練偏差,提高了計數網絡的泛化能力。

圖12 Jiang等人提出的網絡結構Fig.12 Network structure proposed by Jiang et al.

此外,還有許多研究嘗試把注意力機制應用到人群計數領域。

(1)MSAN。Varior等人[82]使用多分支尺度感知注意力來解決圖像中頭部尺度變化較大的問題。該網絡用不同層次的分支在多個尺度上預測相應的密度圖,最后利用軟注意機制融合之前預測的多尺度密度圖,還引入了一個尺度感知的損失函數來指導網絡在不同階段的訓練,這對大規模變化的場景有明顯的改善。

(2)SCAR。Gao等人[83]注意到現有的人群統計方法大多只關注人群的局部外貌特征,而忽略了大量的上下文信息和注意力信息。因此,提出了一個SCAR(spatialchannel-wise attention regression network)框架,該框架包括一個SAM(spatial-wise attention model)和一個CAM(channel-wise attention model)。SAM對整個輸入圖像進行編碼,以獲得大范圍的上下文信息,從而更準確地預測密度圖。CAM從信道中提取出最具識別力的特征,使網絡模型對噪聲背景更加穩健。最后,將兩個注意力網絡的信息進行整合,得到一個融合的密度圖。

(3)SFANet[84]。針對場景中人頭尺度變化大、背景噪聲強的問題,提出了一種帶有注意力的雙路徑多尺度融合網絡用于人群計數。他們以VGG-16網絡為前端進行特征提取,以雙路徑多尺度融合網絡為后端生成密度圖。

(4)Attend To Count[85]。提出了一種融合計數注意力機制的人群計數的自適應模型。該模型較好地利用了粗網絡、細網絡和光滑網絡的多分支進行預測。粗網絡以原始圖像為輸入,經過多列網絡后輸出粗糙密度圖。Fine網絡通過層與層之間的連續融合得到一個微調的密度圖區域。最后,Smooth網絡將兩個密度圖結合,得到最終的密度圖。

基于注意力的方法受到了人腦認知機制的啟發,并在許多人工智能的領域得到了證明。人群計數中的注意力機制可以顯著提高模型在不同尺度、復雜強度和視角變化等復雜場景的計數性能。當然,這一領域的研究還有待進一步深入。

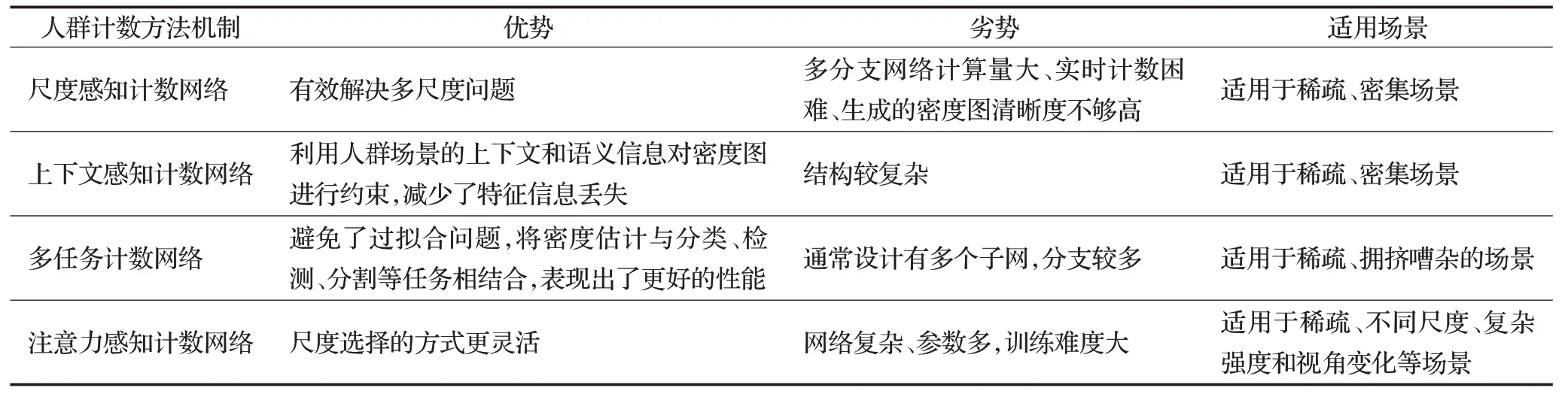

綜上所述,本節對主要的人群計數機制進行了一個系統性的陳述,分析了它們的優勢、劣勢和適用場景。如表1所示。

表1 人群計數機制的對比分析Table 1 Comparative analysis of crowd counting mechanisms

上述分析可知,計數模型的結構在不斷發展,為了解決多尺度問題和跨場景問題,計數網絡由單分支結構升級成多分支結構,網絡結構的建模能力得到進一步鞏固。雖然提高了計數準確度,但是也使得網絡結構越來越復雜、參數多、計算量增加,降低了模型的計數效率。為了應對這些難題,研究者嘗試把多分支結構用單分支結構代替,通過引入創新的CNN模型來降低模型復雜度和提高計數準確度,這將是人群計數領域以后的發展趨勢。上下文感知計數網絡、多任務計數網絡和注意力感知計數網絡等CNN技術可以有效解決多尺度、跨場景和背景噪聲等問題,生成更優質的密度圖,提高計數精度。

3 基于ViT的人群計數

主流的人群計數方法通常利用卷積神經網絡來回歸密度圖,需要點級標注,點級標注耗費財力和人力,因此研究人員傾向于更經濟的標記方式,僅依賴計數級注釋的弱監督計數方法應運而生。目前的弱監督計數方法采用CNN通過圖像端到計數端來回歸人群的總數。然而,基于CNN的弱監督方法的內在限制是上下文建模的接受域有限。因此,這些方法不能達到令人滿意的性能,限制了實際應用。Transformer是自然語言處理中一種流行的序列到序列預測模型,它包含全局接受域,顯示出比CNN架構更出色的優勢。這意味著Transformer架構更適合弱監督計數任務,因為該任務的目標是直接在整個圖像上預測人群總數。

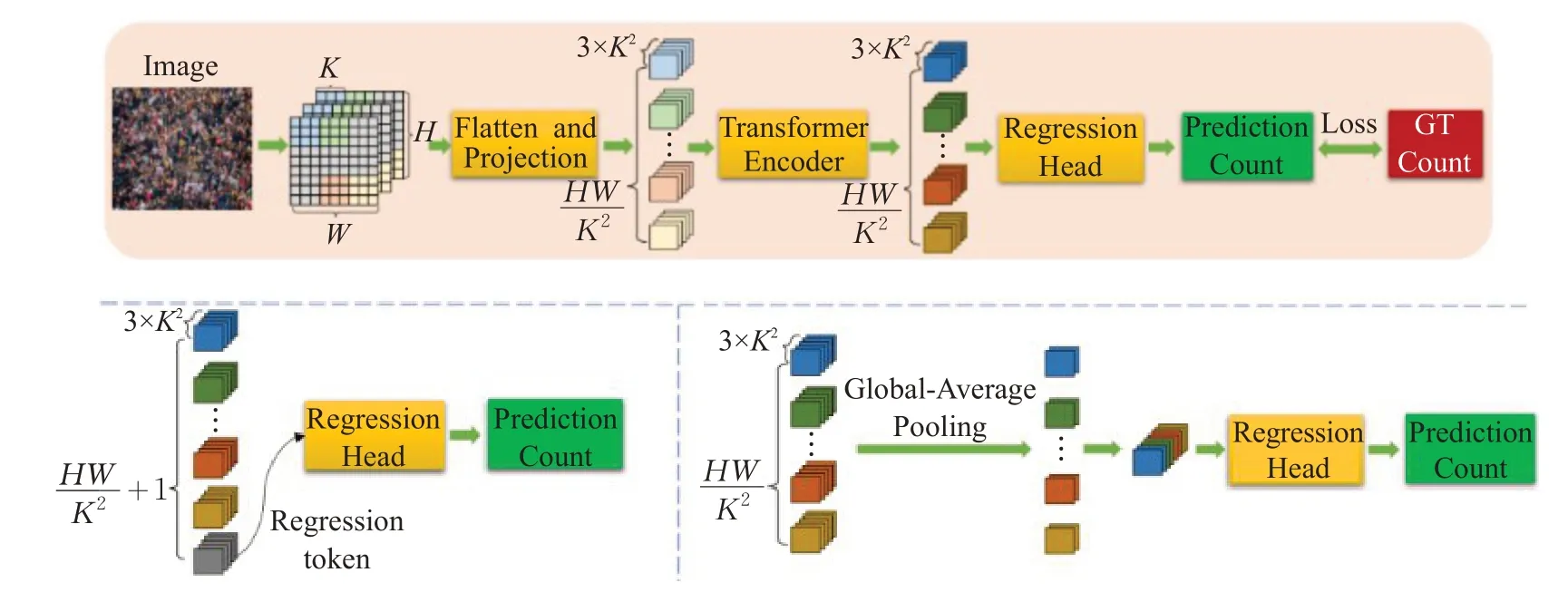

Liang等人[86]提出了TransCrowd,它從基于Vi T的序列計數的角度重新表述了弱監督人群計數問題。TransCrowd能夠利用ViT的自注意力機制有效地提取語義人群信息。此外,這是研究人員首次采用ViT進行人群計數研究,并且取得顯著效果。如圖13所示,TransCrowd分為兩種類型:Trans Crowd-Token和TransCrowd-GAP。TransCrowd-Token利用一個額外的可學習標簽來表示計數,TransCrowd-GAP采用Transformerencoder輸出序列中所有項的全局平均池化(global average pooling,GAP),來獲得池化的視覺標記。然后,回歸標記或池化的視覺標記被送到回歸總部生成預測計數。事實證明,與TransCrowd-Token相比,TransCrowd-GAP能夠獲得更合理的注意力權重,獲得更高的計數精度,收斂速度更快。

圖13 TransCrowd的網絡結構Fig.13 Architecture of TransCrowd

4 人群計數分析

4.1 評價標準

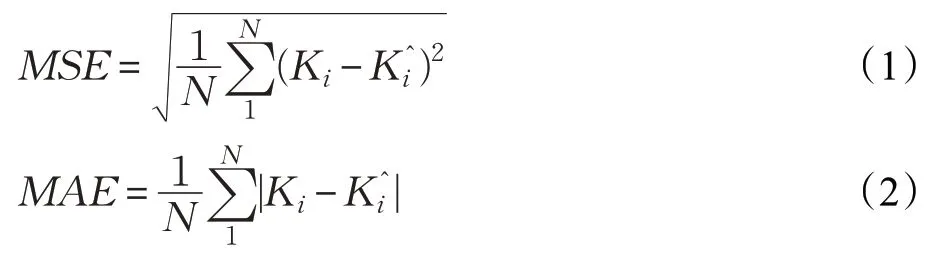

為了驗證神經網絡模型的魯棒性和準確度,分別引入了量化標準均方誤差(mean squared error,MSE)和平均絕對誤差(mean absolute error,MAE),公式如下:

MSE越小則魯棒性越好,MAE越小則準確度越高。N表示測試圖片的總數,K i表示第i張圖像的實際真實人數,K^i表示第i張圖像的估計人數。通過這兩個常用的指標,可以反映一個模型的優劣。

4.2 數據集和結果分析

人群計數領域出現了一批經典數據集,使得研究人員創建了泛化能力更好的模型。相比于早期低密度的數據集,當前的數據集關注高密度人群場景,能有效應對尺度變化、雜亂和遮擋的問題。下面將介紹UCSD[87]、WorldExpo’10、ShanghaiTech[43]、UCF_CC_50[88]這幾個數據集。

(1)UCSD dataset。UCSD[46]是人群計數領域的第一批數據集之一,其是由視頻監控在加州大學圣地亞哥分校的人行道上收集的。原始視頻以30 frame/s捕獲,幀大小為740×480,隨后被下采樣至238×158和10 frame/s。視頻的前2 000幀(200 s)用于真實注釋,作為數據集。在人行道上選擇了一個感興趣區域每隔5幀人工標注一次,剩余幀中的行人位置通過線性插值來估計。該數據集分為訓練集和測試集,總共包含49 885個行人實例。訓練集包含索引為600到1 399的幀,測試集包含剩余的1 200個圖像。該數據集人群稀疏,平均每幀15個人左右,數據集是從單一場景收集的,所以圖像之間的場景視角沒有變化。

(2)WorldExpo’10 dataset。為解決單一場景問題,Zhang等人[39]引入了一個數據集用于跨場景人群計數WorldExpo’10。該數據集來自2010年上海世博會,其中包括108個監控攝像頭捕獲的1 132個帶注釋的視頻序列,通過鳥瞰式攝像機收集視頻,豐富了場景類型。數據集總共標注了3 980幀分辨率為576×720的圖像,標記行人199 923個。數據集被分成兩部分,來自103個場景中的1 127個1 min長的視頻序列被視為訓練和驗證集。測試集來自5個不同場景,每個測試場景中有120個標記幀,兩個幀之間的間隔為30 s。人數變化范圍從1到220,因此該數據集不適用于極度密集場景。

(3)ShanghaiTech dataset。彭超等人[45]引入了一個新的大規模人群計數數據集,該數據集由1 198張圖像和330 165個注釋頭組成,是帶注釋人數最多的數據集之一。它包含兩個部分:A和B。A部分的482張圖片是從互聯網隨機下載的,而B部分圖像來源于上海街道。與B部分相比,A部分的密度圖像要大得多。這兩個部分又進一步劃分為訓練集和測試集。A部分的訓練和測試分別有300和182幅圖像,而B部分的訓練和測試分別有400和316幅圖像。該數據集的圖像具有不同場景類型和不同密度級別,不過不同密度級別的圖像數量并不一致,使得訓練和測試傾向于低密度級別。

(4)UCF_CC_50。該數據集是第一個真正具有挑戰性的數據集,由公開可用的網絡圖像創建。為了豐富場景類型的多樣性,收集了音樂會、示威、體育場、馬拉松等不同標記的圖像。它包含了50張不同分辨率的圖像,平均每張圖像有1 280個人。在整個數據集中總共標記了63 075個人,圖像上人的數量從94到4 543不等,這表明在圖像上存在很大的差異。這個數據集的唯一缺點是用于訓練和測試的圖像數量有限。考慮到低數量的圖像,定義了一個交叉驗證協議來訓練和測試,其中數據集被分成10個集合,并執行5倍的交叉驗證。這個數據集挑戰很大,當前基于CNN的最先進方法在這個數據集上的結果效果不佳。

如圖14所示,是數據集的樣本,從左至右分別是UCSD、UCF_CC_50、WorldExpo’10、Shanghai Tech A和ShanghaiTech B。

圖14 不同數據集的樣本Fig.14 Samples of different data sets

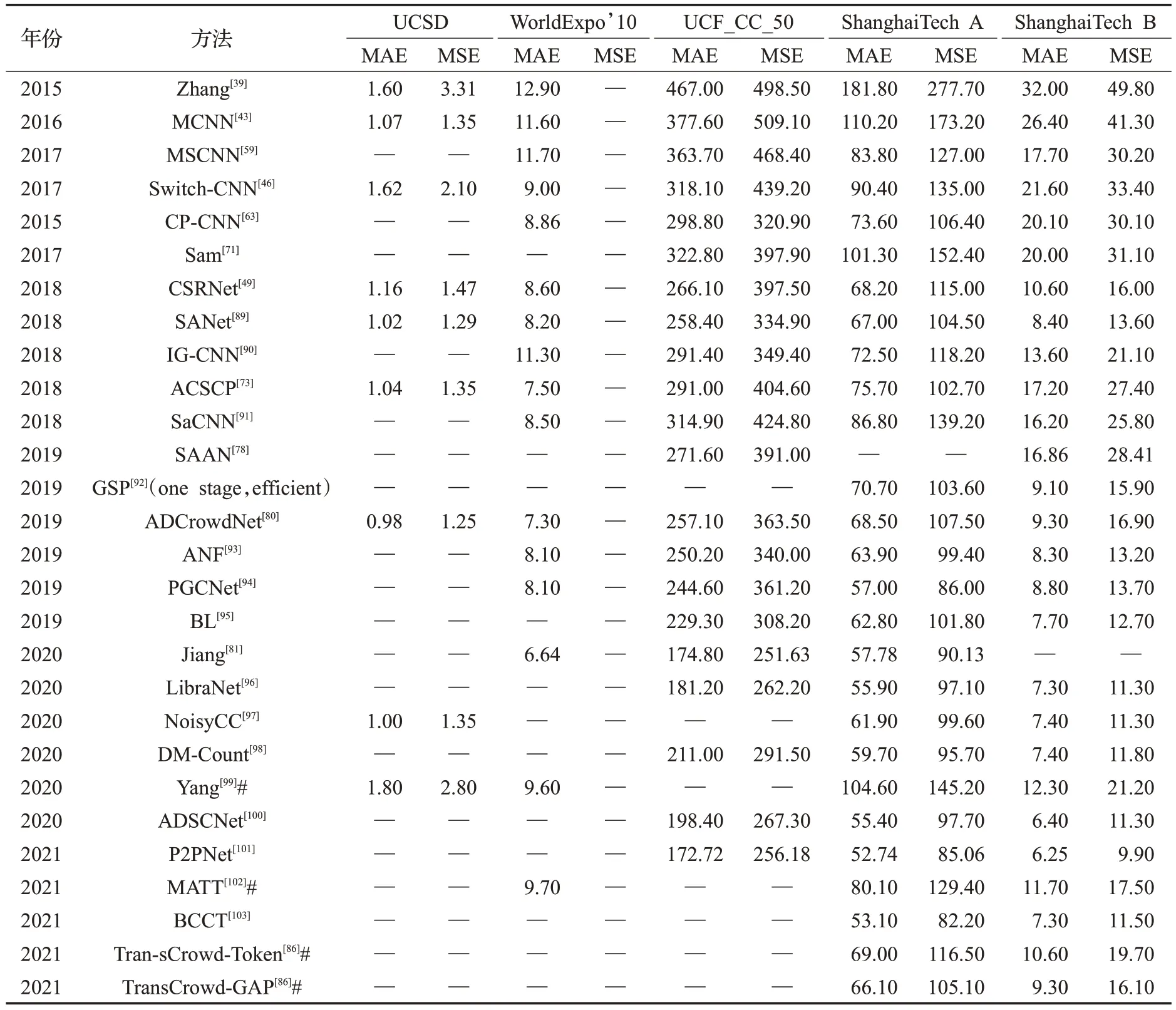

下面是不同計數網絡在不同數據集上的性能對比,如表2所示。

表2 不同計數網絡在不同數據集上的性能對比Table 2 Performance comparison of different counter networks on different data sets

表2羅列了部分人群計數網絡在4個主流人群數據集上的結果。CSCC[39]是單分支結構,MCNN[43]、Switch-CNN[46]、CSRNet[49]、MSCNN[89]和IG-CNN[91]是多分支結構,經過對比可知,多分支結構相比單分支結構有更強的提取特征能力,其計數性能也優于單分支結構。CP-CNN[71]是上下文感知結構,在多列的基礎上增加了全局上下文感知模塊和局部上下文感知模塊,增強了計數精度。文獻[78,80-85]在密度估計的基礎上引入了注意力機制,增強了網絡結構的魯棒性,提高了網絡的泛化能力和計數精度。文獻[70-77]是多任務模型,經過對比,多任務模型比單任務模型計數效果更好。TransCrowd-Toke和TransCrowd-GAP[86]是TransCrowd提出的基于ViT的弱監督計數方法。如前所述,盡管基于ViT的弱監督計數方法性能不如全監督計數方法,但相比其他基于CNN的弱監督計數方法[101-103]展示了獨特的優越性。表2的實驗結果表明,計數精度甚至與部分全監督計數方法相當。

5 結語

本文對人群計數領域的傳統方法、基于CNN和基于ViT三種方法進行了系統性的介紹和分析,通過分析,可得到以下幾點結論:

(1)數據集的場景由單一化逐漸演變成多樣化,跨場景、高度擁擠和遮擋的圖像也能用模型訓練并取得較好效果,圖像分辨率不斷提高,數據圖像數量不斷擴大。

(2)基于CNN的方法在人群計數領域發展迅猛,研究成果豐富。CNN強大的學習能力以及提取特征能力提高了估計準確率,大大推動了這個領域的發展。多列結構模型復雜、參數多,目前很多研究人員仍然重點研究單列結構。同時,引入新的損失函數來優化模型依然是研究熱點。

(3)Transformer是自然語言處理中的一種預測模型,Transrowd[43]利用Transformer的自注意機制可以有效地提取語義群體信息,突破了基于CNN的弱監督計數方法的部分限制,還采用了比CNN更經濟的標注方式,降低了成本。

(4)遮擋、透視失真、光照、極端天氣等問題依然是人群計數領域需要克服的困難,今后研究人員可以嘗試攻克這些特殊情況的計數問題,并且建立相應數據集。

本文回顧了人群計數領域的方法,介紹了常用的數據集、評價指標以及計數網絡,分析了該領域的發展趨勢,希望能給后續研究提供幫助。