基于改進YOLOv3和核相關濾波算法的旋轉彈目標探測算法

王少博, 張成, 蘇迪, 冀瑞靜

(北京理工大學 宇航學院, 北京 100081)

0 引言

現代戰爭中,精確制導武器日益成為戰場的主角。“衛星+慣性導航(以下簡稱慣導)”組合的制導模式,由于其自主性強、精度高,成為精確制導武器采用的主流制導方式,特別是在炮兵制導彈藥中處于壓倒性優勢地位。但隨著攻防對抗日益激烈、戰場環境日趨復雜,“衛星+慣導”的制導方式已無法完全滿足現代戰爭對精確制導彈藥的要求。首先,“衛星+慣導”作為以坐標點為制導目標的制導方式,只能對固定目標進行打擊,不適應機動作戰、立體攻防的陸軍建設目標;其次,彈藥的射擊精度完全以目標的定位精度為基礎,對沒有經過事前高精度偵察的目標打擊時效性差;第三,衛星導航容易受到對方電子戰干擾,在戰時難以保證全天時使用,而失去衛星輔助后,依靠戰術級慣導系統自身的精度,難以達到精確打擊要求的精度。因此,采用末制導手段進一步提高制導彈藥的性能,已經成為必然趨勢[1]。圖像制導以其抗干擾能力強、無需輔助照射等優點,成為首選方案。

在電視制導領域,由于地面戰場環境復雜,要在離目標較遠情況下將目標精確檢測出來,對識別算法有著較高的要求[2]。傳統檢測算法主要通過灰度模板、特征點信息、頻域特征或模型進行匹配,再結合相應策略對目標進行定位,主要包括基于統計的支持向量機(SVM)算法、AdaBoost分類器等檢測方法,以及光流法、背景差分法等基于運動檢測的方法和基于顯著性檢測的方法。經過長期發展,傳統彈載圖像目標檢測算法工程應用較廣泛,能夠基本滿足簡單環境下的打擊任務,但隨著戰場環境日趨復雜,精確制導彈藥對于精確打擊性能、智能化需求越來越高,對目標檢測和跟蹤算法的性能有著更高的要求[3-5]。

得益于大數據、人工智能技術的發展,尤其是以深度學習算法為基礎的智能目標識別技術的進步,使得遠程制導彈藥對軍事目標的自動識別成為可能。在實際作戰中,通過事先獲得的不同類型、不同時機、不同分辨率的海量目標圖像和視頻數據,經過訓練,彈載計算機可以對實時采集到的圖像實現目標識別,從而實現對臨時機動目標的打擊,成為圖像制導的重要發展方向之一,也是彈藥技術由制導彈藥向智能化發展的重要內容。在深度學習目標檢測領域中遇到的困難主要包括三方面:一是數據量不足,在軍事領域最缺失的就是對目標偵查的照片數量;二是偵查拍攝時所處的氣候環境與打擊時有差異,包括光照、噪聲及天氣狀況,不能保證檢測算法通過一次的偵查數據學習適應全氣候打擊;三是小目標難以檢測,特征信息量相對較少,無法有效識別。

目前較成熟的利用深度學習進行目標檢測的算法主要分為兩階段檢測和單階段檢測。其中兩階段檢測的較優秀算法主要是區域卷積神經網絡(R-CNN)、Fast R-CNN、Faster R-CNN等[6-8],單階段檢測主要算法有YOLO系列、單次多盒檢測(SSD)算法等[9-12]。其中YOLOv3是目前在速度和精度上最為均衡的目標檢測網絡算法[12],其在目標檢測任務中性能尤為突出。當前目標跟蹤算法主要分為兩類,即生成模型方法和判別式模型方法[12]。生成模型方法通過搜索最匹配的窗口來執行跟蹤,經典算法有基于均值漂移、基于光流法和基于卡爾曼濾波的目標跟蹤方法,而判別模型方法是利用圖像特征將目標與背景區域分開,由于背景信息對于目標跟蹤十分有效,判別模型方法性能更有競爭力[13]。在判別模型方法中,目標跟蹤算法可以根據是否需要預訓練模型分為兩大類:第一類是基于相關濾波的目標跟蹤算法,無需預訓練模型,利用手工設計模板對視頻或圖像序列中的給定目標進行跟蹤,代表算法有相關濾波跟蹤(MOSSE)算法、循環結構跟蹤(CSK)算法、核相關濾波(KCF)算法等[14-16]。隨后出現的是基于深度學習的目標跟蹤算法,利用數據集預訓練模型,通過CNN進行特征提取以及模板匹配,代表算法有多域CNN(MDNet)算法[17]、孿生網絡系列[18-19]、基于重疊最大化精確跟蹤(ATOM)算法等[20]。上述跟蹤算法主要針對短時間目標跟蹤,對于在較長時間范圍內出現的目標丟失又出視場的問題沒有得到解決。考慮到戰場實時性,KCF算法在跟蹤速度方面始終保持實時高速水平,結合目標檢測算法不失為一個實用性較強的研究方法。

對于旋轉彈,由于電視攝像機與彈體捷聯,采集的圖像隨彈體旋轉而旋轉,解旋后圖像還伴有旋轉和運動模糊的信息,導致成像質量較差,傳統檢測和跟蹤算法已無法有效識別出模糊目標,對目標檢測和跟蹤帶來極大挑戰。

為實現彈體發射后能夠檢測出以上困難情況下的目標并進行良好跟蹤,本文將YOLOv3算法應用到彈載圖像的目標檢測中,對YOLOv3算法進行改進,簡稱S-YOLOv3算法。通過使用數據增強方法,利用深度學習神經網絡在模糊圖像以及復雜環境下對小目標識別檢測的優勢,與處理速度極高的KCF跟蹤算法結合,加入跟丟判別機制和尺度信息,完成了跟蹤算法的改進,使得對目標的檢測跟蹤精度得到進一步提高,為其在工程實踐應用提供了可能。

1 彈載圖像目標檢測算法

隨著Krizhevsky等[21]利用CNN對圖像信息進行提取,促進了CNN在目標檢測領域的發展,與傳統圖像制導炮彈采用的人工特征提取方式不同,基于CNN的特征提取采用監督或者非監督學習方式進行訓練,分層卷積提取信息并自主進行目標特征表示的學習,從而達到對待檢測目標特征的描述。本文結合彈載相機圖像探測目標的成像機理以及CNN在檢測任務中高效精準的表現,提出了一種面向旋轉彈的目標探測技術,以提高圖像制導炮彈目標檢測算法的準確率。

1.1 彈載圖像目標特點

當前制約彈載圖像目標檢測算法性能的主要瓶頸在于過于復雜且相互交融的場景變化,彈載攝像機由于其特殊的應用場景,其成像質量與彈體空中運動姿態以及戰場環境密不可分,多數情況下獲取的彈載圖像存在下列問題:

1) 實時性要求高。彈體在空中飛行時間短,從捕獲目標圖像到彈體著落過程時間短暫,對目標檢測過程的快速、高效性提出了更高要求。

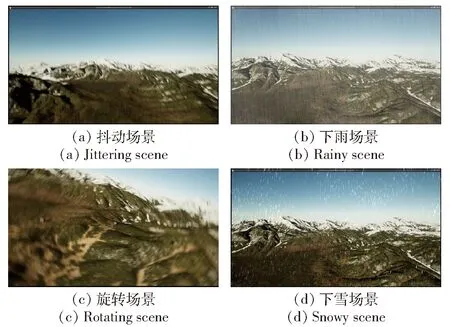

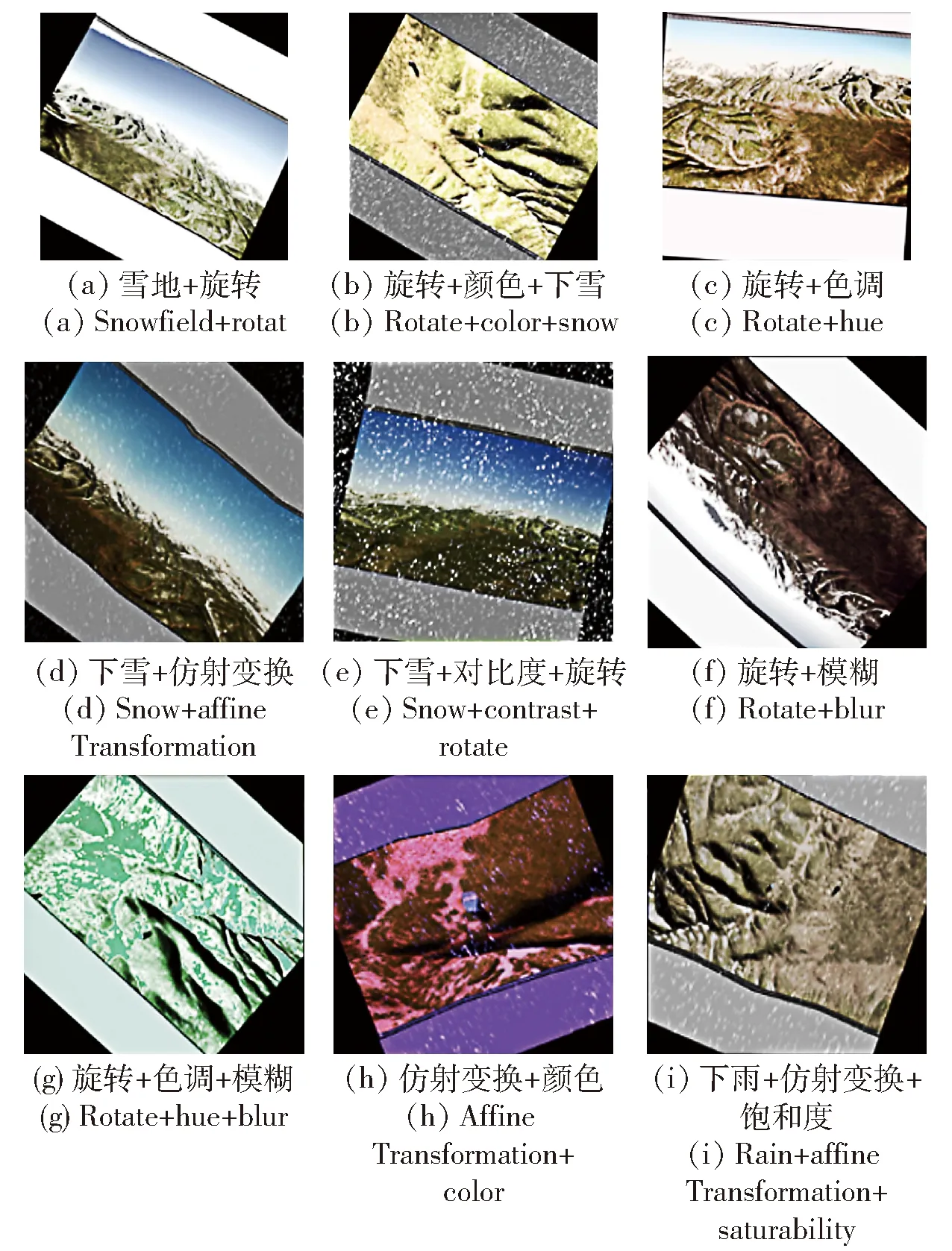

2) 背景復雜。彈體運動過程中,彈載攝像機抓取的背景圖像不斷變化,并且天氣環境變化也會影響彈載圖像的成像質量(見圖1),例如陰、雨、霧、霾情況下成像的清晰度會受到一定程度影響,在檢測、識別過程中產生大量的噪聲。

圖1 復雜背景下的圖像Fig.1 Images in complex environment

3) 目標較小。結合彈載攝像機的應用環境可知,末制導階段彈載攝像機開始工作時,距離目標較遠,目標較小,可提取的目標特征少,在該場景下目標檢測、識別算法表現性能差。

1.2 彈載圖像數據制作

1.2.1 數據來源及標注

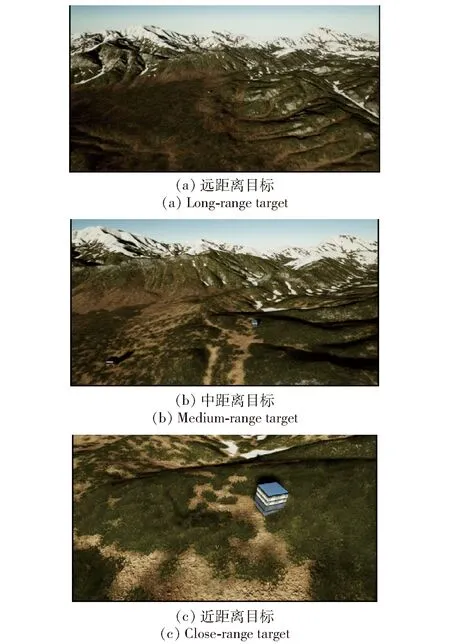

由于真實打擊場景數據獲取困難,本文通過視景仿真軟件模擬的山地打擊場景作為圖像數據進行處理,通過人工標記、裁剪等方法,從場景中獲取圖像數據,數據集包含400張圖片,數據集圖片像素大小為720×400、960×540、1 400×800。圖2所示為模擬旋轉彈距離目標由遠及近情況下圖像采集設備中的視景圖像。

圖2 數據集中的圖像視景Fig.2 Visual images in datasets

數據集標注利用LabelImg標注軟件對圖像視景圖片進行標注。LabelImg軟件是基于Python語言編寫的用于深度學習數據集制作的圖片標注工具,主要用于記錄目標的類別名稱和位置信息,并將信息存儲在可擴展標記語言(XML)格式文件中[12]。

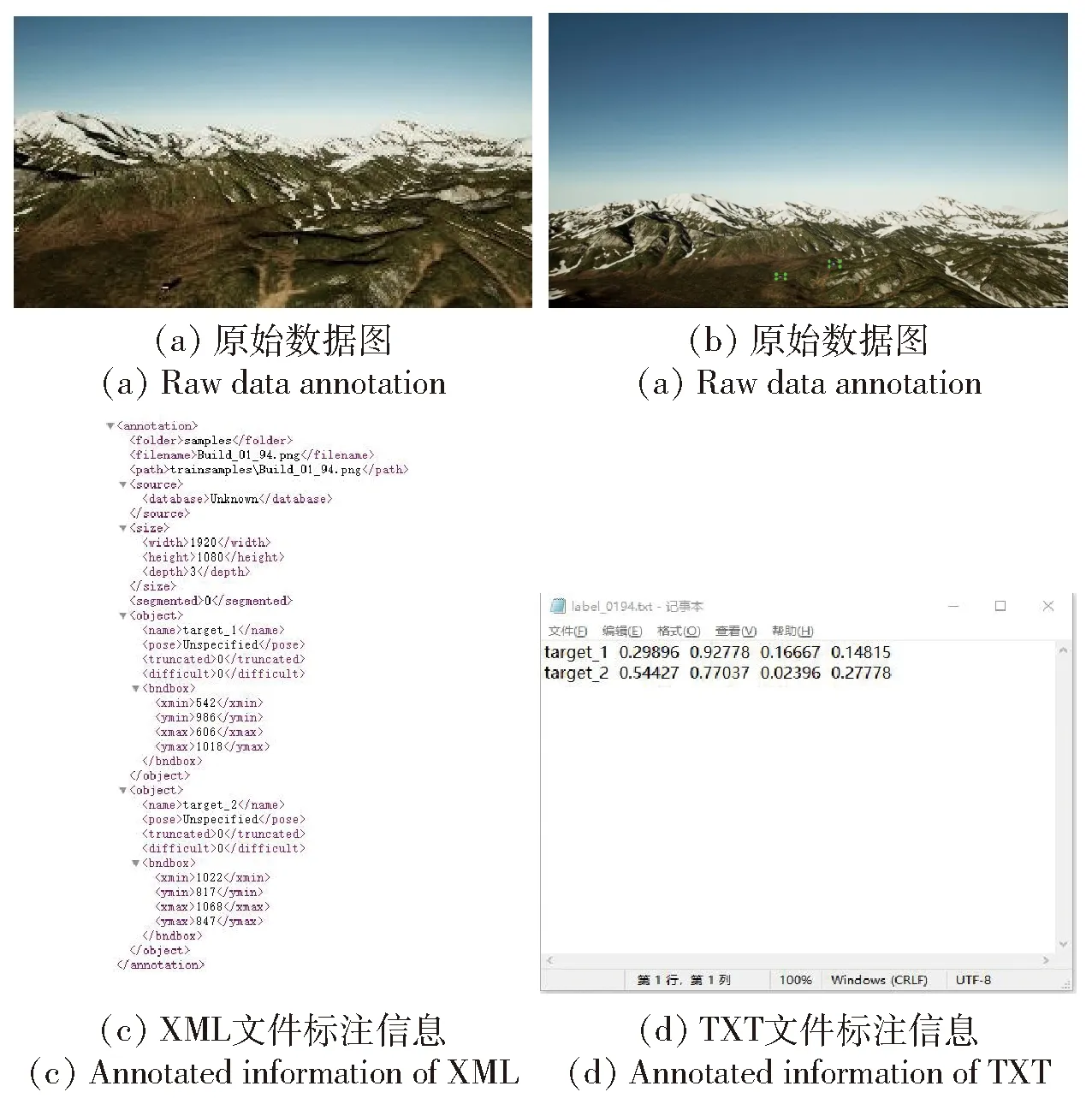

圖3所示為數據標注示意圖。具體標注流程如下:首先對圖像中的目標進行人工識別,確定其為目標;然后用垂直的最小外接矩形框將目標依次選中,同時設置類別標簽以“target_(序號)”表示。矩形框的標記信息存儲在標簽XML文件中,其中(x,y)為矩形框左上角坐標,h、w分別為矩形框高度和寬度。數據標注示例圖如圖3(b)所示,其中綠色矩形框為標注為目標。根據YOLOv3算法的訓練要求,將XML文件轉化為以類別、目標坐標為內容的文本格式文件,為下一步訓練做準備。標注數據類型轉換如圖3(c)和圖3(d)所示,分別表示目標的類別和坐標信息。

圖3 數據標注示意圖Fig.3 Data labeling diagram

在數據集制作中,本文盡可能加入不同尺度、不同表現形式的目標,由于數據有限,使用Imgaug庫對數據進行增強。

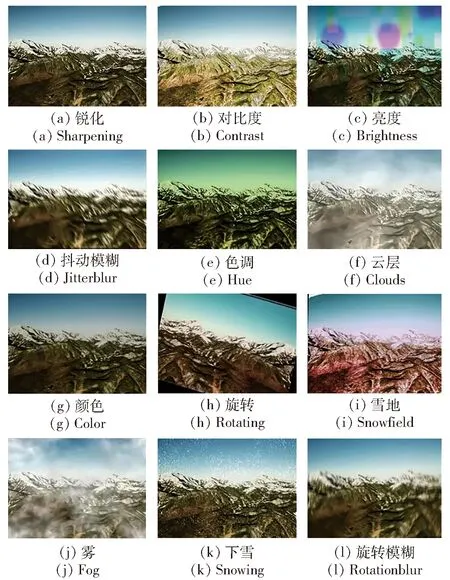

通過調用Imgaug數據庫對400張數據集進行擴充,添加了仿射變換,旋轉模糊、抖動模糊、亮度、左右、上下、翻轉,色調、飽和度、高斯噪聲、銳化、比例×像素、分段仿射、雪地、云層、霧、雪等不同條件的模擬。在實際處理圖像數據時,隨機選擇若干個模擬效果將原圖與目標標記框同時進行增強,既增加了復雜環境的數據又不會對標記框位置產生影響。單項數據增強效果如圖4所示,多項隨機增強疊加效果如圖5所示。最終擴充為1 000張圖像的數據。

圖4 單項圖像增強效果Fig.4 Single image enhancement effect

圖5 多項隨機圖像增強疊加效果Fig.5 Superposition effect of multi-random image enhancement

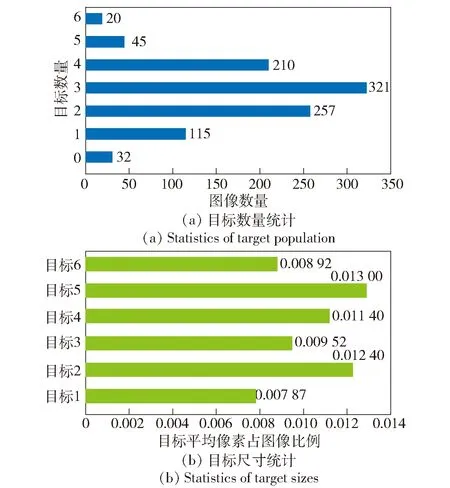

圖6 數據集中目標信息統計圖Fig.6 Statistical charts of target information in dataset

1.2.2 數據集分析

本文數據擴充后一共有1 000張圖像,目標總數2 777個,圖6(a)所示為數據集中每張圖像所含目標個數的統計圖,圖6(b)所示為目標尺寸統計圖。目標平均像素大小為2 598.2,目標平均與原圖像的比例為0.010 5,因此目標屬于較小目標。從圖6可知,數據集中每張圖像上的目標數量為0~6個,目標像素大小在圖像中占比較小。數據集中的圖由于是連續幀,目標大小隨著彈目距離的減小,相機獲取的畫面中目標尺度有一個很明顯的由小變大的過程,故有必要充分利用目標的形狀、細節、尺度特征等信息,研究多尺度網絡檢測模型和跟蹤算法。同時為了確保算法性能,在數據標注過程中還需要準確識別目標,記錄正確的標簽信息。

1.3 基于YOLOv3算法的彈載圖像目標檢測

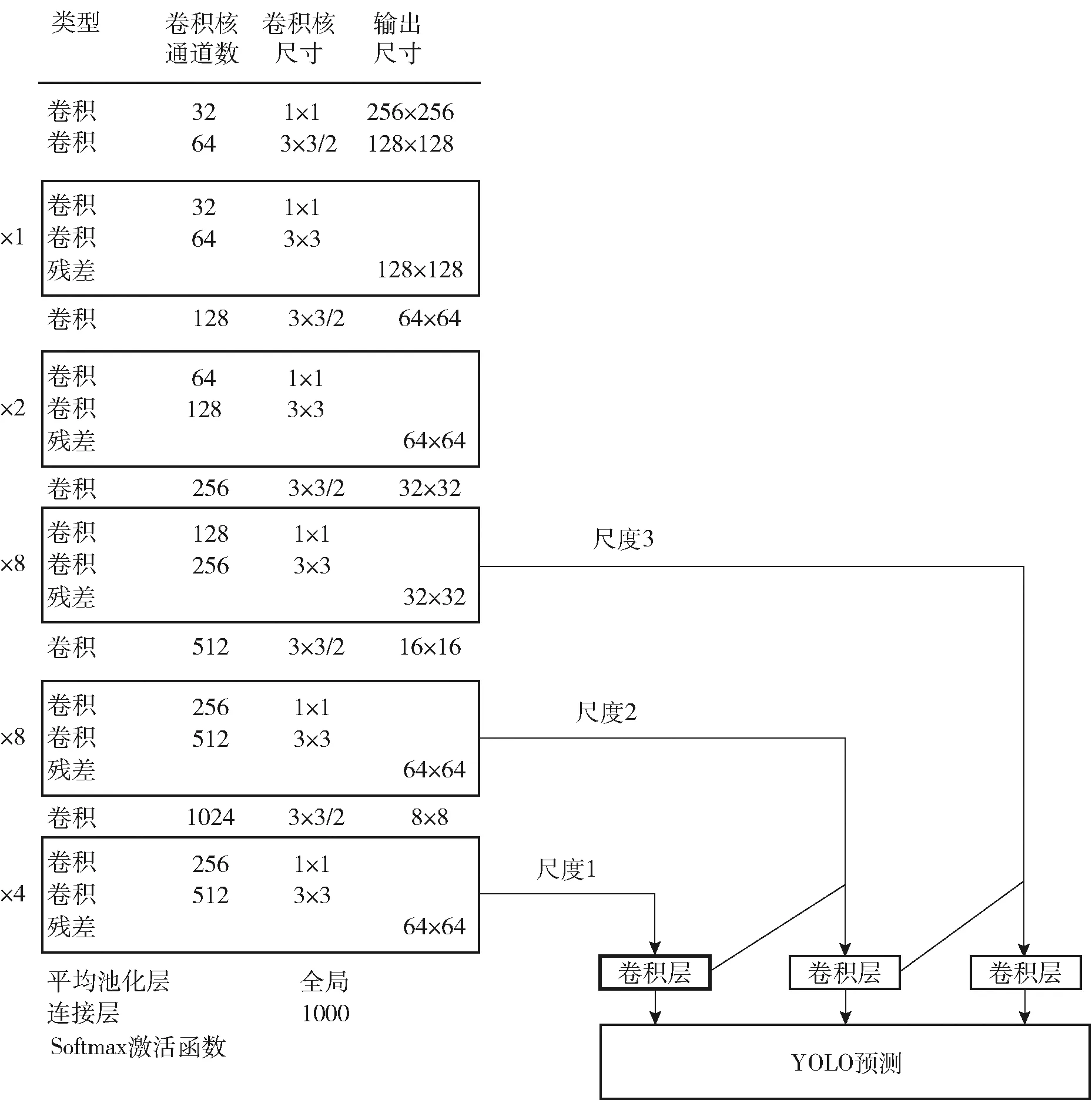

1.3.1 YOLOv3網絡

YOLOv3網絡參考SSD和ResNet[22]的網絡結構,設計了分類網絡基礎模型Darknet-53。Darknet-53兼顧網絡復雜度與檢測準確率,與常用的目標檢測特征提取網絡VGG-16相比,降低了模型運算量[23]。

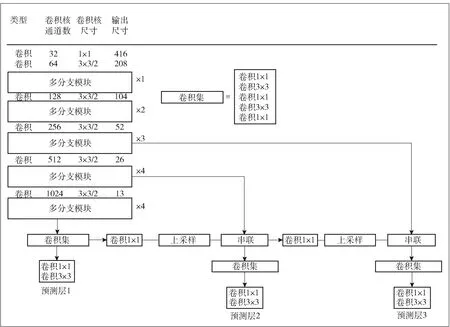

在YOLOv3網絡中Darknet53結構用于圖像特征提取,YOLO結構用于多尺度預測。具體過程由Darknet 53網絡輸出大小為13×13像素、1 024維度的特征圖,進行一系列卷積操作,經過上采樣分別與淺層特征圖連接形成最小尺度YOLO層,再將79層提取出來的13×13×512通道的特征圖進行卷積,降為256通道。進而上采樣生成26×26×256特征圖,與61層特征圖合并卷積,形成中尺度YOLO層,大尺度YOLO層則由91層與36層特征圖進行相應的卷積操作得到。對特征圖進行預測,包括bounding box的坐標信息X、Y坐標,寬度W和高度H,以及網格預測目標置信度(IOU)和類別預測分數。以兩個打擊目標為例,通道數為(4+1+2)×3=21,輸出的3個尺度特征圖為13×13×45,26×26×45,52×52×45,其中Darknet 53結構如圖7所示。

在YOLOv3網絡上使用彈載圖像數據集直接訓練進行檢測,發現有旋轉模糊且目標小于幾十像素時難以檢測出來,因此在后面提到的改進YOLOv3網絡中增加了對小尺度模糊目標的檢測特性。

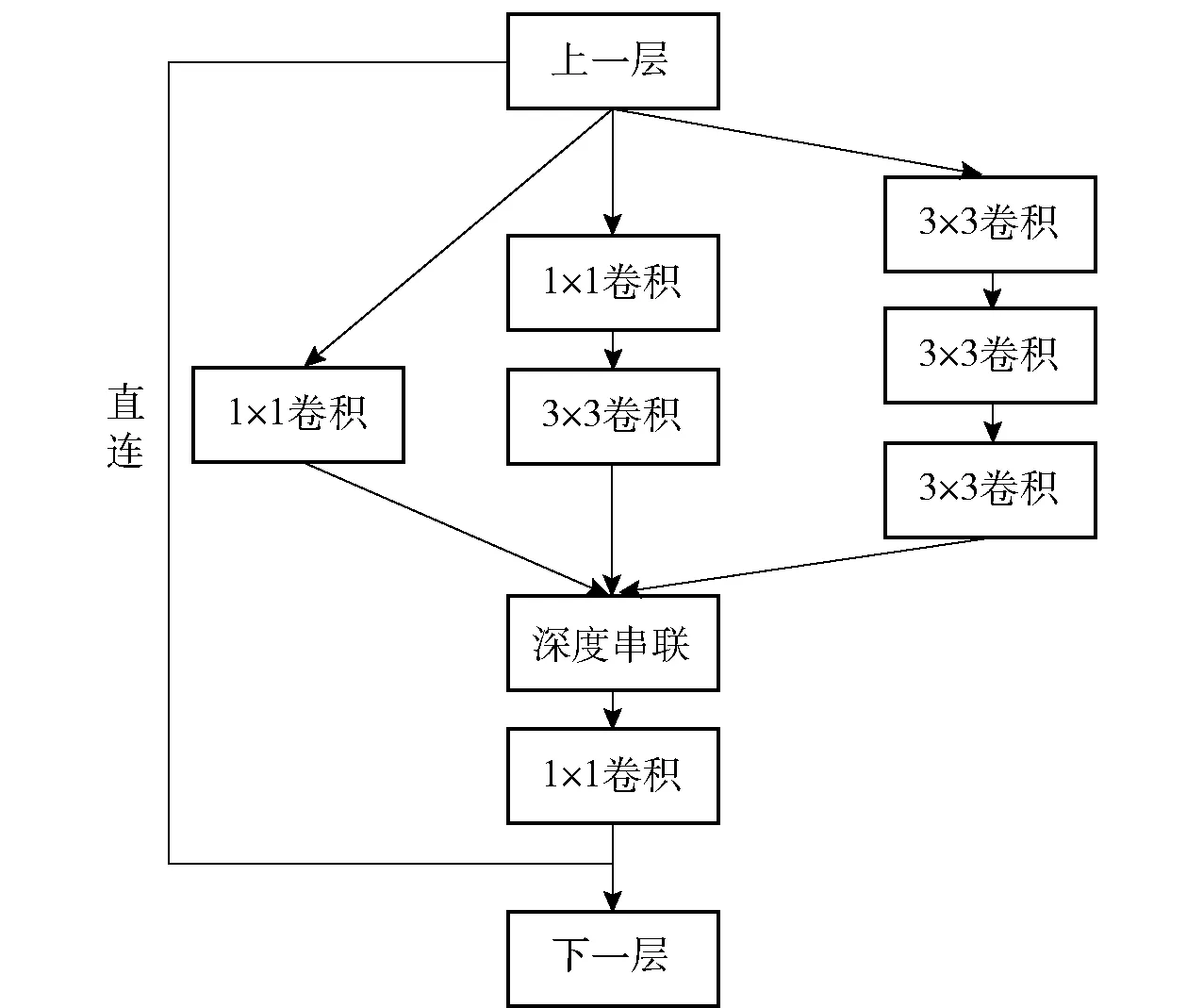

1.3.2 改進的網絡結構

為保證運行時間以及對小目標檢測效果,將原網絡中卷積模塊改為多分支尺度卷積,增加網絡對于目標不同尺寸的適應性,減少網絡層數,來平衡網絡的深度和寬度[24]。采用多分支尺度卷積進行空間聚合則通過低維嵌入來完成,對于圖像網絡提取的特征和表示能力沒有下降,其內部結構可以分為3個分支,如圖8所示。

圖7 Darknet 53結構圖Fig.7 Structure chart of Darknet 53

圖8 多分支結構Fig.8 Multibranch structure

圖8中,深度串聯是指將分支卷積的特征圖按深度鏈接起來形成大小不變而深度疊加的圖,后面緊跟1×1卷積層,并不會改變圖像的高度和寬度,而是改變了深度實現降維,方便多個特征線性組合來進行多通路間的信息整合。加入直連快捷層,將前層提取出的特征與當前層進行疊加,可以避免梯度發散的可能性,對于網絡正向傳播過程中,每一層卷積只能提取一部分信息,對于過小的目標向前傳播幾次,能學到保留的信息就越少,極有可能得到欠擬合的結果。通過添加快捷結構,即在每個模塊中加入最后卷積圖像的全部信息,相當于一定程度上保留了更多的初始特征信息。加入直連結構后,網絡變成了一個最優輸出選擇模型,輸出結果是由之前的塊和組合卷積學習到的一個最優結果,可以將網絡看成并行結構,最終得到的是不同級別的特征提取組合,讓網絡可以學到最適合的模型及參數。

以特征金字塔網絡(FPN)[25]為參考,采用多尺度融合方法進行預測,對于小目標,大尺度52×52的特征圖也就是第1組多分支模塊輸出可以提供分辨率信息,對于正常和小尺度目標,后兩層多分支模塊同時提供分辨率和語義信息,不同尺度的檢測可以有效檢測不同尺度的目標[26]。即使同一個目標出現在多個特征層上被檢測出來,也會因為非極大值抑制取一個最佳的,因此不影響檢測效果。具體結構如圖9所示。

圖9 改進YOLOv3結構Fig.9 Structure chart of improved YOLOv3

1.3.3 錨框計算

使用原有的錨框集合訓練自己的小目標數據并不合適,其設定的好壞將影響目標檢測的精度和速度。本文對小目標數據集的目標候選框在空間維度上進行聚類分析,計算最優錨框個數。YOLOv3的錨框個數和維度是由VOC20類[27]和COCO80類[28]數據集聚類得到的,不適用于遠距離小目標檢測[23],因此重新確定了錨框個數和寬、高維度[29]。

使用無監督學習的k-means均值聚類算法對目標幀進行聚類分析,提取數據集全部目標框大小,將相似對象歸為同一類,最終得到k個數量錨框作為訓練時設定的尺度參數。k-means均值聚類分析采用歐式距離,意味著較大尺度框會產生更多的誤差,因此網絡的損失值采用IOU作為評判指標,即候選框與真實框的交集除以并集,避免較大的邊界框相對于小的邊界框產生的誤差,代替歐式距離的函數為

d(box,centroid)=1-IOU(box,centroid)

(1)

聚類目標函數為

(2)

式中:box為候選框;centroid表示樣本初始聚類中心;k表示劃分樣本的簇的個數。

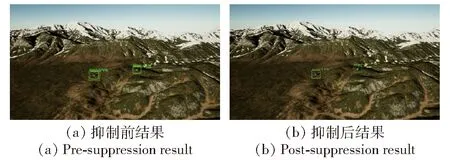

1.3.4 非極大值抑制[30]

直接通過網絡輸出的目標框會有很多,本文通過分辨率1 920×1 080攝像頭采集圖像,并對圖像中的目標進行檢測,結果直接輸出約8個目標框,需要消除多個重復有交疊的檢測框,每個目標只保留最好的一個框。這里使用非極大值抑制方法,抑制不是極大值的元素,對數量進行精簡,通過遍歷高度重疊的邊界框,只保留置信度最高的預測框,針對每一類目標都單獨執行非極大值抑制,效果如圖10所示。

圖10 非極大值抑制前后對比圖Fig.10 Comparison of images before and after non-maximum suppression

2 彈載圖像目標跟蹤算法

2.1 方向梯度直方圖特征

方向梯度直方圖(HOG)[31]的核心思想是通過光強梯度或邊緣方向的分布,描述被檢測到的局部物體的形狀。經過將整幅圖像分割成小的銜接區域(稱為單元),每個細胞生成一個方向梯度直方圖或細胞中像素的邊沿方向,這些直方圖的組合可表示出待檢測物體的描述算子。為提高精度,本文通過計算大面積圖像塊的光強,對局部直方圖進行比較和標準化,然后用這個值歸一化塊中的所有單元,可實現照射和陰影不變性。與其他描述子相比,HOG得到的描述符具有幾何不變性和光學不變性,因此在跟蹤算法中采用該特征提取方法。

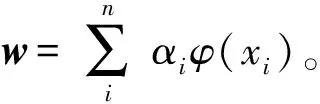

2.2 KCF跟蹤算法

利用目標周圍區域的循環矩陣,通過密集采樣學習濾波器對目標進行跟蹤定位。利用嶺回歸訓練目標檢測器,利用傅里葉空間中圓矩陣的對角化性質,將矩陣運算成功地轉化為矢量的Hadamad乘積,即元素的點積,大大減少了運算量,提高了運算速度,使算法滿足實時性需求。利用核函數將線性空間的嶺回歸映射為非線性空間。在非線性空間中,通過求解對偶問題和一些常見約束,使用循環矩陣傅里葉空間的對角化來簡化計算,將多通道數據融合到該算法。

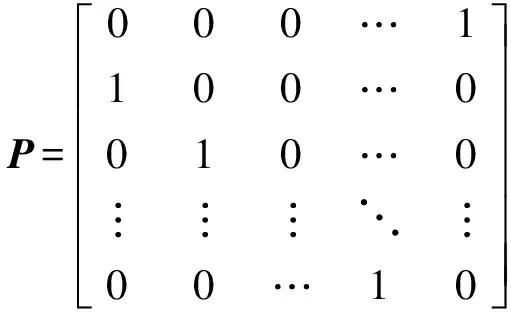

2.2.1 采集樣本

KCF跟蹤算法利用循環矩陣的思想生成大量正負樣本,通過目標區域采樣窗口的循環移位來訓練分類器和檢測目標。設x=[x1,x2,…,xn]T是基準參考樣本(n為樣本數量),x通過置換矩陣P對x進行循環移位,通過一次移位獲得的樣本是Px=[xn,x1,x2,…,xn-1]T,因此n個樣本的樣本集可以通過n次移位得到,樣本集合{Pux|u=0,1,…,n-1},其中置換矩陣

(3)

按照循環矩陣的定義將n次移位的所有樣本組合成循環矩陣X,如(4)式:

(4)

由于循環矩陣可以使用離散的傅里葉矩陣在傅里葉空間中對角化,循環矩陣X可以簡化為

X=Fdiag()FH

(5)

式中:F為離散傅里葉變換矩陣;為向量x=[x1,x2,…,xn]T的離散傅里葉變換,即循環矩陣X第1行的離散傅里葉變換;H表示矩陣共軛轉置。KCF跟蹤算法利用了循環矩陣通過傅里葉對角化來避免求矩陣的逆,從而大大降低了計算復雜度。

2.2.2 分類器

(6)

(6)式求導并令導數為0,可求得

a=(φ(X)φT(X)+λI)-1y

(7)

式中:φ(X)φT(X)為核矩陣,用K表示,則有K=φ(X)φT(X),因此核矩陣K中的各個元素表示為

Kij=κ(xi,xj)

(8)

這里以Kij為元素的核矩陣K是循環矩陣。于是有K=C(kxx),其中kxx為K矩陣的第1行,將K矩陣傅氏對角化為K=Fdiag(xx)FH,化簡(6)式,得到

(9)

2.2.3 目標檢測

分類器訓練完成后,在下一幀圖像的預測框內采集基準待測樣本Z,由基準樣本經循環移位產生大量待測樣本,樣本集{zj=pjz|j=0,1,…,n-1},然后計算待測樣本的響應值,最大響應值的樣本對應位置為目標位置。計算響應的公式為

(10)

式中:κ(z,xi)為核函數。令KZ為訓練樣本與待測樣本之間核空間的核矩陣,由循環卷積性質可知KZ是循環矩陣,記作

KZ=C(kxz)

(11)

2.3 改進的KCF跟蹤算法

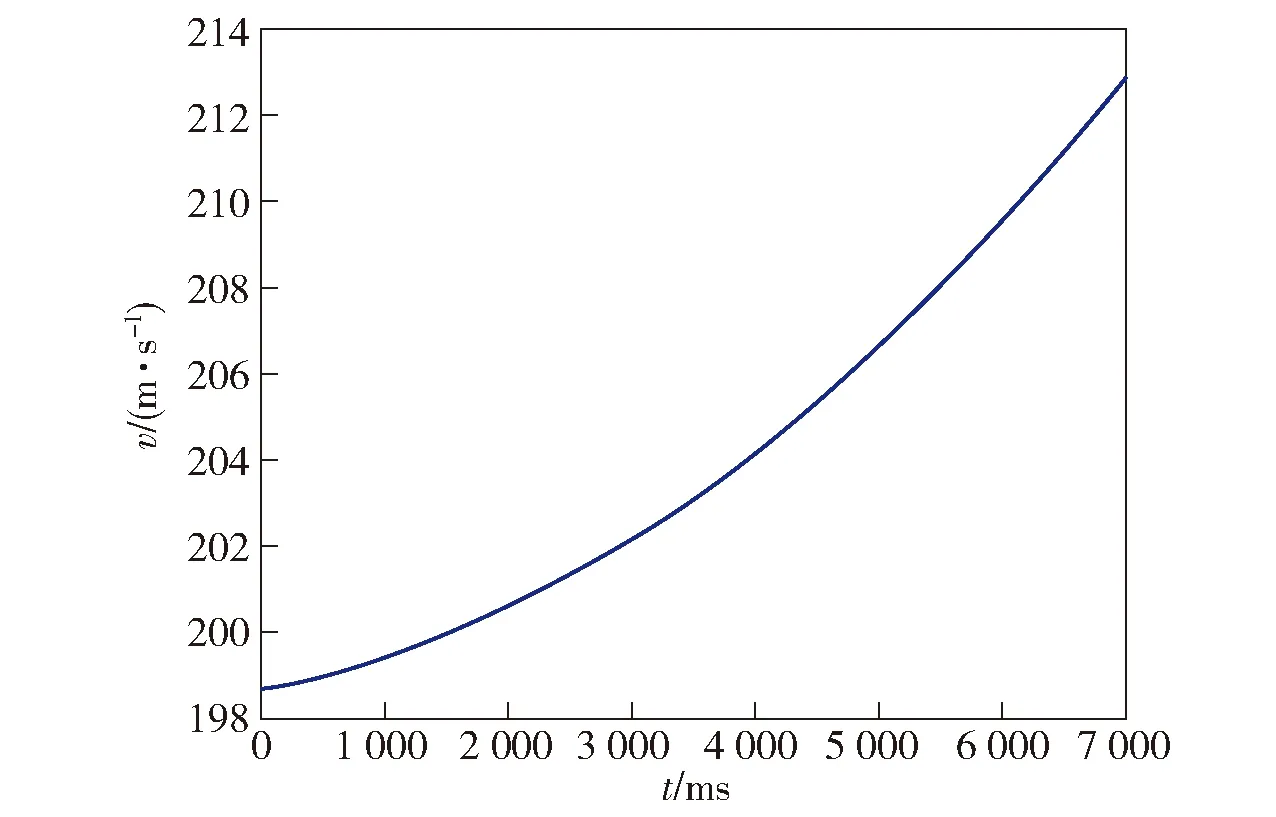

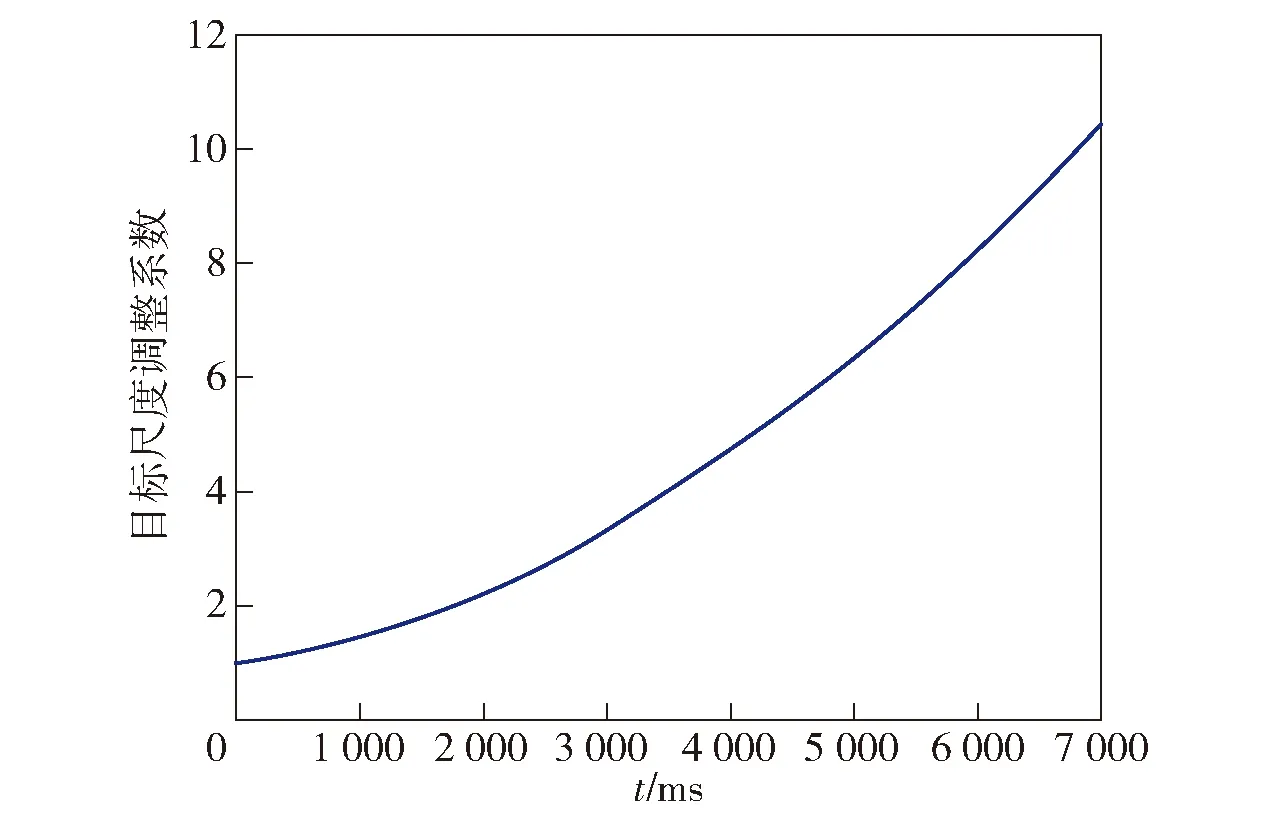

根據彈道仿真數據得到彈體速度與時間信息,將數據進行函數擬合,由于初始檢測框為32×32,命中目標時目標大小為320×240,將速度歸一化為1~10作為尺度系數,最終得到一個目標尺度調整系數與時間的對應關系函數,圖11所示為彈道速度~時間曲線,圖12所示為目標框大小與時間曲線。

圖11 彈道速度- 時間曲線Fig.11 v-t curve

圖12 目標尺度調整系數曲線Fig.12 Scale curve of RoiSize-t

根據擬合曲線,將目標框尺度比例系數定義為

scale_factor=1.404 7×10-7t2+3.67×10-4t+1

(12)

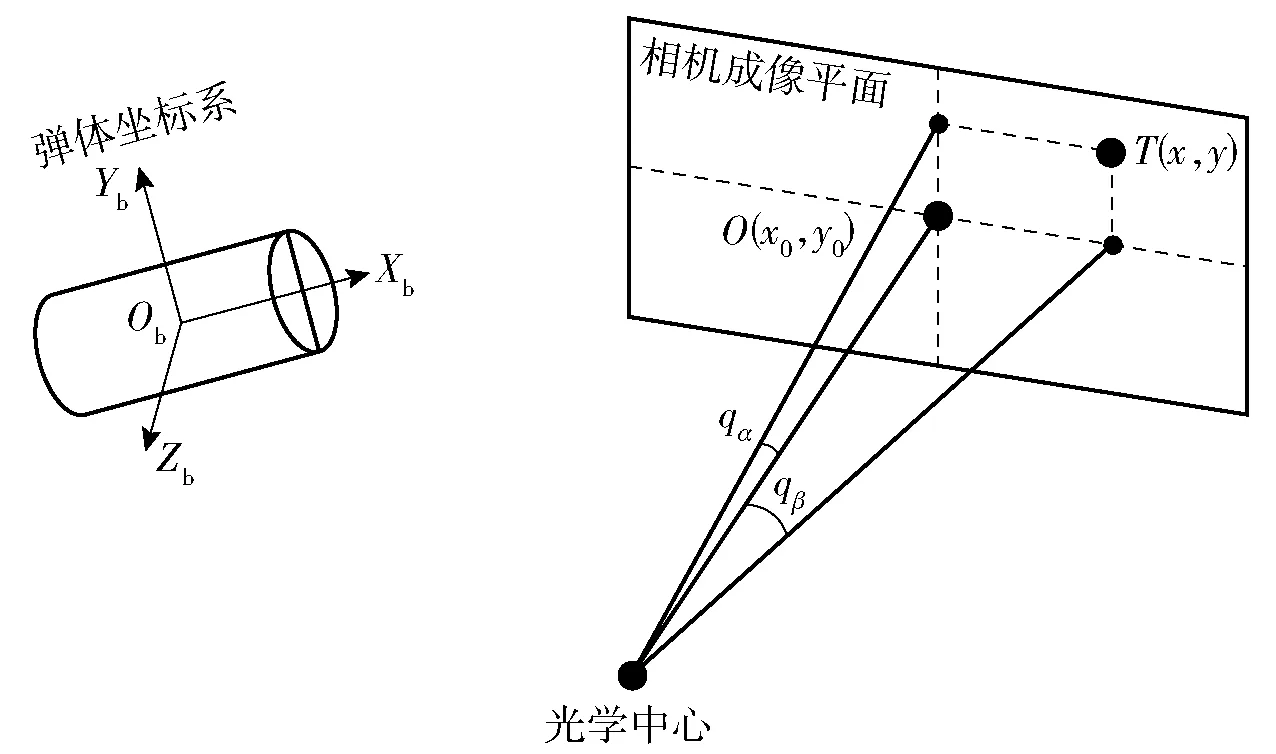

2.4 體視線角計算

圖13 相機成像平面Fig.13 Camera image plane

體視線角表示目標與彈體之間的角度幾何關系,如圖13所示。圖13中,qβ表示導彈與目標連線與彈體坐標系ObXbYb平面之間的夾角,qα表示導彈與目標連線在彈體坐標系ObXbYb平面上的投影與ObXb軸之間的夾角[32],T(x、y)表示目標在像平面的像素坐標,x、y分別為坐標像素值,O(x0、y0)表示物理坐標系原點在圖像坐標系的坐標,x0、y0分別為圖像坐標系的坐標值,對于640×480分辨率的相機,x0=320,y0=240。

體視線角可以由目標在像平面的成像像素來獲得(見圖10),彈體坐標系與相機成像坐標系的3個坐標軸對應相互平行。通過張正友標定法[33]求得相機內參矩陣K:

(13)

式中:f為相機焦距;dx、dy表示像平面上每個像素在x軸、y軸的物理尺寸。

(14)

3 結合S-YOLOv3的目標跟蹤模型

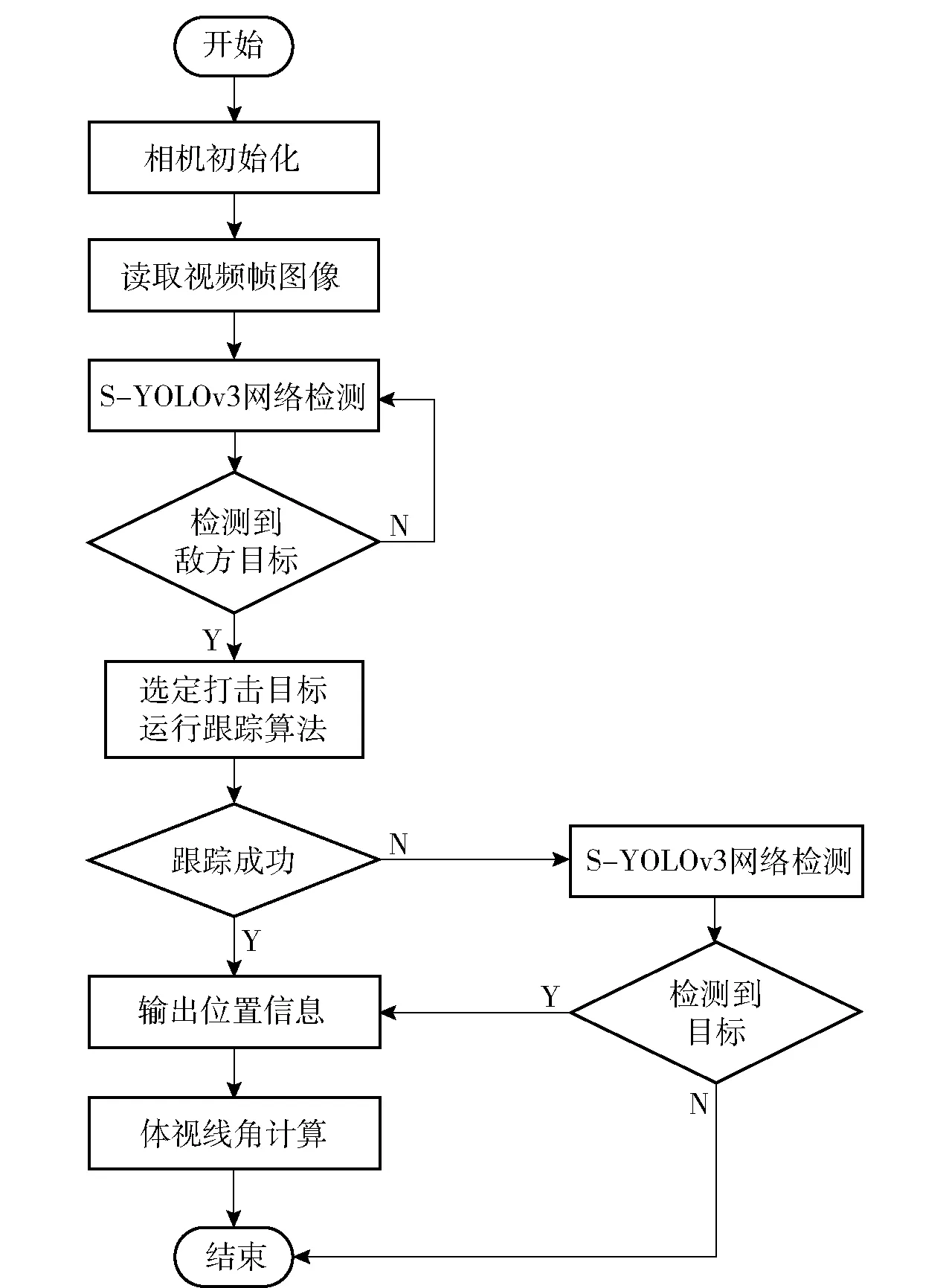

檢測跟蹤模型如圖14所示,對目標探測算法進行仿真。由于目標被遮擋或大幅度位移會導致KCF跟蹤算法中目標的傅里葉響應值突變,可以用峰值檢測的方法判別。首先將檢測到目標的峰值保存起來,正常檢測到目標的峰值為0.74~1.00,如果后續峰值小于第1次峰值的一半,則認為丟失,重新返回檢測。

圖14 結合目標檢測的跟蹤算法流程Fig.14 General theoretical framework

將識別出來的區域傳入改進KCF跟蹤算法,主要通過彈道模型擬合的二次曲線作為跟蹤尺度系數,加入高斯閾值與檢測目標進行判斷,小于閾值后重新檢測,以確保目標丟失在視野內可重新跟蹤。

4 實驗效果與數據分析

4.1 實驗評價指標

對訓練好的目標檢測模型進行測試,使用以對象為基準的評估指標進行效果評估,即精度P、召回率R、精確值和召回率的調和均值F1、均值平均精度mAP、每秒處理幀數FPS。

(15)

(16)

(17)

(18)

式中:TP用于表述預測與真實參數相同,預測參數就是相應的正(在該情形中相應的真實參數即正樣本);FP表示預測和真實有區別,預測即正(在該情形中相應的真實參數即負);FN表示預測與實際有區別,預測即負(在該情形中相應的真實參數即正樣本)。

本文目標跟蹤算法使用中心位置誤差、精確度、重疊率3個指標評估。中心位置誤差的計算公式如下:

(19)

式中:Kt表示真實目標位置,坐標為(xt,yt);Kr表示輸出目標位置,坐標為(xr,yr)。

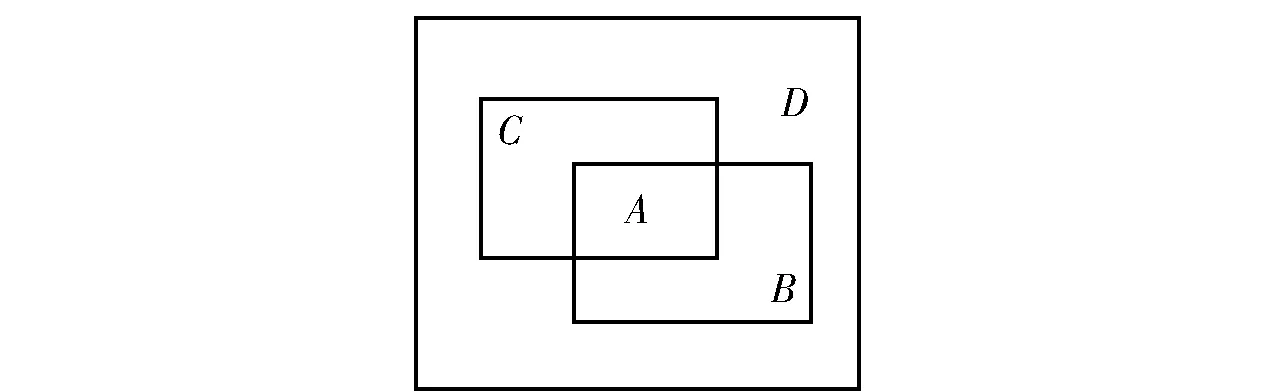

圖15 重合度計算圖Fig.15 Overlap degree calculation

圖15所示為重合度計算圖,其中D表示整副圖像,矩形B表示真實目標區域,矩形C表示算法結果區域,A為B和C的重合區域。

由此重合度定義為

(20)

準確度定義為

(21)

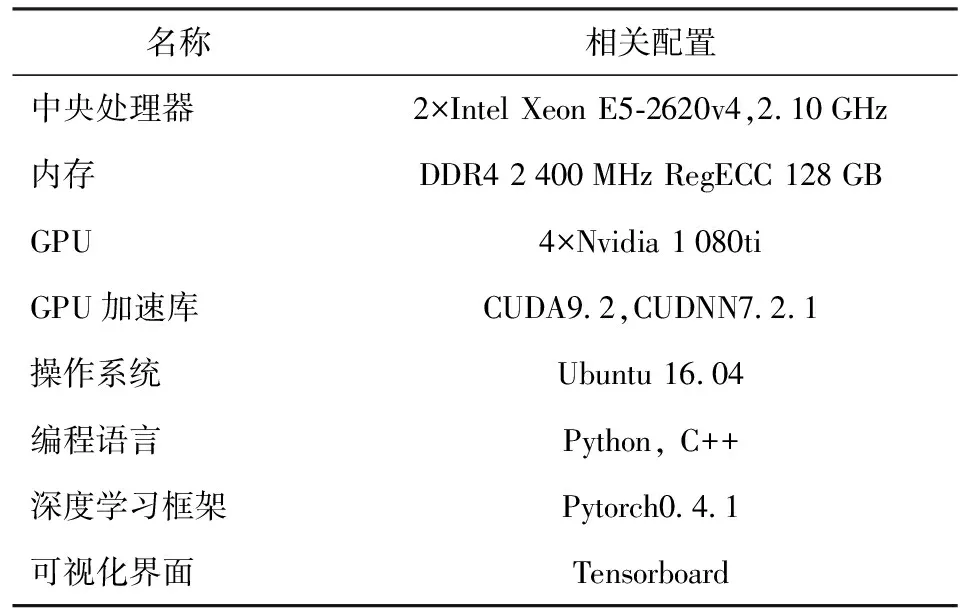

4.2 實驗環境及參數配置

基于目標檢測及跟蹤實驗軟硬件配置(見表1),設計仿真實驗平臺如圖16所示。由于實驗條件有限,通過視景生成器模擬山地打擊情景,使用轉臺模擬彈體的旋轉運動,轉臺一端的攝像頭通過計算機將后端顯示器的視景實時處理并輸出到前端顯示器。

表1 軟硬件配置Tab.1 Hardware and software configuration

圖16 仿真實驗平臺Fig.16 Simulation experimental platform

4.3 目標檢測實驗測試

為評估本文改進YOLOv3算法的性能,對YOLOv3與S-YOLOv3目標檢測模型分別在數據集上進行訓練。訓練集和驗證集按照7∶3的比例進行隨機分配。在網絡訓練過程中,采用Adam方法進行訓練,初始學習率設置為0.000 1,衰減系數設置為0.005,batchsize設置為16,預設錨點框數為9。

為驗證改進算法的有效性,使用視景生成器單獨生成1 000張數據作為測試集進行測試。

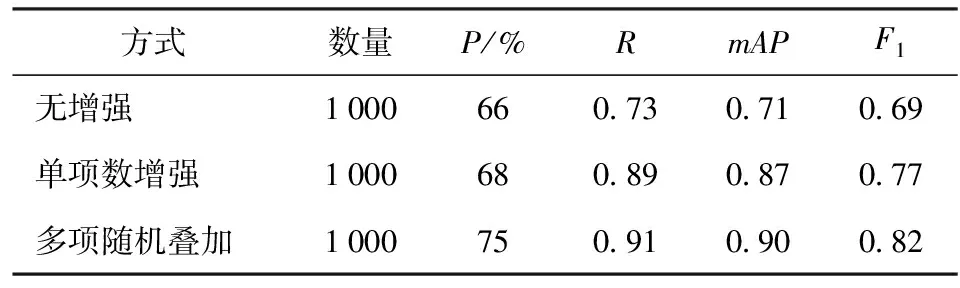

通過使用數據增強,網絡訓練過程中的空間維度同步提升,將分布的數據密度增大,從原始數據集中提取出更多的信息,使得增強后的數據集代表更為全面的數據集合,進而縮小訓練集和驗證集之間的差距。為驗證擴充的數據集對目標識別和網絡泛化能力有著顯著的提升,表2顯示了對比實驗結果,可見通過數據增強的方式能夠得到更好的訓練效果,mAP值提升了26.7%。

表2 數據增強對比實驗效果Tab.2 Comparative test effect of data enhancement

為驗證本文對錨框計算改進的效果,進行對比實驗,改進前預定義的錨框集合為((10,13)、(16,30)、(33,23));((30,61)、(62,45)、(59,119));((116,90)、(156,198)(373,326)),改進后錨框集合為((4,5)、(5,11)、(9,8));((8,15)、(17,9)、(14,15));((11,22)、(25,12)、(21,21)),表3顯示了對比實驗結果,可見通過改進錨框計算的方式對檢測精度有了進一步提升,mAP值提升4.65%。

表3 錨框計算改進前后對比實驗效果Tab.3 Comparative test effect of Anchors

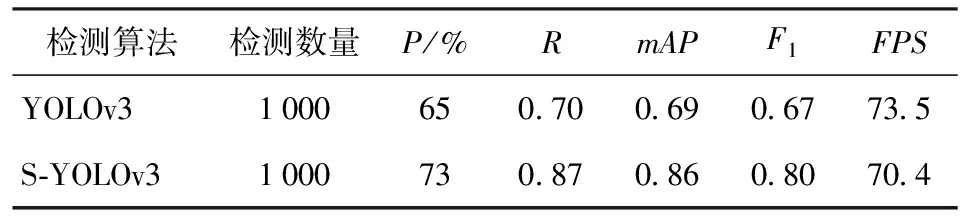

為更好地驗證本文算法的有效性,使用轉臺上的攝像頭(分辨率1 920×1 080)在仿真平臺上對屏幕放映的圖像進行識別,以更加逼真地模擬旋轉彈彈載圖像,使用屏幕顯示出來的圖像相比原圖會產生不同光照、色差等噪聲因素,加上相機硬件產生的噪聲,可以更好地驗證算法魯棒性。實驗共檢測1 000張彈載圖像數據,結果如表4所示。

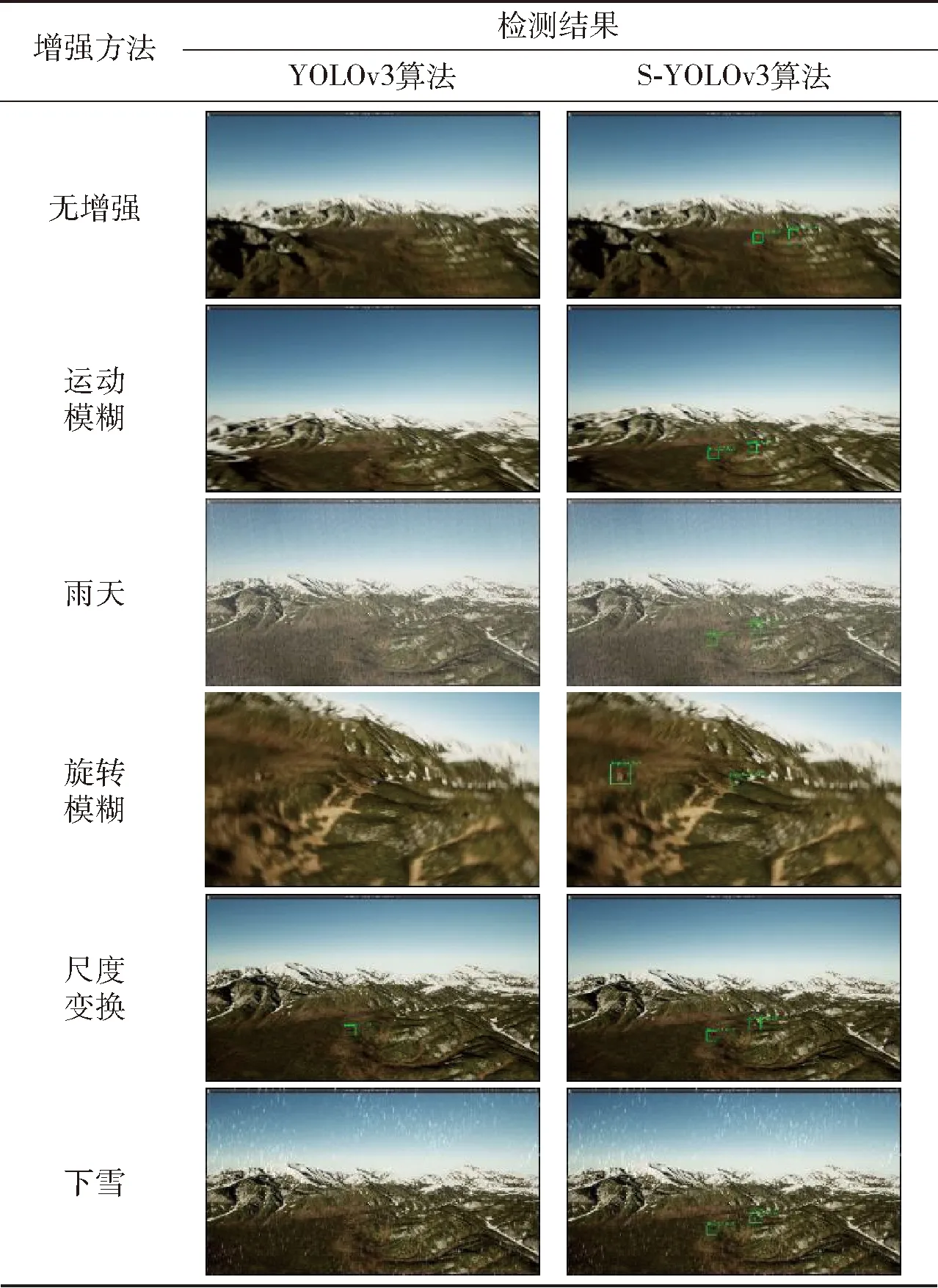

檢測效果如表5所示。從表5中可以看出:在對數據未進行增強前,改進網絡對小目標檢測具有很好的結果;對數據進行增強后,在惡劣天氣和動態模糊中,改進網絡都具有很好的檢測效果,可見本文算法在復雜環境下也能夠準確檢測到目標,也為后續的目標跟蹤提供了關鍵的初始幀信息。

表4 YOLOv3與S-YOLOv3算法目標檢測效果對比Tab.4 Detected results of YOLOv3 and S-YOLOv3

表5 檢測對比結果

4.4 目標檢測跟蹤系統測試

實驗過程模擬的是旋轉彈從末制導段開啟目標探測系統。由于高速的姿態運動以及復雜的戰場環境,在彈載圖像檢測和跟蹤目標過程中會出現識別困難以及丟失的情況,通過本文設計的目標探測算法,在成像質量受到嚴重影響情況下目標仍可被檢測出來,在丟失目標情況下跟蹤算法能夠及時啟動檢測機制,提供目標信息,實現再次跟蹤。最后完成制導信息的指令輸出,對目標實施精確地打擊。

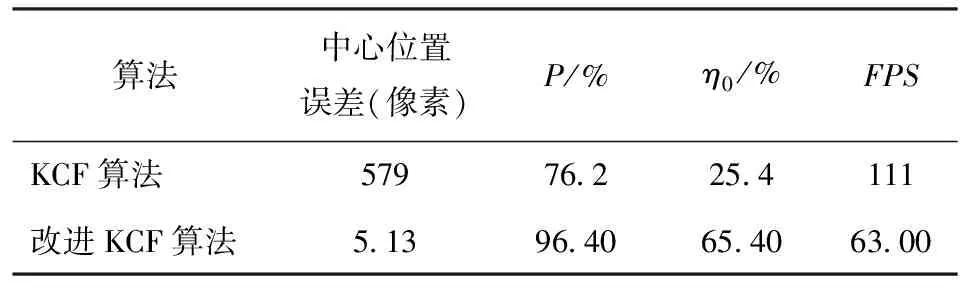

目標檢測與跟蹤畫面如圖17所示,本文實驗為目標檢測與跟蹤定位環節,假設解旋環節已經完成,即視場中旋轉圖像已解旋為正立。圖17(a)、圖17(b)分別為KCF算法和改進KCF跟蹤算法的效果對比。由圖17可見:在末制導段指定目標后開始跟蹤,二者都能很好地跟蹤目標(見圖17(a)),目標都能被黃色框很好地跟蹤到;隨著跟蹤時間的延長,KCF算法的跟蹤目標框逐漸與目標出現了漂移,KCF算法沒有像改進算法那樣對目標尺度進行有效更新,導致跟蹤性能下降,也有效說明改進后算法對目標跟蹤尺度有了很好的估計;在目標丟失情況下(見圖17(b)),改進后KCF算法由于結合了S-YOLOv3檢測算法,能夠及時地再次檢測到目標,為跟蹤算法再次提供了初始幀信息,為后續的跟蹤提供了良好基礎。

圖17 跟蹤圖像序列Fig.17 Target image sequence

從評價指標上看(見表6),跟蹤性能與KCF算法相比,中心位置誤差和重疊率有了很大提高,識別準確度也得到了提升,處理速度為63幀/s,雖然不如KCF算法,但已經滿足實時性要求,對工程實踐的應用有一定指導意義。

表6 目標跟蹤性能對比Tab.6 Performance comparison of algorithms

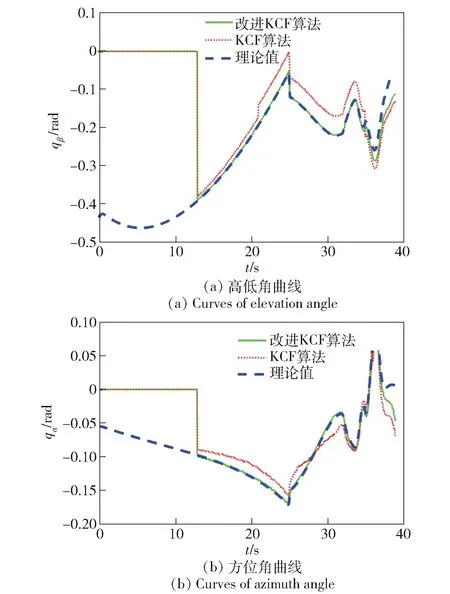

為進一步驗證跟蹤算法的性能,對跟蹤的體視線角進行提取,如圖18所示,在13 s處開始跟蹤。由圖18可以看出:與原算法相比,改進KCF算法高低角曲線與理論曲線誤差更小,最大誤差為0.004 58 rad,約0.268°;方位角最大誤差為0.027 57 rad,約1.58°,其中有標定誤差和相機與屏幕平行度不重合的影響。在像平面中,1個像素對應的體視線角誤差大約為1.5°,與曲線最大誤差接近,進一步驗證了本文提出的改進后跟蹤算算法的有效性。

圖18 體視線角曲線Fig.18 Body line-of-sight angle curves

5 結論

本文對旋轉彈彈載圖像中小目標識別跟蹤算法進行研究,通過模擬山地打擊場景,針對彈載圖像的特點對圖像數據進行模擬制作,對現階段較成熟的YOLOv3檢測器模型進行了改進,結合處理速度高的KCF算法,實現了復雜環境下的小目標精確定位。得到主要結論如下:

1) S-YOLOv3檢測算法配合改進KCF跟蹤算法實現了更加魯棒的目標定位,算法加入了丟失判別機制,時刻更新尺度信息,檢測精度和跟蹤效果有了很大的提升,處理速度達到63幀/s,滿足了實時性要求。

2) 通過數據增強擴充的方式,制作了不同天氣、光照、運動及旋轉模糊等復雜環境的彈載圖像數據,增強了算法對復雜環境背景下目標的檢測能力。

3) 檢測網絡添加了多尺度分支結構,使用k-means均值聚類算法重新計算錨框,跟蹤算法利用彈道的速度—時間信息更新目標跟蹤框尺度,使得算法對小目標尺度更加敏感。

總之,本文將YOLOv3檢測算法成功應用在旋轉彈的目標檢測和跟蹤領域,可見深度學習算法在彈載圖像目標檢測中的可行性,對智能彈藥的發展具有一定推進作用。