虛擬引擎制作在傳統演播室的研究和實踐

劉 美

(浙江廣播電視集團,浙江 杭州 310000)

0 引 言

浙江廣播電視集團廣播電視制作中心的400 m2演播廳完成了一場使用國際上較為先進的Zero Density Reality 虛擬引擎實時渲染技術和增強現實(Augmented Reality,AR)技術的電視節目制作。相比于傳統的切換臺摳像,虛擬引擎制作能夠呈現更宏大的視角,給視頻制作人員更大的自由度,對于演播室的應用也更具有靈活性。為此,本文就虛擬引擎制作的特點和原理展開論述。

1 虛擬引擎制作的優點

虛擬演播室技術能夠完成節目場景的變換,并且不會受到次數的限制,從而實現節目播出時環境變換的無縫銜接。與以往制作節目的演播室相比,虛擬演播室技術無需使用特定的道具或者節目場景,演播室可以隨著節目內容的變化改變環境。一方面,這可以為節目設計者在前期的設計環節創造更多的可能性;另一方面,還可以有效減少成本的投入。

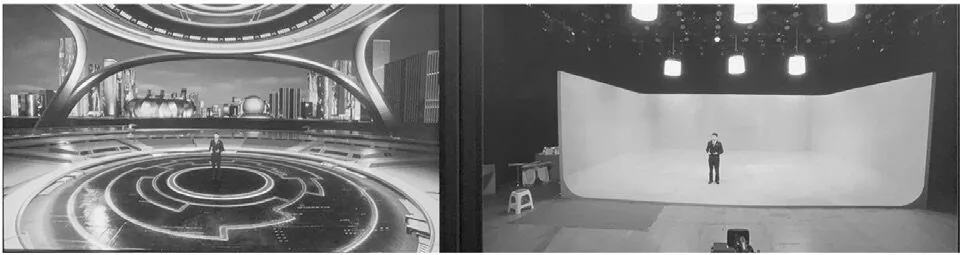

相比于傳統的切換臺摳像方式,虛擬引擎制作具有以下優點。第一,打破空間環境的限制,只需要不太大的空間就能創造出幾倍于場地面積的視覺效果,如圖1 所示。第二,縮短舞美置景的周期,場景素材由專門的制作人員在計算機內完成,現場只需要綠幕空間。第三,虛擬引擎自帶的高質感畫面渲染能力為創作者提供了更絢麗、更現代的舞臺藝術選擇。第四,配合AR 技術,可大大增強節目的交互感、體驗性。

圖1 本次虛擬制作的效果對比

2 虛擬引擎制作的基本原理

跟蹤技術及方式是虛擬制作不可或缺的重要組成部分,也是實現整個虛擬場景的基礎。該技術在現實空間內為虛擬場景提供準確的物理位置,為虛擬物體提供準確的畸變模式以及變換方式,從而實現虛擬場景與現實環境的無縫結合。攝像機將拍攝物體的跟蹤數據實時傳送給渲染引擎,通過計算得出拍攝物體與虛擬物體之間的距離和相對位置關系,使得拍攝實景與渲染生成的虛擬場景結合,最后合成為符合同一空間透視關系的畫面[1]。

攝像機跟蹤系統中,需要獲取的攝像機運動參數包括變焦、聚焦、光圈、搖移、俯仰以及空間位置參數(X,Y,Z)。根據實現原理,可將跟蹤方式分為基于硬件和基于計算機視覺的方式。前者常用的是機械跟蹤(傳感器跟蹤),后者常用的是網格識別方式。還可以將兩者結合,實現更精準的跟蹤[2]。

本次制作使用的是Zero Density 公司的Reality Engine 產品。這是一款基于虛擬引擎打造的虛擬工作室和增強現實解決方案。Zero Density 的技術創新核心是其領先的基于節點的實時合成工具,以及其專有的鍵控技術——Reality Keyer,其所有計算都在GPU 上執行。與一般引擎不同的是,Reality是一種物理的引擎,其動畫效果通過編程而不是制作人員通過手動關鍵幀實現[3]。Zero Density 的所有代碼都能在虛擬引擎中運行,并且能夠利用著色器編譯器、C++語言以及虛擬引擎的跨平臺功能。

在鍵控方面,Reality Keyer 使用一塊空白板,將其與系統的追蹤功能相結合。其生成的網格體可以用來表示攝影棚中的任意環形綠幕。三維圖像是由程序生成的,支持更為干凈的鍵控操作以及動態垃圾遮罩,即便是在掃描平移和傾斜時,也能生成干凈而真實的鍵控最終圖像。該系統通過在空白板上進行投影映射,協助鍵控操作,因此比普通的色度鍵控器更為先進,如圖2 所示。

圖2 Zero Density 摳像效果展示

傳統上,圖形化軟件包只提供填充信號和鍵信號,并假設圖像切換器中存在基本合成畫面。Zero Density 提供了一種更為強大的系統,能夠識別伽馬信號,并且理解線性工作流和查找表。它能將通常為離線方案保留的控制功能添加到實時環境中。

Zero Density 可以從大多數主要解決方案中提取跟蹤數據。此外,它還可以提取程序提供的鏡頭數據。如果沒有鏡頭數據可用,軟件會從最后一次校準的變焦和聚焦數據入手,估算出鏡頭曲率和其他屬性如視野等。

綠幕中拍攝的前景畫面直接進入虛擬引擎,與提前制作好的虛擬素材一起直接進入最終剪輯階段,無需傳統的離線渲染,也無需后期制作的視覺效果。軟件不僅可以輸出最終合成畫面,還可以輸出各種關鍵圖層,以便在后期階段完整地調整并重新剪輯,最終合成畫面。這次實踐也使用了AR技術。在電視內容創作的語境下,AR 指的是在攝像機畫面上疊加一層虛擬空間,其中的虛擬物體多以元素的形態出現[4]。當AR 與虛擬演播技術結合,便形成了混合現實(Mixed Reality,MR),實景不再固定于做后景,而虛景也不再固定于做前景。

3 本次虛擬引擎制作的視頻系統設計

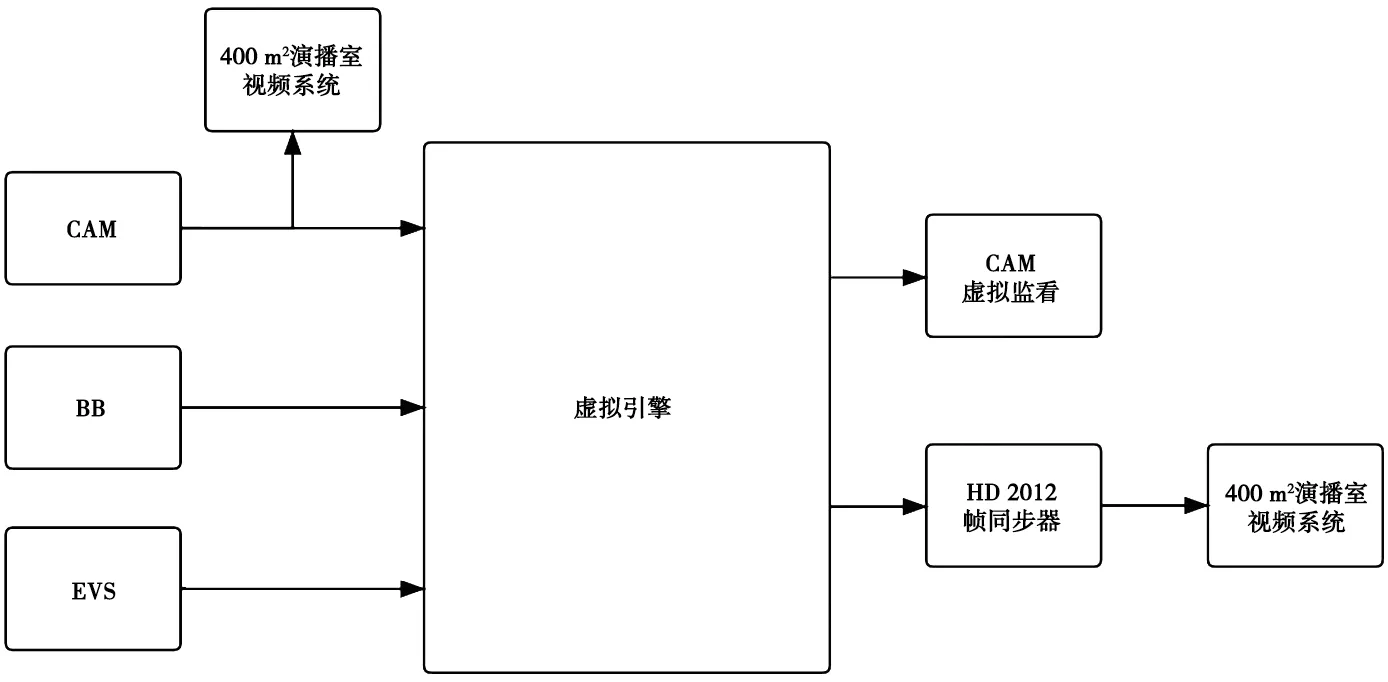

本次制作共有5 個攝制機位,CAM 1、CAM 3、CAM 5 為固定機位,CAM 2 為ROSS 機器人,CAM 4為搖臂。其中,CAM 1、CAM 2、CAM 3、CAM 4連接虛擬引擎,即由攝像機機頭輸出本機拍攝的綠幕畫面信號送至虛擬引擎。經過虛擬引擎渲染后的信號(EXT 1、EXT 2、EXT 3、EXT 4)經過HD2012幀同步器進入系統,分別送往切換臺和矩陣。切換臺負責完成PGM 和PVW 信號的選切,矩陣負責完成錄制等各個節點的信號調度。4 臺虛擬引擎每一臺都接入系統統一的BB 同步信號,虛擬引擎信號流程如圖3 所示。

圖3 虛擬引擎信號流程

每一臺攝像機共有三路監看信號,一路是本機綠幕畫面信號,一路是PGM 信號,一路是經過虛擬引擎渲染的本機合成后信號。其中,經過虛擬引擎渲染的合成信號單獨使用一臺監視器。這樣的設置有利于攝像人員進行渲染前后畫面的比對,更加方便構圖和藝術化創作。

由于這種制作方式還比較新穎,現場除了PGM返看外,還特地為主持人和嘉賓在每一個機位前方都設置了一個單機位返看電視機,這臺電視機接入的信號是經過虛擬引擎渲染的本機位信號,如圖4 所示。

圖4 現場單機位返看

錄制方面,主要錄制手段為7 臺藍光機。其中1臺采集PGM 主路信號,1 臺采集PGM 備路信號,4臺采集經過虛擬引擎渲染后的單機位合成信號,1 臺采集沒有經過虛擬引擎渲染的綠幕信號。備份錄制手段為兩臺EVS,分別采集主路、備路的PGM 信號。

現場主持人和嘉賓錄制完成后,還有一些AR畫面需要制作。此時先用藍光機上載素材到EVS,再在EVS 里進行片段的編輯、播表的制作,最后將EVS 輸出信號接入虛擬引擎,完成畫面合成。

本次實踐中,還對系統的TALLY 指示做了一定更改。在常規制作中,導播在切換臺PGM 和PVW 母線選切CAM 信號時,相應的攝像機機頭指示燈會顯示紅色或綠色。切換臺的交叉點信息(包括PGM、PVW)經過一個GPI/O 控制設備傳送給攝像機控制單元(CCU)。在本次制作中,導播實際選切信號為經過虛擬引擎渲染的信號,即EXT 1、EXT 2、EXT 3、EXT 4,但為了給主持人和現場嘉賓指示,需要相應的機頭CAM 1、CAM 2、CAM 3、CAM 4 亮燈。所以在GPI 設置中,應該將EXT 1、EXT 2、EXT 3、EXT 4 的信號與CCU 1、CCU 2、CCU 3、CCU 4 做一一綁定。

經過虛擬引擎制作后,產生了比較明顯的聲畫不同步現象。由于攝像機信號經過虛擬引擎處理,產生了比較大的延時,所以出現了視頻滯后音頻的問題。要解決這一問題,只需將聲音做一定的延時處理。調音臺將現場主持人及嘉賓聲音做456 ms的延時處理后,經測定,聲畫不同步現象消除。

另外一個值得注意的問題是,為了保證虛擬引擎的摳像效果,對綠幕空間也有一定要求。摳像相體要能提供足夠大小的純色背景,最大限度地不產生色光反射,從而使攝像機采集的前景信號能夠輕松地從純色背景中剝離出來[5]。

4 結 語

虛擬引擎制作已成為一種趨勢,它有著得天獨厚的優點,對于傳統演播室的再利用也有很大價值。虛擬引擎制作給觀眾帶來了視覺奇觀,也讓電視從業者對審美有了重新的思考與升級。相信在未來會有更多的節目應用這一技術,而伴隨而來的必將是更加優質的廣播電視作品。