基于DeepLab v3+模型的高分辨率影像養殖用海信息提取

何顯錦 蒙方鑫

摘要 及時、精確的養殖用海信息探測對于海洋利用開發與管理至關重要,而傳統機器學習因不能自動提取原始信息特征,常導致信息提取精度不高、邊界不完整等問題。鑒于此,提出采用DeepLab v3+模型進行養殖用海信息提取,重點關注該模型在高分辨率復雜影像中養殖用海信息的提取效果。結果表明,無論是單一時相影像還是由多時相構成的拼接影像,DeepLab v3+模型對養殖用海信息提取的精度均達到了97%以上,明顯優于基于傳統機器學習方法分類精度;在養殖網箱、排筏等非均質地物提取細節上,DeepLab v3+模型能夠完整提取地物,邊界也較為規則,可為用海監測與管理提供科學技術手段。

關鍵詞 DeepLabv3+模型;信息提取;養殖用海;欽州灣

中圖分類號 S 951? 文獻標識碼 A

文章編號 0517-6611(2022)12-0208-06

doi:10.3969/j.issn.0517-6611.2022.12.053

開放科學(資源服務)標識碼(OSID):

Extraction of Aquaculture Sea from High-Resolution Remote Sensing Imagery Based on DeepLabv3+ Model

HE Xian-jin1,2,MENG Fang-xin3

(1.Key Laboratory of Environment Change and Resource Use in Beibu Gulf,Ministry of Education(Nanning Normal University),Nanning,Guangxi 530001;2.Guangxi Key Laboratory of Earth Surface Processes and Intelligent Simulation,Nanning,Guangxi 530001;3.School of Geography and Planning,Nanning Normal University,Nanning,Guangxi 530001)

Abstract Timely and accurate detection of aquaculture sea information was essential for the utilization and management of marine.However,traditional machine learning cannot automatically extract the original information features of objects,leading to low precision and incomplete boundaries of extracted objects.A method to extract aquaculture sea information was proposed by DeepLab v3+ model.The extraction effects of this model in high-resolution complex images were mainly researched.The results indicated that the accuracy of the DeepLab v3+ model for extracting marine information for aquaculture reached more than 97% for both a single-phase image and a mosaic image composed of multiple time phases.The classification accuracy was obviously better than that of the Maximum Likelihood Classification in ENVI. For the extraction of aquaculture cages and rafts,DeepLab v3+ model could completely extract these objects with regular boundaries.This research provided methodological guidance for sea monitoring and management.

Key words DeepLabv3+ model;Information extraction;Aquaculture sea;Qinzhou Bay

廣西壯族自治區北部灣經濟區是繼珠江三角經濟區、長江三角經濟區、環渤海經濟區之后的又一個具有重大發展意義的國際區域經濟合作區。隨著北部灣經濟區的快速發展,海域使用也發生了翻天覆地的變化,在獲取經濟效益的同時,也將對周圍的生態環境安全產生重要影響[1]。及時、準確發現獲取海域使用動態變化信息,不但直接影響海域管理部門對海域使用的有效執法監察和行政管理,也為海域資源的可持續利用與發展提供決策支持。然而,由于整個經濟區的海域范圍廣、面積大,人工解譯獲取信息速度慢,而傳統的機器學習方法由于不能自動提取原始特征信息,導致獲取信息精度不夠高,無法更好地為沿海開發利用提供技術支撐與服務。

近年來,隨著科技的迅速發展,深度學習在影像識別、人工智能等方面發揮著越來越重要的作用。深度學習作為機器學習中的一個新興領域,可通過逐層特征提取的方法、逐層學習輸入數據的方式,使得數據分類或預測的問題更加容易實現,并且可以從少數樣本中集中學習數據集的本質特征,還可以通過學習深層非線性的網絡結構,實現對復雜函數的逼近[2]。深度學習從大類上可以歸入神經網絡,通常由多層神經網絡構成。其中,卷積神經網絡(Convolutional Neural Network,CNN)是目前深度學習技術領域中最具有代表性的神經網絡之一,可以通過一系列方法,成功將數據量龐大的圖像識別問題不斷降維,最終使其能夠被訓練[3]。CNN能夠自動獲取特征信息,具備更強的泛化能力,相對傳統機器學習方法能夠處理更復雜的分類問題,極大地提高了分類精度[4];另一種深度學習方法全卷積神經網絡(Fully Convolutional Networks,FCN),則是通過去除CNN的全連接層,將傳統CNN中的全連接層轉化成一個個的卷積層以及添加上采樣操作恢復影像尺寸的方式,在減輕網絡復雜度的同時實現了影像的像素級分類[5-6]。但為了得到更深層次的語義信息,FCN分類方法采用池化層擴大感受野,不可避免地造成空間信息的損失[7]。基于此,眾多更先進的深度學習網絡模型應運而生,如SegNet[6]、U-Net[8]、DeepLab系列[9]。DeepLab v3因其清晰的網絡結構和利用并行空洞卷積所捕獲多尺度信息的特點,在影像信息解譯提取方面得到了廣泛應用[4]。例如,司海飛等[10]提出一種新的輕量化網絡結構MobileNetV2結構,它替代了DeepLab v3原有的特征提取器,改進的DeepLab v3網絡模型綜合性能更強,更適合對分割性能要求較高的快速分割網絡;韓玲等[11]利用DeepLab v3提取高分辨率遙感影像道路,結果顯示該模型能夠較好地提取高分辨率遙感影像中的道路邊緣特征,相比其他道路提取方法具有更高的提取精度和更加完整的道路信息,正確率可達到93%以上;何紅術等[12]提出改進的U-Net網絡語義分割方法,借鑒經典U-Net網絡的解編碼結構對網絡進行改進,改進后的U-Net網絡結構在mIoU、精準率和Kappa系數指標上均高于SegNet和經典U-Net網絡;蔡博文等[13]利用深度卷積神經網絡對影像特征進行提取,并根據其鄰域關系構建概率圖學習模型,進一步引入高階語義信息對特征進行優化,實現不透水面的精確提取。

盡管深度學習在各個領域的應用不斷深入,但是對于用海信息提取的研究較少,且提取的對象多為均質地物[14]。鑒于此,筆者利用深度學習模型,對養殖用海中的網箱、浮筏等非均質地物進行提取,闡明深度學習方法在海域信息提取應用過程,并通過對傳統機器學習方法,說明深度學習方法所具有的優勢,為高精度監測北部灣海域使用狀況提供一套科學有效的方法。

1 材料與方法

1.1 研究區概況

欽州灣位于北部灣頂部,廣西沿岸中段,東鄰欽州市欽州港區,西鄰防城港市企沙半島,北與欽州市欽南區接壤,南臨北部灣,灣口門寬約為29 km,縱深約為39 km,海灣面積約為380 km2。欽州灣是廣西的傳統大蠔養殖基地,近年來養殖區域面積不斷擴大,大蠔養殖也得到爆炸式增長[15]。欽州灣頂部為茅尾海,是以欽江、茅嶺江為主要入灣徑流的河口海濱區。東南部為三娘灣海域,有大風江淡水匯入,其特點是島嶼棋布、淺灘眾多,創造了適宜多種海洋生物生存的不同環境。由于有欽江、茅嶺江淡水匯入,因此餌料充足、魚類資源豐富,并且欽州灣年均水溫21.3 ℃,處于最適合生蠔生長的水溫(15~25 ℃)范圍內[16]。同時,灣內自然災害較少,貼合生蠔養殖要求的無臺風、無污染條件。

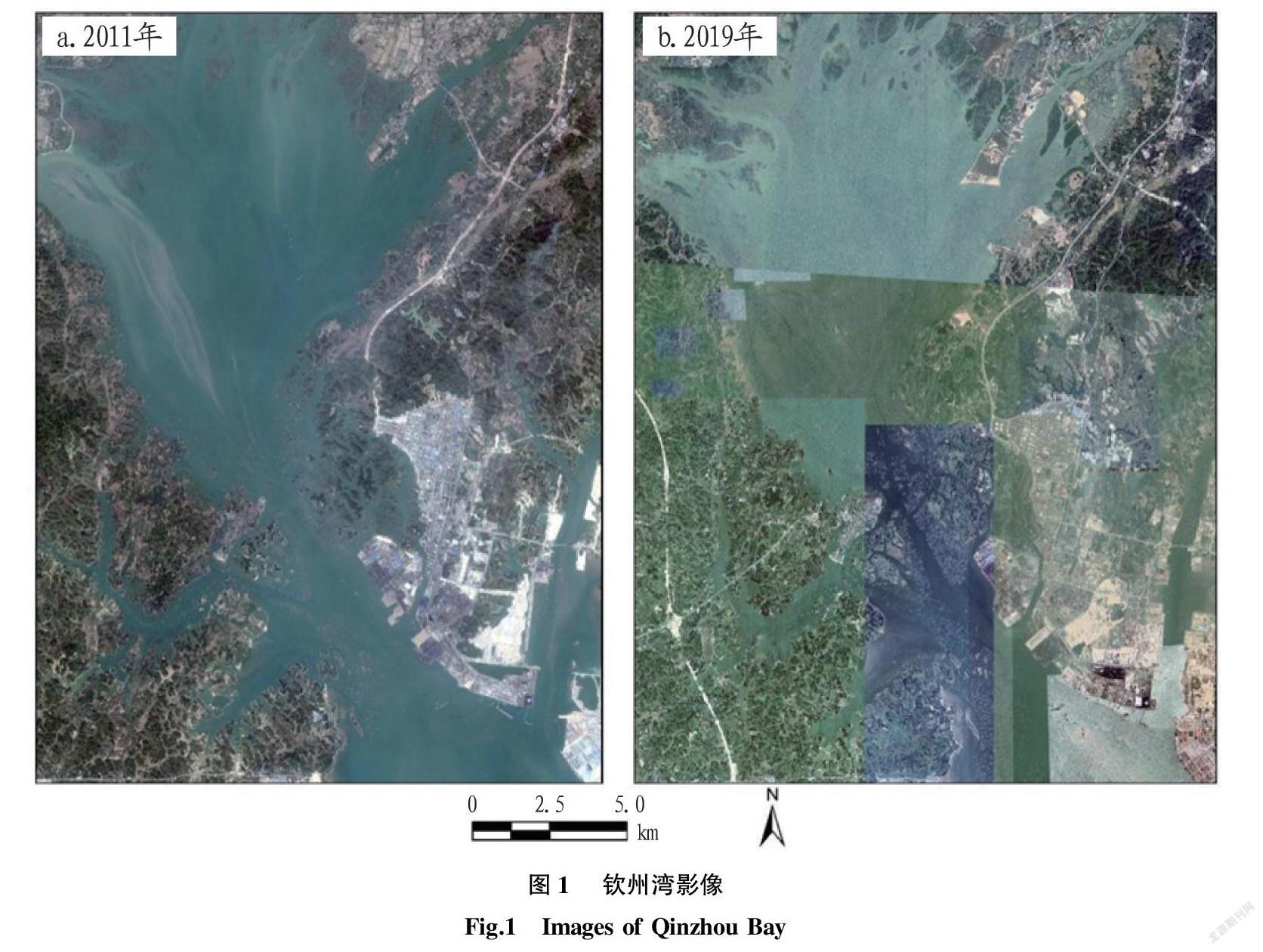

1.2 數據來源 該研究所用數據主要為影像數據,通過谷歌地球引擎平臺獲取了2期空間分辨率為0.5 m的欽州灣海域遙感影像。其中,2011年影像為同一時相影像,2019年影像則由多個時相影像拼接而成(圖1)。另外,該研究利用與影像相匹配的欽州灣海域矢量數據,裁剪出欽州灣海域,這樣可以減少其他地物對目標地物信息提取的干擾。

1.3 研究方法

1.3.1 基于DeepLab v3+模型的影像語義分割

1.3.1.1 模型介紹。

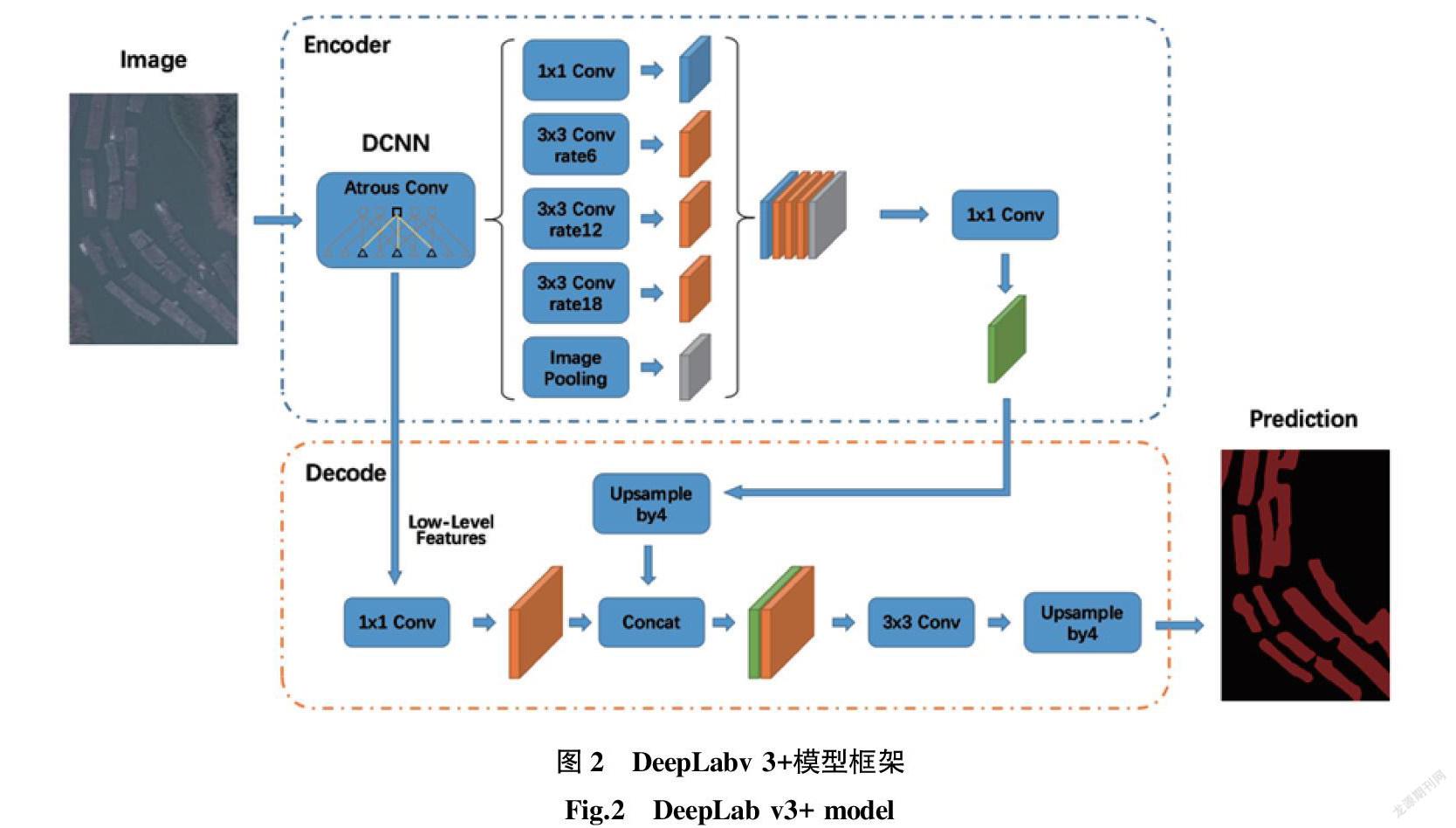

Deeplab語義分割網絡在2015年被提出,該模型是給輸入的圖像在像素級別進行語義標簽的分配[5]。目前,Deeplab經歷了v1、v2、v3以及v3+的不斷發展,其性能更是得到了不斷地完善[17]。DeepLab v3+最大的特征就是引入了空洞卷積,在不損失信息的情況下,加大了感受野,讓每個卷積輸出都包含較大范圍的信息。同時,模型為了融合多尺度信息,引入了語義分割常用的encoder-decoder形式[9]。DeepLab v3+結合了空洞空間金字塔池化(ASPP)和多比例的帶孔卷積級聯或并行來捕獲多尺度背景兩者的優點,在沒有添加任何后端處理的情況下在PASCAL VOC 2012數據集上驗證可達到89% mIoU[9]。該研究采用最新的DeepLab v3+模型進行欽州灣海域使用狀況的信息提取,模型架構如圖2所示。

首先,輸入的圖片經過主干DCNN深度卷積神經網絡之后的結果被分為2部分,一部分直接傳入Decoder,另一部分經過并行的Atrous Convolution,分別用不同rate的Atrous Convolution進行特征提取、進行合并,再進行1×1卷積壓縮特征;其次,對于解碼器Decoder部分,其輸入有2部分,一部分是DCNN的輸出,另外一部分是DCNN經過并行空洞卷積輸出后的結果,接著將編碼器的輸出結果上采樣4倍,然后與resnet中下采樣前的Conv2特征Concat一起,再進行3×3的卷積,最后上采樣4倍使其分辨率和低層級的Feature一致;最后,把獲得的特征重新映射到圖中的每一個像素點,用于每一個像素點的分類,最終輸出Prediction圖像。

1.3.1.2 樣本獲取。(1)樣本影像裁剪。由于該試驗的研究區范圍較大,影像尺寸達到了50 000像素×50 000像素以上,所以不能直接將研究區作為標注對象,需要將影像進行切片處理。為了提高標注精度,將兩景研究區影像切片為621像素×922像素大小的共4 000多張影像,并將其導出為.jpg格式。切成更小尺寸的圖像是為了在標注階段能夠更好地識別地物信息,減小錯分概率。

(2)樣本選取與標注。基于上一步切片得到的影像,還需要通過目視解譯的方法將包含目標地物的圖像選取出來,經過篩選后,最終得到了共542張圖像質量較好、具有較高識別度的圖像;隨后用Labelme工具進行語義分割樣本的標注,將圖像標注為養殖排筏與背景2類。這些樣本在訓練前需要經過鏡像翻轉、圖像旋轉等以獲取更多的訓練樣本。

1.3.1.3 數據處理。訓練前,首先將Labelme軟件標注生成的json格式文件轉換為VOC格式,方便后續進一步轉換成DeepLab v3+模型訓練所需的灰度圖;隨后利用build_voc2012_data.py文件將灰度圖轉換成tfrec7ord格式,同時添加對養殖排筏數據集的描述,最后進行數據集的訓練。

訓練時,引用預訓練模型Xception65_coco_voc_trainval,調整迭代訓練次數(training_number_of_steps)為30 000,圖片訓練尺寸(train_crop_size)為513,訓練批數(train_batch_size)為1。另外,面對訓練數據不足的情況,可以借鑒茍杰松等[15]訓練過程通過增添數據增強模塊,即通過隨步長隨機縮放、鏡像翻轉、圖像旋轉、非等比例縮放等多種方式來增加訓練數據量,以防止樣本不足帶來的過擬合,提升模型泛化能力和魯棒性。訓練結束后,導出生成.dp格式預測模型文件。

預測時,直接調用.pb格式模型文件對圖片進預測。考慮設備限制與數據處理效率,并不能將整幅影像一次性導入進行預測。需將50 000像素×50 000像素的影像切割為500像素×500像素的共10 000張小尺寸圖像,再將小尺寸圖像放入預測模型中循環遍歷,生成的預測圖保存在列表中,最后再將預測好的圖像進行拼接,最終生成一幅與原圖尺寸一致的圖像。

1.3.2 基于最大似然法的養殖用海識別

1.3.2.1 算法選取。

在ENVI軟件中監督分類常用的方法有最大似然法(Maximum Likelihood Classification,MLC)、最小距離法、馬氏距離法、平行六面體法、神經網絡法以及支持向量機法等[18-19]。在影像信息提取研究中,ENVI監督分類利用最大似然法能夠實現較高的信息提取精度,應用較為廣泛[20]。該分類算法是求出每一個像元對于各類別的歸屬概率,把該像元劃分到歸屬概率最大的類別中去。它的判別規則是假設某待分類像元X滿足如下公式:

D=ln(αi)-[0.5 ln(|Covi|)-[0.5(X-Mi)T(Covi-1)(X-Mi)](1)

式中,D、i、X分別為加權距離、某一特征類型和像元的測量矢量;Mi、Covi、ai分別為類別i的樣本均值、協方差矩陣和待分像元屬于類別i的概率。

1.3.2.2 ROI的選取與分離度指標的關系。

根據地物在影像上的分布情況,在ENVI中選擇繪制感興趣區域(region of interest,簡稱ROI),并將地物分為2類,即養殖魚、蠔等排筏與背景。ROI選擇完畢之后還要對其進行分離精度評價,即在ENVI中對每個興趣區計算Transformed距離和Jef-friesMatusita距離,分離度閾值是0~2。在該試驗中,依據可分離值的大小來判斷選取ROI樣本的精度情況。當分離值大于1.9,說明2類地物樣本之間可以很好地被區分開;當分離值小于1.8時說明2類地物樣本之間無法很好地區別開,應當修改原樣本并重新選擇,當可分離值小于1時,說明2類樣本幾乎無法區分開,應該考慮將2類地物視為同種類型的地物并將其合并。該試驗中,將欽州灣2011與2019年2期影像進行養殖用海面積的分類,得到2011年養殖用海與背景的分離度為1.923,具有比較好的分離性;2019年的分離度僅為1.806,達不到很好的分離效果。由此可知,利用最大似然法對影像分類時,拼接影像獲取的分離度較非拼接影像更低。

1.3.3 精度評價方法。

影像分類精度評價方法主要包括整體精度評價和制圖精度評價。整體分類精度評價是對分類精度高低的檢驗,常用的檢驗方法有2種:一是在影像上隨機選取一定比例的驗證樣本與分類結果進行對比;二是將分類結果與實際養殖用海的面積進行對比。該研究主要采用第2種,其中采用的分類精度指標包括總體精度(Overall Accuracy)和Kappa系數。制圖精度是分類器將整個影像的像元正確分為A類的像元數(對角線值)與A類真實參考總數(混淆矩陣中A類列的總和)的比率。

2 結果與分析

2.1 預測結果分析

圖3展示了使用2種方法對2011年單一時相影像與2019年多時相拼接影像的預測結果。從圖3可以看出,在非拼接的2011年影像上,基于MLC方法的總體預測質量較好,但在影像中部以及頂部等河網縱橫交錯、地物分布復雜的區域不能對目標地物實現準確識別(圖3a)。對于2019年的拼接影像,研究區右下角、中部、頂部的部分水域被錯分為養殖排筏,中部有大部分養殖排筏沒有被準確提取,導致了圖上的空白(圖3b)。然而,DeepLab v3+模型提取的結果與實地養殖分布情況相吻合,總體上明顯優于采用MLC方法提取的結果。

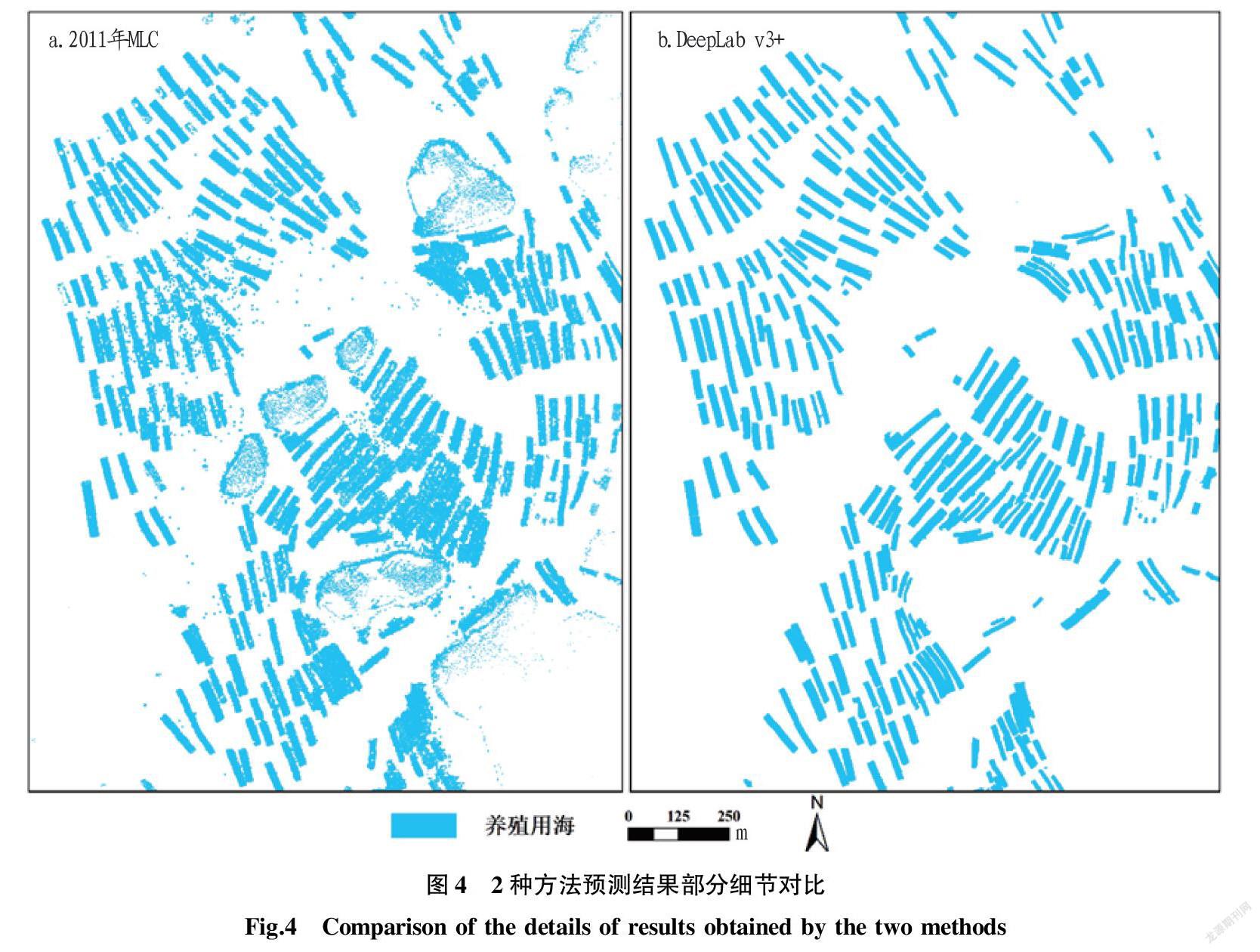

圖4展示了2種方法在2019年多時相拼接影像上的分類結果部分細節。從圖4可以發現,利用MLC方法對2019年的影像進行預測時,圖中大部分區域都產生了噪聲點,在影像拼接處更是將多種“異物同譜”的目標分為一類,在細節處不能將養殖排筏完整地提取出來,而DeepLab v3+模型提取的結果,邊界清晰,地物完整。

圖5展示了2種方法在養殖排筏細節紋理特征識別上的差異。從圖5可以發現,利用MLC方法不能將養殖排筏作為一個整體提取出來,只提取了網格線(圖5a),忽略了其中的水域。而DeepLab v3+模型在紋理特征細節處的識別較為準確,能夠很好地識別出目標輪廓,并將網格和其中水域作為一個整體提取。

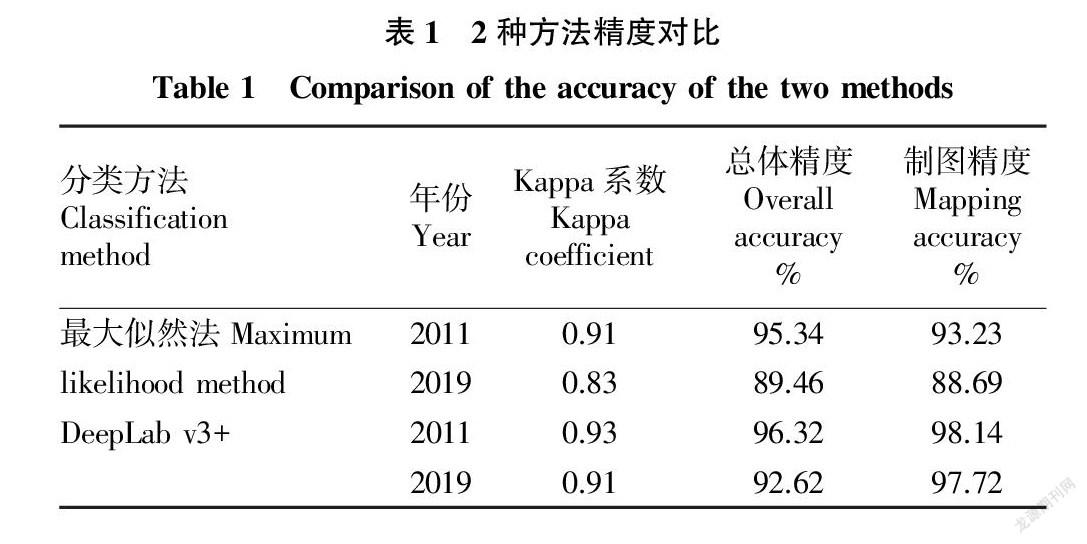

表1為2種方法提取精度對比。從表1可以看出,DeepLabv3+模型的Kappa系數與總體精度均優于最大似然法。在2011年非拼接影像信息提取中,DeepLab v3+模型比最大似然法的總體精度高0.98%,兩者差異較小,而在2019年多時相拼接影像識別上,前者為92.62%,后者僅89.46%,兩者相差3.16%。另外,DeepLab v3+模型在制圖精度上也優于最大似然法,且在識別復雜拼接影像時依舊能夠表現出較高的分類精度。

2.2 敏感性分析

在卷積神經網絡訓練過程中,迭代訓練次數是一個重要參數,對模型精度有顯著影響。圖6展示了不

同迭代訓練次數下模型預測精度情況。從圖6可以看出,隨

著訓練次數的不斷增加,模型預測精度(mIoU值)也逐漸提高。當訓練次數達到30 000次以上時,模型的預測精度趨于平緩,到達

50 000次時,模型的精度與30 000次相比僅相差0.60%。由此可知,在樣本數一定的情況下,模型的精度超過50 000次后將不會再有明顯的提升。分析可知,在不改變初始學習率、train_batch_size以及output_stride時,該模型的預測精度與迭代訓練次數成正相關關系。

2.3 養殖用海變化結果分析

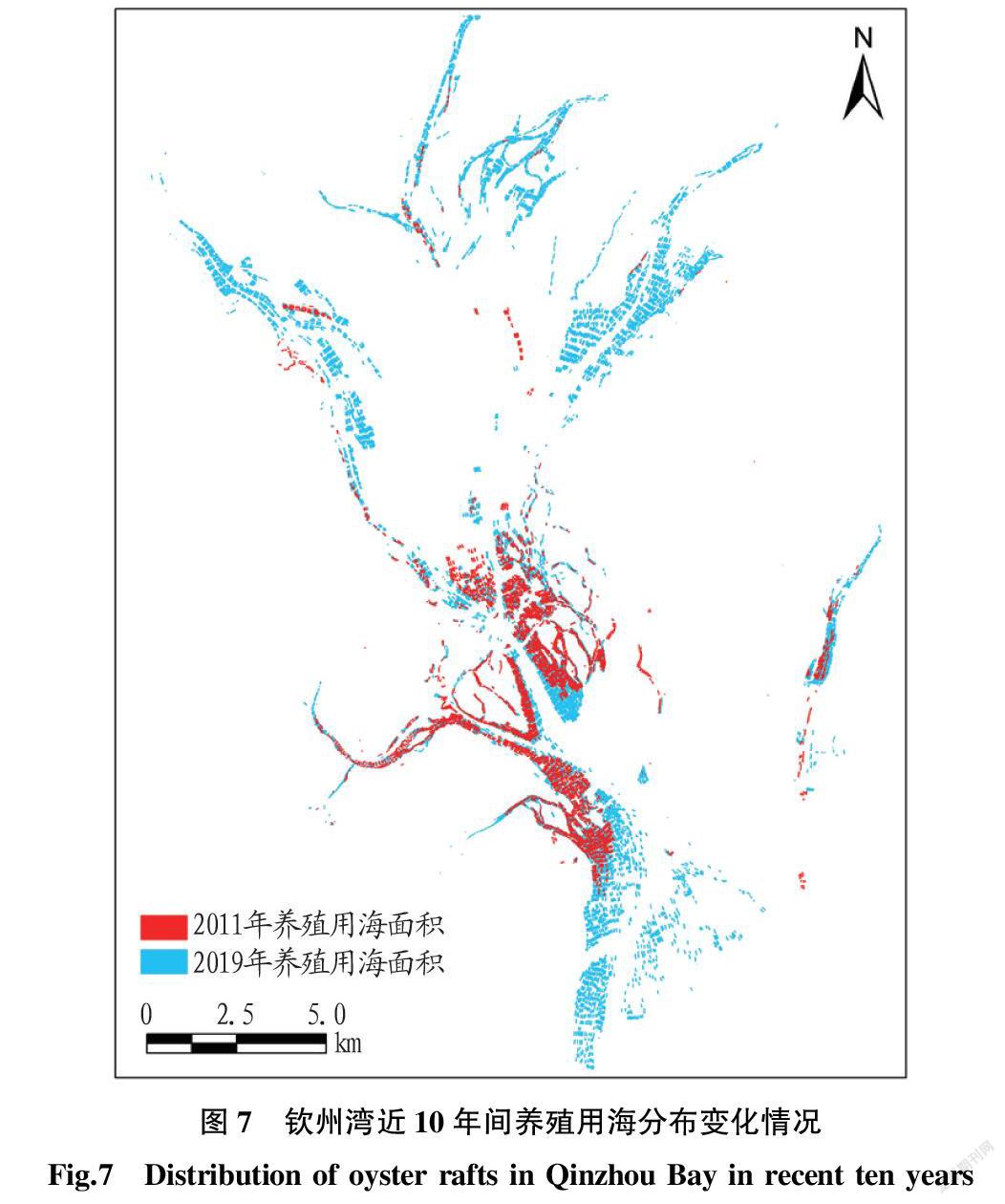

圖7展示了近10年間養殖用海的時空變化分布狀況。養殖用海面積在近10年間呈現出爆炸式的增長,養殖用海的分布格局也由起初位于中部的集群分布拓展至整個欽州灣甚至北部的欽江和茅嶺江的入海口區域,呈現出了中心擴散的趨勢,也從側面彰顯了廣西海洋經濟在可持續發展“十三五”規劃中取得的巨大進步。

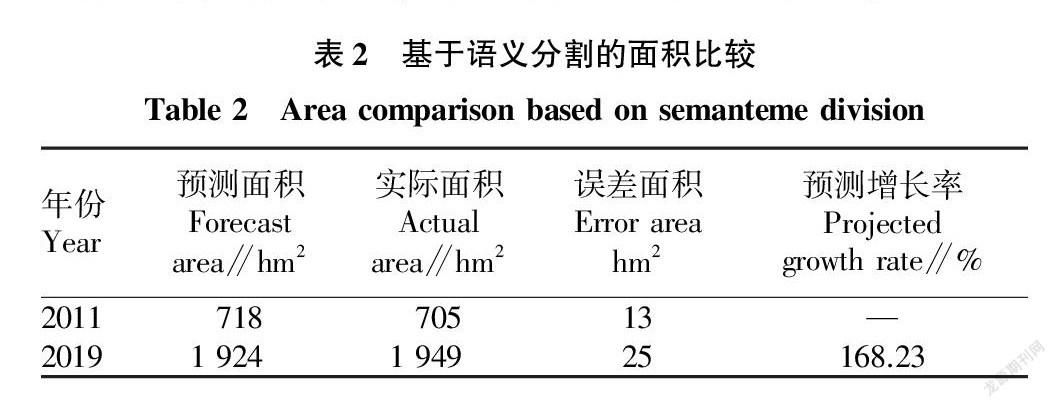

提取面積與實際面積對比。從表2可知,欽州灣養殖用海的凈面積由2011年的718 hm2增長到了2019年的1 924 hm2,是2011年的近2.7倍,相比2011年同比增長了168.23%。隨著2011年欽州市委市政

府將欽州大蠔列為重點扶持的特色產業,市財政每年在大蠔養殖項目上的扶持經費高達數百萬元。另外,隨著養殖技術的不斷進步,“浮筏吊養”逐漸取代了“灘涂插養”的傳統養殖方式,極大提高了欽州大蠔的產量。

3 結論

該研究以2期谷歌地球引擎獲取的高分辨率影像為數據源,采用了DeepLab v3+模型進行了欽州灣養殖用海信息提取。試驗結果表明,該模型在高分辨率、多時相拼接影像上的總體識別精度和紋理特征細節識別方面均顯著優于傳統機器學習方法。DeepLab v3+模型提取總體精度達到了97%以上,能夠很好地識別出養殖網箱、排筏輪廓,可將網格和其中水域作為一個整體提取。另外,通過用海變化分析發現,近10年間,欽州灣海域養殖用海爆發式增長,面積增長接近2倍。該研究可為海域使用監測提供科學技術支持,對海洋開發與管理具有重要意義。

參考文獻

[1]

何顯錦,范航清,胡寶清.近十年廣西海洋經濟可持續發展能力評價[J].海洋開發與管理,2013,30(8):107-112.

[2] 郭麗麗,丁世飛.深度學習研究進展[J].計算機科學,2015,42(5):28-33.

[3] 周飛燕,金林鵬,董軍.卷積神經網絡研究綜述[J].計算機學報,2017,40(6):1229-1251.

[4] 葉沅鑫,譚鑫,孫苗苗,等.基于增強DeepLabV3網絡的高分辨率遙感影像分類[J].測繪通報,2021(4):40-44.

[5] LONG J,SHELHAMER E,DARRELL T.Fully convolutional networks for semantic segmentation[J].IEEE transactions on pattern analysis and machine intelligence,2017,39(4):640-651.

[6] BADRINARAYANAN V,KENDALL A,CIPOLLA R.SegNet:A deep convolutional encoder-decoder architecture for image segmentation[J].IEEE transactions on pattern analysis and machine intelligence,2017,39(12):2481-2495.

[7] 李欣,唐文莉,楊博.利用深度殘差網絡的高分遙感影像語義分割[J].應用科學學報,2019,37(2):282-290.

[8] RONNEBERGER O,FISCHER P,BROX T.U-Net:Convolutional networks for biomedical image segmentation[C]//International conference on medical image computing and computer-assisted intervention.Cham:Springer,2015.

[9] CHEN L C,PAPANDREOU G,KOKKINOS I,et al.DeepLab:Semantic image segmentation with Deep Convolutional Nets,Atrous Convolution,and fully connected CRFs[J].IEEE transactions on pattern analysis and machine intelligence,2018,40(4):834-848.

[10] 司海飛,史震,胡興柳,等.基于DeepLab V3模型的圖像語義分割速度優化研究[J].計算機工程與應用,2020,56(24):137-143.

[11] 韓玲,楊朝輝,李良志,等.利用Deeplab v3提取高分辨率遙感影像道路[J].遙感信息,2021,36(1):22-28.

[12] 何紅術,黃曉霞,李紅旮,等.基于改進U-Net網絡的高分遙感影像水體提取[J].地球信息科學學報,2020,22(10):2010-2022.

[13] 蔡博文,王樹根,王磊,等.基于深度學習模型的城市高分辨率遙感影像不透水面提取[J].地球信息科學學報,2019,21(9):1420-1429.

[14] 茍杰松,蔣怡,李宗南,等.基于Deeplabv3+模型的成都平原水產養殖水體信息提取[J].中國農機化學報,2021,42(3):105-112.

[15] 張廣平,張晨曉.欽州灣大蠔養殖區環境健康評價[J].海洋開發與管理,2020,37(3):41-46.

[16] 勞齊斌,劉國強,高勁松,等.欽州灣養殖區營養鹽分布特征及富營養化狀況研究[J].海洋環境科學,2021,40(3):407-416.

[17] CHEN L C,PAPANDREOU G,SCHROFF F,et al.Rethinking atrous convolution for semantic image segmentation[EB/OL].(2017-06-17)[2021-01-17].https://arxiv.org/pdf/1706.05587v3.pdf.

[18] 秦先祥,余旺盛,王鵬,等.基于復值卷積神經網絡樣本精選的極化SAR圖像弱監督分類方法[J].雷達學報,2020,9(3):525-538.

[19] 柳秀山,彭煒鋒,蔡君.支持向量機的高分辨率光學遙感影像道路提取研究[J].激光雜志,2021,42(4):72-75.

[20] 徐文斌,林寧,盧文虎,等.基于最大似然法的釣魚島航空遙感監視監測信息提取[J].海洋通報,2013,32(5):548-552.