基于深度學習的瞼板腺腺體分割方法研究

林嘉雯,林智明,賴泰辰,郭林靈,鄒 璟,李 笠

0 引言

瞼板腺是位于上、下眼瞼瞼板上的大型皮脂腺,它通過分泌多種脂質成分,形成脂質層,能防止淚液過度蒸發,在維持眼表健康和完整方面起著至關重要的作用[1]。然而炎癥、導管阻塞、環境變化等多種原因均會引起瞼板腺數量和形態的改變以及分泌物質與量的變化,發生瞼板腺功能障礙(meibomian gland disease,MGD)[1]。干眼是除屈光不正外最為常見的眼科疾病。流行病學數據調查顯示,我國干眼患病率達21%~30%,且近年來呈現增長態勢和年輕化趨勢[2],其中超過65%的干眼患者具有MGD的臨床表現[3]。2020年發布的《國人干眼多中心大數據報告》中指出,合并有MGD的臨床確診干眼患者數量占調查總數的92.8%,進一步證實MGD是干眼的主要致病原因之一。嚴重、慢性的MGD癥狀會使角膜和結膜出現繼發性改變,大大降低了患者的視覺質量和生活質量[4]。

瞼板腺的功能與其形態密切相關。通過直接觀察瞼板腺的形態,可以評價其結構和缺失情況[5],為干眼的分型診斷提供依據。利用紅外成像技術透視瞼板腺的形態,形成的圖像便于保存,更有利于監測腺體隨時間或治療的形態變化。因此,紅外瞼板腺圖像已被公認為是臨床上觀察和評估患者瞼板腺形態變化的有效工具[5],在干眼患者的分型診斷、管理與個性化治療中具有重要作用。單純的人工診斷在大規模篩查情況下存在主觀性強、可重復性低、缺乏客觀量化指標和效率低等局限性,且現階段我國基層醫師的MGD診斷水平還十分有限[5],因此引入人工智能技術實現紅外瞼板腺圖像的自動分析能在一定程度上克服人工診斷存在的問題,實現客觀、可重復、高效的分析與評估,輔助形成準確的臨床診斷與分級。紅外瞼板腺圖像的智能分析研究主要圍繞瞼板腺圖像分類、瞼板腺區域分割和瞼板腺腺體分割三方面展開。瞼板腺圖像分類方法能初步達成MGD的自動分級[6];瞼板腺區域分割方法的提出則進一步實現瞼板腺缺失比的粗略估計[7];瞼板腺腺體自動分割旨在實現單個腺體的提取,不僅能得到更為精確的缺失比,還可以計算腺體數量、長寬和彎曲度等形態參數[1]。近年來,深度學習理論的不斷發展及其在醫學領域的成功運用,促進了學者們對紅外瞼板腺圖像智能分析可行性和有效性的進一步驗證[6-8]。本研究初步嘗試了深度學習技術在紅外瞼板腺圖像智能分析中的應用,引入UNet++網絡結構旨在構建高效的瞼板腺腺體自動分割模型,從而服務于后續瞼板腺缺失率與其他形態生物參數的精確計算,以滿足個性化、智能化的干眼診療需求[5]。

1 資料和方法

1.1資料選取2020-01/2021-06于福建省立醫院眼科就診的干眼患者106例212眼,應用眼表綜合分析儀Keratograph 5M采集紅外瞼板腺圖像。為了便于識別,拍攝時選擇增強對比模式以突出顯示腺體,采集到的原始圖像均為RGB模式,分辨率為1578像素×966像素。剔除過于模糊、拍攝范圍不全、睫毛遮擋、存在大面積過強反光的圖像,最終納入圖像193幅。本研究經福建省立醫院倫理委員會審批通過,所有受檢查者均知情同意。

1.2方法

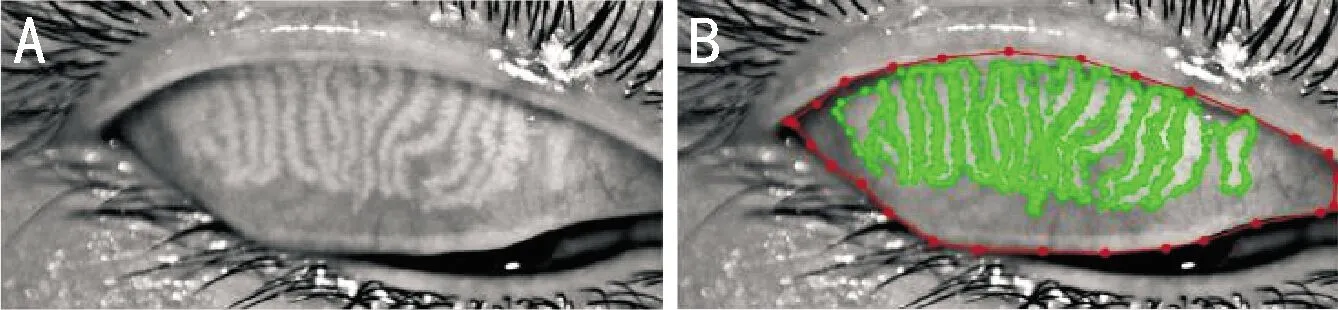

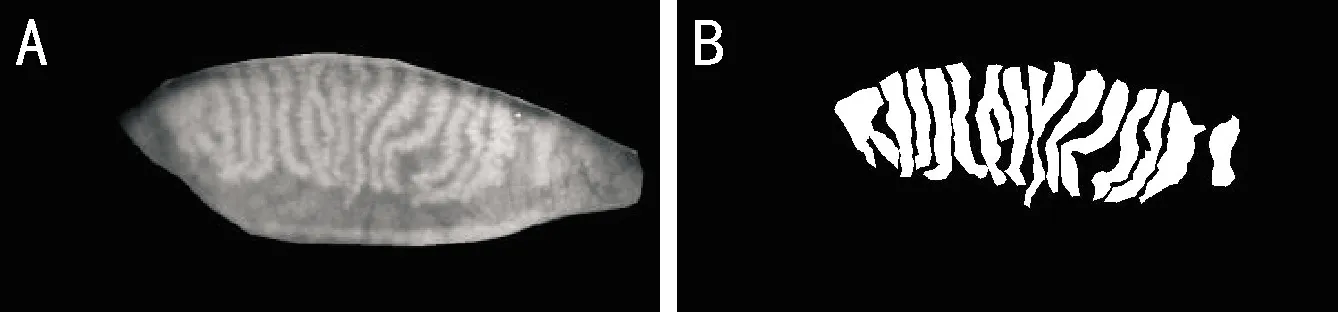

1.2.1數據處理與標記基于既往研究[8]經驗,作為初步探索,本研究僅使用上眼瞼圖像。由于獲取的原始圖像十分規則,故將圖像左上角740像素×350像素范圍設為裁剪區域,通過批量裁剪得到規格相同、僅包含上眼瞼區域的瞼板腺圖像,見圖1A。每幅圖像初始由3名有1a以上臨床工作經驗的眼科醫師使用Labelme軟件中的多邊形工具分別對瞼結膜范圍和各個瞼板腺進行標記。當標記結果出現分歧時,由第4名更高年資的眼科醫師進行判定。最終,所有的標記結果由第4名眼科醫師再次進行審核與修正。人工標記結果見圖1B。根據標記結果,每張裁剪后的原始圖像分別生成2張二值圖像:瞼結膜區域掩模和腺體的人工標注。將瞼結膜區域掩模與裁剪后的圖像相乘,消除睫毛等干擾,處理后得到的最終圖像及其對應的人工標注圖見圖2。最終,這193組圖像共同構成本研究的實驗數據集,按照7∶1∶2的比例劃分為訓練集、驗證集和測試集,其中訓練集和驗證集用于模型訓練和參數調優,測試集則用于驗證本研究提出方法的效果。訓練時批處理大小設為8,訓練周期數設為500,通過初始學習率為0.0003的Adam優化器優化模型,為避免過擬合,每50個周期衰減學習率為一半。

圖1 裁剪后的上眼瞼紅外瞼板腺圖像 A:裁剪后的原始圖像;B:人工標記的上眼瞼瞼結膜區域(紅色)與腺體(綠色)。

圖2 實驗數據集中的圖例 A:處理后圖像;B:腺體的人工標注圖。

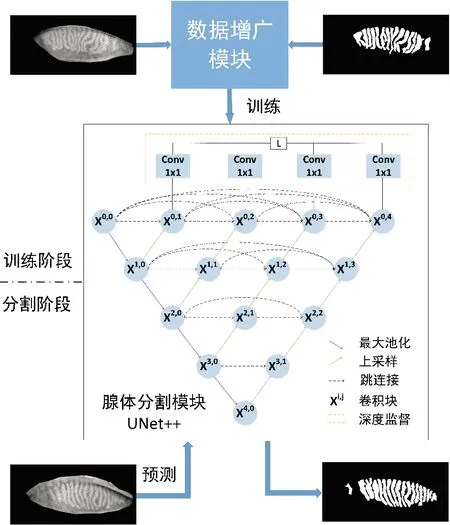

1.2.2基于UNet++的瞼板腺腺體分割模型本研究引入UNet++構建瞼板腺腺體分割模型,瞼板腺腺體自動分割的工作流程見圖3。本研究將瞼板腺腺體分割問題視為一幅圖像中每個像素點進行二分類的問題,瞼板腺腺體分割的具體實現分為訓練和分割兩個階段,包括數據增廣、腺體分割等模塊。

圖3 基于UNet++的瞼板腺腺體分割工作流程。

1.2.2.1數據增廣模塊數據增廣模塊主要克服訓練過程中數據樣本不足的問題,增強數據樣本的多樣性。傳統的數據增廣方法需要針對數據集設計專門的增廣策略,并在增廣過程中設置、調整變換幅度。本研究引入一種自動數據增廣策略[9],每次迭代會從裁剪、翻轉、剪切、平移、旋轉、均衡化、對比度變化、亮度變化等11種數據增廣方式中隨機選擇N種,并為這N種數據增廣方式隨機選擇對應的變換幅度M。理想情況下,經過數據增廣后的訓練樣本可擴增至MN×CN11倍。通過實驗,本研究最終將N設為2,變換幅度M的選擇范圍為1~10。本研究中數據增廣模塊不需要人工設計數據增廣策略,在一定程度上為腺體分割模型提供更多的數據樣本,增強了模型的泛化能力。

1.2.2.2瞼板腺腺體分割模塊紅外瞼板腺圖像為灰度圖像,圖像中沒有特別豐富的語義信息,實驗過程中發現不宜采用特別復雜的網絡模型。2015年提出的UNet[10]是專門針對醫學圖像分割應用需求設計的模型,其利用跳連接融合淺層和深層語義特征圖,克服下采樣造成的信息丟失,顯著提高了醫學圖像分割的精度。UNet++[11]是對UNet的改進,其重新設計了跳連接,進一步減少了編碼器和解碼器之間特征融合的語義差距,并通過深度監督對模型進行優化,使得模型可以剪枝,加快模型的推理速度。因此,本研究引入UNet++模型作為瞼板腺腺體自動分割的主干網絡。

1.2.3損失函數為處理訓練過程中平滑梯度和處理類別不平衡的問題[12-13],本研究使用混合損失L對模型進行優化。混合損失L定義為像素級交叉熵損失LCE和Dice系數損失LDC之和,如公式(1)所示。

L=LCE+LDC

(1)

(2)

(3)

其中,yc,i和pc,i分別代表類別c和第i個像素人工標注和智能分析的分割結果;M為類別數;N為每批次的總像素數。

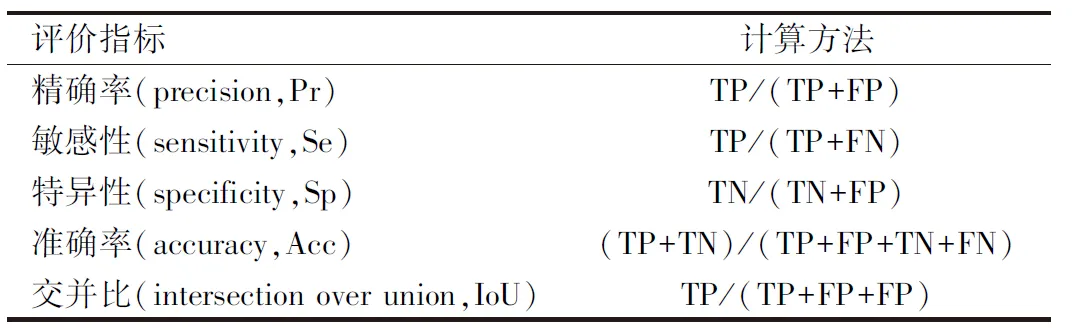

1.2.4評價指標為了評價本研究提出的瞼板腺腺體自動分割方法的性能,本研究以人工標注的瞼板腺腺體作為金標準,將自動分割出的瞼板腺腺體與之進行逐像素對比。當人工標注和自動分割結果一致時,即為分割正確的像素,反之為分割錯誤的像素,可得到4種統計數量:分割正確的瞼板腺像素個數(真陽性,TP)、分割錯誤的瞼板腺像素個數(假陰性,FN)、分割正確的非瞼板腺像素個數(真陰性,TN)和分割錯誤的非瞼板腺像素個數(假陽性,FP)。進而,計算常用的評價指標(表1),其中敏感性(sensitivity,Se)越高說明自動分割模型“找全”瞼板腺腺體的能力越強;特異性(specificity,Sp)越高表明模型能更好地“找對”瞼板腺腺體;交并比(intersection over union,IoU)反映了人工標注與自動分割結果的重疊程度,重疊程度越大表明方法的性能越好。

表1 本研究采用的性能評價指標

2 結果

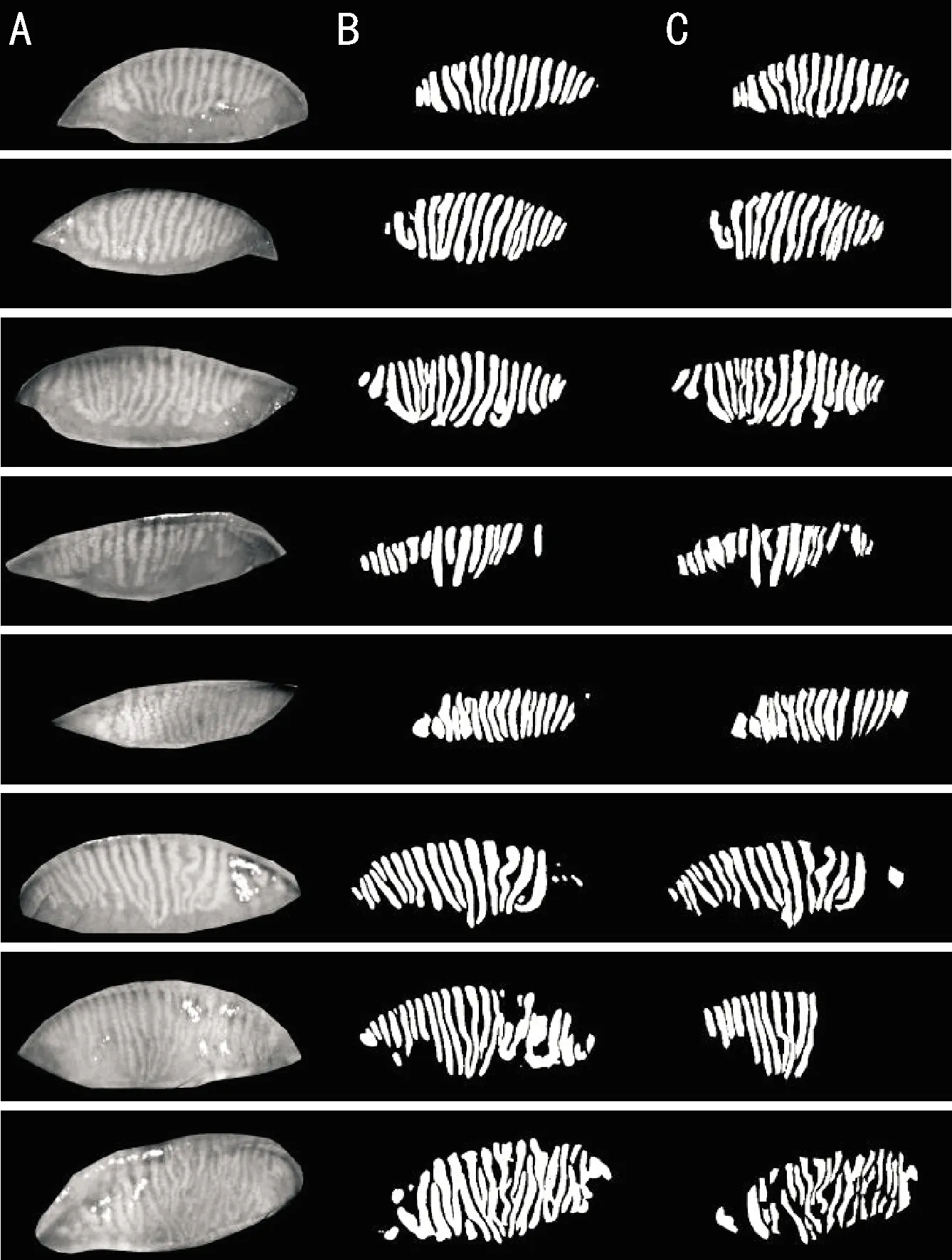

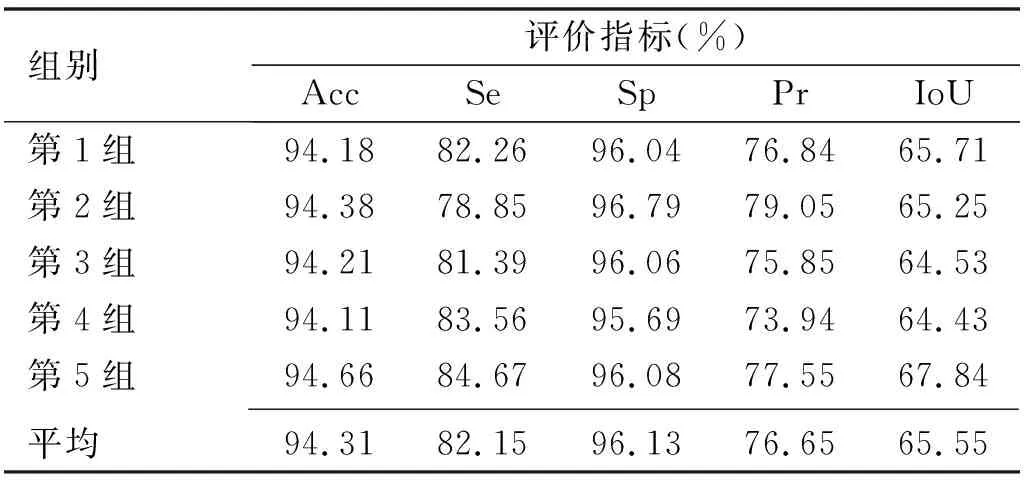

將193組圖像按順序劃分為5組,各包含39、39、39、39、37組圖像。將這5組分別作為測試集,其余圖像作為訓練集和驗證集,采用5組交叉驗證方式對本研究提出的瞼板腺腺體自動分割方法的性能進行評估(表2),平均準確率為94.31%,平均敏感性為82.15%,平均特異性為96.13%,平均交并比為65.55%。交叉驗證過程中各指標的數值均比較平穩,說明所提出的瞼板腺腺體自動分割方法具有較好的穩定性。圖4展示了基于UNet++的瞼板腺腺體分割的可部分可視化效果,前3行圖示分割效果幾乎完美,自動分割結果與人工標注結果極為接近,其中最佳結果準確率高達為96.98%,敏感性為91.28%,特異性為97.79%;中間3行圖示隨機展示了3組一般情況,可以看出多數腺體(尤其是落在眼瞼中間區域的腺體)可以較好地被識別,充分說明了本研究提出的瞼板腺腺體自動分割方法的有效性;最后2行圖示則展示了少數分割結果較差的樣例,最差情況下腺體分割的準確率為87.48%,敏感性僅為50.53%。此外,本研究提出的瞼板腺腺體自動分割方法完成單張圖像的處理平均用時僅為0.11s,效率遠遠優于臨床醫師手動標記的情況。

圖4 本研究提出的瞼板腺腺體自動分割方法結果展示 A:輸入圖像;B:腺體分割結果;C:腺體的人工標注結果。

表2 基于UNet++的瞼板腺腺體分割方法的性能

3 討論

紅外瞼板腺圖像中瞼板腺腺體自動分割的研究目前仍處于起步階段,已開始得到越來越多的關注。Arita等[14]首次提出一種基于快速傅里葉變換和γ校正分割腺體的方法;隨后,研究者們結合閾值分割、形態學等傳統方法[15-18]開展了一系列工作。傳統的基于圖像處理的腺體分割方法依賴研究者主觀設計的手工特征,往往需要設置相應的經驗參數,仍存在一定的主觀性。深度學習方法可以直接從數據中學習特征,不需要明確指定提取規則或設計手工特征,已被廣泛應用于醫學圖像分析領域,在視網膜血管分割[19]、腦腫瘤分割[20]、皮膚病變分割[21]等多個問題上取得不錯的效果。Prabhu等[22]首次提出了一種基于UNet的瞼板腺腺體自動分割方法,在此基礎上,Dai等[23]進一步提出了參數更小的基于mini UNet的腺體分割模型,他們的工作均驗證了深度學習方法用于瞼板腺腺體分割的可行性和有效性。但遺憾的是,多數研究并未描述具體的可比較的性能指數,僅少數研究報道了相關量化結果。本研究提出的瞼板腺腺體自動分割方法敏感性為82.15%,特異性為96.13%,精確率為76.65%,交并比為65.55%。Wang等[24]提出的方法的敏感性為53.9%,精確率為62.7%,交并比為58.4%。Xiao等[8]提出的方法的敏感性為81.39%,特異性為95.65%。可以明顯看出本研究所提出的瞼板腺腺體自動分割方法在幾個評價指標上均表現最佳。盡管目前還沒有針對紅外瞼板腺圖像自動分析研究的公開數據集,現有方法缺乏統一的評價工具和標準,不利于研究者對方法進行直觀比較,上述結果仍能在一定程度上體現出本研究提出的瞼板腺腺體自動分割方法的優越性。

目前認為,當受到光照強度和高亮反光點的影響時,自動分割方法難以得到良好的腺體分割效果。本研究提出的瞼板腺腺體自動分割方法引入深度學習技術,綜合考慮腺體與其鄰近區域的關系和信息,在一定程度上克服了強反光點對周邊腺體分割的影響。然而當圖像中存在偽影、腺體發生嚴重形變時,本研究提出的模型會出現誤判腺體的情況,靠近兩端的區域存在相鄰的腺體分割后黏連的現象,還需在后續的研究中克服這些現象,進一步提高分割的精度。

1駱仲舟, 鄧宇晴, 王耿媛, 等. 基于紅外成像原理的瞼板腺圖像量化分析系統. 眼科學報 2021; 36(1): 30-37