基于注意力機制的無監(jiān)督單目標跟蹤算法*

林志雄,吳麗君,陳志聰

(福州大學(xué) 物理與信息工程學(xué)院,福建 福州350108)

0 引言

目標跟蹤被廣泛應(yīng)用于視頻監(jiān)控和自動駕駛等領(lǐng)域。在給定視頻第一幀中目標位置后,目標跟蹤的任務(wù)是得到目標在后續(xù)幀中的位置信息。在有遮擋、變形和背景混亂等場景下, 準確有效地檢測和定位目標仍然是個難點。

深度網(wǎng)絡(luò)由于可以加強特征表示,被廣泛用于視覺目標跟蹤領(lǐng)域。TAO 等人提出SINT 網(wǎng)絡(luò)[1],首次利用孿生網(wǎng)絡(luò)提取特征,通過匹配初始目標的外觀識別候選圖像位置,實現(xiàn)目標跟蹤任務(wù);BERTINETTO等人提出SiamFC(Siamses Fully Convolution)網(wǎng)絡(luò)[2],使用離線訓(xùn)練的完全卷積孿生網(wǎng)絡(luò)作為跟蹤系統(tǒng)的基本網(wǎng)絡(luò),大大提高了跟蹤性能;LI 等人[3]提出了SiamRPN 網(wǎng)絡(luò),基于SiamFC 網(wǎng)絡(luò)引入了區(qū)域提案網(wǎng)絡(luò)RPN 模塊[4],讓跟蹤系統(tǒng)可以回歸位置、形狀,進一步提高性能并加速;在此之前,基于孿生網(wǎng)絡(luò)的跟蹤器往往使用較淺的網(wǎng)絡(luò),很大原因在于深層網(wǎng)絡(luò)的填充會破壞平移不變性,導(dǎo)致跟蹤性能下降。LI 等人[5]提出在訓(xùn)練過程中引入位置均衡的采樣策略,來緩解網(wǎng)絡(luò)在訓(xùn)練過程中存在的位置偏見問題,進而在SiamRPN 網(wǎng)絡(luò)基礎(chǔ)上用了ResNet 網(wǎng)絡(luò)[6]作為主干網(wǎng)絡(luò),讓跟蹤模型性能不再受制于網(wǎng)絡(luò)的容量。

以上這些單目標跟蹤模型都是屬于有監(jiān)督學(xué)習(xí),有監(jiān)督學(xué)習(xí)需要大量的有標記數(shù)據(jù)集,但是手動標記既昂貴又耗時。而互聯(lián)網(wǎng)上有大量的未標記視頻可供使用,因此無監(jiān)督目標跟蹤算法具有更好的實際應(yīng)用價值。WANG 等人[7]提出了UDT(Unsupervised Deep Tracking)模型,通過將前向傳播和反向預(yù)測的結(jié)果進行一致性損失計算,實現(xiàn)在沒有標簽的情況下同樣優(yōu)化模型。但在前向傳播過程中,跟蹤模型若預(yù)測的位置出錯,經(jīng)過反向修正后可能會再回到正確的位置,這就會導(dǎo)致前向傳播的錯誤預(yù)測沒有被懲罰,降低了模型跟蹤性能。為此,WANG 等人又進一步提出UDT+模型[8],通過多幀驗證方法懲罰前向傳播的錯誤預(yù)測,提升位置預(yù)測的準確性。

為了讓網(wǎng)絡(luò)學(xué)習(xí)到更多關(guān)于目標的信息,注意力機制[9]被引入到有監(jiān)督目標跟蹤模型中,進而提高目標跟蹤模型的性能。例如,WANG Q 等人提出RASNet 模型[10],引入了殘差注意力塊、通道注意力塊和通用注意力塊,使得整個網(wǎng)絡(luò)可以根據(jù)目標的變化而自適應(yīng)調(diào)整注意力,可在適當緩解網(wǎng)絡(luò)過擬合情況的同時提升網(wǎng)絡(luò)的跟蹤性能。HE 等人提出的SA-Siam 模型[11],主要使用了兩個網(wǎng)絡(luò)分別獲取網(wǎng)絡(luò)的語義特征和外觀特征,在語義分支也添加了注意力機制,來提高跟蹤的性能。

針對目前無監(jiān)督單目標跟蹤的精度相對有監(jiān)督的較低的情況,本文設(shè)計一種基于注意力機制的無監(jiān)督單目標跟蹤模型。本文的主要貢獻包括:

(1)本文設(shè)計一種基于注意力機制的無監(jiān)督單目標跟蹤算法;

(2)采用DCFNet 網(wǎng)絡(luò)作為主干網(wǎng)絡(luò),在其最后一層之后引入通道注意力機制,加強關(guān)注特征通道之間的關(guān)系,進行特征融合;

(3)設(shè)計一種反向逐幀驗證方法,提高無監(jiān)督單目標跟蹤性能;

(4)在標準基準的綜合實驗中,所設(shè)計的算法在保證算法實時性下獲得較好的精度。

1 本文方法及模型

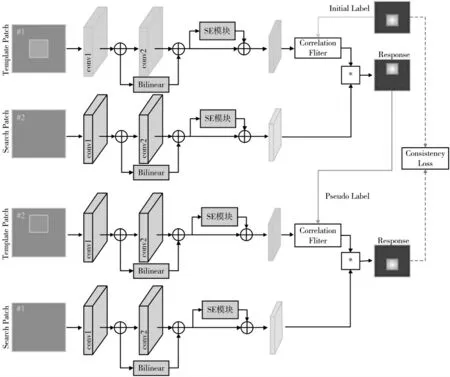

本文采用了DCFNet 網(wǎng)絡(luò)作為主干網(wǎng)絡(luò),對DCFNet 網(wǎng)絡(luò)的每一層網(wǎng)絡(luò)提取的特征,通過下采樣調(diào)整分辨率進行特征融合;此外,在DCFNet 網(wǎng)絡(luò)的最后一層網(wǎng)絡(luò)后面加入通道注意力機制SENet 網(wǎng)絡(luò)[12];最后結(jié)合前向傳播和設(shè)計的反向逐幀驗證方法,實現(xiàn)無監(jiān)督單目標跟蹤任務(wù)。整個網(wǎng)絡(luò)結(jié)構(gòu)如圖1 所示。整個網(wǎng)絡(luò)結(jié)構(gòu)具有兩個網(wǎng)絡(luò)權(quán)重分支:一個是模板分支,以模板補丁(Template patch)作為輸入進行特征提取,通過相關(guān)濾波器(Correlation Filter,CF)模塊進一步生成目標模板;另一個是搜索分支,以搜索補丁(Search patch)作為輸入進行特征提取。兩個分支采用相同的DCFNet 網(wǎng)絡(luò)的前兩個網(wǎng)絡(luò)層進行特征提取,以及后面對兩個分支進行相同的特征融合和通道注意力機制模塊操作。

將第一層網(wǎng)絡(luò)層(conv1)提取的特征圖,通過雙線性池化[13](Bilinear pooling)下采樣到與第二層網(wǎng)絡(luò)層(conv2)提取的特征圖分辨率一致,將兩層網(wǎng)絡(luò)所提取特征相加取平均,得到融合后的特征圖,融合后的特征圖結(jié)合了淺層提取得特征圖具有的位置信息。再將融合得到的特征圖經(jīng)過SENet 模塊,得到重新定義的特征圖。最后,模板分支和搜索分支得到的特征卷積生成響應(yīng)圖Response1(簡稱R1)。響應(yīng)圖R1 是一個高斯標記,理想情況下,響應(yīng)圖R1的峰值就是真實目標所在的位置。后向驗證的操作與前向跟蹤的區(qū)別在于,后向驗證是將前向跟蹤得到的后一幀圖片的預(yù)測位置作為新的目標模板,將前一幀圖片作為搜索補丁。相同理想情況下,后向驗證操作得到的響應(yīng)圖Response2(簡稱R2)應(yīng)該與最初第一幀給定的標簽Initial Label(簡稱Y)相類似。為此,可以通過最小化重構(gòu)誤差損失,以無監(jiān)督的方式訓(xùn)練網(wǎng)絡(luò),從而優(yōu)化跟蹤性能。最小化重構(gòu)誤差損失公式表示為:

1.1 特征融合模塊

圖1 本文算法的網(wǎng)絡(luò)結(jié)構(gòu)

神經(jīng)網(wǎng)絡(luò)每一層網(wǎng)絡(luò)所提取的特征具有不同的表達能力。相對淺的網(wǎng)絡(luò)層所提取的特征往往包含較少的語義信息,包含較多的位置信息和細節(jié)信息,主要表征了目標的邊緣和輪廓等信息,特征圖的分辨率較高。相對深的網(wǎng)絡(luò)層所提取的特征由于分辨率較低,損失了大量的細節(jié)信息,但包含更多的語義信息,有著更強的分辨能力。為使最后提取的特征包含更多的位置信息,文中將DCFNet 后面網(wǎng)絡(luò)層提取的特征去結(jié)合前面所有網(wǎng)絡(luò)層提取的特征,來獲得更多的位置信息,可以提高目標位置的判別準確性。

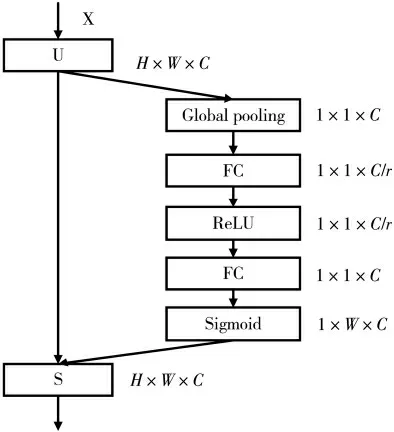

常見的特征融合方法包括通道融合法和像素融合法。通道融合法是將同樣大小分辨率的特征圖在特征維度上疊加;而像素融合法直接將兩張分辨率相等的特征圖對應(yīng)的像素點相加,得到的特征圖和之前的在通道上保持不變。為了在引入通道注意力機制模塊的時候,能更加準確地生成各個通道的權(quán)重,本文選擇通道不變的像素融合法。本文采用雙線性池化進行下采樣特征圖調(diào)整分辨率大小。整個特征融合計算過程如下所示:

其中Bp 表示雙線性池化操作,F(xiàn)i表示特征提取操作,i 表示第幾層,n 表示DCFNet 網(wǎng)絡(luò)總共的網(wǎng)絡(luò)層數(shù)。將每一層網(wǎng)絡(luò)層提取的特征圖x 進行雙線性池化Bp,得到與深層網(wǎng)絡(luò)層提取的特征圖一樣的分辨率。進行相加取平均,得到最后的特征圖FS。

1.2 通道注意力機制模塊

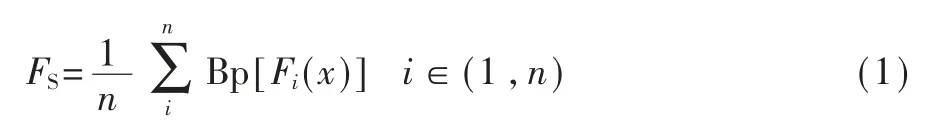

引入通道注意力機制模塊是為了讓網(wǎng)絡(luò)更加關(guān)注特征通道之間的關(guān)系,SENet 網(wǎng)絡(luò)為學(xué)習(xí)特征通道之間的相互依賴關(guān)系而設(shè)計,因此,本文算法在主干網(wǎng)絡(luò)DCFNet 網(wǎng)絡(luò)的最后一層網(wǎng)絡(luò)層后面引入SENet 網(wǎng)絡(luò),來提升跟蹤性能。SENet 網(wǎng)絡(luò)的網(wǎng)絡(luò)結(jié)構(gòu)如圖2 所示。

圖2 SENet 的網(wǎng)絡(luò)結(jié)構(gòu)

圖2 中U 為輸入特征圖,S 為(H,W,C)維度的輸出權(quán)重。SENet 網(wǎng)絡(luò)主要包括兩個操作:壓縮(Squeese)操作和激勵(Excitation)操作。壓縮操作是利用全局平均池化、經(jīng)過空間維度來進行的特征壓縮。將原來二維特征通道壓縮成一個實數(shù),來表示特征通道上響應(yīng)的全局分布,因此壓縮之后的特征通道數(shù)不變;激勵操作由兩個全連接層和一個線性修正單元ReLU 組成。激勵是通過一個w 參數(shù)(如圖2 所示)來為每個特征通道生成各自權(quán)重,被用來學(xué)習(xí)特征通道間的相關(guān)性。將生成的權(quán)重通過scale 操作,即和原特征圖對應(yīng)的通道的二維矩陣相乘,達到在通道維度上對原始特征的重標定。

SENet 模塊提取各個通道間的關(guān)系,使得網(wǎng)絡(luò)增加對信息特征的敏感性,這些信息可以被后續(xù)轉(zhuǎn)換利用,增強DCFNet 網(wǎng)絡(luò)的代表性能力。

1.3 反向逐幀驗證模塊

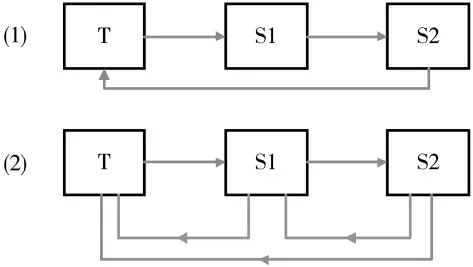

UDT 算法的前向跟蹤和后向驗證是通過三幀圖片來完成一次循環(huán),即通過第一幀去預(yù)測第二幀的目標位置,再通過第二幀去預(yù)測第三幀的目標位置,然后通過第三幀預(yù)測出的目標位置反向預(yù)測第一幀的目標位置,并與第一幀原來的目標框計算一致性損失。但此舉可能會造成較大的預(yù)測錯誤,于是本文將第三幀目標位置先反向預(yù)測第二幀的目標位置,再反向預(yù)測第一幀的目標位置,最后和第一幀原來的目標框位置來計算一致性損失;與此同時,仍然計算第三幀預(yù)測的目標位置直接反向預(yù)測的第一幀的目標位置和第一幀原來的目標框計算一致性損失。將這兩個一致性損失進行相加取平均。反向逐幀驗證如圖3 所示。

圖3 反向逐幀驗證

圖3 中T 為第一幀,S1 為第二幀,S2 為第 三幀。圖3 中(1)代表UDT 算法的多幀驗證,反向驗證通過第三幀S2 直接反向預(yù)測第一幀T 的目標位置。圖3 中(2)代表本文設(shè)計的反向逐幀驗證方案,反向驗證先讓第三幀S3 反向預(yù)測第二幀S2 的目標位置,再預(yù)測第一幀T 的目標位置。通過兩次的反向預(yù)測可以減少反向驗證軌跡上的偏移,減小反向驗證的誤判概率,提高跟蹤準確性。

2 實驗結(jié)果與分析

2.1 數(shù)據(jù)集設(shè)置

本文選用ILSVRC2015 數(shù)據(jù)集作為訓(xùn)練數(shù)據(jù)集。在數(shù)據(jù)預(yù)處理過程中,所設(shè)計算法不需要每一幀都有標簽,減少人力損耗。首先在每一幀中裁剪中心區(qū)域作為補丁,補丁大小為整個圖片的一半,并調(diào)整大小為125×125。接著從連續(xù)裁剪完的10 個補丁中隨機選取三個補丁,將其中一個補丁作為模板補丁,其余兩個補丁作為搜索補丁。本文在基準OTB-2015 數(shù)據(jù)集下與先進的跟蹤器進行測試比較。OTB-2015 數(shù)據(jù)集具有100 個視頻,每個視頻幀不僅提供了標注的目標框,每一個視頻序列還提供了不同的屬性標記,如光照變化、遮擋、形變等。

2.2 實驗參數(shù)設(shè)置

本文實驗使用動量為0.9 的隨機梯度下降(SGD),網(wǎng)絡(luò)一共訓(xùn)練50 個epoch,初始學(xué)習(xí)率設(shè)置為102,每10 個epoch 下降原來的10-1,Batch Size 設(shè) 為32。所有實驗都是在一臺配備4.00 GHz Intel Core I7-6700K 和NVIDIA GTX 1070Ti GPU 的計算機上進行的。在單個GPU 上,本文所設(shè)計算法顯示為61FPS。在OTB-2015 數(shù)據(jù)集上,使用了ROC 曲線下面積(AUC)作為評價指標。

2.3 消融實驗

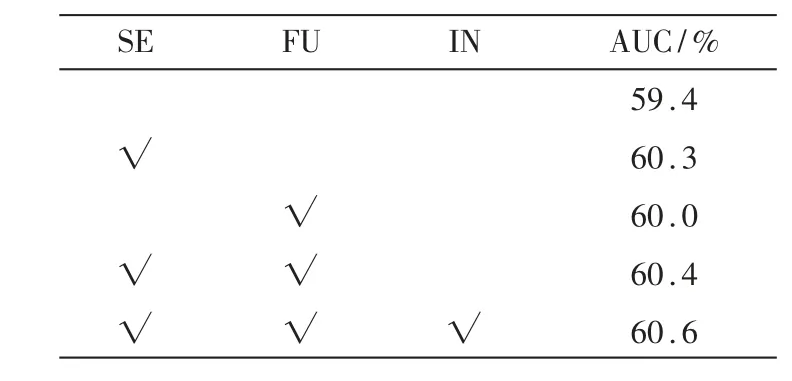

為了驗證上述所提三種優(yōu)化方案對實驗結(jié)果的影響,設(shè)計了四組實驗和UDT 算法進行對比驗證,測試結(jié)果采用AUC 分數(shù)指標。四組實驗分別在UDT算法的基礎(chǔ)上加入各個模塊:(1)引入SENet(簡稱SE)模塊;(2)引入特征融合(簡稱FU)模塊;(3)同時引入SENet 模塊和特征融合模塊;(4)同時引入SENet 模塊、特征融合模塊和反向逐幀驗證(簡稱IN)模塊。實驗結(jié)果如表1 所示。

從表1 中可以看出,分別引入SENet 模塊和特征融合模塊相比UDT 算法在AUC 分數(shù)上分別提高了0.9%和0.6%,表明單獨加入SENet 模塊和特征融合模塊,對UDT 算法在性能上都有一定的提升。同時加入SENet 模塊和特征融合模塊,AUC 分數(shù)上比UDT 算法高了1.0%,在SENet 模塊和特征融合模塊同時引入的基礎(chǔ)上,加上提出的反向逐幀驗證方案,比SENet 模塊和特征融合模塊結(jié)合引入UDT算法的AUC 分數(shù)提高了0.4%,AUC 分數(shù)上比原UDT模型提高了1.2%。表明本文提出的反向逐幀驗證方案同樣可以使UDT 模型的性能有所上升,也表明引入三種優(yōu)化方案的算法性能提升是最好的。

表1 各個模塊對實驗結(jié)果的影響

2.4 對比實驗

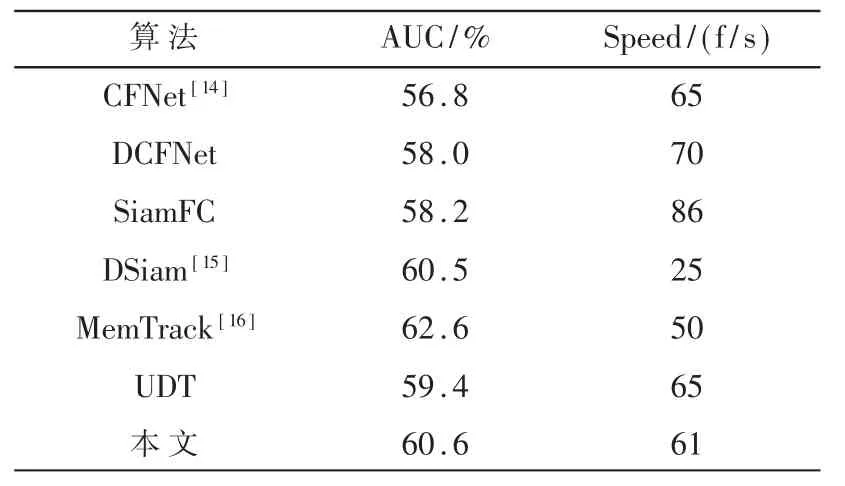

本文對常用的有監(jiān)督跟蹤器和最近提出的無監(jiān)督跟蹤器進行了比較,主要基于孿生網(wǎng)絡(luò),并使用ILSVRC2015 數(shù)據(jù)集進行訓(xùn)練。如表2 所示,在OTB-2015 基準下進行實驗,評價指標包括AUC 分數(shù)和速度(Speed)。測試結(jié)果表明,本文方法在不需要數(shù)據(jù)標簽和提前預(yù)訓(xùn)練好模型的情況下,仍能達到與常用的有監(jiān)督跟蹤器相當?shù)男阅芎托省:蜔o監(jiān)督跟蹤器UDT 相比,在提升實時速度(Speed)的同時,還提高了AUC 分數(shù)。

表2 與其他算法對比結(jié)果

為了測試實驗結(jié)果,本文將所設(shè)計算法和UDT算法在OTB-2015 數(shù)據(jù)集進行更加全面的比較實驗。選取了Biker 序列和Blur Body 序列的結(jié)果進行比較。測試對比結(jié)果如圖4 所示。

Biker 序列實驗結(jié)果中,圖4(a)顯示UDT 算法在的第69 幀視頻幀開始丟失目標,后面的視頻幀一直顯示預(yù)測錯誤;而圖4(b)顯示所設(shè)計算法在第69 幀視頻幀依舊準確預(yù)測目標以及目標位置,以及在后續(xù)幀中保持有效地跟蹤目標;Blur Body 序列實驗結(jié)果中,圖4(c)顯示辦公室人員從第57 幀視頻幀已經(jīng)開始出現(xiàn)模糊,UDT 算法在第58 幀視頻幀開始完全沒有框到目標人員;圖4(d)顯示本文算法在辦公室人員出現(xiàn)模糊的情況下,仍然在第58 幀視頻幀以及后續(xù)幀中對辦公室人員目標進行準確的檢測和跟蹤。可以看出本文算法對于目標甚至模糊的目標的跟蹤效果更好。

3 結(jié)論

針對無監(jiān)督學(xué)習(xí)的單目標跟蹤任務(wù)準確性相對較低的不足,本文設(shè)計一種基于注意力機制的無監(jiān)督單目標跟蹤算法。首先,采用DCFNet 網(wǎng)絡(luò)作為主干網(wǎng)絡(luò),在其中每一層網(wǎng)絡(luò)層提取特征,通過雙線性池化調(diào)整分辨率進行像素特征融合,結(jié)合上下文信息,提高預(yù)測的位置準確性;在網(wǎng)絡(luò)最后一層之后添加SENet 模塊,學(xué)習(xí)特征通道之間的關(guān)系,提高跟蹤目標的性能;利用前向跟蹤和設(shè)計的反向逐幀驗證方法,實現(xiàn)無監(jiān)督學(xué)習(xí)的跟蹤,減少反向驗證誤判概率。實驗表明,本文算法能夠有效實現(xiàn)無監(jiān)督單目標跟蹤任務(wù),在AUC 分數(shù)和Speed 指標對比中可以和現(xiàn)有先進的無監(jiān)督單目標跟蹤算法相媲美,甚至與一些常用的有監(jiān)督單目標跟蹤算法相比,跟蹤性能與實時性也更好。