基于ResNet 與Transformer 的離線手寫數學公式識別

周名杰

(南京郵電大學 自動化學院、人工智能學院,江蘇 南京 210042)

隨著移動設備的快速普及和相關技術的快速發展,更多的輸入和識別手寫數學表達式的情況出現,這要求我們有快速、穩定和準確的手寫數學字符識別方法。但是,手寫字符通常風格變化多樣,并需要關注上下文信息。除此之外,數學表達式結構復雜,常常為復雜的二維結構,甚至出現多種結構嵌套的情況。不同于在線識別,離線圖片中不包含筆跡信息,只能通過圖像本身作為單一信息源來識別表達式。因此,對于手寫數學表達式的識別研究充滿了挑戰。

在傳統的離線手寫數學表達式識別方法中,往往將數學表達式的識別分為兩大部分,符號的切分和識別部分以及結構解析部分[1]。字符的切分往往是基于圖像中的像素點[2]或者是設計包圍字符[3]的包圍框等。卷積神經網絡方法[4],常被用在字符的識別中。結構解析部分,大致分為兩類算法,一類是基于語法的結構解析,如有限從句語法[5],上下文無關語法[6]等。另一類算法是不基于語法的結構解析算法,如MacLean 的貝葉斯模型方法[7],Hirata 的模板匹配方法[8]等。

近年來,基于編碼解碼結構的方法取得了較為明顯的成功。編碼解碼結構在序列到序列的問題,如自然語言處理任務中擁有不錯的表現。ZHANG 的WAP模型[9]中,使用VGG[10]作為編碼環節,將輸入圖片中的特征進行提取,生成序列數據;包含了注意力模塊的循環神經網絡[11]作為解碼環節。密集連接卷積編碼器和多尺度注意力模型[12],進一步提升了編碼解碼結構的性能。

為了解決循環神經網絡訓練的時序依賴問題,文獻[13]提出了完全使用注意力實現的模型Transformer,代替了循環神經網絡,在翻譯任務上取得了很好的成績。

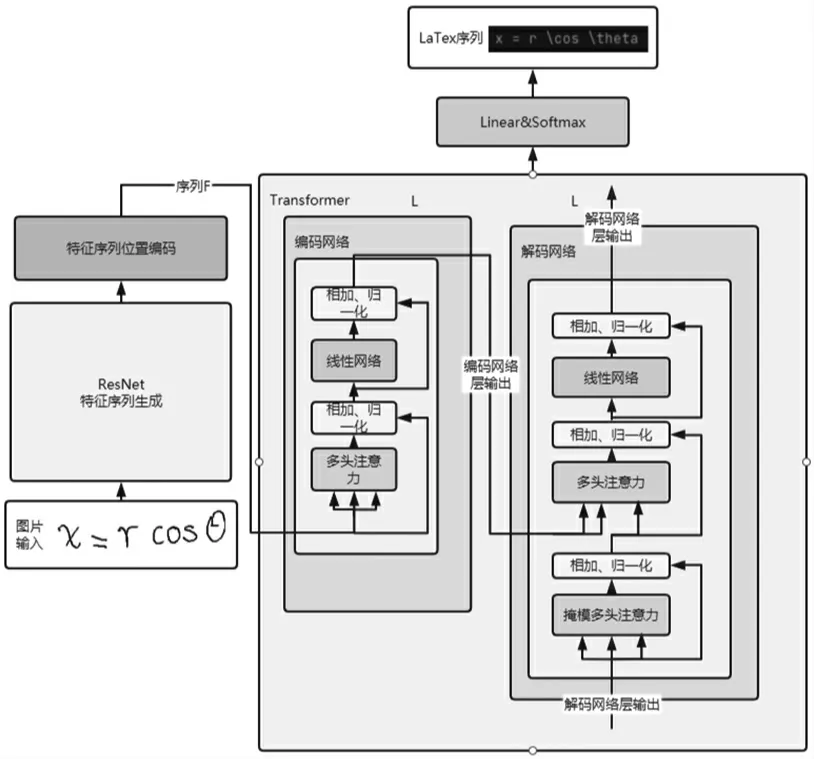

針對手寫數學表達式識別,本文提出基于ResNet[14]與Transformer 結合的方法,首先通過殘差網絡,序列化圖片中的特征信息,之后經過位置編碼[15]添加位置信息。經過處理的特征序列輸入到Transformer 進行編碼解碼計算,達到識別手寫數學表達式的目的。

1 方法概述

受編碼解碼模型以及注意力模型的啟發,本文提出一種新型的基于ResNet 與Transformer 網絡的結構,用以實現對手寫數學表達式的識別工作,整體結構如圖1 所示。本模型的輸入為單個圖像,輸出為LaTex 序列的公式表達。

圖1 模型整體結構圖

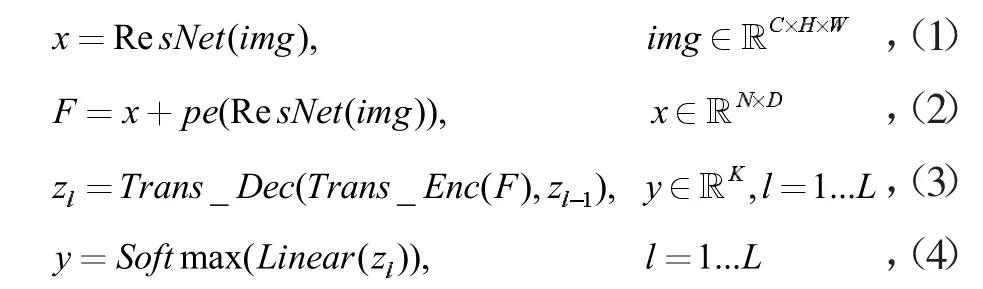

整體公式:

1.1 圖像特征提取

1.1.1 殘差網絡

本文使用的是標準的ResNet34 網絡,但是將最后一層全連接層替換為線性網絡,實現將C×H×W 的圖像轉化為N×D 的二維序列。

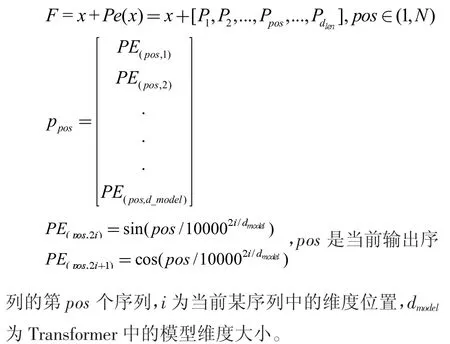

1.1.2 位置編碼

殘差網絡的輸出序列x,以及解碼器輸出將經由位置編碼,用以利用序列之間的位置信息。本文使用的位置編碼方式為相對位置編碼,并使用三角函數來計算位置信息。公式如下所示:

1.2 編碼解碼

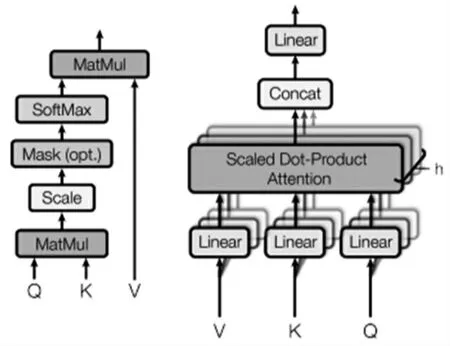

Transformer 網絡中的編碼模塊由多層子網絡組成,子網絡包含多頭注意力與前向網絡。解碼模塊具有類似的結構,但是增加了掩模多頭注意力網絡。解碼網絡的輸入是編碼網絡的輸出F、前部分解碼網絡的輸出Zl-1。

1.2.1 多頭注意力

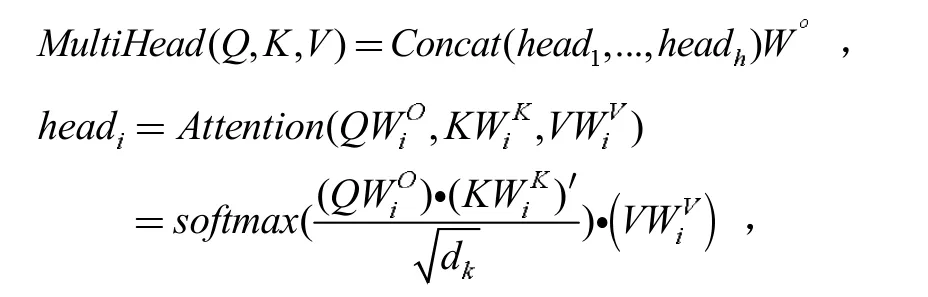

多頭注意力(圖2 右)由多個注意力機制(圖2 左)組成,公式為

圖2 注意力以及多頭注意力

1.2.2 掩模多頭注意力

解碼器在進行對查詢、鍵和值的注意力計算時,需要有一個特殊的當前查詢,它需要滿足能夠包含當前位置以及之前的信息,并且在訓練時不會包含“未來的”信息,即當前位置之后的輸入。根據注意力模型中softmax 函數的性質,采用負無窮化將當前位置之后的輸入,使softmax 計算的結果趨近于0,達到只注意當前以及之前生成結果的目的。

2 訓練和預測方法

在訓練階段,目標是最大化預測詞的概率,使用交叉熵作為目標函數:

loss=CrossEntropy (y,trg),其中y 是預測標簽,trg 是正確標簽。

本模型是整體訓練的,輸入為圖片,輸出為一維向量,代表各字符所在字典中的序號。字典中包含115 個LaTex 符號以及開始標志

在預測階段,目標是得到最可能的預測字符向量:

與訓練階段不同的是,我們將過去生成的結果作為假定的正確標簽輸入,初始輸入為開始標志

3 實驗

3.1 數據集

我們的數據集使用CROHME2016 的競賽數據集,數據集共包含8 852 個數學表達式的訓練集和1 個包含1 147 個數學表達式的測試集。

3.2 驗證

在CROHME 的比賽中,使用表達式正確識別率(競賽組織者提供)來評價模型的表現。

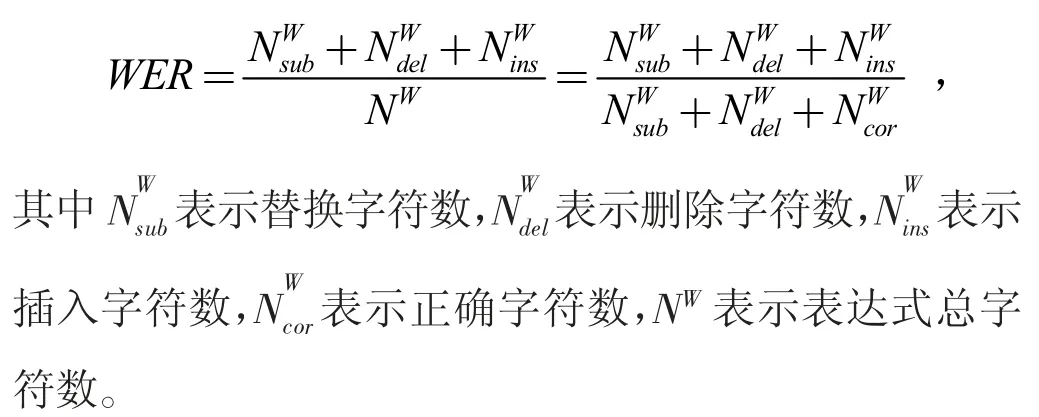

我們在實驗中還使用了單詞錯誤率(WER[16]),每當在表達式中發生替換、刪除和增加時,都記作一次錯誤。其計算公式如下:

3.3 結果及分析

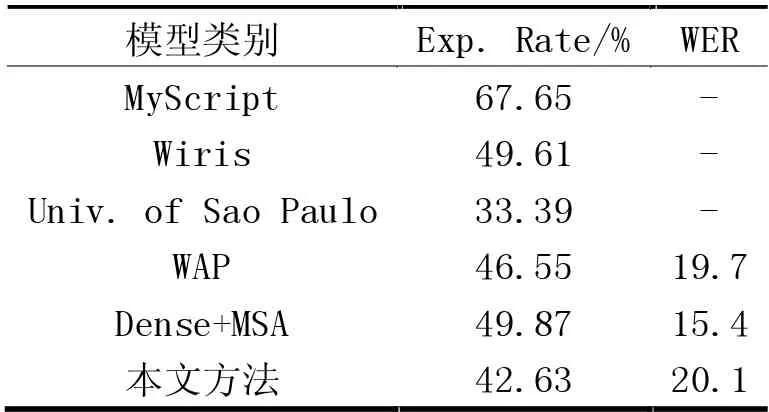

表1 列出了本文方法及其他相關模型在數據集中的表達式正確識別率及WER。

表1 本文方法與其他相關模型對測試數據集中的表達式正確識別對比

與各個參賽的模型進行對比,可以看到本文的方法對測試數據集中的表達式能達到有效識別,單詞錯誤率與WAP 模型相近,證明了本模型的有效性。為了提升表達式正確識別率,我們使用擴展的數據集,擴展數據集除了現有數據之外,還包含了生成數據和采用了隨機旋轉、縮放和扭曲[17]的現有數據,實驗表明表達式正確識別率能夠得到提升,達到45.43%,WER 達到18.8%。

與傳統的分步公式識別方法進行對比,見表1,盡管Wiris 的公式識別率較高,但是其模型使用了大量的訓練數據進行訓練,這表明一個好的解析模型對結果的影響很大。

4 結束語

在本文中我們介紹了一種識別手寫數學表達式的新方法,它由殘差網絡與Transformer 網絡組成,本模型能有效地在不進行顯示分割的情況下完成對字符的識別以及結構的分析,在CROHME2016 數據集上進行了測試。

在未來的工作中,我們計劃采用多尺度分析方法來改進模型,以及探索本模型在文本識別等其他場景下的應用。