基于雙注意力核化雙線性網絡的細粒度圖像分類

朱晨鵬,彭宏京,劉學軍

(南京工業大學 計算機科學與技術學院,江蘇 南京 211816)

0 引 言

與粗粒度圖像數據集相比,細粒度圖像數據集具有較小的類間相似性和較大的類內差異性。只有捕捉到不同類之間局部區域的細微差異或學習到更精細的細粒度圖像特征,才能實現對不同細粒度圖像的有效辨別。因此為了更好描述圖像特征,Lin等[1]提出的雙線性卷積神經網絡(bilinear CNN,B-CNN)采用外積的方式對雙通道特征進行融合,從而建模不同通道間的線性相關,增強了卷積網絡的對圖像表達能力。然后Gao和Cui等[2-4]在此基礎上圍繞雙線性卷積網絡的壓縮和特征分布展開研究,并取得了一定的進展。但這些網絡都忽略了特征圖中不同通道和空間位置關系對分類的不同作用,其次僅使用外積方式建模了不同通道間的線性關系,而沒有考慮非線性關系。

針對上述兩個問題,我們提出從通道和空間兩個維度上對局部區域進行雙注意力建模,其中通道注意力機制對通道加權,使網絡將更多注意力放在具有判別性的特征通道上;空間注意力機制對位置加權,通過增加具有判別性區域的權重和減少噪聲區域的權重,進一步增強網絡的表達能力。其次將兩個機制的注意力特征圖矩陣相加后進行外積聚合。最后為了充分挖掘通道間所蘊含的豐富信息,提出采用sigmoid 核函數的方式對外積矩陣進行核化以建模通道間的非線性關系。與原始B-CNN及其它基于雙線性網絡的算法進行對比,實驗結果表明,本文方法具有更高的分類準確率。

1 相關工作

本節將從細粒度特征提取和注意力機制兩個方面簡要回顧相關工作。研究工作[5]表明,生物特征識別的關鍵在于找到一個合適的特征表達空間將不同類別的對象區分開。我們通過細粒度特征提取結合雙注意力機制獲得了所需的細粒度特征表達空間。

1.1 細粒度特征提取

由于細粒度子類之間的區別是局部且細微的,因此用于粗粒度圖像分類的網絡模型往往不能很好地表征細粒度圖像。Lin等[1]提出了雙線性卷積網絡模型,該模型采用外積的方式對雙通道特征進行融合,從而建模不同通道間的線性相關,增強了卷積網絡的對細粒度圖像表達能力。雙線性卷積網絡模型是細粒度圖像分類領域中“端到端”訓練的首批模型之一,極大地提高了分類的準確性。之后,為了減小雙線性特征的維度和內存消耗,同時加快訓練和識別速度,Gao等[2]使用張量速寫(tensor sketch)與隨機麥克勞林(random maclaurin)兩種算法降低了圖像表達的維度。Cui等[3]提出了核聚合卷積網絡(kernel pooling)來提取高階信息的圖像,該方法通過級聯不同的階信息來獲得圖像的多階特征表示。Li等[4]對全連接層的參數矩陣進行低階分解,把特征的一階和二階信息都利用起來,進而更好完成細粒度圖像分類任務。但上述方法僅使用單層的卷積特征,并不能完整表示圖像特征。本文方法通過雙注意力機制對局部區域進行建模,可以進一步提高對判別性區域的關注度,有效地解決了這些問題。另外,為了建模特征圖中不同通道之間的非線性關系,我們采用核化的雙線性卷積網絡進行分類。

1.2 注意力機制

由于卷積神經網絡直接從單個卷積層中提取的特征并不能完整表征細粒度圖像,因此一些研究試圖通過注意力機制來增強網絡的特征表達能力。

注意力機制類似于人類的視覺系統,它主要包括兩個部分:①確定需要關注的區域;②從關鍵區域提取特征以獲得重要的信息。Zheng等[6]提出了循環注意力卷積神經網絡(RA-CNN),它包含3層分類子網絡,并使用注意建議子網絡進行連接。訓練過程中它將上一個注意建議子網絡的注意力區域裁剪后放大作為下一個分類子網絡的輸入,最后通過融合不同尺度下網絡的分類結果進行判斷。MA-CNN[7]進一步擴展了 RA-CNN的思路,通過特征圖的聚類來定位細粒度圖片中多個具有判別性的區域,然后提取相應特征,最后級聯各個判別性特征取得了優異的分類性能。SENet[8]探索了不同特征通道之間的關系,通過學習和自動檢測每個特征通道的重要性,來增強有用特征并抑制無用特征以強化網絡的表征能力。另外,文獻[9]表明不同空間位置的特征對圖像分類的貢獻度也不同。Woo等[10]同時關注特征尺度,通道和空間位置3個不同維度,并在不顯著增加計算量和參數量的前提下提高了網絡模型的特征提取能力。受文獻[10]的啟發,我們提出了基于雙注意力機制的細粒度分類模型。

2 方 法

細粒度圖像分類的關鍵在于發現局部區域的細微差異。本文采用雙注意力機制對局部區域進行建模,賦予具有判別性區域的更大的權重,以強化有用特征并抑制無用特征,從而實現更有效的特征表示。本節先概述整體流程,然后再分模塊進行介紹。

2.1 總體框架

為了更好地描述圖像特征,我們在B-CNN的基礎上從通道和空間兩個維度對局部區域進行雙注意力建模。其次將兩個維度的注意力特征圖相加后進行外積聚合。最后采用sigmoid核函數的方式對外積矩陣進行核化以建模通道間非線性關系。

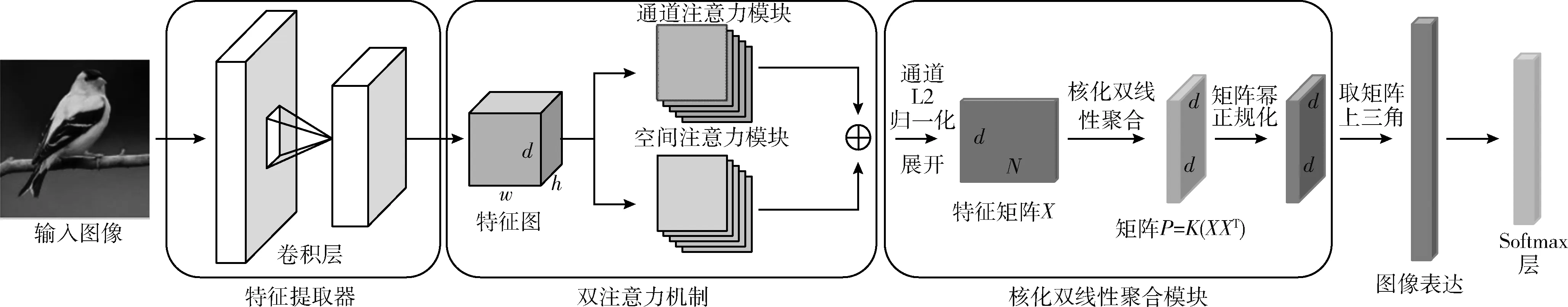

模型的總體框架如圖1所示,雙注意力核化雙線性模型由3個模塊組成:特征提取器、雙注意力模塊及核化雙線性聚合模塊。在第一個模塊中,我們選擇VGG-16充當整個圖像的特征提取器。由于底層特征集中于學習更復雜的形狀和語義信息,因此我們將卷積層Conv5_3的輸出特征圖作為初始特征表示,其中w、h和d分別表示特征圖的寬、高和通道數。第二個模塊中,通道和空間注意力機制分別從通道和空間兩個維度上對局部區域進行建模,對具有判別性的局部區域分配相當大的權重,最后將兩個機制的注意力特征圖以矩陣相加的方式獲得最佳特征表示。核化雙線性聚合模塊首先對雙注意力機制的輸出特征圖進行通道二范數歸一化,并將結果按通道展開為特征矩陣X∈Rd×N,其中N=h×w。然后對X進行外積聚合并采用sigmoid核函數的方式對外積矩陣進行核化以建模通道間的非線性關系,得到圖像表達P。最后對矩陣P進行指數冪操作并取上三角部分作為圖像的最終表達進行細粒度圖像分類。

圖1 基于雙注意力機制的核化雙線性卷積網絡架構

2.2 特征提取器

VGG模型在計算機視覺任務中有著廣泛的應用。在這里,我們使用VGG-16作為特征提取器。

對于輸入圖像I,我們使用W表示所有參數,*表示卷積和池化等一系列操作,則提取的圖像特征F可表示為

F=W*I

(1)

2.3 雙注意力機制

從VGG-16中直接獲取的卷積特征不具有很強的判別力,因此本文引入注意力機制來提高網絡的表征能力,在討論注意力機制之前,我們先介紹特征圖的不同維度。經過卷積和池化后的特征圖具有兩個維度,一個是通道維度,另一個是空間維度。通道間的關系在細粒度圖像分類中被廣泛研究,例如MA-CNN[7]對特征圖分組以獲取不同部位的關鍵性特征。而空間維度則表示不同像素間的關系。本文的注意力機制主要應用于通道和空間兩個維度,可分為以下兩個模塊。

2.3.1 通道注意力模塊

不同通道的特征圖在圖像分類中的貢獻值是不同的,但很多研究認為不同通道的特征圖對分類結果的影響都是相同的。例如,Wei等[11]將不同通道的特征圖直接相加,其結果受到了混亂圖像背景的嚴重干擾。

我們任取了Conv5_3中4個通道的特征圖進行可視化如圖2所示。由圖2可以看出,不同特征通道的關注點不同,后3個通道的特征圖都將關注點集中在目標主體部位上,而第108層的特征圖卻集中在背景噪聲上。

圖2 4個通道特征圖的可視化結果

因此為了突出目標主體區域,同時抑制背景噪聲干擾,我們使用通道注意力機制來根據不同通道的重要性學習權重,通過增加包含目標主體區域特征圖的權重并減小噪聲響應圖的權重,以達到增強有效通道信息和抑制無效通道信息的效果。對于深層卷積神經網絡,在經過多次卷積和池化后,卷積層的最后一層包含最充分的空間和語義信息。所以我們僅在最后一個卷積層輸出的特征圖之后使用注意力機制,其中通道注意力機制的結構如圖3所示。

圖3 通道注意力機制結構

全局平均池化(global average pooling)可以充分利用每個通道的空間信息,具有很強的魯棒性且不易過度擬合。而全局最大池化(global max pooling)可以反映全局最大響應,并在一定程度上表示通道中的關鍵信息。此外,Woo等[10]的研究工作表明,與僅使用一種全局池化方法相比,全局平均池化和全局最大池化的合并結果更為有效。因此我們使用GAP和GMP信息融合的方式來學習通道權重,池化后的特征向量分別表示為FGAP和FGMP。然后為了實現通道間信息的交互并減少數據量,我們將兩層1×1卷積連接起來應用到FGAP和FGMP中。前一層1×1卷積核數量設置為c/r,其中c為FGAP和FGMP的通道維度。r為可變參數,表示特征維度c的縮減倍數,它的值對細粒度分類結果的影響將在實驗部分3.4.1節中詳細介紹。最后一層1×1卷積核的數量調整為c以保證輸出特征圖的通道維度與輸入相同。

經過兩層1×1卷積后得到F′GAP和F′GMP, 然后將它們的合并結果傳遞給sigmoid函數。該函數將合并結果的每個元素都映射到0~1之間來得到權重MC,它表示每個特征通道的重要性。最后將MC乘以原始特征圖F對其加權得到注意力特征圖F′C, 這意味著在不同特征通道上都執行權重分配,以抑制無用信息并增加有用信息的比例。公式表達為

F′C=MC?F=σ(F′GAP+F′GMP)?F

(2)

由于部分通道信息可能會在GAP和GMP傳遞過程中丟失,因此受到ResNet[12]殘差學習的啟發,我們將注意力模塊的卷積特征和原始輸出疊加以獲得最佳表示。整個通道注意力模塊框架如圖4所示,通道注意力機制作為側分支添加到原始特征通道中,這樣網絡只需要學習注意力模塊,而無需學習整個輸出。最終輸出的特征圖FC表示為

FC=F⊕F′C=(1+σ(F′GAP+F′GMP))?F

(3)

其中,σ表示sigmoid函數,⊕表示逐像素相加,?表示逐元素相乘。

圖4 通道注意力模塊框架

2.3.2 空間注意力模塊

特征圖中不同像素對于分類結果的貢獻也不同。空間注意力模塊的作用是為特征圖中每個像素分配權重值,通過增加判別性區域的權重和減少噪聲區域和背景區域的權重,以達到增強關鍵區域和抑制無用區域的效果。該機制結構如圖5所示。

圖5 空間注意力機制結構

與通道注意力機制相同,首先沿著通道維度采用GAP和GMP來獲得FsGAP和FsGMP,維度均為h×w×1。然后將FsGAP和FsGMP逐元素相加后進行3×3的卷積,并將卷積結果傳遞給sigmoid函數以獲得權重圖MS。最后,將權重圖逐元素與原始特征圖F相乘,得到空間注意力特征圖F′S。 公式表達為

F′S=MS?F=σ(f(FsGAP+FsGMP))?F

(4)

同樣的,我們將空間注意力機制作為側分支添加到原始特征通道中,整個模塊框架如圖6所示,最終輸出的特征圖FS表示為

FS=F⊕F′S=(1+σ(f(FsGAP+FsGMP)))?F

(5)

其中,σ表示sigmoid函數,f代表3×3的卷積操作,⊕表示逐像素相加,?表示逐元素相乘。

圖6 空間注意力模塊框架

通道和空間注意力從兩個維度上解析圖像特征,以促進網絡學習更多的特征信息。而雙注意力機制融合了兩個不同維度的注意力特征圖,框架如圖7所示。

圖7 雙注意力機制框架

雙注意力機制的輸出FDA,公式表達為

FDA=FC+FS

(6)

2.4 核化雙線性聚合模塊

在上一模塊中,雙注意力機制以矩陣相加的方式對兩個機制的注意力特征圖進行融合得到FDA,維度為w×h×d。葛等[13]為解決B-CNN中僅能建模特征通道間非線性關系的不足,提出了一種核化的雙線性卷積網絡,因此為了更充分地挖掘通道間所蘊含的豐富信息,我們也采用sigmoid核函數的方式對FDA的外積矩陣進行核化以建模通道間的非線性關系,增強網絡的表征能力。

如圖8所示,核化雙線性聚合模塊首先對雙注意力機制的輸出特征圖FDA進行通道二范數歸一化,并將結果按通道展開為特征矩陣X∈Rd×N,其中N=h×w,d為特征通道數。然后對矩陣X進行外積聚合XXT∈Rd×d,并采用sigmoid核函數的方式對外積矩陣進行核化以建模通道間的非線性關系,得到圖像表達P。最后對矩陣P進行指數冪操作,冪指數設為α,并取結果的上三角部分作為圖像的最終表達進行細粒度圖像分類。

圖8 核化雙線性聚合模塊流程

本文采用sigmoid核函數對外積矩陣A=XXT進行核化,sigmoid核函數公式K表示為

K(xi,xj)=tanh(θ·〈xi,xj〉+γ)

(7)

其中,θ為幅度調節參數,θ>0,γ為位移參數,γ<0,核化后的矩陣P表示為

P=K(XXT)=tanh(θ·XXT+γ·1d×d)= tanh(θ·A+γ·1d×d)=[tanh(θ·〈xi,xj〉+γ)]d×d

(8)

其中,1d×d表示元素均為1的d維方陣。交叉熵損失函數l針對矩陣A的反向傳播公式如下所示,其中“°”表示哈達馬積

(9)

3 實驗與分析

3.1 實驗平臺

仿真的實驗環境為:Win10操作系統,i7-8700K處理器和GTX 1080Ti 顯卡。實驗采用Python編程語言在Tensorflow上設計與實現,并采用NVIDIA推出的通用并行計算架構CUDA(computer unified architecture)加速模型的訓練。

3.2 數據集

實驗部分在CUB-200-2011、FGVC-Aircraft及Stanford Cars這3個細粒度圖像數據集上對本文方法進行評估。所有數據集的訓練集與測試集的劃分見表1,其中CUB-200-2011鳥類數據集被公認為最具挑戰性的細粒度分類數據集,因為每個類平均僅有30張圖片供模型訓練,并且具有較大的類內差異。注意本文實驗中均未采用邊界框等人工標注信息。

表1 3個細粒度數據集的統計數據

3.3 實驗參數設置

本文選用VGG-16網絡模型作為整個圖像的特征提取器,并將Conv5_3卷積層的輸出作為初始特征表示。在模型訓練前,先使用ImageNet上的分類模型初始化網絡參數,并采用與改進的B-CNN相同的圖像預處理方式:對于CUB-200-2011和StanfordCars數據集,在保持長寬比的前提下將短邊縮放至448后,從中間裁剪出448×448的區域作為模型的輸入。對于FGVC-aircraft數據集,則將圖像短邊縮放至512后,從中間裁剪出448×448的區域作為模型的輸入。預處理完成后,采用隨機水平翻轉的方式進行數據增強,最終Conv5_3卷積層的輸出特征圖大小為28×28×512。

訓練過程中采用帶動量的隨機梯度下降法作為優化算法,動量設置為0.9,批次大小設置為20,矩陣冪正規化層中參數α設置為0.5。訓練共分為兩個階段,第一階段為微調訓練,即對模型最后兩層即softmax分類器進行訓練,學習率和權重衰減分別設置為1.0和10-8。第二階段對整個模型進行訓練,學習率和權重衰減分別設置為0.001和10-5。

3.4 實驗結果評估

實驗分別針對本文提出的通道注意力模塊、空間注意力模塊及雙注意力機制進行評估,同時還探討了通道注意力模塊中不同縮減倍數r對分類結果的影響。最后對核化雙線性聚合模塊進行消融實驗以驗證其有效性。

3.4.1 通道注意力模塊評估

通道注意力模塊中r表示特征維度的縮減倍數,它是一個可變參數,因此我們首先對其進行了參數評估。我們在VGG模型的Conv5_3卷積層后直接添加了通道注意力模塊,并將r值分別設置為2、4、8和16,最后在CUB鳥類數據集上進行了實驗。損失函數使用交叉熵損失函數,結果見表2。

表2 不同r值的CAKB模型在CUB-200-2011上的準確率

從表2可以看出,當r值為2時,嵌入通道注意力模塊的核化雙線性網絡(channel attention kernelized B-CNN,CAKB)在CUB鳥類數據集上的分類準確率達到了86.9%的最佳性能。因此,我們將通道注意力模塊中的r值設置為2。然后在3個細粒度數據集上進行了對比實驗,結果見表3。

表3 CAKB與其它基于雙線性網絡方法的比較結果/%

實驗結果表明,與原始B-CNN方法相比,CAKB框架在CUB、FGVC及Stanford Cars上的分類準確率分別提高了2.4%、4.3%和2.8%。與其它基于雙線性網絡的方法,如CBP及KP模型相比,它也具有一定的優越性。因此,引入通道注意力機制對通道加權,使網絡將更多注意力放在具有判別性的特征通道上,這對細粒度分類產生了積極的影響。此外,還驗證了不同特征通道對分類的作用是不同的。

3.4.2 空間注意力模塊評估

同樣地,我們在VGG模型的Conv5_3卷積層后直接添加了空間注意力模塊,并將嵌入空間注意力模塊的核化雙線性網絡命名為SAKB(spatial attention kernelized B-CNN)。SAKB的實驗評估結果見表4。

表4 SAKB與其它基于雙線性網絡方法的比較結果/%

從表4可以看出,與原始的雙線性卷積網絡模型相比,增加空間注意力及核化機制的SAKB框架在3個實驗數據集上的分類準確率分別提高了2.3%、4.1%和2.5%。而與僅包含核化機制的雙線性卷積網絡相比,準確率也有所提升。這表明在空間維度上增加注意力機制的合理性與有效性,也驗證了圖像不同部分對分類的作用也不同。

3.4.3 雙注意力機制

嵌入雙注意力機制的核化雙線性卷積網絡(dual attention kernelized B-CNN,DAKB)架構如圖1所示,它的評估結果見表5。同時為了與CAKB、SAKB框架及其它基于雙線性網絡方法進行更直觀的比較,我們繪制了折線如圖9所示。

表5 DAKB與其它基于雙線性網絡方法的比較結果/%

圖9 各框架與其它基于雙線性網絡方法的對比折線

從表5和圖9可以看出,與B-CNN方法相比,基于雙注意力機制的核化雙線性網絡(DAKB)在3個實驗數據集上的分類準確率分別提高了2.7%、4.4%和2.9%。不僅高于原始的雙線性網絡和其它基于該網絡的算法,還優于嵌入單個注意力機制的CAKB和SAKB框架。這都歸因于雙注意力機制融合了通道和空間兩個不同維度的注意力特征圖,從而促進了卷積網絡學習到更多的特征信息。

3.4.4 消融實驗

由于CAKB、SAKB和DAKB框架中都添加了核化雙線性聚合模塊,因此為了驗證該模塊的有效性,我們對其進行了消融實驗,直接采用原始雙線性卷積網絡中的外積聚合模塊進行細粒度圖像分類。3種框架消融前后在CUB-200-2011鳥類數據集上的準確率見表6。

表6 CUB-200-2011上對核化雙線性聚合模塊的消融結果

從表6可以看出,通道注意力模塊、空間注意力模塊和雙注意力機制添加核化雙線性聚合模塊后再進行細粒度分類,CAKB、SAKB以及DAKB在CUB-200-2011鳥類數據集上的分類準確率分別提高了1.5%、1.7%和1.6%。這驗證了核化雙線性聚合模塊的有效性。雙注意力機制以矩陣相加的方式對兩個機制的注意力特征圖進行融合后,它采用sigmoid核函數的方式對外積矩陣進行核化,進一步建模了通道間的非線性關系,從而得到了更加充分的圖像表達。

4 結束語

為了更好地描述細粒度圖像特征,本文從通道和空間兩個維度對局部區域進行雙注意力建模,其次將兩個維度的注意力特征圖相加后進行外積聚合。最后采用sigmoid核函數的方式對外積矩陣進行核化以建模通道間的非線性關系,進一步增強網絡的表征能力。實驗在CUB-200-2011、FGVC-Aircraft及Stanford Cars這3個細粒度數據集上進行了測試,結果表明本文方法在3個細粒度圖像數據庫上均優于同類方法,同時驗證了特征圖中每個通道和空間位置在分類中的不同作用以及核化雙線性聚合模塊的有效性。在未來的工作中,可以將本文方法應用于更多的計算機視覺任務中,例如場景分割、目標檢測等。同時考慮將ResNet及GoogleNet等模型作為特征提取器來進一步提升分類準確率。