結合注意力與局部特征融合的行人重識別算法

陳林鋒,雷景生,吳宏毅,朱陳思聰,葉仕超

浙江科技學院 信息與電子工程學院,杭州 310000

隨著安防需求的日益增加,越來越多的攝像頭安裝在學校、游樂園、銀行、停車場、社區等場所,形成了大型分布式監控網絡。成熟的監控網絡能夠切實保障社會的平穩運行、人身以及財產安全。學校安裝攝像頭可以保證學生的人身以及財產安全,銀行可以通過監控視頻識別與跟蹤不法分子,社區安裝攝像頭來保證居民的人身以及財產安全。在面對不同攝像頭下行人身份關聯的問題時,由于攝像機拍攝角度以及分辨率的原因,無法得到可靠的人臉圖片進行身份識別,這時候就需要行人重識別技術。行人重識別是指在跨攝像頭跨場景下行人的識別與檢索,即給定一個要查詢的人,確定這個人是否在不同的時間出現在另一個地方,由不同的攝像頭捕捉到。由于光照變化、攝像頭視角變化、行人在視頻畫面中姿態變化以及遮擋等問題的存在,使得同一行人在不同時刻不同場景下被攝像頭捕捉到的圖像差別很大,這為行人重識別帶來了巨大的挑戰[1]。

近年來,隨著機器學習的理論以及應用取得了巨大的進步,深度學習作為其重要分支,也在各個領域大放異彩。基于深度學習的行人重識別方法增強了表征信息的提取,促進了度量學習方法的革新,提升了在各個數據集上的檢索性能。

全局特征學習方法通過使用先進的深度學習技術來提取行人的表征信息,然而,在光照、遮擋等不受限的環境下,只依靠全局特征的行人重識別方法無法解決較大的類內差異,通常會導致檢索性能大幅下降,無法再準確識別行人[2]。為了解決這個問題,基于局部特征的方法廣泛地應用到行人重識別問題當中。Sun等人[3]提出了基于局部的卷積網絡,將從特征提取器獲得的特征水平分割成若干塊,對每一個特征塊提取細粒度局部信息,同時利用精修部件池化(refined part pool)改善直接分塊造成邊緣粗糙的缺點。Wang等人[4]將特征圖進行分割來提取多粒度的行人肢體語義信息。模型采用了三分支結構,一個分支用來提取全局特征,其他兩個分支用于局部特征表示,通過融合全局信息以及具有辨識力的多粒度局部信息來增強行人的特征表達。由于圖片中行人的身體各部位有不對齊的情況,直接使用基于局部特征的方法在計算特征相似度時會帶來噪聲,Suh等人[5]提出了基于身體部位對齊的雙流網絡,其預訓練權重由姿勢估計數據集訓練而得,一個分支用于提取全局外觀特征,另一個分支用于提取局部身體特征,并通過雙線性池化將兩者進行融合。Zhang等人[6]提出了基于密集語義對齊的行人重識別模型,通過引入DensePose(dense human pose estimation in the wild)來定位行人身體各個部件,有效地解決了空間語義不對齊問題,同時也解決了姿態變化、遮擋等常見問題,顯著地提高了算法的精度。Sun等人[7]提出一種可見性感知局部模型(visibility-aware part model),VPM可估計出兩張行人圖像之間的共享區域,并在評估圖片相似性時聚焦共享區域,顯著提高了行人重識別的準確率。

注意力機制因其增強重要特征以及抑制無關特征的特性被廣泛應用在行人重識別領域當中,它能夠改善行人姿態變化、視角變化、檢測器檢測誤差等問題帶來的干擾[8]。Li等人[9]聯合硬注意力與軟注意力機制學習區域級別和像素級別的重要特征來解決同一行人不同圖片之間差距大的問題,同時提出了交叉注意力交互學習機制(cross-attention interaction)來高效地聯合學習全局特征與局部特征。Chen等人[10]采用不同階次的注意力模塊提取高階統計量,從而顯著增強了注意力信息的辨別力和豐富性。此外,引入對抗學習約束來防止模型在訓練階段時高階模塊坍塌為低階模塊。Xia等人[11]結合非局部機制與二階注意力來挖掘特征圖中點與點之間相關性,有效學習到豐富的全局信息,在局部分支加入了DropBlock進行特征擦除來提升模型的魯棒性。Chen等人[12]將一對互補的注意力模塊融入到骨干網絡中,分別提取通道以及空間域的注意力信息,避免注意力機制過度集中于前景,同時引入正交規范化對特征空間以及神經網絡權重進行約束以確保重識別特征的多樣性。Park等人[13]提出基于非局部機制的關系網絡,充分考慮了身體各個部位與其他部位之間的關系,使得每個局部特征都包含了相應部位本身以及身體其他部位的信息,使其更具區分性,并提出全局對比池化來(global contrast pool)獲得行人圖片的細粒度全局特征。

鑒于注意力機制與局部特征學習方法對行人姿態變化、遮擋、視角變化等問題的魯棒性,本文提出了結合注意力與局部特征融合的行人重識別算法。該算法將ResNeSt-50[14]作為特征提取器,由雙分支結構組成,分別提取行人細粒度全局和局部特征,通過關注不同特征之間共享的空間域信息以及同一特征不同水平區域之間的特征相關性,提出了空間感知特征融合模塊(spatial-aware feature fusion module)以及跨區域特征融合模塊(cross-region feature fusion module)。在Market-1501[15]、DukeMTMC-reID[16]以及CUHK03[17]數據集上的實驗結果表明該算法極大程度上提升了網絡的檢索能力,同時與現有算法進行比較,凸顯出優越性能。

1 結合注意力與局部特征融合的算法介紹

1.1 算法網絡框架

ResNet-50憑借其引入的殘差結構,使得網絡能夠向更深的方向發展,提取到豐富的高層語義信息,避免了出現梯度爆炸和梯度消失問題。目前絕大部分行人重識別工作都選擇ResNet-50[18]作為骨干網絡來提取行人圖像的初始特征。然而,像ResNet等一系列基礎卷積神經網絡是針對圖像分類而設計,這些基礎的卷積神經網絡會受到感受野的限制同時缺乏跨通道之間的相互作用。最近,新提出的ResNeSt在圖像分類、對象檢測、實例分割和語義分割任務中達到了最先進的性能,它通過基于通道的注意力機制來捕獲跨通道之間的關系。此外,它采用核大小為3×3的平均池化來代替ResNet-50中使用3×3卷積來進行下采樣,這樣不會損失很多空間信息。ResNeSt網絡目前在行人重識別任務中還未廣泛使用,本文選用最新的ResNeSt-50作為骨干網絡來拓展其在行人重識別任務中的應用。

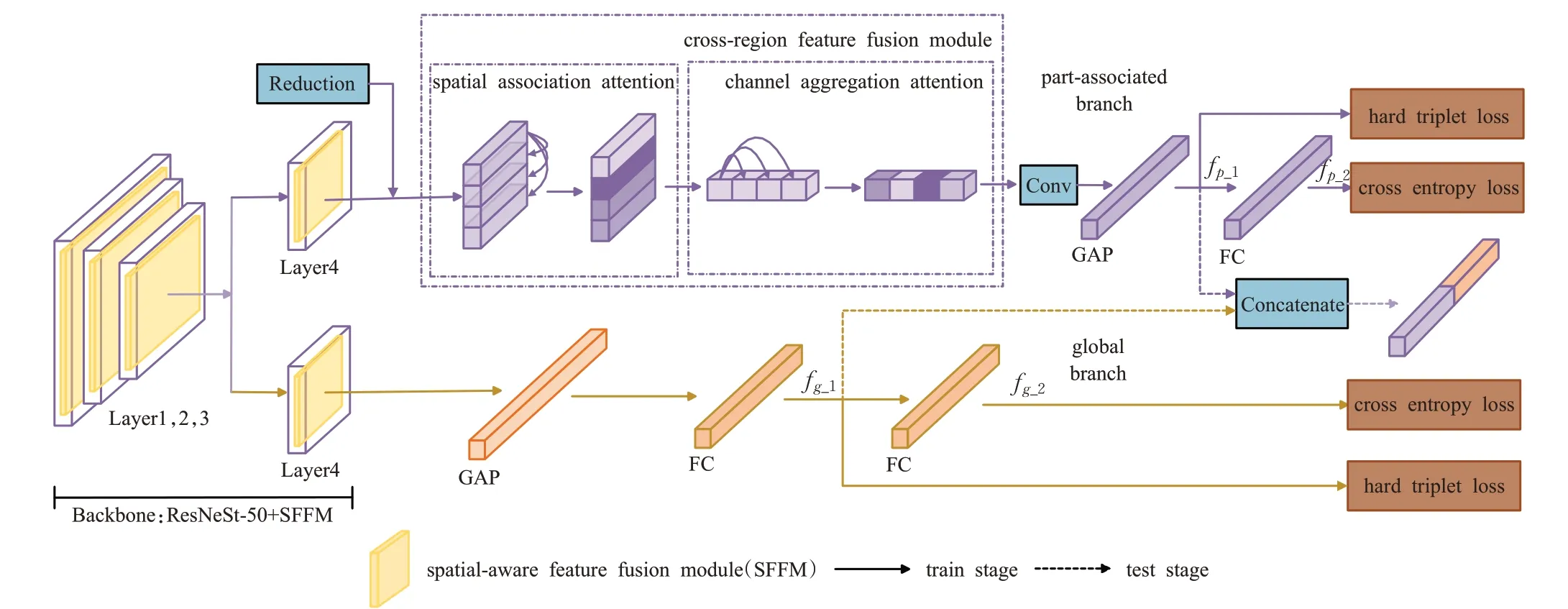

圖1給出了本文提出的行人重識別網絡結構圖,與單純使用ResNeSt-50不同的是,在ResNeSt-50的每個split-attention block中融入了空間感知特征融合模塊,目的是對不同的特征圖進行跨通道關聯之前,讓每一個特征圖經過一個共享權重的空間域注意力模塊,這樣能夠幫助網絡先挑選重要的特征并抑制無關的噪聲,進一步增強特征魯棒性的同時加快網絡的收斂。

圖1 算法網絡框架Fig.1 Algorithm network framework

基于全局特征的單流網絡結構能夠從圖像中提取行人身上顯著的辨別特征,來區分不同身份的行人,但是單流結構無法提取關鍵的非顯著性特征,而且學習到的特征容易受背景信息的干擾,在面對遮擋、行人姿態變化等問題時很難完成行人身份的分類[19]。為了解決這個問題,多分支結構被廣泛應用在行人重識別任務中,通過多個分支學習不同粒度信息來獲得更強大的行人表征,例如雙流結構以及三分支結構等[20]。雖然多分支結構能夠挖掘更豐富的語義信息,增強網絡的檢索能力,但同時也加大了網絡訓練的難度,減慢了網絡的收斂。因此本文在設計網絡結構上,選用雙流網絡結構,這樣不僅可以通過多分支結構增強行人的特征表示,而且不會因為過多的網絡分支造成訓練難以收斂[21]。在圖1中,從ResNeSt-50 Layer1,2,3開始分開為兩個分支,分別是全局分支(global branch)以及部件關聯分支(part-association branch)。其中,全局分支強調學習行人整體的表征信息,部件關聯分支則強調學習行人各個身體部位的細粒度表征信息。在全局分支中,行人圖片通過ResNeSt-50 Layer1,2,3后,進入到ResNeSt-50 Layer4時使用下采樣,之后特征圖經過平均池化層,核大小為12×4,得到2 048維特征向量。該特征向量先通過一個全連接層,得到1 024維的輸出特征fg_1,fg_1在測試階段被視為行人圖片的全局特征,在訓練階段用來計算硬三元組損失。接著,fg_1進入一個全連接層得到輸出特征fg_2,此特征向量在訓練階段用來計算交叉熵損失。在部件關聯分支中,與全局分支不同的是進入到ResNeSt-50 Layer4時為了保留足夠的語義信息,沒有使用下采樣,之后特征圖經過降維層(Reduction)后進入跨區域特征融合模塊,讓每個身體部位的特征融合到其他身體部位來增強局部特征的豐富性,使得網絡能夠自適應地關注到圖片中的行人區域,減少背景噪聲的干擾。模塊生成的各個局部特征先通過一個卷積塊進行特征融合,再經過平均池化層得到1 024維的輸出特征fp_1,其在測試階段被視為行人圖片的局部特征,在訓練階段用來計算硬三元組損失。接著,fp_1進入一個全連接層得到輸出特征fp_2,此特征向量在訓練階段用來計算交叉熵損失。網絡將行人圖片的全局特征fg_1與局部特征fp_1按通道方向拼接在一塊,組成2 048維特征向量ftotal作為行人圖片的特征表示,如公式(1)所示:

1.2 空間感知特征融合模塊

由于ResNeSt網絡結構中融入了基于通道的注意力機制,因此能夠捕獲跨通道的潛在語義信息,獲得更加精細化的行人表征。在行人重識別任務中,除了利用通道間的相互作用來增強特征的區別力之外,還可以捕獲空間域的重要特征信息,增強網絡學習行人特征表示的辨別能力,提升算法精度。鑒于以上分析,采用軟注意力機制,抑制特征圖中的噪聲,引導網絡關注對識別行人身份起到關鍵作用的空間位置,從而為后續的跨通道交互起到互補作用。

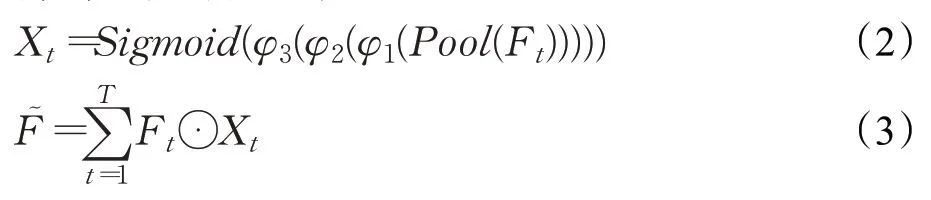

給定在ResNeSt的某一個Bottleneck中分組卷積后輸出的特征映射組F={F1,F2,…,FT},即該分組卷積的結果有T個特征圖。如圖2(b)所示,輸入的每一個特征圖都先經過一個共享權重的空間注意力塊(spatial attention block)來優化空間信息,最后將每一個優化后的特征圖進行累加融合,其結果作為跨通道交互的輸入特征。在圖2(a)中,空間注意力塊的輸入特征先通過一個按通道方向取每個特征位置平均值的全局池化層(Pool),從而得到通道數為1的三維特征向量,再經過三個3×3卷積層(φ1、φ2、φ3)來擴大感受野,捕獲更豐富的空間信息,利用Sigmoid函數將卷積操作后的特征向量映射成空間注意力矩陣Xt,輸入特征與該注意力矩陣點乘后的結果通過一個殘差結構得到優化過空間信息的特征圖。特征映射組F經過此空間感知特征融合模塊后得到融合特征,如公式(2)、公式(3)所示:

圖2 空間注意力塊和空間感知特征融合模塊Fig.2 Spatial attention block and spatial-aware feature fusion module

1.3 跨區域特征融合模塊

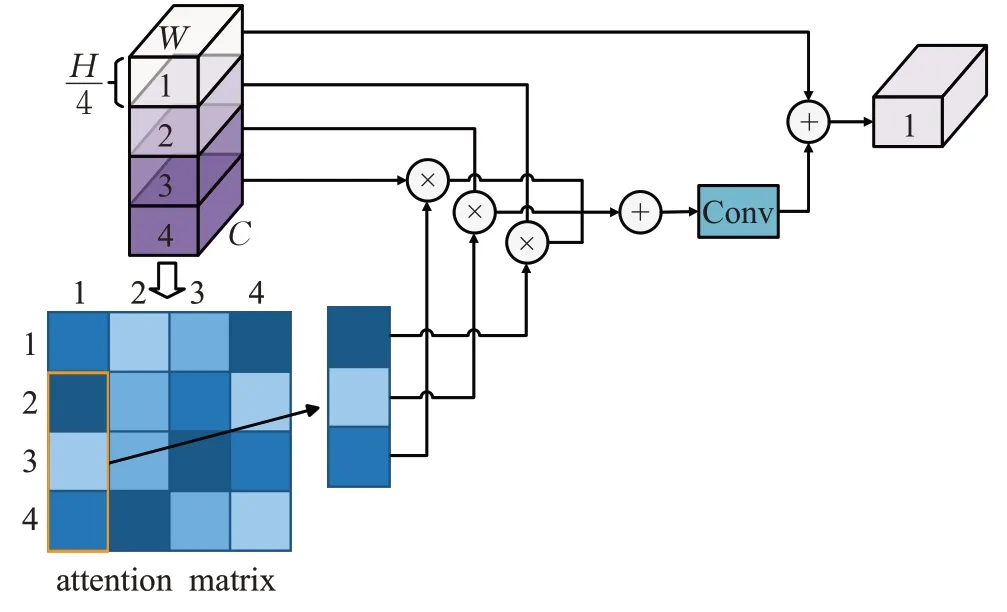

最近的一些工作表明基于局部特征學習的方法有助于挖掘行人精細化表示,減少因遮擋產生的噪聲[11]。相比于其他方法將特征圖水平劃分為若干個區域并對這些區域采用池化方法來直接獲得局部特征不同,本文方法基于非局部注意力機制,充分考慮不同身體部件之間潛在的語義相關性,通過遍歷融合不同部位的局部特征來挖掘關鍵的非顯著性信息。數據經過ResNeSt-50 Layer1,2,3之后,進入部件關聯分支學習細粒度局部特征,通過ResNeSt-50 Layer4,進入跨區域特征融合模塊學習不同身體部位之間的潛在語義信息,該模塊分為空間關聯注意力以及通道聚合注意力兩個子模塊。給定輸入特征P∈RC×H×W,其中C是特征圖的通道總數,H和W分別是特征圖的高和寬。首先把P水平劃分為K個特征區域Pi∈RC×(H/K)×W,將這些特征區域經過空間關聯注意力子模塊,利用不同身體部件之間的空間位置的相關性進行局部特征融合來得到輸出特征Ps_i,再將這些特征輸入到通道聚合注意力子模塊學習通道域中不同身體部件之間的非顯著信息,最后得到精細化行人局部特征Ps_c_i。通過聯合行人的細粒度全局特征和細粒度局部特征,行人特征的完整性以及豐富性得到進一步提升,網絡的檢索能力也因此大大增強。在圖1中展示了跨區域特征融合模塊的框架結構,對其各個子模塊的詳細說明如下。

1.3.1 空間關聯注意力子模塊

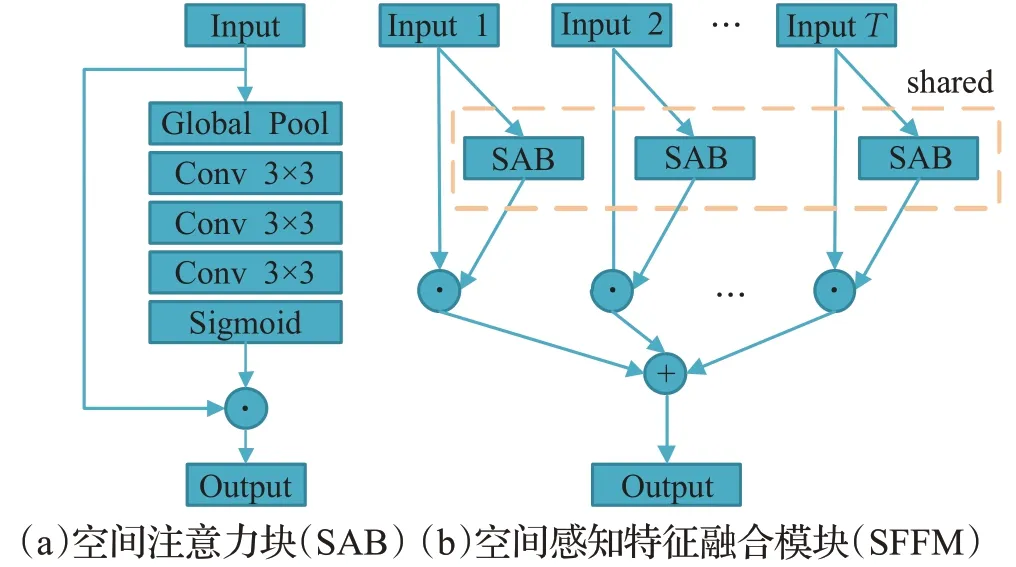

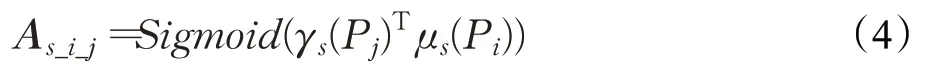

水平劃分的局部特征Pi∈RC×(H/K)×W首先拼接成完整特征圖P∈RC×H×W,再讓特征圖P通過兩個1×1卷積層(γs,μs)進行降維得到兩個輸出特征,對這兩個特征進行reshape操作后的結果分別進行矩陣乘積以及Sigmoid激活函數得到空間注意力系數矩陣As。為了挖掘局部特征的空間域相關性,根據Pi與Pj在特征圖P中的位置,即可從系數矩陣中找到Pj對應于Pi的空間相關系數子矩陣As_i_j,如公式(4)所示:

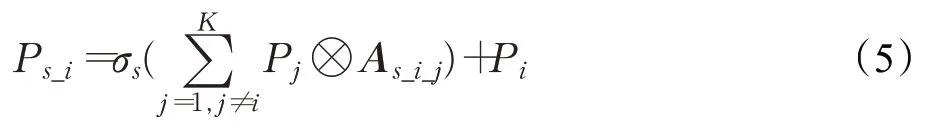

由于單個局部特征內部的相關性較高而局部特征之間的相關性較低,為了挖掘到更多關鍵但非顯著的重要特征,在特征融合操作時沒有將局部特征本身的空間相關性As_i_i計算在內。在圖3中,特征融合操作通過殘差結構和一個1×1卷積層(σs)得到局部特征Pi的對應輸出特征,如公式(5)所示:

圖3 空間關聯注意力Fig.3 Spatial association attention(SAA)

1.3.2 通道聚合注意力子模塊

在行人重識別任務中,高層特征的通道往往有很強的相關性,一些通道共享相似的語義信息,例如衣服、鞋子、褲子、背景等。通過挖掘每個局部特征與其他局部特征之間的通道相關性來進行特征融合,增強重識別特征的豐富性與多樣性。

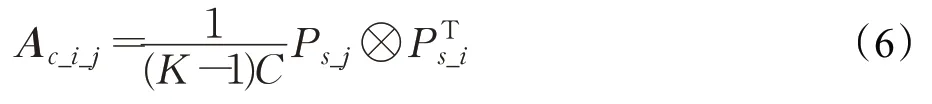

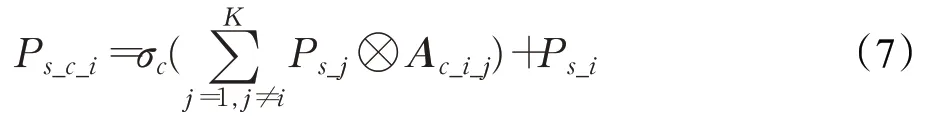

從空間關聯注意力子模塊輸出的特征圖Ps_i按通道方向拼接成完整特征圖,將Ps與自身reshape操作后的特征圖進行矩陣乘積再通過歸一化得到通道注意力系數矩陣Ac。為了挖掘局部特征的通道域相關性,根據Ps_i與Ps_j在特征圖Ps中的位置,即可從系數矩陣中找到Ps_j對應于Ps_i的通道相關系數子矩陣Ac_i_j,如公式(6)所示:

同樣考慮到局部特征內部的相關性較高而局部特征之間的相關性較低,在特征融合操作時沒有將局部特征本身的通道相關性Ac_i_i計算在內。特征融合操作通過殘差結構和一個1×1卷積層(σc)得到局部特征Ps_i的對應輸出特征,如公式(7)所示:

1.4 損失函數

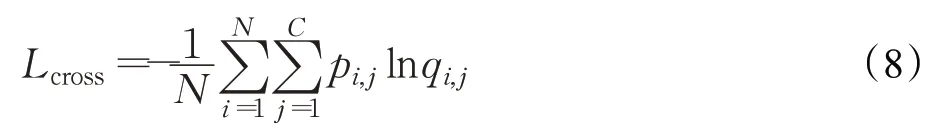

為了在訓練過程中讓網絡學習到有身份鑒別力的特征,使用交叉熵損失(cross entropy loss)作為損失函數之一。交叉熵損失用來度量網絡預測類別分布與真實類別發布的差異性,被廣泛應用于機器學習以及深度學習的分類問題當中。在行人重識別任務中使用交叉熵損失意味著將重識別問題轉化為分類問題,即給定一張行人圖片,判斷它屬于哪個身份并把它歸到那一類別。通過將身份信息作為監督信號,能夠有效地引導網絡學習到具有身份鑒別力的特征表示,保證在訓練過程網絡能夠平穩收斂。然而,行人重識別本質上是一個圖像檢索問題,它通過比較查詢圖片與候選圖片之間的特征相似性進行排序,排名越靠前的圖片越有可能是與查詢圖片具有相同的身份。度量學習,即相似度學習,近幾年被廣泛應用在模式識別領域,它采用神經網絡進行訓練,目標是使得不同類別的圖片相似度小而相同類別的圖片相似度大。因此,將硬三元組損失(hard triplet loss)[22]作為另一個損失函數來引入度量學習。網絡將原始像素域信息映射到編碼空間,硬三元組損失通過拉近相同類別圖片距離的同時加大不同類別圖片的距離來達到聚類的效果,因此基于硬三元損失的模型更適用于行人重識別領域。由于僅僅依靠硬三元組損失進行模型訓練會缺乏身份監督信號,導致訓練過程緩慢,因此聯合交叉熵損失與硬三元損失作為模型的損失函數,這樣不僅引入了身份監督信號,能夠學習到具有身份鑒別力的特征,加速網絡的平穩收斂,而且拉近了同類圖片距離的同時加大不同類別圖片的距離,提升了檢索性能。

對于交叉熵損失,本文的目標是減少預測標簽分布與真實分布的差異性來學習行人的身份鑒別力特征。在圖1中,把網絡學習到的特征fp_2與fg_2用于計算交叉熵損失。交叉熵定義如公式(8)所示,其中N表示一個批次行人圖片總數,C表示訓練集行人標簽總數,qi,j表示預測的標簽概率,pi,j表示真實的標簽。

對于硬三元組損失,本文的目標是讓距離最遠的相同標簽的行人圖片距離小于最近的不同標簽的行人圖片距離來提升檢索的準確性。在圖1中,把網絡學習到的特征fp_1與fg_1用于計算硬三元組損失。硬三元組損失定義如公式(9)所示,其中分別是采樣得到的錨、積極以及消極特征,這里的積極是指與錨具有相同的標簽,消極是指與錨的標簽不同,P指的是一個批次采樣的行人標簽總數,R表示對一個行人標簽采樣的圖片個數,m是用來約束不同類別樣本距離的閾值。

2 實驗

2.1 數據集

本文使用的數據集是在行人重識別任務中廣泛使用的Market-1501、DukeMTMC-reID以及CUHK03。

Market-1501數據集是在清華大學校園內通過5個高分辨率攝像頭和1個低分辨率攝像頭拍攝到的1 501個行人、32 668張行人圖片。數據集提供訓練集以及測試集的劃分,其中訓練集包含751個行人、12 936張行人圖片,測試集包含750個行人、19 732張行人圖片,每類圖片最少被2個攝像頭拍攝到。

DukeMTMC-reID數據集是在杜克大學校園內通過8個高分辨率攝像頭拍攝到的1 812個行人、36 411張行人圖片。數據集提供訓練集以及測試集劃分,其中訓練集包含702個行人、16 522張行人圖片,訓練集包含702個行人、17 661張行人圖片,并且提供了手工標注的邊界框(bounding box)。

CUHK03數據集是在香港大學校園內通過5對攝像頭拍攝到的1 467個行人、14 097張行人圖片,提供檢測器檢測(Detected)和人工標注(Labeled)兩個數據集。采取新的測試協議,將訓練集和測試集中行人個數分別劃分為767和700。相比于舊版本,新測試協議的訓練圖片大大減少而測試圖片大大增加,因此加大了重識別的難度。

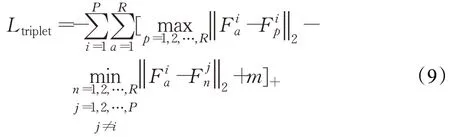

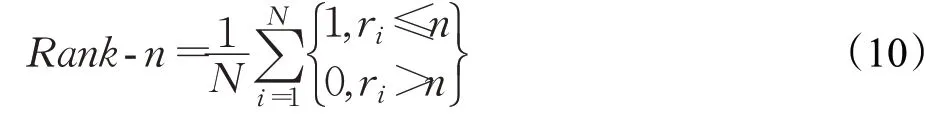

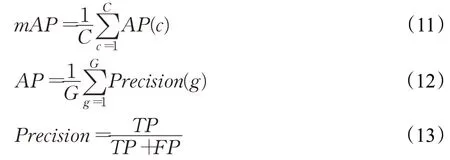

選擇第n次命中準確率(Rank-n)以及平均匹配度(mAP)作為網絡在數據集上測試效果的評價指標。Rank-n表示待查詢圖像與候選庫圖像按照相似度從大到小排序的前n張候選圖片中存在與查詢圖像屬于同一身份的準確率,計算如公式(10)所示,其中N表示查詢數據集中行人的數目,即總共進行N次查詢和排序,ri表示在按相似度排序后的候選圖片中第一個與查詢圖片屬于同一身份的行人圖像的位置。

mAP計算公式如公式(11)所示,其中C表示行人身份的類別數,AP(c)表示行人身份c的平均精度。平均精度是指同一個類別的每個待查詢行人圖像的精確率累加之和與該類樣本總數G的比值,AP的計算如公式(12)所示。精確率Precision指的是檢索出來的正樣本中正確的比例,Precision計算如公式(13)所示,其中TP表示被預測為正樣本,實際上也是正樣本的樣本數目,FP表示被預測為負樣本,實際上是正樣本的樣本數目。

在所有實驗中,不使用重新排序(re-ranking)算法以及多次查詢融合(multi-query fusion)進一步提升評價性能。

2.2 實施細節

遵循常見的行人重識別設置,將所有圖像的大小調整為384×128,并通過隨機翻轉、隨機裁剪和隨機擦除來增強訓練圖像。使用在ImageNet[23]上預訓練的ResNeSt-50作為骨干網絡,在其網絡結構中去掉最后的全局平均池化以及全連接層。為了在部件關聯分支中保留足夠的語義信息,把Layer4下采樣層中平均池化的核大小設置為1×1,stride設置為1。使用Adam作為梯度優化器,將學習率初始設置為0.000 3,并在訓練階段的第30輪以及第60輪衰減10倍直至訓練結束。批量大小設置為64,P=16,R=4,T=2,m=0.3,K=4。使用兩階段遷移學習算法來訓練網絡參數,首先凍結骨干網絡的權重,僅僅訓練分類器150輪,然后將整個網絡再訓練300輪。本文方法在pytorch框架上實現,并在一塊3.6 GHz的Intel i9-9900KF CPU和NVIDIA TITAN RTX GPU環境下訓練,所有數據集共享與上述相同的實驗設置。

2.3 現有方法的對比實驗

在本節中,將提出的方法與現有的最先進方法在三個主流數據集上進行對比來表明本文方法的優越性能,具體在每個數據集上的情況說明如下。

2.3.1 Market-1501

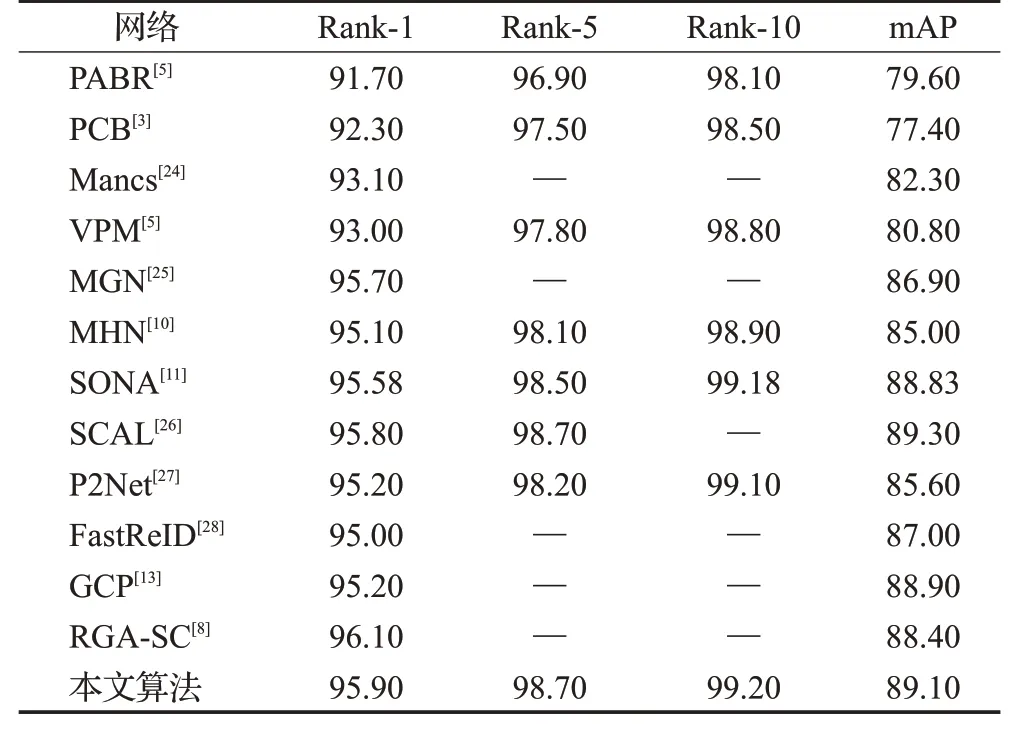

表1中展示了在該數據集上本文提出的方法與現有最先進方法的比對結果,在該數據集上實現了95.9%Rank-1、98.7%Rank-5、99.2%Rank-10以及89.1%mAP。

表1 在Market-1501數據集上的對比結果Table 1 Results comparisons over Market-1501 %

對比使用單一局部特征的PCB,本文方法挖掘局部特征之間的相關性來增強行人表征的豐富性,分別在Rank-1和mAP提高3.6和11.7個百分點。對比同樣把ResNeSt-50作為骨干網絡的FastReID,本文方法分別在Rank-1和mAP提升了0.9和2.1個百分點,這得益于本文結合注意力以及局部特征融合的方法,增強重識別特征多樣性的同時提高了其魯棒性。GCP雖然充分地考慮身體各部位之間的相關性來挖掘具有身份鑒別力的特征,但是直接地水平劃分身體部件區域會導致邊界粗糙,本文提出的方法在局部關聯分支劃分身體部件之前已經通過一系列軟注意力機制來優化邊界特征,分別在Rank-1和mAP性能提升了0.7和0.2個百分點。

2.3.2 DukeMTMC-reID

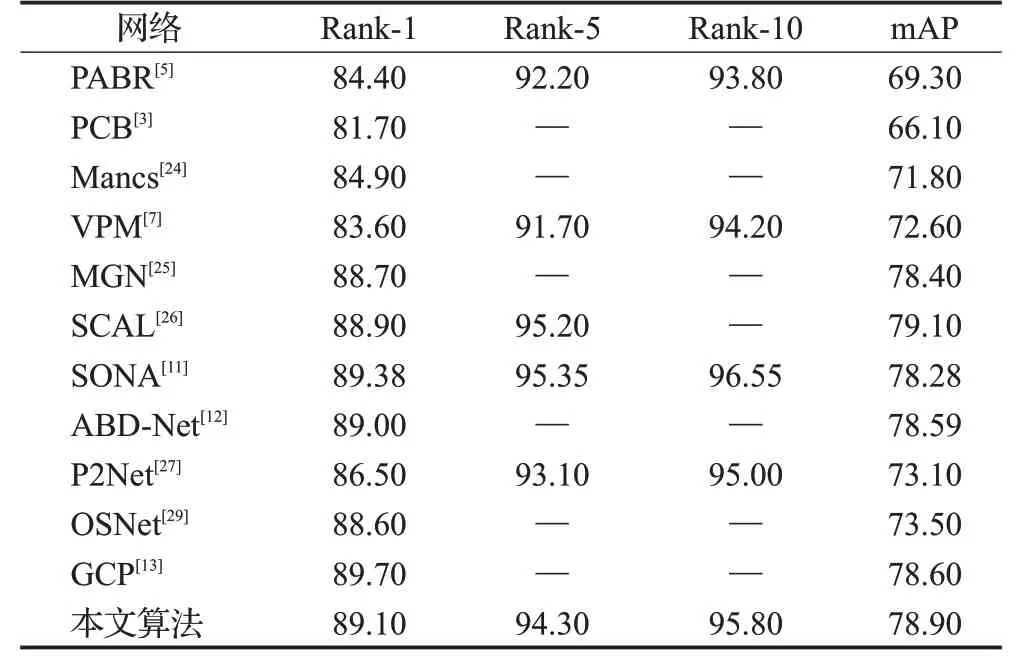

在表2中,本文方法在該數據集上達到了89.1%Rank-1、94.3%Rank-5、95.8%Rank-10以及78.9%mAP。

表2 在DukeMTMC-reID數據集上的對比結果Table 2 Results comparisons over DukeMTMC-reID %

和只考慮局部特征的PCB相比,本文模型聯合全局特征以及局部特征來提升行人表征的完整性,分別在Rank-1和mAP提高了7.4和12.8個百分點。P2Net雖然充分挖掘行人以及外部裝飾的特征來提升精度,但是網絡的關注區域容易被行人圖片的背景所干擾,本文方法分別在Rank-1、Rank-5、Rank-10以及mAP提高了2.6、1.2、0.8、5.8個百分點。和充分考慮身體各個部位與其他部位之間的關系的GCP相比,本文模型在Rank-1上低了0.6個百分點,但在mAP上提高了0.3個百分點,這是由于該數據集的行人圖片被遮擋現象嚴重,存在較多的背景干擾,GCP在該數據集上的魯棒性比較強。

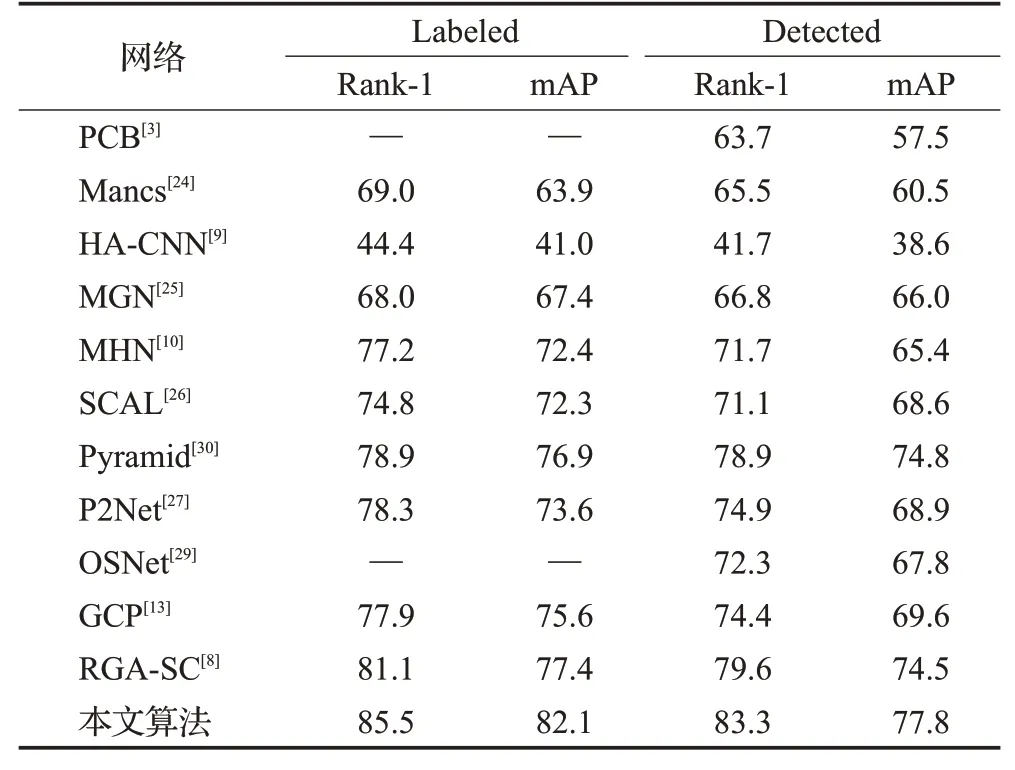

2.3.3 CUHK03

該數據集的標注分為檢測器檢測(Detected)與人工標注(Labeled)兩種。在Labeled數據集中,本文方法達到了85.5%Rank-1和82.1%mAP,在Detected數據集中,該方法達到了83.3%Rank-1和77.8%mAP,如表3。

本文方法在這兩個數據集上的性能大大超過其他方法,在Detected數據集Rank-1、mAP上提高了3.7和3.3個百分點,在Labeled數據集Rank-1、mAP上提高了4.4和4.7個百分點。本文方法與僅提取局部特征的PCB相比,在Detected數據集Rank-1、mAP上提高了19.6和20.3個百分點。對比同樣考慮身體部件關聯的GCP,將其原有性能提高了大約10個百分點,這得益于本文模型提取的細粒度全局特征以及細粒度局部特征,提高了行人表征的鑒別力,提高了重識別特征的完整性。

2.4 消融實驗

為了驗證本文提出的每個注意力模塊的有效性以及探索局部特征劃分個數的問題。在Market-1501、DukeMTMC-reID和CUHK03這三個數據集上設計了幾個不同設置的消融實驗。

表3 在CUHK03數據集上的對比結果Table 3 Results comparisons over CUHK03 %

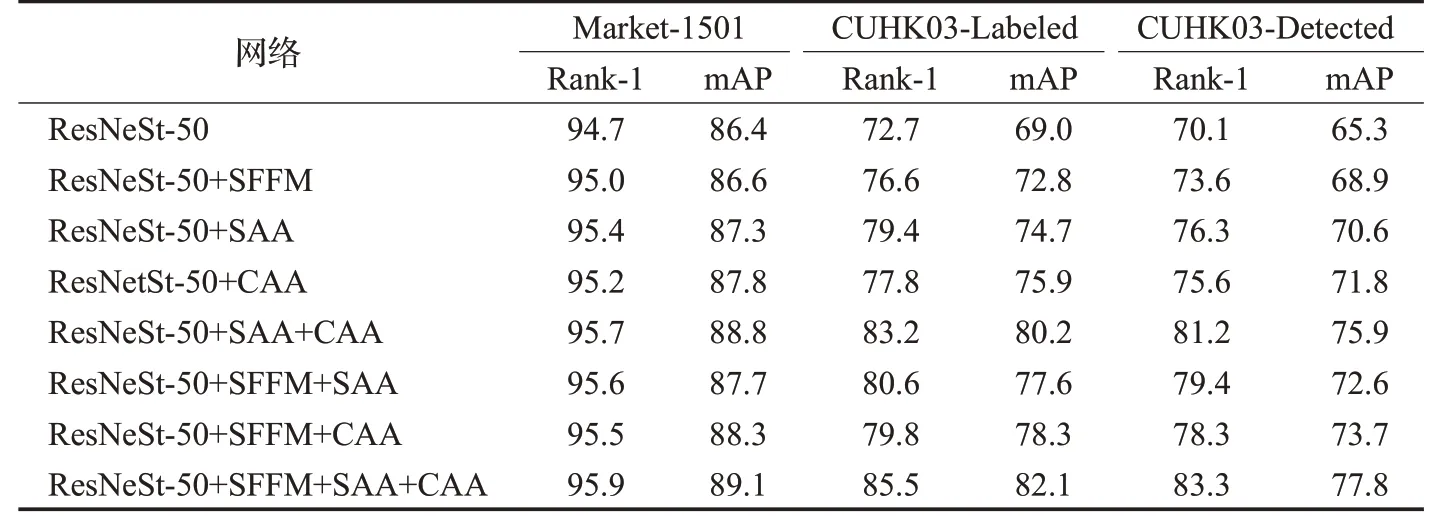

首先驗證注意力模塊的有效性,實驗的具體設置顯示在表4中,其中SFFM表示空間感知特征融合模塊,SAA表示跨區域特征融合模塊中的空間關聯注意力子模塊,CAA表示跨區域特征融合模塊中的通道聚合注意力子模塊。在表格的前兩行可以看到,為了驗證SFFM的有效性,在ResNeSt的split-attention block結構中融入SFFM顯著提高了行人重識別的性能,在CUHK03-Labeled的Rank-1和mAP上提升3.9和3.8個百分點,在CUHK03-Detected的Rank-1和mAP上提升3.5和3.6個百分點。為了驗證不同特征融合模塊對模型性能的影響,在第三、四行分別對ResNeSt-50結構中增加SAA以及CAA,可以看到不管是SAA還是CAA都有助于模型性能的提升。實驗結果表明,將SAA融入ResNeSt-50結構后,在CUHK03-Labeled的Rank-1和mAP上提升6.7和5.7個百分點,在CUHK03-Detected的Rank-1和mAP上提升6.2和5.3個百分點,這得益于空間關聯子模塊將不同身體部位進行關聯,來學習身體部件之間的空間位置的相關性,增強局部特征的鑒別力。將CAA融入ResNeSt-50結構后,在CUHK03-Labeled的Rank-1和mAP上提升5.1和6.9個百分點,在CUHK03-Detected的Rank-1和mAP上提升5.5和6.5個百分點,這得益于通道聚合子模塊通過挖掘局部特征與其他局部特征的通道相關性,來加強學習局部特征之間的非顯著性信息。第五行將它們聯合使用,進一步提高了精確度。為了驗證軟注意力(SFFM)與非局部注意力(SAA、CAA)的互補作用,從第六行開始分別對它們不同的組合進行實驗,可以看到無論哪一種組合都比舍棄對應模塊的性能要強得多。最后一行將所有模塊組合在一起,實驗結果表明它在這兩個數據集上達到最先進的性能。整個模型在CUHK03-Labeled的Rank-1和mAP上相較于單流網絡ResNeSt-50分別提升了12.8和13.1個百分點,在CUHK03-Detected的Rank-1和mAP上相較于單流網絡ResNeSt-50分別提升了13.2和12.5個百分點,這表明全局分支與部件關聯分支具有互補作用,通過聯合網絡分支結構學習到的細粒度全局特征與細粒度局部特征,提高了重識別特征的完整性與準確性,極大程度增強了模型的檢索性能。

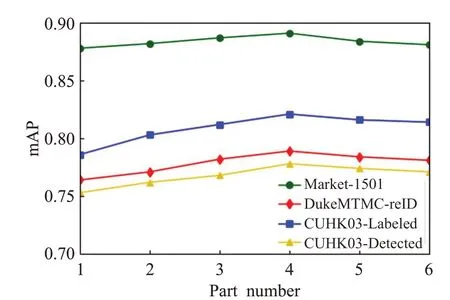

其次,研究了部件關聯分支中身體部件劃分個數對模型性能的影響,在圖4中展示了不同身體部件劃分個數的模型在不同數據集上mAP指標的變化。可以看到隨著部件數量的增加,mAP在不同數據集上的趨勢都是先逐步升高再緩慢下降,當部件數量設置為4時在各個數據集上的性能達到最高。這個觀察結果表明,局部特征的劃分個數會直接影響模型的性能,過少的部件數不能充分提取細粒度局部特征而過多的部件數會減弱部件關聯分支的效果,進而降低特征表達的能力。

圖4 不同部件數量的對比實驗Fig.4 Comparative experiment of different part numbers

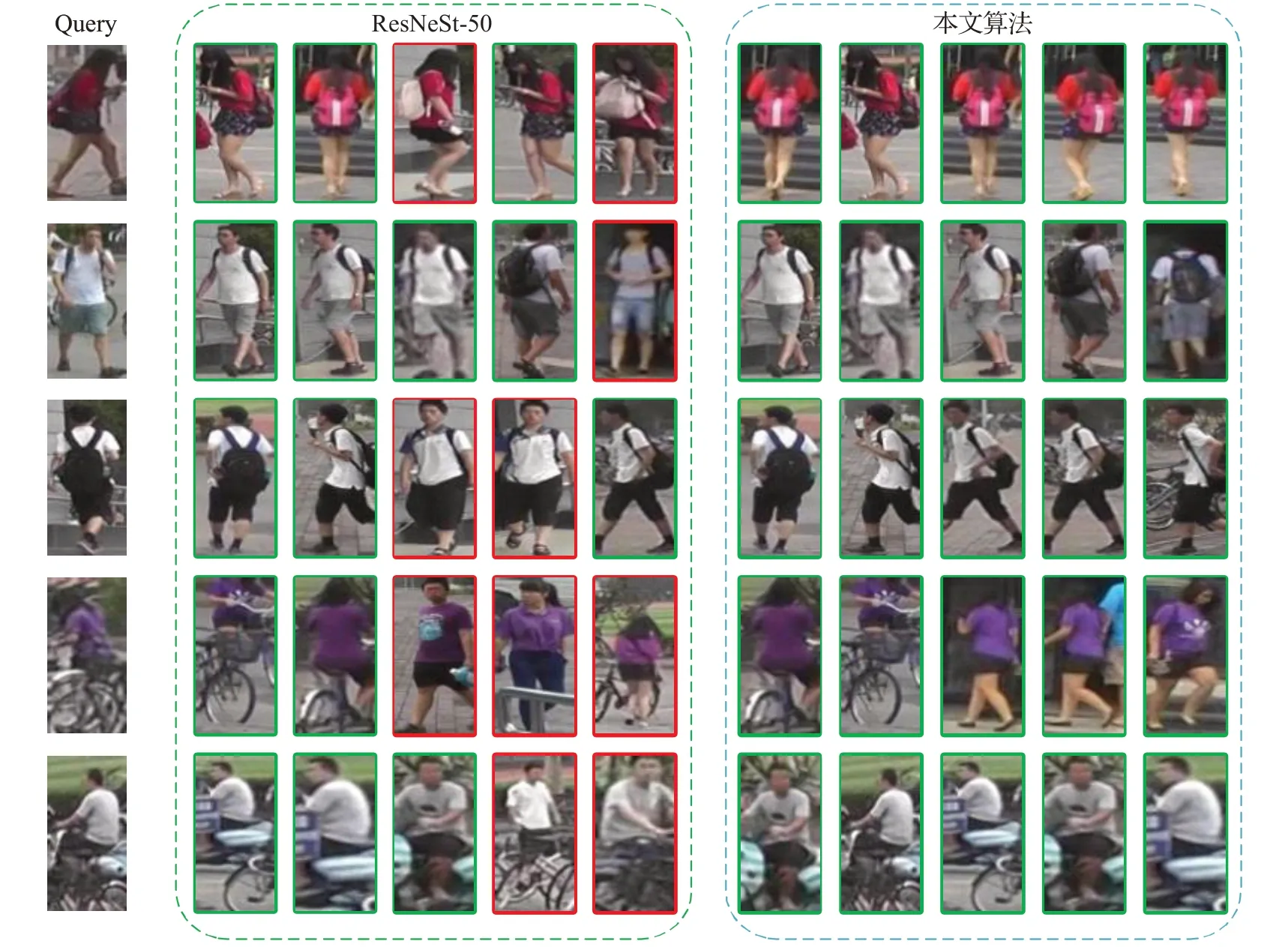

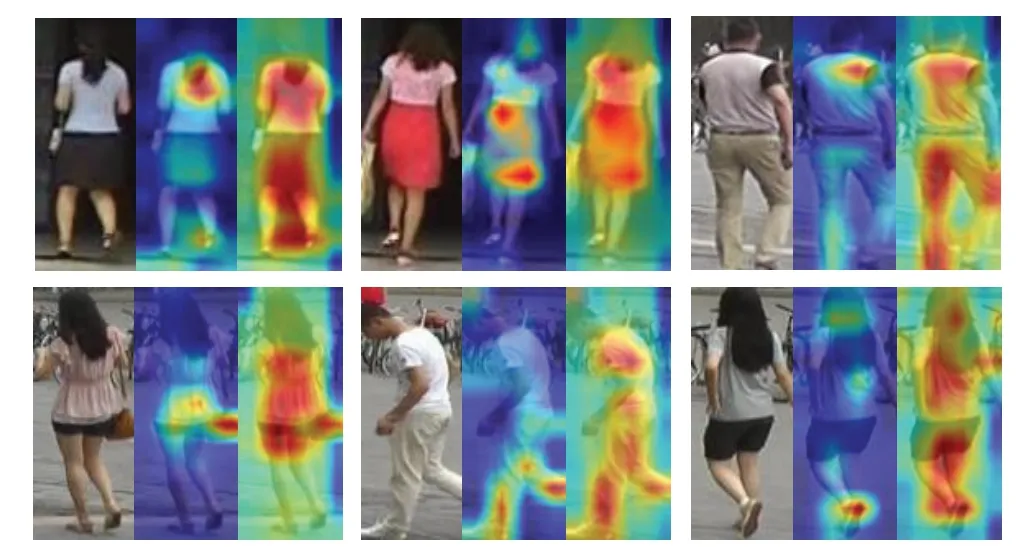

接著,利用Grad-Cam[31]可視化了一些圖像在不同模型中關注的區域情況。如圖5所示,第1列為輸入到模型的原始圖像,第2列和第3列分別是ResNeSt-50和本文提出的模型的圖像熱力圖。在圖5中,和ResNeSt-50相比,本文模型的關注區域更集中在行人身上以及覆蓋區域更廣,這是因為通過聯合軟注意力和非局部注意力機制來挖掘更多的全局信息,提升了關注區域的豐富性,還利用身體部件之間的關聯性來融合不同層次的語義信息,增強了關注區域的魯棒性。

表4 注意力模塊的消融實驗Table 4 Ablation experiment of attention modules %

圖6 Market-1501數據集部分圖像查詢結果Fig.6 Market-1501 dataset partial image query results

圖5 Market-1501數據集部分圖像熱力圖Fig.5 Market-1501 dataset partial image heatmap

圖6展示了在遮擋、背景雜亂、圖片分辨率低等復雜情況下ResNeSt-50與本文算法的一些查詢前5名的對比結果。第一、二、三排行人的查詢圖片在被背包遮擋的情況下,本文算法相較于ResNeSt-50仍然可以準確地檢索,這是由于本文算法融合了軟注意力以及非局部注意力機制,模型能夠發現更多具有鑒別力的行人特征,因此誤檢率更低。第四排、第五排查詢圖像在背景雜亂以及圖片模糊的情況下,本文算法相比于ResNeSt-50有更好的檢索性能,即使圖片出現較大的不對齊情況,仍然能找出對應圖片,這得益于部件關聯分支充分地挖掘局部特征之間的潛在語義關系,使得算法提取到的細粒度局部特征提升了行人表征的魯棒性與豐富性。

3 結束語

在本文中,基于ResNeSt-50骨干網絡,提出了結合注意力與局部特征融合的方法,通過兩個分支網絡,分別提取行人的細粒度全局特征和細粒度局部特征。通過聯合軟注意力以及非局部注意力機制挖掘更豐富的全局信息,讓網絡提取到的特征更具區分力,同時通過挖掘身體各個部件之間的潛在語義相關性,融合不同層次的語義信息,增強了行人表征的魯棒性與豐富性,通過聯合全局特征與局部特征的方法進一步提升了行人表征的完整性,提高了網絡的重識別性能。將ResNeSt網絡高效地應用在行人重識別任務,促進其在更多領域上的推廣。大量實驗證明,提出的每個注意力模塊的有效性以及提出的方法相較于現有方法的優越性。