基于特征子圖位平面切割和卷積神經(jīng)網(wǎng)絡(luò)的青光眼圖像分類

李振鵬,陳國明,孫艷寧,魏小花,李云蓉

(廣東第二師范學院計算機學院,廣州 510303)

0 引言

青光眼是一種常見的眼科疾病,患者通常表現(xiàn)為不同程度的視力下降和視野缺失,嚴重者甚至會喪失視力。據(jù)統(tǒng)計,2020 年全世界患青光眼的中老年人數(shù)約為7600 萬,在將來還會持續(xù)增長。青光眼的早期癥狀不明顯,有的患者表現(xiàn)為無癥狀,甚至發(fā)展到中后期才被確診。因此早發(fā)現(xiàn)、早診斷、早治療是治療青光眼的關(guān)鍵。

眼底照相是青光眼早期檢查的主要項目,通過觀察視盤與視杯的比例,即杯盤比是否有異常增大作為診斷的重要指標之一。這種診斷方式主觀性較強,通常依靠眼科醫(yī)生的經(jīng)驗判斷,如果杯盤比增大不明顯,則有可能造成誤診或漏診的情況。隨著深度學習的發(fā)展,計算機輔助診斷(CAD)逐漸應(yīng)用于臨床,有助于醫(yī)生對患者病情做出更加正確的判斷,提高工作質(zhì)量與效率。

為了降低青光眼早期誤診漏診的可能性,主要思路是提取青光眼病變特征,將正常與青光眼的眼底圖正確分類。卷積神經(jīng)網(wǎng)絡(luò)(CNN)是CAD 系統(tǒng)中被廣泛應(yīng)用的深度學習方法,在進行肺結(jié)節(jié)與前列腺癌的診斷中有著較高的準確率。Harangi提出了一個深度卷積神經(jīng)網(wǎng)絡(luò),結(jié)合另外四種卷積神經(jīng)網(wǎng)絡(luò)作為分類層的輸出,實現(xiàn)了將皮膚鏡圖像分類為黑素瘤、痣和脂溢性角化病三類。Ozawa等基于GoogleNet構(gòu)建了一個基于CNN 的CAD 系統(tǒng),并利用該系統(tǒng)對結(jié)腸鏡圖像進行訓(xùn)練,在分析潰瘍性結(jié)腸炎患者的疾病嚴重程度上表現(xiàn)穩(wěn)健,有望于投入臨床幫助醫(yī)生進行疾病的診斷。Chan 等對三種CNN網(wǎng)絡(luò)進行遷移學習以分類甲狀腺腫瘤,并進行了訓(xùn)練和測試。結(jié)果表明,CNN 網(wǎng)絡(luò)的診斷效果比醫(yī)生要好,訓(xùn)練的CNN 網(wǎng)絡(luò)能提高大多數(shù)甲狀腺癌的診斷準確性。Chougrad等提出了一種基于CNN 的乳腺癌分類器,通過遷移學習克服了數(shù)據(jù)量偏少所帶來的過擬合問題,達到了98.23%的準確率,并能夠判斷腫瘤是惡性還是良性。Patel 等利用兩種胃腸息肉的視頻序列訓(xùn)練CNN 模型,在判斷息肉類型是腺瘤性的還是增生性的結(jié)果與專科醫(yī)生的報告吻合較好。

醫(yī)學影像數(shù)據(jù)集是多種多樣的,相對于其他數(shù)據(jù)集而言,尚缺乏特定病癥的大型數(shù)據(jù)集,因此可用于深度學習的數(shù)據(jù)量較少。且圖像中存在著一定程度的噪聲干擾,不確定性較高,如何抵抗噪聲干擾并從較少的圖像數(shù)據(jù)中提取有效的隱藏信息成為提高青光眼識別準確率的關(guān)鍵。

Maheshwari 等提出了一種基于位平面分解的青光眼診斷方法,對圖像進行RGB 三通道分離并進行位平面分解,再利用局部二值模式對每個位平面提取紋理特征,再將這些特征分別輸入到三個不同的支持向量機進行分類,實驗表明在區(qū)分正常和青光眼病例方面是有效的。為了評估PET/CT 圖像區(qū)分非小細胞肺癌(NSCLC)的能力,Han 等比較了10 種機器學習模型和VGG16 深度學習方法,發(fā)現(xiàn)VGG16 算法優(yōu)于這些傳統(tǒng)機器學習方法。由于VGG16 網(wǎng)絡(luò)有較高性能,Montaha 等提出了一種基于VGG16 的網(wǎng)絡(luò)消融研究方法。以預(yù)處理后的乳腺X 光圖像作為數(shù)據(jù)集,評估該網(wǎng)絡(luò)與另外五種網(wǎng)絡(luò)的健壯性,研究表明,該網(wǎng)絡(luò)模型表現(xiàn)最佳。

本文主要提出了結(jié)合位平面分解和提取特征子圖兩種方法提取眼底圖特征,通過CNN 分類器實現(xiàn)青光眼與正常眼的分類。為了驗證提取圖像特征的健壯性和魯棒性,采用FGSM對原始眼底圖像進行對抗攻擊,再對攻擊后的圖像提取特征子圖和位平面分解,將位平面圖像分別輸入CNN 分類器中以抵御對抗攻擊,并比較攻擊后的原始圖像與對應(yīng)特征子圖位平面圖像之間的分類效果。

1 卷積神經(jīng)網(wǎng)絡(luò)分類器

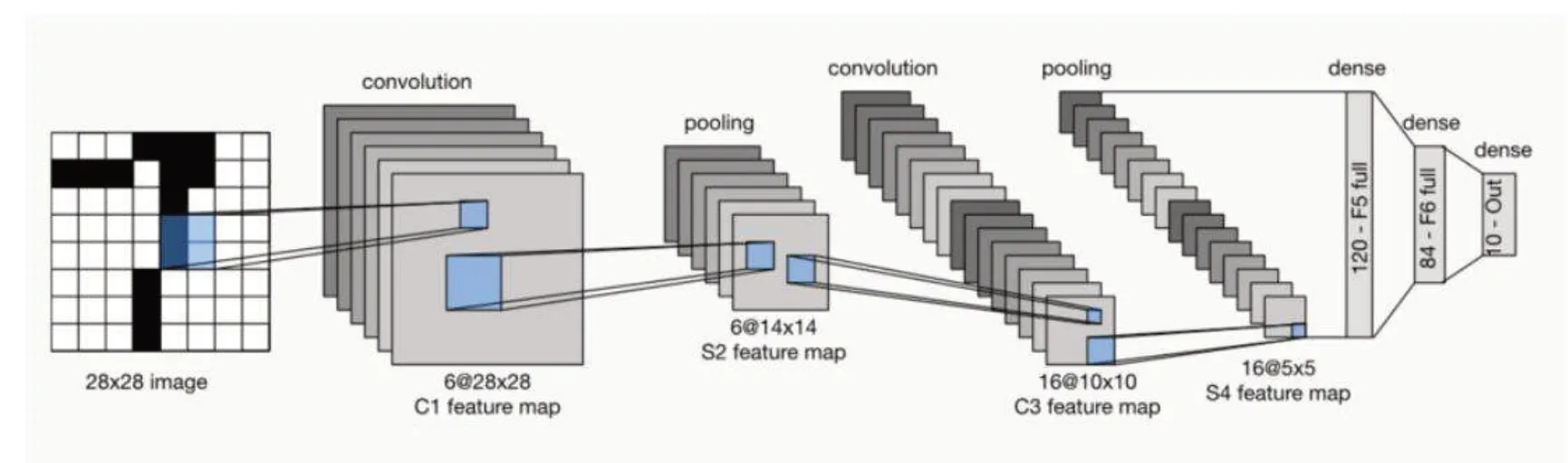

卷積神經(jīng)網(wǎng)絡(luò)(CNN)是一種包含卷積計算且具有深度結(jié)構(gòu)的前饋神經(jīng)網(wǎng)絡(luò),是深度學習的代表算法之一。圖1是卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)圖,該網(wǎng)絡(luò)簡化了對圖像的復(fù)雜前期預(yù)處理,可以直接將圖片作為網(wǎng)絡(luò)的輸入,自動對圖像提取特征,并且對圖片的變形具有高度不變性。實驗使用的卷積神經(jīng)網(wǎng)絡(luò)分類器共有三層卷積層,卷積核大小均為3x3,激活函數(shù)使用relu 函數(shù),池化層采用最大池化策略,大小為2x2,全連接層激活函數(shù)使用softmax函數(shù)。

圖1 CNN網(wǎng)絡(luò)結(jié)構(gòu)圖

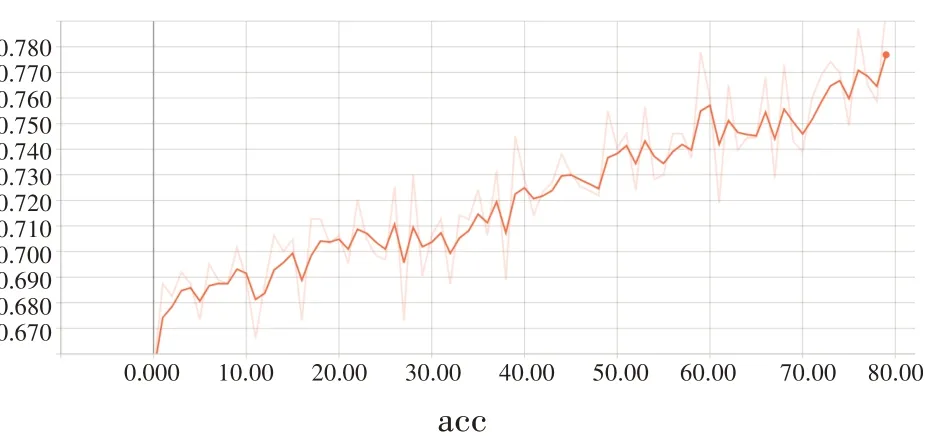

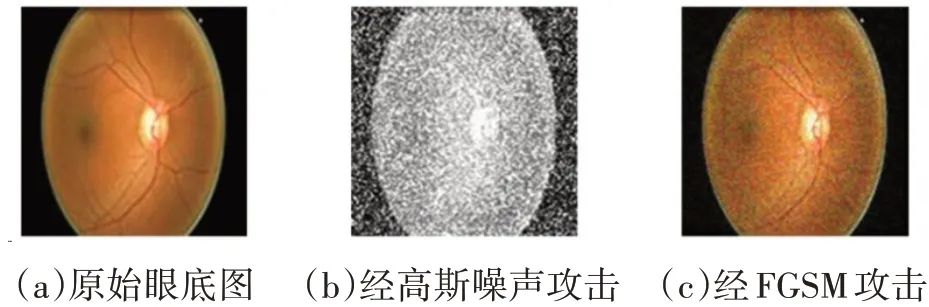

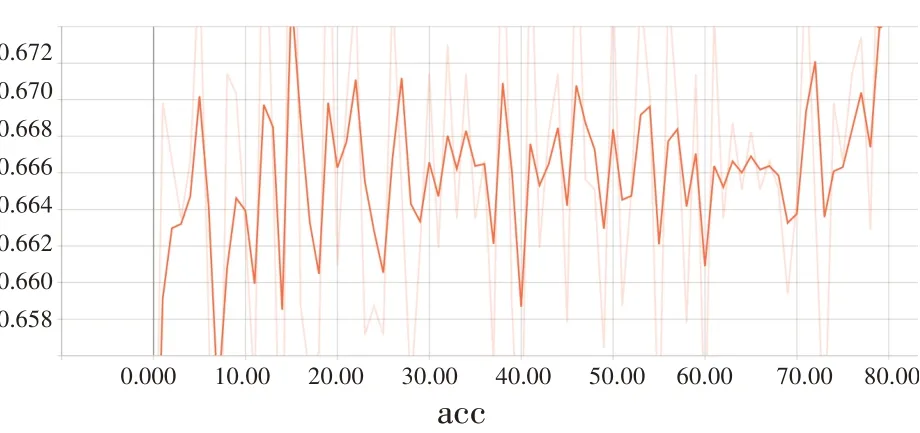

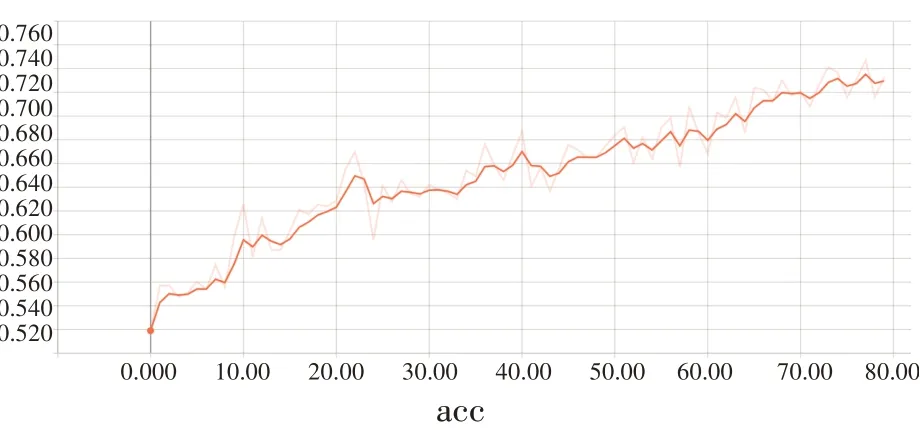

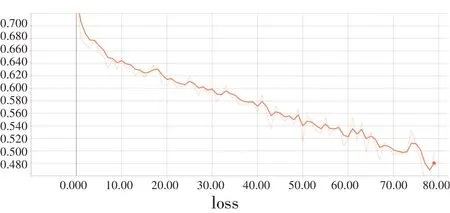

實驗采用公共醫(yī)學圖像眼底影像作為數(shù)據(jù)集,總體分為兩類,正常眼眼底與青光眼病變眼底。其中,正常樣本數(shù)為483,青光眼樣本數(shù)為167,把圖像分為訓(xùn)練集和測試集,比例為1 ∶1。將數(shù)據(jù)集輸入分類器中,經(jīng)過80次迭代得到識別準確率為77.6%,損失率為47.5%,如圖2、圖3 所示。實驗結(jié)果顯示,原始圖像的分類準確率較低,準確率曲線呈上升趨勢但未達到收斂狀態(tài),并不適宜投入臨床試驗,分類性能還有一定的提升空間。CNN 的分類性能受到迭代次數(shù)、網(wǎng)絡(luò)層數(shù)以及數(shù)據(jù)集的影響。本文以同一CNN 分類器作對比實驗,為了提高圖像識別率,采用位平面分解和生成特征子圖兩種手段對原始圖像進行特征提取。

圖2 原始眼底影像分類準確率

圖3 原始眼底影像分類損失率

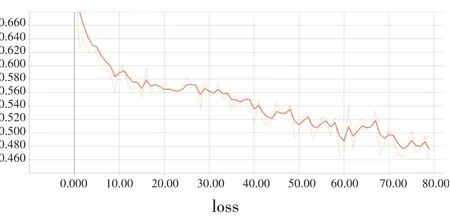

2 快速梯度符號方法

Goodfellow 等提出了快速梯度符號(Fast Gradient Sign Method,F(xiàn)GSM)圖像攻擊算法。該文指出,一張能被常規(guī)分類器分類為熊貓的圖片,通過添加由網(wǎng)絡(luò)梯度生成的攻擊噪聲后,看起來仍然是熊貓,但分類器卻將其分類為長臂猿。為了模擬醫(yī)學影像數(shù)據(jù)集遭遇噪聲攻擊的情況,分別利用高斯噪聲和FGSM對眼底圖像進行攻擊,攻擊效果如圖4所示。

圖4 對原始圖像進行攻擊

由圖4看出,經(jīng)過高斯攻擊后的圖像相對于原始圖像有著明顯差異,清晰度有所下降,部分圖像特征丟失。而經(jīng)過FGSM攻擊后的眼底圖像與原始圖像相似,仍能夠從圖像中觀測出原圖的整體特征。將兩種攻擊后的圖像輸入分類器中,分類準確率和損失率如圖5、圖6、圖7和圖8所示。

圖5 高斯攻擊圖像分類準確率

圖6 高斯攻擊圖像分類損失率

圖7 FGSM攻擊圖像分類準確率

圖8 FGSM攻擊圖像分類損失率

經(jīng)過高斯噪聲攻擊的圖像分類準確率為66.7%,與原始圖像相比下降了11.0%;經(jīng)過FGSM 攻擊后的圖像分類準確率為72.9%,下降了4.7%。結(jié)果表明,高斯噪聲攻擊會降低圖像質(zhì)量,干擾噪聲會影響圖像分類準確率。FGSM相較于高斯噪聲攻擊而言,其隱蔽性更強,能在肉眼無法分辨的情況下對圖像進行攻擊,更容易被惡意利用,在該種情況下,分類器的分類性能與人工觀測判斷相比有著明顯劣勢。如何在受到噪聲干擾的圖像數(shù)據(jù)集中提取出有效的圖像特征,成為抵御攻擊、提高圖像識別準確率的關(guān)鍵。

3 特征子圖

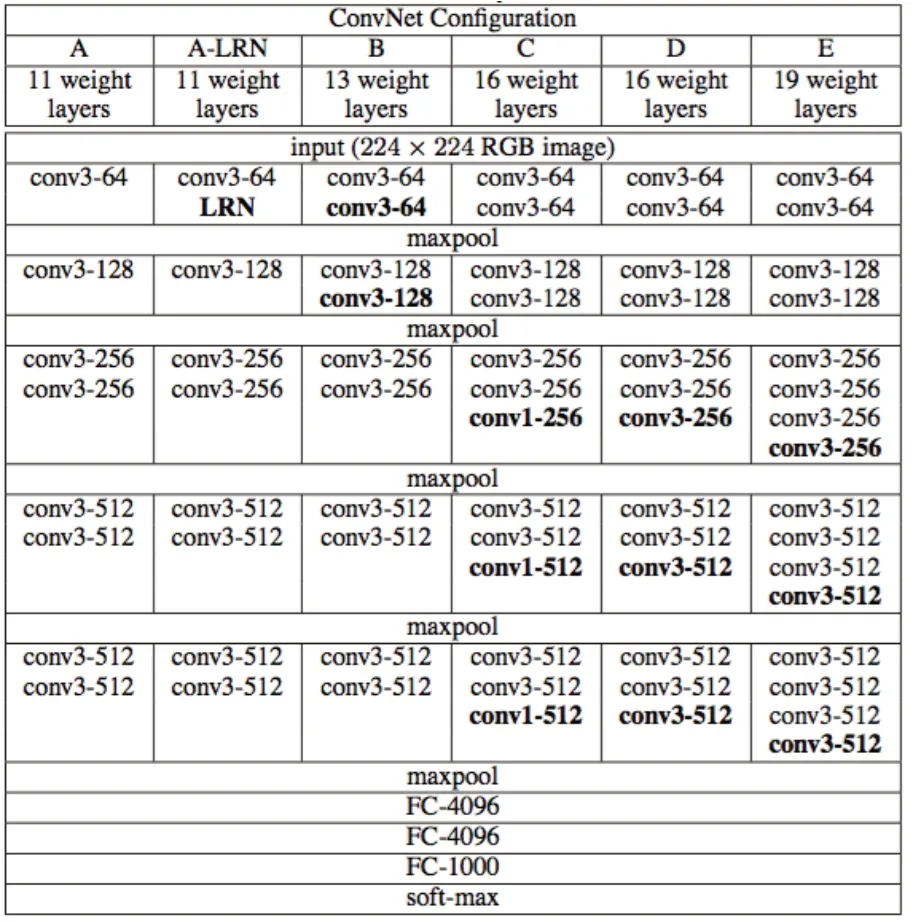

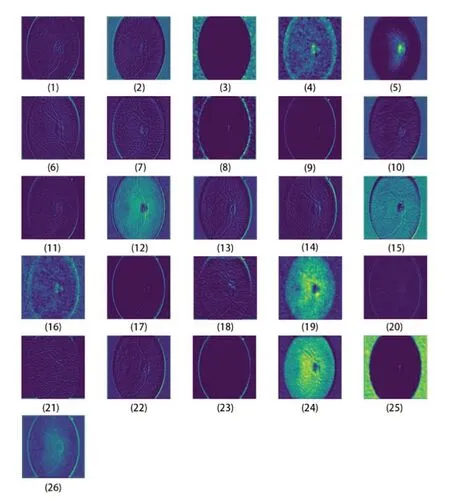

VGG16網(wǎng)絡(luò)是2014 年牛津大學和Google DeepMind 公司聯(lián)合研發(fā)的深度網(wǎng)絡(luò)模型,該網(wǎng)絡(luò)一共有16 個訓(xùn)練參數(shù),由13 層卷積層和3 層全連接層組成。VGG 網(wǎng)絡(luò)能將輸入的圖像提取出25 張?zhí)卣髯訄D,以及25 張?zhí)卣髯訄D融合后的一張整體特征圖,每張圖像共生成26 張圖像,形成了一個新的數(shù)據(jù)集。VGG16 網(wǎng)絡(luò)及其生成的特征子圖分別如圖9、圖10所示。

圖9 VGG16網(wǎng)絡(luò)

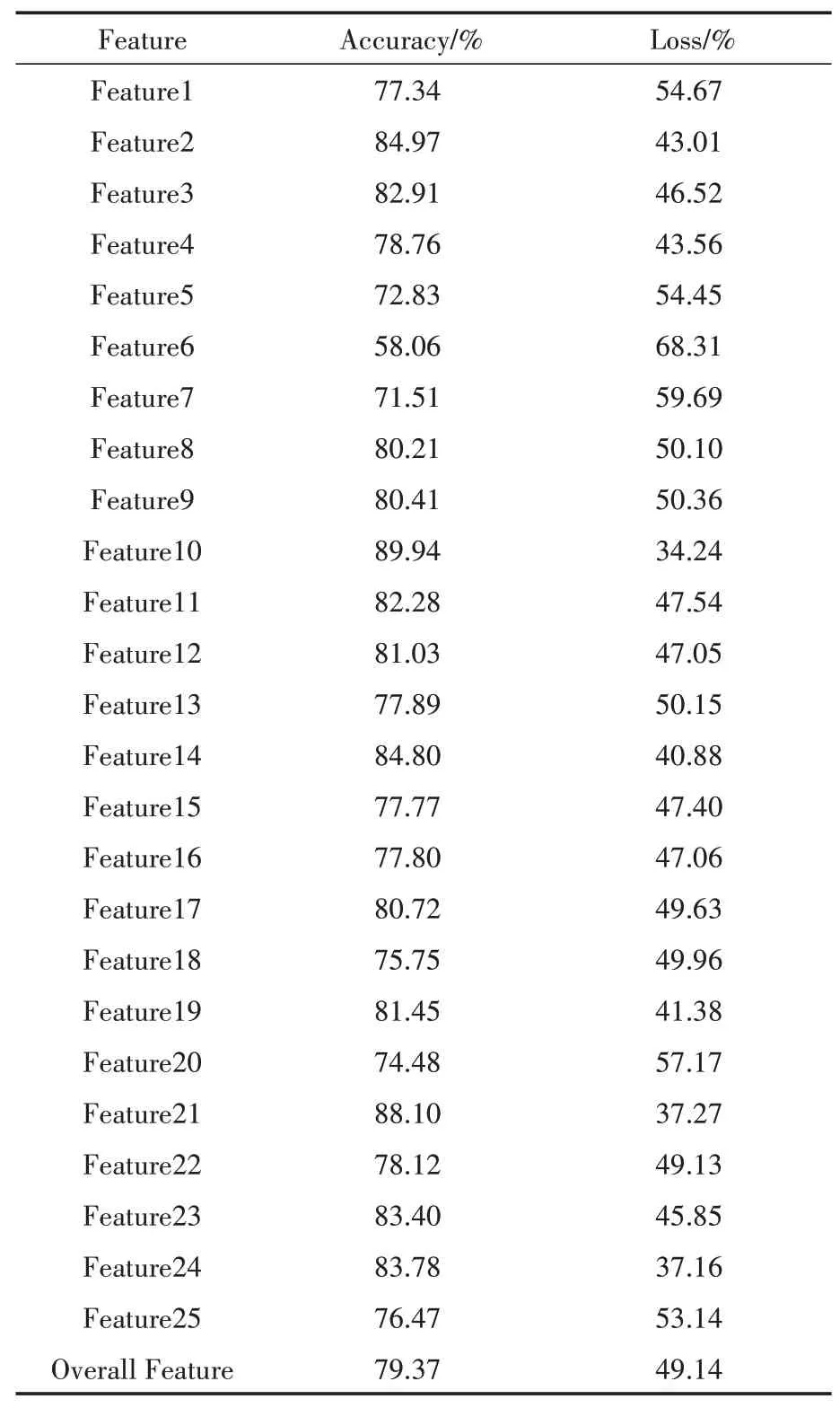

從圖10 可以看出,26 種圖像反映的圖像特征貢獻不一樣,某些子圖能夠很好反映出原始圖像的結(jié)構(gòu)特征,但某些子圖只能看到眼底輪廓,并且包含了大部分的黑暗區(qū)域,與原圖差異較大。我們通常認為這些圖像是不適宜進行分類的,應(yīng)該抽取那些特征明顯或者更能反映杯盤比的圖像特征作為輸入圖像。為了驗證假設(shè),分別將所有特征圖像輸入分類器,比較它們的識別率,準確率與損失率如表1所示。

圖10 VGG網(wǎng)絡(luò)提取的特征子圖

表1 青光眼特征子圖的分類準確率和損失率

結(jié)果顯示,提取圖像特征后,圖像分類準確率提升顯著,平均識別率為79.23%,最高可達89.94%。這表明運用VGG16 網(wǎng)絡(luò)對圖像提取特征子圖是有效的,能夠總體提高圖像的準確率,但與此同時,特征子圖還有待改進的空間,那些我們認為應(yīng)該從數(shù)據(jù)集中剔除的特征子圖中有可能隱藏了一些肉眼不可見的特征,也可能是因為分類器分類失敗所導(dǎo)致的,與網(wǎng)絡(luò)梯度攻擊后的圖像分類結(jié)果類似。為了消除這種不確定性,我們將有可能影響分類性能的特征子圖摒棄。

4 位平面分解

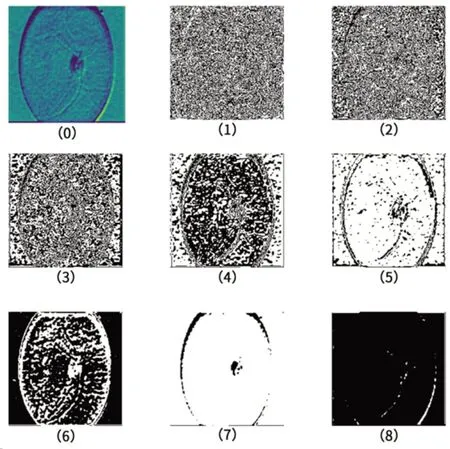

26 個特征圖像的最高識別率為89.9%,為了進一步提高識別率,突破特征子圖所達到的準確率瓶頸,我們對篩選出來的特征子圖進行位平面分解,進一步蒸餾圖像特征。用圖像作為底面,表示像素亮度大小的8位二進制數(shù)作為高度,可形成一個立體直方圖,各像素位置相同的位形成的一個平面成為圖像的位平面,這個過程稱為位平面分解。先將提取出的特征子圖進行位平面分解,然后采用格雷碼進行位平面置換,通常可以減小灰度變化所帶來的影響。圖11 顯示了青光眼圖像特征子圖的位平面分解結(jié)果。

圖11 位平面分解后進行格雷碼置換

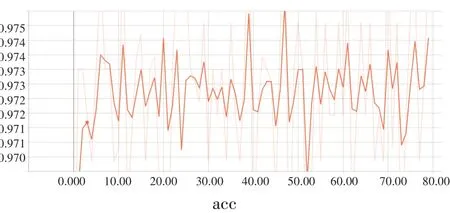

圖11(0)為被分解前的原圖,從圖11(1)到圖11(8)為最低位平面到最高位平面。通常情況下,位平面越高,圖像整體特征越明顯,更接近原圖,說明高位平面圖保留了較多的原圖信息,在原圖組成上更為關(guān)鍵。低位平面圖像能反映局部特征,但整體與原圖有著一定差異。從圖11 看出,由于圖11(7)、圖11(8)位平面強調(diào)原圖信息,反而丟失了圖像的特征,導(dǎo)致圖像中出現(xiàn)了較多的無效區(qū)域。圖11(1)、圖11(2)位平面作為低位平面,更容易受到噪聲干擾,有可能承載了更多的噪聲信息,因此通過實驗分析哪些位平面層更適合分類顯得尤其關(guān)鍵。將篩選出的特征圖位平面圖像輸入CNN 分類器中,得出最高的分類準確率達到97.41%,準確率與損失率分別如圖12、圖13所示。

圖12 特征子圖最高分類準確率

圖13 對應(yīng)特征子圖分類損失率

經(jīng)過80 次迭代,準確率曲線在97.0%~97.5%之間呈震蕩形態(tài),震蕩區(qū)間為0.5%,而損失率曲線在47%~41%之間呈震蕩形態(tài),震蕩區(qū)間為6%。由于準確率曲線的震蕩區(qū)間較小,在宏觀上看,準確率曲線收斂于97.3%,平均損失率為44%左右,分類性能良好,準確率比原始圖像提高了19.7%,比高斯噪聲攻擊后的圖像提高了30.6%,比FGSM 攻擊后的圖像提高了24.4%。綜上所述,遭受噪聲攻擊的圖像雖然會造成分類性能的下降,但通過對被攻擊的圖像生成特征子圖,再結(jié)合格雷碼位平面置換的方法,仍能夠從圖像中提取出關(guān)鍵特征,提高分類器分類性能,達到較高的準確率與較低的損失率。

5 結(jié)語

本文針對青光眼臨床診斷依賴人工經(jīng)驗判斷容易引發(fā)錯誤的問題,提出了一種基于CNN的青光眼分類器。結(jié)合特征子圖和位平面分解提取青光眼圖像特征,通過實驗結(jié)果說明該方法能夠抵御噪聲干擾并提升分類準確率,有助于青光眼的早期診斷與篩查。該分類器簡單,會對分類準確率有所制約,將來的研究工作主要包括優(yōu)化分類器網(wǎng)絡(luò)結(jié)構(gòu),用不同網(wǎng)絡(luò)提高分類器的分類效能,降低損失率。