自動駕駛汽車目標檢測方法綜述

李愛娟,鞏春鵬,黃欣,曹家平,劉剛

1.山東交通學院 汽車工程學院,山東 濟南 250357;2.山東交通學院 信息科學與電氣工程學院,山東 濟南 250357;3.山東交通學院 教務處,山東 濟南 250357

0 引言

汽車自動駕駛技術主要包括環境感知、定位導航、軌跡規劃和執行控制4個方面[1],其中環境感知為自動駕駛汽車的決策和控制提供外界環境信息,是自動駕駛的前提和保障,目標檢測是環境感知的重要內容[2-3]。綜合分析國內外部分研究文獻,以目標檢測采用的傳感器數量和種類對目標檢測方法進行分類,綜述各檢測方法的特點及研究現狀,并對目標檢測方法未來發展方向進行展望。自動駕駛汽車目標檢測方法分類如圖1所示。

圖1 自動駕駛汽車目標檢測方法分類

1 基于單傳感器的目標檢測方法

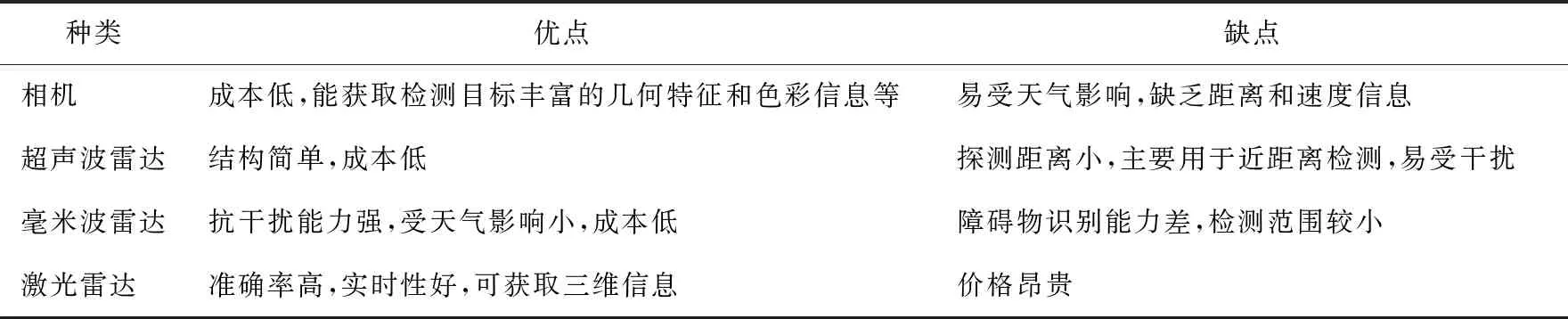

自動駕駛汽車目標檢測的傳感器主要有相機、超聲波雷達、毫米波雷達、激光雷達等[4],目標檢測常用傳感器的特性如表1所示。

表1 目標檢測常用傳感器的特性

1.1 基于視覺的目標檢測方法

相機是自動駕駛汽車獲取周圍環境信息的主要來源之一。早期的目標檢測多采用視覺獲取信息,基于視覺的目標檢測方法是先選擇候選區域,再對候選區域提取特征并判斷目標類型,包括基于傳統視覺的目標檢測方法和基于深度學習的目標檢測方法。

1.1.1 基于傳統視覺的目標檢測方法

基于傳統視覺的目標檢測方法采用手工提取特征[5],主要檢測方法有VJ檢測器[6]、方向梯度直方圖(histogram of oriented gradient,HOG)檢測器[7]、可變形部件模型(deformable part-based model,DPM)[8]等。

VJ檢測器采用滑動窗口遍歷整個圖像,判斷目標是否存在。文獻[6]通過VJ檢測器實現對人臉的實時檢測,采用檢測級聯增加對有效目標的計算,提高了檢測速度。但該方法檢測的目標種類及大小均不固定,滑動窗口不能適應物體大小的改變。

文獻[7]改進VJ檢測器的缺點,采用HOG檢測器,沿用VJ檢測器滑動窗口的思想,引入多尺度圖像金字塔適應檢測目標的變化。文獻[9]采用HOG檢測器與支持向量機分類器相結合的方法識別前方車輛,并可刪除提取區域中的非車輛目標。

文獻[8]改進HOG檢測器,采用DPM,將整體檢測目標分解為局部檢測目標,分別檢測目標的各個部件,再整合檢測結果。傳統的DPM主要檢測目標圖像的梯度特征,容易過濾一些信息。文獻[10]提出基于車輛顏色的DPM檢測方法,目標檢測準確率大于90%,相比傳統目標檢測方法的檢測效率和準確率均較高。

VJ檢測器對自動駕駛汽車目標檢測方法的進步做出了較大貢獻,為后來的目標檢測方法提供了思想支持;HOG檢測器克服了VJ檢測器不能適應物體大小改變的缺點;DPM將整體目標化為局部目標進行檢測,一定程度上提升了檢測效率。但上述方法均基于手工選取特征區域,存在計算量大、實時性差等問題,不能滿足自動駕駛汽車高可靠性的要求[11]。

1.1.2 基于深度學習的目標檢測方法

基于深度學習與基于傳統視覺的目標檢測方法主要區別為特征區域的提取方式不同,前者采用神經網絡解決檢測目標的分類和回歸問題,按檢測原理不同分為單階段和兩階段目標檢測方法。

1.1.2.1 單階段目標檢測方法

單階段目標檢測方法是直接應用單個檢測網絡,代表算法有“你只需看一次”(you only look once, YOLO)[12]系列算法、單點多框檢測器(single shot multibox detector,SSD)[13]、RetinaNet[14]等。

文獻[12]提出了1種統一的、實時的檢測框架YOLO,將目標檢測轉化為回歸類問題,可實現檢測目標與背景環境的區分與關聯,降低誤檢率。但對小目標和集群目標的檢測較低。目前YOLO系列算法已經發展到v5版本,在保證高檢測速度的同時,提升了檢測準確率[15]。

針對YOLO v1版本存在的問題,文獻[13]采用SSD方法引入多尺度檢測,在神經網絡的不同層檢測多個不同尺度的目標,提升了小目標的檢測準確率。文獻[16]將SSD應用于小型交通標志的檢測,具有較高準確率。為解決單階段目標檢測方法無法兼顧速度與準確率的問題,文獻[14,17]提出了新的單階段檢測框架RetinaNet,該算法引入焦點損失函數,使檢測框架的關注焦點放在難分類的檢測目標上,極大地提升了單階段檢測方法的檢測效果。

YOLO v1作為第1個單階段目標檢測方法,解決了檢測速度慢的問題,滿足實時檢測要求,但對不同尺度目標尤其是小目標的檢測效果較差;SSD引入多尺度檢測,有效提升了小目標的檢測性能,這一思想也被應用到YOLO v3算法中。單階段目標檢測方法的主要缺點是檢測準確率低,而引入焦點損失函數的RetinaNet算法,在保持高檢測速度的同時,達到了兩階段算法的檢測準確率。

1.1.2.2 兩階段目標檢測方法

兩階段目標檢測方法將目標檢測問題分2步解決,先產生候選區域,再對候選區域分類,主要包括區域卷積網絡(region proposals with CNN,R-CNN)[18]、空間金字塔池化網絡(spatial pyramid pooling networks,SPPNet)[19]和特征金字塔網絡(feature pyramid network,FPN)[20]等系列算法。兩階段目標檢測方法比單階段目標檢測方法更準確,但檢測速度較慢。

文獻[18]首次提出在自動駕駛汽車目標檢測領域應用R-CNN,成為兩階段算法的研究基礎。R-CNN在神經網絡中輸入1個固定大小的圖像進行訓練并提取目標特征,比傳統目標檢測方法的檢測準確率高,但會產生大量重復計算,降低目標檢測速度。文獻[21-22]分別在R-CNN算法的基礎上提出了Fast R-CNN、Faster R-CNN兩階段目標檢測方法,但仍存在重復計算,達不到單階段目標檢測方法的實時性。

針對R-CNN存在需輸入固定大小圖像導致檢測速度慢的問題,文獻[19]引入空間金字塔模型,消除固定尺寸約束,提出了SPPNet,該算法不需要將目標縮放,減少了多余計算,提高了檢測速度,但仍無法適應自動駕駛環境的實時檢測目標。

上述目標檢測方法只在神經網絡的頂層進行檢測,不利于檢測目標的分類,文獻[20]提出了FPN算法,充分利用神經網絡檢測多尺度目標。文獻[23]將FPN算法用于小目標檢測,該算法簡單易實現,對小目標的檢測效果明顯。

SPPNet、FPN等算法的核心思想,不但應用在兩階段目標檢測算法中提升檢測準確率,也被引入單階段檢測算法,如在YOLO v3算法中引入FPN結構,將不同特征層融合后的結果用作目標檢測,在小目標檢測中起到關鍵作用;在YOLO v4算法中加入SPP模塊,實現了局部特征和全局特征的融合。兩階段目標檢測方法雖然檢測準確率高,但會產生一些冗余計算導致檢測速度慢,Faster R-CNN是R-CNN系列算法中檢測速度最快、最接近實時檢測要求的兩階段目標檢測算法。

綜上所述,基于視覺的目標檢測方法的發展框架如圖2所示。基于傳統視覺的目標檢測方法實時性差、檢測準確率低,不能適應復雜的自動駕駛運行環境;基于深度學習的神經網絡目標檢測算法的檢測速度與準確率一直未達到最優平衡點[24]。

圖2 基于視覺的目標檢測方法的發展框架

1.2 基于雷達的目標檢測方法

自動駕駛汽車運行環境復雜多變,基于視覺的目標檢測方法易受環境光照影響出現誤檢和漏檢情況。雷達檢測范圍擴大,分辨率不斷提高,已成為最主要的目標檢測傳感器。基于雷達的目標檢測方法多采用點云特征,首先在三維點云數據中提取感興趣區域(regions of interest,ROI),再提取檢測目標的特征,對檢測目標進行分類[25]。

傳統基于點云特征的檢測方法與基于視覺的檢測方法相似,均采用手工方式提取特征。基于雷達的目標檢測方法受基于深度學習目標檢測方法的啟發,將神經網絡運用到雷達提取點云特征。文獻[26]將圖像檢測方法引入基于點云特征的目標檢測,提出1種實時三維點云檢測網絡Complex-YOLO,能夠實時檢測多種類型的目標;文獻[27]提出采用二維全卷積網絡(fully convolutional network,FCN),將三維信息投影到二維點圖中預測目標的置信度和邊界框。上述2種檢測方法均采用三維信息投影到二維點圖的方法,容易缺失部分信息。文獻[28]直接在點云信息上進行目標檢測,提出PointNet算法,該算法結構簡單,引入最大值池化將每個點獨立分類檢測,再通過FCN將各點云特征整合獲得全局特征。文獻[29]將PointNet運用到行人檢測,結合點云的多尺度局部特征和全局特征在激光雷達上實現行人檢測,試驗表明檢測效果良好。PointNet在局部處理上存在缺陷,在此基礎上文獻[30]提出了PointNet++算法。

基于雷達與基于視覺的目標檢測方法有類似之處,也分為單階段和雙階段檢測方法。毫米波雷達的分辨率較低,激光雷達的成本較高,基于深度學習的視覺檢測方法提升了檢測效率和準確率,但易受天氣影響且不能獲取目標的距離、速度等信息,無法提供準確可靠的環境信息[31]。由于自身特性的局限性和天氣等影響因素,基于視覺和雷達的單一傳感器目標檢測方法不能適應復雜的自動駕駛環境[32]。

2 基于多傳感器融合的目標檢測方法

相機檢測到的目標特征信息比雷達更豐富,但無法獲取目標的距離、速度及三維信息[33]。將雷達與相機進行數據融合,既能獲取圖像信息,又能獲取檢測目標的深度信息[34],目前目標檢測最常用的傳感器融合方式是相機與毫米波雷達融合[35]。文獻[36]研究了基于相機和毫米波雷達融合的目標檢測方法,相機識別目標特征的能力和毫米波雷達在惡劣環境中的抗干擾能力相結合,提升了目標檢測準確率。文獻[37]基于密度的聚類算法(density-based spatial clustering of applications with noise,DBSCAN)對激光雷達采集的點云數據進行聚類,利用Faster R-CNN算法識別圖像信息,提出了基于激光雷達和視覺信息融合的框架,能快速準確地識別目標信息。

多傳感器融合的目標檢測方法是國內外高校及汽車行業的研究熱點[38]。多倫多大學和Uber公司提出了1種通過神經網絡連續融合圖像和激光雷達點云信息的檢測方法,通過融合2種傳感器的數據信息準確獲取目標的三維空間信息[39];百度與清華大學研發團隊提出了多視圖3維網絡(multi-view 3D networks, MV3D)[40],融合框架采用點云的主視圖和俯視圖,同時處理相機的光學三原色圖像和激光雷達點云2種信息,縮短了信息處理時間,保證了目標檢測的實時性[41]。

信息融合是一門交叉學科,涵蓋概率統計、估計理論及神經網絡等[42]。信息融合的方法主要包括基于隨機模型的加權平均融合法[43]、卡爾曼濾波(Kalman filtering,KF)融合法[44]、貝葉斯估計融合法[45]、D-S證據推理融合法[46]等傳統融合算法和正在蓬勃發展的神經網絡法、模糊邏輯法、遺傳算法等人工智能融合法。

2.1 基于隨機模型的目標檢測融合方法

2.1.1 加權平均融合法

加權平均融合法是按不同權重處理多個傳感器的數據。文獻[47]加權分配2個超聲波雷達的觀測值,研究表明:當觀測值權重取值合適時可獲取最優估計值,結論推廣到多個超聲波雷達及激光雷達數據融合同樣具有較高的可行性。但加權平均融合法不易確定各傳感器數據的權重,影響采集信息的準確率。文獻[48]提出了1種自適應加權平均融合法,采用不同方法處理高頻、低頻數據,較傳統加權平均融合方法的準確率更高,但不易處理傳感器自身誤差及環境干擾。文獻[49]通過設置權重淘汰檢測結果差的傳感器數據,減少多傳感器的測量誤差和不確定性,在實際應用中提高了融合系統的準確率。

2.1.2 KF融合法

KF是1種常見的數據處理方法,實時性好,廣泛應用于計算機視覺、圖像檢測及自動駕駛環境感知等領域。KF融合法基于KF進行拓展,目前主要有不變擴展KF算法[50]、加權測量融合KF算法[51]、無跡KF與神經網絡結合算法[52]等。文獻[53]研究目標關聯后的不同融合方法,提出了基于KF的多傳感器信息融合算法。由于復雜的運行環境及目標的不確定性,文獻[54]基于KF提出了1種實時多目標追蹤(multiple object trackin,MOT)框架。文獻[55]改進迭代擴展KF,提出了多傳感器融合狀態估計算法,考慮獲取信息的不確定性,先將各傳感器獲取的信息單獨處理再進行并聯,提高目標檢測的可靠性。

2.1.3 貝葉斯估計融合法

貝葉斯估計理論[56]通過先驗信息與檢測目標信息相結合預測事件發生的概率。文獻[57]通過試驗得到貝葉斯估計融合法,可有效融合多個傳感器獲取的數據,但該方法需要大量先驗信息,在實際應用中先驗信息并不容易獲取。文獻[58]提出了1種利用置信距離理論與貝葉斯估計相結合的多傳感器信息融合法,充分利用2種理論的特性,提高了檢測系統性能,但該方法只適用于同類型傳感器檢測同一目標的情況。貝葉斯估計融合法對不確定的信息處理較困難,文獻[59]提出將KF與貝葉斯估計理論相結合的多傳感器信息融合法,該方法能有效解決各傳感器獲取信息的不確定性和不一致性,提高了檢測準確率。

2.1.4 D-S證據推理融合法

相較于貝葉斯估計理論,D-S證據推理在處理不確定信息方面有一定優勢,是貝葉斯估計融合法的改進。文獻[60]通過試驗驗證了D-S證據推理應用在多傳感器融合的自動駕駛汽車目標檢測方面的可行性和有效性。由于自動駕駛環境的復雜性和單一傳感器的檢測缺陷,對遠距離目標及小目標的檢測存在準確率低、可靠性差等問題[61]。文獻[62]采用D-S證據推理對可見光和紅外熱圖像進行決策級融合,提出了基于決策級融合的遠距離目標檢測方法。D-S證據推理融合法雖然在解決不確定信息問題上有良好的效果,但無法較好地處理證據沖突情況。文獻[63]提出了1種結合加權法改進的D-S證據推理融合法,通過均值加權思想將D-S證據推理中的矛盾證據弱化,通過仿真驗證了改進后的算法能有效彌補D-S證據推理融合法的缺陷。

2.2 基于人工智能的目標檢測融合方法

基于人工智能的目標檢測融合方法主要包括神經網絡融合法、模糊邏輯融合法、遺傳算法等,目前多傳感器融合常用的方法是神經網絡融合法。通過給神經網絡輸入大量信息,經過訓練產生固定邏輯獲得最佳的融合權值[64]。為解決雷達與紅外傳感器的融合問題,文獻[65]在協方差未知的環境下,采用神經網絡融合2種傳感器獲取的信息,通過仿真分析驗證算法的可行性。文獻[66]提出1種多傳感器融合神經網絡,將毫米波雷達的先驗信息添加到卷積神經網絡中得到新的注意力機制模塊,再將該模塊與SSD目標檢測網絡相結合,這種基于深度學習的融合算法提高了目標檢測的穩定性和可靠性。文獻[67]發現利用神經網絡可有效解決多傳感器融合的固有問題,但要達到最佳融合結果,需收集全部可能發生的事件數據。

綜上所述,面對復雜的自動駕駛環境,融合方法的應用使自動駕駛汽車充分利用各傳感器獲取更多、更豐富的環境信息,提高了目標檢測的準確率和可靠性,減少了獲取信息的時間和費用[49]。加權平均融合法和KF融合法直接處理原始數據,屬于低層次的數據級融合方法,原始數據丟失少,需集中處理大量信息,影響目標檢測的實時性;貝葉斯估計融合法、D-S證據推理融合法相比前2種方法,計算量小,屬于高層次的融合方法,但先驗信息不易獲得、適用范圍較小;神經網絡融合法以神經元的形式輸入,無需大量的先驗信息,有較強的自適應性。

基于隨機模型的目標檢測融合方法是多傳感器融合方法的發展基礎,基于人工智能的目標檢測融合方法是多傳感器融合方法的發展趨勢,但傳感器融合方法均存在計算量大、規則難建立等缺點。只有充分利用各傳感器的特點,綜合多種融合方法,才能為自動駕駛汽車提供安全保障。

2.3 目標檢測方法存在的問題和解決方法

自動駕駛的目的是降低交通事故的發生概率,保證行車安全。基于單傳感器的目標檢測方法無法滿足復雜的自動駕駛行車環境,基于多傳感器融合的目標檢測方法需要結合多種學科、多個領域的技術。現有的目標檢測方法只能實現在特定環境下的自動駕駛,目標較小或天氣環境惡劣時對自動駕駛系統的穩定性提出了較大挑戰。為滿足自動駕駛高可靠性的要求,可通過增加目標檢測傳感器的數量增加獲取的目標信息量,或通過增強自動駕駛目標檢測方法的魯棒性,提高系統穩定性。針對自動駕駛目標檢測方法的問題與難點,文獻[68]提出將YOLO與Faster R-CNN結合,利用YOLO將整張圖像輸入神經網絡的特點,解決兩階段Fast-RCNN算法背景檢測錯誤率高的問題,增強目標檢測的效果;文獻[69]將視覺、毫米波雷達和激光雷達3種傳感器融合,實時獲取環境的點云信息、方位角、速度和距離等深度信息,極大地提高了目標檢測的準確率和實時性;文獻[70]通過融合深度相機和激光雷達傳感器提高了小目標檢測的準確率;文獻[71]將毫米波雷達與相機融合用于惡劣天氣環境下的目標檢測;文獻[72]研究了自動駕駛汽車在坑洼路段及濕地運行時的目標檢測,采用YOLO作為檢測算法并在數據集上增加對坑洼、濕地等環境運行時的訓練,使自動駕駛汽車更安全可靠。

3 展望

自動駕駛汽車目標檢測方法研究與應用已取得較大進步,但與實現真正的自動駕駛仍存在差距。目標檢測方法未來研究與發展的重點和趨勢如下:1)基于視覺的目標檢測方法多依賴高性能計算機及強大的顯卡算力,而汽車上的內存和計算資源有限,無法滿足要求,因此基于視覺目標檢測方法的發展趨勢是發展計算量小、識別速度快、便于在移動設備上安裝的輕量級車載應用;2)目前基于多傳感器融合的目標檢測方法較多對2種傳感器的融合技術進行研究,未來發展趨勢是應用3種及以上傳感器進行數據融合,采用的傳感器種類越多,獲取目標信息越豐富,更能反映目標的特性,檢測結果更準確可靠;3)對遠距離目標、小目標和集群等特殊目標檢測的研究較少,獲取目標特征較少的小目標檢測是最具挑戰的目標檢測任務之一,所以采用提高采集和輸入圖像信息分辨率和融合多種傳感器獲取多尺度特征的目標檢測方法是未來發展趨勢;4)目前研究的汽車自動駕駛技術多在路況良好的城市道路進行,對路況差及某種傳感器在復雜環境下被遮擋或失效等問題的研究較少[73],未來發展趨勢是在復雜環境中應用多傳感器融合技術。