基于Cross-DeepFM的軍事訓練推薦模型*

高永強,張之明,王宇濤

(1.武警工程大學信息工程學院,陜西 西安 710086;2.中國人民武裝警察部隊貴州省總隊,貴州 貴陽 550081)

1 引言

新一輪軍事信息化革命的推進對軍事訓練組訓方式提出了新的要求。以往的軍事訓練方式在尊重個體差異性方面仍有所欠缺,較難制定出個性化的訓練計劃。將推薦系統應用于軍事訓練領域,通過適當的推薦算法對訓練數據進行分析,可以形成具有針對性的軍事訓練方案,為提高部隊整體戰斗力提供科學輔助。因此,個性化軍事訓練推薦系統的研究與應用具有重要的理論意義和實踐價值。

近年來,深度學習取得了長足發展并被廣泛應用到了計算機視覺、自然語言處理和語音識別等領域,基于深度學習的推薦系統研究也成為當前研究的熱點之一。文獻[1]提出了基于深度學習的協同過濾模型NeuralCF(Neural Collaborative Filtering),用深度神經網絡替代了矩陣分解模型中簡單的內積操作,使用戶向量和物品向量能夠更充分地交叉,有效提高了模型的表達能力。文獻[2]將單層的線性模型和深度神經網絡相結合提出了Wide &Deep模型,使模型兼具較強的“記憶能力”和“泛化能力”。文獻[3]用交叉網絡代替Wide &Deep模型中的Wide部分,組合交叉網絡和深度網絡2部分輸出進行預測,提出了DCN(Deep &Cross Network)網絡模型。文獻[4]用因子分解機FM(Factorization Machine)模型替換了Wide &Deep模型中的Wide部分,提出了深度因子分解機模型DeepFM(Deep Factorization Machine),加強了淺層網絡部分的特征組合能力。隨著圖神經網絡的不斷發展,越來越多的研究人員提出了基于圖神經網絡的推薦算法。文獻[5]將GCN(Graph Convolutional Network)引入推薦系統,提出了NGCF(Neural Graph Collaborative Filtering)模型,顯式建模User-Item之間的高階連接性并據此給出推薦。文獻[6]提出了一種高效的圖卷積神經網絡推薦算法PinSage,通過該算法產生圖中節點的嵌入表達,成功地將其應用到了節點數為10億級別的超大規模推薦系統中。文獻[7]提出了RippleNet,引入知識圖譜信息,沿著知識圖譜中的連接自動擴展用戶的潛在偏好,提高了推薦系統的性能。文獻[8]提出了基于知識圖譜和圖注意網絡的推薦算法KG-GAT(Knowledge Graph and Graph Attention neTwork),將知識圖譜作為輔助信息,在圖注意網絡中使用分層注意力機制獲取更有效的用戶和項目的潛在表示,能夠生成更精確的top-N推薦列表。

目前,推薦系統在軍事領域已有諸多應用,尤其是軍事情報智能推送和軍事新聞個性化推薦領域。申遠等[9]提出了一種基于深度神經網絡和Doc2Vec的戰場態勢智能推送算法,能夠充分利用用戶-情報歷史交互信息挖掘二者之間的關聯關系,是混合推薦模型在軍事情報智能推送中的典型應用之一。王中偉等[10]針對軍事用戶特點,提出了一種軍事文本信息智能推薦技術,并基于“沙漠風暴”軍事文本內容構建了軍事用戶角色的特征層次模型,實現了情報信息的智能推薦。袁仁進[11]提出了一種基于支持向量機和二分K均值聚類的軍事新聞推薦方法,首先使用支持向量機來表示軍事新聞的文本特征,然后使用聚類算法對文本進行分類,最后將各類軍事新聞推薦給相應的感興趣的用戶。但是,推薦系統在軍事訓練領域的應用目前還比較少。

基于對深度學習推薦系統的研究分析,本文將推薦系統應用到軍事訓練領域,基于DeepFM模型的設計思路,將深度殘差神經網絡DRN(Deep Residual Network)、深度交叉網絡DCN和因子分解機FM相結合,提出了Cross-DeepFM(Cross Deep Factorization Machine)混合推薦模型。最后將該模型與主流的深度推薦模型進行了對比實驗,驗證了該模型的有效性。

2 模型工作流程

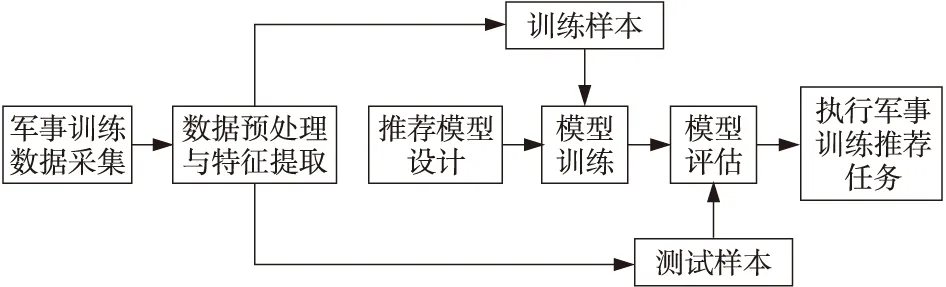

為完成軍事訓練推薦任務,本文所提模型的工作流程如圖1所示,主要步驟包括軍事訓練數據采集、數據預處理與特征提取、推薦模型設計、模型訓練和模型評估與應用。

Figure 1 Flow chart of model圖1 模型工作流程

步驟1軍事訓練數據采集。該步驟主要是收集模型所需要的原始數據。本文采集了某軍事院校2020年4個季度的學員軍事訓練成績以及參訓人員和訓練科目信息,構建軍事訓練數據集。

步驟2數據預處理與特征提取。對原始數據中的重復值、缺失值和異常值等非法數據進行修正,對數據進行one-hot編碼和歸一化操作,使數據格式符合模型訓練的要求。

步驟3推薦模型設計。為提高推薦效果,克服傳統推薦模型面臨的數據稀疏和冷啟動問題,在DeepFM模型結構的基礎上,提出了一種結合深度殘差網絡、深度交叉網絡和因子分解機的混合推薦模型。

步驟4模型訓練。每輪訓練輸入一個批次的數據,根據設定好的損失函數計算損失值,應用誤差反向傳播算法計算梯度并利用梯度下降算法更新模型參數,循環迭代至模型收斂。

步驟5模型評估與應用。選定評估指標,在本文構建的軍事訓練數據集上測試模型性能,并與因子分解機、深度因子分解機和深度交叉網絡等模型進行對比,并最終通過結合多個模型輸出結果完成軍事訓練推薦任務。

3 Cross-DeepFM模型結構

3.1 模型整體結構

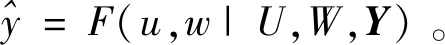

本文提出的Cross-DeepFM模型由深度殘差網絡DRN、深度交叉網絡DCN和因子分解機FM 3部分并行組成,模型結構如圖2所示。其中,FM負責對二階特征組合進行自動學習,DCN負責提取線性交叉組合特征,DRN負責提取深層次高階非線性特征。下面詳細分析模型各個組成部分的結構和原理。

Figure 2 Structure of Cross-DeepFM model 圖2 Cross-DeepFM模型結構

3.2 嵌入層

原始數據中的參訓學員ID、學員類別、訓練科目ID、訓練科目類型等類別型字段數據經過one-hot編碼后包含大量離散信息,直接將高維稀疏特征傳入模型會導致模型參數過多,所以在模型的輸入部分引入嵌入層(Embedding Layer),將高維稀疏特征轉換為低維稠密特征。

3.3 FM

FM是由Rendle等[12]提出的,其綜合了矩陣分解和支持向量機模型的優勢,尤其適合數據稀疏的場景。普通線性模型僅僅將不同特征進行加權求和,沒有考慮特征之間的組合關系,模型的表達能力較弱。FM在線性回歸模型的基礎上,引入了二階組合項xixj,能夠學習特征之間的非線性交互關系,其表達式如式(1)所示:

(1)

(2)

此時二階FM表達式可以寫為式(3)所示:

(3)

利用隨機梯度下降方法對FM進行訓練,通過式(3)可以得到模型中各個參數的梯度如式(4)所示:

(4)

3.4 DCN

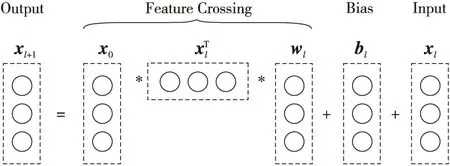

FM是淺層模型,可以有效地提取一階特征和二階特征,如果加入三階及以上的特征組合,會使模型的預測和訓練復雜度過高,最終導致特征爆炸問題。為了增加特征之間的交互力度,本文在模型中引入Cross Network[3]對輸入向量進行高階特征交叉。單層Cross Network的結構如圖3[3]所示。

Figure 3 Structure of Cross Network圖3 Cross Network結構

假設第l層Cross Network的輸出向量為xl,則第l+1層輸出向量的計算公式如式(5)所示:

(5)

由Cross Network的結構可知,多層Cross Network的參數量為D×L×2,其中,D為輸入數據的維度,L為Cross Network的層數。與全連接神經網絡相比,其參數要少一個數量級。可見,多層Cross Network充分考慮了不同特征之間的交叉組合,原始數據在每一層都和當前層數據進行特征交叉,在保留原始數據低階特征的同時,又交叉作用于深層高階特征。

3.5 DRN

DRN是一個全連接的多層前饋神經網絡,通過多個全連接的神經網絡層獲得復雜的非線性處理能力。深度全連接神經網絡每層的輸出如式(6)所示:

a(l+1)=σ(W(l+1)a(l)+b(l))

(6)

其中,a(l+1)為第l層的輸出,W(l+1)和b(l)分別為第l層的權重矩陣和偏置,σ(·)為激活函數。

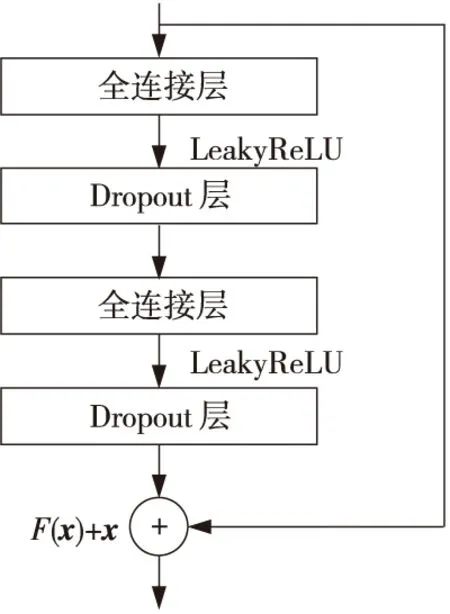

通常認為,深度神經網絡的深度越深,其提取特征的能力和表達能力越強,然而,深度增加也會導致模型難以收斂,造成網絡性能退化。為了增加網絡深度增強網絡提取高級特征的能力,同時克服深層神經網絡面臨的梯度消失和梯度爆炸問題,本文在DRN中引入殘差結構[13]和Dropout機制[14],結構如圖4所示。圖4中,x表示殘差模塊的輸入,F(x)表示殘差函數。每個殘差模塊的輸入都與殘差模塊的輸出加在一起,作為輸出,即:xl+1=xl+F(xl,Wl)。引入殘差模塊,增加了一個恒等映射,將原始需要學習的函數H(x)轉換為F(x)+x,F(x)+x的優化難度比H(x)小得多,并且不會給網絡增加額外的參數和計算量,在模型層數增加時能很好地解決模型的性能退化問題。

Figure 4 Structure with deep residual network and Dropout圖4 引入殘差模塊和Dropout的網絡結構

在深度殘差網絡中引入Dropout機制是為了防止模型在訓練過程中出現過擬合現象,增強模型的泛化能力。在訓練過程中每個神經元會以設定的概率進入失活狀態,例如神經網絡中某一層有1 000個神經元,本文設定Dropout概率為0.3,則這一層神經元經過Dropout后,大約300個神經元的輸出值會被置為0。其計算公式如式(7)所示:

(7)

3.6 輸出層

最后模型的輸出如式(8)所示:

(8)

4 模型訓練

本文采用的目標函數為平方損失函數,如式(9)所示:

(9)

在模型訓練開始前,首先隨機初始化模型參數,在前向傳播階段將訓練集數據輸入模型計算出一個目標值及其對應的損失函數值。在反向傳播階段,利用反向傳播算法計算出模型中每個參數的梯度值,采用梯度下降算法對模型參數進行更新。循環執行上述操作直到完成指定的迭代次數,模型訓練完成。Cross-DeepFM模型的整體訓練流程如算法1所示。

算法1Cross-DeepFM模型訓練

輸入:訓練集、模型參數、批次大小batch、迭代次數epoch和學習率r。

輸出:優化的模型參數。

步驟1初始化模型參數;

步驟2創建Adam優化器對象;

步驟3While迭代次數小于epochdo

步驟4for一批次數據 in 訓練集do

步驟5將數據輸入嵌入層,將高維的稀疏向量轉換為低維的稠密向量;

步驟6利用式(3)得到FM的輸出yFM;

步驟7利用式(5)得到DCN的輸出yDCN;

步驟8利用式(6)和式(7)得到DRN的輸出yDRN;

步驟9將以上3部分輸出向量進行拼接,利用式(8)得到模型的最終輸出;

步驟10利用式(9)計算模型損失值;

步驟11利用反向傳播算法計算參數梯度;

步驟12使用Adam優化器更新模型參數;

步驟13endfor

步驟14endwhile

5 實驗與結果分析

5.1 實驗環境

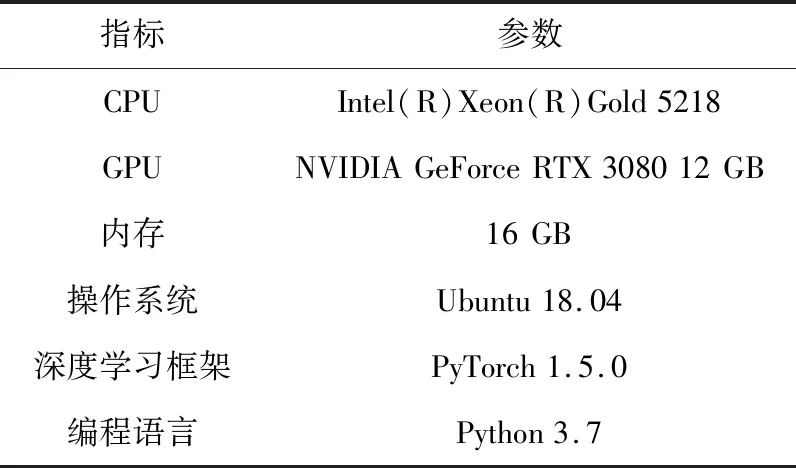

本文實驗使用的硬件平臺為Intel Xeon(R)Gold 5218 處理器,NVIDIA GeForce RTX 3080 12 GB顯卡。軟件平臺為Ubuntu 18.04操作系統,深度學習框架為PyTorch,編程語言為Python 3.7。具體環境參數配置參見表1。

Table 1 Parameters of experimental environment表1 實驗環境參數

5.2 數據集

本文采用的自定義軍事訓練數據集來源于某軍事院校學員某年度全年的軍事訓練考核數據,包括3 600名參訓人員在15個軍事訓練科目上的20 000條訓練成績數據,主要包括以下3部分內容。

(1)參訓學員個人信息。該部分數據包含學員號、身份證號、姓名、性別、學員類別、入學年份、年齡、籍貫、身高、體重和單位等屬性數據。

(2)訓練科目基本信息。該部分數據采集自最新的軍事訓練與考核大綱等文件,包括科目名稱、類型、評分標準和成績評定等數據。

(3)參訓學員軍事科目訓練成績和評價信息。該部分數據包含學員號、訓練科目、考核時間、考核地點、考官、考核成績、評定和綜合評價等數據。

將數據集隨機分成訓練集和測試集2部分,訓練集占比80%,用于學習推薦模型中的參數;測試集占比20%,用于評估推薦模型的準確性。

5.3 評價指標

本文采用均方根誤差RMSE(Root Mean Square Error)和平均絕對誤差MAE(Mean Absolute Error)作為模型性能的評估指標,誤差值越小,表明算法的推薦精度越高。RMSE和MAE的計算方式分別如式(10)和式(11)所示:

(10)

(11)

5.4 對比模型

為了驗證Cross-DeepFM模型的性能,本文采用以下幾個具有代表性的推薦模型進行對比實驗:

(1)FM模型[12]:一種能對二階特征組合進行自動學習的模型,通過隱向量做內積來表示組合特征,能夠有效解決高維數據的特征組合問題,具有較高的預測精度和計算效率,在推薦系統領域得到了廣泛研究和應用。

(2)神經因子分解機NFM(Neural Factorization Machine)模型[15]:在嵌入層和神經網絡層之間加入了特征交叉池化層,與傳統因子分解機模型相比,實現了更高階的特征交叉,獲得了更好的預測性能。

(3)DCN模型[3]:由谷歌和斯坦福大學提出的一種深度學習推薦模型,采用交叉網絡代替Wide &Deep模型中的Wide部分,組合交叉網絡和深度神經網絡2部分的輸出進行預測。

(4)DeepFM模型[4]:由哈爾濱工業大學和華為提出的一種深度學習推薦模型,結合了因子分解機和深度神經網絡,因子分解機負責提取低階組合特征,深度神經網絡部分負責提取高階組合特征。

5.5 實驗結果分析

本文為了從多角度驗證本文模型的有效性,從深度網絡結構對算法性能的影響、深度模型參數對算法性能的影響和算法效果對比3個方面進行了實驗。

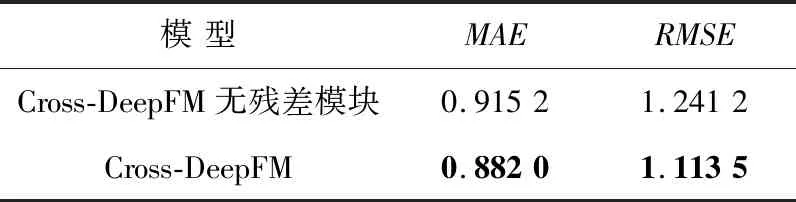

5.5.1 深度網絡結構對模型性能的影響

為了研究殘差模塊對模型性能的影響,本文在自定義軍事訓練數據集上設置了一組對比實驗。去除Cross-DeepFM模型中的殘差模塊DRN,全部替換成普通的全連接層,并與原始Cross-DeepFM模型進行實驗對比,結果如表2所示,表中數據均為5次實驗結果的平均值。

Table 2 Influence of residual module on model performance表2 殘差模塊對模型性能的影響

從實驗結果可以看出,加入殘差模塊的模型性能整體優于不加入殘差模塊的模型的。在自定義軍事訓練數據集上,引入殘差模塊的Cross-DeepFM模型的MAE為0.882 0,相較于只采用普通全連接神經網絡的Cross-DeepFM模型下降了4.5%;RMSE為1.113 5,下降了9.2%。以上結果表明,引入殘差模塊可以有效解決深度神經網絡的退化問題,提高了模型的高階特征學習能力。

5.5.2 深度模型參數對模型性能的影響

為了探究Cross-DeepFM模型中深度神經網絡的網絡層數L的最優值,本文對網絡層數L對模型性能的影響進行了實驗測試,實驗結果如圖5所示。圖5中展示了神經網絡層數從2到10變化時,Cross-DeepFM模型在訓練集和測試集上RMSE值的變化趨勢。在訓練集上,隨著網絡層數的增大,模型的RMSE值逐漸下降,表明模型的擬合能力在逐漸增強。在測試集上,隨著網絡層數的增大,RMSE值呈現出先下降后上升的趨勢,當網絡層數為6時,RMSE值最小,此時模型的準確度最高。當網絡層數繼續增大時,模型在訓練集上的效果很好,而在測試集上的效果開始變差,表明模型出現了過擬合現象,泛化能力變差。該實驗結果表明,恰當的模型層數設置能夠使模型具有較高泛化能力的同時保持合理的計算復雜度,因此在下一步的模型性能對比實驗中將神經網絡層數設定為6。

Figure 5 Influence of neural network layers on model performance圖5 神經網絡層數對模型性能的影響

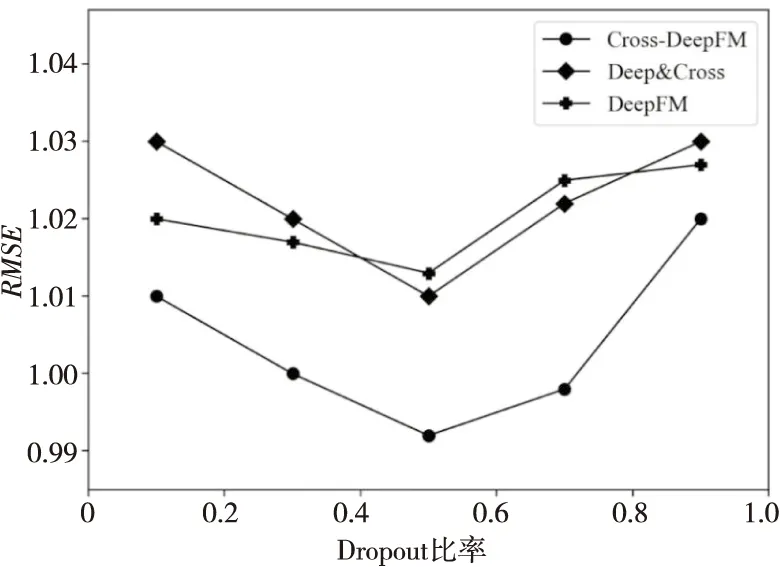

為了防止模型過擬合,本文在DCN模型、DeepFM模型和Cross-DeepFM模型中的深度神經網絡部分引入Dropout機制。為了分析不同Dropout比率對模型性能的影響,本文以Dropout比率作為自變量,模型的RMSE值作為因變量,在自定義軍事訓練數據集上進行了對比實驗,實驗結果如圖6所示。

Figure 6 Influence of Dropout rate on model performance圖6 Dropout比率對模型性能的影響

從圖6可知,隨著Dropout比率的逐漸提高,模型性能呈現出先升高后下降的趨勢。這是由于Dropout比率過大時,神經網絡中大部分神經元處于休眠狀態,使模型的表達能力下降,處于欠擬合狀態;而Dropout比率過小時,神經網絡中大部分神經元處于活躍狀態,模型很容易出現過擬合狀態。這反映出恰當的Dropout比率設置可以有效緩解過擬合,使模型具有更好的泛化能力。根據以上實驗結果,在下一步的模型性能對比實驗中將Dropout比率設定為0.5。

5.5.3 模型性能對比實驗

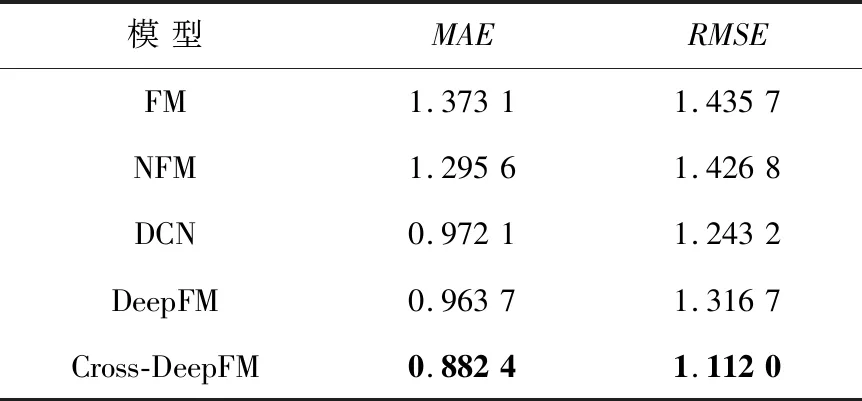

為了客觀地驗證本文模型的性能,本文將使用最優參數組合條件下的Cross-DeepFM模型與4.5.4節介紹的4個推薦模型進行對比實驗,通過RMSE和MAE指標評估模型性能。最終實驗結果如表3所示,表中數據均為5次實驗結果的平均值。

Table 3 MAE and RMSE comparison of different models表3 不同模型的MAE和RMSE

分析實驗結果可以得到如下結論:

在使用相同數據集的情況下,深度學習模型的性能比因子分解機等傳統淺層模型的性能更優。主要原因在于:首先,傳統淺層模型的局限性在于其只能學習線性特征,而深度學習推薦模型能夠以非線性方式對參訓人員和訓練科目進行建模;其次,一些深度學習技巧如Dropout、殘差連接等能夠有效抑制過擬合,提高了模型的泛化能力。

本文提出的Cross-DeepFM模型在軍事訓練數據集上的MAE值和RMSE值均優于對比模型的,取得了最優的結果。在自定義軍事訓練數據集上,Cross-DeepFM模型的MAE值為0.882 4,相比對比模型中表現最好的DeepFM模型,下降了6.3%;RMSE值為1.112 0,相比表現最好的DCN模型,下降了3.6%。該實驗結果表明,Cross-DeepFM模型結合了因子分解機、深度交叉網絡和深度神經網絡的優點,能夠有效提高評分預測和成績預測的準確度。

6 結束語

本文基于因子分解機、深度交叉網絡和深度殘差神經網絡,提出了Cross-DeepFM模型,并將其應用于軍事訓練推薦系統。最后在自定義軍事訓練數據集上進行了對比實驗,實驗結果驗證了本文模型的準確性和優越性。下一步將在本文工作的基礎上繼續進行以下2個方面的研究:一是融入評論文本等多源異構數據,提高模型準確度;二是針對算法運行效率做出改進,提高算法在大規模數據集上的運算速率。