基于分布式無線傳感網絡的電纜隧道無人機巡檢技術

馬聰,李德泉,汪培月,王興振,侯建峰

(國網山東省電力公司濟南供電公司,山東濟南 250000)

隨著計算機科學、智能電站的快速發展,電纜隧道巡檢手段不斷從人工巡檢向智能巡檢的方向發展。電站管理人員借助物聯網等通信設備可以進行遠程巡檢,大幅度提高了巡檢效率,降低了人員受傷的可能。

具有自主導航和環境感知能力的無人機在物流、運輸、偵察等領域應用廣泛,但大多數無人機并不適合在電纜隧道內使用,即使訓練有素、經驗豐富的飛行員也難以確保絕對安全的遠程操作。

為了實現大規模的智能化隧道巡檢,該文采用了可以廣泛部署的低成本傳感器,總體設計了基于擴展卡爾曼濾波器(EKF)的多傳感器融合框架。由于隧道圖像的共同背景和色彩紋理較為復雜,該文提出了一種基于卷積神經網絡特征的快速深度卷積神經網絡(R-CNN)方法來定位故障元件,將目標分類問題轉化為目標檢測和識別問題。使用轉移學習的方法學習目標的基本特征,并根據學習結果在圖像中準確定位故障區域。

1 無人機傳感網絡設計

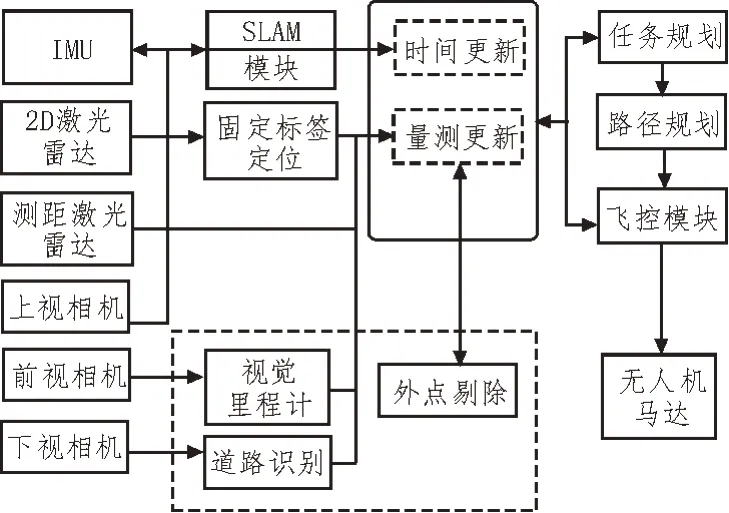

該文設計的系統架構包括傳感器、軟件算法模塊、基于擴展卡爾曼濾波的多傳感器融合框架等[1],具體如圖1 所示。

圖1 自主無人機的整體系統架構

為了實現魯棒的隧道內自主導航,無人機傳感系統由一個2D 激光雷達、一個測距激光雷達、3 個攝像頭(向前、向上和向下)和一個慣性測量單元組成。

在實現無人機的自主運動前,需要無人機所處的環境地圖[2]。該文基于XML 標簽,在坐標系中存儲無人機的位置和姿態,然后將這些姿勢附加到每個機架的預定位置。當無人機觀察到標簽時,即可根據標簽識別所計算出的結果更新無人機的定位信息。

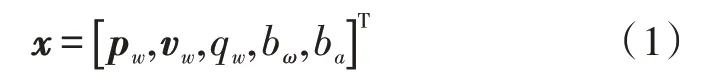

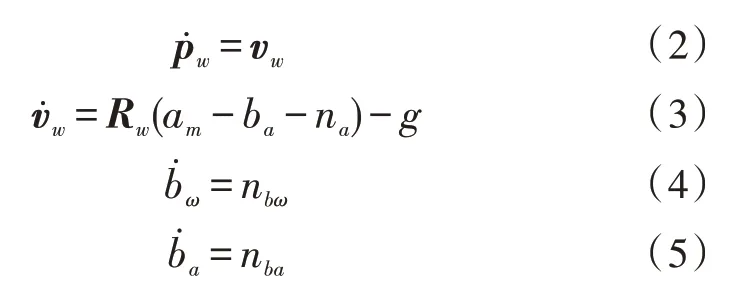

該文假設IMU 傳感器的姿態與UAV 的姿態相同。EKF 的狀態由以下位置組成:坐標框架{W}中IMU 的定位向量為pw,速度向量為vw,其方向四元數描述了IMU 相對于W的旋轉,陀螺儀偏置為qw,加速度計偏置[3]為ba。無人機的總體狀態由16 維狀態向量x表示:

從而可以得出以下微分方程:

其中,Rw是與四元數qw相對應的旋轉矩陣,am是IMU測得的加速度[4],na、nbω、nba是高斯噪聲[5]。該文將偏置項建模為隨機浮動,取微分方程式(2)-(6)的期望值,并定義式(1)的誤差狀態向量Δx,得到線性化的誤差狀態方程。測量模型將狀態向量和傳感器測量值關聯為:

其中,z是測量向量,如位置、歐拉角和姿態;h(x)是相應的測量模型;n是高斯測量噪聲[6]。該次采用模塊化多傳感器融合框架,其中各個傳感器的測量數據更新相互融合,以獲得狀態的最佳估計。

文中用于更新EKF 濾波器的最小傳感器系統包括:1)攝像頭:測量6D 絕對姿態機架上標簽的姿態。2)2D 激光掃描儀以及IMU 傳感器。3)下視測距傳感器:估計無人機的高度。

從理論上講,此概念應保證足夠一致的結果,因為通過組合絕對姿態和相對姿態測量,始終可以獲得完整的6D 姿態。但由于系統不確定性和不完整的傳感數據,系統估計不可避免地存在漂移、離群值和測量干擾。此外,相比基于視覺的自主導航,隧道環境的情況更加復雜,若不解決此類問題,則無法保障自主操縱無人機的安全,所以該文設計了魯棒的異常數據剔除算法。

異常值通常是由傳感器故障、較大的識別錯誤或不良的測量環境引起的。為了消除測量異常值,采用馬氏規則來剔除異常數據。

在任務飛行期間,分別檢查馬氏規則的特定組成部分,對于機器人定位標簽的偏航角、俯仰角或來自SLAM 定位的橫向位置,若其中某一項或幾項大于預定閾值時,該文設計的EKF 框架將拒止相應的測量部分,從而有效降低錯誤拒絕率。

2 基于Faster R-CNN的巡檢算法

傳感器網絡主要依靠視覺相機實現對隧道內有價值目標的準確檢測,因此選用Faster R-CNN 檢測網絡實現實時巡檢算法[7]。

由于電纜線路檢查的復雜性,無人機不易獲得真實的采樣圖像。但神經網絡需要大量的樣本,以實現高精度訓練。因此采用轉移學習方法,使用公開數據獲得預訓練模型,以構建檢測網絡。

為了確定檢查過程中的電纜故障,將正常元件、損壞元件和干擾物圖像構建為訓練集,并通過包含目標和類別的最小矩形框的坐標進行標記圖像。利用特征提取網絡的卷積層,可以生成訓練集中隨機大小的正常元件、受損元件和干擾物圖像的相應特征,然后添加基于滑動操作的卷積層以預測包含目標的窗口位置。

當小窗口中的信息被識別為目標時,將區域保留并轉換到網絡中。若將小窗口中的信息識別為背景,則將該區域丟棄。

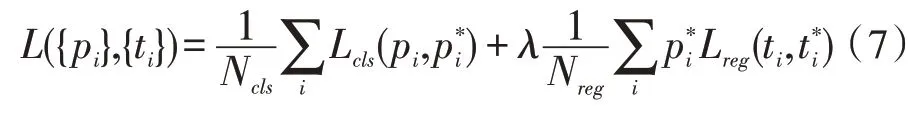

在訓練集的基礎上,基于ResNet 網絡中的共享卷積層提取圖像的深層特征[8]。綜合考慮卷積層的區域信息,使用隨機抽取的方法篩選不同大小的圖像輸入網絡池層。為了保證網絡輸入的一致性,將不同大小的圖像標準化為固定大小的數據,并輸入ResNet。然后通過兩個完整的連接層連接到高維特征向量[9],第一個完整的連接層用于實現對目標的分類;網絡所用的第二個連接層主要用于驗證數據合理性,同時負責區域回歸算法的實例化[10]。在訓練過程中,神經網絡的參數并非不發生改變,隨著訓練的進行,網絡參數通過下述的損失函數進行調整:

其中,i是用于索引訓練集數據的錨點,預測定義錨點i的預測概率為pi[11]。

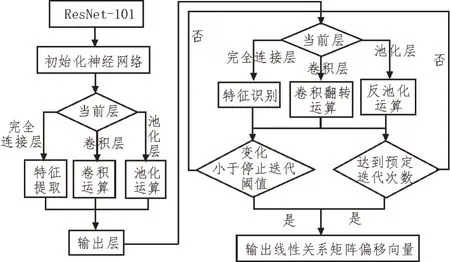

在具體實現時,網絡使用隨機梯度下降法最小化損失函數的輸出,以實現最小化反向傳播過程中的損失函數[12-14]。算法整體流程如圖2 所示,詳細步驟如下:

圖2 算法流程

1)基于ResNet-101 網絡模型,初始化權重W和初始化神經網絡的偏移b。

2)前向傳播計算分下述三種情況:

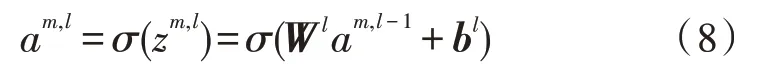

①若當前層是完整連接層,則:

其中,am,l代表第l層中m個圖像樣本的輸出值,σ為激活函數[15]。

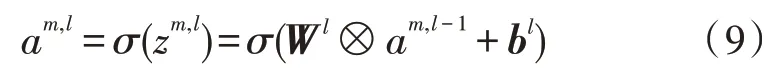

② 若當前層是卷積層,則:

③若當前層是池化層,則需要進行降維操作。

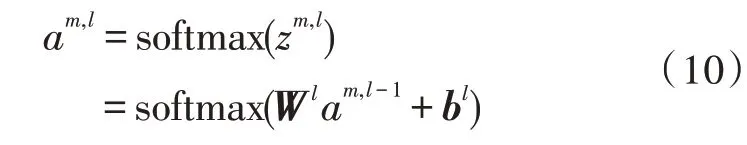

3)對于輸出層l有:

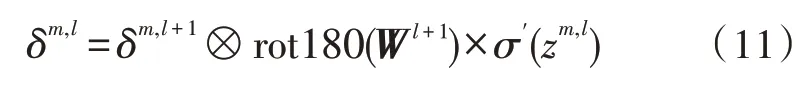

4)基于損失函數J(W,b),反向傳播參數分別按照以下三種情況計算:

①若當前層是完整連接層,則使用標準隨機梯度下降法。

② 若當前層是卷積層,則:

其中,rot180 是卷積核的函數,具體實現為卷積內核上下翻轉,然后左右翻轉。

③若當前層是池化層,則進行反池操作。

5)根據以下兩種情況更新l層的Wl和bl:

若當前層是完整連接層,則:

其中,α是學習率。

若Wl和bl的所有變化均小于停止迭代閾值或達到預先設定的迭代次數,則跳轉至步驟6)。

6)輸出每個隱藏層與輸出層的線性關系矩陣W和偏移向量b。

該文使用標記的隧道內部圖片作為驗證集,通過檢驗網絡輸出的預測區域信息與實際網絡之間的差異,最終調整整個網絡的權重[16]。經過足夠的訓練,Faster R-CNN 可以檢測興趣目標的準確位置和標識。

3 實驗驗證

為了對該文設計的無人機巡檢平臺進行性能驗證,選取傳感器網絡搭建了傳感系統,在隧道環境中進行巡檢實驗。

文中選取低成本2D激光雷達Hokuyo UST-10LX(具有270°視場和10 m 測量范圍),一維距離傳感器Terabee TeraRanger One(可測高度上限為14 m)。向前和向上的攝像機是分辨率為752×480 的單色攝像機,具有全局快門功能并配備平角和廣角鏡頭。向下的相機是分辨率為1 280×960的全局快門彩色相機,該文使用嵌入在Pixhawk3 中的IMU 傳感器。無人機的長寬均為74 cm,包括電池在內的重量為3.2 kg。為了實現隧道巡檢的高性能故障定位,該次實驗在裝有Intel Core i7-7700 K、CPU(4.0 GHz)、16 GB DDR3和1080Ti顯卡、11 GB 內存的Windows PC 上進行。

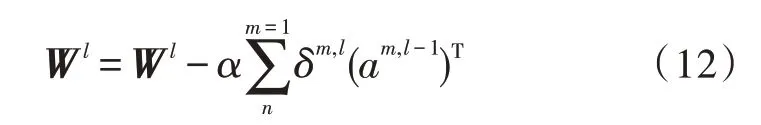

在實驗的隧道環境中,共有32 個檢查位。隧道巡檢區域長60 m,寬55 m。圖3 為自主無人機執行的單個路徑上的環境感知圖。

圖3 無人機環境感知圖

該文設計的自主無人機可以完成在電纜隧道中全面檢查和周期盤點的任務,能夠代替人工完成常規的隧道巡檢。

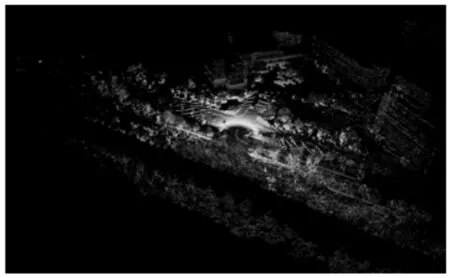

無人機在高壓線路檢查中所拍攝的圖像可分為3 類,包括元件損壞的120 幅圖像、雜物120 幅圖像、正常元件320 幅圖像。按照4∶1 的比例,訓練集由448個圖像組成,測試集由112個圖像組成。由于計算資源的限制,將原始圖像的分辨率調整為1 000×750。

如圖4 所示,所有圖像均以最小矩形框標記,并以VOC2007 的XML 格式保存。當識別的外圍框架與標記的外圍框架之間的重疊區域大于標記區域的90%時,則被認為是成功識別。該文所提出的方法性能通過分析識別精度和召回值來進行評估。

圖4 數據集示例

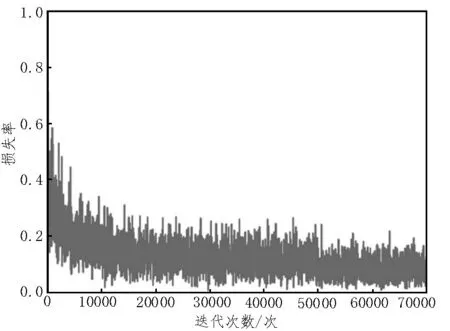

深度學習框架基于Caffe 搭建,并選擇由大數據集ImageNet 預訓練的ResNet-101 作為網絡模型。Faster R-CNN 的訓練使用動量法進行,該次使用0.000 1 的權重衰減和0.9 的動量。前40 000 個小批次的學習率為0.001,接下來30 000 批次的學習率為0.000 1,最大步長值為70 000,訓練損失如圖5 所示。

圖5 訓練損失

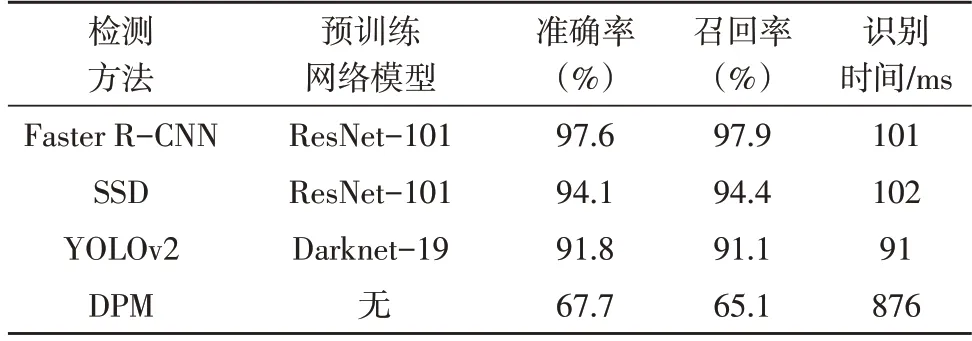

為了分析所提方法的有效性,使用了一系列不同的目標檢測方法進行對比實驗,如表1 所示。

表1 檢測方法對比實驗

使用ResNet-101 預訓練網絡模型時,Faster RCNN 的平均識別準確率為97.6%,平均召回率為97.9%。此外,單個圖像的平均時間成本為101 ms,可以有效檢測出隧道中的問題元件,并且兼顧了成本開銷。

4 結束語

該文設計了一種具有低成本傳感系統和多傳感器融合框架的自主無人機,其可以有效地用于狹窄和黑暗的隧道環境。為了自動定位故障元件,提出了一種基于Fast R-CNN 方法的深度卷積神經網絡。將目標分類問題轉化為目標檢測和識別問題,可以準確實現對故障元件的檢測。

在今后的工作中,如何使用有限的計算資源,實現自主巡檢無人機平臺的大規模部署將是研究的重點。