基于U-Net改進的多尺度融合超聲神經分割算法研究*

張克雙,鄔春學,張 生,林 曉

(1.上海理工大學光電信息與計算機工程學院,上海 200093;2.上海師范大學信息與機電工程學院,上海 200030)

1 引言

在獲取患者頸部超聲圖像的過程中,由于病人的晃動以及超聲儀器電子器件的擾動,使采樣到的超聲圖像中廣泛存在散斑噪聲,這給臨床治療帶來很大的挑戰。并且超聲圖像中存在前背景顏色相近、陰影和低對比度區域,僅利用顏色、紋理等信息難以準確分割病變區域[1]。近年來,針對頸部臂叢神經分割的研究主要依靠傳統方法,如基于閾值的直方圖雙峰法、Sobel算子、分水嶺算法和區域分裂合并法等。但是,基于深度學習的研究較少,龍法寧等人[2]提出了一種基于U-Net(U-shaped Network)[3]卷積神經網絡的臂叢神經超聲圖像分割算法QU-Net,引入了一種新的損失函數。楊桐等人[4]提出了一種基于SegNet(Segmentation Network)模型的臂叢神經超聲圖像分割算法,對分割后的結果使用自適應對比度增強的方法使超聲圖像的顯示更加清晰。

上述傳統方法分割速度快,但是對噪聲敏感,且模型的建立需要手工設計圖像特征,過程復雜繁瑣,模型的魯棒性和泛化能力也表現一般[5]。而基于U-Net和SegNet的深度學習分割算法,都沒有考慮從多尺度角度提取目標特征,也沒有解決連續下采樣帶來的小尺寸目標的丟失問題。本文提出一種基于U-Net的多分支融合改進算法,針對U-Net的普通卷積層和池化層的缺點同時進行優化,使用密集網絡[6]替代原有普通卷積層,使得較淺層提取出的特征仍可能被較深層直接使用;使用多尺度骨干網絡Res2Net[7]來改進普通卷積層,對每一層使用多個相同尺度的卷積核進行特征提取,在原有的殘差[8]單元結構中增加小的殘差塊,增大每個神經元感受野大小,且可以有效降低梯度消失的風險;使用深度可分離卷積[9]來代替原有的卷積層,在不改變網絡復雜結構的基礎上,提升網絡的性能;池化層降采樣的同時會丟失目標物體的位置信息,本文算法將使用帶有空洞的空間金字塔池化層代替U-Net網絡中層、深層的最大池化操作,以減少信息丟失。

2 相關研究

2.1 U-Net網絡結構

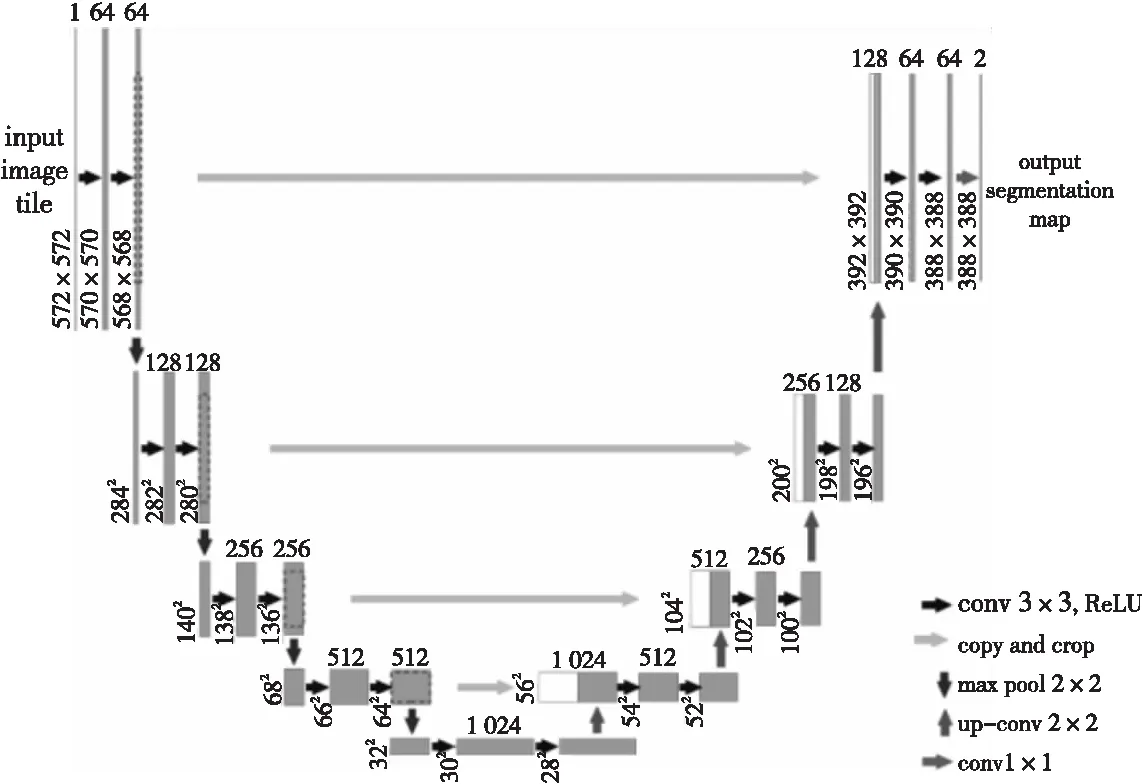

傳統CNN(Convolutional Neural Network)對醫學圖像中目標的分割往往是以像素的鄰域像素塊作為其輸入,卷積核在輸入圖上滑動時,一方面所需的存儲空間較大,另一方面由于圖像各區域之間存在較多相似性,容易造成過分割,得到不符合人類視覺特性的分割結果[10]。

全卷積神經網絡FCN(Fully Convolutional Network)[11]的出現使得網絡不再局限于特定尺寸的輸入圖,可實現端到端的語義分割[12]。FCN解決了大部分自然圖像分割的難題,但生物醫學圖像具有樣本數量少、分割要求精度高、對細節信息敏感等特點[12,13],FCN單次上采樣難以融合淺層特征的位置、邊緣等信息,導致其應用在生物醫學領域效果不理想。直到2015年,ISBI(IEEE International Symposium on Biomedical Imaging)競賽中提出了U-Net網絡結構,該結構通過對網絡編碼以及對稱地對網絡解碼,構成了一個U 型結構,完善了FCN擴張路徑,并且僅需要少量數據進行訓練,對生物醫學圖像的分割有很大貢獻。

U-Net網絡是一種全卷積神經網絡,其結構如圖1所示,整個網絡共有23個卷積層,其中卷積層有19層,反卷積層[13]有4層。收縮路徑階段采用卷積操作和最大池化操作降低圖像分辨率,以提取淺層和深層特征信息,其中每個下采樣操作中包含2個連續的3×3卷積層和1個步長為2的2×2最大池化層,采用修正線性單元ReLU(Rectified Linear Unit)作為激活函數。下采樣后的特征圖尺寸變為原來的一半,但通道數加倍,以保證特征的豐富性。擴張路徑階段,每個上采樣都包含1個2×2的反卷積結構和2個連續的3×3卷積結構,以逐步擴大圖像尺寸至原始圖像大小,實現端到端的語義分割。其中反卷積操作將低分辨率的特征圖增大,再將其與下采樣階段尺寸相同的特征圖進行拼接融合,再使用3×3卷積對融合特征進行進一步提取,激活函數仍采用ReLU。網絡的最后階段,將上采樣至原圖尺寸的特征圖使用1×1的卷積核卷積,激活函數使用Softmax,以完成像素級別的分類。

Figure 1 Structure of U-Net network圖1 U-Net網絡結構

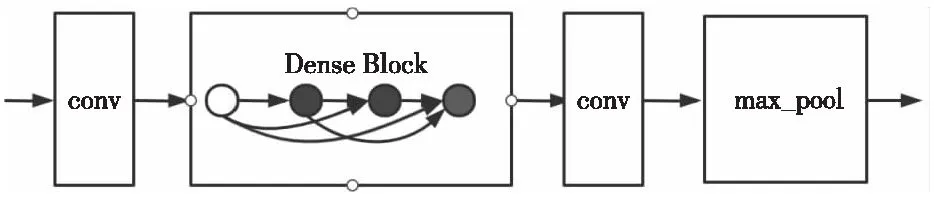

2.2 DenseNet密集連接的卷積網絡

密集連接網絡DenseNet使得網絡中的每一層都和輸出建立直接的連接,很大程度上避免了梯度消散的問題,其結構如圖2所示。同時,DenseNet的提出打破了通過加深網絡層數和拓寬網絡寬度來提高網絡性能的常規思路,加強了特征重用,大幅減少了參數數量,相較于傳統的卷積,特征復用是一種更好的特征提取方式。

Figure 2 Structure of DenseNet network圖2 DenseNet網絡結構

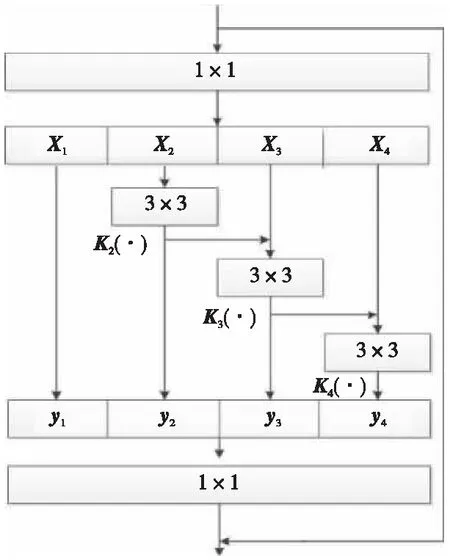

2.3 Res2Net網絡

Res2Net是一種將多尺度特征進行融合的神經網絡基本單元,其結構如圖3所示,其中變量含義見3.4節。本文將用其替代U-Net中層和深層卷積層,此結構是在原有的單個殘差結構中添加分層的殘差連接,采用多個小卷積核代替大卷積核的理念,增大同層中神經元的感受野,用于更好地捕獲區域特征的相關性,提高像素級分類的準確性。其中,在第1個1×1卷積后,將輸入劃分為s個子特征,定義為Xi,i∈{1,2,…,s},每一個特征的尺度相同,但通道數是輸入特征數的1/s,除了X1其他的子特征都用相應的3×3卷積核進行卷積,卷積核定義為Ki(·),其輸出為yi。最后,采用1×1卷積層壓縮通道,進行通道之間的融合,減小參數數量,降低計算量。

Figure 3 Structure of Res2Net圖3 Res2Net結構

2.4 改進的ASPP網絡

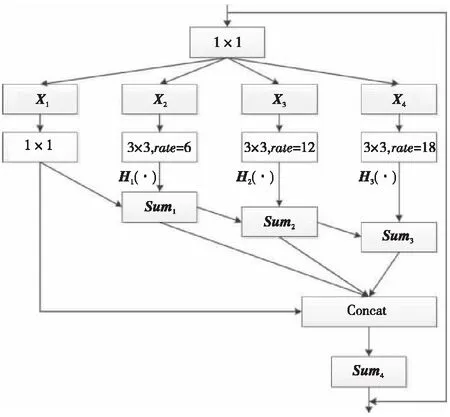

輸入圖像中出現小目標物體時,經過多次池化后,目標信息會完全丟失。ASPP(Atrous Spatial Pyramid Pooling)網絡中使用了帶有空洞的卷積,實驗中發現,空洞卷積對小目標邊緣分割得到的邊界更清晰。但是,空洞卷積的引入也會帶來網格問題。針對此,本文在ASPP的基礎上引入HFF (Hierarchical Feature Fusion)[14]結構,作為本文改進的ASPP網絡結構,其中HFF將ASPP網絡的卷積結果進行分層特征融合,以彌補空洞卷積帶來的網格效應,如圖4所示。

Figure 4 Structure of improved ASPP network圖4 改進的ASPP網絡結構

本文算法使用改進的ASPP網絡結構替代U-Net中層和深層的最大池化層。其中每一個Xi都會用相應的3×3卷積核對其進行操作,相應卷積核用Hi(·)表示。sumi表示Hi的輸出。

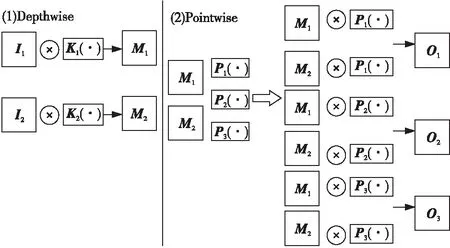

2.5 Xception結構

Xception主要采用深度可分離卷積,就是將普通卷積操作拆成2步實現,第1步為Depthwise,即對輸入通道進行一對一的普通卷積,其中Ii表示單通道的輸入特征圖,此后使用單個卷積核對Ii進行卷積操作得到輸出特征圖Mi;第2步為Pointwise,將經過Depthwise操作得到的所有輸出特征圖進行通道級別的拼接后,使用1×1的卷積核Pi(·)對其進行普通卷積后得到輸出特征圖Oi。Xception結構如圖5所示,在本文中將用于替代深層U-Net網絡中的卷積結構。

Figure 5 Xception structure圖5 Xception結構

3 多尺度融合的U-Net超聲神經分割算法

高質量的視覺顯著性模型可以使用深度卷積神經網絡抽取多尺度特征進行學習[15],鑒于U-Net卷積網絡深度稍有不足且沒有從多尺度角度提取特征信息,本文提出基于U-Net改進的多尺度融合分割算法。算法原理如下:(1)考慮到特征之間存在連續性,在U-Net網絡編碼階段加入密集連接網絡DenseNet,使得靠近輸入端的淺層特征仍有可能被使用。(2)為使各層之間的局部信息得到訓練,保證各層之間是收斂的,以達到最佳的分類效果[16],加入殘差網絡和批正則化,在確保網絡深度的同時,避免出現梯度消失及模型退化問題。(3)池化層的作用是降低計算量,避免過擬合,節省內存開銷,但是因為超聲神經圖像尺寸小、語義信息少,隨著池化層使用的增加,丟失的信息會增多[17],增加了語義分割的難度。對此使用改進的ASPP網絡替換U-Net下采樣階段深層最大池化操作,在不降低深層特征圖分辨率的前提下增大神經元感受野范圍,減少信息的損失。(4)考慮到U-Net網絡沒有從多尺度層面提取特征,本文使用Res2Net代替普通卷積,并采取特征圖分組的思想加強多尺度語義信息提取能力。(5)為提高本文模型訓練速度,采用Xception結構替代U-Net網絡中的深層卷積層,加速本文模型收斂。

3.1 網絡結構

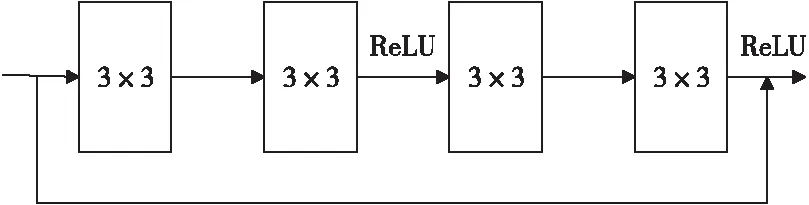

在原U-Net中,網絡的收縮路徑和擴張路徑采用2個普通的卷積層,本文對這一結構進行改進:在2個卷積層之間加入殘差連接,將單個卷積層卷積后的輸出結果,通過正則化層處理后作為激活函數的輸入。改進后的Resblock結構如圖6所示。

Figure 6 Resblock圖6 Resblock

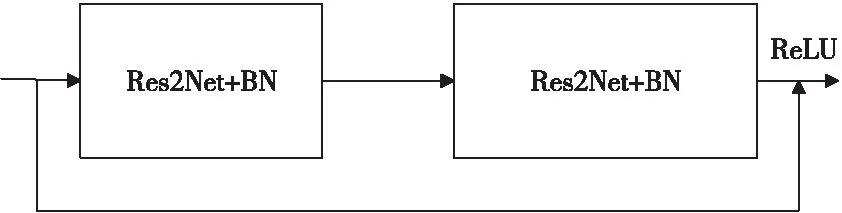

本文在Res2Net結構的基礎上添加組內的正則化代替原U-Net的中層普通卷積層,改進后的結構Res2Net_block如圖7所示,其中BN(Batch Normalization)表示批次歸一化。

Figure 7 Res2Net_block圖7 Res2Net_block

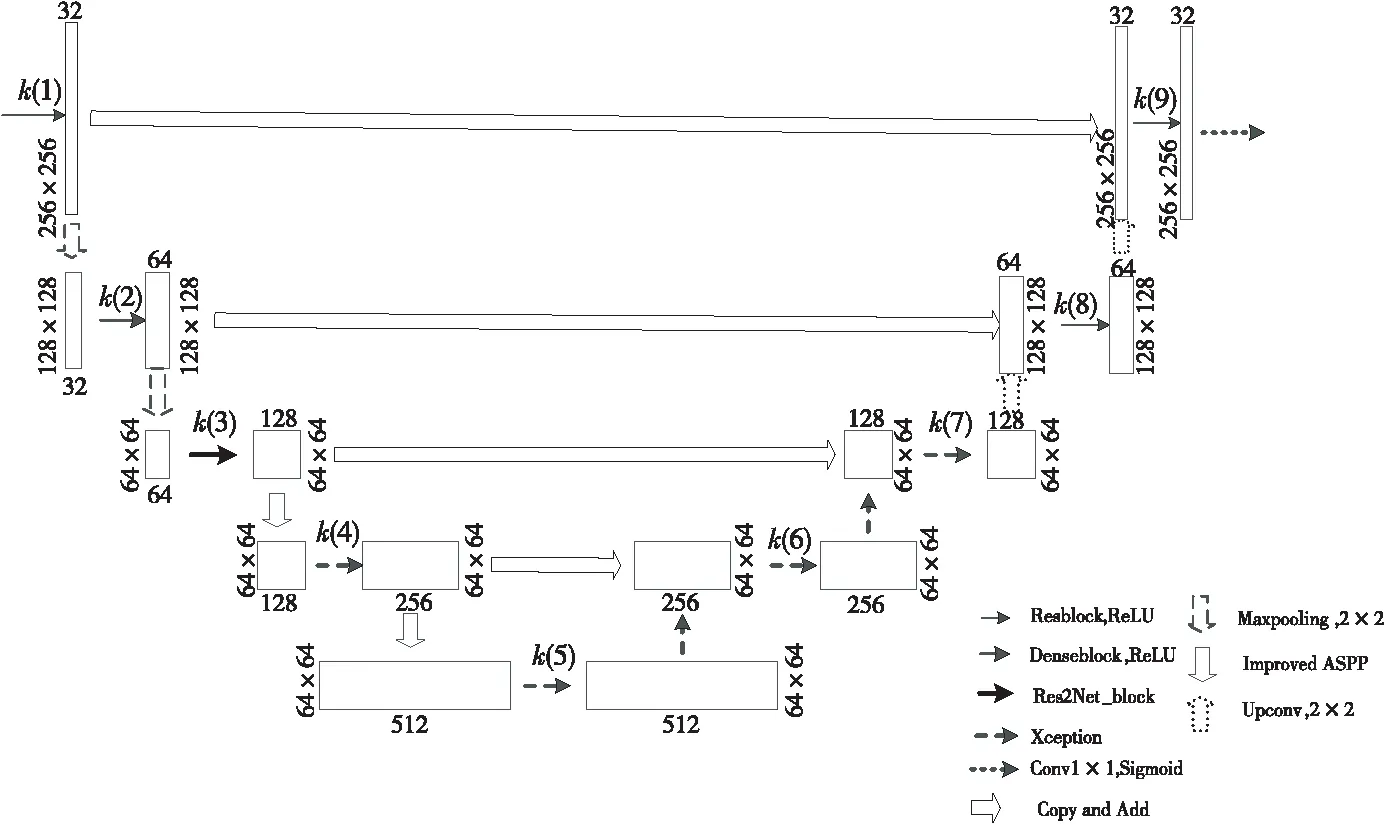

改進后的網絡在保留U-Net對稱結構的基礎上構建多尺度融合網絡。網絡結構仍左右對稱,該網絡結構結合了多種多尺度結構與殘差網絡的特點,且在激活函數前對每一層輸出結果進行批標準化處理。與U-Net擴張路徑不同的是,上采樣階段沒有采用與收縮路徑相對應的特征圖的拼接,而是改用像素值相加的方式形成從輸入到輸出的多條路徑,每條路徑相當于FCN的一個變體[18]。改進后的多尺度融合的U-Net網絡結構如圖8所示。

Figure 8 Multi scale fused U-Net network structure圖8 多尺度融合的U-Net網絡結構

本文改進的網絡結構按照下采樣層劃分各卷積層,卷積層記為k(i)。網絡編碼階段,網絡的輸入是256×256的灰度圖,k(1)使用Resblock結構來代替原普通卷積層,該操作得到32幅分辨率為256×256的特征圖,此后連接到k(2)中密集連接網絡的Dense Block和transition layer,DenseNet中的growth rate設置為3,該操作得到64幅128×128的特征圖。本文在k(1)、k(2)和k(3)之間仍然采用kernel為2×2,stride為2的最大池化層。因為在語義信息提取上,允許少量信息的丟失,且池化層的存在可以很大程度上減少計算量,降低模型的過擬合概率。k(3)中使用改進的多尺度骨干網絡Res2Net,在達到2個3×3普通卷積特征提取效果的同時,提高語義特征的豐富性,該操作得到128幅分辨率為64×64的特征圖。此后,因為深層特征圖包含的語義信息更多,于是在k(3)、k(4)和k(5)之間使用本文改進的空間金字塔池化層,其中空洞卷積率rate=6,12,18,輸出特征圖數量為128。k(4)和k(5)中分別使用深度可分離卷積來代替普通卷積,很大程度上降低了參數數量,加快了模型收斂。k(4)操作得到256幅64×64的特征圖,k(5)操作得到512幅分辨率為64×64的特征圖。使用張量相加運算替換 U-Net 中的concatenation 張量連接。

網絡解碼階段,首先使用256個卷積核對深層語義特征圖進行卷積,并將卷積后的特征圖與下采樣過程中通道數和尺寸大小相同的特征圖融合。融合后的結果使用k(6)卷積后獲得分辨率為64×64的特征圖。同樣,對64×64的特征圖進一步解碼,得到的結果仍然與下采樣過程中分辨率和通道數相同的特征圖進行融合,融合后的結果使用卷積層k(7)操作后,得到輸出通道數為128,分辨率為64×64的特征圖。此后,對此特征圖進行卷積核大小為2×2,步長為2的反卷積操作,得到64幅大小為128×128的特征圖up8。將特征圖up8和k(2)卷積操作后的結果通過卷積核為3×3,步長為1的k(8)操作后,得到分辨率大小為128×128,輸出通道數為64的特征圖。繼續采用反卷積操作,最終得到與原圖尺寸一樣的特征圖,將其與k(1)卷積后的淺層特征層合并后,再采用k(9)卷積操作進一步融合特征圖。網絡的最后采用卷積核為1×1,步長為1的卷積操作,經過Sigmoid激活函數,輸出最終的分割圖,完成對輸入圖像的端到端的操作。

本文網絡模型每層參數和激活函數的詳細信息如表1所示。表1中,Conv表示卷積層,Pool表示池化層,Deconv表示上采樣層,pixelAdd(Xception1)表示當前層和Xception1層進行像素級別的融合后的卷積層,BN為批正則化層,ReLu和Sigmoid為激活函數。

3.2 密集連接網絡DenseNet

在設計理念上DenseNet和殘差網絡都使用了跨層連接,但是兩者實現原理有明顯區別。殘差網絡使用的是k層的輸出加上k層輸出的非線性變換的結果作為k+1層的輸入,通道數沒有變化。而DenseNet為得到k+1層的輸入,會將之前所有層的通道進行合并,通道數大幅增加。本文將DenseNet的實現方式使用式(1)表示。

xi=Hi([x0,x1,…,xi-1])

(1)

其中x0,x1,…,xi-1作為第i層的輸入,第i層得到了之前所有層的特征映射,網絡在傳輸過程中每一層信息都會被后面所有層網絡使用。

3.3 改進的空間金字塔池化網絡

空洞卷積的主要作用就是在不降低分辨率的條件下增大感受野。本文改進的ASPP結構可以用式(2)表示:

(2)

Table 1 Parameters of multi-scale fused U-Net network structure

如圖4所示,對輸入圖用1×1卷積核卷積m(m=4)次,得到4個分塊,每個分塊標記為Xi,i∈{1,2,…,m},每個分塊用對應的空洞卷積運算。其中H1表示卷積核大小為3×3,卷積率為6的空洞卷積對X2操作得到的結果。將該層的結果與上一層的結果相加,表示該層的輸出。

本文改進的ASPP是將不同空洞卷積率的結果進行融合之后再進行拼接,以此來解決擴張卷積帶來的網格效應,從最小的膨脹卷積核輸出的特征圖開始,逐級疊加。這樣的做法并沒有引入任何新的參數,同時計算量上也沒有增加太多,實驗結果顯示網格效應得到了有效改善。

3.4 多尺度骨干網絡Res2Net

改進后的U-Net中引入了Res2Net,Res2Net的基本網絡結構如圖3所示,本文中將此網絡結構使用式(3)表示:

(3)

首先對輸入特征圖進行1×1卷積處理后,按通道數均分為s(圖中s=4)塊,每一部分是Xi,i∈{1,2,…,s},其中每一個Xi都會用相應的3×3卷積核對其進行操作,由Ki(·)表示。yi表示Ki的輸出。

3.5 損失函數

本文損失函數采用Focal Loss,如式(4)所示:

(4)

其中,γ是特征選擇因子,本文中γ=2,對于那些網絡非常容易識別的正負樣本,Lfl的損失值會小得多,這樣就降低了簡單樣本的影響,使得網絡更加關注于難以區分的樣本。

該損失函數主要將輸出的裁剪區域與目標裁剪區域像素進行對比,可解決正負樣本中比例嚴重失衡的問題,降低大量簡單負樣本在訓練中所占的權重,使得網絡更有針對性地學習特征。

4 實驗及結果分析

為驗證本文提出的多尺度特征融合算法,采用kaggle超聲圖像神經分割競賽中的頸部臂叢神經數據作為輸入,訓練網絡模型,并與傳統醫療圖像檢測算法U-Net和SegNet[19]比較。實驗平臺采用谷歌深度學習平臺 Google Colaboratory,該平臺 GPU 型號為 NVIDIA Tesla T4,基于最新圖靈架構,并采用TensorFlow神經網絡框架進行訓練。

頸部臂叢神經數據集大約有5 000組超聲波掃描圖像,每幅圖像像素為256×256,人工注釋的標簽圖像記錄了待檢測目標尺寸大小和位置信息。該數據集的特點是輸入圖像信息量大,待檢測目標大小不一。候選神經檢測任務中,若檢測出的神經區域在真實標注的半徑范圍以內時,即認為是正確的檢測結果。實驗中,對頸部臂叢神經數據集進行10-折交叉驗證。

4.1 參數設置及評價指標

本文以4∶1的比例將數據集劃分為訓練集和測試集。使用本文所提算法對頸部臂叢神經數據集訓練的過程中,迭代次數設置為300次,batch size初始化為2,學習率初始設置為0.001,當迭代到200次時,學習率設置為0.000 1,參數的初始化方法為Xavier,參數更新采用Adam方法。

Dice系數是一種重要的分割評價系數,是一種集合相似度函數,所以其更注重于集合A和集合B中對應元素的相似性,更能對比像素間的相似性。本文使用Dice系數來評判模型的好壞。對于2個樣本,樣本之間相似度越高,Dice系數越大。Dice系數可用式(5)表示:

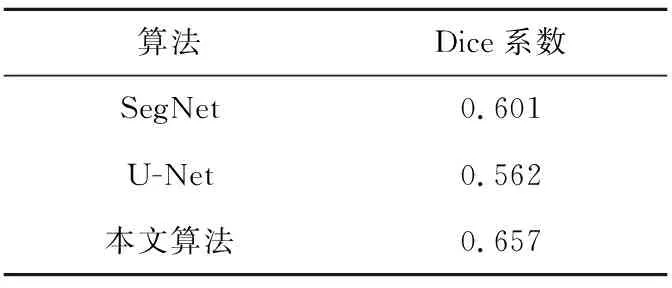

(5)

其中,smooth為平滑系數,X和Y分別表示預測值集合和標簽值集合,X∩Y表示2個樣本集合重合的部分,|X|+|Y|表示2個集合的總量。本文實驗中若預測值與標簽值完全重合,則Dice系數為1,由此可看出,Dice系數的值越接近1,說明2個樣本間的相似度越高,同樣也證明模型越好。表2對比了U-Net、SegNet算法和本文改進算法在相同數據集上的Dice系數,驗證了本文算法的準確性及合理性。

Table 2 Comparison results of Dice coefficients of three segmentation algorithms

從表2中可以看出,本文算法分割效果明顯高于SegNet和U-Net的。相較于SegNet和U-Net分割效果分別提升了9%和17%。

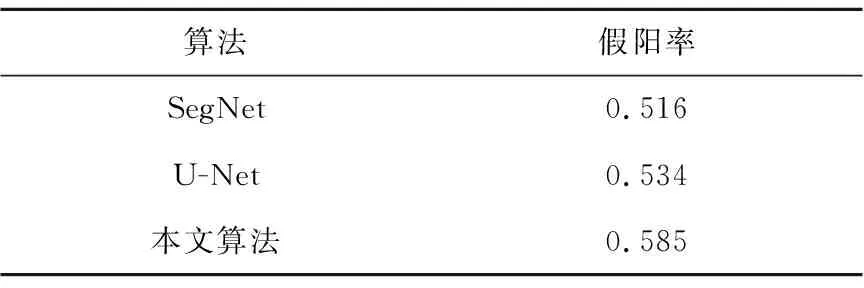

評判模型的優劣,除了模型對于數據集檢測的準確性以外,還有一個重要的指標——假陽率需要考慮。假陽率是指實際上這個檢測區域沒有疼痛神經的存在,然而檢測結果中卻含有疼痛神經的圖像數量占所有檢測結果的比值。如果一個改進模型的提出,使得疼痛神經的檢測精度有所提高,但同樣伴隨著假陽率的升高,那么該模型可用性就比較低,且不能夠商用。對此,分別統計U-Net、SegNet和本文算法的預測結果的假陽率,如表3所示。通過對比結果可以看出,3種算法在假陽率上沒有較明顯的差別,都沒有犧牲假陽率來提高檢測精度。

Table 3 False positive rate comparison of three segmentation algorithms

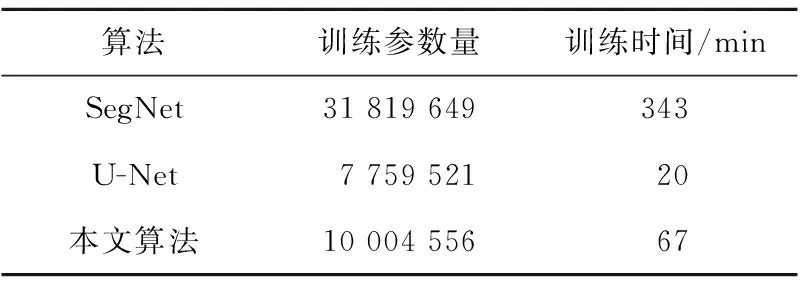

針對頸部臂叢神經數據集,本文提出的算法將多種多尺度網絡結構作為基本的卷積單元進行組合,同時使用1×1的卷積層構建瓶頸層進行特征維度壓縮。從表4中可以看出,本文算法參數及訓練時間都略高于U-Net的,但遠小于SegNet的。

Table 4 Comparison results of three segmentation algorithms with different parameter number

4.2 消融實驗

為了驗證Xception結構、本文改進的ASPP結構、深度密集連接塊DenseNet和Res2Net多尺度特征融合單元中哪個結構對本文所提算法在多尺度語義分割方面貢獻最大,進行了消融實驗。在消融實驗中,將本文算法的分割結果作為實驗中比較的基準,此外在本文算法的基礎上每次只去除上述結構中的一個,并分別命名為XU-Net、AU-Net、DU-Net和RU-Net。通過將XU-Net、AU-Net、DU-Net、RU-Net和本文所提算法應用于頸部臂叢神經數據集,可以獲得不同的目標分割結果,以便在消融實驗中比較不同的網絡結構。

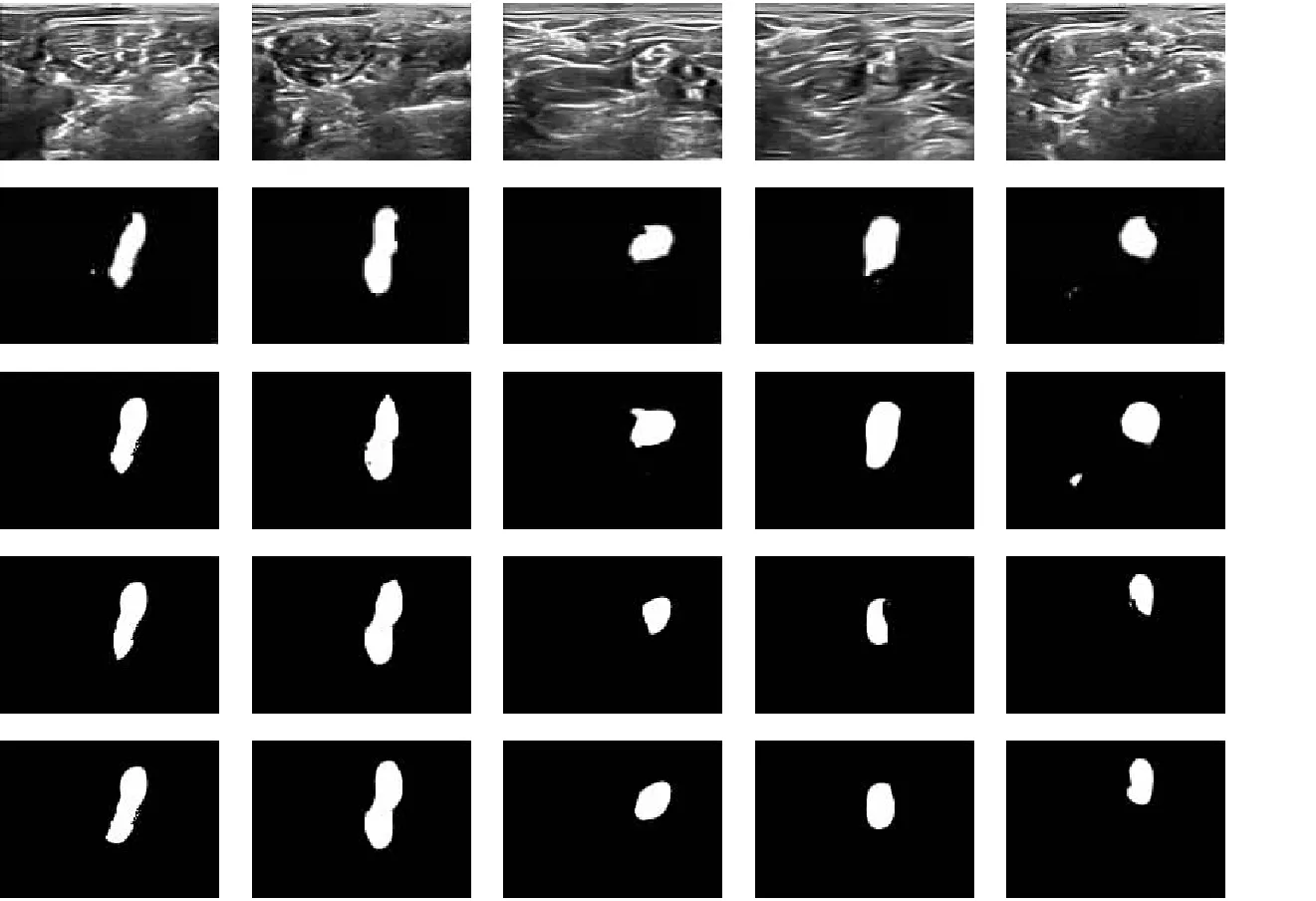

如圖9所示,高亮區域表示針對不同尺寸頸部臂叢神經的分割結果。從圖9中可以看出,XU-Net(圖9d)中由于去除了輕量級網絡Xception,實驗中得到的分割結果相較于本文算法變化不明顯,但從圖10中可以看出模型收斂速度明顯降低。AU-Net(圖9e)去除了ASPP單元,使得AU-Net在頸部臂叢神經分割方面的表現略差于本文算法,丟失了部分細節特征,說明了本文使用帶有空洞卷積的ASPP單元替換最大池化層的有效性。DU-Net(圖9f)去除了密集連接塊,造成其分割結果相較于本文算法效果更差,說明了特征的重復利用,以及淺層特征可以被深層特征使用,對多尺度細節邊緣修復的必要性。最后RU-Net(圖9g)由于完全去除多尺度單元Res2Net,以致在頸部臂叢神經區域分割結果中獲得了最差的效果,說明Res2Net在本文多尺度改進算法中貢獻最大。

Figure 9 Ablation experiment圖9 消融實驗

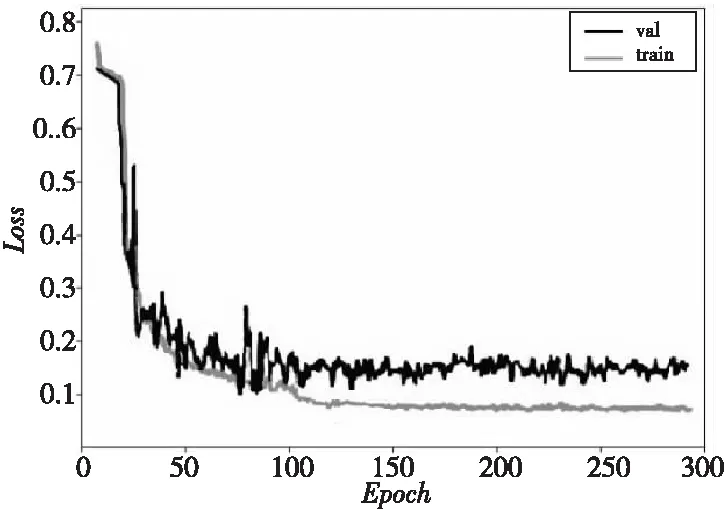

此外,除了視覺上對比,本文還對上述所提結構在同一計算環境下,分別應用在頸部超聲臂叢神經上訓練并對得到的Loss曲線進行了統計比較,如圖10所示。可以清楚地看到上述算法都隨著迭代次數的增加而收斂。此外,U-Net算法是醫學分割領域常用的語義分割算法,算法普適性和穩定性較好,但是對于頸部臂叢神經的分割從圖中可看出其損失值較高。XU-Net中去除了輕量級網絡Xception,從圖中可看出收斂效果要落后本文算法,但從圖9中可看出分割的精度并沒有明顯下降。而AU-Net和DU-Net都較之本文算法損失值更高,證明了本文算法添加空洞卷積和密集連接塊的有效性。RU-Net的表現同時差于AU-Net和DU-Net,接近于U-Net算法的分割效果,更加說明了下采樣過程中多尺度特征提取的必要性,從圖9中也能看出RU-Net對小尺寸神經區域分割結果最差。而與XU-Net、AU-Net、DU-Net和RU-Net相比,本文算法在頸部臂叢神經圖像上獲得了最佳的Loss值,同時在圖9中得到的分割結果也最接近標簽圖Ground Truth,這表明本文算法在集成了輕量級單元、空洞卷積單元、深度密集連接單元和多尺度特征提取單元后,對頸部臂叢神經圖像的精細化分割的實用性和有效性更高。

Figure 10 Loss comparison of different algorithms圖10 不同算法Loss值對比圖

4.3 實驗結果分析

本文算法在訓練過程中的Loss曲線隨迭代次數的變化如圖11所示,其中,灰色的曲線是本文算法在訓練集上的Loss,黑色的曲線為本文算法在測試集上的Loss。從圖11中可以看出,本文算法在預設參數下總體呈收斂狀態,且當訓練次數達到200次以后,Loss曲線的波動開始趨于穩定。

Figure 11 Loss curve of the proposed algorithm圖11 本文算法Loss曲線

Figure 12 Segmentation effect of normal and small size brachial plexus圖12 常規尺寸及小尺寸病變區域分割效果

圖12顯示了各算法對常規尺寸臂叢神經圖像和小尺寸臂叢神經圖像的檢測效果。圖12結果的顯示方式為5×5,由上至下,第1行代表原始數據;第2代表SegNet算法檢測的結果;第3行代表U-Net算法檢測的結果;第4行代表本文算法的檢測結果;第5行是標簽圖Ground Truth,由專家手工標注出頸部臂叢神經區域。此外,前2列是對直徑尺寸介于50 mm~100 mm的常規病變區域的檢測結果,后3列是對直徑小于50 mm的小尺寸頸部臂叢神經的檢測效果。可以看出,SegNet、U-Net和本文算法在50 mm~100 mm的頸部臂叢神經圖像上均得到了較好的邊緣分割結果,由此可知3種算法對輸入圖像都學習了一定的語義信息。但是,對于直徑在50 mm以下尺寸較小的神經區域,SegNet和U-Net出現了誤分割,而本文改進算法可以很好地表達邊緣特征。

實驗結果表明,U-Net、SegNet和本文算法,對常規尺寸病變區域的頸部臂叢神經圖像檢測均有很好的表現,可準確表達目標的位置信息及尺寸大小。然而在一些尺寸較小且邊緣復雜的病變區域分割中,U-Net和SegNet算法的假陽率升高,且由于連續池化層的操作使得兩者得到的分割邊緣不夠精細;而本文算法相較于這2種算法,在沒有犧牲假陽率的前提下,分割的結果更接近于標簽圖像,提升了分割精度,并且訓練模型所消耗的時間也處于正常的范圍,保證了實時性,一定程度上表明了本文算法融合多種多尺度單元的有效性。同時說明了本文算法在小尺寸病變區域的檢測分割上更有優勢,泛化性更好,可以在醫生診斷過程中,提供更有效的協助。

5 結束語

為了準確分割頸部臂叢神經超聲圖像中的疼痛區域,借此有效插入患者疼痛管理導管來提高局部麻醉外科手術的成功率,本文算法在U-Net算法的基礎上,引入多種多尺度網絡結構作為基本的卷積單元進行組合,增強特征提取的豐富性,并提高特征利用率;引入殘差網絡,增加網絡深度,使得網絡可以提取更高維度的語義特征,提高網絡的表達能力;加入批正則化處理,在提高模型訓練速度的同時,抵制過擬合現象的發生;改進損失函數,使得網絡更有針對性地學習通道特征。

實驗表明,本文算法的分割效果較SegNet和U-Net有很大提升,分割效果較醫學領域流行的分割算法U-Net提升了近17%,且對于正常尺寸及小尺寸的神經分割均有較高的分割精度,泛化性較好,可以更加準確地分割超聲圖像中頸部臂叢神經區域,有助于局部麻醉外科手術的順利進行。下一步將會在預訓練模型的基礎上訓練網絡,進一步提高分割精度。