基于多形態卷積神經網絡的遙感圖像融合方法

張應剛

(中國機械科學研究總院集團有限公司,北京 100044)

0 引言

對全色(PANchromatic,PAN)圖像和多光譜(Multi-Spectral,MS)圖像進行融合,可以獲得同時具有高空間分辨率和高光譜分辨率的遙感圖像。經典的分量替換法(Component Substitute,CS)[1~3],多分辨率分析法(Multi-resolution Analysis,MRA)[4,5]和基于模型的方法[6,7]等已取得了一定得融合效果,但仍存在空間細節和光譜失真問題[8]。大多數融合算法將源圖像視為單個成分并直接對其進行處理,而沒有考慮具有不同屬性的圖像的特性差異很大,因此通常會忽略源圖像中的某些細節。

Starck等人[9,10]提出了一種信號稀疏表示方法——形態成分分析(Morphological Component Analysis,MCA)。MCA在圖像分解[11]、圖像去噪[12]、圖像修復[13]等方向中都取得了良好的成效,它集合了多種經典變換基的優點,把圖像分解為多個形態成分,有效的表達了圖像成分。

隨著深度學習技術的迅速發展與廣泛應用[14],越來越多的研究人員將深度學習引入遙感圖像分類[15]、圖像融合[16]等。其中卷積神經網絡(Convolution Neural Network,CNN)[17,18]能夠更加出色的提取圖像的非線性特征,相較于眾多傳統的遙感圖像融合方法,基于卷積神經網絡的遙感圖像融合方法能夠學習全色圖像和多光譜圖像波段間的相關性,從而使該方法取得了顯著的融合效果,且端到端的融合更加便捷。

因獲取遙感圖像常攜帶高頻的噪聲和干擾,現有的經典融合算法和深度學習法把源圖像視為單個成分并直接對其進行處理,而沒有考慮具有不同源圖像的差異性,常會忽略圖像內容中的某些細節。因此,本文結合稀疏分解MCA法和CNN,提出了一種基于多形態卷積神經網絡(Multi-morphological Convolution Neural Network,MCNN)的遙感圖像融合方法,對待融合的源圖像先進行多形態成分的稀疏分解,獲得不同源圖像的紋理成分和平滑的卡通成分,然后利用CNN最終獲得具有高空間分辨率的多光譜圖像。

1 基于多形態卷積神經網絡的遙感圖像融合

1.1 基于形態成分分析圖像分解

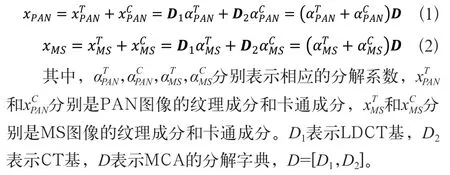

聯合局部離散余弦變換(Local Discrete cosine Transform,LDCT)和曲波變換(Curved Wave Transform,CT)作為MCA的字典,分別對單通道的PAN圖像和三個通道的MS圖像進行形態成分分析,提取其紋理成分和卡通成分。基于MCA的PAN圖像和MS圖像的稀疏分解分別如式(1)、式(2)所示。

假設待處理圖像是僅包含紋理或卡通成分且大小為的圖像,將該圖像表示為長度為的一維向量,該圖像就可以通過LDCT字典D1和CT字典D2來提取其紋理成分和卡通成份,即:

1.2 網絡的選取與設置

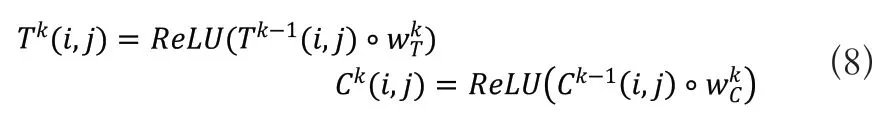

在融合網絡中,假設F(i,j)是融合圖像在(i,j)處的像素,PAN(i,j)和MS(i,j)分別是PAN和MS圖像的對應像素,T(i,j)和C(i,j)分別是紋理成分和卡通成分的對應像素。卷積運算定義為式(6)所示:

其中,x是卷積的輸入,w是卷積核,ReLU為非線性激活函數。

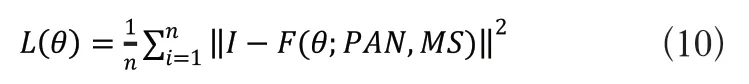

融合網絡包含10個卷積層,其中6個卷積層的大小為N×N(N>1),其余為(1×1)。通過這個網絡來表示融合函數F(PAN,MS)→F。設Tk(k=1,2,3)和Ck(k=1,2,3)分別表示紋理成分和卡通成分的第k層卷積層的輸出。

通過T(i,j)和C(i,j)計算融合像素F(i,j)。融合過程如式(6)所示:

在卷積運算的整個過程中,每一層都是在融合過程中參考前一層的融合結果,即多尺度成分融合,通過卷積運算獲得的最終融合圖像是不同成分比例圖像融合的結果。

1.3 MCNN算法流程

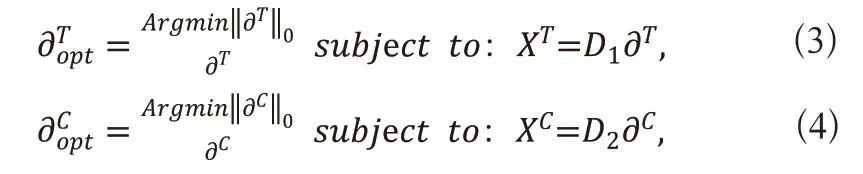

基于MCNN的遙感圖像融合方法的流程圖如圖1所示。詳細步驟如下:

圖1 MCNN算法流程圖

1)聯合LDCT基D1和CT基D2作為形態成分分析的分解字典D=[D1,D2],對輸入的源圖像PAN和MS分別進行形態成分分析,提取兩幅圖像的紋理和卡通成分。

3)將步驟2輸出的紋理分量和卡通分量再次作為輸入圖像,經過卷積神經網絡的融合后,得到最終輸出的融合圖像。

1.4 MCNN網絡結構

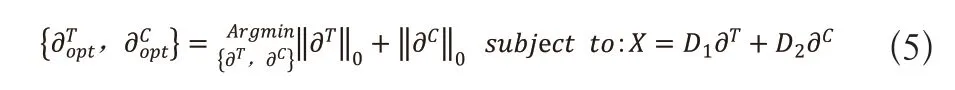

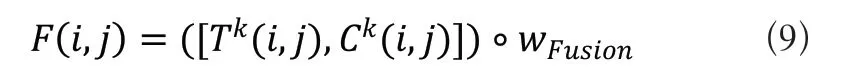

基于MCNN的遙感圖像融合方法的網絡結構如圖2所示。

圖2 MCNN 網絡結構圖

較大的卷積核和深度網絡會削弱融合的特性,增加計算的代價,因此在CNN模型中,我們將卷積核的大小N設為3,網絡深度設為4。根據原始圖像分別計算兩幅圖像的紋理成分和卡通成分。在生成Ti(i,j)和Ci(i,j)時,分別使用了兩個大小為3×3和1×1的卷積層,T1(i,j)/C1(i,j),T2(i,j)/C2(i,j),T3(i,j)/C3(i,j)的特征圖個數分別為32,64和128。最終的融合圖像有三個特征圖(R,G,B三通道),在生成融合的特征圖是,使用了3個1×1的卷積層,且特征圖的個數相同。

2 實驗結果與分析

2.1 實驗數據

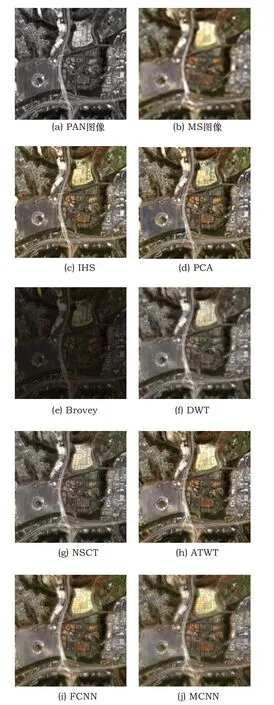

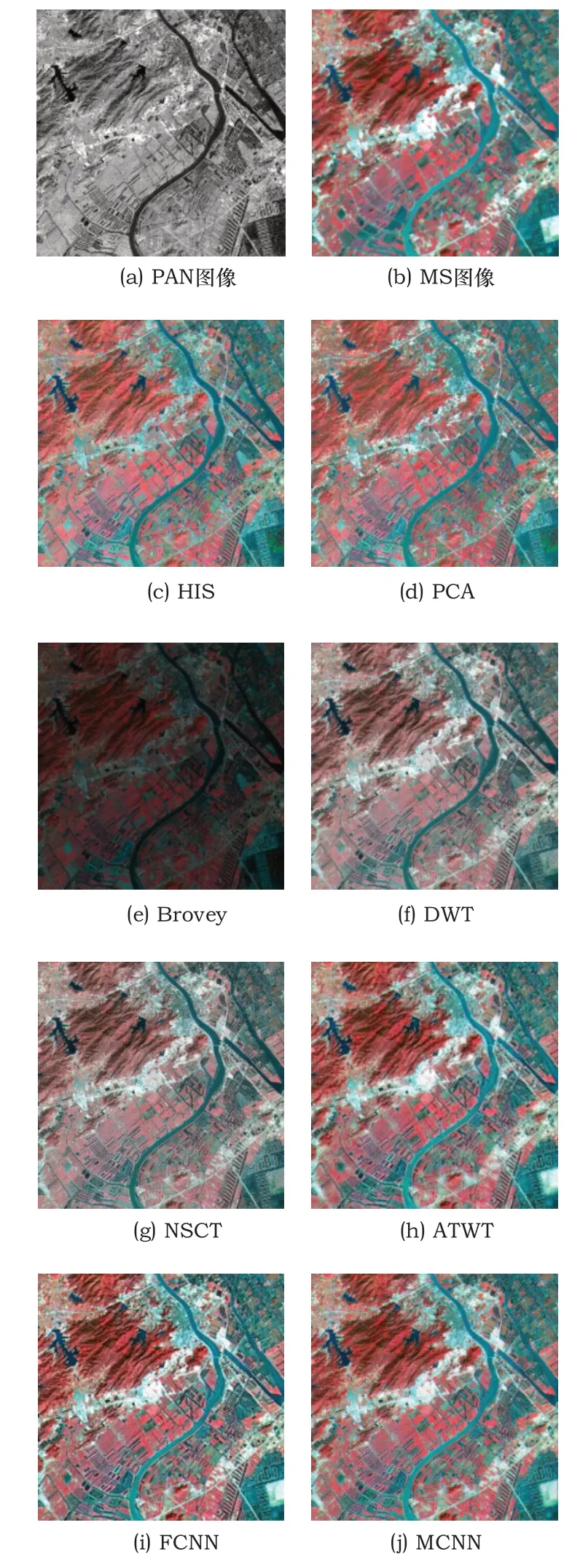

選取了兩組地形區域不同的遙感圖像進行融合效果測試。第一組實驗數據(圖2(a)~圖3(j))分別取自Landsat-TM影像中分辨率為30m的MS圖像和SPOT影像中分辨率為4m的PAN圖像,實驗區位于吉林地區,涵蓋了植被、建筑用地、交通道路等多種類型,圖像大小為256×256像素。第二組實驗數據(圖3(a)~圖3(j))分別取自中巴地球資源一號衛星(CBERS)影像中分辨率為19.5m的MS圖像和Landsat ETM+影像中分辨率15m的PAN圖像,實驗區位于廣東省珠海市斗門區,包含林地、水體、農業用地等,圖像大小為512×512像素。

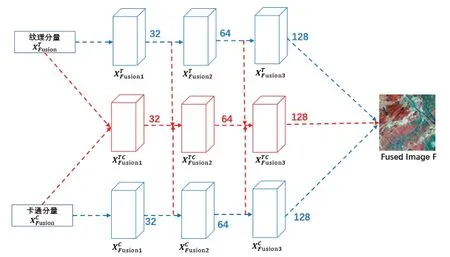

2.2 損失函數

本文使用回歸模型訓練融合函數:

其中為訓練集的原始圖像,PAN是全色圖像,MS是低分辨率多光譜圖像。F(θ;PAN,MS)是模型輸出的融合函數,n是訓練樣本的個數,我們通過最小化函數I來求解融合函數F。另外,圖像的像素值范圍為0~255,在輸入模型之前歸一化到區間[0,1]。

模型的優化算法為Adam算法,這是一種基于隨機梯度下降的自適應學習率優化算法。該模型的初始學習率設置為0.001,在訓練階段總數的50%和75%時除以10。總訓練時間為40分鐘,模型最終訓練均方差為0.00012。

2.3 評價指標

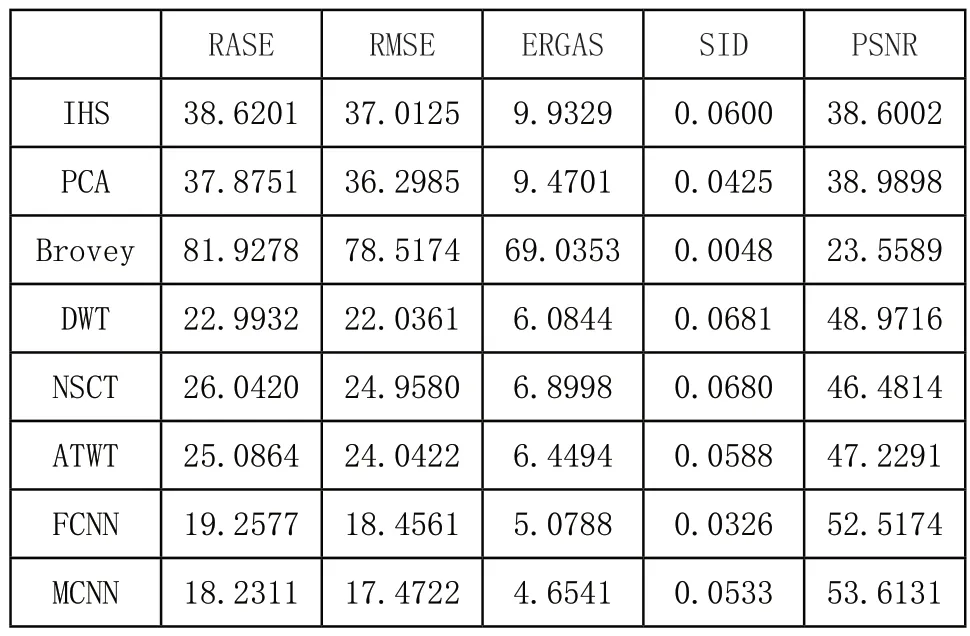

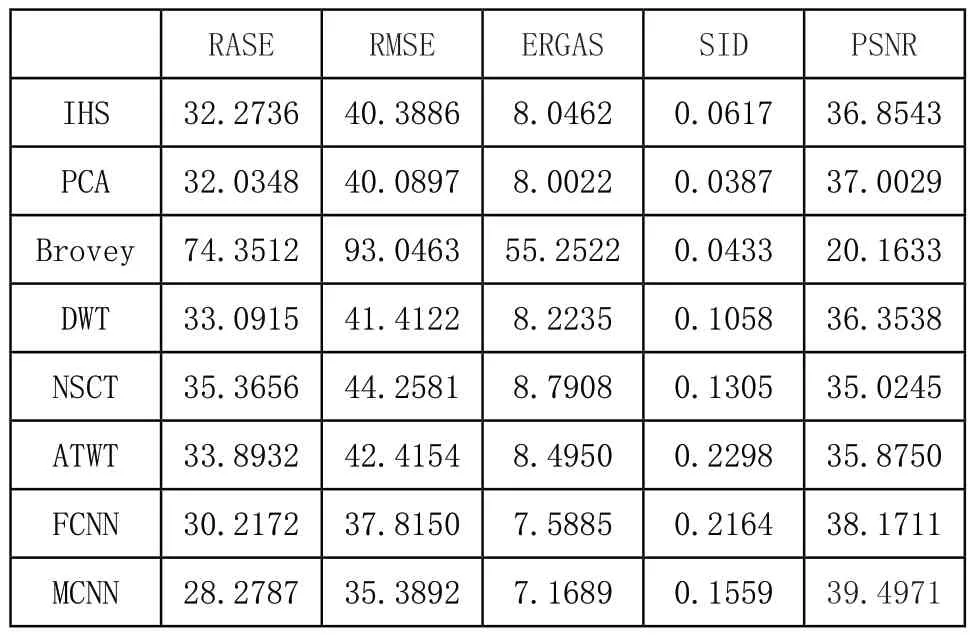

為了能夠客觀的驗證不同方法的性能,選取了以下五種常用的客觀評價指標對實驗結果圖像進行了評價,分別是相對平均光譜誤差(Relative Average Spectral Error Index,RASE)、均方根誤差(Root Mean Square Error,RMSE)、全局相對光譜損失(Erreur Relative Globale Adimensionnelle de Synthese,ERGAS)、光譜信息散度(Spectral Information Divergence,SID)、峰值信噪比(Peak Signal-to-Noise Ratio,PSNR)。其中,RASE反映所有通道平均光譜表現,融合圖像光譜質量越高,則RASE越低,理想值為0。RMSE是計算融合圖像與參考圖像之間像素值差異,差異越小說明光譜保持越好,理想值為0。ERGAS是評價融合圖像的空間和光譜質量,其值越小說明融合圖像質量越好,理想值為0。SID是基于信息論衡量兩幅光譜差異的方法,值越小說明差異越小,即光譜保留越好,理想值為0。PSNR反映了圖像的噪聲和失真水平,PSNR值越大,圖像與參考圖像越接近,質量越好。

2.4 實驗結果

實驗對HIS[1]、PCA[2]、Brovey[3]、DWT[4]、NSCT[5],ATWT[6]、FCNN[19]和本文的MCNN融合方法進行了結果的比較。

第一組遙感數據中不同融合方法的結果如圖2所示。從對比實驗中可以看出,與輸入的PAN圖像和MS圖像相比,這些方法都可以一定程度的提高融合圖像的質量。然而,圖3(c)~圖3(i)都呈現了不同程度的失真,圖3(c)和圖3(d)發生了融合過飽和的情況,圖3(e)~圖3(h)可以明顯的看出,都具有不同程度的頻譜失真,圖3(i)的紋理和光譜信息相較于輸入原圖像,都得到了很好的保留,但是MCNN融合法在光譜信息的保留方面仍優于FCNN。

圖3 第一組遙感影像數據的不同融合方法實驗結果

圖4是第二組遙感數據通過不同融合方法的最終結果。圖4(c)~圖4(i)都具有不同程度的空間結構模糊和光譜畸變,圖4(c)~圖4(d)在左上角的山體部分和右下角的植被部分都有著明顯的光譜失真,色度偏暗,圖4(e)~圖4(g)中,可以看到整體的光譜畸變情況嚴重,分別存在著光譜過為深重和過為明亮的情況,圖4(h)的光譜信息保留較好,但是可以看出在山體與林地的交界處,邊緣較為模糊,紋理的可視程度差;圖4(i)~圖4(j)從主觀視覺效果來看,無論是在光譜保留方面還是紋理細節方面,均優于其他算法。

圖4 第二組遙感影像數據的不同融合方法實驗結果

表1列出了通過對第一組數據進行不同融合而產生的結果的客觀評估指標。表1中的粗體數字表示各評價指標的最佳值。可以看出,MCNN除了SID指標以外,均取得最高結果。綜合圖2的視覺效果,MCNN優于其他融合方法。

表1 吉林省實驗數據融合結果的評價指標

表2所示為第二組數據融合結果的評價指標,其中粗體數字表示每個評價指標的最佳值。與其他七種方法相比,MCNN具有更好的評價指標結果。結合圖3主觀視覺效果,MCNN優于其他融合方法。

表2 廣東省實驗數據融合結果的評價指標

3 結語

本文提出了一種基于多形態卷積神經網絡的遙感圖像融合方法,通過形態成分分析提取遙感圖像的紋理成分和卡通成分,并將該方法與卷積神經網絡相結合,在避免源圖像信息丟失的同時又加強了對輸入圖像細節的提取。通過對不同的衛星獲取的不同類型的數據進行融合實驗與結果分析,結果表明本文的方法能夠較好地保持光譜信息,且獲得了更為豐富的空間細節。