基于編解碼網絡的化工驅油圖像分割方法

翟鈺杰,尚佳童,張 棟,趙偉強,雷 濤?

(1.陜西科技大學 電子信息與人工智能學院,陜西 西安 710021;2.陜西省人工智能聯合實驗室,陜西 西安 710021;3.中電科西北集團有限公司西安分公司,陜西 西安 710065)

石油作為國際重要的化石資源,自20世紀50年代起,在能源消耗總量中,油氣始終占據首位,引起了生產方式的革命,創造了空前文明成果,使世界進入了“石油時代”。石油供應關系國家經濟和軍事保障,影響發展戰略;與其他礦產資源相比,石油帶有更多的戰略物資的色彩。但由于油氣是流體礦物,在整個體系中油、氣、水關系復雜,不合理的開采、驅油會大大降低其采收率,因此選用合適的驅油材料并對驅油率進行分析則顯得尤為重要。驅油圖像分割是驅油率分析的關鍵步驟,它將不同時序得到的油水圖像進行分割,目的是為下一步驅油率的計算以及材料的使用提供參考數據。因此,研究并找到更好的驅油圖像分割方法,提升模型分割水平,對整個石油資源領域都具有重要的意義,對社會的發展和進步也具有不可代替的作用。

近年來,隨著深度學習的發展,圖像被廣泛應用于目標檢測、圖像分類、分割和識別,其中圖像分割技術根據相似性原理將圖像分成幾個不同的部分。自從全卷積神經網絡提出后將端到端的網絡結構引入圖像語義分割技術中,隨后便被廣泛研究和利用,并且基于深度學習的圖像分割算法在各種圖像分割任務中取得顯著的成就。如Bai等人利用大規模CMR圖像數據集對FCN進行訓練及評估,最終得到與專家相同的分割精度和臨床測量精度。FCN可以接受任意大小的圖像,但圖像經過池化操作后部分像素的空間位置信息丟失,分割過程中未能考慮圖像上下文信息,導致分割結果粗糙、分割邊界不連續。U-net則繼承FCN的思想,繼續進行改進。如Sreekumar等人使用兩個包含復雜背景的數據集Egohands和GTEA進行訓練多種網絡并測試比較,實驗證明U-net相比于FCN具有更好的性能,其中實驗通過將U-net網絡第一次應用于手部分割,證明了其泛化性,也正是我們選取其進行化工圖像分割的原因所在。U-Net將經過多次下采樣得到的低分辨率信息和從編碼器直接傳遞到同高度解碼器上的高分辨率信息結合起來,可以更好地適用于邊界模糊、梯度復雜的圖像任務。然而其大小固定的卷積導致圖像細節特征缺失;重復的下采樣、池化以及參數共享造成模型抗噪性差,魯棒性低,導致圖像分割精度差,邊界模糊。

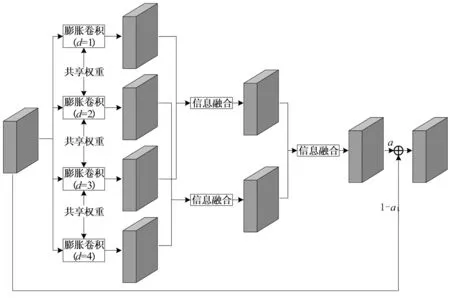

為解決上述問題,在U-net網絡結構的基礎上提出一種新的網絡模型CoU-net,來有效地提取多尺度上下文信息并將其通過空間注意力融合,提高分割精度。通過吉淑瀅等人的研究證明,信息融合模塊在網絡復雜程度不變的基礎上可以有效提升分割結果的精度。多尺度信息融合方法有很多,本文提出的多尺度信息提取融合模塊由四個并行膨脹卷積濾波器和兩個級聯的注意力信息融合模塊組成,四個并行膨脹卷積濾波共享權重,用于捕獲不同的尺度上下文信息并且運用空間注意機制進行融合。模塊嵌入解碼器的頂部,可以通過自學習為不同尺度的目標動態選擇合適的感受野,更好地融合多尺度背景信息,提高分割精度。

1 基于編解碼網絡的化工驅油圖像分割方法

1.1 U-net網絡

2015年Olaf Ronneberger等人在FCN的基礎上改進,提出了U-net網絡,由于其網絡呈“U”形而得名,網絡通過U形網絡和跳躍連接實現底層高分辨率圖像信息和深層語義信息相融合,可稱之為醫學分割影像的基石,能夠有效處理醫學圖像任務。

在U-net中作者采用了對稱結構,整個網絡分為編碼器部分(下采樣)和解碼器部分(上采樣),結構簡單但很有效,在生物醫學圖像的分割任務中取得了出色的效果。編碼器部分為特征提取網絡,通過多層的卷積操作來提取特征信息,并采用步長為2的2×2最大池化操作來縮小特征圖,提取更抽象的特征,獲取場景信息。解碼器為特征融合網絡,對任務目標進行精確定位,通過上采樣操作,將包含高級抽象特征信息但低分辨率的圖片在保留高級抽象特征的基礎上變為高分辨率,恢復到原始圖像大小;并且圖片與編碼器提取的低級特征高分辨圖片進行通道融合還原圖片細節信息。最后通過兩次卷積操作生成特征圖,再經過sigmoid函數輸出一個反映預測結果的概率值,值越大,預測結果的可能性越大。U-net結構不僅適用于生物醫學圖像,后也在遙感圖像、制造工業以及農業等自然圖像中擔當著重要角色。

1.2 多尺度信息提取模塊

正如引言中所討論的,多尺度上下文信息可以提高語義分割任務的性能。然而,如何有效地提取和整合利用這些信息是一個值得探索的問題。DeepLabV1中作者提出空洞卷積的概念,在避免大量損失圖像特征的前提下增加感受野,在特征圖分辨率不變的同時增加卷積層的感受野,有效地獲取了圖像位置和細節信息。DeepLabV2中作者提出空洞空間金字塔池化(ASPP)結構,通過不同膨脹率的空洞卷積進行卷積后,將得到的圖像多尺度信息特征圖進行拼接。PSPNet和PoolNet采用了具有不同內核大小的多個并行卷積池來聚合不同區域的上下文信息,從而提高獲取全局信息的能力。DeepLabV3和CE-Net采用了具有不同感受野的多個并行的卷積分支,提取不同尺度的特征信息后將其融合,提高了模型的多尺度信息捕獲能力。DeepLabV3+在V3的基礎上為了減少網絡計算量舍棄了傳統卷積運算,采用了空洞深度可分離卷積將其替換。

設計一種新的多尺度信息提取融合模塊,具體結構如圖1所示。在此模塊中,我們采用4個并行的、膨脹率分別為1、2、3、4的膨脹卷積改變傳統卷積的感受野,用來捕捉不同尺度的特征信息。膨脹卷積共享權重用來減少模型參數和過擬合的風險。

圖1 多尺度信息提取融合(MIEF)模塊

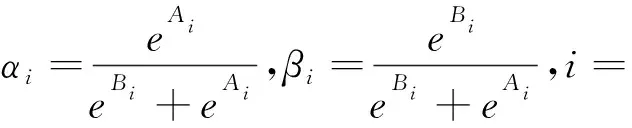

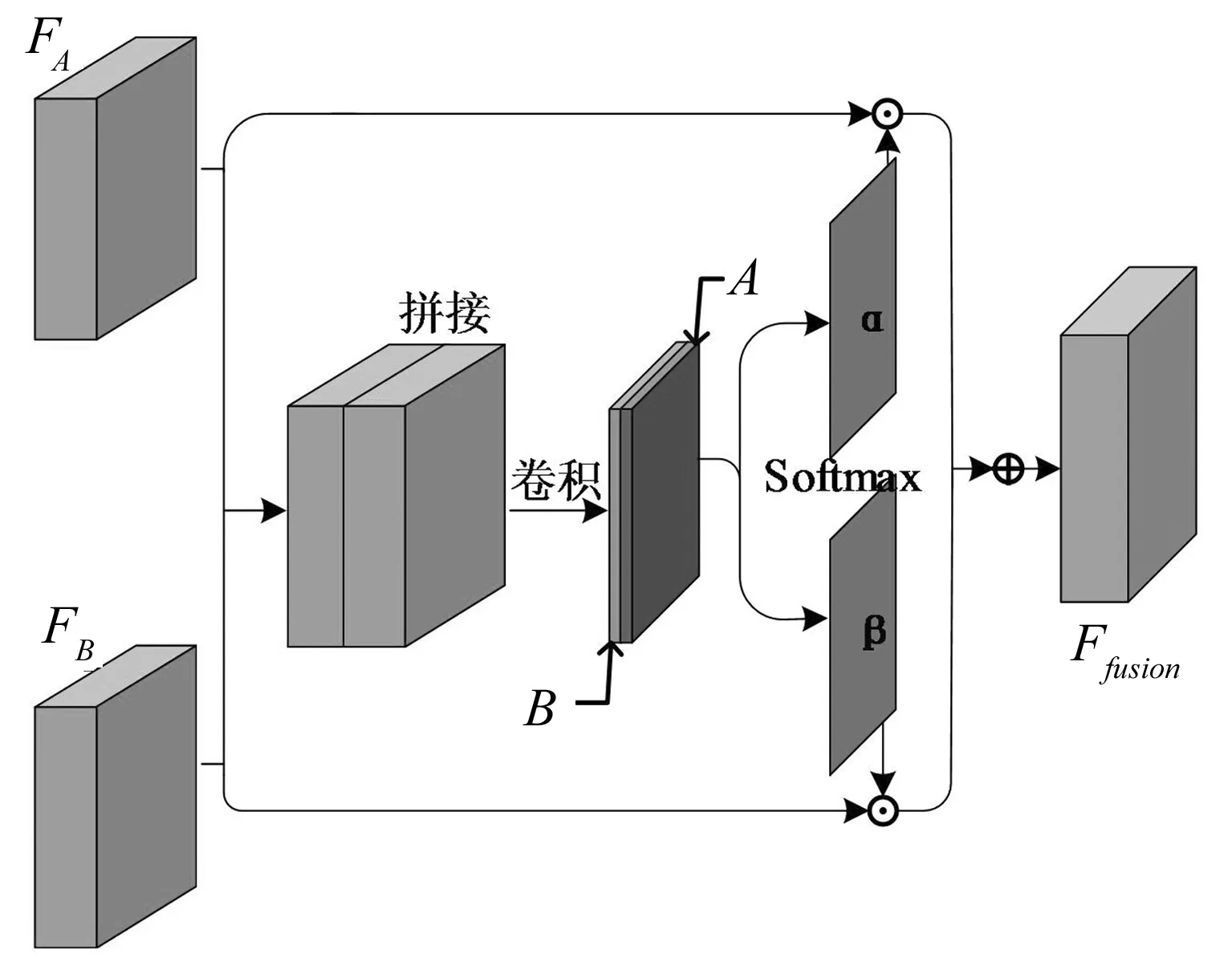

1.3 注意力信息融合模塊

然而,在上述多尺度信息提取以及信息融合的過程中,感受野不能動態調整以適應不同大小的目標,導致模型的魯棒性較差,分割精度低。由于注意力機制已被廣泛用于改進模型性能,許多基于注意力機制的規模感知網絡已被提出以克服上述問題。SA通過將注意力模塊引入多尺度輸入,學會了對每個像素的多尺度特征進行加權。AFNet和SPAP采用尺度感知層自適應地改變有效感受野的大小。SKNet提出了一種動態內核選擇機制,將通道注意機制引入多個特征分支中。

除此之外,我們使用文獻中的注意力信息融合模塊來融合不同尺度的特征信息,增強模型的魯棒性和抗噪性。如圖2所示,引入空間注意力機制來動態地選擇合適的尺度特征,并通過自學習將其融合。通過不同膨脹率的膨脹卷積得到的不同尺度的特征和經過通道拼接,一系列卷積操作后得到一組通道數為2的特征圖,并將其按通道分別作為對應,的特征映射,∈×(:特征圖的高度,:特征圖的寬度)。通過softmax函數對空間值進行操作后得到兩張像素級注意力特征圖,∈×,計算公式如式(1)所示。

[1,2,3,…,×]

(1)

其中,為特征映射圖,第個位置的像素值。

最后融合的特征圖通過加權和獲得,加權公式如式(2)所示。

=⊙+⊙

(2)

我們使用兩個并行的注意力信息融合模塊并與另一個進行級聯操作,來獲得四個分支的最終融合特征。之后利用帶有可學習參數的殘差連接來獲得整個MIEF模塊的輸出。

圖2 注意力信息融合模塊

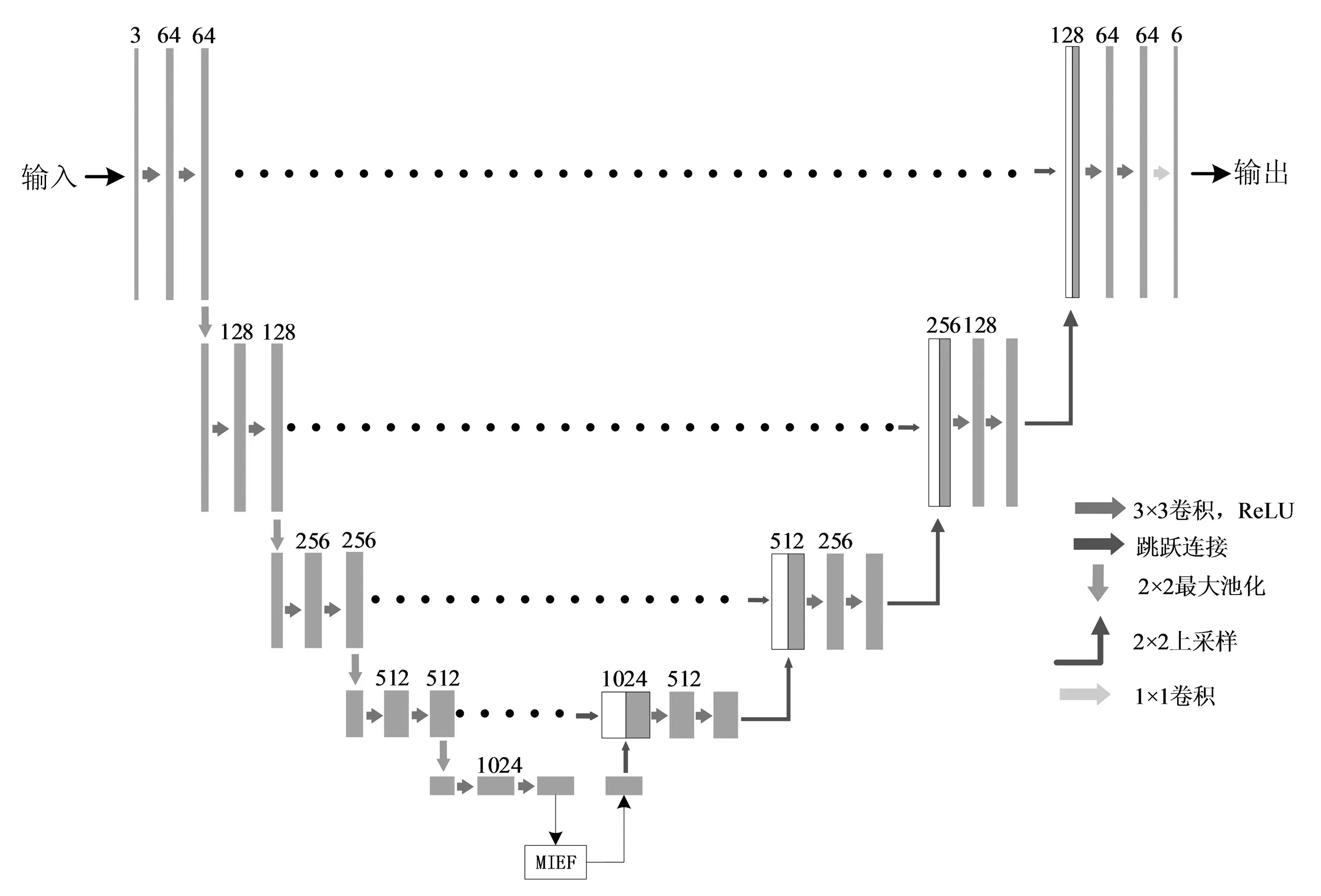

1.4 CoU-net整體框架

CoU-net網絡結構如圖3所示,多尺度信息提取模塊和注意力信息融合模塊集成在一起,將編碼器提取的特征送入模塊中,從而提高圖像的分割精度。

圖3 CoU-net網絡

2 實 驗

2.1 數據集建立

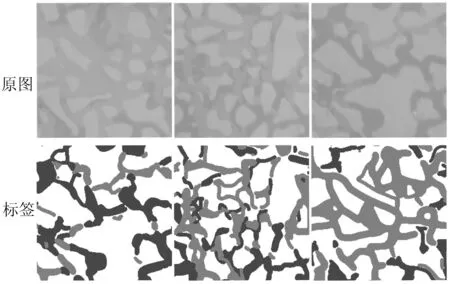

本次課題使用的是驅油數據集,此數據集是通過CAD和3D打印技術重新模擬新疆某油田中的巖石板,通過高分辨率相機拍攝驅油過程中油路的變化,按照像素差異總共包括3種類別,其中背景為灰色,油是紅色,驅油材料為藍色,背景為分割場景中不關心的區域。

原始的影像尺寸較大,因此我們需要對原始影像和標簽圖像進行預處理,首先對數據集進行隨機裁剪,裁剪成2000張256×256大小的訓練集,1000張測試集,并且在訓練集中選取500張圖片作為驗證集,為了確保數據集能夠訓練出有效的網絡模型,使其具有魯棒性,需要將裁剪好的數據集進行數據增強。通過隨機角度旋轉、翻轉、伽馬變換、亮度變化以及添加噪聲等增強圖像數據集。經過對原始影像進行預處理操作,最終形成了2000張原圖和對應標簽構成的訓練集,500張原圖和對應標簽構成的驗證集以及1000張測試集,如圖4所示,至此實驗所需數據集建立完成。

圖4 數據集(部分)

2.2 實驗環境

實驗環境為:處理器Intel(R) Xeon(R) CPU E5-1620 v4 @ 3.50 GHz,顯卡NVIDIA GeForce GTX 1080,內存64 GB,Windows64位系統。GPU加速庫為CUDA 11.0;深度學習框架為PyTorch,版本為torch 1.7.1;開發環境為PyCharm,版本為2019.3.3;編程語言為Python 3.7;可視化工具為TensorboardX 2.4;python庫NumPy 1.19.5。

2.3 評價指標

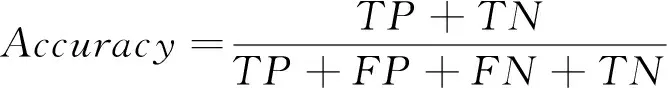

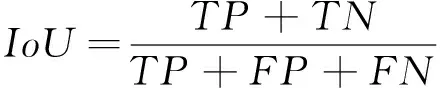

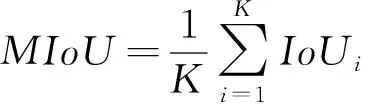

為了定量分析模型在驅油圖像中進行分割的效果,引入三個分割評價指標,分別為準確率(Accuracy),交并比(IoU)和平均交并比(MIoU),其計算公式分別如式(3)~(5)所示。

(3)

(4)

(5)

其中,代表樣本為正,預測結果為正;代表樣本為負,預測結果為正;代表樣本為正,預測結果為負;代表樣本為負,預測為負;為圖像總類別數。

2.4 實驗結果與分析

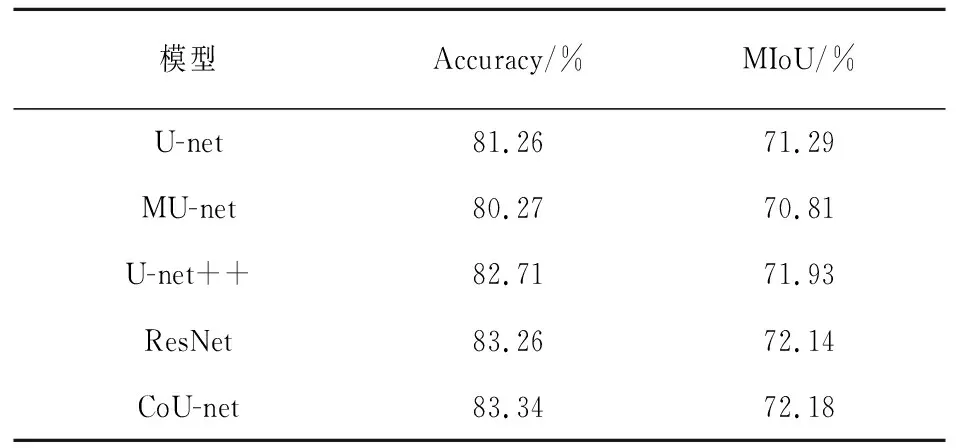

為了驗證所提出方法的有效性,提出的網絡為CoU-net,與原始U-net、MU-net、U-net++、ResNet深度學習模型進行對比。實驗采用交叉熵(Cross Entropy)損失函數和Adam優化器來對網絡模型優化,學習率(Learning Rate)為0.0001,批數量(Batch)為8,迭代次數(Epoch)為300,最終模型收斂,分割模型性能指標如表1所示。

表1 分割模型性能指標

表1展示了不同分割模型的性能,從結果中可以看出CoU-net在測試集上的MIoU達到了72.18%,準確率達到了83.34%,相比于原始的U-net網絡分別提高了1.24%和2.55%,并且優于其他網絡。由此可以驗證本文方法的可行性,具有更加優異的分割精度。

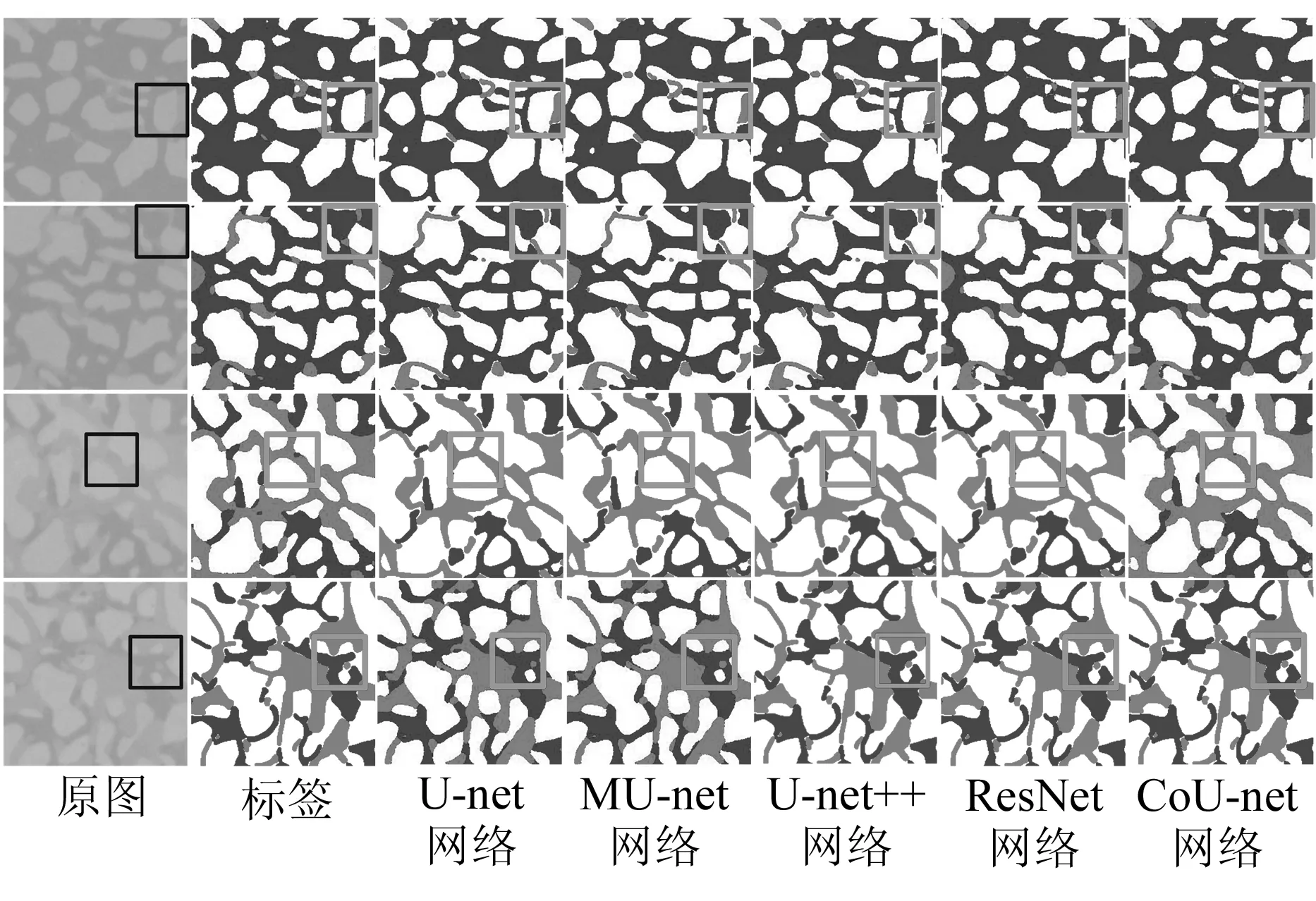

為了更直觀地表示,圖5列舉了部分圖像分割樣例。從圖中可以看出,使用CoU-net進行分割的圖片已經非常接近標注圖像,并且相比于其他網絡的分割結果邊界更為明確,線條更加流暢,明顯優于原始網絡。

圖5 不同分割網絡的結果圖對比

3 結 論

基于U-net提出了一種新的U形網絡模型:CoU-net用于化工驅油圖像分割,解決了U-net中多尺度上下文信息提取不足以及融合過程中造成的信息冗余,模型魯棒性差等問題。設計并嵌入了集成多尺度信息提取以及空間注意力機制的MIEF模塊,實現了多尺度上下文信息的提取融合,有效地改善了U-net對圖像邊緣細節的分割能力,并且通過注意力機制提高了原有模型的魯棒性,提高了模型對圖像重要任務的計算能力,分割精度較原始模型有較大的提升。但整個網絡的結構還存在一定的問題,在跳躍連接部分沒有進行充分的考慮,在一些細致的目標上還存在問題,未來將重點對網絡構架進行優化,針對跳躍連接進行改進,進一步提高分割精度。