基于目標增強和視覺跟蹤的紅外運動點目標半自動標注算法

何 敏,回丙偉,易夢妮,胡衛東

〈圖像處理與仿真〉

基于目標增強和視覺跟蹤的紅外運動點目標半自動標注算法

何 敏,回丙偉,易夢妮,胡衛東

(國防科技大學 電子科學學院ATR重點實驗室,湖南 長沙 410073)

本文針對紅外視頻數據標注效率低、標注質量差等問題,提出了一種基于目標增強和視覺跟蹤的紅外序列圖像中運動點目標半自動標注方法。首先對一段連續時間內的紅外序列圖像進行配準和背景對消以增強目標特征;然后使用視覺跟蹤算法對增強后的特征進行高效自動定位;最后通過相位譜重構得到單幀圖像的目標顯著圖,進而確定目標的準確坐標;在自動標注過程中,利用相鄰幀標注結果的差異性選擇關鍵幀,可以讓標注人員快速定位可能發生錯誤的圖像幀并對其進行手動標注。實驗結果表明該算法可以顯著降低標注人員的參與度,有效解決數據標注作業中周期長、質量難以保證的問題。

半自動標注;紅外點目標;視覺跟蹤;序列圖像

0 引言

2009年受益于大規模標注數據集的出現,人工智能技術取得了跨越式發展。隨后數據標注作為一項基礎性工作也逐漸得到重視。數據標注是指在數據加工階段利用標注工具將數據中被機器用以學習和認知特征的部分加上標簽的過程。大數據時代下,數據標注是一項龐大的工程,而視頻標注一直是大數據標注領域的難點。此類數據具有體量大、處理困難的特點。隨著技術的發展,基于人機協同的視頻半自動標注算法研究逐漸增多。而現階段的視頻半自動標注算法多數是針對可見光圖像中的擴展目標進行研究的,對紅外點目標的半自動標注研究甚少。而紅外運動點目標檢測識別作為紅外成像探測系統的關鍵技術之一,一直是研究的重難點問題,特別是現代智能目標識別技術的發展,對紅外目標數據集的標注效率及標注質量提出了更高的要求。

視頻與單張圖像相比,多了時間上下文信息且相鄰幀之間存在大量冗余信息,因此采用交互式跟蹤的方法對其進行快速標注已成為視頻標注的主流手段。早期的視頻標注算法[1-2]大多通過對兩幀人工標注的視頻幀之間進行坐標插值來加速工作,之后出現了基于幾何建模[3]的方法對視頻進行半自動標注。此類方法假設目標在兩個手工標注的圖像幀之間為勻速運動,對剩余幀目標位置進行預測,無需使用目標的視覺信息,對于模糊圖像或者包含遮擋目標的圖像更具有魯棒性,但是標注質量受人工標注頻率影響較大,如果需要獲得較高的標注質量,標注人員需要密集介入標注過程。當標注人員的參與程度較低時標注結果將不可避免地產生誤差,這種誤差對于擴展目標而言有時是可接受的,但是對于成像面積只有一兩個像素大小的紅外運動點目標而言影響非常大。

另一類使用視覺信息的標注算法[4-8],利用標注人員給出的初始信息對目標進行交互式視覺目標跟蹤進行標注。視覺目標跟蹤是指在當前幀中給出目標的位置信息,然后通過目標的顏色、形狀等外觀信息,在后續幀中對目標進行持續跟蹤的過程。其中,影響較大的算法為Carl Vondrick[4]等人提出的通過在每次標注人員提供一個標注信息后求解一個動態規劃問題并對剩余幀進行標注。Bakliwal[9]等人利用多個算法對同一目標進行視覺跟蹤并融合其跟蹤結果得到更為精確的標注信息。此類方法需要目標的外觀信息,當目標不發生遮擋或形變時可以依靠少量的手工標注信息得到較好的標注質量。但是,紅外弱小目標本身并不具備紋理、形狀、顏色等特征,直接使用此類跟蹤算法無法獲得理想的標注效果。

同時,有研究人員[4]發現如果由標注人員自己選擇一段視頻中需要標注的幀,不僅要耗費標注人員大量的精力,而且還會降低標注速度。這些需要人標注的幀稱為關鍵幀,一些工作探尋了如何選取關鍵幀的問題。如Curve-VOT[10]利用多邊形擬合的方式擬合跟蹤軌跡,將最靠近頂點的幀作為關鍵幀。文獻[5,11]采用最大模型改變期望策略選擇關鍵幀。這些方法都試圖找出標注最有可能發生錯誤的幀并交予標注人員進行標注。

通過上述分析,本文結合紅外視頻點目標數據開展高效的半自動標注方法研究。主要工作如下:

①針對純手工標注效率低下的問題,本文利用人機協同的方法對紅外運動點目標進行高效的半自動標注。

②針對紅外點目標自動定位難的問題,本文綜合運用視覺跟蹤算法和相位譜重構技術實現了由粗到精的點目標坐標自動定位。

③針對點目標標注提出了一種關鍵幀選擇策略,自動返回關鍵幀給標注人員進行校驗,不需要標注人員全程參與整個跟蹤過程。

1 紅外運動點目標半自動標注的基本原理

1.1 紅外運動點目標高效半自動標注算法流程

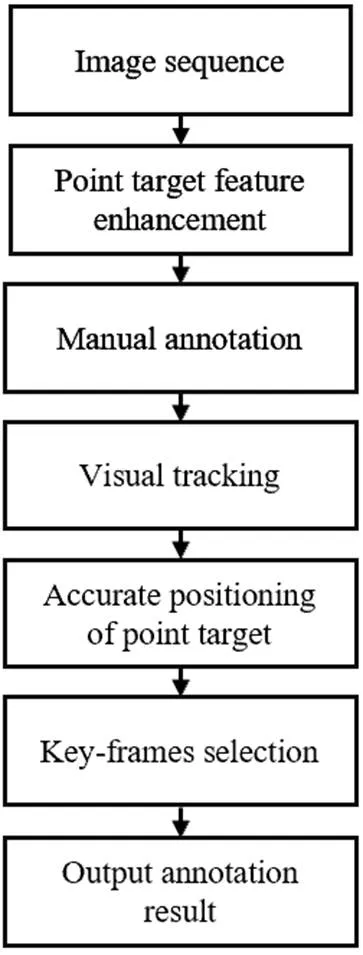

本文設計了基于目標增強和視覺跟蹤的半自動標注算法,當紅外序列圖像輸入時,首先利用圖像配準算法對紅外序列圖像進行對齊及背景對消來增強紅外點目標的特征,標注人員對增強之后的首幀目標特征進行標注,標注形式為矩形框,然后利用目標跟蹤算法對增強之后的目標進行粗定位,接著利用跟蹤框和相位譜重構對目標得到目標準確的位置,同時選取發生錯誤概率較大的關鍵幀交予標注人員進行標注,從而實現人機協同下的紅外運動點目標高效半自動標注。具體流程圖如圖1所示。

圖1 半自動標注流程

1.2 序列圖像點目標特征增強

紅外點目標特征少,且紅外探測系統一般用于較為復雜的環境中,圖像背景會出現與目標相似的干擾噪聲,直接使用視覺跟蹤算法無法對點目標進行持續且準確的跟蹤,因此利用多幀圖像累積點目標的運動信息,然后使用差分消除圖像序列的背景信息,突出目標的運動區域,減少背景的干擾。

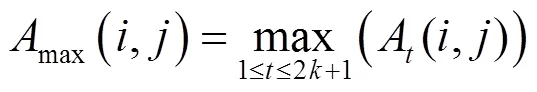

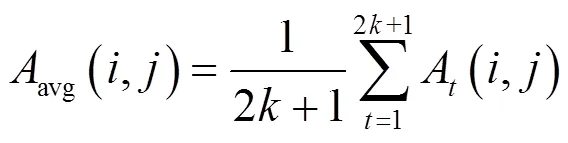

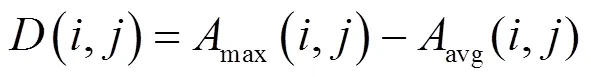

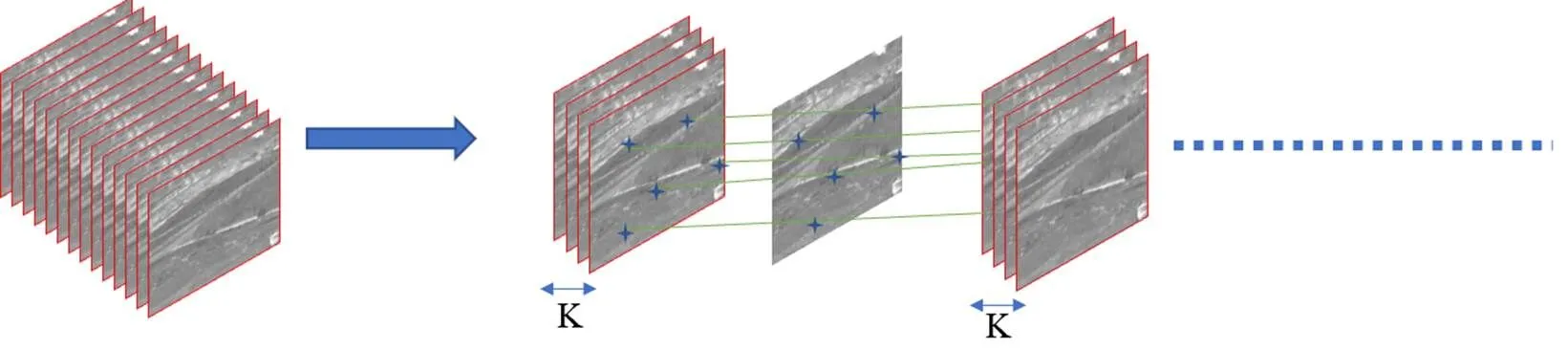

通過點目標的運動信息對其進行增強,具體操作分為兩步:①對序列圖像進行配準,如圖2所示,將2+1張圖像利用配準算法對圖像序列進行對齊,其中以第+1張圖像為基準圖像;②在對應位置取2+1張圖像的最大值、平均值并對其進行差分,具體公式如下:

式中:A(,)表示配準后的第張圖像(,)位置上的像素值;max(,)表示配準后的2+1張圖像在(,)位置上取最大值;avg(,)表示配準后的2+1張圖像在(,)位置上取平均值,圖像為所求的目標增強圖。

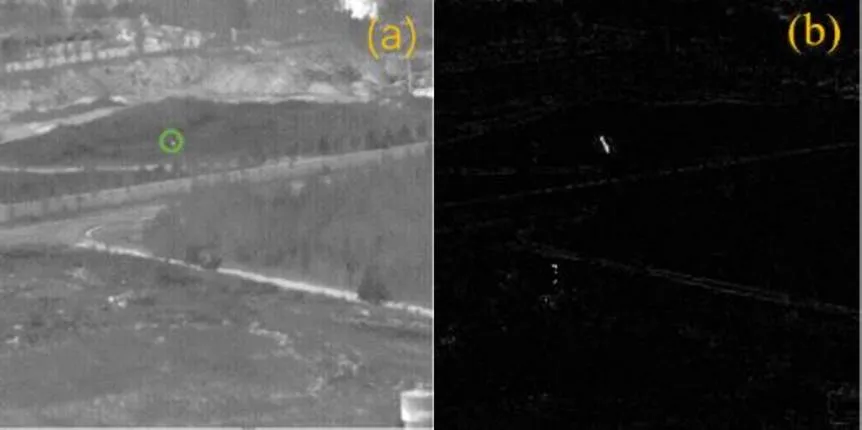

圖3為增強之后的效果對比圖,由圖可知增強之后的圖像,不僅消除了部分背景噪聲,目標區域的能量強度也被增強,具有較強的辨識度,因此在增強圖上對紅外點目標的位置進行初步定位。

圖2 序列圖像配準

圖3 增強效果對比:(a) 原圖;(b) 增強圖

1.3 視覺目標跟蹤

序列圖像相比于單張圖像多了時間上下文信息,且相鄰的圖像幀之間存在很強的相關性,因此可以使用視覺跟蹤算法實現對目標的快速定位。為了兼顧算法的效率和準確率,本文選用的跟蹤算法為核相關濾波算法(kernel correlation filter,KCF)[12]。

1.3.1 KCF目標跟蹤

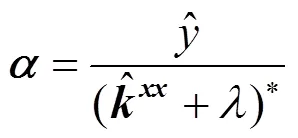

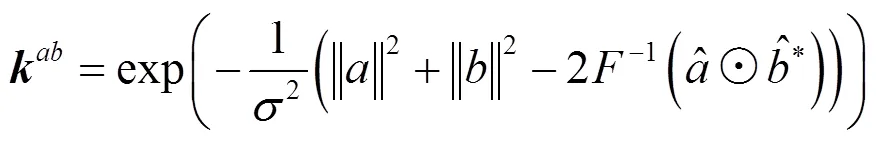

KCF則是將跟蹤轉化為脊回歸的問題,然后通過基樣本循環移位得到訓練樣本,接著利用循環矩陣可被傅里葉矩陣對角化的特點,將計算過程轉化到頻域進行求解,最后使用核技巧將低維線性不可分的特征映射到高維空間求出回歸器的權值參數,并使用回歸器得到下一幀圖像的輸出響應圖(),響應最大處為預測的目標位置。其中脊回歸器的權值通過式(4)得到:

然后利用訓練得到的濾波器尋找相關響應值最大的圖像位置:

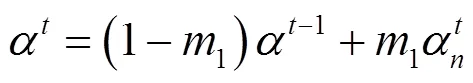

在跟蹤過程中只需對參數進行更新,更新公式如下:

式中:n為式(4)得到的權值;n-1是上一幀的權值,然后根據預設的步長1進行更新。

1.3.2 基于跟蹤置信度的模板更新

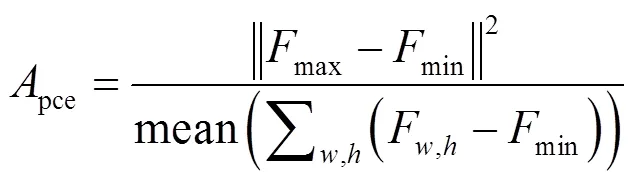

原始的KCF每幀都會進行更新,但是增強之后的紅外目標特征只包含輻射信息,當目標輻射微弱且運動不明顯時,很容易受到目標背景的強噪聲影響,導致跟蹤器跟錯、跟丟目標。為了減輕背景強噪聲對整個過程的影響,本文使用文獻[13]提出的跟蹤置信度pce對跟蹤模板有選擇的進行更新。pce計算公式如下:

式中:max、min、F,h分別表示輸出響應圖()的最大響應,最小響應和(,)位置上的響應。在對紅外弱小目標增強數據集進行跟蹤時,檢測區域很容易出現相似物干擾,因此輸出響應圖將會呈現多個峰值,且峰值最高的位置很可能為背景噪聲,如果此時跟蹤器進行更新則很容易跟錯目標,因此使用pce判斷輸出響應圖的震蕩程度,pce越大代表輸出響應圖的震蕩越小,跟蹤置信度越高,此步驟能有效提高KCF跟蹤在增強數據集上的成功。模板更新條件如下:

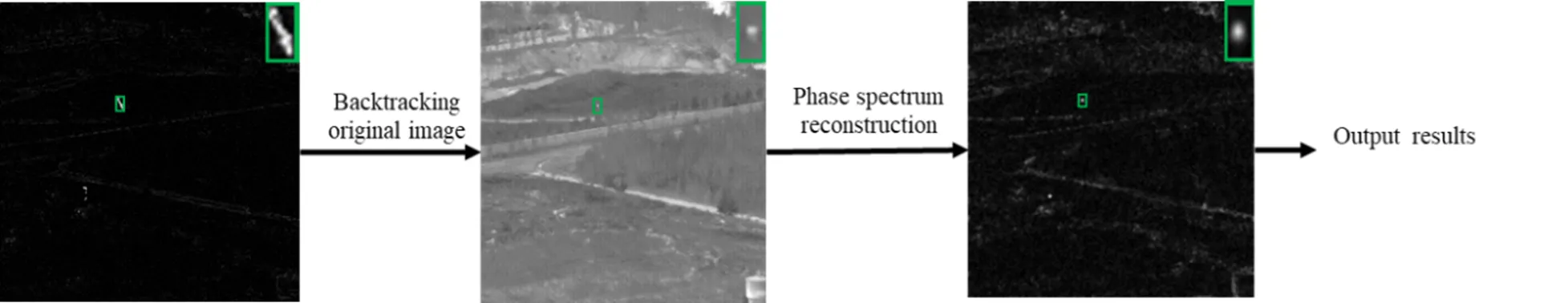

1.4 紅外點目標準確定位

為了得到目標準確的點標注,需利用1.3節得到的跟蹤框和原圖(,),得到目標的準確位置(x,y)。步驟如圖4所示。

圖4 紅外點目標的精確定位

因為跟蹤框內可能會出現連續的高亮的背景噪聲,因此本文利用紅外弱小目標所在位置存在區域突變這一特性對其進行精準定位。使用相位譜重構的方法對原圖進行處理,對圖像進行傅里葉變換可以得到如下兩個部分:

式中:(,)表示圖像的幅度譜;(,)表示圖像的相位譜;FFT表示圖像的傅里葉變換。之后對圖像相位譜進行重構,如下式:

*(,)=IFFT[(,)] (12)

式中:*(,)為所求的注意力圖,IFFT為圖像的傅里葉反變換。直接對相位譜進行重構相當于在對圖像重構時將初相不同的平面波幅度置1,而自然圖像的能量集中于低頻,此步驟相當于濾除低頻噪聲,突出高頻目標,從而消除連續的高亮背景噪聲,得到目標準確位置(p,p)。

1.5 關鍵幀選擇

視頻圖像標注中需要由人標注或檢驗的圖像幀稱為關鍵幀,它為一段圖像序列中具有代表性或包含較大信息量的圖像幀。本文將具有較大錯誤概率的幀作為關鍵幀自動返回給標注人員進行校驗,利用最小的代價提高數據集的標注質量。

通過實驗發現,最有可能發生標注錯誤的情況有兩種,一是由于某些原因,目標在序列圖像的運動突然發生不連續的情況,二是目標長時間靜止,融合后依然很微弱,且背景噪聲較大,因此容易錯誤跟蹤到雜波。圖5具體表明了上述兩種錯誤,如圖5(a)所示,由于目標軌跡發生斷裂,跟蹤框只能跟蹤軌跡的一部分,如圖5(b)在第幀時目標能被正確檢測,但是到+1幀目標實際上已經在另一半軌跡處,所以圖5(c)并未正確檢測到目標,雖然之后跟蹤算法會隨著軌跡前半部分的逐漸減弱、消失而正確尋回目標,但是這種情況易出現連續多幀被錯誤標注。如圖5(d)所示,在第幀時目標區域輻射信息較強尚能正確跟蹤到目標,但是在+1幀時目標輻射信息減弱、背景噪聲增強時則會發生跟蹤錯誤的情況(如圖5(e)(f)所示)。

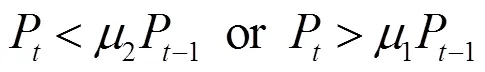

1.5.1 利用像素值變化定位關鍵幀

目標在運動過程中像素值是逐漸變大或者變小的,一般情況下不會產生突變。當目標軌跡斷裂而發生錯誤檢測時,算法預測的錯誤目標位置處的像素值與前一幀正確的目標像素值可能會有較大差距。因此將這一特性作為判斷關鍵幀的依據,判斷條件如下:

圖5 典型錯誤分析:(a)(b)(c)目標運動不連續;(d)(e)(f)強背景噪聲干擾

Fig.5 Typical error analysis: (a)(b)(c)Discontinuous motion of target;(d)(e)(f) Strong background noise

P表示第幀預測目標的像素值,1和2為預設常數。由于目標的探測亮度與作用到探測器單元的有效面積相關,它的亮度本身就會發生一定的起伏變化,因此在設計這個參數時要排除這種正常的現象。本課題的標注人員是對增強之后的目標進行初始化,每個初始化跟蹤框中其實包含了2+1幀圖片目標的位置信息,映射到原圖后可以得到2+1個目標像素點的信息。其中的最小像素值為min,最大像素值為max,利用min/max估算目標正常減小的范圍,本文利用9個data進行實驗,一共需要初始化9次得到9個估算值,用值最小的估算值來衡量目標正常減小的范圍,而相鄰幀的目標亮度變化一般不會超過自身的一半,因此1的取值范圍為[0.5,]。本課題選取的值為這個取值范圍的中點,同理2的取值范圍為[min/max, 1.5],本文選取的值也為這個范圍的中點。1和2作為預設值也可以由標注人員選取更加合適的值。

1.5.2 利用前后兩幀標注距離定位關鍵幀

針對目標長時間靜止而被強噪聲干擾的情況,通過前后兩幀標注結果的距離判斷可能發生錯誤的關鍵幀,因為正常情況下目標在序列圖像中的運動應該是連續且規律的,如某幀圖像前后兩幀標注距離與之前相差較大則將此幀圖像作為關鍵幀。判斷條件如下:

式中:d表示第張圖像預測目標與前一幀圖像預測目標的標注距離,為常數。如果當前幀目標的d遠超其歷史平均值,則將其判斷為關鍵幀。

2 實驗分析與討論

2.1 數據集與實驗設置

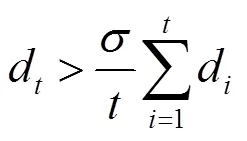

對半自動標注算法而言,目前缺乏系統的評價標準。因此本課題采用經過反復校驗的手工標注信息作為實驗的真值信息,標注位置為點目標上像素值最大的位置,標注形式為點標注。本文選擇了公開數據集[14]的8個目標符合大小數據段進行測試,數據集為多種復雜環境下采集的無人機序列圖像,數據集基本信息如表1所示。

2.2 結果分析

2.2.1 不同場景下的目標增強算法

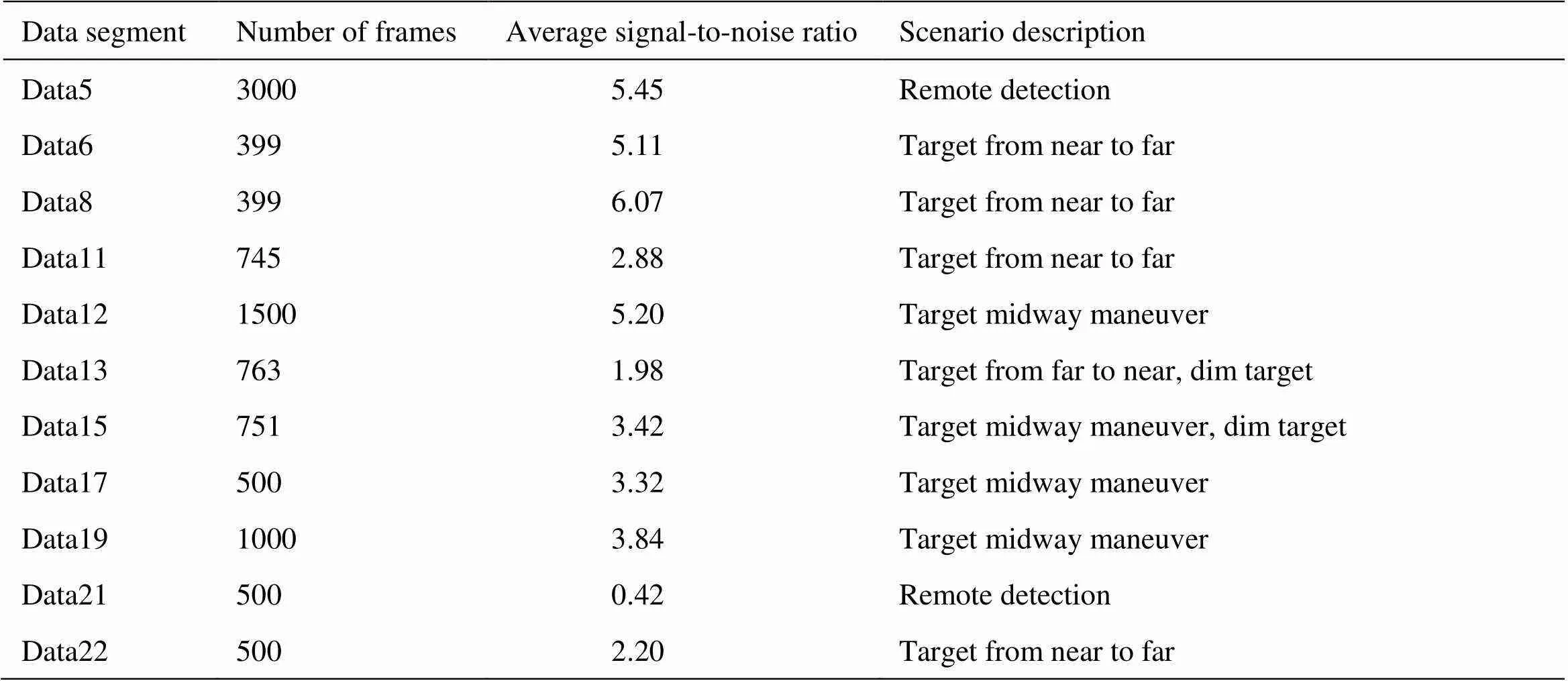

本文選取了多個典型實測場景測試紅外目標增強算法的適應性。在這幾種場景中,紅外點目標分別受到探測距離遠、遮擋、高亮噪聲等影響,目標所在位置的信息很容易被噪聲淹沒。

圖6為不同場景下的增強算法的效果,如圖6(a)場景所示,此場景目標的探測距離較近,亮度信息較強,且此時的攝像頭沒有快速運動,可以觀察到3維灰度圖中的目標區域(黑點所在位置)的能量明顯增強,且沒有很多的雜波,另一個能量較強的區域是因為相機本身不正常的感光單元形成的,但是它在后續跟蹤構成中并不會落在檢測區域,并不會影響后續跟蹤過程。場景(d)是因為目標受到遮擋導致其輻射亮度減弱以及樹葉的晃動,因此目標增強圖的背景仍會存留一部分噪聲、場景(g)存有一部分噪聲的原因是攝像機的快速移動,場景(j)存在的噪聲主要為高亮背景的邊緣信息。在面對各種復雜的紅外弱小目標探測背景和環境時,此目標增強算法雖不能徹底消除背景噪聲。但是與原圖相比,增強目標沒有被噪聲淹沒,能夠提供更多的信息用來區分它和噪聲,保證在進行目標跟蹤時,目標所在區域能夠及時有效地響應跟蹤器。因此,無論背景有較強的邊緣噪聲、存在運動的干擾背景還是目標由于遮擋導致自身成像灰度降低,抑或是相機的運動導致的噪聲,此方法都能夠明顯增強目標區域的辨識度,消除檢測區域中的強噪聲的干擾。

表1 數據集的基本信息

圖6 不同場景下的目標增強算法:(a)(d)(g)(j)原圖;(b)(e)(h)(k)原圖的三維灰度圖;(c)(f)(i)(l)增強圖的三維灰度圖

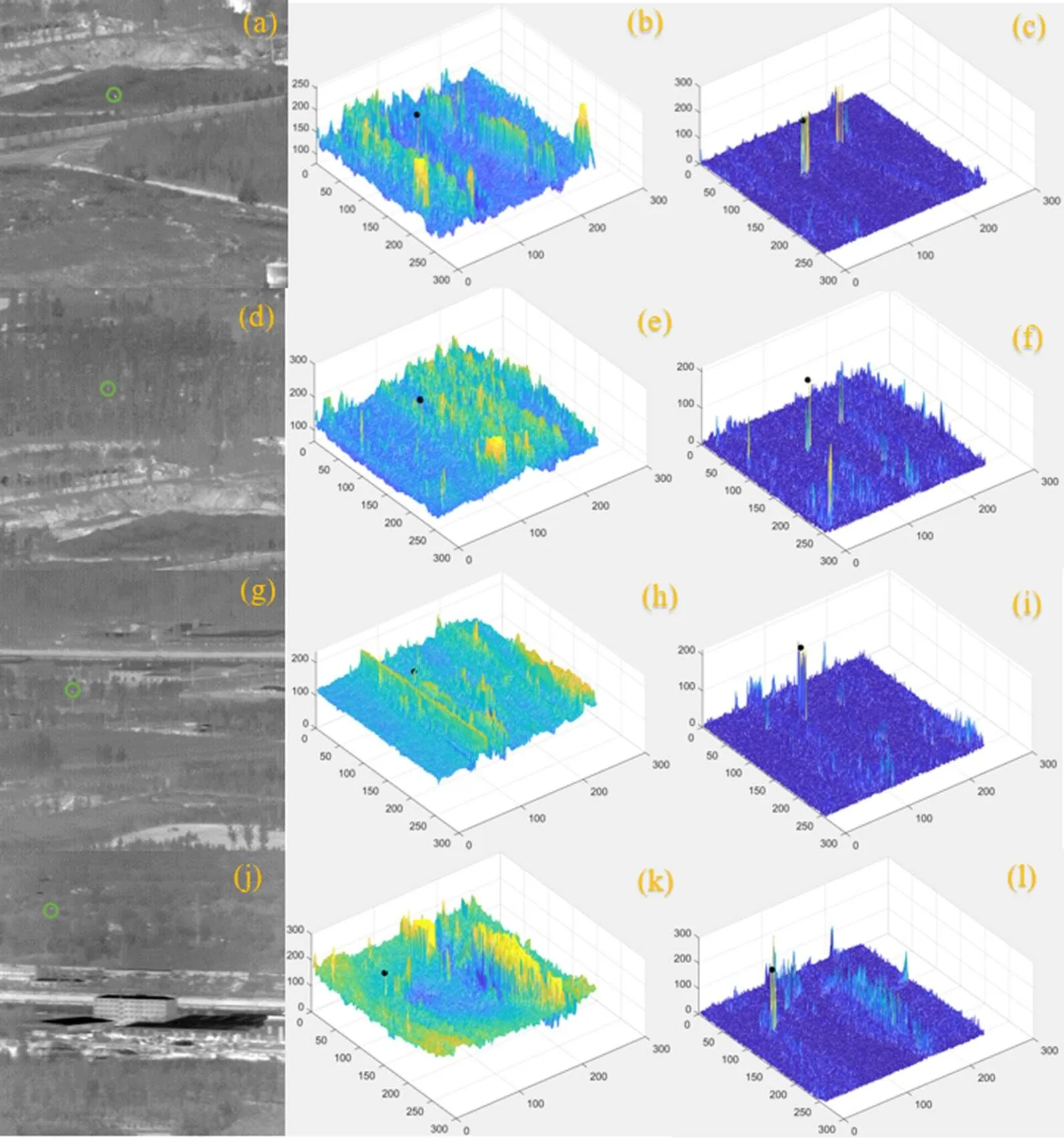

2.2.2 半自動標注算法對比實驗

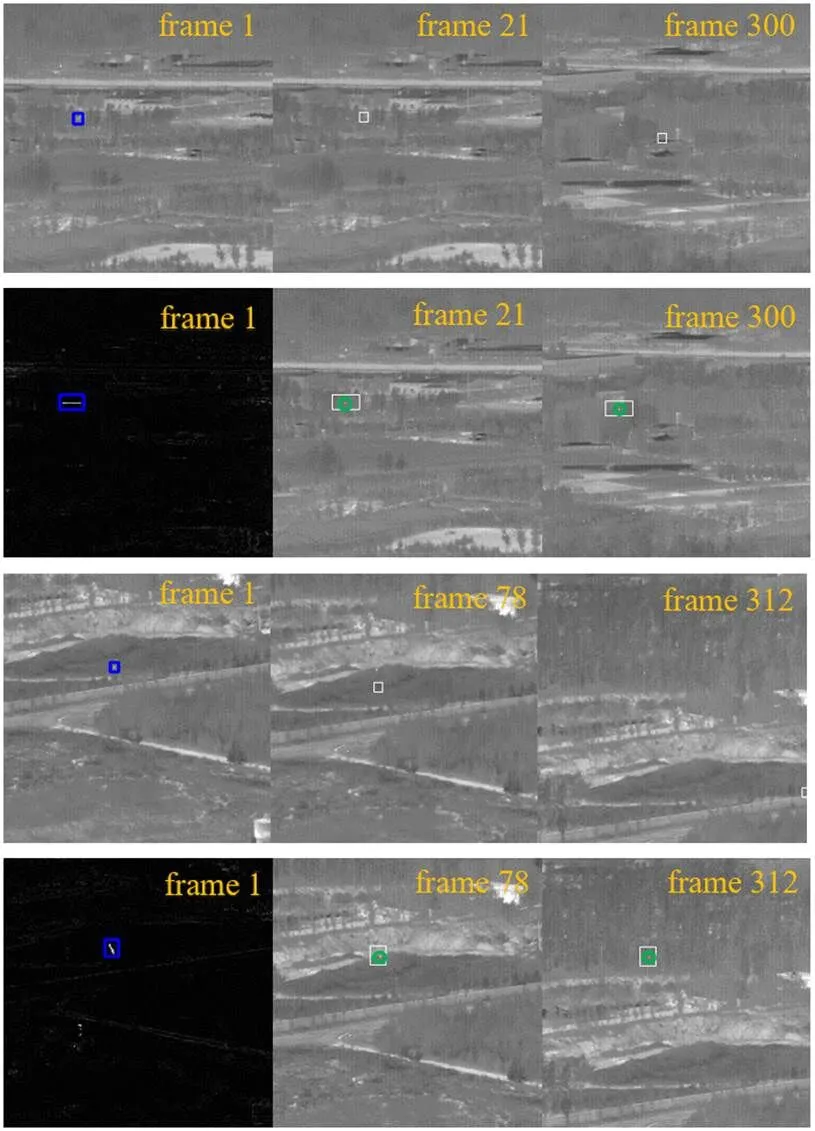

目標的初始位置都是手動標注,使其完全包圍需要跟蹤的目標,對于3×3個像素矩陣以下的紅外點目標來說,直接進行KCF目標跟蹤失敗率很高,使用本文的增強方法在差分圖上進行跟蹤能有效提升跟蹤的成功率。圖7為本文算法與原始KCF對紅外點目標跟蹤部分結果對比圖,如圖7所示,藍色框為初始框,白色框為跟蹤框,綠色圓圈是以跟蹤得到的點標注為中心進行繪制,上面兩行為data5,下面兩行為data11。對于遠距離探測的data5來說,因為目標提供的信息太少,跟蹤框從第二幀就開始發生偏移,到第21幀就徹底跟蹤失敗。對于data11來說,由于最開始目標的位置較近,目標的輻射信息較強,直接使用KCF跟蹤目標成功跟蹤了79幀,但是目標一旦運動到具有較高輻射信息的背景區域時就會跟蹤失敗。但是在使用本文提出的增強方法的數據上進行跟蹤,將得到的跟蹤框映射到原圖,可以發現目標無論是被遠距離探測(成像面積小且輻射強度弱),還是經過較為復雜的背景區域導致目標和背景的灰度對比度下降,都能準確地跟蹤到目標。因此,本文提出的紅外運動點目標增強方法能夠有效地提高KCF對紅外運動點目標跟蹤的成功率。

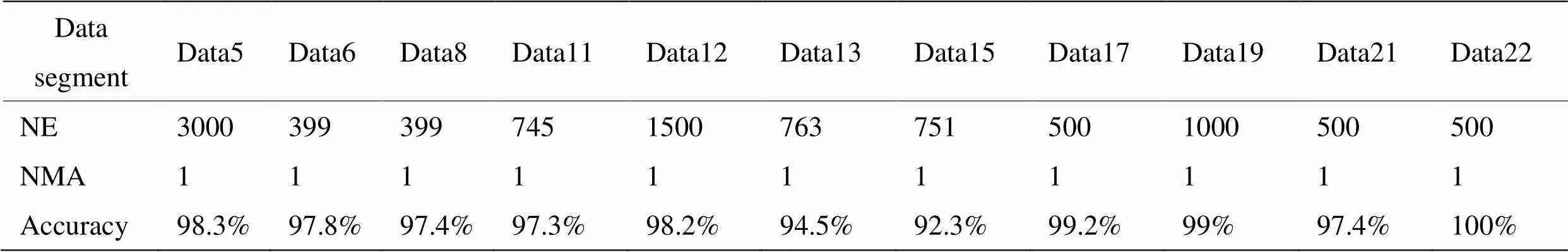

本文通過KCF跟蹤和相位譜重構得到紅外點目標的標注位置,表2為在人工標注首幀的情況下算法的正確率(Accuracy),此正確率是與人工標注的真值信息相比,與人工標注結果相同則為正確,否則為標注失敗,其中每個數據段的總幀數(number of frames, NF)及人工標注的幀數(number of manual annotations, NMA)都在表中給出。使用本文提出的自動標注算法,能夠得到較高的標注準確率。如表2所示,除data13以及data15以外在人手工只標注一幀的情況下都能達到97%以上的標注精度。Data13錯誤較多的原因是目標在飛入樹林以后目標的輻射信息減弱,且目標距離鏡頭較遠,融合之后形成的運動軌跡非常短,因此易被噪聲干擾,雖然此類噪聲具有一定的隨機性,當其減弱后便能重新尋回目標。Data15是因為目標的機動性強,因此目標經常出現不連續運動,導致跟蹤算法只能跟蹤目標軌跡的一部分,所以正確率較低。

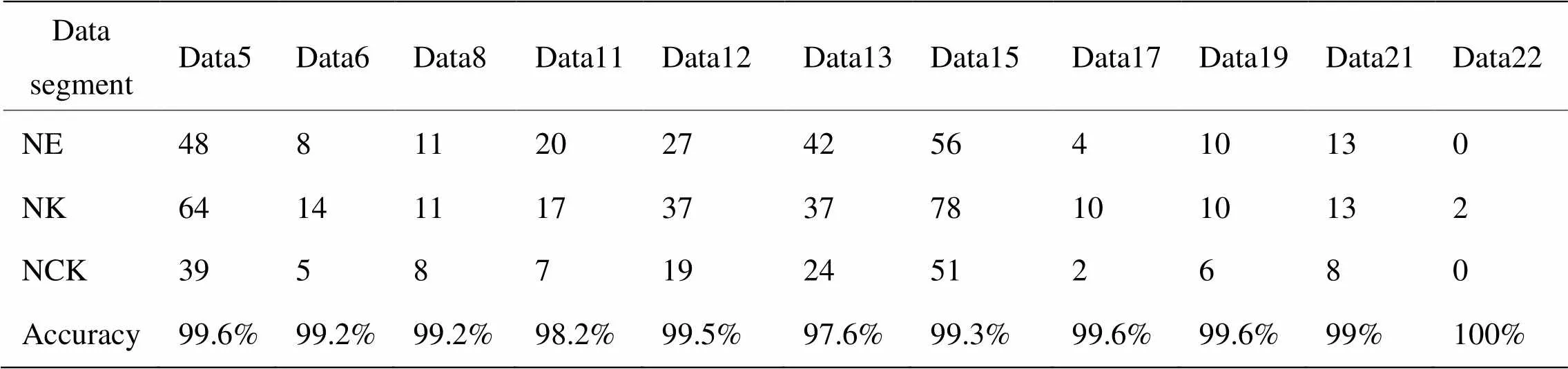

圖7 跟蹤結果對比

在花費最少的時間與人工代價的前提下,進一步提高標注數據集的準確率。按1.4節所示方法,選擇關鍵幀。各個數據集的錯誤幀數(number of errors, NE)、算法選擇的關鍵幀數(number of keyframes, NK)以及關鍵幀中準確查找錯誤幀的數量(number of correct keyframes, NCK)都如表3所示,表3中的標注正確率表示為在加入關鍵幀選擇策略之后半自動標注算法能達到的正確率。其中data15數據集錯誤56幀圖像,其中有51幀圖像為可以被糾正的數據,雖然關鍵幀策略并沒有將錯誤幀全部選擇出來,因為此關鍵幀只是以前后幀的聯系作為判斷條件,比如對data15提取關鍵幀時,提取的關鍵幀幀號為340及343,但是出現錯誤的幀為341及342,所以此方法能判斷某位置出現異常,但是不一定能準確返回幀號,此種情況多次發生,因此在用此標注方法可以關注返回關鍵幀的相鄰幀,能得到比表3更加優異的結果。盡管如此,本文設計的關鍵幀選擇策略仍然能以較低的時間與人工代價進一步提升數據集的標注質量,提升標注效率。

本文通過與手動標注的時長相比評價算法的效率,半自動標注算法處理一幀平均時間為1.2s,但是手動標注一幀圖像約為7s,此算法在實際標注作業中能夠大大減少標注時長,縮短標注周期。

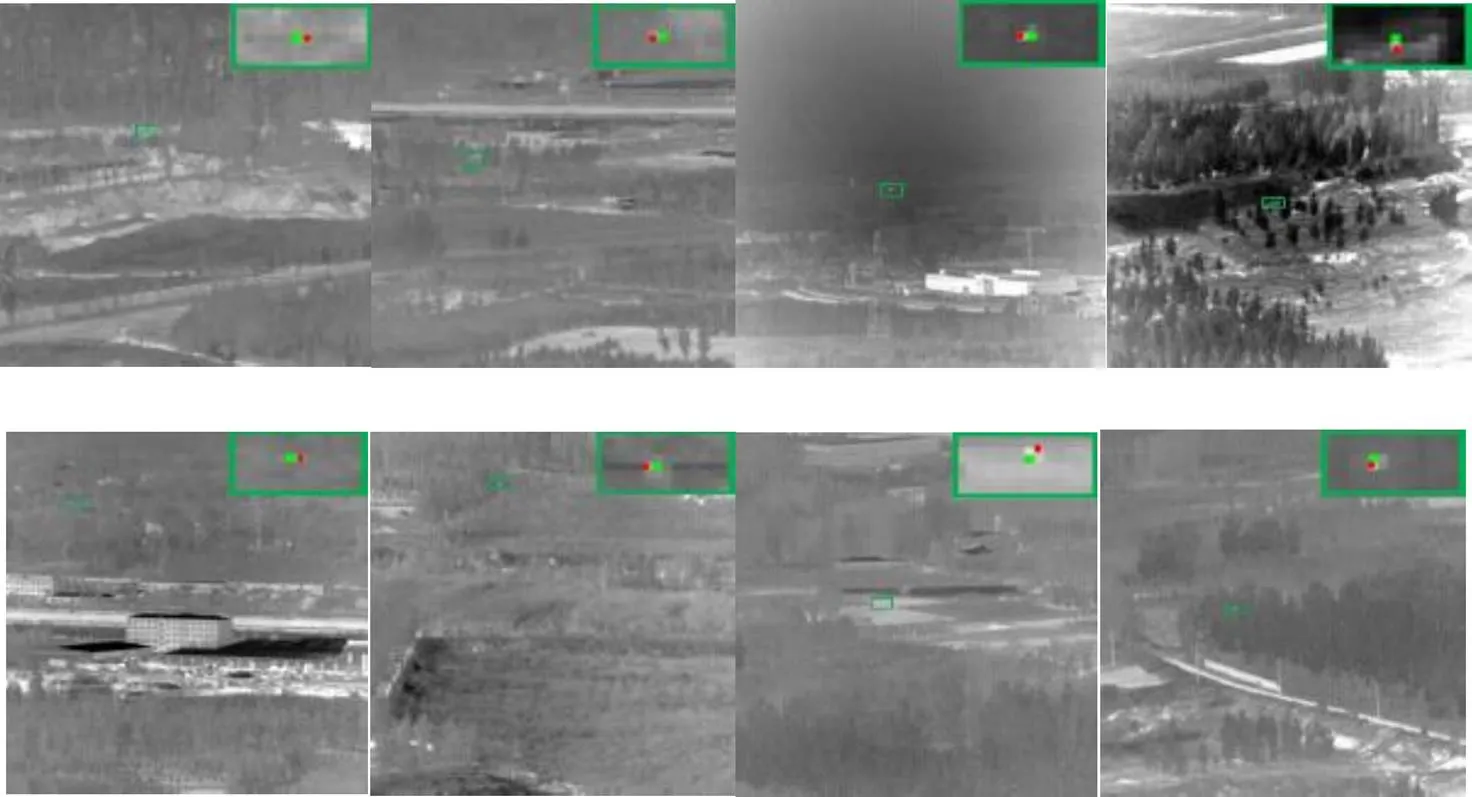

2.2.3 定位精度與誤差分析

本文提出的算法對紅外點目標進行標注,本數據集為各種背景下的無人機小目標,無人機的機頭位置一般為高亮區域,機翼的亮度與背景區域相近。本文提出的標注算法可以高效標注目標的高亮位置,得到像素級的點標注。圖8表示各種場景下目標的形態以及標注坐標的位置,如圖8所示,綠色點為本算法得到的標注位置,它為目標區域中最亮的點。但是,由經驗豐富的標注人員可以判斷,紅色點所在位置其實也屬于飛機的機頭位置,但是由于它在成像過程中亮度低于本文的標注位置,無法被標注出來。因此,本文的標注算法可以得到像素級的點標注,標注對象為目標上最亮的點,與經驗豐富的標注人員相比,本文算法無法得到更加精細的紅外點目標分割圖。

表2 給出首幀標注信息的標注結果

表3 半自動標注結果

圖8 標注精度與誤差對比

3 結論

針對紅外弱小目標數據集標注周期長、標注質量難把控等問題,提出了一種基于目標增強和視覺跟蹤的紅外運動點目標標注算法,該算法首先利用目標的運動信息對弱小的紅外點目標增強,然后利用改進的KCF算法和相位譜重構實現對紅外點目標的精確定位,同時在跟蹤過程中算法將可能發生標注錯誤的圖像幀返回給人進行校驗。實驗結果表明,本文提出的算法能夠在保證數據集質量的同時降低人的參與度、提高標注效率、縮短標注周期。

[1] Yuen J, Russell B, Liu C, et al. Labelme video: building a video database with human annotations[C]// 12(ICCV),, 2009: 1451-1458.

[2] Lee J H, Lee K S, Jo G S. Representation method of the moving object trajectories by interpolation with dynamic sampling[C]//2013(ICISA),, 2013: 1-4.

[3] Gil-Jiménez P, Gómez-Moreno H, López-Sastre R, et al. Geometric bounding box interpolation: an alternative for efficient video annotation[J]., 2016, 2016(1): 1-13.

[4] Vondrick C, Patterson D, Ramanan D. Efficiently scaling up crowdsourced video annotation[J]., 2013, 101(1): 184-204.

[5] Vondrick C, Ramanan D. Video annotation and tracking with active learning[J]., 2011, 24: 28-36.

[6] Buchanan A, Fitzgibbon A. Interactive feature tracking using K-D trees and dynamic programming[C]//(CVPR),, 2006: 626-633.

[7] Agarwala A, Hertzmann A, Salesin D H, et al. Key frame-based tracking for rotoscoping and animation[J]., 2004, 23(3): 584-591.

[8] Biresaw T A, Nawaz T, Ferryman J, et al. Vitbat: video tracking and behavior annotation tool[C]//13th(AVSS),, 2016: 295-301.

[9] Bakliwal P, Hegde G M, Jawahar C V. Collaborative Contributions for Better Annotations[C]//(VISAPP), Scite Press, 2017: 353-360.

[10] CHEN B, LING H, ZENG X, et al. Scribblebox: interactive annotation framework for video object segmentation[C]//(ECCV), Berlin Springer, 2020: 293-310.

[11] Lowe D G. Distinctive image features from scale-invariant keypoints[J]., 2004, 60(2): 91-110.

[12] Henriques J F, Caseiro R, Martins P, et al. High-speed tracking with kernelized correlation filters[J]., 2014, 37(3): 583-596.

[13] WANG M, LIU Y, HUANG Z. Large margin object tracking with circulant feature maps[C]//(CVPR), New York: IEEE, 2017: 4021-4029.

[14] 回丙偉, 宋志勇, 范紅旗, 等. 地/空背景下紅外圖像弱小飛機目標檢測跟蹤數據集[J]. 中國科學數據, 2020, 5(3): 286-297.

HUI Bingwei, SONG Zhiyong, FAN Hongqi, et al. A dataset for infrared detection and tracking of dim-small aircraft targets under ground/air background[J]., 2020, 5(3): 286-297.

Infrared Moving-point Target Semi-Automatic Labeling Algorithm Based on Target Enhancement and Visual Tracking

HE Min,HUI Bingwei,YI Mengni,HU Weidong

(,,,410073,)

Infrared video data annotation has the problems of low efficiency and poor quality. In this paper, a semi-automatic labeling method for moving point targets in infrared sequence images is proposed based on target enhancement and visual tracking to solve it. First, infrared sequence images in a continuous period of time were registered and fused to enhance the target features. Second, a visual tracking algorithm was utilized to locate the fused features efficiently and automatically. Lastly, a saliency map was obtained through phase spectrum reconstruction, and the exact coordinates of a target were obtained. During automatic annotation, the difference between the annotation results of adjacent frames was used to select key frames, which enabled the annotators to locate the image frames that had errors and manually annotated them quickly. The results of the experiments showed that the algorithm significantly reduced the participation of annotators and effectively solved the problems of long period and poor quality assurance in data annotation.

semi-automatic annotations, infrared point target, visual tracking, image sequences

TP391

A

1001-8891(2022)10-1073-09

2021-10-11;

2021-12-08.

何敏(1997-),女,湖南邵陽人,碩士,主要研究方向為紅外目標檢測。E-mail:douyc2021@163.com。

回丙偉(1985-),男,河北衡水人,博士,講師,主要研究方向為目標識別數據樣本工程。E-mail:huibingwei07@nudt.edu.cn

ATR重點實驗室基金“面向目標檢測跟蹤識別應用的多源數據集構建”項目。