修正的線性和冪函數的神經網絡算子的構造與逼近

李秉坤 陳志祥

(紹興文理學院 數理信息學院, 浙江 紹興 312000)

0 引言

人工神經網絡是根據人腦建立的數學模型,在計算科學、數學、工程等領域有廣泛的應用[1-2].而在一些應用中,如模式識別、回歸分析、智能控制等方面,主要是將人工神經網絡模型用來逼近多元函數.人工神經網絡作為一種萬能逼近器,受到人們的廣泛關注,其中最重要和最簡單的一種模型就是單隱層前向神經網絡,其數學表達式為

其中aj是連接隱層與輸出層之間的權值(也稱外權),x∈Rd是網絡的輸入,ωj∈Rd是連接輸入層與隱層之間的權值(也稱內權),bj是閾值或偏置, 而φ是定義在R上的激活函數,n是隱層神經元的個數. 第二種是近年來引起人們極大興趣的, 在計算機視覺、自然語言處理及模式識別等領域取得突破性成功應用的深度網絡或多隱層神經網絡. 由于深度網絡有多個隱層, 從而其網絡的拓撲結構就較單隱層而言更復雜, 且網絡隱層數越多, 其結構越復雜. 由此引起其表示能力的增強.

無論是第一種還是第二種網絡模型, 事實上第一種是第二種的特例, 總是涉及這樣三個問題:稠密性、復雜性和算法. 已知, 稠密性是理論基礎, 是對一個網絡模型進行復雜性和算法研究的前提和支撐. 對于單隱層模型, 所謂稠密性, 就是指對定義在Rd中緊集Ω上一個函數空間中的任一函數f(x)以及任意給定的精度ε>0,總存在一個網絡使

這里aj,ωj,bj(j=1,2,…,n)均是具體的數或者向量. 我們知道決定一個網絡的重要因素是激活函數φ,此模型對定義在Rd中緊集上的勒貝格Lebesgue可積函數類具有稠密性, 所以對于深度網絡模型, 當激活函數是非線性函數時, 自然具有稠密性. 比較常見的激活函數有Sigmoidal函數、tanh函數、ReLU函數等. 有關稠密性結果可參看文獻[3-10]. 一個網絡的復雜性就是指對給定的精度, 網絡中所含神經元的個數以及所涉及的權值與閾值的數量.因此,復雜性的研究為網絡結構的設計與算法設計提供理論基礎.而在網絡復雜性問題的研究中, 有一個重要的方法, 就是構造出具體的網絡結構或網絡算子,并對具體的函數空間通過一定的度量給出其逼近上界估計,這樣也就得到了精度、隱層神經元(包括權值與閾值數)之間的關系,從而對復雜性問題給出了一個量化的估計. 不論是淺層網絡還是深度學習中的深度網絡, 這種方法都是復雜性問題研究中的重要方法(可見文獻[11-27]). 鑒于ReLU函數,其定義為

σ(x)=max{0,x}.

是目前深度網絡中常用的激活函數,而該網絡的研究更多地偏重于模式分類問題.所以,本文一方面將利用ReLU函數的特點構造插值網絡和擬插值網絡,并討論其逼近誤差估計; 另一方面, 為了提高逼近函數的光滑性, 將研究修正的冪函數的網絡構造與逼近問題. 本文還將通過數值實驗進行說明.

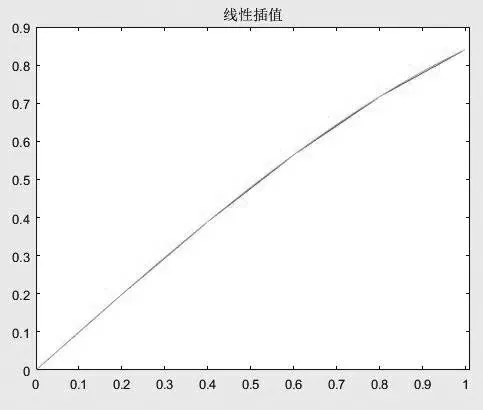

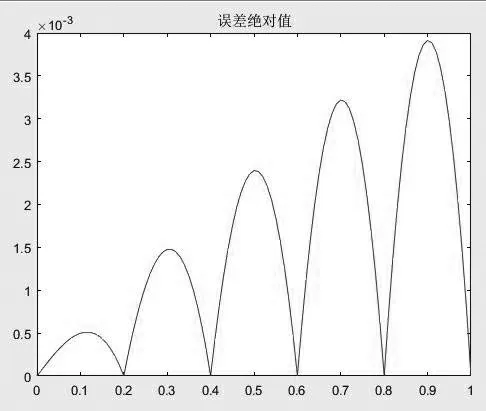

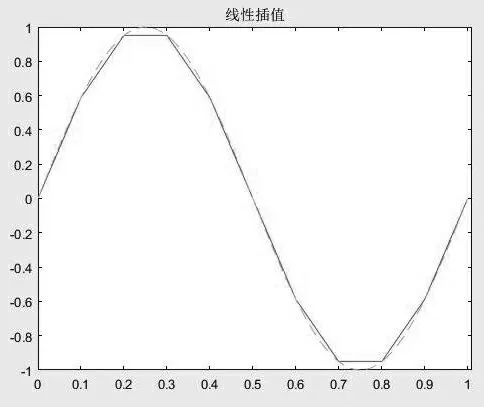

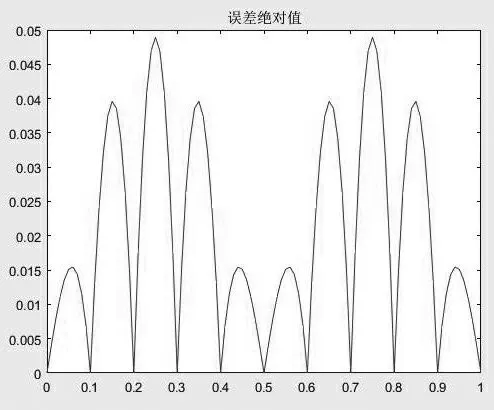

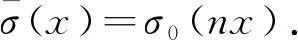

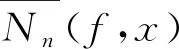

1 單隱層插值ReLU網絡的構造與逼近

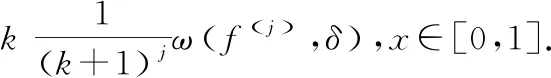

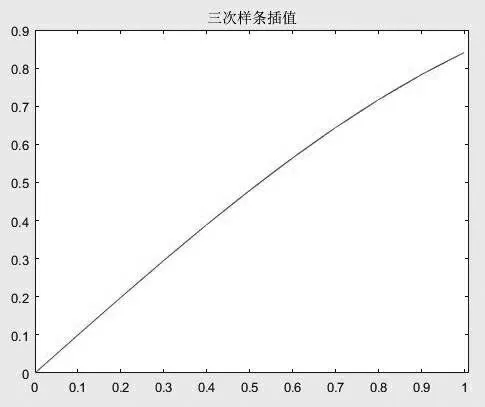

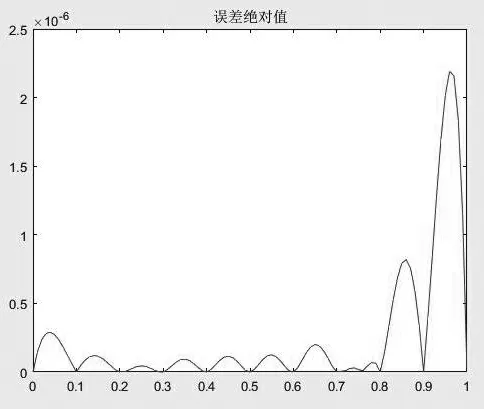

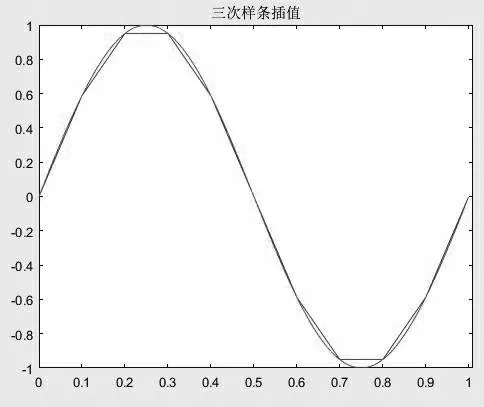

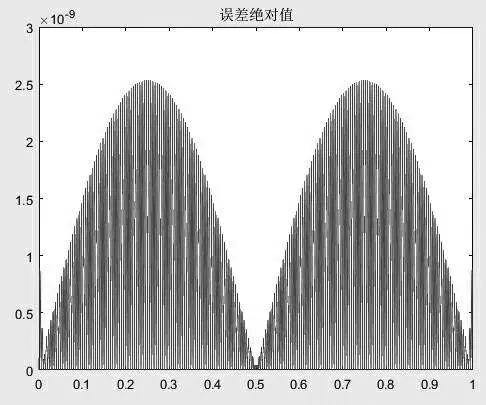

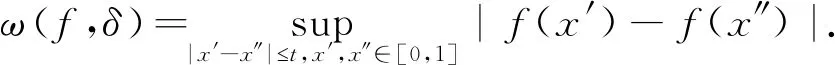

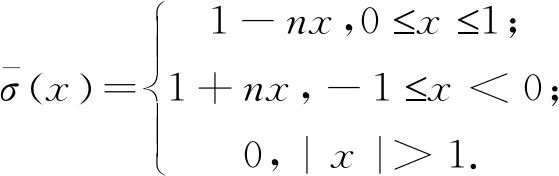

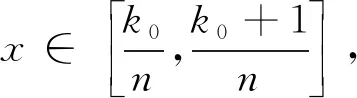

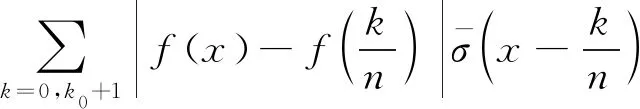

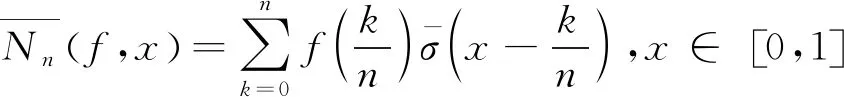

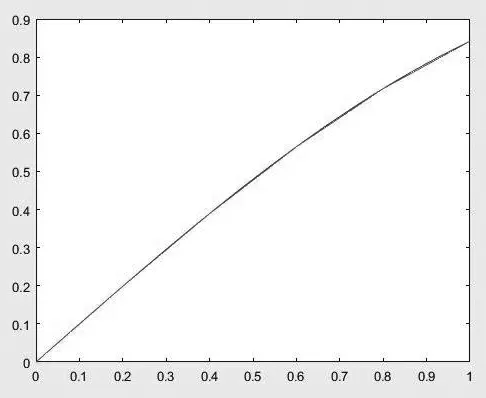

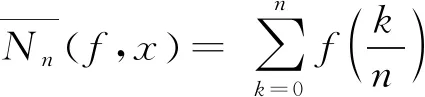

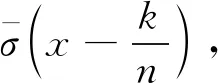

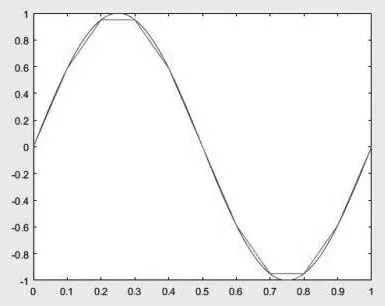

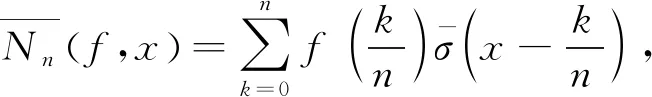

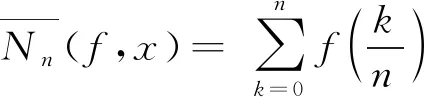

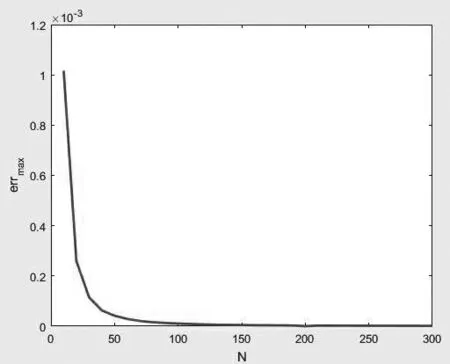

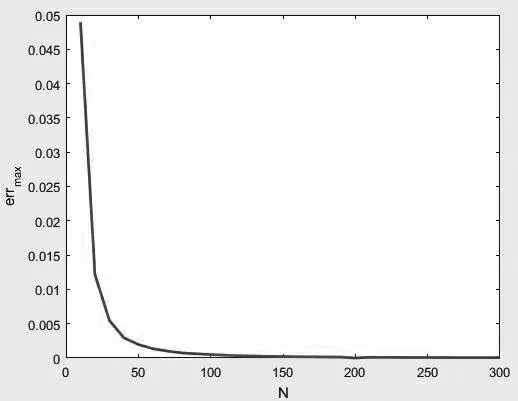

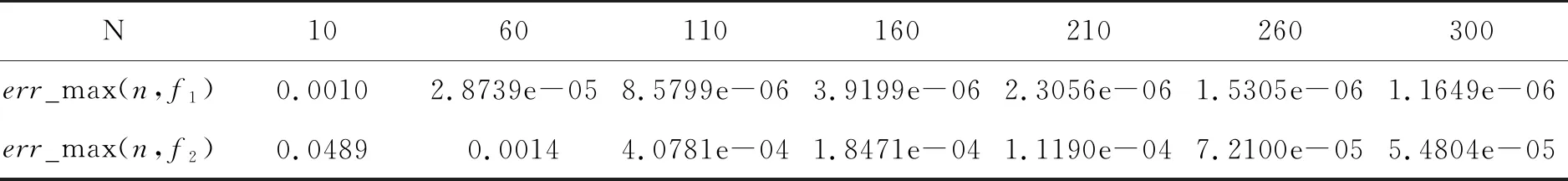

插值法是數值分析和函數逼近的重要方法之一.下面首先討論單隱層插值ReLU網絡逼近的構造與逼近.這里不妨設目標函數是定義在區間[0,1]上連續函數,且設插值節點為x0=0 Nn(f,x)=a-1σ(x+1)+a0σ(x-x0)+a1σ(x-x1)+…+an-1σ(x-xn-1). 而a-1,a0,a1,…,an-1可這樣來確定: 由Nn(f,0)=f(0), 即a-1σ(1)=f(0), 則 a-1=f(0). Nn(f,x1)=f(x1), 即a-1σ(x1+1)+a0σ(x1)= ? Nn(f,xn)=f(xn), 即a-1σ(xn+1)+a0σ(xn)+…+an-1σ(xn-xn-1)=f(xn). 或a-1(xn+1)+a0xn+…+an-1(xn-xn-1)=f(xn), 則有: 這樣,網絡Nn(f,x)就在節點x0,x1,…,xn上插值f.如果我們令: δ=max{x1-x0,x2-x1,…,xn-xn-1}. 則有|Nn(f,x)-f(x)|≤ω(f,δ),x∈[0,1],這里ω(f,t)是連續模,即: 特別地, 當f在[0,1]上滿足Lip條件, 即存 在M>0,使得對任意的x′,x″∈[0,1]有|f(x′)-f(x″)|≤M|x′-x″|α,(0<α≤1). 注1:若f是定義在一般的區間[a,b]上,只要通過線性變換就可以定義在[0,1]區間上. 接下來,通過數值實驗給以說明. 本實驗是在Windows環境下MATLAB R2016a中進行的.取f1(x)=sin(x), 其圖像與f1(x)=sin(x)在 x∈[0,1]上平均取5個插值節點作線性插值圖像, 如圖1所示.f1(x)=sin(x)在x∈[0,1]上平均取5個插值節點作線性插值與f1(x)=sin(x)的誤差絕對值如圖2所示,誤差絕對值的最大值為0.003 9. 圖1 線性插值 圖2 誤差絕對值 f2(x)=sin(2πx)圖像和f2(x)=sin(2πx)在x∈[0,1]上平均取10個插值節點作線性插值圖像如圖3所示.f2(x)=sin(2πx)在 圖3 線性插值 x∈[0,1]上平均取10個插值節點作線性插值與f2(x)=sin(2πx)的誤差絕對值如圖4所示,誤差絕對值的最大值為0.048 9. 圖4 誤差絕對值 對于前面的ReLu激活函數σ(x),令: σ0(x)=σ(x+1)-2σ(x)+σ(x-1),x∈(-∞,+∞). 事實上,容易得到: 從而有: 如此便得到結果.于是有: 從而有: 圖5 f1(x)與的圖像 圖6 f2(x)與的圖像 圖 7 f1(x)=sin(x)最大絕對誤差曲線 圖8 f2(x)=sin(2πx)最大絕對誤差曲線 x∈[0,1]誤差絕對值的最大值比較結果如表1所示. 表1 比較結果 我們知道,ReLu網絡的輸出是一個連續函數,但是一條折線,從而在某些點不可導.與ReLu相關的所謂修正的r次冪函數單元(RePU)σr(x), r≥2為整數, 其定義為σr(x)=(max{0,x})r.在回歸問題中,根據神經網絡中的萬有逼近定理,對于非多項式作為激活函數的單隱層前向神經網絡必具有萬有逼近性,即對于任意的精度,總存在某網絡結構使其對定義在閉區間上連續目標函數逼近給定的精度. 對給定的r≥2,若r是奇數,則σr(x)-σr(-x)=xr,x∈(-∞,+∞).而當r為偶數時,則有σr(x)+σr(-x)=xr,x∈(-∞,+∞).由于(x+1)r-xr=Pr-1(x)是一個r-1次多項式,而Pr-1(x+1)-Pr-1(x)是一個r-2次多項式,如此可得到任一r次多項式可通過 ar(x+br)r+ar-1(x+br-1)r+…+a1(x+b1)r+a0(x+b0)r來表示.也就是說, 當以xr為激活函數時,含有r+1個隱層神經元的單隱層前向神經網絡可得到任意的次數不超過r的多項式,自然形成一個對目標函數用次數不超過r的多項式近似.也就是說,當用σr作為激活函數時,其隱層單元是2r+2個. 而且由于xr是通過σr(x)與σr(-x)表示,從而網絡結構中的參數只有一半在變化. 由此我們可以看出, 當用一個r次冪函數或r次多項式作為單隱層前向神經網絡的激活函數時, 隱層神經元不管怎么多, 其輸出至多為一個r次多項式. 不過, 對光滑性比較好的目標函數, 自然可以考慮用多項式作為逼近工具, 而且, 隱層神經元數只需比激活函數的次數多一. 但是, 如果再利用σr(x)作為隱層激活函數,也就是使其輸出是一個r次樣條函數, 這時網絡的逼近能力就增強了.所以, 這也充分表明網絡結構設計的重要性. 不妨將所考慮的目標函數仍定義在[0,1]上,x1 Sr(x1,x2,…,xk)={s∈Cr-1[0,1]:s|[xi,xi+1]∈Pr,i=0,1,…,k}, 這里x0=0,xk+1=1,Cr-1[0,1]表示由定義在[0,1]上的r-1階連續函數所構成的線性空間. 1,x,x2,…,xr,(x-x1)r,…,(x-xk)r形成Sr(x1,x2,…,xk)的一個基, 而且有如下結果(可見[28]): 對任意給定的j∈{0,1,…,r},存在僅依賴于j的常數kj,使得對任意的f∈Cj[0,1]及節點集{x1,x2,…,xk}成立: 這里δ=max{|xi+1-xi|:i=0,1,…,k}.這說明對給定的f∈Cj[0,1]存在s∈Sr(x1,x2,…,xk)使得|f(x)-S(x)|≤kδjω(f(j),δ),x∈[0,1].特別地,若x0,x1,…,xk+1構成[0,1]區間的k+1等分點,則有: 顯然s(x)可以看作以激活函數σr(x)構成的單隱層前向網絡的輸出.而且, 網絡結構的隱層含有2r+k個神經元. 最后,還是選取如下兩個目標函數: f1(x)=sin(x),x∈[0,1],f2(x)=sin(2πx),x∈[0,1]. 進行數值實驗. f1(x)=sin(x)圖像與f1(x)=sin(x)在x∈[0,1]上平均取10個插值節點作三次樣條插值如圖9所示.f1(x)=sin(x)在x∈[0,1]上平均取10個插值節點作三次樣條插值與f1(x)=sin(x)的誤差絕對值如圖10所示,誤差絕對值的最大值為2.1927e-06. 圖9 三次樣條插值 圖10 誤差絕對值 f2(x)=sin(2πx)圖像與f2(x)=sin(2πx)在x∈[0,1]上平均取10個點作三次樣條插值圖像如圖11所示.f2(x)=sin(2πx)在x∈[0,1]上平均取200個點作三次樣條插值與f2(x)=sin(2πx)的誤差絕對值如圖12所示,誤差絕對值的最大值為2.5370e-09. 圖11 三次樣條插值 圖12 誤差絕對值

2 擬插值(近似插值)ReLU網絡的構造與逼近

3 RePU網絡的構造與逼近