基于YOLACT++的檳榔檢測算法研究

舒 軍,王 祥,舒心怡

(1 湖北工業大學電氣與電子工程學院,湖北 武漢 430068;2 湖北工業大學太陽能高效利用及儲能運行控制湖北省重點實驗室,湖北 武漢 430068;3 武外英中國際學校,湖北 武漢 430000)

檳榔是海南的重要經濟作物,產量占全國97%以上,曾列入抗擊新冠肺炎中藥配方,具有較高藥用價值[1]。檳榔檢測作為檳榔加工的重要步驟。目前,主要采用最大類間方差法(OSTU)[2]、最大極值穩定區域(MSER)[3]等傳統圖像處理方法將圖片中的檳榔與背景分割開,再根據檳榔圖像最小外接矩形的長寬對檳榔進行分級。在檳榔圖像采集過程中,由于機械振動造成檳榔花蒂掉落、檳榔堆疊,和打光原因造成的陰影生成。使得傳統的圖像處理方法無法準確識別單個檳榔實例,給檳榔分級造成嚴重干擾。因此,實現高可靠性的檳榔實例分割是目前亟需解決的問題。

實例分割具備目標檢測和語義分割的特點,既需要檢測出同一種類的不同實例對象,又需要做到像素層面分類。當前,實例分割算法逐漸被應用于農業生產中,并具有較高的應用價值,姜紅花等[4]將 Mask R-CNN運用于玉米葉與雜草的檢測,雜草檢測率達91%。陳佳等[5]采用YOLACT算法將白羽雞背部的分割面積與體質質量進行關聯,實現白羽雞體質質量評估,平均準確率97.49%。劉文波等[6]在SOLOV2網絡中引入可變形卷積,實現對番茄葉片病害的檢測,掩模分割精度達42.3%。YOLACT++[7]作為YOLACT改進算法[8],相較于Mask R-CNN[9]具有速度優勢,較SOLOV2算法[10]在檳榔堆疊時具有邊緣分割優勢。選用YOLACT++作為檳榔實例分割模型,仍然存在掩模預測錯誤與檢測框回歸不準確造成的部分檳榔掩模殘缺的問題。

針對檳榔自動化加工中檳榔檢測的需求,需要實例分割速度達到18幀/s以上,同時要確保檢測與分割準確性。在YOLACT++主干網絡中引入改進的Res2Net[11]模塊增強網絡語義信息提取能力,改善掩模預測錯誤問題。對于邊界框不精確問題,本文采用CIoU[12]邊界框回歸損失函數,改善了邊界框預測精度。實驗結果表明,改進算法改善了檳榔實例分割效果,進而提高了檳榔的分級準確率。

1 檳榔檢測流程

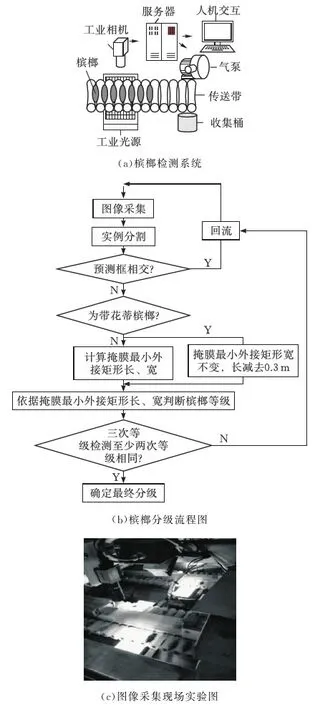

檳榔檢測主要由圖像采集、圖像處理和檳榔分揀三部分完成,其檢測系統模型見圖1a,使用工業相機采集傳送帶上的檳榔圖片,使用工業光源增加檳榔與傳送帶對比度,突出檳榔特征。服務器用訓練好的檳榔檢測模型對采集來的檳榔圖片進行實例分割與等級判斷,結果發送到人機交互界面,同時控制氣泵,將不同等級的檳榔果吹入不同的收集桶中。

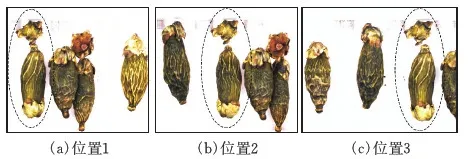

檳榔分級流程見圖1b,工業相機完成檳榔圖片的采集,每張圖片正常采集三顆檳榔,用實例分割網絡識別出帶花蒂檳榔與無花蒂檳榔的類別、掩膜和預測框位置,若檳榔預測框相交,可判斷為檳榔堆疊,進行回流處理。對于無花蒂的檳榔,計算其掩模的小外接矩形的長和寬。對于帶花蒂的檳榔,將其掩膜的最小外接矩形長度減去30 mm,視為去花蒂處理,寬度保持不變。最后,依據最小外接矩形的長寬將檳榔分為A、B、C、D四個等級,檳榔分級指標見表1。每顆檳榔均采集三個不同位置的圖片,三次等級檢測中選其中至少兩次相同的等級作為最終分級。對三次等級檢測均不同的情況進行回流處理。

圖1 檳榔檢測系統

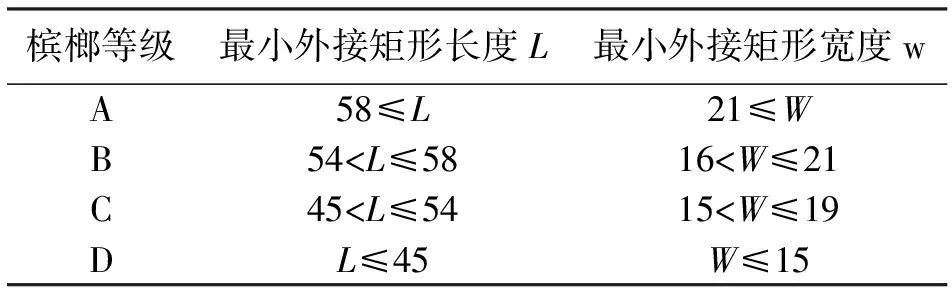

表1 檳榔分級指標 mm

2 YOLACT++網絡結構

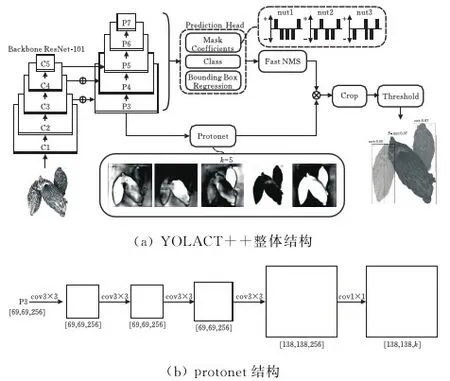

YOLACT++整體結構見圖2a,包含主干(Backbone)、預測頭(Prediction Header)、原型分支(Protonet)、快速非極大值抑制(Fast NMS)、裁剪模塊(Crop)和閾值分割(Threshold)六個部分組成。基于ResNet101構造的主干網絡對輸入的圖像進行特征提取,生成C1~C5五個特征圖。將C3,C4,C5三個特征圖作為特征金字塔的中間輸入層,經過多個尺度的特征融合生成P3~P7五個特征圖,再通過兩個并行的分支任務。第一個分支將P3特征圖通過圖2(b)所示的原型分支產生k個原型掩模。第二個分支在預測頭中以特征圖的每個像素點為錨點,生成長寬比為[1,1/2,2,1/3、3]的錨框,用于檢測是否存在實例。再分別進行原型掩模的系數預測(mask Coefficients)、錨框分類(Class)與邊界框回歸(Bounding Box Regression)。Fast NMS對經過邊界框回歸后的錨框進行篩選,獲取最終的實例預測框。將原型掩模與掩模系數進行線性組合,生成的圖像經過預測框區域裁剪和閾值分割,進而獲得最終的實例掩模。

圖2 YOLACT++模型結構

3 算法改進

3.1 主干網絡改進

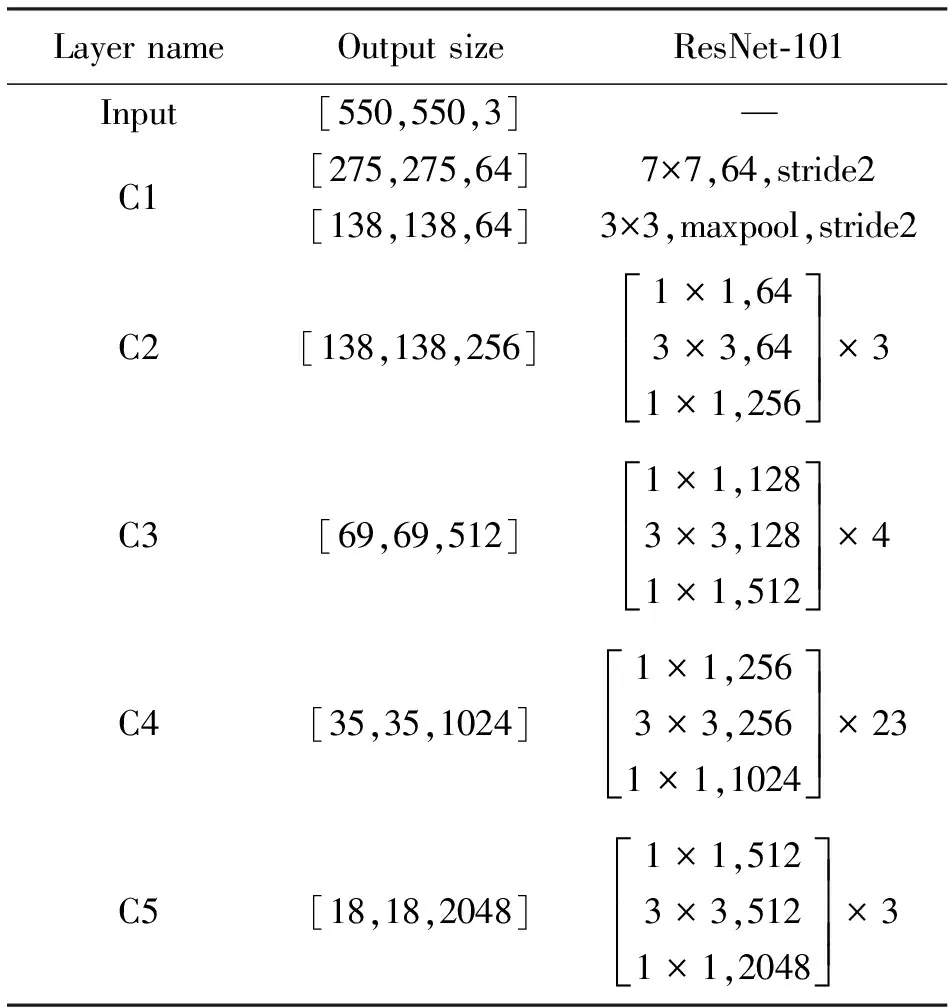

YOLACT++采用基于ResNet-101的主干網絡(表2),其中Bottleneck[13]殘差結構作為ResNet-101的基本模塊(圖3a),該結構在解決梯度消失同時增強網絡的特征提取能力。為更進一步提取深層特征,充分利用單層內特征,本文采用改進的Res2Net模塊替換主干網絡中的Bottleneck模塊,以獲得更強的分層多尺度表示能力。Res2Net結構見圖3b。Res2Net將經過1×1卷積特征圖按通道均勻分為4個特征子圖,每個特征子圖含有相同的空間大小和通道數。除第一個特征子圖,其余每個特征子圖都對應一個3×3卷積。從第三個特征子圖開始,將特征子圖與前一個經過卷積的特征子圖輸出相加,作為該特征子圖對應卷積的輸入,然后將4個特征子圖的輸出結果進行合并,并經過1×1卷積輸出。通過對特征子圖的分割和拼接實現特征重用,擴大感受野,有利于全局和局部信息提取。最后通過卷積輸出。改進的Res2Net增加了CBAM[14]注意力模塊,對通道特征與空間特征進行加權,抑制無效特征,使得網絡更關注于目標區域特征。

表2 ResNet-101主干網絡

圖3 網絡結構對比

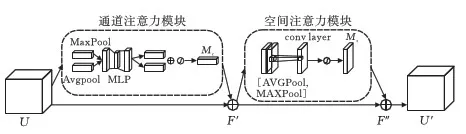

CBAM注意力模塊結構見圖4。由通道注意力模塊和空間注意力模塊構成。分別為特征圖生成一維的通道注意力權重和二維的空間注意力權重,用于加強網絡的特征提取能力。

圖4 CBAM結構

在通道注意力模塊中將輸入的特征圖U(大小H×W×C)經過全局最大池化和平均池化,獲得兩個1×1×C的特征圖,其結果分別輸入權值共享的兩層感知器(MLP),將輸出的特征相加經過激活函數,生成通道注意力權重Mc。最后將輸入特征圖與通道注意力權重相乘,生成通道注意力特征圖F′。計算過程如下:

Zavg=AvgPool(U)

Zmax=MaxPool(U)

Mc=σ[fc2(δ(fc1(Zavg)))+fc2(δ(fc1(Zmax)))]

F′=Mc·U

式中:AvgPool表示全局平均池化,求取每個通道的像素平均值;MaxPool表示全局最大池化,保留每個通道的特征圖的像素最大值;fc1全連接層,輸入通道C,輸出通道C/16;fc2全連接層,輸入通道C/16,輸出通道 C;δ表示ReLU函數;σ表示sigmoid函數。

在空間注意力模塊中將通道注意力特征圖F′作為輸入先進行通道維度的平均池化和最大池化,獲得兩個H×W×1的特征圖,再將兩個特征圖拼接后通過7×7的卷積層,結果經過sigmoid函數,得到二維單通道的空間注意力權重Ms,將空間注意力權重與通道注意力特征圖相乘,生成同時具有空間與通道注意力的特征圖F″。計算過程如下:

Zavg=AVGPool(U)

Zmax=MAXPool(U)

Ms=σ(fc3(Zavg,Zmax))

F″=Ms·F′

式中:AVGPool表示通道維度平均池化,對每個通道的特征圖對應像素相加取平均值;MAXPool表示通道維度最大池化,保留各個通道特征圖對應位置的最大像素值;fc3表示7×7的卷積,輸出通道為1。

3.2 邊界框回歸損失函數改進

邊界框回歸損失函數用來衡量預測框與真實框的位置關系。YOLACT++采用Smooth L1損失函數作為邊界框回歸損失函數,分別對預測框的長、寬、中心點橫坐標和縱坐標的偏置進行損失計算,具體計算過程如下:

式中:xa,ya,wa,ha表示anchor的中心點坐標、長和寬;x*,y*,w*,h*表示真實框的中心點坐標、長和寬;u表示網絡預測的anchor偏置矩陣;v表示真實框與anchor的偏置矩陣。

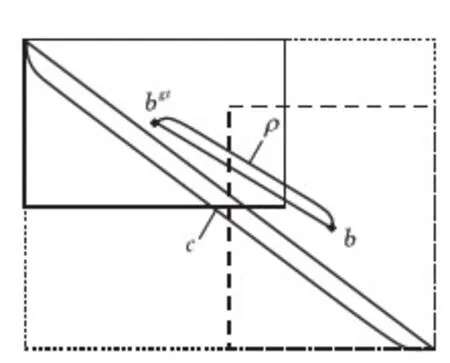

由于Smooth L1作為邊界框回歸損失函數對四個偏置量分別計算損失值,算法無法準確描述預測框與真實框之間位置關系。采用CIoU損失函數將有助于解決上述問題。邊界框回歸損失示意圖見圖5,定義邊界框損失函數:

圖5 邊界框回歸損失計算

式中:b,bgt分別表示預測框與真實框的幾何中心;ρ表示兩個中心點之間的歐式距離;c表示預測框和目標框最小外接矩形的對角線長度;α為用于平衡比例的參數;v用來衡量預測框和目標框之間的比例一致性。

網絡先進行anchor偏置量預測,再將anchor經過平移縮放成為預測框b,完成邊界框回歸。利用預測框b與真實框bgt計算邊界框回歸損失函數,CIoU損失函數考慮到了預測框與真實框的交并比(IoU)、最小外接矩形、幾何中心距離ρ和長寬比例。Smooth L1損失函數針對預測框的偏移量進行損失計算。只考慮幾何中心距離與長寬比,缺乏對交并比和最小外接矩形的考量。

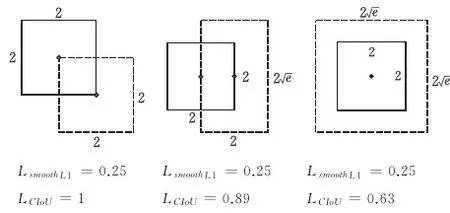

圖6中實線框為真實框,虛線框為預測框。當偏移量u=(0,0,0,0),即預測框與anchor重合時,用兩種邊界框損失函數分別計算其對應損失值,可以發現采用Smooth L1損失函數計算的損失值均相同,但采用CIoU損失函數計算的損失值均不同,預測框與真實框交并比越大、外接矩形越小、幾何中心距離越短、長寬比越接近,其損失值越小,預測框與真實框越接近,即邊界框回歸越準確。故可采用CIoU損失函數更加精確地衡量邊界框回歸性能。

圖6 不同預測框對應的損失函數

4 實驗

4.1 檳榔圖片采集與數據集建立

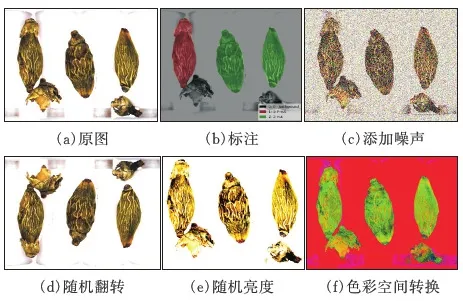

本研究以檳榔果作為研究對象。數據采集地點在益陽市口味王檳榔廠,圖像采集設備選用德國acA1280-60gc Basler ace工業相機。對每顆檳榔采集如圖7所示左、中、右三個位置對應不同角度的圖片,共采集檳榔圖片1500張,并對圖片采用添加噪聲、隨機翻轉、隨機亮度、色彩通道轉換這4種數據增強技術,將數據集擴充到6000張。用LabelMe 標注工具完成圖像的標注工作,將圖像的語義分為三類:背景(background)、帶花蒂檳榔果(F-nut)、無花蒂檳榔果(nut)對應的標簽分別為0、1、2。標記后的數據集包含原始圖像和與之對應json標簽文件,部分數據處理后的圖片見圖8。

圖7 同一顆檳榔不同位置圖像采集

圖8 數據集處理

4.2 實驗環境

檳榔實例分割實驗硬件配置:操作系統Windows 10,CPU為 Intel Core i5-11400,GPU加速NVIDIA GTX1080ti 與CUDA10.0 cuDNN7.0,運行環境Python3.7,深度學習框架Pytorch1.2.0。

4.3 評價指標

選用AP(Average Precision)作為預測框和實例分割掩模的評價指標。AP通過計算精確度-召回率曲線(P-R)下方面積得到,由于IoU閾值的選取會影響精確度和召回率大小,選用AP75(IoU=0.75),mAP(IoU=0.50:0.05:0.95)作為評價指標,計算公式如下:

式中:TP表示模型識別為帶花蒂檳榔或無花蒂檳榔且與真實標注類別匹配的樣本數量;FP表示模型預測為帶花蒂檳榔或無花蒂檳榔且與真實標注類別不匹配的樣本數;FN表示預測為背景但真實標注為帶花蒂檳榔或無花蒂檳榔的樣本數量。

對網絡模型運算速度及模型復雜度采用參數量(Parameter),以及浮點計算量(FLOPs)作為評價標準完成評價。對于一次卷積運算,其模型參數和浮點計算量公式如下:

Parameter=(K2Cin)Cout+Cout

FLOPs=[2(CinK2)Cout+Cout]HW

其中Cin,Cout分別為輸入輸出特征圖通道數,K為卷積核的大小,H×W為輸出特征圖大小。考慮到激活函數(activation function)以及偏置(bias)等方面的不同,對FLOPs的計算方式不盡相同。為便于對比分析,本文采用Pytorch中的第三方庫thop,對模型參數量、浮點計算量進行統一計算。

4.4 實驗結果分析

實驗數據集內共包含檳榔片樣本6000張,其中用作訓練集4800張,測試集1200張。訓練epoch為800次,GPU每次處理4張圖片,使用隨機梯度下降(SGD)作為訓練時的優化器,初始動量設置為0.9,學習率為0.001,權重衰減系數0.0001。

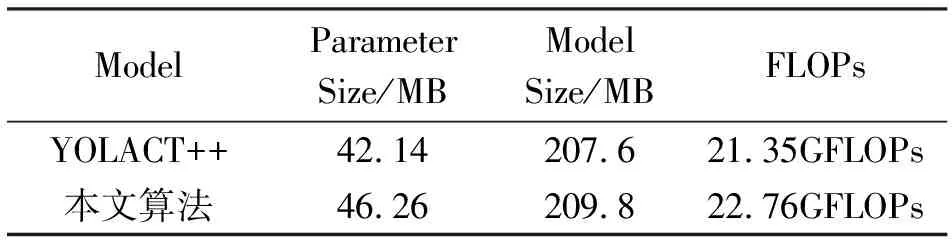

4.4.1參數量與計算量對比結果主干網絡的改進將同一特征層的不同通道特征圖進行多次多尺度的特征融合,使得高分辨率特征圖與低分辨特征圖信息相互補充,使得主干能充分提取圖片的語義信息,同時造成部分主干網絡模型尺寸與參數的增加,邊界框回歸損失函數改進也在一定程度上增加模型的計算量。網絡改進前后網絡參數量及總浮點運算量FLOPs量化結果見表3。可以看出網絡參數、模型大小、浮點運算量相較于改進前提升9.8%,1.1%,6.6%

表3 網絡改進前后參數量與計算量對比

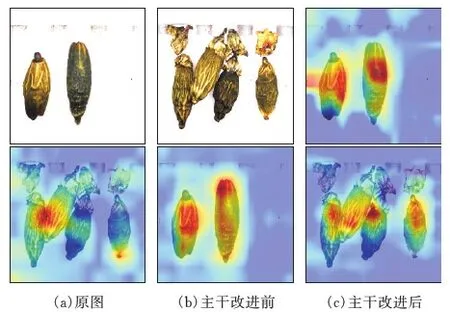

4.4.2主干網絡改進前后熱點圖對比針對主干網絡的改進,采用Grad-CAM生成主干網絡的熱力圖(heatmap)用來對主干網絡的輸出進行可視化分析,生成的主干網絡改進前后的熱力圖見圖9。顏色越亮表示主干網絡對于該區域的關注力越強,原主干網絡關注的區域包含檳榔的部分區域和背景區域,存在關注區域錯誤的問題。本文提出改進的主干特征提取網絡,加深網絡對于圖像深層信息的提取能力,采用CBAM注意力機制,使得主干網絡更關注于檳榔區域,并極大的抑制了背景陰影和掉落花蒂的干擾。

圖9 主干網絡熱點圖

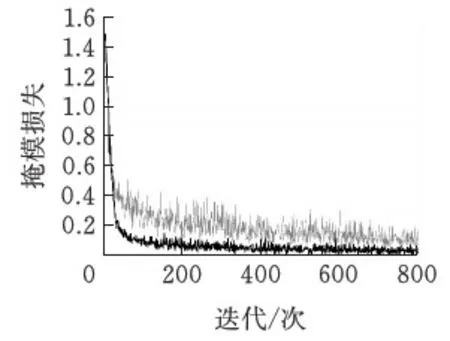

4.4.3網絡分割效果對比損失值用來衡量網絡預測結果與標注之間的誤差,損失值越小表示模型預測得越準,網絡每一次迭代訓練過程中生成損失值,并記錄于訓練日志中。網絡改進前后的掩模損失函數相同,均采用預測掩模與標注掩模的二值交叉熵作為損失函數,故可通過掩模損失值作為衡量網絡改進前后的掩模質量。掩模損失折線圖見圖10,損失值隨著迭代次數的增多而下降,原網絡進行800次迭代后loss值穩定在0.08左右。改進后網絡損失值最終穩定在0.01左右,改進后的模型具有更加良好掩模預測性能。

圖10 掩模損失值曲線

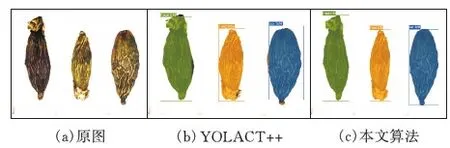

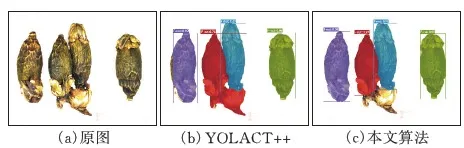

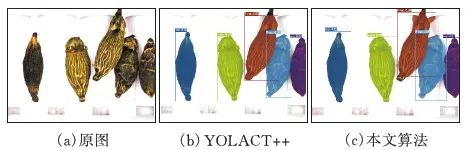

從測試集中挑選3幅不同條件下的圖片來測試檳榔實例分割模型改進前后的分割效果。圖11可以看出對正常采集圖像進行實例分割,掩模會受到預測框區域的限制,SmoothL1損失函數作為邊界框回歸的損失函數造成部分檳榔果預測框定位不準確,導致掩模的部分區域無法識別出來。圖12和圖13可以看到,原始的YOLACT++算法對傳送帶上的陰影與臟污和掉落的檳榔花蒂容易造成誤分割。本文提出改進的主干特征提取網絡,加深網絡對于圖像深層信息的提取能力,同時使得主干網絡更關注于檳榔花蒂與檳榔籽,減少背景陰影與臟污干擾,算法使用CIoU作為邊界框回歸損失函數,使得邊界框回歸更加準確,一定程度上提升了掩模的分割質量。

圖11 正常采集

圖12 花蒂掉落及檳榔堆疊

圖13 背景陰影及檳榔堆疊

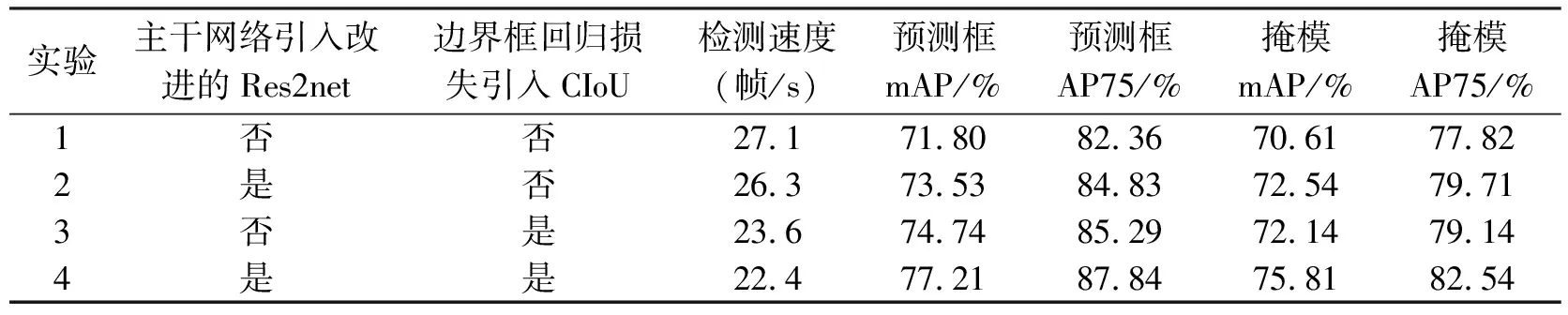

4.4.4不同改進點對比為了驗證不同改進點的有效性,做了四組對比實驗,結果見表4。

表4 不同改進點對比實驗結果

通過對比實驗1與實驗2可以發現,主干網絡的改進對于預測框與掩模的mAP均分別提升1.73%,1.93%。對比實驗1與實驗3,邊界框回歸中CIoU的引入明顯提高了預測框的平均精度,相較于改進前上升2.94%。對比實驗1與實驗4,可以發現主干網絡與邊界框整體改進相較于原算法在預測框mAP與掩模mAP上分別提升5.41%與5.20%,但檢測速度有所損失,降低了4.7幀/s。

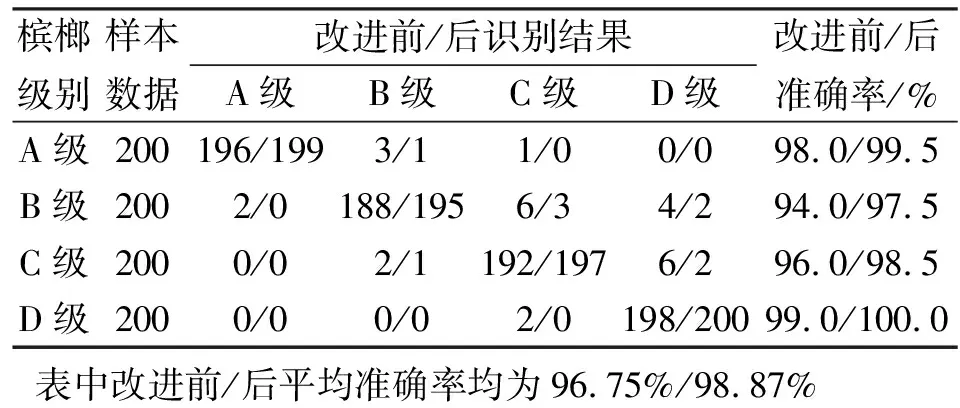

4.4.5樣本預測結果用訓練好的網絡模型進行分級測試,將A、B、C、D四個等級的檳榔各兩百顆送入傳送帶進行實例分割與檳榔分級測試,改進前后實驗測試結果見表5。

表5 改進前/后識別結果

通過對比可以發現YOLACT++網絡的實例掩模由于受到預測框精度限制,導致無法實現完整的掩模分割,造成部分檳榔等級被誤分為低等級。由于打光造成的陰影被誤分割為檳榔區域,造成檳榔被誤分為高等級。而本文算法很好的改善了上述問題,使得檳榔的平均準確率提升2.12%,達到98.87%。

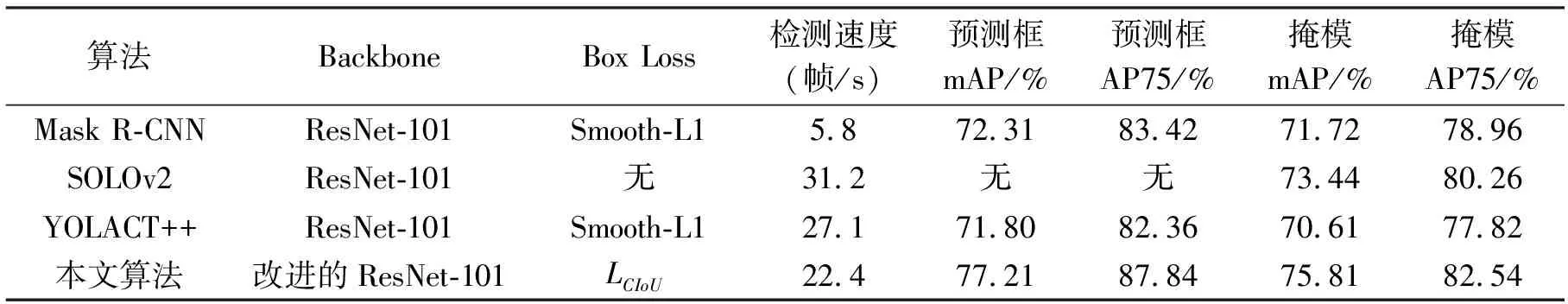

4.4.6不同算法對比為進一步驗證本文算法的實例分割效果,利用檳榔數據集分別對Mask R-CNN、SOLOv2、YOLACT++與本文算法進行訓練,用訓練好的模型驗證檳榔的檢測與分割效果。Mask R-CNN作為R-CNN最具代表性的雙階段實例分割算法,SOLOv2作為單階段實時實例分割代表,訓練結果對比見表6。從表6可以看出Mask R-CNN檢測速率不佳,SOLOv2檢測精度稍遜于本文算法,本文算法相較于Mask R-CNN、SOLOv2在掩模mAP上分別高出4.09%,2.37%。本文算法相較于Mask R-CNN在預測框mAP上分別高出4.90%。

表6 不同算法分割數據對比

5 結論

提出了一種基于YOLACT++的檳榔檢測模型,對采集的檳榔圖像進行標注并采用數據增強方法擴增數據集。在主干網絡中引入改進的Res2Net模塊,加深了主干特征提取能力。并改進了邊界框回歸損失函數,進而改善了掩模分割效果。測試實驗結果表明,訓練出的模型在處理花蒂掉落、檳榔堆疊和復雜背景等情況下的檳榔圖片均有較好的檢測效果,訓練后的模型掩模分割效果優于Mask R-CNN、SOLOv2網絡,檳榔實例分割速度達到22.4幀/s,檳榔分級準確率提升了2.12%,滿足工業現場需求。對模型部分參數稍作修改仍可應用于其他工業生產線產品檢測,具有較高的應用價值。由于網絡的改進造成部分速度損失,后續工作將在保證網絡分割質量的前提下優化網絡結構,提升分割速度。