改進(jìn)RetinaNet特征融合方式的無人機(jī)檢測方法

馬田源,孫 涵

(南京航空航天大學(xué) 計算機(jī)科學(xué)與技術(shù)學(xué)院,江蘇 南京 211106)

0 引 言

近年來,隨著無人機(jī)制造成本和使用難度的不斷降低,無人機(jī)得以迅速應(yīng)用到各行各業(yè),普通人也可以很容易操控?zé)o人機(jī)。這給人們的生產(chǎn)和生活帶來了很大方便,但與此同時,無人機(jī)“黑飛”也給空中交通、公共安全等領(lǐng)域的監(jiān)管帶來了巨大挑戰(zhàn)。因此,作為無人機(jī)監(jiān)管的重要環(huán)節(jié),對無人機(jī)小目標(biāo)的檢測就成為了目前亟待解決的關(guān)鍵問題。

目前無人機(jī)檢測的方案有很多種,基于雷達(dá)、聲、無線電、光電設(shè)備等。這些利用無人機(jī)的物理屬性對無人機(jī)進(jìn)行定位的技術(shù)非常常見,但是這些檢測方案往往需要非常昂貴的設(shè)備和嚴(yán)格的配置。基于視覺的方法則成本較低,配置相對簡單,且易于部署。

而今,隨著深度學(xué)習(xí)技術(shù)的發(fā)展,其在計算機(jī)視覺領(lǐng)域取得了大量的突破,優(yōu)秀的工作不斷涌現(xiàn)出來,早期的工作例如Fast R-CNN[1]、Faster R-CNN[2]、YOLO[3]等,在各個通用數(shù)據(jù)集上均取得了不錯的成績。后來何愷明等人提出了特征金字塔融合網(wǎng)絡(luò)(Feature Pyramid Network,F(xiàn)PN)[4],該網(wǎng)絡(luò)由自底向上和自頂向下兩條通路以及一條橫向連接三部分構(gòu)成。首先,自底向上進(jìn)行特征提取;然后,橫向連接對齊通道數(shù)目;接著,自頂向下進(jìn)行特征融合;最后,得到具有多尺度特征的特征圖進(jìn)行預(yù)測。該方法通過將語義信息從深層傳播到淺層來實現(xiàn)多尺度的特征融合,使深層豐富的語義信息得以傳遞到淺層,解決了淺層語義信息缺失的問題,提高了網(wǎng)絡(luò)對不同尺度目標(biāo),尤其是對小目標(biāo)的檢測性能。因此FPN在各種通用的目標(biāo)檢測方法中普遍被采用,例如RetinaNet[5]、FCOS[6]等工作。然而,無人機(jī)小目標(biāo)與通用尺度的目標(biāo)不同,它尺度極小,通常占整張圖像的像素比低于0.1%,且小型無人機(jī)鏤空的外觀,使其與背景融為一體,特征極不明顯,檢測難度很高。

該文總結(jié)了FPN方法在無人機(jī)目標(biāo)檢測任務(wù)中表現(xiàn)不佳的三點原因:(1)原始FPN上采樣所使用的最近鄰插值法會造成特征偏移失真,這些偏移會對無人機(jī)小目標(biāo)檢測造成很大的影響;(2)無人機(jī)小目標(biāo)通常在網(wǎng)絡(luò)淺層被檢測出來,而網(wǎng)絡(luò)淺層特征的語義信息缺失問題導(dǎo)致網(wǎng)絡(luò)對小目標(biāo)檢測性能不佳。因此原始的FPN方法將深層的語義信息傳遞到淺層來緩解這個問題,但是在FPN的實際操作過程中,通道維度對齊的做法仍會產(chǎn)生大量通道信息衰減,造成深層語義信息向淺層傳遞不足的問題。對于更需要深層語義信息補充的無人機(jī)這類極小目標(biāo)來說,語義信息不足會產(chǎn)生更大的影響;(3)在FPN特征融合時,網(wǎng)絡(luò)最深層特征只有本層的語義信息,同其他層產(chǎn)生了語義差異,這種差異在一定程度上會影響后續(xù)的推理。

為了解決上述問題,基于RetinaNet提出了新的多尺度特征融合方式,具體貢獻(xiàn)如下:

(1)受到超分辨率領(lǐng)域中效果十分優(yōu)秀的像素洗牌(Pixel Shuffle,PS)[7]上采樣方式的啟發(fā),設(shè)計了像素洗牌上采樣模塊(Pixel Shuffle Unit,PSU),將其作為特征融合網(wǎng)絡(luò)中的上采樣方法,解決特征失真問題,并且使深層的語義信息得到充分利用。

(2)設(shè)計了像素洗牌特征融合網(wǎng)絡(luò) (Pixel Shuffle Feature Fusion,PSFF)。采用PSU改進(jìn)了上采樣方式,并且重構(gòu)了特征通道融合流程。降低了深層語義信息向淺層傳遞過程中的衰減,使深層的語義信息能夠有效地傳遞到淺層,進(jìn)而增強(qiáng)淺層無人機(jī)小目標(biāo)的特征表示。

(3)增加了深層語義增強(qiáng)模塊(High-level Semantic Enhancement,HSE)。在網(wǎng)絡(luò)深層追加特征提取模塊,使網(wǎng)絡(luò)可以提取到更深層的語義信息,提高網(wǎng)絡(luò)整體的特征提取能力,同時消除FPN最深層同其他層之間的語義差異。

實驗結(jié)果驗證,在自建蜂群無人機(jī)數(shù)據(jù)集上,與其他類似特征融合方式相比,提出的新特征融合方式具有明顯優(yōu)勢,基于RetinaNet的檢測效果提升了1.7%,精度達(dá)到了91.2%。

1 研究現(xiàn)狀

1.1 目標(biāo)檢測

通用目標(biāo)檢測方法主要分為兩個大方向:一是以Faster R-CNN[2]、Cascade R-CNN[8]、Grid R-CNN[9]、Sparse R-CNN[10]為代表的二階段目標(biāo)檢測方法。這類方法首先預(yù)測出目標(biāo)可能出現(xiàn)的候選區(qū)域(Region Proposal),再對該區(qū)域內(nèi)的目標(biāo)進(jìn)行目標(biāo)檢測和類別預(yù)測[11],這類方法精度相對較高,但是模型相對復(fù)雜,且推理速度較慢;二是以YOLO[3,12-13]系列、SSD[14-16]系列、RetinaNet為代表的一階段目標(biāo)檢測方法。這類方法沒有復(fù)雜的預(yù)測候選區(qū)域的過程,直接根據(jù)輸入圖像預(yù)測出目標(biāo)的類別和檢測框的位置,因此這類方法具有速度快、開銷低的優(yōu)點,但是檢測精度往往不如二階段檢測方法。

1.2 多尺度特征融合

為了應(yīng)對不同尺度的目標(biāo)檢測,何愷明等人首先提出了特征金字塔融合網(wǎng)絡(luò)FPN[4]。后續(xù)對FPN進(jìn)行改進(jìn)的多種多尺度特征融合方法相繼提出。例如PAFPN[17]采用雙向融合,在原有自頂向下融合的基礎(chǔ)上,增加了反向傳遞,縮短了淺層與深層特征之間的信息路徑,在一定程度上提高了信息的利用率,讓融合效率提高。NAS-FPN[18]在多尺度特征融合網(wǎng)絡(luò)中,將神經(jīng)網(wǎng)絡(luò)搜索出來的不規(guī)則拓?fù)浣Y(jié)構(gòu)作為融合網(wǎng)絡(luò),效果優(yōu)異,但訓(xùn)練成本極高。文獻(xiàn)[19]提出了HRFPN,使特征金字塔在進(jìn)行下采樣的過程中保留盡可能多的細(xì)節(jié)信息。BiFPN[20]中重復(fù)堆疊簡化的PAFPN,同時引入權(quán)重參數(shù),來平衡不同尺度的特征信息。文獻(xiàn)[21]在顯著性檢測領(lǐng)域提出了多尺度特征金字塔網(wǎng)格MFPG來豐富語義信息。

1.3 無人機(jī)目標(biāo)檢測

基于傳統(tǒng)方法的無人機(jī)檢測工作如下:文獻(xiàn)[22]采用基于卡爾曼模型的方法動態(tài)地對無人機(jī)進(jìn)行檢測和跟蹤。文獻(xiàn)[23]利用無人機(jī)本身的移動性、振動性、空間性這三個本身的物理特性來發(fā)現(xiàn)并定位無人機(jī)。基于深度學(xué)習(xí)的無人機(jī)檢測工作如下:文獻(xiàn)[24]在YOLOv3中引入多尺度的特征圖融合方法,以此提升無人機(jī)檢測精度。文獻(xiàn)[25]基于RetinaNet構(gòu)建了無人機(jī)目標(biāo)檢測網(wǎng)絡(luò),對多旋翼無人機(jī)進(jìn)行檢測識別,取得了較好的效果。文獻(xiàn)[26]基于SSD,將高層的特征引入到淺層,以此增強(qiáng)淺層無人機(jī)小目標(biāo)的特征表示,來提高網(wǎng)絡(luò)對無人機(jī)的檢測效果。文獻(xiàn)[27]受到人臉檢測方法的啟發(fā),設(shè)計了輕量級迭代的無人機(jī)檢測網(wǎng)絡(luò)TIB-Net,取得了不錯的檢測效果。

2 模型和方法

2.1 網(wǎng)絡(luò)整體框架

原始RetinaNet[5]在采用FPN的基礎(chǔ)之上,又引入聚焦損失Focal Loss的概念,解決了類不平衡問題,提高了一階段目標(biāo)檢測方法的精度,同時也保持了較高的檢測速度。其網(wǎng)絡(luò)由三個主要部分構(gòu)成:一是特征提取的主干網(wǎng)絡(luò);二是多尺度特征融合網(wǎng)絡(luò);三是分類和邊界框回歸的檢測網(wǎng)絡(luò)。因為該方法具有較高的檢測速度,且結(jié)構(gòu)清晰易于擴(kuò)展,對小目標(biāo)有較好的檢測效果,所以該文采用該框架作為基本的檢測框架。

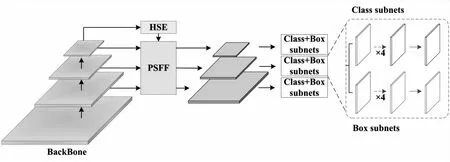

總體結(jié)構(gòu)如圖1所示。框架基于RetinaNet,該文重新設(shè)計了新的多尺度特征融合方法。其中Backbone部分采用ResNet50[28]進(jìn)行自底向上的特征提取。多尺度特征融合部分采用像素洗牌融合網(wǎng)絡(luò)PSFF進(jìn)行自頂向下的多尺度特征融合,深層語義增強(qiáng)模塊HSE繼續(xù)提取更深層次的語義信息,并且注入到PSFF中,讓深層的語義信息可以更有效地傳遞到淺層。最后為兩個FCN全卷積網(wǎng)絡(luò)(Fully Convolutional Networks,F(xiàn)CN)[29]分類分支和檢測框回歸分支。

圖1 總體結(jié)構(gòu)

2.2 基于像素洗牌的特征融合網(wǎng)絡(luò)PSFF

原始FPN網(wǎng)絡(luò)在自底向上的通路中,隨著網(wǎng)絡(luò)的不斷加深,特征通道數(shù)會逐層增加,特征圖尺寸會逐層減小。在網(wǎng)絡(luò)的最深層,通道數(shù)量最多。例如ResNet50的{C2,C3,C4,C5}特征層分別對應(yīng){256,512,1 024,2 048}個特征通道,最深層的C5通道數(shù)量為2 048包含最豐富的語義信息。在橫向連接中,由于特征融合需要對齊特征維度,所以該步驟將得到的特征層的通道維數(shù)統(tǒng)一壓縮到256。在自頂向下的通路中,從頂層開始,進(jìn)行2倍最近鄰上采樣的同時,與橫向連接對齊通道數(shù)量的特征層進(jìn)行特征融合。

可見,原始FPN上采樣的過程造成了特征失真;在進(jìn)行橫向連接時將所有層的通道維數(shù)統(tǒng)一壓縮到256再進(jìn)行自頂向下的特征融合的做法,造成了深層特征沒有充分地傳遞到淺層的問題;最深層特征F5直接來自C5層,沒有融合其他層的特征,只具備一層的語義信息,造成了深層同其他層之間的語義差異。

考慮以上因素,該文對特征融合網(wǎng)絡(luò)進(jìn)行了重新設(shè)計,其中包括兩大塊:其一,使用像素洗牌上采樣模塊PSU構(gòu)造了像素洗牌特征融合網(wǎng)絡(luò)PSFF。該網(wǎng)絡(luò)既解決了原始FPN上采樣方法的缺陷,又可以讓深層特征充分地參與到向淺層傳遞的過程中去,使深層語義信息更有效地傳遞到淺層,以此提升淺層小目標(biāo)的特征表示。其二,引入深層語義增強(qiáng)模塊HSE,既解決深層語義差異問題,又可以提取更深層的語義信息,提高網(wǎng)絡(luò)整體的特征提取能力。

為此,該文首先引入深層語義增強(qiáng)模塊HSE,來補充深層缺失的語義信息;接著,采用像素洗牌上采樣模塊PSU,利用深層大量的通道信息進(jìn)行上采樣,在完成上采樣的同時,將特征的維度信息轉(zhuǎn)化到空間尺度信息中去,以此將深層的語義信息由低分辨率的特征圖帶入到高分辨率特征圖,既對齊了維度又對齊了尺度;然后,進(jìn)行逐像素相加和,即特征融合;最后進(jìn)行去除混疊和通道壓縮。具體實現(xiàn)如圖2所示,其中{C3,C4,C5}為來自主干網(wǎng)絡(luò)Backbone也就是ResNet50特征提取網(wǎng)絡(luò)的第3、第4和第5層的特征,{F3,F(xiàn)4,F(xiàn)5}為對應(yīng)的輸出。PSU為像素洗牌上采樣模塊。C5*為深層語義增強(qiáng)模塊HSE的輸出,Conv-3×3用來去除混疊效應(yīng)。圖中“64x”代表相對于原始網(wǎng)絡(luò)輸入圖像下采樣64倍的尺度,“64x->32x”代表該過程圖像尺度由64x上采樣到32x,“2 048->256”表示通道數(shù)從2 048變?yōu)?56。“⊕”表示特征圖之間逐像素相加。

圖2 像素洗牌特征融合網(wǎng)絡(luò)PSFF

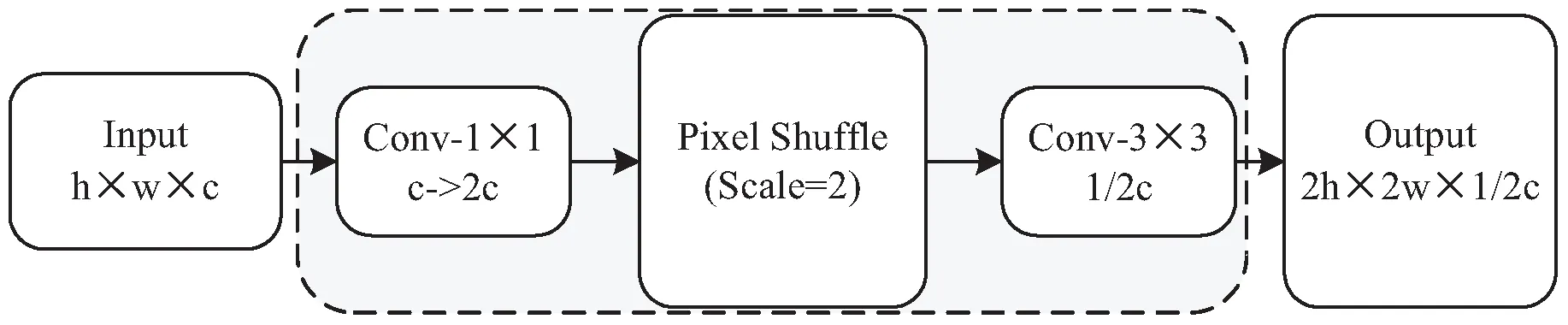

2.3 像素洗牌上采樣模塊PSU

原始的特征金字塔融合網(wǎng)絡(luò)FPN采用最近鄰插值的上采樣法,該方法在上采樣的過程中使用鄰近像素值進(jìn)行填充,簡單且不需要復(fù)雜計算。但該方法在計算上采樣圖像像素點對應(yīng)位置時,對非整數(shù)的計算結(jié)果直接向下取整的做法會造成像素偏移,使某一區(qū)域的像素值相同,讓像素變化不連續(xù),產(chǎn)生鋸齒狀失真。考慮以上因素,該文采用了像素洗牌[7]上采樣方法,該方法具有高效、快速、無參的特性,更重要的是,它可以充分利用主干網(wǎng)絡(luò)最深層大量的通道信息,將其作為像素洗牌所需的像素信息,進(jìn)行像素洗牌的上采樣。簡言之,就是可以把通道維度信息轉(zhuǎn)換成空間信息保留下來。如此,不僅避免了簡單最近鄰差值特征失真的缺陷,還可以最大程度地讓深層豐富的語義信息傳遞到淺層,讓淺層獲得到更加豐富的深層語義信息,提升淺層無人機(jī)小目標(biāo)特征表示,進(jìn)而提升網(wǎng)絡(luò)對無人機(jī)小目標(biāo)的檢測性能。

圖3 像素洗牌上采樣原理PS

將該做法整理為公式(1),其中PS代表Pixel Shuffle,是像素洗牌英文名簡稱,默認(rèn)擴(kuò)張因子(Scale)為2,代表使用像素洗牌方法進(jìn)行2倍上采樣,其中輸入為x'∈Rh×w×4c其通道數(shù)量為4c,輸出為y'∈R2w×2h×c其通道數(shù)量為c,在這個過程中通道數(shù)由4c減少到c,圖像尺寸由h×w擴(kuò)增到2h×2w。

直觀來看,可以在原始FPN方法的基礎(chǔ)上直接替換上采樣方式。首先,將統(tǒng)一壓縮到256維的特征進(jìn)行4倍通道擴(kuò)增;接著,采用像素洗牌上采樣,通道數(shù)還原為256;最后,與上層特征進(jìn)行融合。以上作法雖然解決了原始FPN上采樣特征失真問題,但是并沒有解決深層特征大量丟失的問題。因為橫向連接的過程特征首先被統(tǒng)一壓縮到256維,這一造成深層特征大量丟失問題的根源,沒有被改變。所以該文未予采用。

圖4 像素洗牌上采樣模塊PSU

y'=PS(x')

(1)

y=Conv-3×3(PS(Conv-1×1(x)))

(2)

2.4 深層語義增強(qiáng)模塊HSE

在原始的FPN中,融合后網(wǎng)絡(luò)的最深層F5層僅包含它本層一個尺度的語義信息,而其他層則融合了多層語義信息,同其他層之間產(chǎn)生了語義差異。對此,該文設(shè)計了深層語義增強(qiáng)模塊HSE,旨在向F5中注入更深層次的語義信息,消除該層同其他層之間的語義差異問題,同時提高網(wǎng)絡(luò)整體的特征提取能力。

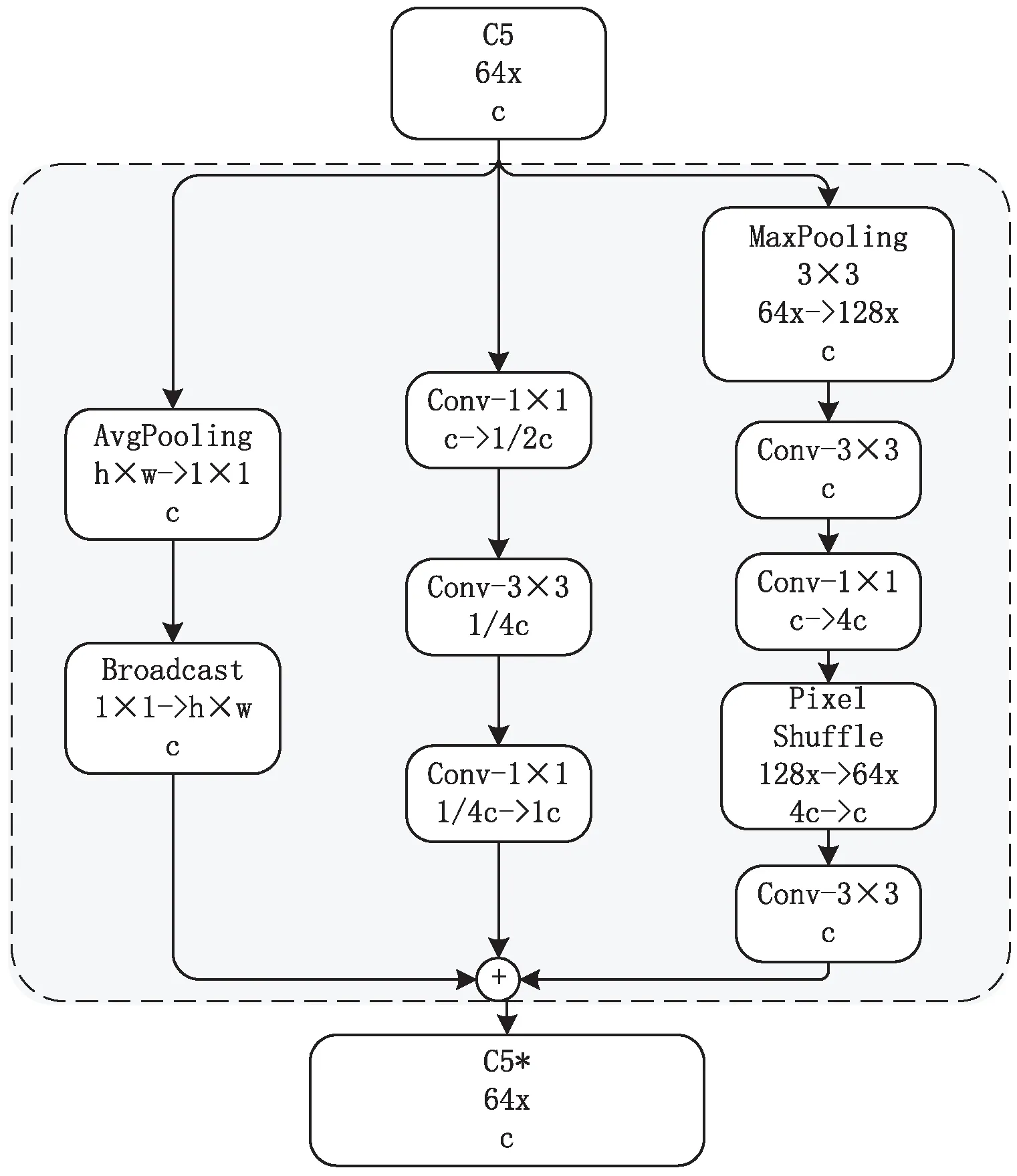

HSE具體流程如圖5所示,采用并行分支結(jié)構(gòu)。第一個分支首先進(jìn)行全局平均值池化,接著用廣播的形式還原特征尺度,以獲取全局信息;第二個分支采用瓶頸結(jié)構(gòu)結(jié)合3×3卷積獲取局部信息;第三個分支利用最大值池化進(jìn)行下采樣,結(jié)合3×3卷積,然后用1×1卷積進(jìn)行通道維度擴(kuò)增,再通過像素洗牌還原特征尺度,以再次增大感受野來獲取更豐富的語義信息。

圖5 深層語義增強(qiáng)模塊HSE

最后HSE模塊以殘差形式加入特征融合網(wǎng)絡(luò),防止網(wǎng)絡(luò)退化。在特征融合網(wǎng)絡(luò)中引入該深層語義增強(qiáng)模塊,首先消除了最后一層F5與其他層之間的語義差異;其次,在層內(nèi)形成了多層級的特征提取,提高了網(wǎng)絡(luò)整體的特征提取能力;最終為自頂向下的特征融合過程提供了更加豐富的深層語義信息。因此使淺層小目標(biāo)可以獲得更多深層的語義信息,進(jìn)而提升網(wǎng)絡(luò)對無人機(jī)小目標(biāo)的特征提取能力。

2.5 損失函數(shù)

在訓(xùn)練設(shè)置部分,模型的損失是兩個部分損失的加和,第一部分為回歸子網(wǎng)絡(luò)的檢測框回歸損失,采用標(biāo)準(zhǔn)的Smooth L1 Loss損失;第二部分為分類子網(wǎng)絡(luò)的分類損失,采用帶平衡因子的聚焦損失(Focal Loss)[5],其形式如公式(3)。

FL(pt)=-αt(1-pt)γlog(pt)

(3)

FL代表Focal Loss,其中αt為正負(fù)樣本的加權(quán)平衡參數(shù),值越大正樣本的權(quán)重越大,這里設(shè)置為0.25。γ為聚焦系數(shù),控制樣本權(quán)重更新速率,是一個大于0的超參數(shù),該文設(shè)置為2。pt表示樣本屬于正樣本的概率,(1-pt)γ是權(quán)重表達(dá)式。以上超參數(shù)設(shè)置均來自RetinaNet[5]原文。

Focal Loss聚焦損失函數(shù)就是給簡單樣本和困難樣本分別加上一組權(quán)重系數(shù)。這個系數(shù)跟模型預(yù)測的樣本屬于真實類別的概率相關(guān)。對于簡單樣本,如果模型預(yù)測該樣本屬于真實類別的概率很大,那該樣本對于模型來說就是簡單樣本,此時的pt接近于1,權(quán)重系數(shù)接近于0,如此就會降低簡單樣本的損失權(quán)重。對于困難樣本,如果模型預(yù)測某樣本屬于真實樣本的概率很小(也可以說這很可能是錯誤分類),那么該樣本對于模型來講就屬于困難樣本,此時的pt很小,權(quán)重系數(shù)接近于1,如此就會讓困難樣本的損失得以最大限度地保留。無人機(jī)小目標(biāo)尺度小、特征少、區(qū)分度不高導(dǎo)致其難以識別,對于網(wǎng)絡(luò)來說屬于困難樣本。而聚焦損失又能夠讓網(wǎng)絡(luò)聚焦于困難樣本,因此采用該損失函數(shù),有利于網(wǎng)絡(luò)學(xué)習(xí)無人機(jī)小目標(biāo)的特征,提高對無人機(jī)小目標(biāo)的檢測性能。

3 實驗過程與結(jié)果

3.1 數(shù)據(jù)集描述

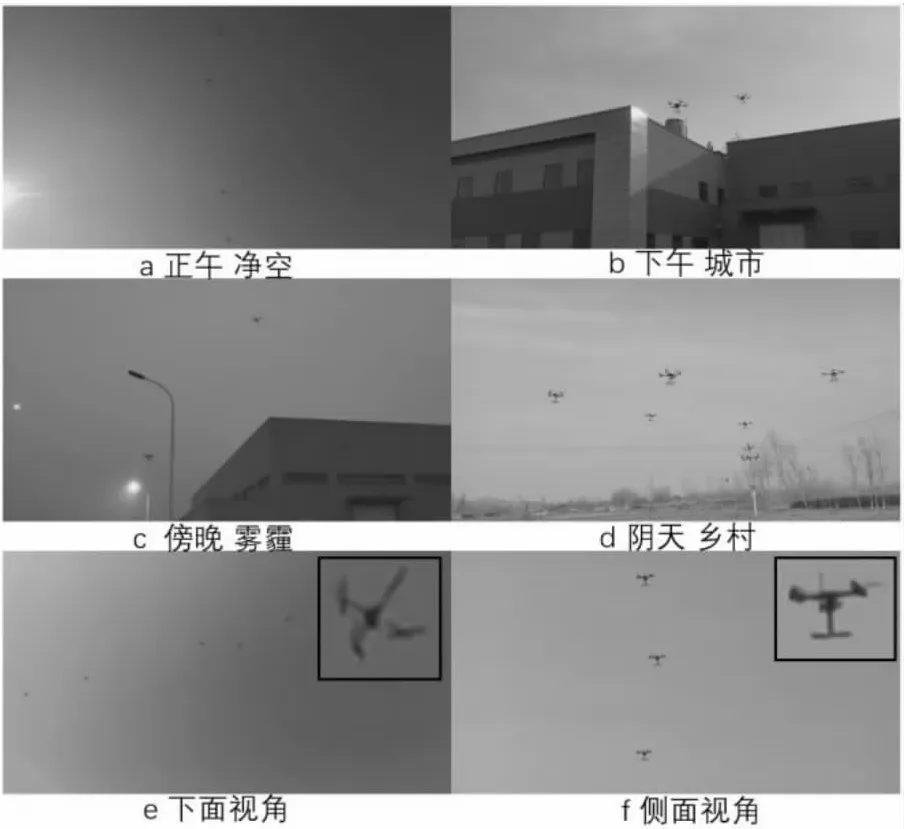

實驗采用自建的蜂群無人機(jī)數(shù)據(jù)集。以往的無人機(jī)數(shù)據(jù)集都是單架次的,即每張圖像中只存在一個無人機(jī)目標(biāo)。但真實場景中會有多架無人機(jī)同時出現(xiàn)的情況,目前還沒有這類公開的數(shù)據(jù)集。而在圖像中剪切粘貼很多架次無人機(jī),這種方式生成的無人機(jī)群數(shù)據(jù)集又有失樣本的真實性。因此本次研究專門采集了真實的無人機(jī)群數(shù)據(jù),并且為保證數(shù)據(jù)的多樣性,涵蓋了不同天氣條件、不同時間段、不同地點、不同距離以及不同視角的數(shù)據(jù)。如圖6,其中(a,b,c)分別為晴天、陰天、霧霾天,(a,b,c)分別為中午、下午和傍晚,(b/c,d,a/e/f)分別為城市、鄉(xiāng)村、凈空,(a/e/f,b/c/d)分別為遠(yuǎn)距離和近距離圖像,(e,f)分別為下面視角和側(cè)面視角,且以上每個場景關(guān)注的空域中都有包含1~10架次無人機(jī)的無人機(jī)編隊。所有數(shù)據(jù)均通過手持?jǐn)z像頭和固定機(jī)位的云臺攝像頭以視頻形式采集,然后抽幀獲得,最后對其中2 843張圖像進(jìn)行標(biāo)注,標(biāo)注采用VOC數(shù)據(jù)集[30]的標(biāo)注格式。

圖6 數(shù)據(jù)集中多場景無人機(jī)樣本

3.2 訓(xùn)練過程

實驗環(huán)境如下:Ubuntu20.04 LTS系統(tǒng)、Intel i9-9900KCPU×16、內(nèi)存為64 GB、兩張NVIDIA 2080Ti顯卡(12 GB 顯存) 、Pytorch1.7.1、CUDA10.2、CUDNN7.6.5,實驗采用的預(yù)訓(xùn)練模型是由Pytorch官方提供的在Imagenet上進(jìn)行了預(yù)訓(xùn)練的模型。

為公平起見,所有的實驗結(jié)果都是基于以下訓(xùn)練參數(shù):迭代次數(shù)為12、動量為0.9、批大小為4、初始學(xué)習(xí)率為0.000 5、每訓(xùn)練4個epoch權(quán)重衰減為原來的0.3倍。為了降低模型計算開銷,所有圖像在送入模型前尺寸都被統(tǒng)一調(diào)整為1 333×800。

對于RetinaNet,主干網(wǎng)絡(luò)全部采用ResNet50作為特征提取網(wǎng)絡(luò),其余配置與RetinaNet原文配置相同。

3.3 實驗結(jié)果

3.3.1 評估指標(biāo)

為了評價該方法的有效性,該文采用VOC[30]數(shù)據(jù)集的評價指標(biāo),使用mAP (mean Average Precision)來評價檢測器的性能。mAP是由精確率和召回率得到的。其計算公式如公式(4)和公式(5):

(4)

(5)

其中,p(Precision)表示精確率、r(Recall)表示召回率,AP (Average Precision)表示平均精度,是計算在不同召回率下精度的平均值,N表示類別數(shù)目,由于該文無人機(jī)檢測任務(wù)目標(biāo)類別數(shù)為1,因此這里的N值設(shè)為1。

3.3.2 實 驗

為驗證該方法的有效性,表1展示了模塊消融實驗。分別使用深層語義增強(qiáng)模塊HSE和像素洗牌融合網(wǎng)絡(luò)PSFF。可以看出在只引入深層語義增強(qiáng)模塊HSE時模型性能提升0.7%,只引入像素洗牌融合網(wǎng)絡(luò)PSFF時,模型性能提升0.9%,在兩者都加入網(wǎng)絡(luò)時,模型精度提升到91.2%,提升了1.7%。

表1 模塊消融實驗

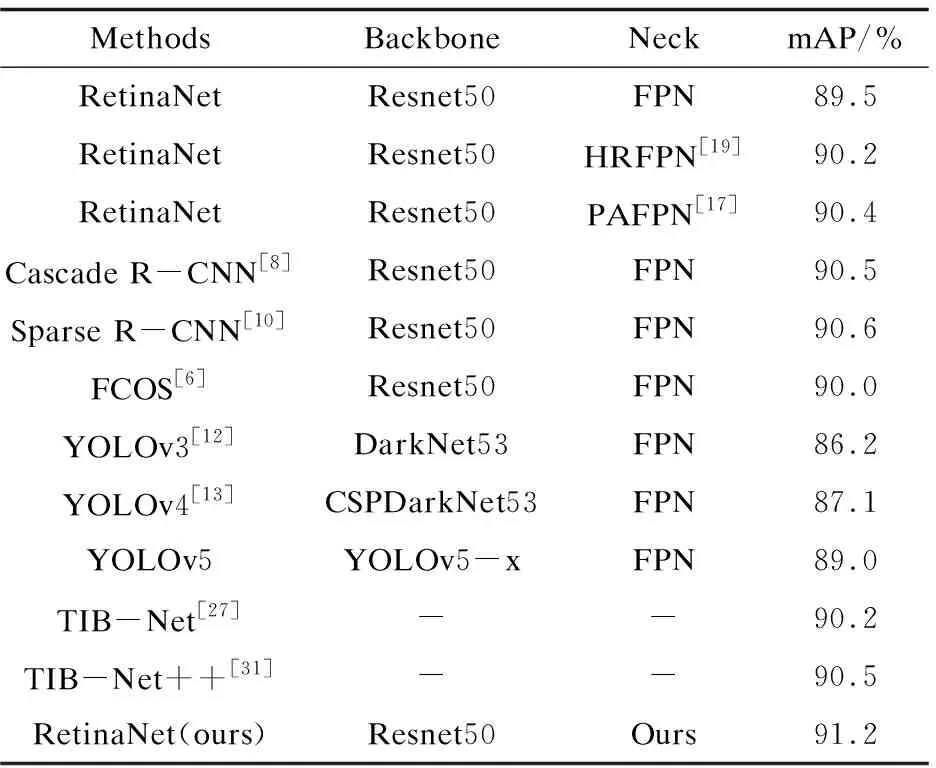

如表2所示,其中Neck表示該方法的多尺度特征融合部分,Backbone表示主干網(wǎng)絡(luò)部分。第1行為基準(zhǔn)實驗,第2、3行分別為使用HRFPN和PAFPN特征融合方法的實驗結(jié)果,最后一行中的Ours代表該文提出的多尺度特征融合方法。可以看出,同其他特征融合方法相比,使用該文提出的新的特征融合方式具有更好的結(jié)果,對無人機(jī)小目標(biāo)檢測的精度更高。

表2 對比實驗

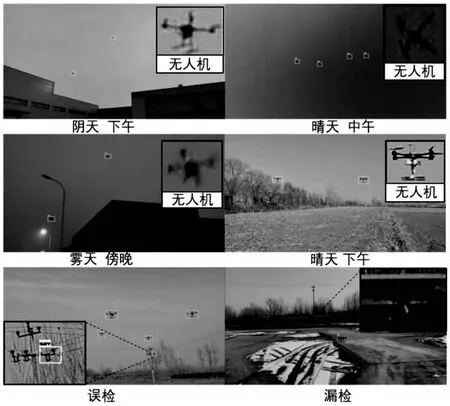

另外,該文也與使用其他方法進(jìn)行無人機(jī)檢測的方法進(jìn)行對比。這里由于缺乏公開的代碼,使用當(dāng)前最優(yōu)秀的通用目標(biāo)檢測方法進(jìn)行對比實驗。表2下半部分展示的對比實驗包括:二階段的方法Cascade R-CNN、Sparse R-CNN,一階段的方法FCOS、不同版本的YOLO,同樣專門進(jìn)行無人機(jī)檢測的TIB-Net、TIB-Net的改進(jìn)方法(表2中的TIB-Net++)。從結(jié)果上看,文中方法都優(yōu)于它們。為了展示模型的性能,圖7將部分場景的檢測結(jié)果進(jìn)行展示,其中右上角為圖中無人機(jī)目標(biāo)的放大圖。可以看出,RetinaNet在引入該文提出的新特征融合方式之后,能夠在不同場景、不同天氣、不同光照條件下得到較好的檢測結(jié)果,網(wǎng)絡(luò)具有魯棒性,并且檢測結(jié)果十分精準(zhǔn)。

新的特征融合方法在特征融合的過程中緩解了上采樣造成的失真、深層語義信息衰減以及深層語義差異問題。所以,網(wǎng)絡(luò)可以提取到更加豐富的語義信息,并且深層的語義信息可以更好地豐富淺層小目標(biāo)的特征表示。因此,該網(wǎng)絡(luò)模型可以根據(jù)無人機(jī)所處的背景調(diào)整其置信度,有效地過濾掉一些不合理的誤檢情況,進(jìn)而提升無人機(jī)小目標(biāo)在各種場景的檢測性能。

對于檢測失敗的情況,例如,圖7誤檢中誤將電線桿的一部分誤檢為無人機(jī),從展示的放大細(xì)節(jié)來看,電線桿支架部分的外觀同無人機(jī)確實十分接近,所以網(wǎng)絡(luò)將其誤檢為無人機(jī)目標(biāo)。圖7漏檢中,漏檢了一架無人機(jī),原因可能是該無人機(jī)由于距離較遠(yuǎn),且與背景墻的顏色和線條較為接近,導(dǎo)致漏檢。對于這類背景十分復(fù)雜的情況,網(wǎng)絡(luò)的檢測效果仍有待提高。

圖7 檢測結(jié)果

4 結(jié)束語

基于RetinaNet,根據(jù)無人機(jī)小目標(biāo)的特點進(jìn)行了有針對性地改進(jìn)。首先,通過引入深層語義增強(qiáng)模塊HSE,解決深層語義差異問題,同時又能提高網(wǎng)絡(luò)整體的特征提取能力;接著,基于像素洗牌上采樣模塊PSU設(shè)計了像素洗牌特征融合網(wǎng)絡(luò)PSFF,改進(jìn)了上采樣方式造成特征失真的問題,使網(wǎng)絡(luò)能夠?qū)⑸顚拥恼Z義信息更有效地向淺層傳遞,以此增強(qiáng)淺層小目標(biāo)的特征表示;最后,在自建蜂群無人機(jī)數(shù)據(jù)集上進(jìn)行實驗,驗證了提出的方法可以提升無人機(jī)小目標(biāo)的檢測效果。

對于接下來的工作,準(zhǔn)備從目標(biāo)之間的關(guān)系入手,嘗試建立無人機(jī)與背景之間、無人機(jī)群之間的關(guān)聯(lián)性,以此解決復(fù)雜場景中漏檢和誤檢的問題。