仿人表情機器人情感表達技術研究綜述

何 苗,畢 健,王玉金,殷 勤

(重慶理工大學 機械工程學院, 重慶 400054)

0 引言

仿人表情機器人具有逼真的類人外觀和表情行為,能夠實現人機情感交互,在社會生活各領域扮演著重要角色,應用前景廣闊。仿人機器人情感表達技術是機器人與人工智能研究領域中的熱點話題之一,也是人機交互領域的一項前沿技術。

本文在分析與總結仿人表情機器人的國內外研究歷程的基礎上,重點對仿人表情機器人的結構設計與情感控制兩個方面進行了綜述,并對仿人表情機器人情感表達技術作出展望。

1 研究歷程

日本和歐美國家對仿人表情機器人的研究開展得較早,不僅在機構設計、皮膚制作和控制算法方面取得了進展,還對仿人表情機器人的心理模型、學習能力、認知能力等方面進行了研究。隨著機器人技術的不斷發展,越來越多的國家投入到仿人表情機器人的研究之中。國內的表情機器人研究近20年發展迅速,取得了卓越成績,產生了許多有代表性的機器人,如H&F robot系列[1-4]和SHFR系列[5-8]表情機器人。

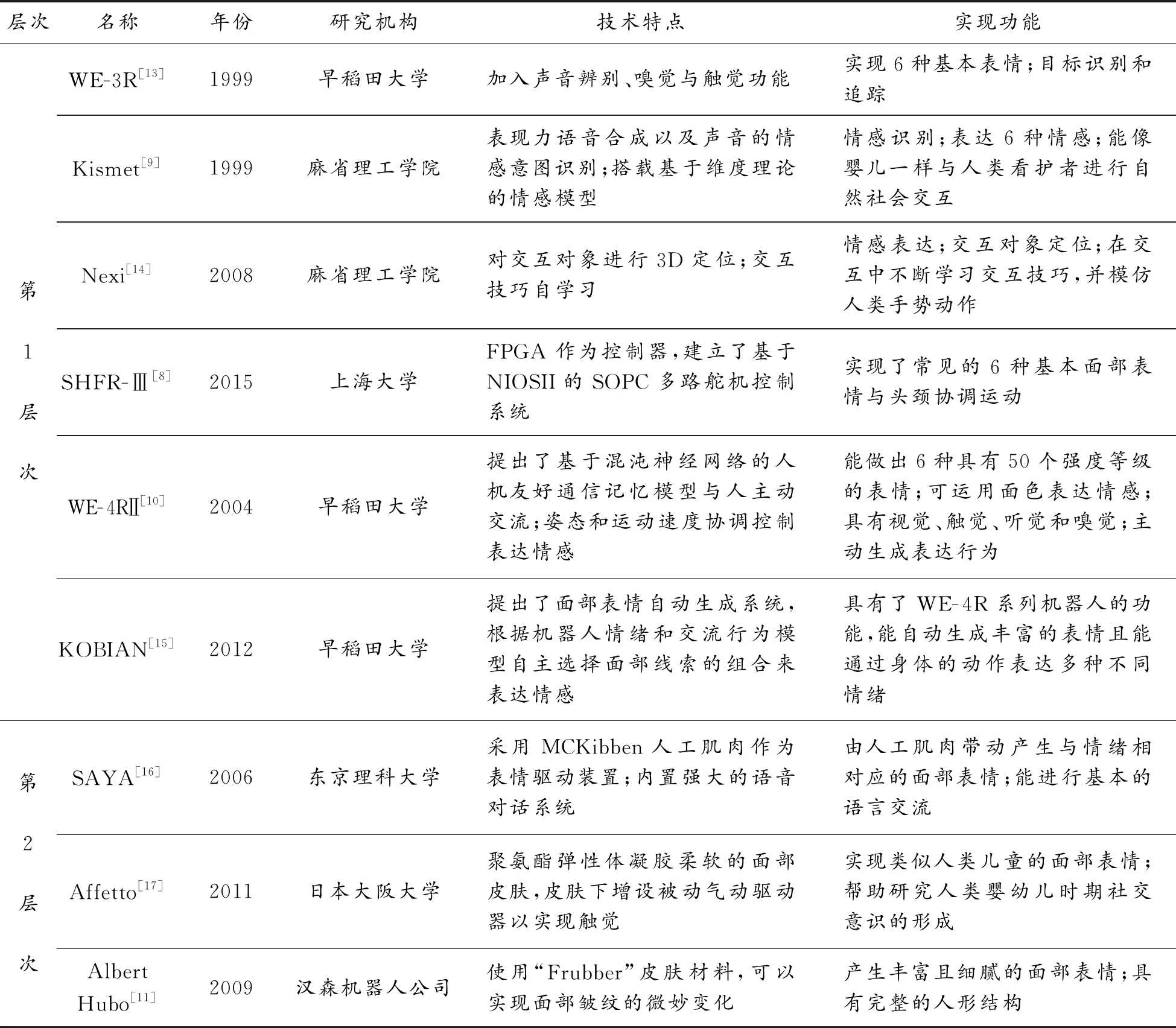

根據表情實現效果與情感表達能力,可將現有仿人表情機器人劃分為3個層次,如圖1所示。其中,第1層次的仿人表情機器人初步具備類人外觀,能產生6種基本表情,并具備簡單的交互功能,這里面具有代表性的表情機器人有Kismet[9]、SHFR-Ⅲ[8]、WE- 4RⅡ[10]等。第2層次的表情機器人的仿人外觀進一步提升,能產生更加豐富的表情動作,特別是仿真皮膚“Frubber”[11]的應用使表情機器人可以實現面部皺紋的微妙變化,情感表達功能更為豐富。部分表情機器人還被用于心理疾病治療,如用于治療自閉癥的表情機器人Alice[12]。第3層次的表情機器人外形逼真,表情細膩,搭載了較完善的情感模型,能與人進行更自然的情感交互,典型代表有仿人表情機器人Sophia。她還是全球第1個被賦予公民身份的機器人。

圖1 仿人表情機器人研究歷程

為進一步探究仿人表情機器人的研究趨勢,表1對3個層次里具有代表性的仿人表情機器人的技術特點與實現功能進行了詳細分析與對比。

表1 國內外代表性表情機器人的技術特點與實現功能

續表(表1)

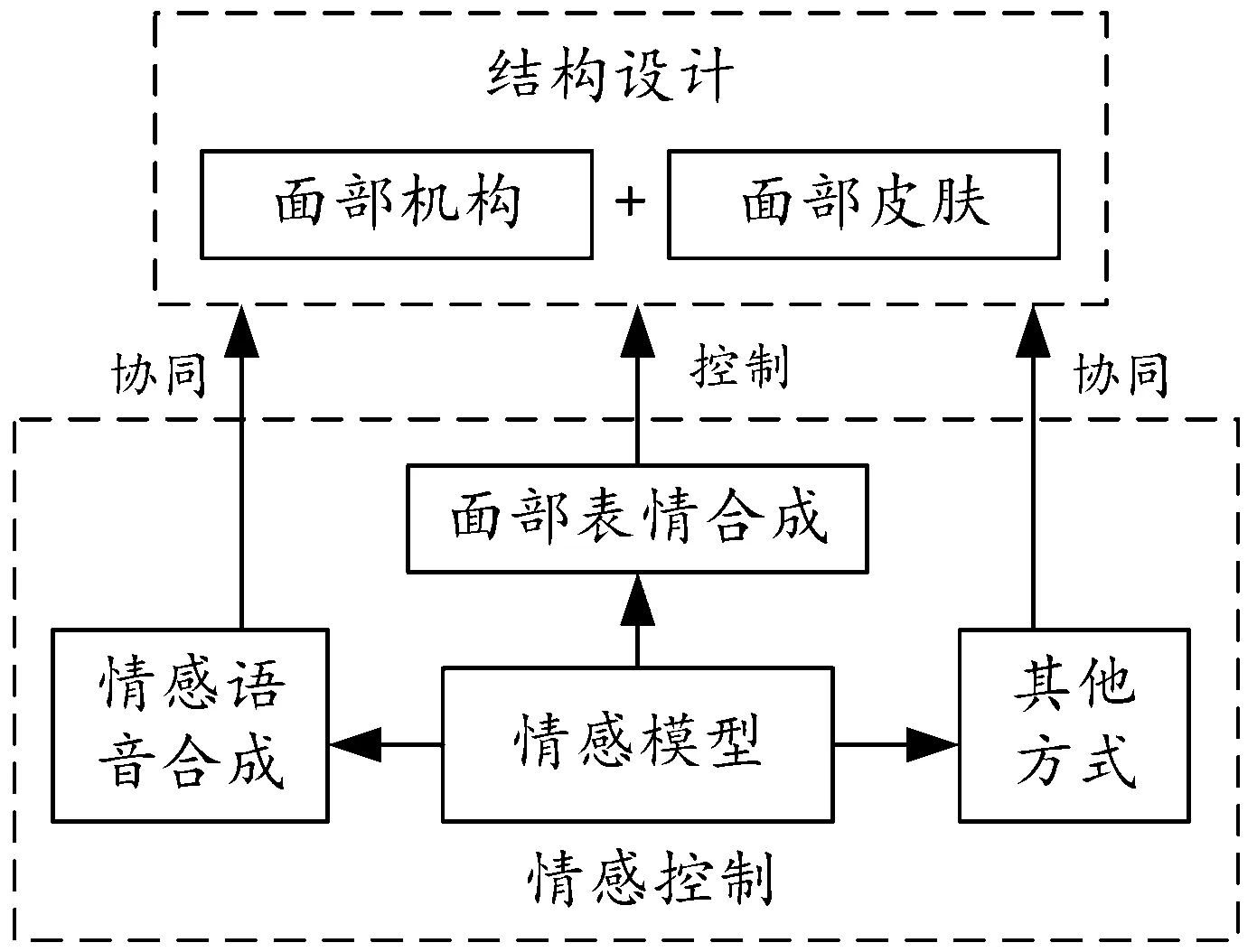

從上述分析可以看出,仿人表情機器人的情感表達能力主要取決于結構設計與情感控制。結構設計主要集中于機器人面部,情感控制則集中于機器人情感建模與情感表達方式控制。總體來看,仿人表情機器人的情感表達系統示意圖見圖2。

圖2 仿人表情機器人情感表達系統示意圖

2 面部結構設計

仿人表情機器人的情感表達以面部作為核心表現形式,面部結構以面部行為編碼系統(facial action coding system,FACS)[23]為理論基礎開展設計,具體分為兩部分內容:面部機構設計與機器人皮膚設計。

2.1 面部行為編碼系統

目前,最常用的表情劃分方法是將其分成7類基本表情,即自然(無表情)、高興、悲傷、驚奇、恐懼、憤怒與厭惡。FACS將人臉面部劃分成46個運動單元(action unit,AU),每個AU由1塊或多塊肌肉組織組成。在FACS中,有24個AU與面部表情相關,而與基本表情相關的只有14個AU。表2列出了6種基本表情(“自然”表情除外)與AU之間的關系[24-25]。

表2 基本表情與AU的關系

2.2 面部機構設計

現有的仿人表情機器人的面部機構設計大多是利用FACS在機器人面部合理設置控制點位置及其運動方向(如圖3所示),并在有限空間中設計精巧的機械結構以靈活控制機器人眼部、嘴部和臉頰等部位運動或形變,進而產生表情動作。另外,仿人表情機器人的設計不僅需要精巧的結構,還需要柔順協調的控制算法、美觀且盡可能逼真的類人外觀,避免陷入“恐怖谷”。恐怖谷理論可以用圖4表示[26],圖中橫軸表示機器人與人類的相似度,縱軸表示人類對機器人的好感度。在恐怖谷的區間內,機器人在動態時比靜態時的恐怖感更強。

圖3 面部控制點的位置及其運動方向設置

圖4 恐怖谷理論示意圖

從技術復雜度來看,仿人表情機器人的機構設計可分為純機械式與仿人皮膚式2種。純機械式相對于仿人皮膚式設計更加簡單,無需考慮柔性皮膚控制問題,各柔性單元均被機械化,但逼真效果不如仿人皮膚式。典型代表有日本的“WE”系列機器人[27],如圖5(a)所示。仿人皮膚式即機器人設計人造皮膚以達到逼真的仿人面部效果,如圖5(b)所示的PKD機器人[21]。這也是目前大多數仿人表情機器人所采用的方案,除眼球外的其他部位均與柔性皮膚上的表情控制點相連,表情控制的關鍵在于面部皮膚的柔性控制。這種方案不僅對內部機構設計要求更加嚴苛,也對控制方式提出了更高要求。

圖5 典型仿人表情機器人

人臉表情大部分動作來源于面部皮膚的運動。對于仿人表情機器人面部皮膚的控制,研究者們針對不同機構的設計方案研制了諸多具有代表性的面部表情驅動方式,使仿人表情機器人能產生更加自然的類人表情。機器人SAYA的表情由MCKibben型氣動執行器進行驅動[16]。該執行器由氣囊和外部的尼龍纖維編織網外殼組成,如圖6(a)所示。當氣囊內部氣壓升高時,由于編織網殼中尼龍纖維的不可延展性,致動器會根據其體積增加而縮短,使外部的尼龍線剛性體產生驅動位移。這種表情驅動裝置質量輕、體積小、運動靈活,可以像人類肌肉一樣分布在機器人面部表殼,如圖6(b)所示。

圖6 SAYA表情驅動裝置

H&F robot-Ⅲ采用電機與繩索相結合的驅動方式控制表情,其機構原理如圖7所示。其中,舵機6控制繩輪7轉動,繩索4隨繩輪轉動而帶動滑塊2移動,而滑塊在導向槽9內往復運動實現對表情控制點的位移控制[28]。該機構結構簡單,集成度高,動作控制平穩,傳遞效率高。

圖7 H&F robot-Ⅲ面部表情驅動裝置機構原理示意圖

2.3 皮膚研究

表情機器人擁有高仿真和高彈性的仿人面部皮膚材料是模擬逼真機器人表情的基礎。現有大多數表情機器人的面部皮膚材料采用的都是加工性能良好、易成型的硅橡膠。簡易的硅膠皮膚制作流程如圖8所示,這種硅膠皮膚的制作工藝簡單,但效果一般[29]。逼真的機器人皮膚則需要更為復雜的制作工藝。鄒人倜以自身形象制作的機器人,其皮膚可呈現汗毛、皺紋、斑痣等細節[30],但面部動作有限。漢森機器人技術公司利用海綿狀人造橡膠與泡沫的混合物研制出了“Frubber”皮膚材料[11],并應用在了Albert Hubo、PKD等機器人身上。該款仿真皮膚逼真度高且能夠實現較為自然的皮膚褶皺,同時能在面部驅動器的作用下作出更加精細的表情,仿真度極大提升。

圖8 硅膠皮膚制作

人類皮膚具有靈敏的觸覺功能,用于機器人觸覺感知的電子皮膚的研究也一直備受關注[31-33]。通過觸覺電子皮膚的設計,機器人能夠辨別交互對象對它進行的是撫摸還是按壓、打擊等行為,進而可以從一個新的維度去分析交互對象情感。

3 仿人表情機器人情感控制

仿人表情機器人的情感來源于人為建立的情感模型。情感模型決定不同時刻機器人的情緒狀態,不同的情緒則對應這不同的情感表達方式下的不同表現形式。現有的仿人表情機器人的情感表達方式則主要為面部表情合成和情感語音合成。

3.1 機器人情感模型

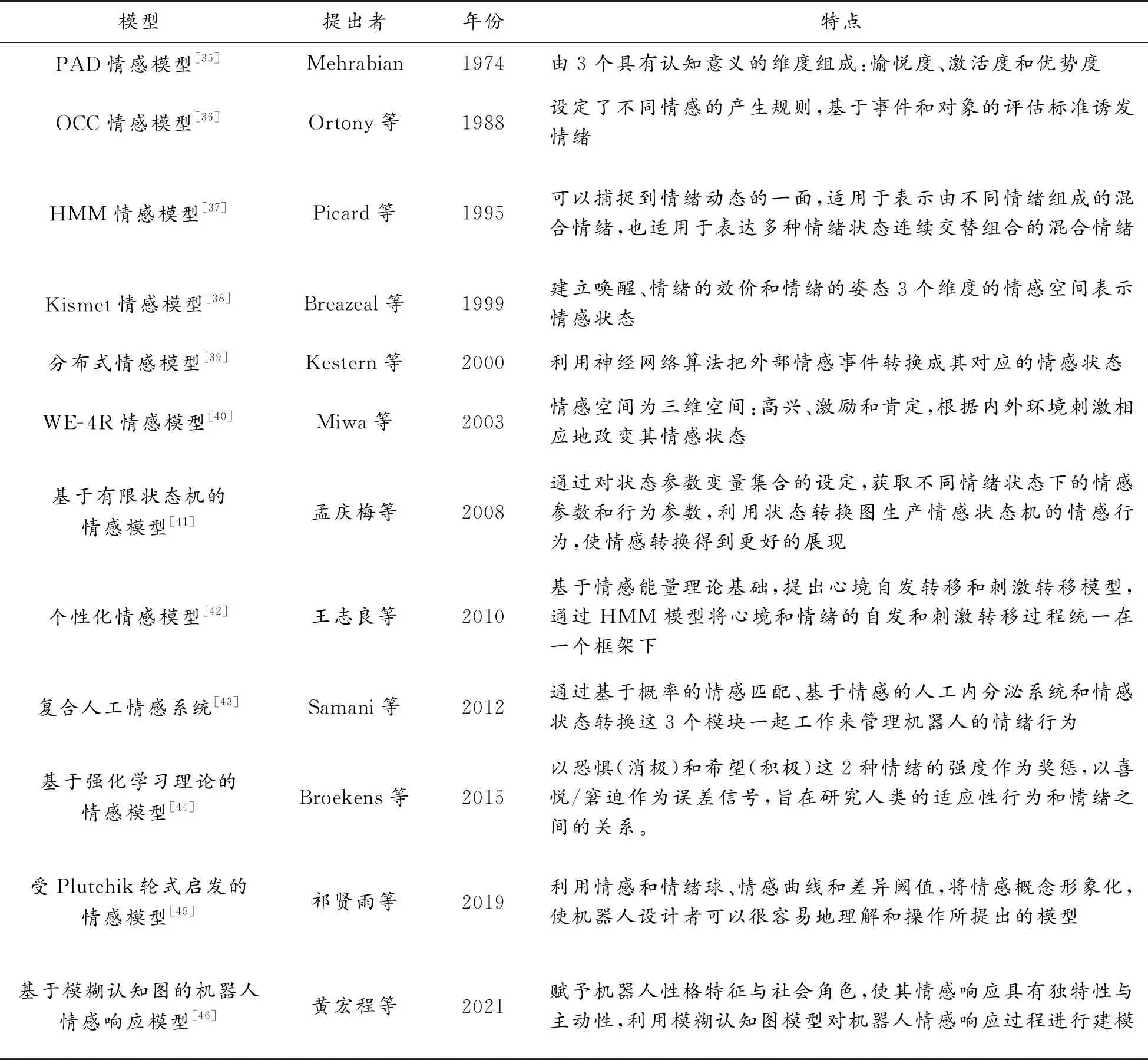

人類的情感受諸多因素的影響而復雜多變,因此讓機器人具備類人情感極具挑戰。要實現具有情感的智能系統,需要建立一個合適的計算模型來描述情感[34]。早期的情感模型以人工規則與簡單情緒維度實現對人類情緒的推理,如PAD模型[35]、OCC模型[36]等,這種情感建模方式雖能表示較為豐富的情感狀態但沒有考慮不同情感狀態之間的切換關系,進而難以實現自然的情緒變換。隨著統計學習與機器學習的不斷發展,情緒狀態轉移的設計方案不斷涌現,同時情緒狀態的觸發與自適應體系也在不斷完善。表3按發展歷程對一些典型的機器人情感模型進行了總結概括。

表3 典型情感模型概括

3.2 面部表情合成

仿人表情機器人的面部表情合成即控制其面部表情驅動器協同運動。為使表情機器人合成的表情更加自然,實現更好的交互效果,研究者們探尋了諸多表情合成方法,大致可分為人工設置和表情模仿2種。

人工設置即根據機器人面部AU與驅動器機械特性間幾何關系預先設置好實現不同表情的驅動方式,具體包括各驅動器的位移、速度、優先級等。如 Mazzei等[47]為FACE表情機器人研制了一種用于生成和控制表情機器人和3D虛擬人物面部表情的混合引擎HEFES(hybrid engine for facial expressions synthesis),其結構如圖9所示。HEFES利用FACS將表情標準化,基于情感笛卡爾空間合成基本表情和混合表情。用戶可以通過HEFES直接創建機器人面部表情,而不需要藝術或動畫技術。

圖9 HEFES結構組成

表情模仿即表情機器人通過視覺傳感器獲取當前用戶的實時表情信息并將其再現。與動畫表情模擬[48]不同,仿人表情機器人的表情模仿還需要根據解析的AU強度對機器人頭部電機進行控制。隨著機器人頭部電機數量與自由度的增多,非線性機械模型逐漸被引入到多電機協同控制中。Magtanong等[49]基于反向傳播神經網絡實現了單幀表情的模擬。Ren等[50]基于能量守恒的前向機械模型和多目標優化完成在線表情遷移。針對機器人表情再現時空一致性和電機抖動的問題,黃忠等[51]基于雙LSTM(long short-term memory)網絡融合方法實現仿人機器人表情再現。該方法利用多層LSTM網絡保障表情再現的時空一致性,并通過面部特征時序到電機控制時序端到端的映射提升了表情再現的柔順度與自然度。

3.3 情感語音合成

目前有多種方法可以有效合成情感語音,主要包括波形拼接合成[52]、 韻律特征修改[53]、統計參數語音合成[54-55]和基于深度學習的情感語音合成[56-57]4種。在波形拼接合成方法中,需建立一個大型情感語料數據庫,并以增加語料樣本的方式提升情感語音合成質量,但大型數據庫的獲取通常較為困難。韻律特征修改方法利用韻律特征分析和參數調整手段實現情感語音的合成,但合成的情感語音自然度和情感表達度不佳。統計參數合成方法利用小型情感語料數據庫進行說話人自適應訓練得到情感語音模型,并通過情感模型修正實現情感語音合成。該方法綜合了語音合成方法的諸多優點,但依然存在自然度低、韻律特征平淡等不足。基于深度學習的情感語音合成方法利用深度神經網絡對情感語料庫進行訓練,進而合成高質量情感語音。這種方法進一步提升了情感語音合成的自然度與情感表達效果,成為當前研究熱點。

3.4 其他情感表達方式

面部表情和語音是使機器人情感表達最直觀生動的2種方式。考慮到表情合成與語音合成技術的復雜度高,一些研究者提出了其他機器人情感表達方式。為了提高互動效率并降低成本,Song等[58]利用顏色、聲音和振動3種互動方式及其組合,通過簡單的方式表達機器人的情感。另外,顏色和震動可以和其他情感表達方式結合以增強機器人情感表達效果。

4 結論

對仿人表情機器人的情感表達進行了綜述,并將現有國內外仿人表情機器人按表情效果與情感表達劃分為3個層次。重點從結構設計與情感控制兩方面總結分析仿人表情機器人情感表達技術的研究現狀與趨勢。仿人表情機器人未來的主要研究重心應集中于以下3個方面。

1) 動態表情姿態更自然。表情行為是一個連續的動態過程,仿人表情機器人的表情合成不僅需考慮整體姿態的協調性,還需注重表情動作的動態過程研究,具體包括表情動作產生過程研究、表情維持過程研究、表情切換過程研究和表情強度變化過程研究。另外,在仿人表情機器人處于自然無表情時,也需考慮其當期面部狀態的自然表現,映射出機器人當前的心理活動狀態。當機器人在需要與人進行情感交互時,從無表情狀態切換到其他表情就會顯得更加自然。

2) 多模態情感表達能力提升。現有的仿人表情機器人雖然能通過表情和語音等方式實現情感表達,但是想要實現自然的人機情感交互仍存在一定局限性。人與人交互中情感的表現不僅在于面部表情與語音,還包括肢體動作、下意識行為等,總體來說是一種多模態的融合。仿人表情機器人采用單一模態的情感表達方式與人進行情感交互會讓人們感到生硬與不自然。因此,需要進一步研究如何更好地融合情感表達相關的多模態特征,而人類行為學、社交心理學等學科將有助于這項研究。與此同時,多模態情感表達對仿人表情機器人的控制系統提出了更高要求。如何提升控制系統多單元協作的穩定性與實時性也將是未來工作的研究重點。

3) 完善恐怖谷測試研究。現有的仿人表情機器人研究者往往會忽視對所研發機器人的恐怖谷效應測試問題,導致目前沒有一套相對完善的標準體系去評判仿人表情機器人是否具有廣泛認可性、是否符合實際應用標準。而恐怖谷的社會性方面研究更少,導致難以評估仿人表情機器人的行為自然度表現,研究者們難以針對具體標準去改善表情機器人,大多數情況下僅憑主觀判斷。因此,開展恐怖谷測試研究對仿人表情機器人的研究具有重要意義。