基于雙重低秩分解的不完整多視圖子空間學(xué)習(xí)

徐光生,王士同

(1.江南大學(xué) 人工智能與計算機學(xué)院,江蘇 無錫 214122;2.江南大學(xué) 江蘇省媒體設(shè)計與軟件技術(shù)重點實驗室,江蘇 無錫 214122)

近年來,多視圖[1-2]數(shù)據(jù)分析已經(jīng)引起了越來 越廣泛的關(guān)注,由于科技的發(fā)展,不同類型的傳感器可以從多個角度采集數(shù)據(jù),這為我們提供了豐富的樣本。但是,隨之也帶來了相關(guān)挑戰(zhàn),多視圖數(shù)據(jù)中的同一類標簽往往對應(yīng)多個不同的樣本,甚至是異構(gòu)的。這導(dǎo)致了一個學(xué)習(xí)困難的問題,若多視圖的類內(nèi)數(shù)據(jù)相似性低于同一視圖不同類之間的相似性,將會導(dǎo)致算法效果較差甚至失敗。一般來說,多視圖數(shù)據(jù)分析可采用3 種策略:1)特征自適應(yīng)算法[3-4],旨在尋找一個公共空間,不同視圖之間的特征可以在該空間中很好地對齊;2)分類器自適應(yīng)算法[5],旨在獲得適用不同的視圖的分類器;3)深度學(xué)習(xí)算法[6-7],旨在構(gòu)建層次結(jié)構(gòu)以捕獲更多區(qū)分性特征以減輕視圖分歧。本文主要采用特征自適應(yīng)策略來尋找不同視圖之間共享的低秩子空間。

在特征自適應(yīng)方面,子空間學(xué)習(xí)[8-9]成為較熱的研究熱點,并在許多領(lǐng)域得到了廣泛的運用。具體而言,子空間學(xué)習(xí)本質(zhì)上是試圖找到一個合適的子空間,在該子空間中盡可能地保留原始特征的區(qū)分性表示。子空間學(xué)習(xí)被引入多視圖數(shù)據(jù)分析中以減輕不同視圖之間的特征差異,通過常規(guī)子空間學(xué)習(xí)方法獲得公共特征空間,可以解決維數(shù)詛咒和不同視圖之間分布差異的問題。

低秩約束[10]已經(jīng)在數(shù)據(jù)表示中被廣泛采用,它最初通過找到最低秩表示并檢測噪聲或離群值來幫助發(fā)現(xiàn)數(shù)據(jù)的多個結(jié)構(gòu)。因此,Zhang 等[11]采用了雙重低秩分解來處理大量損壞的數(shù)據(jù)情況,但是他們只是將數(shù)據(jù)在原始的高維空間中進行低秩分解,并沒有考慮到多視圖之間的類結(jié)構(gòu)信息與視圖結(jié)構(gòu)信息。此外,低秩約束被集成到子空間學(xué)習(xí)框架中以幫助處理高維數(shù)據(jù),多視圖數(shù)據(jù)的投影子空間結(jié)構(gòu)可以通過低秩約束的感知位置重構(gòu)特性被挖掘,從而達到減輕不同視圖之間的差異的效果。

當數(shù)據(jù)在恢復(fù)底層結(jié)構(gòu)方面受到限制時,從不足的觀測數(shù)據(jù)中挖掘潛在的知識就變得很必要。潛在因子[12-14]在許多數(shù)據(jù)挖掘和機器學(xué)習(xí)應(yīng)用場景中起著關(guān)鍵作用,它通過使用貪婪搜索、推斷或近似算法試圖尋找一些人或機器無法觀測到的隱藏變量。在本文中,潛在因子被引入雙重低秩分解子空間學(xué)習(xí)框架中以幫助恢復(fù)視圖數(shù)據(jù)中丟失的信息,這與傳統(tǒng)的多視圖數(shù)據(jù)分析方法區(qū)分開來。

一般來說,對于常規(guī)的多視圖數(shù)據(jù)分析算法,它們關(guān)注的核心問題是如何在數(shù)據(jù)分析過程中盡量減小不同視圖之間的差異,這導(dǎo)致它們大都需要一個必要的前提條件:在訓(xùn)練階段需要完整的視圖信息參與算法的訓(xùn)練。然而,當多視圖數(shù)據(jù)不完整[15]時,這些常規(guī)的多視圖數(shù)據(jù)分析算法則效果較差甚至失敗。不幸的是,許多現(xiàn)實應(yīng)用場景條件苛刻,例如本文關(guān)注的不完整多視圖問題,它的視圖信息就是殘缺的。常規(guī)的多視圖數(shù)據(jù)分析算法無法很好地解決該問題,幸運的是,Liu 等[16]提出可以通過潛在因子來幫助修復(fù)不完整的視圖信息,這為本文的不完整多視圖問題提供了一個很好的解決思路。

為了克服上述挑戰(zhàn),本文提出了一種基于雙重低秩分解的不完整多視圖子空間學(xué)習(xí)算法(incomplete multi-view subspace learning through dual low-rank decompositions,IMSL),所提算法可以解決不完整多視圖問題。算法的主要思想是基于雙重低秩[17]分解子空間學(xué)習(xí)框架,引入潛在因子修復(fù)丟失的信息。此外,本文通過預(yù)先學(xué)習(xí)多視圖數(shù)據(jù)的低維特征來有效地促進視圖之間的特征對齊。本文的主要貢獻總結(jié)可以歸納如下:

1) 基于雙重低秩分解多視圖子空間學(xué)習(xí)框架,引入潛在因子以解決不完整多視圖問題,并以有監(jiān)督的方式來指導(dǎo)雙重低秩分解。

2)通過預(yù)先學(xué)習(xí)多視圖數(shù)據(jù)的低維特征來促進不同視圖之間的特征對齊,保證算法具有更好的魯棒性。

3)在人臉識別、物體分類等數(shù)據(jù)集上,大量的實驗驗證了所提算法的有效性,相較于傳統(tǒng)的多視圖學(xué)習(xí)算法有明顯優(yōu)勢。

1 不完整多視圖子空間學(xué)習(xí)

1.1 問題形式化

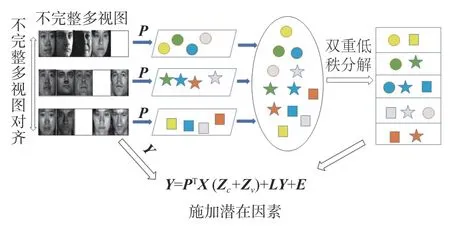

在不完整多視圖數(shù)據(jù)分析場景下,給定多視圖數(shù)據(jù)X=[X1X2···Xm],每個視圖Xi∈Rd×ni,這里一共有m個視圖,其中d是原始特征維數(shù),ni代表單個視圖中的樣本數(shù)量。多視圖數(shù)據(jù)共包括C類樣本,但單個視圖并不包含所有類別樣本,不同視圖數(shù)據(jù)之間具有分布差異。因此,只是單純地對多視圖進行低秩分解解析結(jié)構(gòu)信息并不足以幫助我們?nèi)〉幂^好的實驗效果,還需要意識到丟失信息的重要性。所以本文基于雙重低秩分解子空間學(xué)習(xí)框架,引入潛在因子挖掘丟失的視圖信息,致力于尋找多視圖數(shù)據(jù)的共享子空間來傳遞視圖數(shù)據(jù)中的判別性區(qū)分能力并減輕不同視圖之間的分布差異。如圖1 所示,相同的顏色表示數(shù)據(jù)同類別,相同的形狀表示數(shù)據(jù)同視圖,所提算法通過不完整多視圖對齊預(yù)先學(xué)習(xí)多視圖數(shù)據(jù)的低維特征,并通過施加潛在因子的雙重低秩分解將視圖結(jié)構(gòu)與類別結(jié)構(gòu)彼此分開。

圖1 本文的算法框架Fig.1 Algorithm framework of this paper

1.2 不完整多視圖對齊

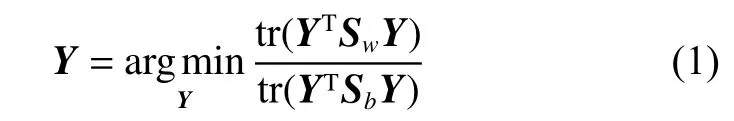

多視圖數(shù)據(jù)分析中,不同視圖由于不同來源可能具有不同的分布,為了保證它們可以傳遞有效的知識,將它們進行特征對齊[18]是非常必要的。此外,預(yù)先學(xué)習(xí)數(shù)據(jù)的低維特征將在算法迭代過程中保持固定,這提高了算法的魯棒性。假設(shè)Yi∈Rp×ni是每個視圖預(yù)先學(xué)習(xí)到的低維特征,Y=[Y1Y2···Ym]∈Rp×n這里p表示降維后的低維特征的維度。本文通過拉普拉斯矩陣[19]來進行多視圖的特征對齊并獲得它們的低維特征表示,具體細節(jié)為

這里Sw∈Rn×n與Sb∈Rn×n分別代表多視圖數(shù)據(jù)的類內(nèi)拉普拉斯矩陣與類間拉普拉斯矩陣。本文旨在預(yù)先學(xué)習(xí)低維特征的過程中盡量保留更多的類內(nèi)信息而盡量增大類間的差異,具體的拉普拉斯矩陣定義為

式中:υ是Sw相對于Sb的特征值;Y是最小的p個特征值所對應(yīng)的特征向量。預(yù)先學(xué)習(xí)的低維特征可以在低維空間中減輕原始空間中多視圖的分布散度。

1.3 基于雙重低秩分解的子空間學(xué)習(xí)

在不完整多視圖問題中,如何恢復(fù)丟失部分的視圖信息是我們解決該問題的重點。為了恢復(fù)丟失部分的視圖信息,本文首先假定丟失部分的視圖信息是可觀測的,因此多視圖數(shù)據(jù)可以定義為X=[XO,XU],XO為保留的視圖信息,XU為丟失的視圖信息。因此,針對多視圖數(shù)據(jù),引入低秩約束子空間學(xué)習(xí)公式:

式中:rank(·)代表矩陣的秩;Z∈Rn×n代表多視圖的低秩重構(gòu)系數(shù)矩陣,這可以幫助指導(dǎo)多視圖的局部位置感知重建。眾所周知,秩最小化問題[20]為非收斂性問題,Liu等[16]利用凸替代來解決該問題,即核范數(shù)。因此,式(3)可被重新定義為

式(6)與常規(guī)的低秩約束子空間學(xué)習(xí)相比,引入潛在因子以處理不完整多視圖問題。從幾何角度分析,式(6)實際上提出了通過列重構(gòu)[21]與行重構(gòu)[18]來重構(gòu)低維視圖特征,列重構(gòu)通常被認為是字典學(xué)習(xí),行重構(gòu)則被稱為潛在因子。在數(shù)據(jù)矩陣中,列空間代表主要特征,行空間代表關(guān)鍵對象部分,當數(shù)據(jù)中的某些樣本丟失(即數(shù)據(jù)矩陣中的某些列為空),通過行重構(gòu)來恢復(fù)數(shù)據(jù)是非常行之有效的。

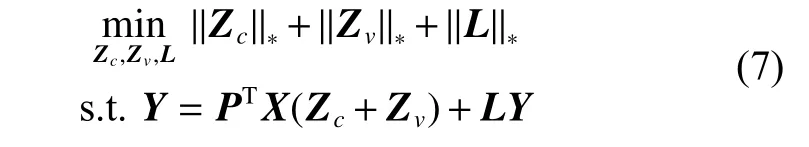

然而,潛在因子只能夠幫助我們恢復(fù)丟失的視圖信息,而對于多類別的多視圖數(shù)據(jù),若同一類別的不同視圖特征差異較大,這將導(dǎo)致低秩約束Z無法揭示類結(jié)構(gòu)信息。實際上,多視圖數(shù)據(jù)包含類結(jié)構(gòu)和視圖差異結(jié)構(gòu),類結(jié)構(gòu)旨在揭示類信息的全局結(jié)構(gòu),視圖差異結(jié)構(gòu)旨在保留不同類之間的視圖信息,兩種獨立的結(jié)構(gòu)相互交織在一起。因此,Z可被分解為兩個低秩部分[22],即

這里Zc∈Rn×n代表的是類結(jié)構(gòu)的低秩表示,Zv∈Rn×n代表的是視圖差異結(jié)構(gòu)的低秩表示。由式(7)可知,低秩約束Z被分解為Zc和Zv,這樣類結(jié)構(gòu)信息和視圖差異結(jié)構(gòu)信息被彼此分離,避免了較大的視圖差異影響類信息的全局結(jié)構(gòu)。此外,為了放松原始問題,本文將稀疏項E∈Rp×n引入目標函數(shù),將原本的硬約束轉(zhuǎn)換為軟約束,避免了潛在的過擬合問題。至此,目標函數(shù)可被歸納為

式中 ‖·‖1表示矩陣的1 范數(shù)。這里,我們只是采用無監(jiān)督的方式來指導(dǎo)多視圖的雙重低秩分解。但是,無監(jiān)督的方式無法將類結(jié)構(gòu)信息與視圖差異結(jié)構(gòu)信息完全地剝離開來,因此有必要利用多視圖的標簽信息來完成雙重低秩分解。

1.4 監(jiān)督信息對齊

在不完整多視圖問題中,本文期望通過有監(jiān)督的方式將相互交織在一起的類結(jié)構(gòu)信息與視圖差異結(jié)構(gòu)信息分離開來,因此針對類結(jié)構(gòu)與視圖差異結(jié)構(gòu),本文定義了兩個監(jiān)督圖正則化項以此來指導(dǎo)多視圖的雙重低秩分解。假設(shè)類結(jié)構(gòu)的低維特征Yc=PTXZc,視圖差異結(jié)構(gòu)的低維特征Yv=PTXZv,本文旨在最小化類內(nèi)相似性的同時最大化視圖間的差異性,以此來保留更多的類內(nèi)信息并消除視圖差異的影響。具體的正則化項定義為

這里,li、lj分別是xi與xj的標簽信息,xi∈Nk1(xj)表示xi屬于同類別的xj的k1個最近鄰居集合,xi∈Nk2(xj)表示xi屬于同視圖的xj的k2個最近鄰居集合。至此,本文采用類似LDA函數(shù)的形式來統(tǒng)一式(9)以求最小化類內(nèi)方差且最大化同視圖,但不同類的邊際分布差異,其具體形式為

式中Lc、Lv分別是Wc和Wv的拉普拉斯矩陣。由此,同一類中的局部流形結(jié)構(gòu)得以保留,且減輕了視圖流形的影響。

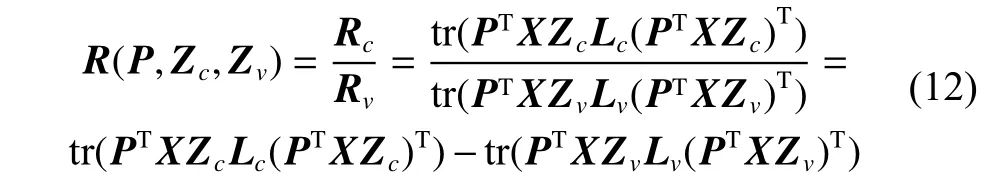

1.5 目標函數(shù)和優(yōu)化

至此,有監(jiān)督的雙重低秩分解可以將相互交織在一起的多視圖數(shù)據(jù)中的類結(jié)構(gòu)與視圖結(jié)構(gòu)分離開來,而在此雙重低秩分解下學(xué)習(xí)到的健壯子空間使類內(nèi)數(shù)據(jù)更加緊湊,同時最大化同一視圖內(nèi)不同類別的數(shù)據(jù)之間的邊際分布差異。因此,基于雙重低秩分解的不完整多視圖子空間學(xué)習(xí)的目標函數(shù)可以被定義為

式中:Y1、Y2、Y3和Y4是 4 個拉格朗日乘子;μ >0是懲罰參數(shù);〈〉表示矩陣的內(nèi)積,即〈A,B〉=tr(ATB)。我們無法同時更新優(yōu)化Jc、Jv、Zc、Zv、L、K、E和P,幸運的是,我們可以通過交替方向乘子法(altermating direction method of multipliers,ADMM)依次地解決每個子問題,并不斷地迭代更新優(yōu)化這些參數(shù)直至收斂。具體而言,當我們更新其中一個參數(shù)時,需要固定其他參數(shù)。假設(shè)當前迭代次數(shù)為t(t≥0 ),t+1次迭代具體各項的更新為

1)固定Jv、Zc、Zv、L、K、E和P,將它們視為常數(shù)項,從而得到Jc的更新公式:

3)固定Jc、Jv、Zv、L、K、E和P,將它們視為常數(shù)項,從而 Γ對Zc進行求導(dǎo)得:

4)固定Jc、Jv、Zc、L、K、E和P,將它們視為常數(shù)項,從而 Γ對Zv進行求導(dǎo)得:

5) 固定Jc、Jv、Zc、Zv、L、E和P,將它們視為常數(shù)項,從而得到K的更新公式為

6) 固定Jc、Jv、Zc、Zv、K、E和P,將它們視為常數(shù)項,從而 Γ對L進行求導(dǎo)得:

7) 固定Jc、Jv、Zc、Zv、L、K和P,將它們視為常數(shù)項,從而得到E的更新公式:

8) 固定Jc、Jv、Zc、Zv、L、K和E,將它們視為常數(shù)項,從而 Γ對P進行求導(dǎo)得:

式(16)、(17)、(20)可通過奇異值閾值(SVT)運算求解得,式(18)、(19)可通過Sylvester 方程求解,式(22)可通過收縮算子進行求解,詳細的算法流程在算法1中列出。參數(shù)μ、ρ、ε、μmax和tmax參考了相關(guān)的多視圖分析算法RMSL[17]。其他的參數(shù) λ、α則在實驗中調(diào)節(jié),并在實驗章節(jié)中給出分析。

算法1:IMSL 的算法描述

或t達到tmax,其中 ‖·‖∞表示矩陣的無窮范數(shù);

13)更新迭代次數(shù)t,t=t+1;

14)結(jié)束循環(huán)。

上述算法中,2)、3)、6) 的核范數(shù)計算與4)、5)、7)、9)的矩陣乘法和逆運算為主要耗時部分。2)、3) 的SVD 計算的時間復(fù)雜度為O(n3),6) 的SVD 計算的時間復(fù)雜度為O(p3),n為多視圖的樣本大小,p為降維的維數(shù)。如果在實驗中選擇較小的降維維數(shù),可以加速6) 中的計算。4) 采用Sylvester 方程求解,因此主要耗時部分為矩陣乘法、逆運算和Sylvester 方程求解,可推導(dǎo)出其時間復(fù)雜度為O(dn2+n3),d為原始特征維數(shù)。5) 與4)求解過程相同,時間復(fù)雜度為O(dn2+n3)。類比可以推導(dǎo)出7)與9)的時間復(fù)雜度分別為O(pn2+pdn)pdn)、O(dn2+nd2+d3)。8)采用收縮算子進行求解,其時間復(fù)雜度為O(pn)。通常在實驗中設(shè)置p?n且p?d,因此綜上所述,算法1 的時間復(fù)雜度為O(T(dn2+n3+d3+nd2)),T為所提算法的迭代次數(shù)。

2 實驗

2.1 數(shù)據(jù)集

本文分別在3 組多視圖數(shù)據(jù)集上驗證了所提算法的實驗效果,它們分別是人臉數(shù)據(jù)集CMUPIE、物體數(shù)據(jù)集ALOI-100 和COIL-100。

CMU-PIE 是一個多視圖人臉數(shù)據(jù)集,總共有68 類樣本,采取同一對象的但具有不同姿勢的樣本之間有著較大的差異,每個對象的每個姿勢都有著21 種不同的照明變化,這里采用C05、C07、C09、C27 和C29 來構(gòu)建訓(xùn)練集與測試集,且它們中的圖像都被裁剪為32×32 的尺寸。

ALOI-100 和COIL-100 都為多視圖物體數(shù)據(jù)集,都包含100 個類別物體和7 200 張圖像。ALOI-100 和COIL-100 都是利用旋轉(zhuǎn)角度進行采樣的,因此每個類中的圖像都相隔85°,共有72 張圖像。本文設(shè)定4 種視圖:v1 [0°,85°]、v2[90°,175°]、v3[180°,265°] 和v4[270°,355°](v 表示view),且它們中的圖像被裁剪為64×64 的尺寸。

2.2 實驗設(shè)置

在實驗部分,對于CMU-PIE 多視圖人臉數(shù)據(jù)集,我們選取不同數(shù)量、不同姿勢的視圖作為數(shù)據(jù)集,從視圖的每個類別中隨機選擇10 張圖像構(gòu)建訓(xùn)練集,剩下的圖像作為測試集。而為構(gòu)造不完整多視圖實驗場景,隨機從訓(xùn)練集的每個視圖中挑選10 個類別移除。而對于ALOI-100 和COIL-100 這兩個多視圖物體數(shù)據(jù)集,依次選擇兩個視圖作為訓(xùn)練集,剩下的兩個視圖作為測試集,構(gòu)建不完整多視圖訓(xùn)練集。此外,我們使用最近鄰分類器(KNN)來評估最終性能。

本文主要采用特征提取算法與多視圖數(shù)據(jù)分析算法進行比較:LDA[24]、LPP[23]、LatLRR[16]、LRCS[25]、RMSL[17]和CLRS[26](CLRS1 表示施加低秩約束,CLRS2 表示未施加低秩約束)。其中,CLRS、LDA、RMSL 屬于有監(jiān)督的方法,LPP、LatLRR 為無監(jiān)督的方法,LRCS 為弱監(jiān)督方法。對于這些對比算法,同樣采用最近鄰分類器(KNN)來評估最終性能。

2.3 結(jié)果分析

在CMU-PIE 多視圖人臉數(shù)據(jù)集上的實驗結(jié)果如表1 與表2 所示,Task 1~Task 9 分別表示為{C05,C07}、{C07,C09}、{C27,C29}、{C05,C09,C27}、{C09,C27,C29}、{C05,C07,C09}、{C05,C09,C27,C29}、{C05,C07,C09,C27}、{C05,C07,C09,C27,C29}。由表1 與表2 可知,所提算法在CMU-PIE 人臉數(shù)據(jù)集的大部分測試任務(wù)中都排名第一。對于LPP 與LDA,LPP 通過熱核函數(shù)來區(qū)分不同類別,LDA 通過監(jiān)督信息將同類特征與異類特征加以區(qū)分,但是在不同視圖之間同類特征之間存在較大差異時會導(dǎo)致傳統(tǒng)的監(jiān)督學(xué)習(xí)算法性能低于無監(jiān)督學(xué)習(xí)算法。由表中不難看出,基于低秩約束的方法是優(yōu)于傳統(tǒng)的特征提取算法的,尤其對于有損壞的CMU-PIE 數(shù)據(jù)集,這驗證了低秩約束對帶有稀疏誤差項的噪聲有很好的抑制效果。但是相較于算法RMSL、LRCS、CLRS與IMSL,算法LatLRR 只是簡單地施加低秩約束,并未考慮到在多視圖場景中不同類別的特征相似性較大的可能,這導(dǎo)致了LatLRR 在多視圖測試案例中性能較差。算法LRCS 則針對多視圖場景提出學(xué)習(xí)不同視圖相對應(yīng)的子空間并將它們對齊,這盡可能地保留了不同視圖各自的特征,但是當同類特征差異大于異類特征時則會導(dǎo)致該算法效果較差。算法RMSL 針對同類特征差異較大的問題提出了雙重低秩分解來減小不同視圖對同類別數(shù)據(jù)進行低秩分解時造成的影響,然而它對不完整多視圖場景并沒有一個很好的解決效果。算法CLRS 則旨在學(xué)習(xí)由各個視圖特定的投影所共享的無視圖低秩投影來減小視圖之間的語義差距,并施加有監(jiān)督的正則化項來耦合不同視圖的類內(nèi)數(shù)據(jù)。但是當視圖數(shù)據(jù)不完整時,各個視圖特定的投影所共享的特征可能趨向于非常少,這就導(dǎo)致最終獲得的共享低秩投影性能下降。最后,算法IMSL 針對不完整多視圖場景提出了引入潛在因子的雙重低秩分解子空間的學(xué)習(xí)方法,潛在因子幫助挖掘丟失的視圖信息,此外,預(yù)先學(xué)習(xí)的低維不完整多視圖特征與監(jiān)督信息對齊也進一步促進了不同視圖之間的特征對齊。因此IMSL 的性能是優(yōu)于以上算法的。

表1 在原始的CMU-PIE 人臉數(shù)據(jù)集上各算法的分類精度Table 1 Accuracy of algorithms on original CMU-PIE face datasets %

表2 在損壞的CMU-PIE 人臉數(shù)據(jù)集上各算法的分類精度Table 2 Accuracy of algorithms on corrupted CMU-PIE face datasets %

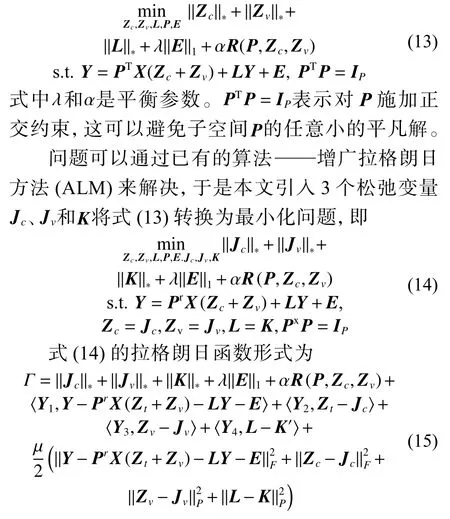

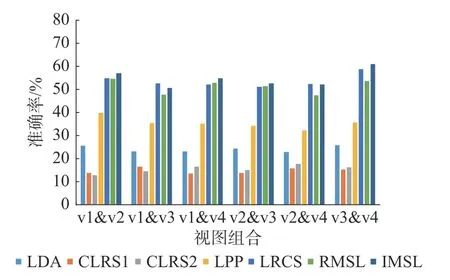

在COIL-100 多視圖物體數(shù)據(jù)集上的實驗結(jié)果如圖2 所示,顯然所提算法的平均性能在大部分測試任務(wù)中要好于所有對比算法,且受不同的視圖組合影響較小。在ALOI-100 多視圖物體數(shù)據(jù)集上的實驗結(jié)果如圖3 所示。對于不同的視圖組合,所有算法的平均性能相差不大,這表明了兩個視圖之間的發(fā)散度在一定程度上是等效的。LRCS 與RMSL的性能較接近于所提算法,甚至LRCS 在一些測試任務(wù)中表現(xiàn)出更優(yōu)性能,這是由于該視圖組合可能同類別特征差異性較小,導(dǎo)致雙重低秩分解的效果相較于常規(guī)的低秩分解可能較差,但是在不完整的多視圖場景下,施加了潛在因子的雙重低秩分解子空間學(xué)習(xí)框架仍然保證了所提算法勝任絕大多數(shù)的測試任務(wù)。

圖2 在COIL-100 數(shù)據(jù)集上各算法的分類準確率Fig.2 Accuracy of algorithms on COIL-100 datasets

圖3 在ALOI-100 數(shù)據(jù)集上各算法的分類準確率Fig.3 Accuracy of algorithms on ALOI-100 datasets

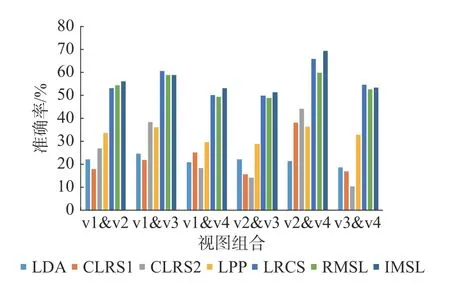

2.4 模型分析

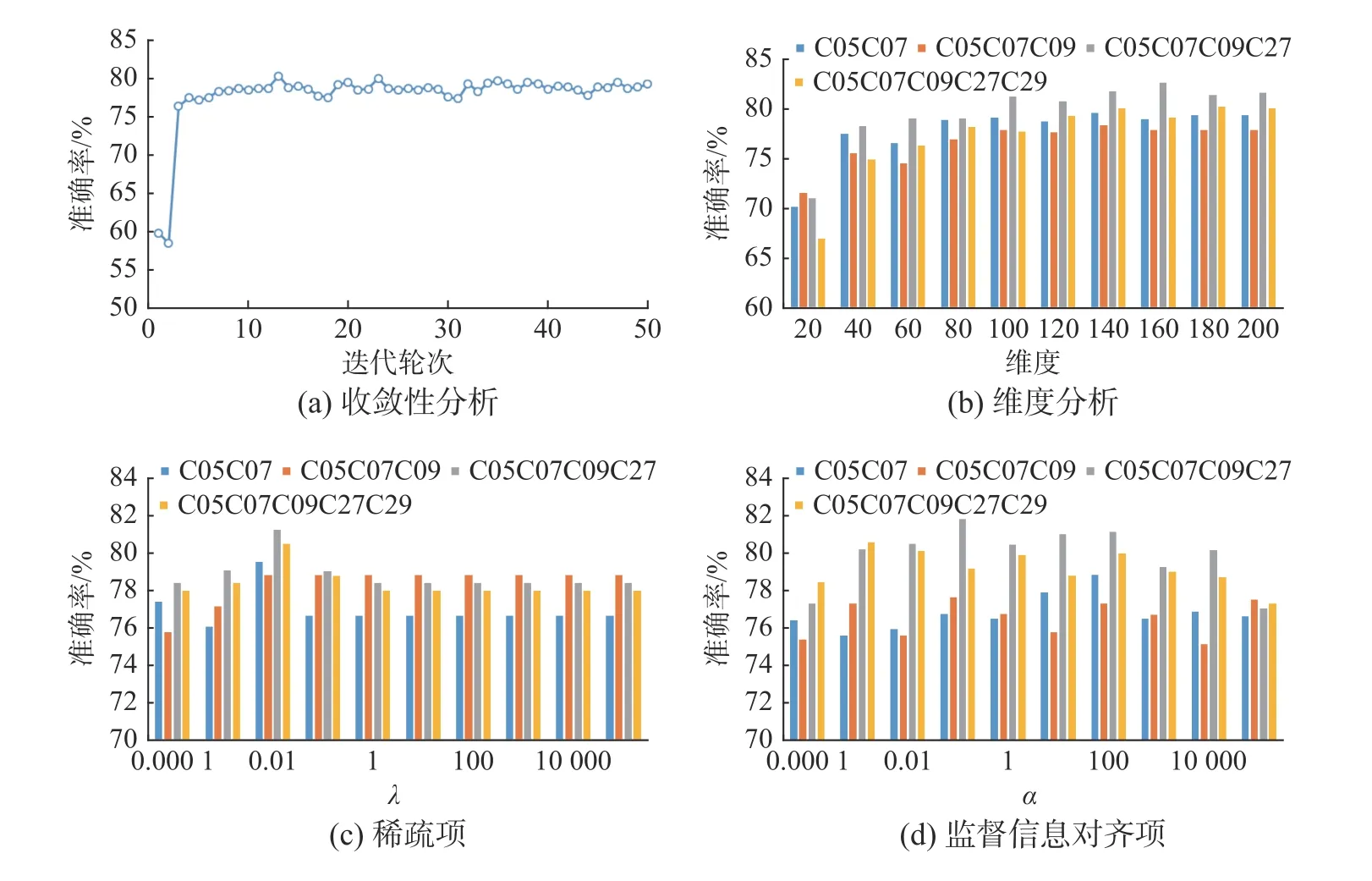

本節(jié)將分析所提算法的收斂性,并評估不同子空間維度下所提算法的準確變化,此外還驗證監(jiān)督信息、對齊項等正則化參數(shù)的有效性。在本節(jié)中,主要評估以下參數(shù):子空間維度參數(shù)p、稀疏項參數(shù)λ、監(jiān)督信息對齊項參數(shù) α。這里以CMUPIE 數(shù)據(jù)集作為測試案例,通過固定其他參數(shù)來逐一測試它們對于算法的意義。

圖4(a)展示了以{C05 C07}作為測試案例,所提算法的準確率隨迭代次數(shù)逐漸增大的變化趨勢。顯而易見,所提算法收斂速度較快,識別精度迅速上升并在5 次迭代后保持一個較穩(wěn)定的值。

圖4(b)展示以{C05C07,C05C07C09,C05C07C09C27,C05C07C09C27C29}作為測試案例,所提算法在不同子空間維度下的準確率變化。從圖中不難看出,隨著維度的增加,算法的精度先是逐步上升,在達到一定維度后轉(zhuǎn)為平穩(wěn)趨勢。

圖4(c)與圖4(d)展示了以{C05C07,C05C07C09,C05C07C09C27,C05C07C09C27C29}為測試案例,正則化參數(shù)對所提算法準確率的影響。由圖可知,當監(jiān)督信息對齊項參數(shù) α趨向于0 時算法性能較差,這驗證了監(jiān)督信息對齊項的有效性。稀疏項參數(shù) λ在較小值時取得的效果較好,且隨著參數(shù)值的增大算法精度趨向于穩(wěn)定或一定的下降。

圖4 參數(shù)分析Fig.4 Parameter analysis

3 結(jié)束語

為了解決不完整多視圖問題,本文提出了一種基于雙重低秩分解的不完整多視圖子空間學(xué)習(xí)算法。所提算法基于雙重低秩分解子空間學(xué)習(xí)框架,引入潛在因子挖掘丟失的視圖信息,并通過預(yù)先學(xué)習(xí)多視圖的低維特征來進行特征對齊。此外,通過監(jiān)督信息來進一步地促進雙重低秩分解,避免了視圖結(jié)構(gòu)差異對全局類結(jié)構(gòu)造成的影響。在3 個數(shù)據(jù)集上的實驗效果證明了所提算法的優(yōu)越性。