基于多模態互補特征學習的遙感影像語義分割

王興武,雷濤,王營博,耿新哲,張月

(1.陜西科技大學 陜西省人工智能聯合實驗室,陜西 西安 710021;2.陜西科技大學 電子信息與人工智能學院,陜西 西安 710021)

遙感圖像語義分割是將對象類標簽分配給遙感圖像中每個像素的一項技術,被廣泛應用于地質的量化分析、城市規劃、環境監測和保護等領域。因此,語義分割一直是遙感領域的研究熱點。然而,建筑物、道路和樹木等地物具有較高的類內方差和相似的類間外觀,因此遙感圖像語義分割具有一定的挑戰性。

遙感圖像的光譜信息,例如紅、綠、藍三通道圖像(red,green,blue,RGB)或近紅外、紅、綠(infrared,red,green,IRRG)圖像,通常是語義分割任務的第一個數據源。近年來,深度學習在遙感圖像的光譜圖像語義分割方面取得了重大進展[1-2]。基于全卷積網絡的方法和編碼架構已被廣泛應用并取得了較好效果。Fu 等[3]設計了基于全卷積神經網絡的遙感圖像語義分割算法,實現了遙感圖像端到端的語義分割。在此基礎上,研究者們還提出了空間關系模塊[4]和空間信息推理模塊[5]。通過對特征圖通道及空間上下文關系進行有效建模,使網絡聚焦于目標區域,抑制其他類別的影響。Zhang 等[6]在編解碼結構中采用金字塔池化模塊以聚合不同區域的上下文信息,從而提高網絡獲取全局信息的能力。此外,在損失函數的設計上,為了解決遙感圖像中嚴重的類不平衡問題,Dong 等[7]提出了加權損失和像素級交叉熵損失相結合的多類損失,提升了小樣本量地物分割精度。Liu 等[8]將邊界損失引入網絡中得到了更精細的地物邊界分割結果。這些方法在遙感圖像語義分割中均取得了顯著效果。但在某些特定場景下,如物體的外觀因陰影和天氣條件而改變,某些地物在光譜信息上高度相似的類間外觀(高低植被)等,僅僅利用光譜信息作為單一信息源會導致分割性能低,在某些地物上錯分嚴重。

隨著航空拍攝和衛星成像技術的不斷發展,獲取到的遙感圖像也愈加多樣,如數字地形模型(DTM)、數字表面模型(DSM),數字高程模型(DEM)等。這些高程數據通過向二維光譜數據提供三維幾何信息,自動補充光譜信號,這對光照變化、陰影等具有魯棒性,合理地使用高程數據可以大幅提高遙感圖像的語義分割性能[9]。目前,簡單地將近紅外、紅色、綠色(IRRG)光譜和DSM 合并為四通道作為網絡輸入的像素級融合方法,但這種方法已被證明不能充分融合異構信息之間的關系,需要額外的網絡結構單獨對高程信息進行特征提取[10]。

基于多模態信息融合的遙感圖像語義分割算法可以總結為三類結構,即早期融合、中期融合和后期融合。

Cao 等[11]提出的中期融合策略用兩個獨立編碼器分別提取光譜和高程分支特征,在上采樣之前或期間進行融合。融合特征僅存在于解碼器端,這種中期融合的優勢在于:在網絡中間階段進行融合,多模態特征語義信息豐富,可以避免某單一源的低級特征將噪聲信息帶入融合特征。Hazirbas 等[12]提出的早期融合策略,將高程分支特征作為光譜分支特征的補充,并在不同的下采樣階段將它們融合在一起。這種方法存在高程分支只處理高程信息的問題,而光譜分支實際上處理的是融合數據,高程分支帶來有效信息的同時也引入了噪聲信息。因此,這種方法會破壞原始光譜分支的特征流,使網絡在對某些地物分類時陷入對某單一模態數據的過分依賴,造成誤判。Audebert 等[13]提出了后期融合策略。他們為光譜數據和DSM 數據訓練了兩個獨立的深度網絡,然后將兩個深度網絡的最終特征映射概率圖輸入到殘差校正網絡中進行訓練。然而,存在的不足是:一方面,僅在語義層面的融合忽略了語義分割任務對低級融合特征的需求;另一方面,大量參數和復雜訓練過程限制了該方法的實際應用。

雖然上述方法在多模態數據遙感圖像語義分割任務中均取得了不錯的效果,但這些網絡在進行特征融合時均未考慮多模態數據之間的關系,容易導致復雜地物的誤分。在本文中,假設從光譜和高程信息計算的中層特征(網絡中特征提取階段結束時提取的特征)有相同特征和互補特征,那么從光譜和高程計算的信息將相互作用,從而為分類提供更獨特和互補的特征。基于這一假設,本文設計了用于多模態遙感圖像語義分割的雙分支互補特征學習(complementary features learning)網絡。在該網絡中,通過添加額外的損失重建共有和互補特征,可以產生更魯棒的融合特征以提高分割精度。

1 相關知識

為了充分利用光譜數據與高程數據之間的異構信息,大多數現有算法均采用兩個深度網絡分別提取多模態信息特征,在網絡不同階段將提取到的多模態特征融合,融合特征比原始單一模態特征更具魯棒性,從而產生更精細的分割結果。然而,現有方法存在以下問題:一方面,以直接相加或級聯的方式通過建模實現多模態信息融合,或簡單地以多模態特征自身所含信息量決定該模態特征在融合特征中所占比例[14],這兩種方法均忽略了多源信息間的關系,在某些復雜地物上造成嚴重錯分;另一方面,融合策略的選取也會嚴重影響分割結果,幾種融合策略各有優劣[15]。基于此,我們在網絡訓練過程中引入互補特征學習約束,并根據該約束的特點選取中期融合策略。提出的網絡根據多模態數據之間的關系,選擇性地提取對分割任務更有效的部分,可以有效減少誤分,提升分割精度。

1.1 互補特征的提取

現有算法在構建多模態特征融合時,僅僅將多源特征在網絡的不同階段簡單合并或相加,而忽略了多源信息間的互補性,對于一些光譜上表現相似的地物,如高低植被、建筑物陰影遮擋后的路面與正常路面等,網絡偏向于高程信息時,對提升分割精度是有利的;但是對于車輛、路面而言,高程信息難以體現情況,分割精度較低。為了更清晰地展示過分依賴單一信息源造成的誤分現象,利用網絡提取到的特征圖解釋這一現象,圖1 和圖2 給出了裁剪出更小區域時的分割結果,并用紅色框標記重點誤分區域。圖1 和圖2中的(a)、(b)、(c)分別為光譜圖、歸一化DSM圖以及手工標注標簽,(d)、(e)分別為DSMFNet編碼器中光譜分支與高程分支第一次下采樣后得到的特征圖,(f)為DSMFNet 分割結果。圖1 的地物背景是兩塊在光譜上表現完全不同的建筑物,其中一塊光譜上表現為低植被類,另一塊在光譜上表現為建筑物類別,但是在高程數據中,兩塊建筑物區域數值并不高,與道路特征類似,由于大量數據樣本下的建筑物高程上數值都很高,在這種情況下網絡偏向于信任高程信息,將該區域錯分為低植被類。在圖2 中,位于建筑物頂部的汽車,在光譜圖像中特征明顯,但是在高程圖像中幾乎表現不出來,高程分支提取到的特征圖在該區域也十分模糊,導致網絡仍偏向于高程特征,最終分割結果并沒有將汽車類別準確分割。

圖1 建筑區域的可視化特征圖Fig.1 Visual feature map of the buliding region

圖2 不透水和汽車的可視化特征圖Fig.2 Visual feature map of water impervidle and automobile region

由上述分析可得,光譜和高程數據在相同地物上會表現出不同的特征。如何有效地識別它們的差異并將兩種類型信息統一表示為語義特征是十分重要的。我們認為光譜和高程信息計算的中層特征存在相同信息和互補信息,相同信息包括重合的建筑物、植被的邊緣信息;光譜數據中的互補信息有車輛顏色、紋理信息,高程數據中的互補信息有可區分的高、低植被高度以及輪廓信息。光譜和高程計算的信息需要相互作用,這為分類提供更獨特和互補的信息。基于這一結論,我們把多模態數據提取到的中層特征分別劃分為相同的和互補的特征,在多模態特征融合時將提取到的互補特征與另一模態所有特征合并,補充后的互補特征可以有效避免上述誤分。

1.2 中期融合策略

目前基于多模態信息融合的語義分割網絡中,應用最為廣泛的是早期融合策略。該策略采用兩個深度網絡分別對多模態數據進行特征提取,將高程分支下采樣過程中產生的不同尺寸的特征圖作為輔助與光譜分支中的特征圖進行合并,再由共用的解碼器完成特征重建[16]。該方法的理論依據是:網絡的淺層主要提取邊緣特征,而光譜圖像和高程圖像所表現的邊緣特征有很大不同。主要表現為:無結構的邊緣主要依靠顏色區分,無紋理的邊緣主要依靠結構高度區分[17]。因此,早期融合策略是從淺層開始對特征進行融合。這種方法雖然應用廣泛且取得了不錯的分割結果,但仍存在一些問題:一方面,在網絡淺層提取到的低級特征在提供融合特征細節信息的同時也會帶來大量冗余信息,例如,光譜數據中地物陰影的邊界,高程數據中建筑物鋸齒狀的邊緣等噪聲,均會干擾網絡模型對該區域的識別;另一方面,由于需要從多模態特征中提取出對應的互補特征,該互補特征是依靠最大化多模態特征之間的距離得到的,如果在網絡淺層就開始采用互補特征約束最大化多模態特征之間的距離,會導致網絡過于注重提取到的多模態特征間的差異性,而忽略了對分割任務語義信息的提取。

基于上述分析,本文先采用中期融合策略,利用光譜和高程數據分別訓練兩個結構相同的深度網絡,再對編碼器的最后一層輸出特征圖進行融合。這種方法雖然舍棄了一定的細節信息,但網絡中添加的互補特征約束的語義級特征融合會對融合特征中的錯誤部分進行修正。此外,在下采樣過程中丟失的細節信息會通過跳躍連接補充到解碼器中。

2 主要研究內容和關鍵技術

多模態高分辨率遙感語義分割任務中,輸入為IRRG 光譜圖像和相應的DSM 高程圖像,輸出是每個像素的語義類別標簽。本文利用一種模態數據改進另一種模態的特征提取過程:一方面,由于一些語義特征在這兩種模態中都是可見的,可以從光譜圖像和相應的高程信息中提取一組相似特征;另一方面,由于光譜圖主要捕獲外觀信息,高程圖主要捕獲形狀信息,可以分別從它們中提取一些特定的特征。

在本文中,我們通過最大化共享信息之間的相似性和特定模態信息之間的互補性,將每個模態的特征分別分解為共同特征和互補特征。得到這些特征后,一種模態通過借用另一種模態中的互補特征,以增強它們共享信息的能力。這種共享機制在單一模態特征沒有被很好提取時是十分有效的,最后通過融合這兩種模態輸出的概率圖得到分割結果。

2.1 網絡結構

如圖3 所示,互補特征學習網絡由兩個相同的并行基礎分割網絡和互補特征提取部分組成,并行基礎分割網絡包括光譜信息分支和高程信息分支。互補特征提取部分位于編碼器(encoder)與解碼器(decoder) 之間,由4 個并行的補充性特征融合(complementary feature fusion)卷積層組成。

圖3 CFL-Net 網絡結構Fig.3 CFL-Net network structure

兩個基礎分割網絡均以ResNet-50[18]作為backbone,并有完成特征重建的解碼器與之對應。為了防止網絡過深造成的梯度消失問題,在解碼器中添加殘差結構。為了將低階特征利用起來,將每一個res-block 輸出特征圖以跳躍連接的方式補充到解碼器部分。為了避免信息冗余,我們在每個跳躍連接上添加了額外的卷積塊,以自適應地過濾由低級特征帶來的冗余信息。

此外,為適應遙感圖像特殊的紋理特征,對骨干網絡ResNet-50 做出以下改進。原始ResNet-50 網絡用于自然圖像分類,由一個步長為2 的7×7卷 積層、3×3池化層以及4 個殘差塊組成。此處保持4 個殘差塊不變,將最初步長為2 的7×7卷積層替換為 3×3卷積層,步長保持不變,后續的3×3池化層被刪除。通過在第一塊中使用較小的卷積核和丟棄最大池化,可以避免特征圖過于平滑,從而保留更清晰的邊界信息,以區分通常具有尖銳邊界信息的對象,如建筑物、車輛等。

該網絡主要創新在于互補特征提取部分,光譜數據與高程數據經過相同的編碼器處理得到中間的語義特征,為了不破壞空間信息,本文分別用兩個卷積對它們進一步處理,將單個特征圖劃分為共同特征與互補特征,以此達到不同模式的共同特征是相似的,而互補特征是不同的。此外,采用額外的互補特征學習損失約束共同特征和相似特征之間的距離。在融合策略上,以光譜分支為例,將光譜分支獲取的共同特征與互補特征、高程分支獲取的互補特征合并在一起,構成新的融合特征。得到的光譜分支的融合特征Us及高程分支的融合特征Ud可以分別表示為

式中:Ss和Sc分別表示光譜、高程分支的共同特征;Ds和Dc分別表示光譜、高程分支的互補特征。在特征融合之后,利用ASPP 模塊[19]擴大感受野,獲取多尺度融合特征。最后,解碼器使用具有殘差結構的反卷積模塊重建語義標記結果。

該結構中,這兩種模態可以通過學習到的互補特征相互促進。若其中一種模態的數據提取到的特征較差,丟失了部分關鍵信息時,另外一種模態的互補特征將是十分有利的。由于不同模態的數據特征通過不同網絡獲取,且通過額外的損失約束兩組特征之間的距離,在保證互補特征的差異性基礎上又可以保證對分割任務是有效的。

2.2 多尺度特征融合模塊

為了減少池化操作引起的細節信息丟失問題,研究人員提出了使用空洞卷積代替池化操作[20]。這種空洞卷積與普通卷積不同的地方在于引進了空洞率的思想,在卷積取點時將空洞率作為取點步長。空洞卷積在不增加計算量、不添加網絡層數的基礎上有效擴大感受野。另一種在池化操作上的改進是Zhao 等[21]提出的空間金字塔池化模塊,該模塊對不同核大小卷積得到的多尺度特征進行融合,大幅提升了對過大或者過小目標的分割性能。

結合空洞卷積和多尺度金字塔池化塊的優點,Chen 等[22]提出了一種可以大幅提升分割精度的空洞空間金字塔池化模塊。然而,ASPP 模塊在圖像分割中仍然存在兩個問題:1)在原始空洞率組合下,任意一個空洞卷積對某些點均復發采樣,造成局部信息嚴重丟失,從分割結果上表現為網格效應嚴重,分割結果不完整[23];2)原始ASPP模塊中高達18 的空洞率在遙感圖像提取到的特征中是不適用的,這種空洞率下的卷積提取到的信息在很大的距離上是不相關的。原始輸入圖片的尺寸為 256×256,經過ResNet-50 中的5 次下采樣之后,特征圖尺寸變為 8×8,只需要較小的空洞率即可獲得全局的特征。因此對ASPP 模塊中的空洞率部分的超參做出調整,具體結構如圖4所示。

圖4 多尺度特征融合模塊Fig.4 Multi-scale feature fusion module

由于顯存限制,首先將融合特征用1 ×1卷積進行降維,再經過優化后的ASPP 模塊處理,該特征分別由最大池化(max-pooling)、1 ×1卷積、空洞率為2、4、6 的空洞卷積進行處理,得到5 個多尺度特征圖,并在通道上均有一定的維度減少。最終將多尺度特征統一尺寸之后與原始特征圖進行合并,通過這種融合,可以保留對象的空間上下文和邊界細節,以極小的計算增加獲取更大范圍的感受野,產生更精細的分割結果。

2.3 互補特征學習損失

為了獲得相似的光譜和高程的共同特征,可以簡單地最小化它們的歐氏距離。然而,歐氏距離對不相似的共同特征的異常值很敏感。將兩種模態的共同(互補)特征看作兩個分布的樣本,將問題建模為計算分布之間的距離。為了獲得兩個相似分布的公共特征和不同分布的互補特征:一方面需要衡量兩個分布之間的距離;另一方面,需要將這一距離作為損失函數并約束訓練階段,提取共同特征時要最小化這個損失,相反,提取互補特征時需要最大化該損失。

當前有許多計算分布之間相似性的技術,如熵、互信息或JS、KL 散度等[24]。然而,這些信息論方法依賴于密度估計,或復雜的空間劃分、偏差校正策略,這些策略對于高維數據通常是不可行的。還有一些利用生成對抗的思想,間接最小化分布之間的JS 散度[25]。這種方法需要額外的網絡且難以收斂。

在遷移學習領域中,最大均值差異(MMD)損失[26]常用來衡量多模態特征之間的距離,表現出優異的性能,通過最小化子空間特征的分布差異,從而使源域與目標域的特征分布盡可能相似。我們將MMD 應用在多模態特征融合任務中,一方面要求從兩種模態數據中提取的共同特征分布相同時需要最小化該差異,另一方面提取互補特征時需要最大化該差異。

MMD 的作用效果很大程度上取決于核函數k的選取,不同的核函數會得到不同的結果。Gretton等[27]在兩個測試樣本中提出了基于多核的MMD方法,通過生成基于核族的核函數,多核MMD 可以提高測試能力,并成功地應用于域適應中。目前,以多個不同高斯核的線性組合為核函數的多核MMD 損失已經被集成在pytorch 工具包中。

訓練階段,在batchsize 維度上分組計算特征之間MK-MMD 的無偏估計,以共同特征之間的損失函數d(Sc,Dc)為例:

式中:n為batchsize;Sc和Dc分別為解碼器得到的光譜和高程的共同特征,可以計算出它們互補特征之間的相似性。

在本文的網絡中,期望共同特征Sc和Dc盡可能地相似,而互補特征Ss和Ds期望分布不同。因此,應最小化d(Sc,Dc),同時最大化d(Ss,Ds)。網絡的損失函數為

式中:CEs和 CEd是標簽與網絡輸出之間的像素級交叉熵損失。使用參數 λ平衡像素級損失與互補學習的損失,λ參數由交叉驗證得到。在反向傳播中,從反卷積特征和MK-MMD 距離兩個不同的來源計算了公共特征和互補特征的梯度。

3 實驗分析及結果

3.1 數據集及預處理

為了驗證提出方法的有效性,使用公開的Potsdam 和Vaihingen 數據集進行了實驗測試。這2 個數據集由ISPRS 語義分割委員會提供[28]。這兩個數據集主要覆蓋城市及其周邊地區,均標注了6 個常見類別,包括不透水表面(白色)、建筑物(藍色)、低植被(青色)、樹木(綠色)、汽車(黃色)和背景(紅色),其中背景類較特殊,包括集裝箱、網球場和水池等地物,根據文獻[29]本文將背景忽略。此外,為了防止不精確的邊緣標注對評估模型精度造成的影響,這兩個數據集還提供了用半徑為3 像素的圓盤腐蝕類別邊界的標簽。

Potsdam 是德國的一座歷史名城,有著巨大的建筑和密集的街道。Potsdam 數據集包括地面采樣距離(GSD)為5 cm 的24 幅圖像,包括近紅外、紅色、綠色、藍色和歸一化數字表面模型(nDSM)的5 個通道,分辨率均為6 000×6 000。在實驗中,本文使用了17 幅圖像進行訓練,7 幅圖像進行測試。另外,Vaihingen 是一個小而分散的村莊,Vaihingen 數據集包含3 波段IRRG(紅外、紅色和綠色)光譜圖像和相應的數字表面模型(DSM)。其中,GSD 為9 cm,平均分辨率為2 500×2 500。根據之前的工作[30],本文選擇11 幅圖像進行訓練,其余5 幅圖像進行測試。

在數據預處理中,考慮到GPU 內存有限,使用步長為64 像素的滑動窗口將圖像分割成大小為256×256 的較小塊。為了減少可能出現的過擬合現象,采用4 種形式的數據增強:噪聲干擾(高斯噪聲)、0.8~1.2 倍的隨機非比例縮放、0°~360°的隨機旋轉和90°、180°或270°的隨機翻轉。

3.2 實驗設置

所提出方法使用pytorch 工具庫實現,互補特征學習網絡在兩塊顯存為32 GB 的GTX 3 090 顯卡上訓練,batchsize 設置為16。初始學習率設置為0.001,每10 個epoch 學習率衰減10%。在優化器設置上,采用動量為0.9 的隨機梯度下降進行優化。此外,在訓練階段本文使用沒有腐蝕邊界的標簽,而在計算指標時使用腐蝕邊緣的標簽,以避免不確定的邊緣標注對模型評估的影響。其他實驗細節說明如下。

1)多核MMD 損失設置:使用pytorch 中的多核MMD 損失,其核函數為多個高斯核的線性組合,將核函數個數設置為11,以保證可以區分互補特征與共同特征。

2)Fine-tuning:根據之前的工作[31],網絡模型在ImageNet 及PASCAL VOC 2012 語義分割數據集上的預訓練模型基礎上進行fine-tuning,可以收斂得更快且獲得更精確的結果。因此,本文用backbone 為Resnet-50 的Deeplab V3+模型在PASCAL VOC 2012 數據集上訓練之后,將該Resnet-50 及ASPP 部分的checkpoint 作為預訓練模型。

3)訓練設置:訓練階段,為了避免一開始網絡就將重點放在最小化互補學習損失中而忽略對語義信息的學習,本文先將兩個網絡分開訓練20 個epoch,當兩個網絡都產生較穩定的語義標記輸出后,再將兩個網絡進行聯合訓練。

4)測試設置:測試階段,采用重疊滑窗采樣方法截取預測的小塊圖,獲取預測結果后對于重疊部分取平均值,可以有效糾正拼接邊界的小錯誤,進一步減少拼接帶來的邊界效應。

3.3 實驗結果

為了更好地評估本文提出的互補特征學習網絡的性能,本文與5 種SOTA 方法進行了比較,將這5 種方法分為兩類,即光譜數據網絡和多模態數據融合網絡,前者包括FCN8s[32]、Deeplab v3+[22],后者包括VFuse-Net[33]、DP-DCN[34]、DSMFNet[11]。根據數據集guideline。在本實驗中使用3 個指標全面評估每個網絡的分割質量,分別是總體準確率(OA)、平均F1分數和每個類別的F1分數。在Potsdam 數據集上的實驗結果如表1 所示。

表1 Potsdam 數據集分割精度對比Table 1 Comparison of segmentation accuracies for the Potsdam dataset %

從結果可以看出,所提出的CFL-Net 在OA中達到91.21%,在平均F1分數中達到了92.47%。與DSMFNet 相比,平均OA 與F1分別提高了0.48%和0.87%,相較于SOTA 方法,本文的模型在更加細化的5 個類別上的F1分數都有所提升。

為了更直觀、更清晰地比較本文提出的CFL-Net分割性能,分別選取兩大類分割網絡中性能較好的方法DeeplabV3+、DSMFNet 與本文的結果進行可視化對比。圖5 展示了在Potsdam 數據測試集上3 種網絡在整張圖上分割的結果,從整張圖的分割結果來看,由于在測試時均采用了小步長滑動裁剪的方法,這幾張圖像的分割結果都沒有明顯的邊界效應,相鄰拼接塊之間物體邊界都比較平滑。

圖5 Potsdam 數據集整圖預測結果對比Fig.5 Comparison of the whole graph prediction results for the Potsdam dataset

此外,上述方法在防水表面類別的分割中都表現良好,均有較明顯的道路網,這是由于在Potsdam 數據集中大多防水表面都有高對比度的邊界和可區分的光譜信息。可以看到,CFL-Net的分割結果邊界往往更加精確且光滑,尤其是建筑和草地的邊緣及拐角。此外,對于一些零星的小目標CFL-Net 也能夠實現較精準的分割。

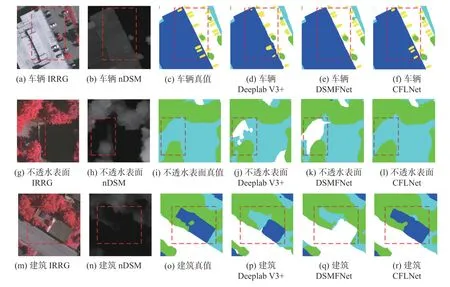

在圖6 中給出了Postdam 數據測試集上更精細的矯正錯誤分類區域的例子,并截取了較小的尺寸以便對比觀察。由圖6 可見,兩棟樓房之間的連廊區域較小,樣本量也十分少,由于陰影、遮擋等因素在光譜上難以區分,因此僅光譜數據輸入的Deeplab V3+網絡的分割結果丟失了連廊區城,DSMFNet 雖然考慮到了高程信息,但簡單地合并兩者信息并不能夠充分利用到多模態信息之間的相似性與互補性,造成對連廊的錯分,將其分割為背景類。本文的CFL-Net 在該區域的分割上表現出良好的性能。圖6 中,nDSM 信息不能夠完全提供滿足對高低植被分類的高程信息時,CFL-Net 也能夠充分利用光譜信息,并得到了比較好的分割結果。

圖6 Potsdam 數據集裁剪的小區域分割結果對比Fig.6 Comparison of small region segmentation results for the Potsdam dataset cropping

本文在Vaihingen 數據集上進行了同樣的測 試,實驗結果如表2 所示。

表2 Vaihingen 數據集分割精度對比Table 2 Comparison of segmentation accuracies for the Vaihingen dataset %

從圖7 中裁切的可視化結果可以看出,本文模型針對于之前提到的問題有了很好的解決,在提取融合互補特征之后,多模態輸入網絡模型不再偏向于某單一模態數據提供的信息,而是針對語義分割任務以及多模態特征之間的關系選擇性地從多模態數據中提取特征。

圖7 Vaihingen 數據集裁剪的小區域分割結果對比Fig.7 Comparison of small region segmentation results for Vaihingen dataset cropping

通過圖7 可以發現,在對一些低矮的建筑物,以及光譜上表現為植被的建筑物進行分類時,本文模型表現出很好的性能,證明該模型具有較好魯棒性。整體來說,本文提出的網絡具有更好的能力區分具有相似光譜性能的物體,如不透水表面和建筑物、低植被和樹木。同時又可以避免陷入對某一種模態信息的過分信任,減少可能的誤判。

從得到的結果來看,Vaihingen 數據集上CFLNet 的OA 為90.83%,平均F1為88.69%,分別比最近的競爭方法DSMFNet 高0.78%和0.67%。盡管Vaihingen 數據集上的精度集小于Potsdam 數據集,但本文提出的方法仍然能夠獲得更好的性能。Vaihingen 數據集中整張圖像分割的可視化結果如圖4 所示。從各個類別的分割結果來看,本文提出的方法相較于其他方法可以獲得更加清晰的地物輪廓,對于形狀多變、紋理特征復雜、結構復雜的建筑物類別分割得也更加完整。另外,對于一些面積較小的目標,如車輛、單體植被等,本文的分割方法在相鄰的小目標之間沒有粘連現象。

3.4 消融實驗

本文對所提出的網絡進行了分解和組合,利用OA 和F1-score 指標驗證了每個模塊的有效性。消融實驗在Vaihengen 數據集上完成。首先,為了驗證互補特征學習的有效性,分別單獨訓練了完整的光譜分支與高程分支,對得到的模型進行驗證。其次,為了驗證多核MMD 的有效性,本文在原有網絡框架基礎上,使用歐氏距離以及余弦相似度衡量特征之間的距離,并設置對應的損失函數參與訓練。采用IRRG-branch 表示光譜分支,DSM-branch 表示高程分支,dual path(DP)表示將兩個分支聯合訓練,DP+ED 與DP+consine 分別表示將歐氏距離與余弦相似度作為互補特征約束的雙分支網絡,最終實驗結果如表3所示。

表3 消融實驗結果Table 3 Results of the ablation experiments %

由表3 可得出結論:單一DSM 分支由于缺少車輛、路面等地物的細節信息,精度最低。同樣,單一光譜分支雖然細節信息較多,但對于光譜上表現相似的地物識別能力有限,仍然無法得到較高的精度。聯合訓練后,歐氏距離和余弦相似度的表示能力有限,無法完全衡量分布之間的距離。本文提出的多核MMD 方法取得了最好的結果,有效性最好。

4 結束語

本文對目前主流多模態數據融合遙感圖像語義分割存在的問題進行了分析,針對該問題提出了基于互補特征學習的多模態數據語義分割網絡。一方面,本文從互補特征約束中設計損失函數參與網絡訓練,使多模態數據在特征提取過程中可以相互學習,并將它們建模為共同特征與互補特征。另一方面,本文將一種模態數據提取到的互補特征補充給另外一種模態,在單一模態特征不足以完成語義重建時,另一模態中提取到的互補特征可以對其進行補充,產生更魯棒的融合特征。