基于機器視覺的金屬絲網缺陷識別方法

陳東亮,師素雙,房立慶,蔡猛,師占群

基于機器視覺的金屬絲網缺陷識別方法

陳東亮1,師素雙1,房立慶1,蔡猛2,師占群1

(1.河北工業大學 機械工程學院,天津 300130;2.中國民航大學 機械工程學院,天津 300300)

提升金屬絲網的檢測效率與檢測精度。提出一種應用于金屬絲網表面缺陷識別的EfficientNetV2改進網絡,首先更改了網絡的骨干結構,在特征提取模塊前后分別引入通道拆分與通道轉換等操作,以增大網絡容量,提高特征利用率;其次重新設計網絡的分類器,通過對提取的高級語義信息進行逐層分步壓縮,以減小特征損失,提高分類精度;最后搭建圖像采集系統,構造金屬絲網缺陷數據集。實驗結果表明,文中改進的網絡模型在數據集上的準確率、精確度和特異度分別達到99.43%、99.42%和99.88%,圖像識別耗時為27.5 ms,增強了缺陷識別效果。該方法具有較高的準確率,在金屬絲網缺陷檢測上具有較好的實用性,也可為其他類似產品的缺陷檢測提供參考。

缺陷檢測;深度學習;EfficientNetV2;金屬絲網;遷移學習

產品質量至關重要,它代表著企業的信譽,只有高質量的產品才能長期在市場上取勝[1]。在包裝行業,金屬絲網作為熱收縮包裝機的重要組成部分,其質量影響產品的包裝效果,因此,對金屬絲網表面缺陷精準識別是產品生產過程中不可或缺的一環,對保證金屬絲網的生產質量具有重要意義。

目前,國內大多采用人工目測的方式對金屬絲網進行缺陷檢測與識別,不僅檢測效率低、強度高,而且難以滿足高效的生產需求。隨著人工智能在計算機視覺領域的廣泛應用,機器學習和深度學習被廣泛應用于物體檢測與圖像分類[2]。針對絲網的早期檢測研究[3],前人大多采用圖像處理與機器學習的方法對絲網進行質量檢測,雷洋等[4]結合現代圖像處理,提出了一種試驗篩網經絲和緯絲夾角的自動檢測方法。王延年等[5]提出了一種基于傅里葉變換和改進閾值分割的印刷絲網布疵點的檢測算法,實現了對常見缺陷的快速檢測。許悅等[6]提出了一種網片缺陷在線檢測及分類方法,實現了對3種缺陷進行分類。雖然傳統的機器學習方法有效地避免了人工檢測的弊端,但是上述的方法都需要針對不同的任務手工制作不同的特征,因此模型的泛化性能低。

如今,卷積神經網絡已廣泛應用于圖像分類、對象檢測和圖像分割等任務[7]。相比于傳統的圖像處理方法,卷積神經網絡可以發揮其自動學習的優勢,避免了復雜的手工設計特征,在工業[8-9]、農業[10-11]、醫療產業[12-13]等領域均有所應用。基于此,Li等[14]設計了一種檢測織物缺陷的網絡結構,與主流網絡相比,模型小、分類準確度高。Chakraborty等[15]構造了印花織物缺陷庫,并應用深度卷積神經網絡對印花織物進行缺陷檢測。He等[16]提出了一種新的基于卷積神經網絡的分層學習框架,用于熱軋缺陷分類。為了實現可靠的分類,Habibpour等[17]引入了不確定性估計,提出了鑄件缺陷檢測的不確定性感知深度學習框架,增強了鑄件生產質量的保證。考慮到絲網缺陷的多樣性、變化性以及訓練數據相對較少等情況,為加快網絡的擬合速度,可以使用遷移學習[18]進行網絡訓練。Cheng等[19]提出了一種新的基于遷移學習的表面缺陷檢測方法,有效地解決了缺陷類別不平衡分布的問題。Ragb等[20]提出了一種基于深度卷積神經網絡的算法來幫助從超聲圖像中準確識別乳腺癌,并通過遷移學習加快了收斂速度。Hohlfeld等[21]針對啤酒瓶分類問題提出了一種深度學習模型,達到了100%的準確率。盡管深度學習在公共數據集以及工業場景的分類問題上取得了很好的結果[16],但是尚未發現其在金屬絲網缺陷檢測中的應用。

為此,文中在EfficientNetV2[22]網絡的基礎上,提出一種應用于金屬絲網表面缺陷識別的方法。通過加入通道拆分與通道轉換等結構,對網絡骨干進行重新布局,以增強網絡對特征的提取能力。調整網絡分類器的結構,以減小特征損失的同時增強網絡分類精度。搭建圖像采集系統,構建金屬絲網缺陷數據集并進行相應實驗,獲得較好的識別效果。

1 網絡模型

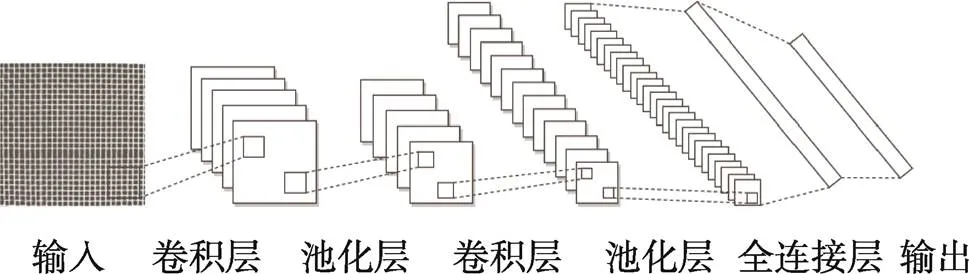

圖1為典型的卷積神經網絡結構,其中卷積層的數學表達式為:

式中:為輸出;f、k和b分別為第個通道上的特征圖、卷積核與偏差;*為卷積操作。通常使用Relu作為激活函數,表達式為:

式中:為卷積層的輸出。最大池化層數學表達式為:

式中:為區域內的最大值;R為第(,)個池化區域。

由于金屬絲網表面缺陷復雜多樣,簡單的卷積神經網絡結構對其進行缺陷識別的效果不佳,故提出了一種基于EfficientNetV2網絡的改進模型。

圖1 典型卷積神經網絡結構

1.1 EfficientNetV2網絡模型介紹

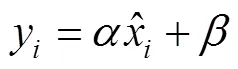

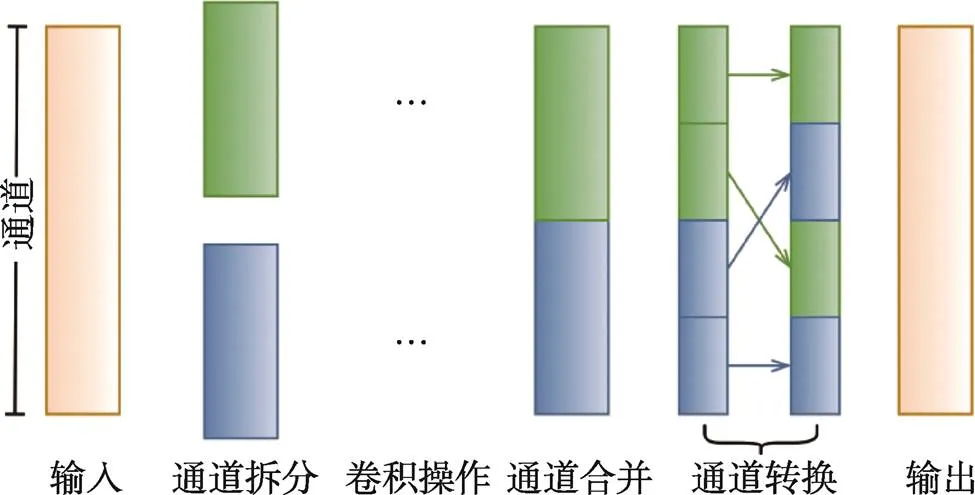

EfficientNetV2網絡的基本結構見圖2a,該網絡由大量的倒殘差結構組成。圖2b為MBConv模塊,該模塊通過點卷積、深度卷積、通道注意力機制等卷積運算,對輸入的特征圖進行增維、特征提取、自適應通道權重、降維等操作,不僅減少了網絡的運算量,也增強了網絡的特征提取性能。此外,當深度卷積步長為1且倒殘差結構中輸入與輸出維度相同時,主分支與捷徑分支的和將作為下一步操作的輸入。雖然深度卷積理論上計算量很小,但在淺層網絡中應用會使訓練速度變慢,故引入Fused–MBConv結構,見圖2c。該結構將MBConv模塊中的深度卷積和點卷積替換成了卷積核為3×3的卷積層,通過此操作可以提取更多細節信息并提升準確率。倒殘差結構中的SE為簡單有效的注意力模塊,結構見圖3。該模塊通過壓縮操作,將特征圖壓縮為1×1×向量,在經過激勵操作后得到各通道權重,最后原有特征向量與通道權重相乘,以突出不同通道的重要性。

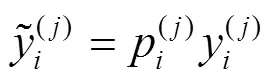

此外,為了避免模型過擬合,在倒殘差結構中引入Dropout和批規范化(Batch Normalization,BN)策略。Dropout以一定概率隨機失活神經元,得到更加精簡的網絡模型。各個神經節點的輸入為:

式中:以漸進學習方法進行賦值。

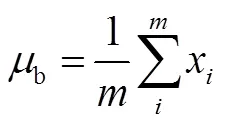

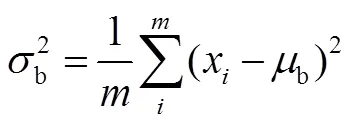

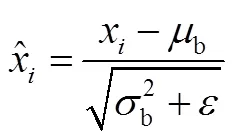

BN策略就是對數據做批規范化處理,以緩解梯度消失現象,加快網絡收斂速度。算法表達式為:

式中:和為可學習的參數;為趨近于0的常數;y為x處理后的值。

圖2 EfficientNetV2結構

Fig.2 EfficientNetV2 structure

注:為Fused–MBConv;為MBConv。

圖3 SE注意力模塊

1.2 網絡骨干改進

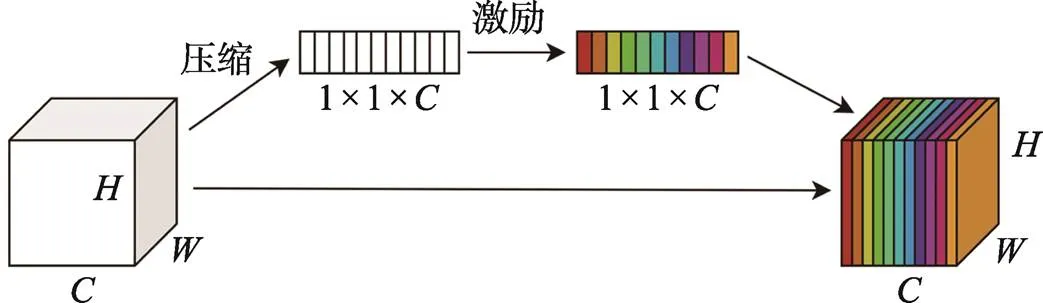

EfficientNetV2網絡骨干由圖2b、c所示模塊堆疊而成,特征提取模塊中雖然存在倒殘差結構,但整個網絡深度過深,以至于提取的特征信息利用效果不佳,并且網絡存在密集卷積以及特征圖元素相加等操作,導致運算成本增加,影響模型精度,因此,為提高特征的利用率,增強網絡的運行速度與識別精度,對網絡骨干進行改進。首先在各個特征提取模塊之前增加了通道拆分操作,將特征通道拆分為2個分支,一個作為捷徑分支,另一個作為主分支進行卷積操作提取特征信息。其中一半的特征通道直接連到下一模塊,從而實現特征重用以獲得較高的精度。之后將2個分支輸出的特征圖沿著通道方向進行拼接,代替了特征圖元素相加的操作,從而減小模型運算成本、提高運行速度。最后應用通道轉換操作,即將合并的2個分支通道各劃分為若干個子組,然后將不同子組按順序進行填充,以實現各通道之間的信息交流。特征圖通道操作流程見圖4。改進后的特征提取模塊見圖5a、b,其中3×3卷積步距全為1。空間下采樣模塊見圖5c,特征圖經過2個卷積分支分別進行特征提取,之后再合并2個分支特征,其中3×3卷積步距全為2。該模塊應用在特征提取模塊之前,使輸入特征圖寬高減半、通道擴增,達到下采樣的效果。

圖4 通道操作流程

圖5 改進后各模塊結構

1.3 分類器改進

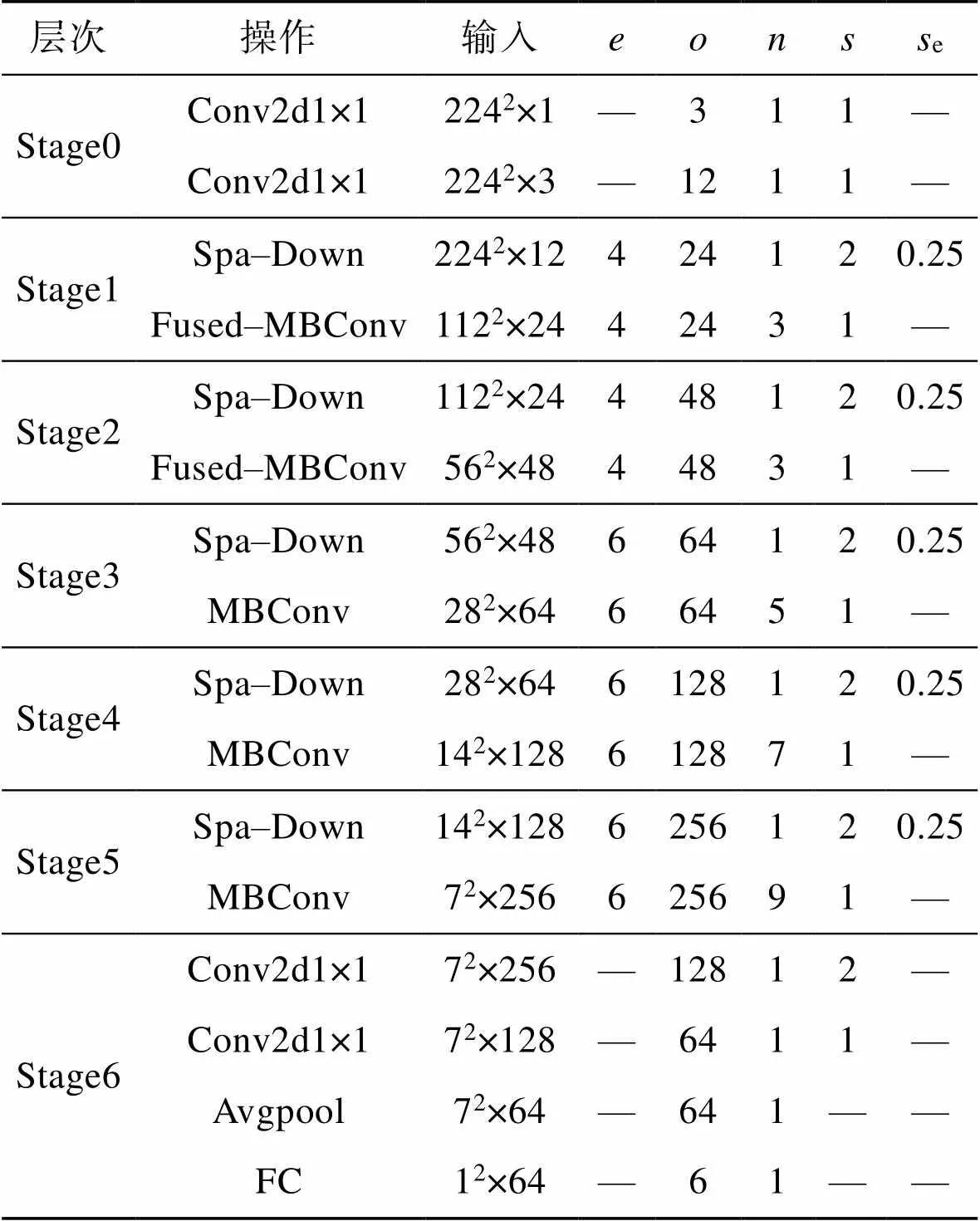

EfficientNetV2通過網絡骨干提取目標的高級語義信息,并根據信息利用分類器對目標進行分類識別。通常在遷移學習過程中只需修改分類器輸出的類別個數便可直接應用。由于EfficientNetV2網絡針對的是ImageNet[23]數據集上的1 000多種類別,而文中僅針對6種金屬絲網目標。如果直接修改分類器輸出的類別數量,可能會損失高層網絡的語義信息,進而影響分類精度,因此,為了增強網絡對金屬絲網缺陷識別的穩定性,將網絡的分類器進行重新設計,具體結構見表1。

表1 分類器參數

Tab.1 Classifier parameters

由于骨干網絡提取的特征維度與分類器輸出的類別差異較大,首先使用2個卷積核大小為1×1的卷積層對提取的特征進行分步降維,避免了數據因降維較大而造成語義信息的丟失。然后通過全局池化層對特征圖尺寸進行壓縮,進一步提煉語義信息。最后應用全連接層進行分類輸出。

1.4 改進后網絡總體結構

改進后網絡結構見表2,其中Conv2d、Avgpool和FC分別為卷積、最大池化和全連接操作,Fused–MBConv和MBConv為特征提取模塊,Spa–Down為空間下采樣模塊,為通道拓展因子,為輸出通道,為當前層的操作重復次數,為步距,e為SE模塊縮放因子。

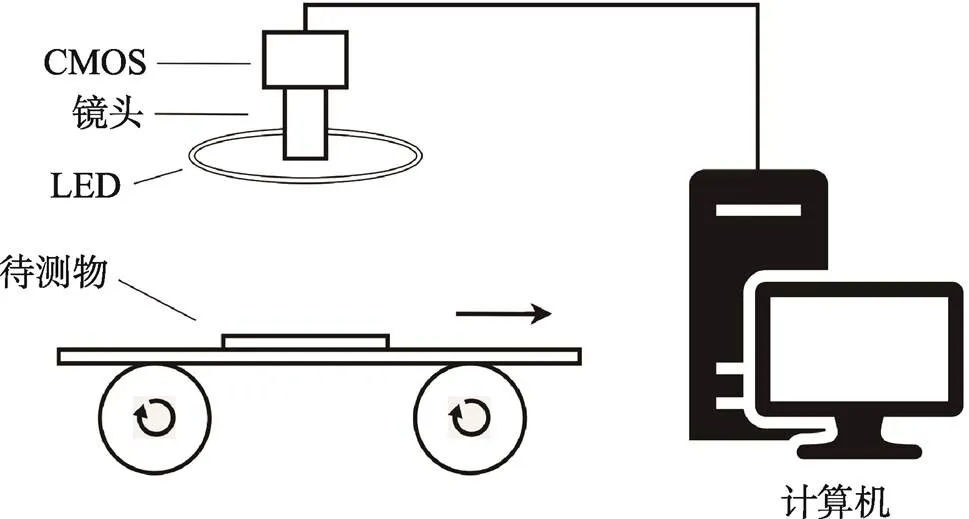

2 圖像采集設備

文中以目數為10、絲徑為0.5 mm的不銹鋼方孔網為采集對象。絲網以0.4 m/min的速度打卷包裝,并在打包之前進行圖像采集。金屬絲網圖像采集設備由工業相機、照明系統、黑色橡膠板、計算機組成,見圖6。工業相機與絲網的視距為20 cm,通過外部輸入的信號來控制相機對絲網進行連續采集。為了能夠保證連續采集圖像的精度要求,最終選擇維視圖像的Mako G–223 CMOS工業相機。該相機具有2 048×1 088的分辨率,最大幀速率為50幀/s,有效工作溫度范圍為?10~70 ℃,能夠滿足實際使用要求,并使用千兆以太網連接到計算機進行數據傳輸。照明系統由環形LED燈組成,由于金屬絲網表面易反光,采用光照均勻的環形光源能夠避免出現局部高光,從而獲得高質量的金屬絲網圖像。

表2 網絡結構

Tab.2 Network structure

圖6 圖像采集設備示意圖

3 實驗設計與分析

實驗硬件環境為:Intel Cote i7?10700F CPU、16 GB RAM、Nvidia GeForce RTX 3080 Ti 12 G GPU。軟件環境為:Win10專業版操作系統、Python 3.7、CUDA 11.4、cuDNN 11.4、Pytorch1.7。

3.1 金屬絲網缺陷數據集

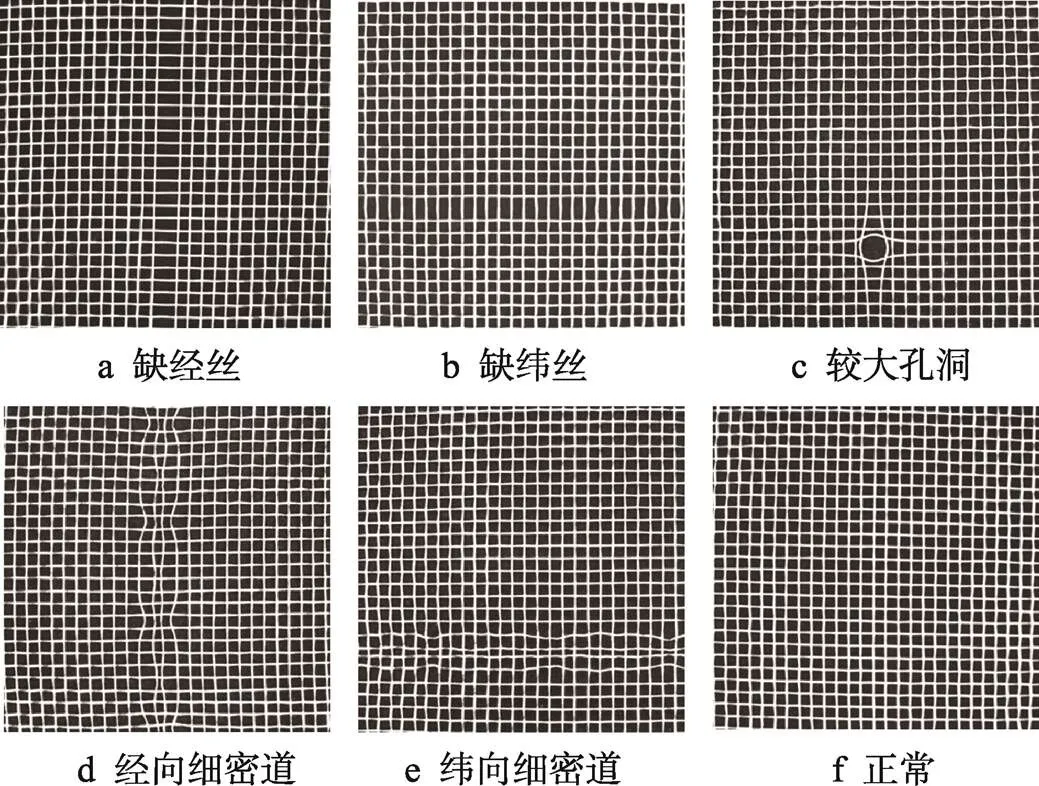

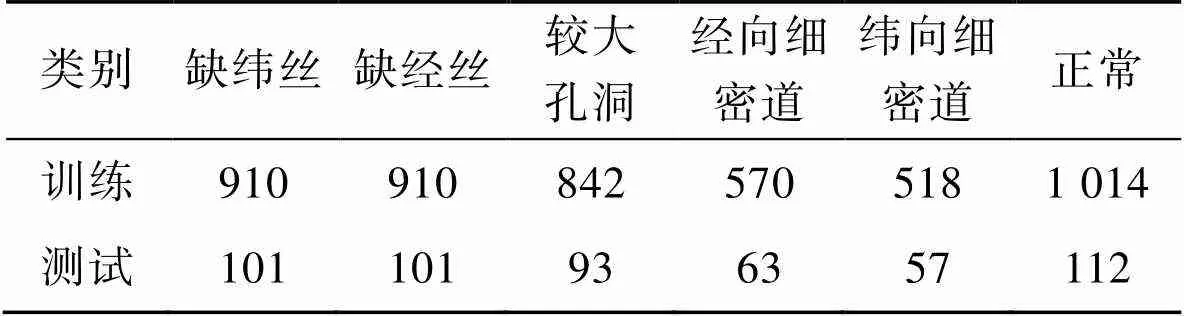

由于有關金屬絲網表面缺陷的公共數據集較少,因此文中創建了一個目標缺陷數據集,所有圖像均通過第3節介紹的圖像采集系統進行收集。數據集共涉及6類目標樣本,1類正常樣本和5類缺陷樣本,加入正常樣本主要是為了提高網絡模型對缺陷樣本的識別能力。圖7顯示了金屬絲網的部分圖像,其中5種缺陷類型分別為缺經絲、缺緯絲、較大孔洞、經向細密道、緯向細密道。在圖7中,圖7a與圖7b、圖7d與圖7e缺陷非常相似,但在方向上有所差異,因此作為不同缺陷類型進行處理。本次實驗共包含5 294張金屬絲網圖像,隨機選擇其中4 767張樣本圖像作為訓練集,其余527張樣本圖像作為測試集。各種缺陷類型的數量見表3。

圖7 絲網圖像

表3 絲網樣本數量

Tab.3 Quantity of wire mesh samples

3.2 實驗設置

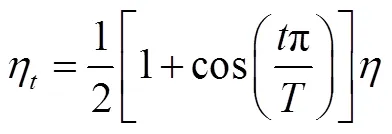

所有分類網絡均訓練500個周期。在訓練過程中采用隨機梯度下降(SGD)優化器更新網絡參數,其中衰減因子、動量分別設為0.01、0.9,batch_size設為16,并遵循余弦學習率衰減函數將學習率從初始值0.01降為0,學習率計算公式為:

式中:為總批次數量;為單批次數量;為初始學習率。

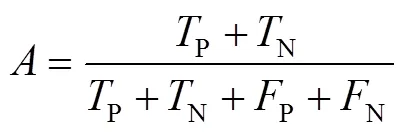

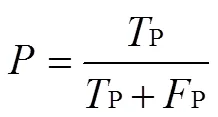

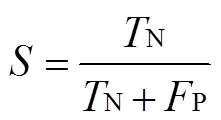

網絡模型的有效性可以通過各種標準的性能指標進行評估,綜合考慮最終選擇準確率、精確度、特異度作為評判依據。各指標定義如下:

式中:、和分別為待評估模型的準確率、精確度和特異度;P、P、N和N分別為真陽性、假陽性、真陰性和假陰性的百分比。其中真陽性表示預測是正樣本,實際也是正樣本;假陽性表示預測是正樣本,實際是負樣本;真陰性表示預測是負樣本,實際也是負樣本;假陰性表示預測是負樣本,實際是正樣本。例如,缺絲徑為正樣本,則非缺絲徑全為負樣本,其他類別以此類推。

3.3 實驗結果與分析

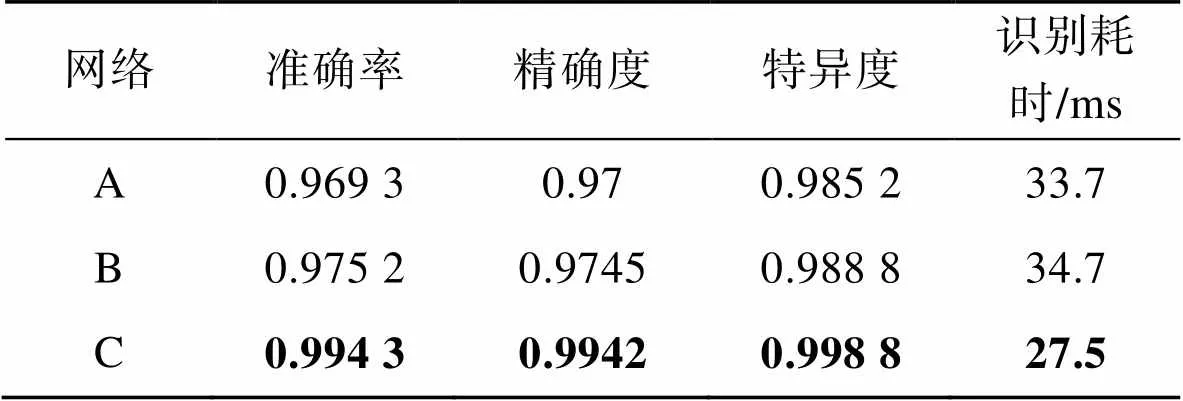

網絡模型改進前后性能指標對比見表4。

表4 不同方法的評估結果

Tab.4 Evaluation results of different methods

注:A為原始EfficientNetV2網絡;B為使用文中分類器的EfficientNetV2網絡;C為使用文中分類器和骨干的EfficientNetV2網絡。

由表4可知,改進分類器的網絡與原始網絡相比準確率提升了0.6%、精確度提升了0.46%、特異度提升了0.36%,單張圖像的識別耗時提升了2.8%,由于改進后的分類器添加了一些卷積操作,從而增加了識別耗時。由此可見新的分類器對網絡骨干提取的高級語義信息更加敏感,提高了網絡對金屬絲網表面缺陷的識別精度,卻增加了識別時間;同時相較于原始網絡,改進分類器和骨干的網絡的準確率、精確度和特異度分別提高了2.5%、2.4%和1.4%,識別耗時降低了18.3%;與僅改進分類器的網絡相比,改進分類器和骨干的網絡的準確率、精確度和特異度分別提高了1.9%、2%和1%,識別耗時降低了20.7%。由此可知改進后的網絡能夠更好地提取特征語義信息,進一步增強了網絡缺陷的識別效果。

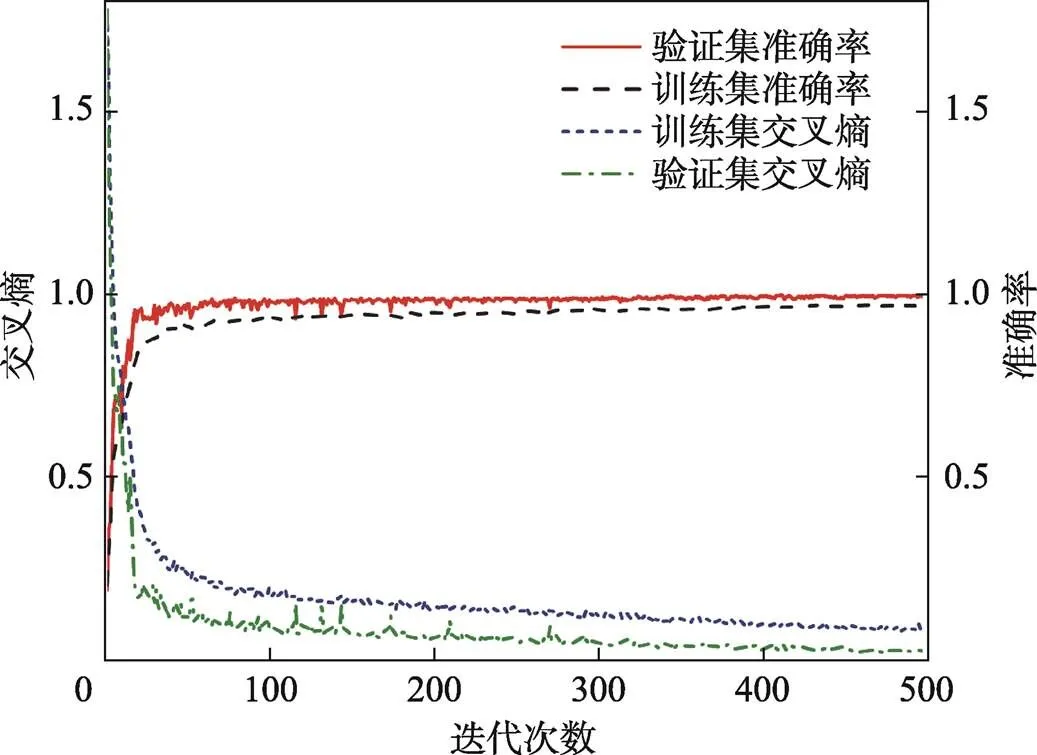

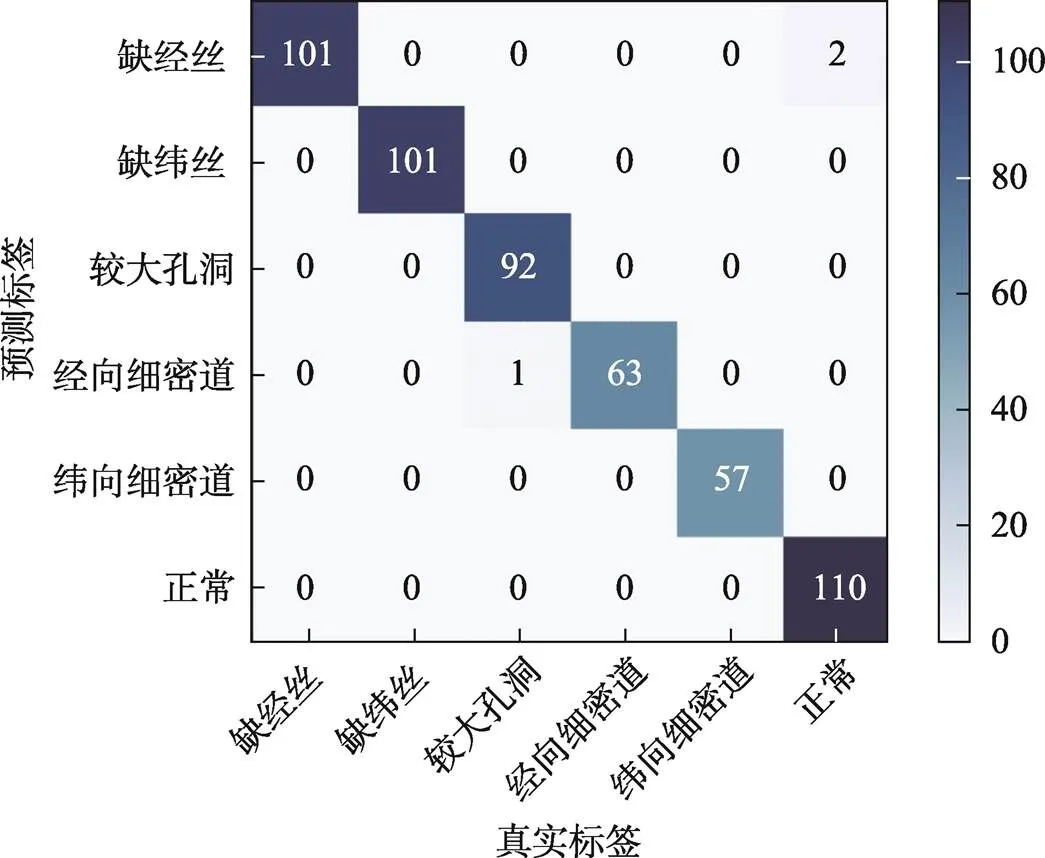

改進的網絡模型訓練結果見圖8。隨著迭代的進行,在200步之前網絡模型總交叉熵損失降幅較大,在200~400步之間緩慢下降,之后模型便趨于收斂,最終在訓練集和驗證集上的準確率分別達到97.8%和99.4%。觀察模型在數據集上的曲線可知,改進后的網絡快速收斂,沒有出現明顯的過擬合現象。圖9為模型在測試集上的混淆矩陣,由圖9可知改進后的模型僅3例樣本出現誤檢,表明模型檢測效果良好、誤檢率低。

綜上所述,改進后的EfficientNetV2網絡模型提高了特征的利用率,增強了網絡識別精度,同時降低了模型單張圖像的識別耗時。

圖8 網絡模型曲線

圖9 測試集混淆矩陣

3.4 不同模型對比實驗

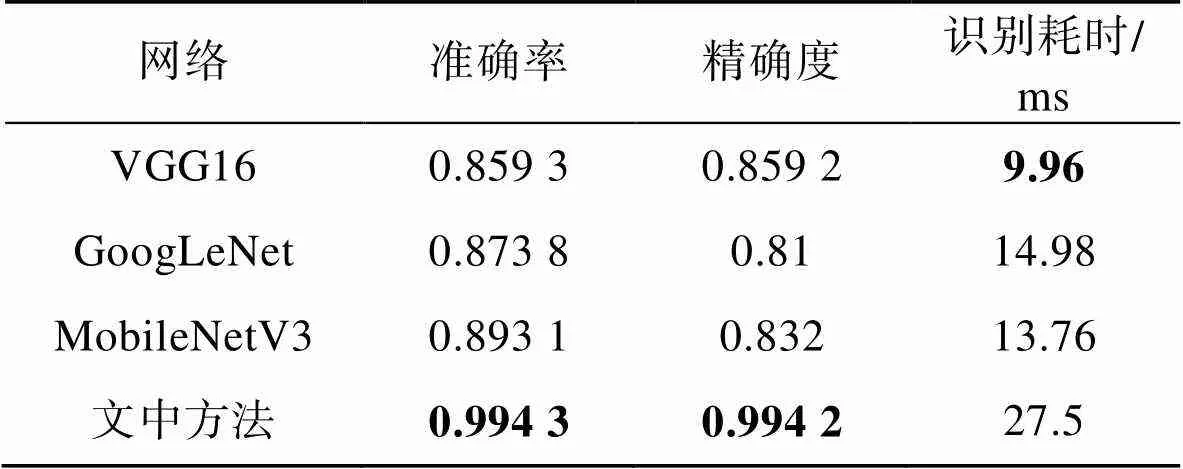

為了進一步展示文中改進模型的實驗結果,在相同的硬件配置下,分別使用VGG、GoogLeNet和MobileNetV3網絡模型在同一數據集上進行對比。其中VGG用多個小的卷積核來代替大尺度卷積核,以減少網絡參數增大感受野。GoogLeNet網絡引入Inception結構充分發揮其融合不同尺度特征信息的優點。MobileNetV3網絡因其體積小、模型復雜度低,被廣泛部署在移動設備上。以上3種模型在圖像分類任務中性能優異、應用廣泛,因此作為本次實驗的對比方法。表5為不同分類模型的識別效果。

表5 不同模型的識別效果

Tab.5 Recognition effects of different models

由表5可知,文中改進的網絡模型在準確率方面相較于VGG、GoogLeNet和MobileNetV3分別提升了13.5%、12.1%和10.2%,在精確度方面分別提升了13.6%、18.5%和16.3%。由于改進的網絡模型深度較深,從而導致單張圖像的識別耗時大幅增加。考慮到產品的生產速度為0.4 m/min,而文中方法的單張圖像識別耗時為27.5 ms,符合實際的工業需求。綜上所知,文中方法在識別精度上具有較大優勢,能夠滿足實際檢測需求。

4 結語

文中以金屬絲網為對象,研究了基于機器視覺的缺陷檢測方法,在EfficientNetV2網絡的基礎上提出了一種新的改進網絡,并取得了較好的識別效果。主要結論如下:

1)在網絡模型骨干中引入通道拆分與通道轉換操作可以增強各個通道之間的信息交流、擴大網絡模型的容量,并在一定程度上提高了模型的特征學習能力。

2)在分類器中逐層有序地降低特征的維度,可以有效減少高層語義信息的丟失,提高模型分類精度。

3)通過自主構建的缺陷數據集進行網絡訓練,結果表明模型缺陷識別能力良好、準確率較高,能夠滿足實際檢測需求。

由于金屬絲網生產環境復雜可能會產生新的缺陷類型,后續會采集更多的缺陷圖像進行數據擴增,用以優化網絡模型,從而更好地將文中改進的模型應用于金屬絲網表面缺陷檢測。

[1] JING J, WANG Z, RTSCH M, et al. Mobile-Unet: An Efficient Convolutional Neural Network for Fabric Defect Detection[J]. Textile Research Journal, 2020, 38(1): 142-158.

[2] YANG D M, CUI Y R, YU Z Y, et al. Deep Learning Based Steel Pipe Weld Defect Detection[J]. AppliedArtificial Intelligence, 2021, 35(3): 1237-1249.

[3] 王曉飛, 裘祖榮, 楊聰, 等. 基于影像測量儀的試驗篩自動測量方法[J]. 數據采集與處理, 2013, 28(2): 257-260.

WANG Xiao-fei, QIU Zu-rong, YANG Cong, et al. Calibration Method for Test Sieves Based on Video Measuring Machine[J]. Journal of Data Acquisition & Processing, 2013, 28(2): 257-260.

[4] 雷洋, 張建正. 一種試驗篩網孔角度的自動檢測方法[J]. 華東理工大學學報(自然科學版), 2014, 40(3): 315-320.

LEI Yang, ZHANG Jian-zheng. An Automatic Angular Measurement Algorithm of Mesh of Test Sieve[J]. Journal of East China University of Science and Technology (Natural Science Edition), 2014, 40(3): 315-320.

[5] 王延年, 楊萬里. 一種改進的印刷絲網布疵點快速檢測算法[J]. 國外電子測量技術, 2017, 36(1): 35-37.

WANG Yan-nian, YANG Wan-li. Improved Fast Printing Mesh Fabric Defect Detection Method[J]. Foreign Electronic Measurement Technology, 2017, 36(1): 35-37.

[6] 顧寄南, 唐良穎, 許悅, 等. 機器視覺在網片缺陷檢測與分類中的應用[J]. 機械設計與制造, 2019(S1): 47-49.

GU Ji-nan, TANG Liang-ying, XU Yue, et al. Application of Machine Vision in Detection and Classification of Mesh Defects[J]. Machinery Design & Manufacture, 2019(S1): 47-49.

[7] LU Yang. Artificial Intelligence: A Survey on Evolution, Models, Applications and Future Trends[J]. Journal of Management Analytics, 2019, 6(1): 1-29.

[8] CHEON S, LEE Han-kang, KIM C O, et al. Convolutional Neural Network for Wafer Surface Defect Classification and the Detection of Unknown Defect Class[J]. IEEE Transactions on Semiconductor Manufacturing, 2019, 32(2): 163-170.

[9] KANG G, GAO S, YU L, et al. Deep Architecture for High-Speed Railway InsulatorSurface Defect Detection: Denoising Autoencoder With Multitask Learning[J]. IEEE Transactions on Instrumentation and Measurement, 2019, 68(8): 2679-2690.

[10] HASAN A S M M, SOHEL F, DIEPEVEEN D, et al. A Survey of Deep Learning Techniques for Weed Detection from Images[J]. Computers and Electronics in Agriculture, 2021,184(5): 1067-1084.

[11] ANDREASEN C. Deep Neural Networks to Detect Weeds from Crops in AgriculturalEnvironments in Real-Time: A Review[J]. Remote Sensing, 2021, 13(21): 44-86.

[12] LOU An-ge, GUAN Shu-yue, LOEW M. CFPNet-M: A Light-Weight Encoder-Decoder Based Network for Multimodal Biomedical Image Real-Time Segmentation[J]. Electrical Engineering and Systems Science, 2021, 5(4): 31-42.

[13] XIE Y, ZHANG J, SHEN C, et al. CoTr: Efficiently Bridging CNN and Transformer for 3D Medical Image Segmentation[J]. Computers and Electronics in Agriculture, 2021, 3(3): 24-37.

[14] LI Y, ZHANG D, LEE D J. Automatic Fabric Defect Detection with a Wide-and-Compact Network[J]. Neurocomputing, 2019, 329(1): 329-338.

[15] CHAKRABORTY S, MOORE M, PARRILLO- CHAPMAN L. Automatic Defect Detection of Print Fabric Using Convolutional Neural Network[J]. ArXiv, 2021, 13(20): 325-337.

[16] HE D, XU K, WANG D. Design of Multi-Scale Receptive Field Convolutional Neural Network for Surface Inspection of Hot Rolled Steels[J]. Image and Vision Computing, 2019, 89(1): 12-20.

[17] HABIBPOUR M, GHAROUN H, TAJALLY A, et al. An Uncertainty-Aware Deep Learning Framework for Defect Detection in Casting Products[J]. ArXiv, 2021, 11(6): 43-52.

[18] YOSINSKI J, CLUNE J, BENGIO Y, et al. How Transferable are Features in Deep Neural Networks?[J]. Advances in Neural Information Processing Systems, 2014, 45(5): 3320-3328.

[19] CHENG J, GOU B, LIU J, et al. TL-SDD: A Transfer Learning-Based Method for Surface DefectDetection with Few Samples[C]// 2021 7th International Conference on Big Data Computing and Communications (BigCom), 2021: 136-143.

[20] RAGB H, ALI R, JERA E, et al. Convolutional Neural Network Based on Transfer Learning for Breast Cancer Screening[J]. ArXiv, 2021, 16(6): 16-25.

[21] HOHLFELD P, OSTERMEIER T, BRANDL D. Classification of Beer Bottles Using Object Detection and Transfer Learning[J]. arXiv, 2022, 3(7): 91-96.

[22] TAN MINGXING, LE Q V. EfficientNetV2: Smaller Models and Faster Training[J]. ArXiv, 2021, 4(6): 298-309.

[23] JIA D, WEI D, SOCHER R, et al. ImageNet: A Large-Scale Hierarchical Image DataBase[C]// Computer Vision and Pattern Recognition, Miami FL USA, 2009: 248-255.

Defect Recognition Method of Wire Mesh Based on Machine Vision

CHEN Dong-liang1, SHI Su-shuang1, FANG Li-qing1, CAI Meng2, SHI Zhan-qun1

(1. School of Mechanical Engineering, Hebei University of Technology, Tianjin 300130, China; 2. School of Mechanical Engineering, China Civil Aviation University, Tianjin 300300, China)

The work aims to improve the detection efficiency and accuracy of wire mesh. An improved network EfficientNetV2 for wire mesh surface defect recognition was proposed. Firstly, the backbone structure of the network was changed, and operations such as channel splitting and channel conversion were introduced before and after the feature extraction module to increase network capacity and improve feature utilization. Secondly, the classifier of the network was redesigned, and the extracted high-level semantic information was compressed layer by layer to reduce the feature loss and improve the classification accuracy. Finally, an image acquisition system was built to construct a wire mesh defect data set. According to the experimental results, the accuracy, precision and specificity of the improved network model on the data set were 99.43%, 99.42% and 99.88% respectively, and the image recognition time was 27.5 ms, which enhanced the defect recognition effect. The method has high accuracy and good practicability in wire mesh defect detection, and can also provide reference for defect detection of other similar products.

defect detection; deep learning; EfficientNetV2; wire mesh; transfer learning

TP391.4

A

1001-3563(2023)03-0164-08

10.19554/j.cnki.1001-3563.2023.03.020

2022?04?13

陳東亮(1996—),男,碩士生,主攻機電系統智能檢測。

師占群(1963—),男,博士,教授,主要研究方向為智能診斷。

責任編輯:曾鈺嬋