通道注意力引導(dǎo)的空洞卷積神經(jīng)網(wǎng)絡(luò)圖像去噪

孫光靈,彭欣儀

(1.安徽建筑大學(xué) 電子與信息工程學(xué)院,安徽 合肥 230601;2.合肥工業(yè)大學(xué) 智能互聯(lián)系統(tǒng)安徽省實驗室,安徽 合肥 230009)

圖像去噪是視覺應(yīng)用和圖像處理領(lǐng)域中的典型問題,也是研究熱點之一。許多圖像都存在部分細(xì)節(jié)丟失,圖像質(zhì)量下降的問題。高效的圖像去噪算法在去除噪聲的同時,保證被處理圖像的結(jié)構(gòu)信息不被改變,從而有助于圖像分類、圖像分割等其他圖像處理任務(wù),進(jìn)一步運用于遙感、醫(yī)療成像、監(jiān)控等領(lǐng)域。典型的圖像去噪算法所應(yīng)用的模型y,是由不加噪聲的圖像x和噪聲水平n相加組合而成,去噪的最終目的是從y中推算出潛在的干凈圖像x。從貝葉斯的角度,給定似然的圖像先驗是克服不良去噪問題的關(guān)鍵。受這一事實的啟發(fā),ZHA等[1]充分利用稀疏表示的固有去噪特征這一特性,提高去噪性能并降低計算成本。用圖像的稀疏性質(zhì)對其結(jié)構(gòu)信息進(jìn)行表示[2],經(jīng)典的相關(guān)算法有K-SVD算法[3]、BM3D算法[4]、OMP算法[5]。由于圖像去噪的實際應(yīng)用場景不斷增加,去噪任務(wù)面臨的現(xiàn)實需求更加復(fù)雜多變,但是上述算法功能有限,不能滿足當(dāng)前圖像去噪的需求。

隨著各類計算機(jī)性能和算力的增強(qiáng),研究人員把深度學(xué)習(xí)的方法逐漸引入圖像去噪領(lǐng)域。ZHANG等[6]首先提出了一種用于去噪的卷積神經(jīng)網(wǎng)絡(luò)(DnCNN),包括殘差學(xué)習(xí)(RL)[7]和批處理(BN)[8]以恢復(fù)破裂的圖像。深層遞歸殘留網(wǎng)絡(luò)(DRRN)[9]利用全局和局部RL技術(shù)來增強(qiáng)受過訓(xùn)練的模型在圖像恢復(fù)中的表示能力。ZHANG等[10]提出了一個用于圖像去噪的FFDNET方法,其將噪聲水平與噪聲圖像作為聯(lián)合輸入,并訓(xùn)練一種模型以在不同噪聲水平下處理噪聲圖像。在經(jīng)典的深度學(xué)習(xí)算法中,利用卷積神經(jīng)網(wǎng)絡(luò)的圖像去噪模型在性能上獲得了一定提升,但是目前去噪網(wǎng)絡(luò)的整體去噪性能仍有很大的提升空間。卷積神經(jīng)網(wǎng)絡(luò)(CNN)的表現(xiàn)力一般情況下會隨著網(wǎng)絡(luò)深度的增加而增加,然而簡單疊加的多層卷積層會使訓(xùn)練變得更加困難,導(dǎo)致過擬合或性能飽和[7,11]。為了解決這個問題并獲得更高的去噪質(zhì)量,HU等[12]首次提出通道注意來提高圖像分類精度,在CNN情況下不同的特征信道對應(yīng)不同的頻率分量,利用通道注意可以選擇性地使用信息信道來更有效識別噪聲。盡管上述方法對圖像去噪都有一定的效果,但其中有些方法存在計算成本高、內(nèi)存消耗大、未能充分利用深層網(wǎng)絡(luò)對淺層網(wǎng)絡(luò)的影響,以及容易忽視一些復(fù)雜背景后的關(guān)鍵信息特征等缺點。

針對上述問題,本文在DnCNN基礎(chǔ)上探究了一種通道注意引導(dǎo)的空洞卷積神經(jīng)網(wǎng)絡(luò)(CDNet)以用于圖像去噪。該方法主要優(yōu)勢如:(1)引用了稀疏塊的理念,減少網(wǎng)絡(luò)深度。(2)引入通道注意力機(jī)制來調(diào)節(jié)網(wǎng)絡(luò)同一層中特征通道間的重要程度,使網(wǎng)絡(luò)更加關(guān)注與噪音密切相關(guān)的信息通道。所采用的網(wǎng)絡(luò)主動適應(yīng)圖像內(nèi)容,獲取更多信息特征,從而清晰高質(zhì)量地恢復(fù)圖像。(3)二者結(jié)合構(gòu)成本文的去噪網(wǎng)絡(luò),噪聲最終被處理為殘差圖,在輸出時殘差被丟棄,從而實現(xiàn)去噪功能。

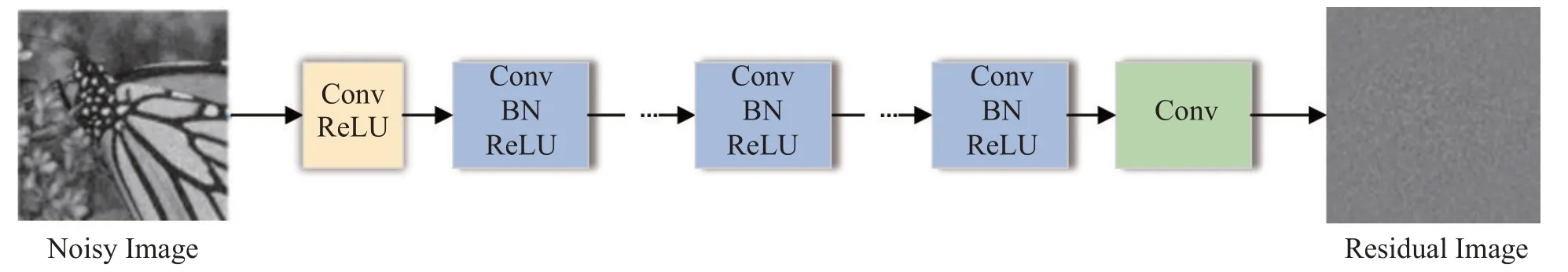

1 DnCNN網(wǎng)絡(luò)

DnCNN[6]在VGG基礎(chǔ)上進(jìn)行改進(jìn),是用于圖像去噪的前饋去噪卷積神經(jīng)網(wǎng)絡(luò),其網(wǎng)絡(luò)結(jié)構(gòu)是卷積、批量歸一化(BN)以及ReLU函數(shù)的級聯(lián)結(jié)構(gòu)。該網(wǎng)絡(luò)共有17層,分為三個部分,第一部分為Conv+Re-LU(一層),第二部分為Conv+BN+ReLU(若干層),第三部分為Conv(一層),對于每個卷積層,卷積核的大小為3×3,步長設(shè)置為1。網(wǎng)絡(luò)結(jié)構(gòu)如圖1所示。

圖1 DnCNN結(jié)構(gòu)

DnCNN 通過殘差學(xué)習(xí)策略進(jìn)行訓(xùn)練,損失函數(shù)數(shù)學(xué)表達(dá)式,其中,θ表示網(wǎng)絡(luò)參數(shù),N表示訓(xùn)練樣本數(shù),R(yi;θ)表示殘差輸出,yi為噪聲圖,xi為無噪聲圖像。

2 去噪網(wǎng)絡(luò)CDNet

雖然DnCNN去噪效果較好,但其網(wǎng)絡(luò)結(jié)構(gòu)單一,且同一層中特征通道間的重要程度平等,不利于特征的提取,且隨著網(wǎng)絡(luò)深度的增加,淺層網(wǎng)絡(luò)對深層的影響也隨之減弱。本文在DnCNN網(wǎng)絡(luò)基礎(chǔ)上結(jié)合通道注意力機(jī)制及稀疏性質(zhì)構(gòu)成了通道注意力引導(dǎo)的空洞卷積神經(jīng)網(wǎng)絡(luò)CDNet 以用于圖像去噪。CDNet利用稀疏性質(zhì)可以減少網(wǎng)絡(luò)深度,對輸入圖像進(jìn)行充分特征提取,再經(jīng)過通道注意力機(jī)制,根據(jù)不同權(quán)重以得到更重要的特征信息,從而有助于恢復(fù)清晰的圖像并提高去噪性能,其網(wǎng)絡(luò)結(jié)構(gòu)如圖2所示。

圖2 CDNet結(jié)構(gòu)

2.1 空洞卷積與稀疏性質(zhì)

上下文信息對于重建圖像去噪過程中損壞的像素點很重要[12],擴(kuò)大卷積神經(jīng)網(wǎng)絡(luò)的感受野,是獲取更多上下文信息的經(jīng)典方法。堆疊后的普通卷積感受野大小rn=rn-1+,其中,rn為本層的感受野大小,kn為本層的核尺寸(實際覆蓋尺寸,空洞卷積需要考慮dilation rate,池化層同理),si為第i層的步長。

空洞卷積不僅可以增加感受野,還能降低數(shù)據(jù)維度來減少計算量。YU[13]等用多個空洞卷積層來構(gòu)建了一個網(wǎng)絡(luò),其中每層空洞率都按指數(shù)級增長,有效的感受野大小隨層數(shù)的增加是指數(shù)級增長,而參數(shù)量以線性增長。為了提高模型的訓(xùn)練速度和性能,WANG[14]等結(jié)合了空洞卷積和批處理技術(shù),降低了圖像去噪的計算成本。ZHANG 等[15]利用多尺度損失和擴(kuò)張的卷積來消除偽像對JPEG 壓縮任務(wù)的影響。這些方法都驗證了空洞卷積在圖像應(yīng)用中的有效性。其次,TIAN等[16]提出稀疏性對于圖像應(yīng)用也是有效的,可以減少去噪網(wǎng)絡(luò)的深度,有利于降低計算成本和內(nèi)存消耗。TIAN等[17]驗證了網(wǎng)絡(luò)前12層中Dilated Conv+BN+ReLU和Conv+BN+ReLU錯綜交替可以被視為是稀疏的,其中,BN為批量歸一化處理,ReLU是激活函數(shù),空洞卷積的空洞率為2。這不僅可以提高訓(xùn)練的降解性能和效率,還能降低模型復(fù)雜度,基于此,本文將其作為此網(wǎng)絡(luò)的特征提取模塊。在稀疏塊中,Conv+BN+ReLU分別在第1、3、4、6、7、8、10以及11層,Dilated Conv+BN+ReLU分布在第2、5、9和12層。空洞卷積既能盡可能避免信息損失,保持圖像輸出特征的尺寸大小,又能獲得更多的上下文信息。具體而言,1~12層的卷積濾波器大小為3×3。第1層輸入為噪聲圖像的通道數(shù)即1或3,第2~12層的輸入和輸出都為64。特征提取模塊的輸出O1可表示為O1=Function1(IN),。其中IN表示輸入的噪聲圖像,F(xiàn)unction1表示特征提取模塊的功能函數(shù)。

2.2 通道注意

WOO等[18]提出了一種卷積注意模塊,其將通道注意和空間注意結(jié)合起來,用于高級視覺任務(wù)。在真實圖像去噪方面,肖娟等[19]通過對加性高斯白噪聲與真實噪聲的灰度直方圖進(jìn)行分析,用于去除圖像的真實噪聲。注意力機(jī)制能使網(wǎng)絡(luò)模型自適應(yīng)地獲取隱藏在復(fù)雜圖像背景后的隱藏信息,從而提升模型的表達(dá)性能與去噪能力。典型的注意力網(wǎng)絡(luò)為Squeeze-Excitation 網(wǎng)絡(luò)(SE-Net),其原理如圖3所示。

圖3 Squeeze-Excitation模塊

Squeeze壓縮操作是將輸入的空間特征維度進(jìn)行壓縮,類似于進(jìn)行池化操作且被壓縮后特征的通道數(shù)不改變,C表示特征的通道數(shù)目。該過程的數(shù)學(xué)表達(dá)式為,c=1,2,3,…,C,其中uc代表第c個特征通道。Excitation操作獲取通道之間的依賴關(guān)系,通過參數(shù)W給每一個特征通道生成權(quán)重,再將該權(quán)重用于原來的所有通道并學(xué)習(xí)不同通道的重要程度,因此使用兩個全連接層FC來學(xué)習(xí)通道之間的依賴關(guān)系,最后再通過sigmoid函數(shù)對權(quán)重進(jìn)行歸一化(將各通道的權(quán)重值限制在0-1,權(quán)重和限定為1),其公式為s=Fex(z,W)=σ(W2δ(W1z)),其中,δ和σ分別為ReLU 和Sigmoid 函數(shù),W1表示對特征維度進(jìn)行降維,W2表示對特征維度進(jìn)行升維。最終將學(xué)習(xí)到的各通道激活值乘以原始特征,公式為=Fscale(uc,sc)=sc·uc。

中間殘差塊負(fù)責(zé)在特征空間中執(zhí)行去噪任務(wù),一個殘差塊由三個Conv+BN+ReLU、一個Conv、一個通道注意力模塊,以及后面的執(zhí)行跳躍連接,殘差塊中每個Conv有64個大小為3×3×64的濾波器。該功能計算公式為O2=Function2(O1),其中,O2為殘差塊的輸出,O1為上一層輸出并作為本層輸入,F(xiàn)unction2表示該塊的功能函數(shù)。最后一個塊為3×3×1大小的單個Conv層,以構(gòu)建最終的干凈圖像,此功能計算公式為O3=IN-Function3(IN),其中,O3為重構(gòu)塊的輸出即最終的潛在圖像,IN為輸入的噪聲圖像,F(xiàn)unction3表示整個模型所預(yù)測出的殘差圖像。

為了訓(xùn)練CDNet,文中使用L2損失函數(shù)。給定一個訓(xùn)練數(shù)據(jù)集D={…,(I(i),J(i),…)},其中I(i)和J(i)代表第i張噪聲圖像以及其對應(yīng)的ground truth 無噪聲圖像。所采用的損失函數(shù)表達(dá)式為

3 實驗結(jié)果與分析

3.1 實驗設(shè)置

實驗硬件平臺為NVIDIA RTX 3060,深度學(xué)習(xí)框架為Pytorch1.8、Cuda11.1 和CuDNN 8.0。訓(xùn)練數(shù)據(jù)集來自于BSD數(shù)據(jù)集的訓(xùn)練集。通過設(shè)置0.9、0.8和0.7的比例因子以對每幅圖像進(jìn)行下采樣。然后將每個圖像隨機(jī)裁剪成180×180大小,并從每幅被裁剪后的圖像中提取40×40的patch,且stride設(shè)置為10。在整個實驗過程中,通過零均值隨機(jī)初始化以及0.000 5的標(biāo)準(zhǔn)差來初始化所有普通卷積層的權(quán)重,并使用Adam優(yōu)化器來優(yōu)化模型。

實驗將訓(xùn)練三個噪聲水平:σ=15、σ=25以及σ=30的模型。最終每個epoch生成了45 563個patch,同時采用峰值信噪比(PSNR/dB)和結(jié)構(gòu)相似性(SSIM)[20]作為最終的數(shù)據(jù)評價指標(biāo)來衡量并比較各個模型的去噪性能。PSNR和SSIM越大則去噪性能越好。為了驗證該網(wǎng)絡(luò)的去噪性能,與DnCNN[6]、FFDNet[10]、IRCNN[21]幾種常見的網(wǎng)絡(luò)模型進(jìn)行對比,測試數(shù)據(jù)集則使用公開數(shù)據(jù)集Set12中常用的7張圖片以及Set68中的10個測試集。

3.2 去噪性能對比

表1~2 給出了各算法在Set12 和Set68 上的PSNR 值和SSIM 值,其中,表1 為各算法在不同水平高斯白噪聲強(qiáng)度下(σ=15、σ=25、σ=30)的PSNR 值。表2 則為各算法在不同水平高斯白噪聲強(qiáng)度下(σ=15、σ=25、σ=30)的SSIM值。由于不同圖像之間的結(jié)構(gòu)存在差異性,因此不同的去噪算法在不同驗證集上的去噪性能也會產(chǎn)生不同程度的差異性。

表1 Set12上不同算法的PSNR值

表2 Set12上不同算法的SSIM值

從表1和2可以看出,該網(wǎng)絡(luò)在高斯噪聲水平為σ=25和σ=30情況下,除了σ=30的平均SSIM值稍遜于FFDNet[10],其PSNR值均取得了最好的平均指標(biāo),表明此網(wǎng)絡(luò)在該水平高斯噪聲情況下的去噪效率整體處于優(yōu)勢。圖4給出了“Barbara”(σ=25)去噪圖像的視覺效果。可以看出CDNet可以較好地保持一些邊緣特征,在紋理和邊緣結(jié)構(gòu)上具有一定的長處。

從表3和圖5也可以看出,在數(shù)據(jù)集Set68上,各種不同噪聲強(qiáng)度情況下CDNet 的SSIM 值均高于其他模型,且都有較強(qiáng)的優(yōu)勢。同時在中高噪聲的水平下,該網(wǎng)絡(luò)的PSNR值也都不遜色于其他對比網(wǎng)絡(luò)。

表3 Set68上不同算法的平均PSNR值

圖5 Set68上不同算法的平均SSIM值

4 結(jié)束語

該文在DnCNN 的基礎(chǔ)上組合了通道注意力機(jī)制和稀疏機(jī)制,構(gòu)建了一種通道注意力引導(dǎo)的去噪卷積神經(jīng)網(wǎng)絡(luò)。注意力模塊使網(wǎng)絡(luò)模型自適應(yīng)地獲取隱藏在復(fù)雜圖像背景后的信息,由空洞卷積和普通卷積構(gòu)成的具有稀疏性的網(wǎng)絡(luò)部分可以增加感受野,并減少網(wǎng)絡(luò)深度,從而降低數(shù)據(jù)維度以減少計算量,提高了網(wǎng)絡(luò)模型的性能與效率。對比結(jié)果表明,該去噪網(wǎng)絡(luò)在各類公開數(shù)據(jù)集上都可以取得很好的效果。接下來,作者將繼續(xù)研究注意力機(jī)制對卷積神經(jīng)網(wǎng)絡(luò)的自適應(yīng)性,進(jìn)一步提高模型對不同類型圖像特征的表征能力,從而更廣泛有效地處理各種去噪問題。