基于改進YOLOv7的復雜環境下紅花采摘識別

王小榮,許 燕,周建平,陳金榮

·農業信息與電氣技術·

基于改進YOLOv7的復雜環境下紅花采摘識別

王小榮1,2,許 燕1,2,周建平1,2※,陳金榮1

(1. 新疆大學機械工程學院,烏魯木齊 830017;2. 新疆維吾爾自治區農牧機器人及智能裝備工程研究中心,烏魯木齊 830017)

針對光照、遮擋、密集以及樣本數量不均衡等復雜環境造成紅花機械化采摘識別不準問題,該研究提出一種基于YOLOv7的改進模型,制作紅花樣本數據集建立真實采摘的復雜環境數據,增加Swin Transformer注意力機制提高模型對各分類樣本的檢測精準率,改進Focal Loss損失函數提升多分類任務下不均衡樣本的識別率。經試驗,改進后的模型各類別樣本的檢測平均準確率達到88.5%,與改進前相比提高了7個百分點,不均衡類別樣本平均精度提高了15.9個百分點,與其他模型相比,檢測平均準確率與檢測速度均大幅提升。改進后的模型可以準確地實現對紅花的檢測,模型參數量小,識別速度快,適合在紅花采摘機械上進行遷移部署,可為紅花機械化實時采摘研究提供技術支持。

圖像識別;圖像處理;復雜環境;YOLOv7;注意力機制;多分類Focal Loss損失函數;紅花采摘

0 引 言

紅花花絲是一種具有醫療、染料等多種用途的經濟作物[1]。隨著其功效在醫藥保健、農副產品、化妝品等行業的不斷研發,其需求量正在穩步上漲。目前紅花花絲的采摘仍以人工采摘為主[2],紅花花期短,時效性要求高,勞動強度大,且作業環境差,受天氣影響嚴重。為提高紅花采收效率,降低勞動成本,機械化采收成為紅花產業化種植發展的必然趨勢。

針對紅花機械化采收研究,國內外學者進行了初步探索。圍繞采收設備的研究,BERTETTO等[3]設計制作背負式便攜采收設備進行紅花采收,但仍需要勞動者長時間背負設備工作,沒有真正意義代替人工;針對末端采摘執行機構的研究,國內多位學者進行了結構設計,主要包括氣力式[4]、對輥式[5]、梳夾式[6]、旋切式[7]以及拉拔式[8];關于采收機械路徑規劃研究,GUO等[9]通過運動學分析、采摘試驗探索并聯機器人在紅花采摘中的可行性,ZHANG等[10]通過改進蟻群算法探索雙輥型紅花采摘機器人路徑規劃方法。以上關于紅花采收的研究均是在實驗室理想條件下開展,在實際農田中的應用研究尚存在很大空間,因此紅花機械化采收研究處于起步階段。

在采摘過程中,光照、遮擋等自然環境與紅花目標小而密、成熟度不同等作物特性構成了復雜環境因素,導致紅花機械采摘過程難以準確識別精準定位。近年來,隨著深度卷積網絡目標檢測技術的發展以及Fast R-CNN[11]、YOLO系列[12-14]等經典目標檢測算法不斷開源,基于深度學習算法的采摘機器人被廣泛地應用在蘋果、番茄、柑橘等[15-17]果蔬采摘中。JIA等[18-19]學者通過改進Mask RCNN算法可以提高在樹葉遮擋等復雜環境下模型的蘋果識別的準確度和識別精度,但是Mask RCNN作為兩階段檢測方法,其識別速度和效率較低;ZHANG等[20-21]學者采用Fast R-CNN模型算法分別對蘋果和藍莓進行識別,識別準確率和效率明顯提高,針對復雜環境下小目標的檢測效果也有所改善,但是Fast R-CNN算法需要采集大量的數據用作模型訓練,對于少樣本或樣本不均衡情況下目標檢測效果有待加強。近年來,YOLO算法作為單階段檢測方法,具有速度快效率高等特點,在實際場景目標檢測中應用廣泛。李天華等[22-24]學者在YOLOv4基礎上對模型進行了改進,并對復雜環境下的番茄進行實時識別,能夠有效解決遮擋、粘連、或光照影響下目標識別準確率低的問題。因采茶與紅花采收有相似性,以上研究為紅花的采摘檢測與識別提供借鑒。CHEN等[25]提出了一種基于YOLOv3的茶蕾識別與采摘點提取的方法,該方法將深度學習與傳統的圖像處理算法相結合,驗證了在遮擋光照等自然環境下茶蕾識別與采摘點定位的可行性,提高了茶蕾采摘的完整率,但是該算法識別的準確率有待加強。CAO等[26]提出了一種集成YOLOv5和GhostNet的茶芽檢測模型,該模型的精度、召回率均有所提高,但在自然環境下因受樣本數量、拍攝角度和照明角度的影響,該算法F1得分值沒有試驗效果明顯。

基于此,本文建立復雜環境下紅花數據集,選用YOLOv7檢測網絡模型,針對數據樣本存在的問題進行算法模型改進與優化,為紅花機械化采摘提供研究基礎。

1 試驗數據

1.1 試驗數據的獲取

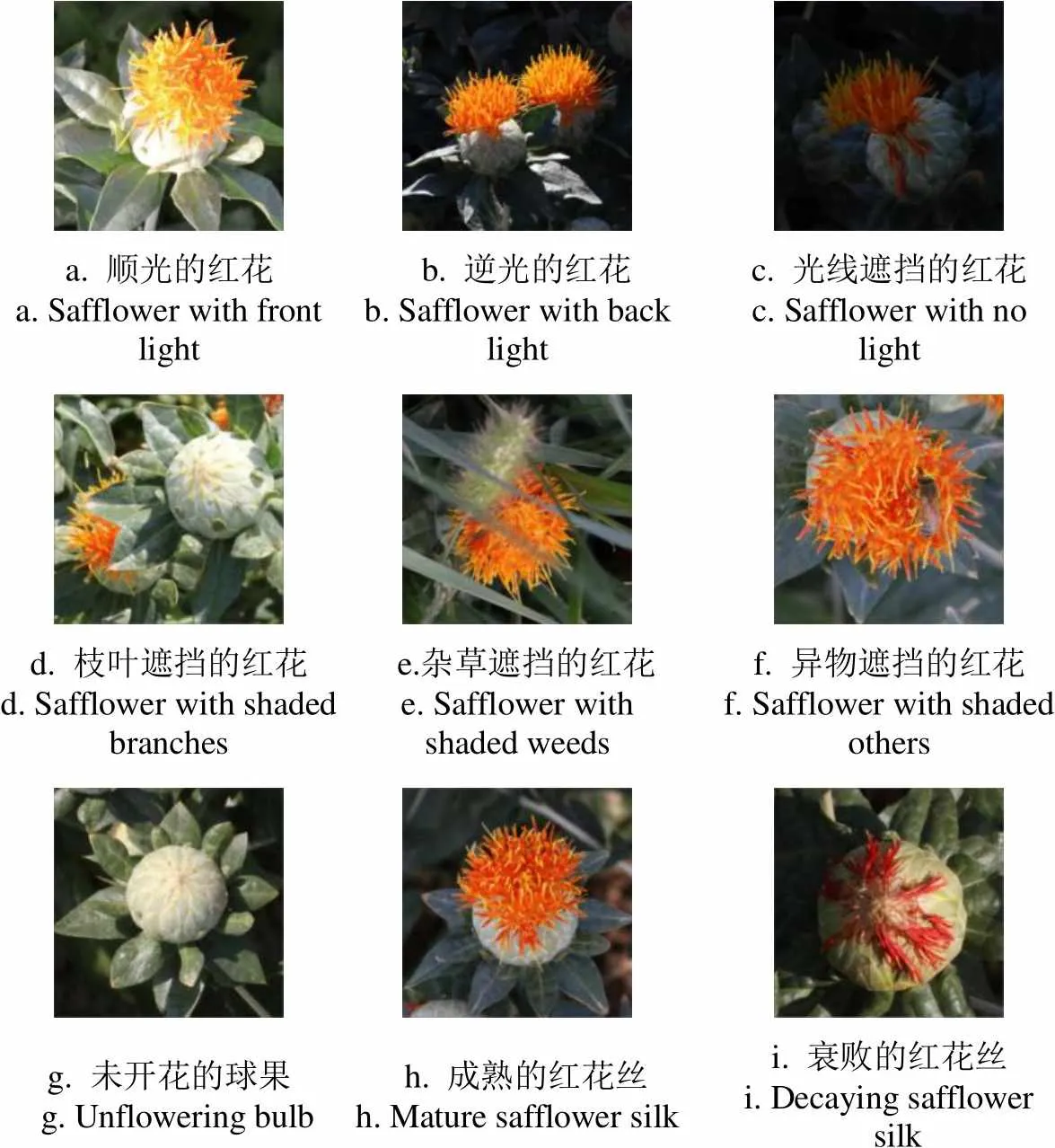

新疆地區紅花種植面積占國內紅花種植面積的80%以上,本文以新疆吉木薩爾縣種植紅花為研究對象。為滿足復雜環境下紅花識別的多樣性以及種植場景真實性,采用不同時間段不同角度拍攝,收集到不同成熟度、不同光照、不同遮擋程度以及不同姿態的紅花圖片約1 596張,經過篩選后的圖片1 500張,從中隨機抽取1 200張作為訓練集,150張作為驗證集,150張作為測試集。圖1分別為復雜環境下不同光照、遮擋以及成熟度的紅花樣本數據。光照、遮擋等因素容易造成模型對紅花絲的特征提取不準確,從而導致錯檢漏檢,影響網絡模型的性能。不同成熟度的紅花,因含水量不同,采摘決策不同,因此需對3種不同類別的紅花目標進行識別與定位。

a. 順光的紅花a. Safflower with front light b. 逆光的紅花b. Safflower with back lightc. 光線遮擋的紅花c. Safflower with no light d. 枝葉遮擋的紅花d. Safflower with shaded branches e.雜草遮擋的紅花e. Safflower with shaded weeds f. 異物遮擋的紅花f. Safflower with shaded others g. 未開花的球果 g. Unflowering bulb h. 成熟的紅花絲h. Mature safflower silki. 衰敗的紅花絲i. Decaying safflower silk

1.2 試驗數據標注與分析

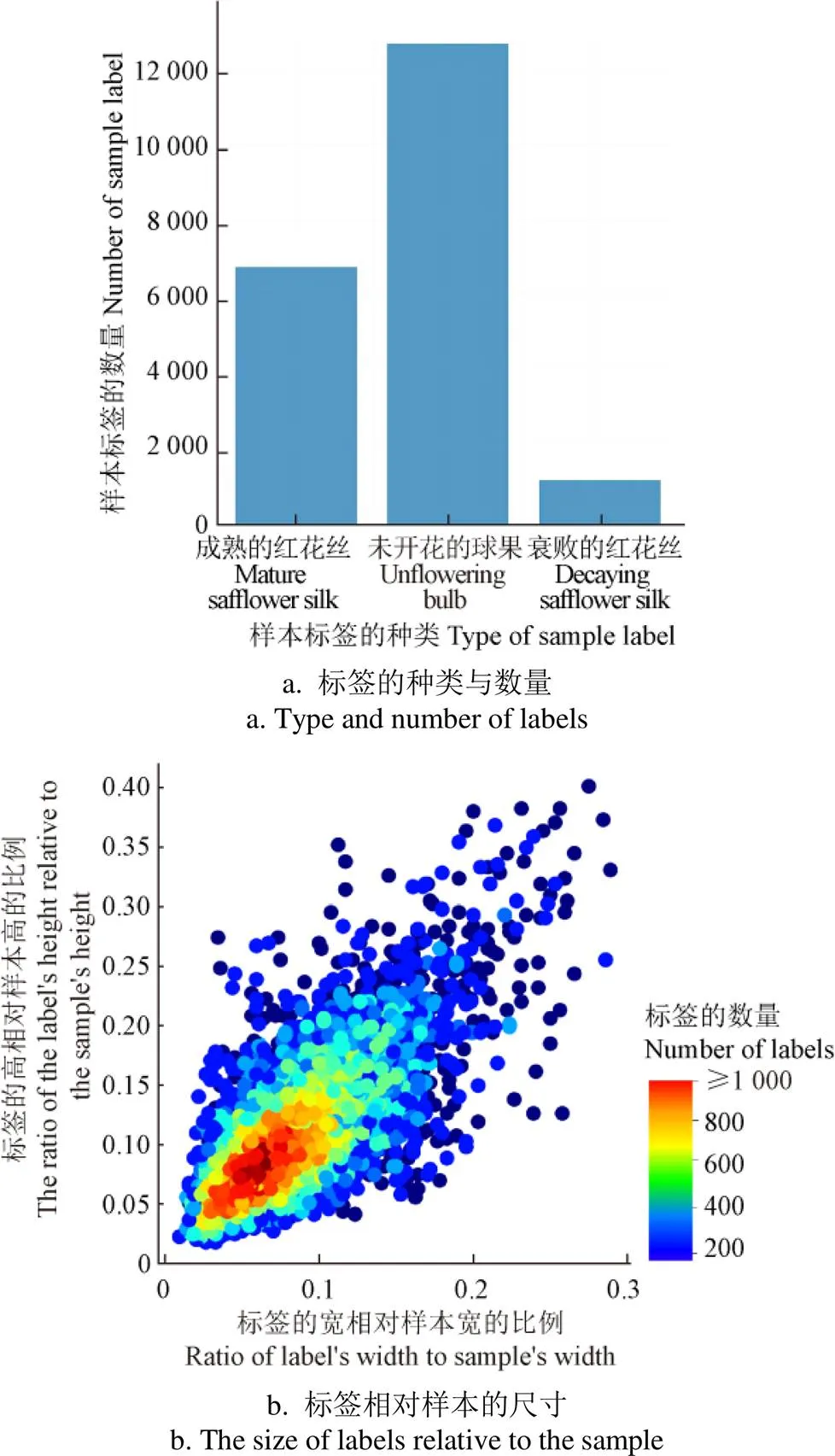

根據采收決策,本文按照成熟的紅花絲(silk)、未開花的球果(bulb)、衰敗的紅花絲(decay)對樣本進行分類,利用Labelme圖像標注軟件對數據集進行人工標注并對訓練集的標注文件進行可視化分析,如圖2所示。

從圖2a可以看出,在復雜場景下silk、bulb和decay三種樣本數量比例約為5∶9∶1,樣本的數量是不均衡的,容易導致在模型訓練過程中decay樣本的準確率較低。對圖 2b中標簽尺寸相對樣本尺寸而言,標簽的寬和高大多為樣本尺寸的0.02~0.15倍,小目標偏多,易導致模型準確率不高。以上2種情況是由于紅花的種植模式、生長特性以及采摘視野等多重因素造成,均會影響模型的檢測效果。

圖2 訓練集標簽分布情況

針對以上問題,本文在YOLOv7網絡模型的第50層特征提取層增加Swin Transformer注意力機制,以提高模型骨干網絡對小目標特征的提取能力;改進適用于多分類的Focal Loss損失函數,應用于目標置信度損失和分類損失,以提高網絡模型反向傳播時對不均衡樣本的關注程度,最終設計符合復雜環境下紅花檢測網絡模型以滿足實時準確的檢測需求。

2 網絡模型及改進

2.1 YOLOv7目標檢測模型

YOLO作為單階段目標檢測典型算法,因較快的運行速度被廣泛應用于實時檢測,而YOLOv7在MSCOCO數據集上的檢測效果顯示,其準確率和速度超越其他YOLO系列模型,因此本文選擇YOLOv7作為紅花目標檢測的算法模型。

YOLOv7網絡結構[27]主要包括Input層、Backbone層和Head層。Input層為輸入層,主要作用是對輸入的圖片進行預處理后輸入到Backbone層;Backbone層又被稱作特征提取層,主要功能是提取不同大小的目標信息特征,由51層(Layer0~50)不同的卷積組合模塊構成,其最大特點是采用了高效的E-ELAN網絡架構,可以提高算法的檢測效率,Backbone層的輸出為不同大小的特征信息,位置分別位于第24層、第37層以及第50層;Head層主要是融合Backbone層給出的特征生成邊界框并預測類別,主要包括SPPCPC層、若干Conv層、MPConv層以及REP層,Head層在第75層、第88層以及第101層輸出不同大小的特征圖,經過重參數化結構REP層輸出預測結果。

2.2 網絡模型的改進

2.2.1 Swin Transformer注意力機制

注意力機制是一組通過網絡自主學習得出權重系數,并以“動態加權”的方式來強調感興趣的區域,抑制不相關背景區域的機制。目前主流的注意力機制可以分為通道注意力機制、空間注意力機制混合注意力機制以及自注意力機制。通道注意力機制通過對每個特征圖做全局池化獲取每個通道的重要程度,得到權重系數并以此來提升特征或抑制不重要的特征,該權重系數具有全局感受野,對本文復雜環境下紅花的小目標檢測問題效果不佳。空間注意力機制僅關心與任務相關的區域,當目標區域被遮擋或受光照干涉時會影響注意力機制的判斷。混合注意力機制是由通道注意力及空間注意力串聯或并聯而成,因存在全局池化及平均池化操作,因此對復雜環境下紅花目標的檢測仍存在問題。自注意力機制與前三者不同,是對輸入的特征進行一系列的復雜矩陣運算得到特征之間的相關權重,找到特征之間的關系,自注意力機制不依賴于卷積網絡,更加關注每個像素特征之間的關系,適合小目標的識別,因此本文在YOLOv7網絡增加Swin Transformer自注意力機制。

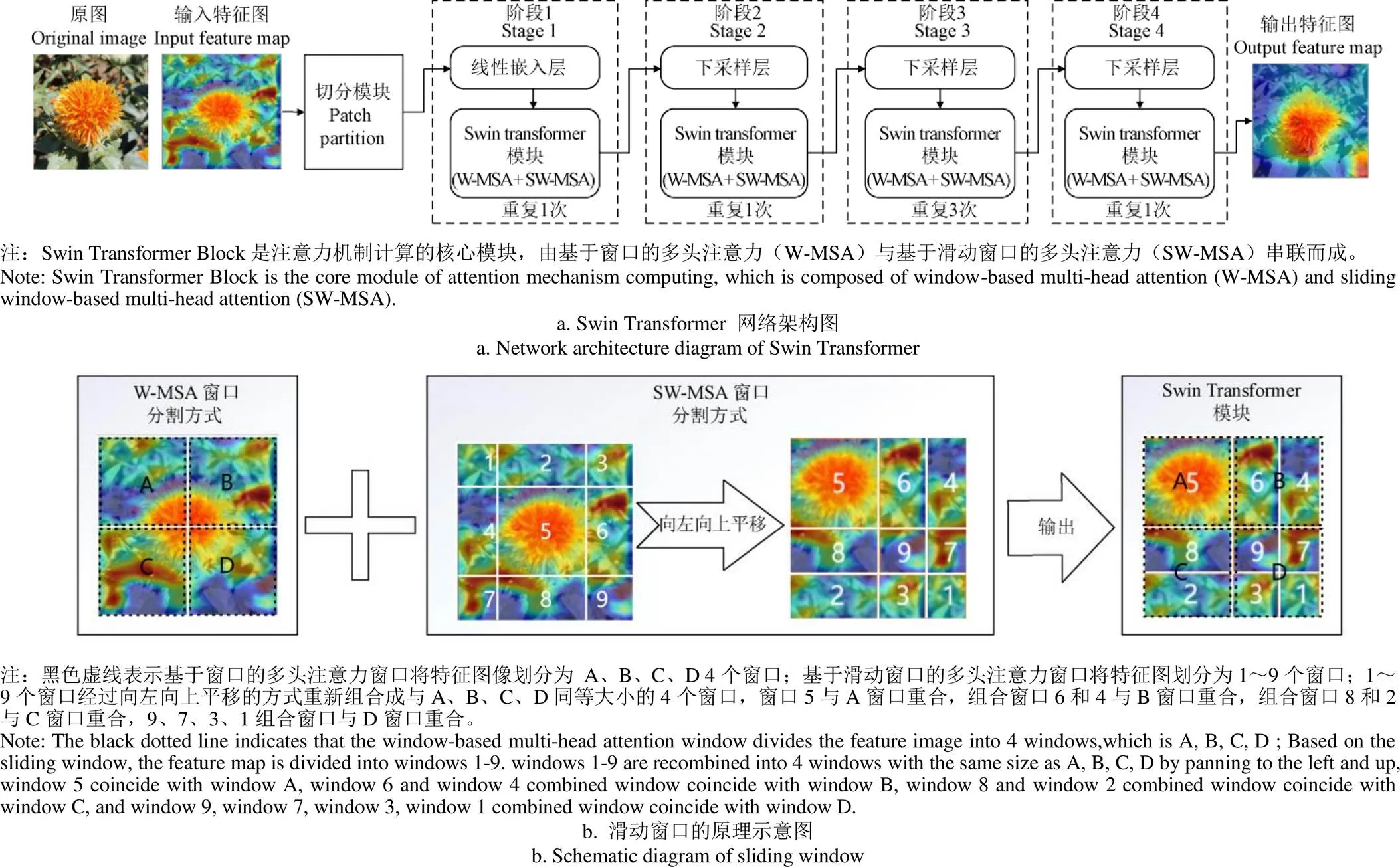

在進行自注意力機制訓練時,如果以特征序列為計算單位在圖像全局進行矩陣計算,計算量大且訓練速度慢。Swin Transformer[28]是一種以窗口和分層的形式代替長序列的自注意力機制,可以在提升檢測性能的同時降低對運行速度的影響。Swin Transformer注意力機制的網絡結構如圖 3a所示,首先輸入一張3通道的特征圖像,經過Patch Partition切分模塊將圖像切割,將切割的圖像送入Lineat Embedding層,得到嵌入向量。然后分4個階段(Stage1~Stage4)逐步下采樣分層計算注意力。Swin Transformer Block是注意力機制計算的核心模塊,是由基于窗口的多頭注意力(W-MSA)計算與基于滑動窗口的多頭注意力(SW-MSA)計算串聯而成。滑動窗口原理如圖3b所示,首先基于窗口多頭注意力將特征圖像劃分為 A、B、C、D 4個窗口,為得到4個窗口的內部聯系,再利用滑動窗口將圖像特征劃分為編號為1~9的9個窗口,此時9窗口的計算量比4窗口多了2.25倍,為并行計算MSA,必須保證二者之間窗口數一致,因此采取向上、向左平移的策略將9個窗口重新組合成與ABCD同等大小的4個窗口,最后進行MSA計算,輸出特征圖。在YOLOv7中利用GradCAM可視化熱力圖對增加Swin Transformer注意力機制前后紅花數據的特征進行可視化,如圖3a所示,模型輸入的原圖經過前期特征提取,在第37層網絡中獲得的特征圖為輸入特征圖,經過Swin Transformer 注意力機制后輸出特征圖,可以看出,增加Swin Transformer注意力機制后,網絡更加專注于對紅花絲的識別,即使是處于圖片邊緣葉片遮擋下的紅花絲小目標也可以識別出來。

圖3 Swin Transformer 注意力機制網絡架構及原理

2.2.2 多分類任務Focal Loss損失函數

YOLOv7的損失函數L用于更新梯度的損失,由坐標損失ciou、目標置信度損失obj和分類損失cls三部分求和而成。如式(1)所示。

loss=ciou+obj+cls(1)

其中目標置信度損失和分類損失采用帶對數的二值交叉熵損失。為了解決樣本不均衡問題,LIN等[29]首先改善了分類過程中的交叉熵函數,提出了針對二分類可以動態調整權重的Focal Loss。針對本文紅花圖像數據,分為silk、bulb和decay 3種分類樣本,因此本文基于Focal Loss對多分類動態調整權重的損失函數進行了推導。

樣本的標簽為Onehot形式,與二分類不同的是多分類任務是以Softmax作為最后激活函數。例如silk、bulb、decay 3類標簽分別為1(1,0,0),2(0,1,0),3(0,0,1),Softmax輸出為(1,2,3),1、2、3分別對應3種類別的概率,1、2、3的和為1。以Sofmax作為激活函數的多分類任務損失函數(multi-classification focal loss,簡寫為MCFL)計算式推導過程如下:

MCFLylgP(2)

MCFLα(1-P)ylgP(4)

MCFL-α(1-P)ylgP(5)

式(2)為多類交叉熵損失,為降低易分類樣本的比例,式(3)函數中增加(1-P)做衰減;為調節正負樣本比例式(4)用α來調整該樣本的權重。因標簽是Onehot形式,樣本標簽中的值只有在對應位置上為1,其余都為0,最終得到多分類以Sofmax作為激活函數的動態調整權重損失函數(式(5)),其中為衰減參數,可以通過試驗對比獲得最佳取值,α為該類別樣本的權重參數,與α是相互作用的,并且起的作用比α大。

2.3 網絡模型的訓練

2.3.1 環境配置

試驗運行環境操作系統為Windows 10(64位),內存為16 GB,顯卡驅動RTX3060,搭載12th Gen Intel(R) Core(TM) i5-12400F 2.50 GHz處理器,編程平臺Anaconda 4.12.0,CUDA 11.6,開發環境PyTorch,編程使用Python 3.8。

2.3.2 超參數設置

訓練時選用官方提供的YOLOv7.pt預訓練權重進行訓練,數據集選用自己建立的紅花數據集,標簽格式為YOLO格式,輸入圖像大小為640×640,Batchsize大小為16,迭代次數Epoch為100,采用Adam優化器并設置初始學習率為0.01。

2.3.3 評價標準

為了評價模型對紅花識別檢測結果的好壞,評價標準選用準確率(precision)、召回率(recall)、平均準確率(mean average precision,mAP)與檢測速度(frames per second,FPS)[16]。

2.3.4 模型集成

本文在YOLOv7網絡增加Swin Transformer注意力機制,對目標置信度損失和分類損失均采用改進的多分類損失函數Multiple Classifications Focal Loss計算,主要集成方法如下:第一步,在common.py文件中增加Swin Transformer網絡模型代碼,并在配置文件中的特征提取層(backbone)第50層增加該網絡結構。第二步,在loss.py文件中定義多分類任務 Focal Loss損失函數并通過改變數據集配置文件中fl_gamma的參數值對其進行調用,實現兩種模型與YOLOV7網絡的集成。

3 結果與分析

3.1 YOLOv7模型與YOLO系列其他模型對比

為驗證YOLOv7在紅花數據集上檢測效果,本文分別將YOLOv3、YOLOv5s、YOLOv5m、YOLOv5l和YOLOv7五種網絡模型在紅花數據集上進行訓練,試驗結果如表1所示。

通過表1對比結果可以看出,在相同迭代次數內,由于YOLOv7網絡的模型參數量增加,模型檢測速度低于YOLOv5s和YOLOv5m,但55.5幀/s的檢測速度已能滿足紅花采收決策需求。YOLOv7模型在紅花數據集上的mAP值比YOLOv3高出2.5個百分點,比YOLOv5s、YOLOv5m、YOLOv5l三個不同大小的模型分別高出7.9、8.4、5.1個百分點,尤其是在不均衡樣本類別上優勢更加明顯,在decay不均衡樣本上分別高出4.2、23.5、24.5、10.8個百分點。因此本文選用YOLOv7模型,并在此基礎上進行改進以增強其在復雜環境下對紅花實時檢測的準確率。

表1 紅花數據集在不同YOLO系列模型檢測效果

3.2 Swin Transformer注意力機制對模型影響

為驗證不同注意力機制對模型的影響,分別將通道注意力機制SE、混合注意力機制CBAM以及自注意力機制Swin Transformer 3種注意力機制模塊添加到YOLOv7的特征提取層第50層進行試驗,結果顯示3種注意力機制均降低了模型的檢測速度,下降比例分別為21.08%、25.22%、17.66%,Swin Transformer速度下降比例最小。增加SE注意力后,模型的mAP值反而降低了3.1個百分點,說明在本文數據集上SE注意力機制強化了成熟紅花絲、未開花的球果的通道特征,抑制了衰敗紅花絲的特征。CBAM注意力機制對3種樣本的平均準確率分別提升0.8、2.1、3.0個百分點,Swin Transformer注意力機制對3種樣本的平均準確率分別提升1.6、2.1、10.6個百分點,說明Swin Transformer注意力機制在本數據集上提升效果優于其他兩種注意力機制。分析以上結果,這是由于Swin Transformer自注意力機制強化了各特征之間的關系,降低了對全局注意力計算的結果,因此Swin Transformer注意力機制在3種樣本上效果均有所改善,尤其是對衰敗紅花絲這種數量少的樣本改善效果更加明顯。為驗證Swin Transformer模型添加位置對模型的影響,分別在特征提取層的第24、37層增加Swin Transformer,并相應地調整Head層級數進行對比,試驗結果見表2。

表2 注意力機制對YOLOv7模型訓練過程影響

通過以上結果可以看出,在第24層、37層、第50層增加Swin Transformer對平均準確率有所提升,而且插入的位置層級越大,模型性能提升越明顯,這是由于插入的位置層級越大,感受野越大,特征提取就越多,效果越明顯,因此本文在特征提取網絡的第50層增加Swin Transformer注意力機制。

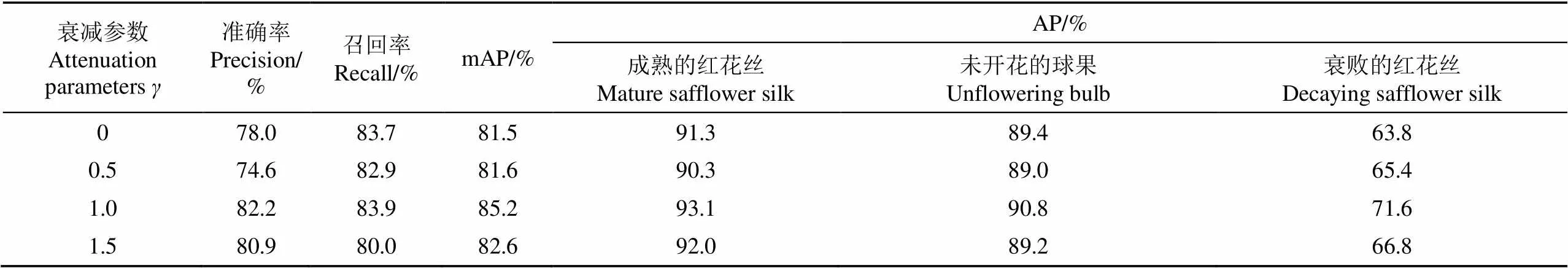

3.3 多分類任務Focal Loss損失函數對模型的影響

在計算損失函數時,為確定衰減參數對模型的影響,本文在loss.py文件通過改變數據集配置文件中fl_gamma的參數值對其進行調用,設定3個樣本參數權重α為0.3、0.3、0.4,分別對在0.25~3取值范圍模型的性能與改進前(=0)進行對比,得出以下結論:1)關于模型訓練損失loss:當=0.5時出現了不收斂現象,值越大損失越小。2)關于均值精準率mAP值,0.5≤≤1.5時,模型的mAP值有所提升。3)關于準確率precision:當≤0.5,≥2.0時,準確率均下降。4)關于召回率recall,當≥0.5時,召回率均有所提升。

綜上,當0.5≤≤1.5時,損失函數對模型的性能提升效果較好。本文分別對選取=0.5、1.0、1.5與改進前=0進行結果對比,如表3所示,當=1.0時,改進的損失函數比改進前各類別mAP值提高3.7個百分點,對單類別AP值分別提升1.8、1.4、7.8個百分點,可以看出該損失函數對數量較少的樣本進行了強化,從而可以提高樣本不均衡造成的識別率低的現象。

表3 衰減參數γ=0.5、1.0、1.5與改進前γ=0對模型影響對比

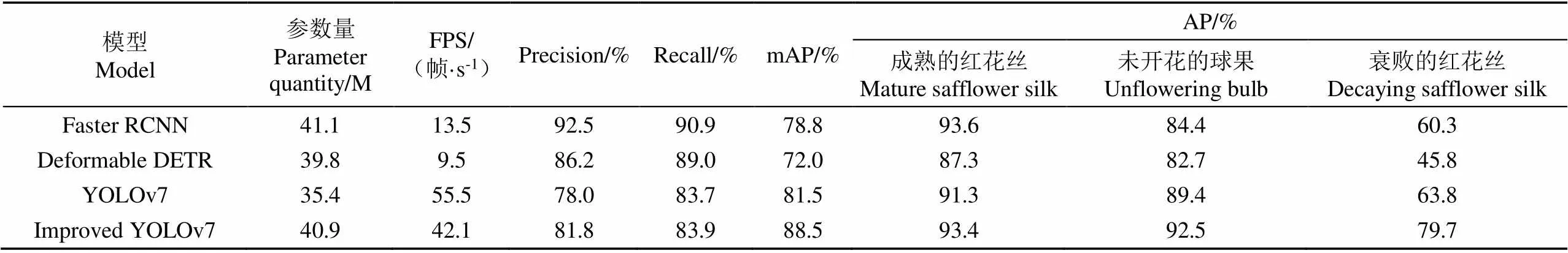

3.4 與其他模型性能對比

本文模型在YOLOv7特征提取層第50層插入Swin Transformer,目標置信度損失和分類損失使用改進損失函數計算。在紅花數據集上,利用MMDeteceion檢測工具箱將本文模型與改進前的YOLOv7模型以及其他典型目標檢測算法模型Faster RCNN、Transformer 框架目標檢測算法Deformable DETR分別進行對比,結果如表4所示。

表4 不同模型在紅花數據集檢測效果對比

通過對比可以看出,4種模型YOLO系列模型優勢是實時的檢測速度,雖然Faster RCNN、Deformable DETR模型的準確率及召回率較高,但是平均準確率比YOLO系列低,在實際采摘中就會錯檢漏采情況較為明顯。本文根據YOLOv7改進后的模型平均準確率與Faster RCNN、Deformable DETR、YOLOv7模型相比,分別提高了9.7、16.5、7.0個百分點,尤其是針對不均衡樣本的平均準確率分別提高了19.4、33.9、15.9個百分點,綜合性能指標有一定優勢。

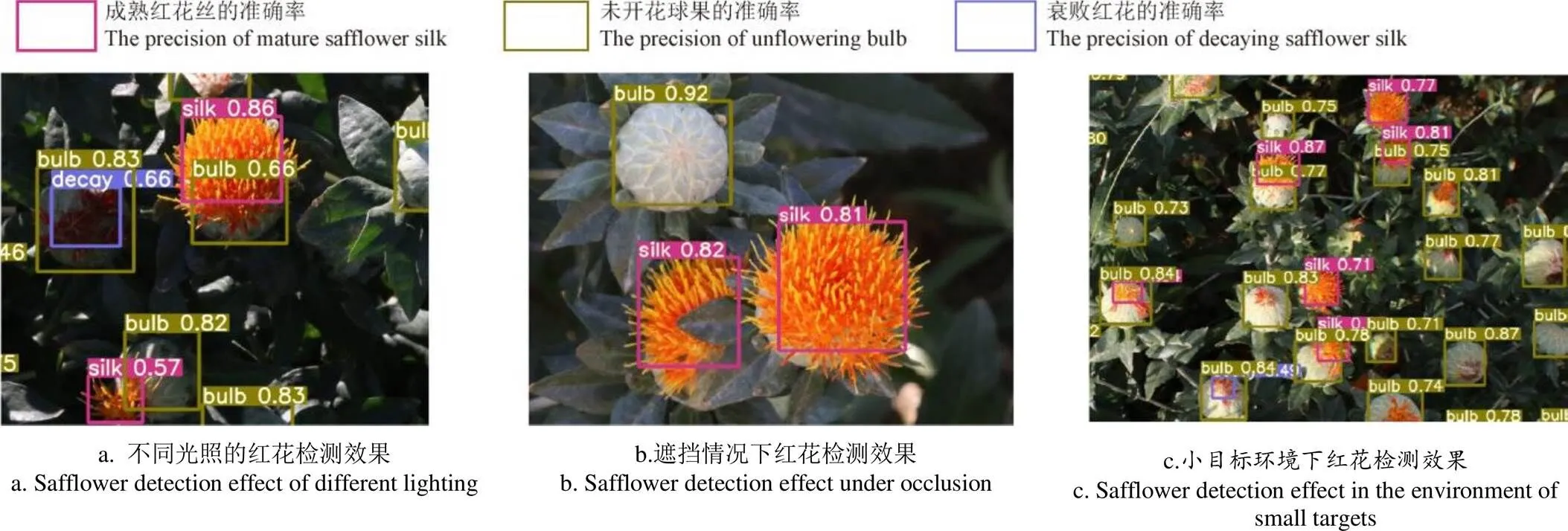

3.5 模型檢測效果

利用改進后的模型對紅花數據集進行訓練與驗證,并在測試集中進行測試,檢測效果如圖4所示。可以看出,改進后的算法在不同光照、遮擋以及小目標等復雜環境下,可以準確地識別出成熟的紅花絲、未開花的球果以及衰敗的紅花絲3種樣本,且識別的準確率達到0.6以上。說明改進后的模型對復雜環境下紅花樣本的識別效果較好。

圖4 改進后的模型在復雜環境下的檢測效果

4 結 論

本研究針對環境背景復雜、光線遮擋以及樣本不均衡造成紅花機械化采摘識別率低的問題,建立紅花樣本數據,增加Swin Transformer注意力機制提高模型對各分類樣本的檢測精準率,改進Focal Loss損失函數提升多分類任務下不均衡樣本的識別率,并與其他典型算法模型進行對比,得出如下結論:

1)在本文紅花數據集上,改進后模型的檢測效果與改進前相比,各類樣本檢測的平均準確率達到88.5%,提高了7.0個百分點,不均衡樣本衰敗紅花絲decay的平均準確率提高了15.9個百分點;與Faster RCNN模型相比,平均準確率提高了9.7個百分點,不均衡樣本衰敗紅花絲decay的平均準確率提高了19.4個百分點;與Deformable DETR算法模型相比平均準確率提高了16.5個百分點,不均衡樣本衰敗紅花絲decay的平均準確率提高了33.9個百分點;無論是綜合檢測效果、還是對不均衡樣本檢測的平均準確率,改進后模型的優勢都比較明顯。

2)在模型特征提取層增加Swin Transformer注意力機制可以提高復雜背景下目標的檢測準確率,尤其是提升不均衡樣本的檢測準確率,可以減少紅花采摘過程的漏檢現象,但是會降低模型的檢測速度,降低后的識別速度仍可以滿足機械化實時采摘要求,而且對于機械化采摘而言,在保證識別準確率的前提下,犧牲較小的速度指標,匹配采摘動作更有利于保障采摘機械的穩定性。

3)改進后的多分類任務Focal Loss損失函數通過調整衰減參數的大小抑制不同類別樣本的權重,改善樣本不均衡問題,經過試驗對比確定衰減參數取值范圍:0.5≤≤1.5,且在本數據集上取值1.0時模型性能提升效果最好。

本文所提方法可以有效改善網絡模型在復雜環境下對紅花的識別與檢測,尤其是解決樣本不均衡問題、光照遮擋等問題,可以為真實農田環境下各種作物的識別提供借鑒。在今后的研究中,將從數據層面通過擴大樣本數量縮小種類間的不均衡,為模型在采摘機械上的遷移部署提供支持。

[1] 曹衛彬,焦灝博,劉姣娣,等. 基于TRIZ理論的紅花絲盲采裝置設計與試驗[J]. 農業機械學報,2018,49(8):76-82. CAO Weibin, JIAO Haobo, LIU Jiaodi, et al. Design of safflower filament picking device based on TRIZ theory[J]. Transactions of the Chinese Society for Agricultural Machinery, 2018, 49(8): 76-82. (in Chinese with English abstract)

[2] 陳飛,葛云,張立新,等. 紅花采摘機器人集條預定位機構設計與試驗[J]. 農業工程學報,2021,37(15):10-19. CHEN Fei, GE Yun, ZHANG Lixin, et al. Design and experiment of the strip-collected pre-positioning mechanism for safflower picking robots[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(15): 10-19. (in Chinese with English abstract)

[3] BERTETTO A, MANUELLO, RICCIU R, et al. A mechanical saffron flower harvesting system[J]. Meccanica, 2014, 49(12): 2785-2796.

[4] 錢營,葛云,谷家偉,等. 正壓紅花采摘裝置氣流場分析與結構優化[J]. 計算機仿真,2016,33(1):264-267. QIAN Ying, GE Yun, GU Jiawei. et al. Air flow simulation and flow field optimization for positive pressure safflower picking device[J]. Computer Simulation, 2016, 33(1): 264-267. (in Chinese with English abstract)

[5] 陳元博,葛云,梁丹丹,等. 對輥式紅花采收實驗臺的設計與研究[J]. 農機化研究,2017,39(10):38-41. CHEN Yuanbo, GE Yun, LIANG Dandan, et al. Design and research of the roller type safflower harvest test bed[J]. Journal of Agricultural Mechanization Research, 2017, 39(10): 38-41. (in Chinese with English abstract)

[6] 曹衛彬,連國黨,牛馳,等. 梳夾式紅花絲采摘頭等高采收性能試驗與參數優化[J]. 農業工程學報,2018,34(22):36-44. CAO Weibin, LIAN Guodang, NIU Chi, et al. Harvest performance test and parameter optimization of comb-type safflower-filaments picking head at same height[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(22): 36-44. (in Chinese with English abstract)

[7] 張振國,呂全貴,任杰宇,等. 旋轉剪切式紅花花絲采摘機械關鍵部件的設計[J]. 中國農機化學報,2019,40(7):1-6. ZHANG Zhenguo, LV Quangui, REN Jieyu et al.Design of critical compinents for safflower harvesting machinery by rotary shear[J]. Journal of Chinese Agricultural Machanization, 2019, 40(7): 1-6. (in Chinese with English abstract)

[8] 張曉偉,葛云,陳飛,等. 三手指拉拔式紅花采摘末端執行器的設計[J]. 機械設計與制造,2022(1):145-149. ZHANG Xiaowei, GE Yun, CHEN Fei, et al. Design of three-finger pull-out safflower picking end effector[J]. Machinery Design and Manufacture, 2022(1): 145-149. (in Chinese with English abstract)

[9] GUO H, LUO D, GAO G, et al. Design and experiment of a safflower picking robot based on a parallel manipulator[EB/OL]. (2022-06-18)[2022-11-19] https://doi.org/10.1590/1809- 4430-Eng.Agric.v42n1e20210129/2022.

[10] ZHANG H, GE Y, SUN C, et al. Picking path planning method of dual rollers type safflower picking robot based on improved ant colony algorithm[J]. Processes, 2022, 10(6): 1213.

[11] Girshick R. Fast R-CNN[C]//Santiago: Proceedings of the IEEE International Conference on Computer Vision. 2015: 1440-1448.

[12] Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]//Las Vegas, NV, USA: IEEE Conference on Computer Vision and Pattern Recognition. 2016: 779-788.

[13] Redmon J, Farhadi A. YOLOV3: An incremental improvement[EB/OL].(2018-04-08)[2022-11-19] https://arxiv.org/abs/1804.02767.

[14] WANG C Y, Bochkovskiy A, Liao H Y M. YOLOv7: Trainable bag-of-freebies sets new state-of-the-art for real-time object detectors[EB/OL]. (2022-07-06)[2022-11-19] https://arxiv.org/abs/ 2207.02696.

[15] 宋懷波,尚鈺瑩,何東健. 果實目標深度學習識別技術研究進展[J]. 農業機械學報,2023,54(1):1-19. SONG Huaibo, SHANG Yuying, HE Dongjian. Review on deep learning technology for fruit target recognition[J]. Transactions of the Chinese Society for Agricultural Machinery, 2023, 54(1): 1-19. (in Chinese with English abstract)

[16] 趙德安,吳任迪,劉曉洋,等. 基于 YOLO 深度卷積神經網絡的復雜背景下機器人采摘蘋果定位[J]. 農業工程學報:2019,35(3):164-173. ZHAO De’an, WU Rendi, LIU Xiaoyang, et al. Apple positioning based on YOLO deep convolutional neural network for picking robot in complex background[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(3): 164-173. (in Chinese with English abstract)

[17] 呂佳,李帥軍,曾夢瑤,等. 基于半監督SPM-YOLOv5的套袋柑橘檢測算法[J]. 農業工程學報,2022,38(18):204-211. Lyu Jia, LI Shuaijun, ZENG Mengyao, et al. Detecting bagged citrus using a semi-supervised SPM-YOLOv5[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(18): 204-211. (in Chinese with English abstract)

[18] JIA W, TIAN Y, LUO R, et al. Detection and segmentation of overlapped fruits based on optimized mask R-CNN application in apple harvesting robot[J]. Computers and Electronics in Agriculture, 2020, 172: 105380.

[19] 岳有軍,田博凱,王紅君,等. 基于改進Mask RCNN的復雜環境下蘋果檢測研究[J]. 中國農機化學報,2019,40(10):128-134. YUE Youjun, TIAN Bokai, WANG Hongjun, et al. Research on apple detection in complex environment based on improved Mask RCNN[J]. Journal of Chinese Agricultural Machanization, 2019, 40(10): 128-134. (in Chinese with English abstract)

[20] ZHANG J, Karkee M, ZHANG Q, et al. Multi-class object detection using faster R-CNN and estimation of shaking locations for automated shake-and-catch apple harvesting[J]. Computers and Electronics in Agriculture, 2020, 173: 105384.

[21] 朱旭,馬淏,姬江濤,等. 基于Faster R-CNN的藍莓冠層果實檢測識別分析[J]. 南方農業學報,2020,51(6):1493-1501. ZHU Xu, MA Hao, JI Jiangtao, et al. Detecting and identifying blueberry canopy fruits based on Faster R-CNN[J]. Journal of Southern Agriculture, 2020, 51(6): 1493-1501. (in Chinese with English abstract)

[22] 李天華,孫萌,丁小明,等. 基于YOLO v4+HSV的成熟期番茄識別方法[J]. 農業工程學報,2021,37(21):183-190. LI Tianhua, SUN Meng, DING Xiaoming, et al. Tomato recognition method at the ripening stage based on YOLO v4 and HSV[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(21): 183-190. (in Chinese with English abstract)

[23] 楊堅,錢振,張燕軍,等. 采用改進YOLOv4-tiny的復雜環境下番茄實時識別[J]. 農業工程學報,2022,38(9):215-221. YANG Jian, QIAN Zhen, ZHANG Yanjun, et al. Real-time recognition of tomatoes in complex environments based on improved YOLOv4-tiny[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(9): 215-221. (in Chinese with English abstract)

[24] 張伏,陳自均,鮑若飛,等. 基于改進型 YOLOv4-LITE 輕量級神經網絡的密集圣女果識別[J]. 農業工程學報,2021,37(16):270-278. ZHANG Fu, CHEN Zijun, BAO Ruofei, et al. Recognition of dense cherry tomatoes based on improved YOLOv4-LITE lightweight neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(16): 270-278. (in Chinese with English abstract)

[25] CHEN C, LU J, ZHOU M, et al. A YOLOv3-based computer vision system for identification of tea buds and the picking point[J]. Computers and Electronics in Agriculture, 2022, 198: 107116.

[26] CAO M, FU H, ZHU J, et al. Lightweight tea bud recognition network integrating GhostNet and YOLOv5[J]. Mathematical Biosciences and Engineering, 2022, 19(12): 12897-12914.

[27] 張大刀,YOLOv7 網絡架構深度解析[EB/OL].(2022-07-20)[2022-11-19] https: //blog. csdn. net/zqwwwm/article/details/125901507.

[28] LIU Z, LIN Y, CAO Y, et al. Swin transformer: Hierarchical vision transformer using shifted windows[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Virtual, 2021: 10012-10022.

[29] LIN T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]//Proceedings of the IEEE International Conference on Computer Vision. Venice, 2017: 2980-2988.

Safflower picking recognition in complex environments based on an improved YOLOv7

WANG Xiaorong1,2, XU Yan1,2, ZHOU Jianping1,2※, CHEN Jinrong1

(1.,,830017,;2.,830017,)

Safflower silk is one of the most important cash crops in the medical treatment and dye. The manual picking of safflower silk cannot fully meet the large-scale production at present. The mechanized harvesting can be expected to improve the safflower harvesting efficiency and labor cost-saving in the industrial planting. The complex environmental factors have made great difficulty to accurately identify and locate the safflower during mechanical picking, including the natural environment (such as the light and shelter), and the safflower characteristics (such as the small and dense target, as well as the different maturity). In this study, an improved YOLOv7 model was proposed to rapidly and accurately locate the safflower recognition in the complex environment. 1500 safflower images were established to divide into three types of samples, silk, bulb, and decay. The small target was found in the datasets with uneven sample size, especially the data of decay. The safflower sample dataset was produced to build the complex environment data for the real picking. Firstly, the Swin Transformer attention mechanism was added to the YOLOv7 network model, in order to improve the detection accuracy of the model for each classification sample, and the ability of the backbone network, especially to extract the small target features. Secondly, the Focal Loss function of the multi-classification was improved in the recognition rate of unbalanced samples under multi-class tasks, particularly for the target confidence loss and classification loss. The attenuation parameterswas adjusted to balance the sample. The attenuation parameters were determined after experimental verification. Finally, the safflower detection network model was designed to meet the real-time and accurate detection requirements under the complex environment. The test results show that the best performance of the model was achieved in the attenuation parameters of 1.0, where the position of Swin Transformer was the layer 50. The average precision of the improved model reached 88.5% in each category sample, which was 7.0 percentage points higher than before. The average detection accuracy of the unbalanced category sample decay was 15.9 percentage points higher. Compared with the Faster RCNN model, the detection speed increased by three times, while the average accuracy increased by 9.7 percentage points; Compared with the Deformable DETR model, the detection speed increased by about 5 times, and the average accuracy increased by 16.5 percentage points. The improved model performed the best, in terms of the detection efficiency, detection speed, and model size. The improved model can also be expected to accurately detect the safflower, indicating the smaller parameters and the faster recognition speed suitable for the migration deployment on the safflower picking machinery. The finding can provide the technical support for the mechanized picking in real time. In the future research, the balance between species can be promoted to expand the number of samples from the data level in the harvesting machinery.

image recognition; image processing; complex environments; YOLOv7; attention mechanisms; multi-classification focal loss function; safflower picking

10.11975/j.issn.1002-6819.202211164

S225;TP391

A

1002-6819(2023)-06-0169-08

王小榮,許燕,周建平,等. 基于改進YOLOv7的復雜環境下紅花采摘識別[J]. 農業工程學報,2023,39(6):169-176.doi:10.11975/j.issn.1002-6819.202211164 http://www.tcsae.org

WANG Xiaorong, XU Yan, ZHOU Jianping, et al. Safflower picking recognition in complex environments based on an improved YOLOv7[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2023, 39(6): 169-176. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.202211164 http://www.tcsae.org

2022-11-19

2023-03-01

新疆維吾爾自治區創新團隊項目-機器人及智能裝備技術科技創新團隊(2022D14002)

王小榮,博士生,研究方向為人工智能、農業機械化與信息化。Email:XiaorongWang@xju.edu.cn

周建平,教授,博士生導師,研究方向為機電一體化、農業機械化與信息化。Email:linkzhou@163.com