基于改進YOLOv5s的自然環境下獼猴桃花朵檢測方法

龔惟新,楊 珍,李 凱,郝 偉,何 智,丁辛亭,崔永杰

基于改進YOLOv5s的自然環境下獼猴桃花朵檢測方法

龔惟新,楊 珍,李 凱,郝 偉,何 智,丁辛亭,崔永杰※

(1. 西北農林科技大學機械與電子工程學院,楊凌 712100;2. 農業農村部農業物聯網重點實驗室,楊凌 712100;3.陜西省農業信息感知與智能服務重點實驗室,楊凌 712100)

為實現對獼猴桃花朵的快速準確檢測,該研究提出了一種基于改進YOLOv5s的獼猴桃花朵檢測模型YOLOv5s_S_N_CB_CA,并通過對比試驗進行了精度驗證。在YOLOv5s基礎上引入C3HB模塊和交叉注意力(criss-cross attention,CCA)模塊增強特征提取能力,結合樣本切分和加入負樣本處理方法進一步提升模型精度。改進模型的檢測精確率為85.21%,召回率為90%,模型大小為14.6 MB,交并比(intersection over union,IoU)為0.5下的均值平均精度(mAP0.5)為92.45%,比僅進行樣本縮放處理的原始YOLOv5s提高了31.91個百分點,檢測速度為35.47 幀/s,比原始YOLOv5s提高了34.15%。使用改進模型對自然環境下不同天氣、晴天不同時段光照強度下的獼猴桃花朵進行檢測,結果表明模型檢測晴天、陰天下獼猴桃花朵的mAP0.5分別為91.96%、91.15%,比原始YOLOv5s分別高出2.55、2.25個百分點;檢測晴天9:00-11:00、15:00-17:00光強下獼猴桃花朵的mAP0.5分別為92.11%、92.10%,比原始YOLOv5s分別高出2.20、1.32個百分點。結果表明,該研究提出的基于改進YOLOv5s的獼猴桃花朵檢測模型在保持輕量化的同時,檢測精度高、速度快,可實現對自然環境下獼猴桃花朵的有效檢測。

圖像處理;模型;目標檢測;獼猴桃花朵;改進YOLOv5s;自然環境

0 引 言

授粉對于提高獼猴桃果實產量,增強果實品質至關重要。對于獼猴桃果樹等無法自花授粉的雌雄異株植物,常借助風媒、蟲媒及人工輔助授粉等傳統授粉方式進行授粉,從而確保獼猴桃的優質高產[1-2]。但傳統授粉方式存在一定缺陷,例如:蟲媒受天氣影響較大,遇風雨天氣會導致昆蟲無法正常授粉[3],且因環境污染導致授粉昆蟲數量減少的情況也時有發生[4-5];人工輔助授粉中的花對花授粉、毛筆點授、簡易授粉器授粉和電動授粉槍授粉等方式,對授粉精度、花粉用量均有較高要求,且勞動強度大,耗時費力[6]。因此,為解決上述問題,保證獼猴桃花朵授粉率和獼猴桃掛果率[7-8],很多專家學者提出利用自動化授粉的作業方式,引入農業機器人技術,對獼猴桃開展有關自動化授粉智能裝備方面的研究。

對于獼猴桃自動化授粉裝備而言,最重要是實現對獼猴桃花朵目標的精準檢測,為后續授粉機械的作業路徑規劃、末端執行器的精準對靶授粉提供有利保障[9-10]。隨著卷積神經網絡(convolutional neural networks,CNN)的出現,深度學習技術以其優良的特征提取能力及泛化能力逐漸運用于果蔬花朵及花卉的識別上[11]。基于深度學習的目標檢測算法可分為基于區域提取的雙階段(two-stage)框架和基于回歸的單階段(one-stage)框架,其中雙階段框架在處理過程中先確定出樣本的候選框,接著對樣本通過CNN網絡分類[12],檢測精度較高,但實時性較差,其代表性算法包括R-CNN、Faster R-CNN等;單階段框架在處理時不產生候選框,直接在一定的回歸分析基礎上實現目標檢測,檢測速度較快,其代表性算法包括YOLO、SSD等。

在果蔬花朵及花卉檢測領域,許多專家學者針對兩類目標檢測算法開展了相關研究。在針對基于區域提取的目標檢測算法研究中,FARJON等[13]提出了一種基于Faster-RCNN網絡進行蘋果花識別算法,并使用線性回歸方法進行預測花朵密度計算,之后根據開花量衰減時間預估開花峰值期預估,用于輔助蘋果疏花決策。劉浩洲等[14]提出一種基于-means聚類的獼猴桃花朵識別方法,通過-means 聚類分割,然后由經過訓練的卷積神經網絡進行分類選出花蕊圖像,完成獼猴桃花朵識別,識別成功率為92.5%。林君宇等[15]針對10種常見觀賞花卉,提供一個包含4種花卉的共16種葉部病癥的圖像數據集,設計并實現基于卷積神經網絡的分類模型,集成為花卉分類-病癥識別一體化工具,該工具可實現95.3%的花卉分類準確率和88.2%的疾病識別準確率。WILLIAMS等[16]設計了一種獼猴桃授粉機器人,應用全卷積神經網絡機器視覺系統對獼猴桃花朵進行識別,識別準確率達到90%以上,授粉率為79.5%,相較人工授粉效率仍存在一定差距。此類基于區域提取的雙階段目標檢測算法具有較高的檢測精度,但難以進行實時性檢測,無法滿足農業智能裝備實時性、高效性的作業要求。

在針對基于回歸的目標檢測算法研究中,XIA等[17]提出了一種基于TensorFlow平臺的Inception-v3模型,利用遷移學習技術在ImageNet中的花卉數據集中構建了花卉識別模型,該模型在Oxford17 和Oxford102花朵數據集上的分類準確率分別為95%和94%。SUN等[18]提出了一種基于DeepLab-ResNet語義分割網絡的蘋果花、桃花和梨花檢測方法,該方法將語義分割技術與水平集實現的形狀約束活動輪廓相結合,在桃花、梨花和蘋果花朵數據集上的平均F1分數為80.9%。此類基于回歸的雙階段目標檢測算法在保持較高檢測精度的同時,具有較高的檢測速度,可實現實時檢測,能夠滿足農業智能裝備的高效作業要求。

目前,基于深度學習的果蔬花朵及花卉檢測,多針對生長分布較為稀疏、規整且背景簡單的常見水果花朵和觀賞花卉,如蘋果花[19]、向日葵[15]等。自然環境中的獼猴桃花朵呈簇狀密集生長分布,花朵間緊密粘連,存在相互重疊或遮擋;獼猴桃所處生長環境露天無遮蔽,其棚架栽培的管種模式使得部分花朵易受枝葉遮擋及不穩定光照影響,這些干擾因素均為獼猴桃花朵的檢測帶來了一定的難度和挑戰。

因此,針對自然環境下存在復雜背景的獼猴桃花朵,本研究提出一種基于改進YOLOv5s的獼猴桃花朵檢測方法,通過改進YOLOv5s的骨干網絡和預測層結構,結合一定的樣本處理方法,從而實現對自然環境下獼猴桃花朵的準確快速檢測。本研究可為獼猴桃自動化授粉裝備信息感知系統的搭建提供理論依據和技術支撐。

1 材料與方法

1.1 圖像采集與數據集構建

本文主要研究對象是“海沃德”品種的獼猴桃花朵,所采集花朵圖像來自陜西省眉縣西北農林科技大學獼猴桃試驗站(4°7'39″N,107°59'50″E,海拔約648 m)。圖像采集設備為索尼(SONY)Alpha7Ⅱ(a7M2K)全畫幅微單數碼相機,焦距、曝光和拍攝模式均為自動,圖像分辨率為6 000×4 000像素,拍攝時間為 2022年5月3日至5月11日,時段為09:00-17:00。拍攝形式為定點拍攝,模擬授粉機械的作業方式,通過三腳架固定設備位置,沿豎直方向自下而上以仰視視角進行拍攝,圖像設備距離地面(0.9±0.1)m。

在圖像采集過程中,針對不同天氣(晴天和陰天)、晴天不同時段光照強度(早晨09:00-11:00和下午15:00-17:00)下的獼猴桃花朵進行圖像采集,同時考慮花葉間遮擋情況,采集了無遮擋、花朵間相互遮擋和枝葉遮擋3種情況下的花朵圖像(圖1),確保所構建試驗樣本數據庫的全面性。所采集試驗樣本圖像共1 032幅,如表1所示。

圖1 3種不同遮擋情況

表1 采集圖像詳細信息

為提升網絡泛化能力,從采集的1 032幅獼猴桃花朵樣本圖像中選取部分圖像,通過Comic Enhancer Pro軟件亮度增強20%和40%各282幅,亮度減弱20%和40%各282幅,對比度增強20%和40%各282幅、對比度減弱20%和40%各282幅,僅銳化1級、銳化3級、銳化4級各280幅。增強后的圖像數量達到3 096幅。圖像增強處理后得到的圖像加上原始圖像共4 128幅。

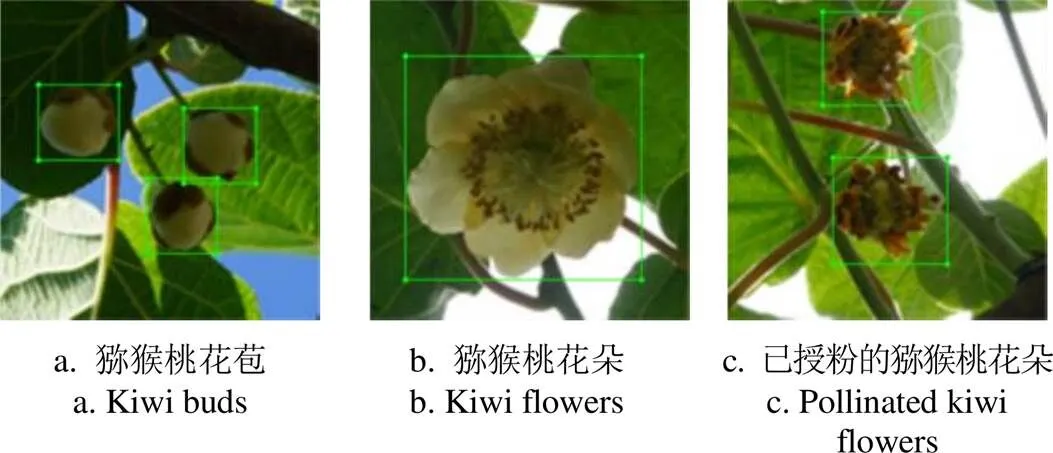

使用LabelImg工具對構建的數據集進行手動標注,對目標以最小外接矩形框進行標注。本研究將標注目標即待檢獼猴桃花朵分為3類,包括獼猴桃花苞(bud)、獼猴桃花(flower)以及已自然授粉的獼猴桃花朵(pollinated),如圖2所示。隨后將4 128幅圖像按照7∶2∶1的比例分為訓練集(2 889幅)、驗證集(826幅)和測試集(413幅)進行模型訓練和試驗。

圖2 標注目標類別

1.2 基于改進YOLOv5s的獼猴桃花朵檢測模型構建

YOLOv5網絡因其體積小,計算速度快的優點,被廣泛應用于各種目標檢測場景下,其根據網絡深度差異可分為YOLOv5s、YOLOv5m、YOLOv5l、YOLOv5x。為滿足本研究的輕量化需求,選用復雜度較低的YOLOv5s檢測模型,能夠在確保較高檢測精度的前提下,保持較小的儲存占用和較快的識別速度[20],有利于在移動設備上的搭載和實現[21-22]。

YOLOv5s主要結構包括輸入端、骨干網絡(backbone)、頸部網絡(neck)和預測層(prediction)4個部分[23]。其輸入端用于對圖像進行數據增強,并對圖像處理策略和錨框生成機制進行優化。backbone用于提取圖像中的特征圖,沿用CSPDarknet53結構,應用跨階段連接方式融合特征,可以有效緩解梯度消失的問題,并減少網絡參數的數量[24-26]。neck部分使用特征金字塔網絡(feature pyramid networks,FPN)結構和路徑聚合網絡(path aggregation network,PAN)結構增強特征,從而有效豐富特征信息,進而提高預測準確性。prediction部分應用網絡提取的特征,對預測目標的類別概率和位置信息進行推理,獲得網絡輸出信息。

本研究針對自然環境下的獼猴桃花朵目標檢測,在YOLOv5s的基礎上,提出一種改進的YOLOv5s網絡模型。由于獼猴桃花朵生長密集,花朵間存在相互重疊或遮擋,且受露天棚架模式下的光照影響,花朵特征在圖像中可能存在表征不清晰的情況,因此需要通過改進網絡模型,增強對花朵粘連、遮擋及不同光照等情況下的特征提取能力,提高檢測精度。基于以上考慮,對模型的主要改進點包括:在主干網絡中引入C3HB模塊[27],用以增強特征提取能力;在預測層中引入交叉注意力(criss-cross attention,CCA)模塊[28],達到進一步提升檢測精度的目的。改進后的YOLOv5s網絡模型有望在保持輕量化和較快檢測速度的前提下,進一步提升在自然環境下對獼猴桃花朵的識別精度。改進后的YOLOv5s結構如圖3所示。

注:CBS為Conv+BN+SiLU,Conv為卷積操作,BN為歸一化操作,SiLU為Sigmoid加權線性組合激活函數,SPPF為快速空間金字塔池化結構,Upsampling為上采樣操作,Concat為特征融合函數,Maxpool為最大池化操作。

1.2.1 C3HB模塊

C3HB模塊主要由CBS模塊、Horblock模塊和Concat操作組成(圖4a)。Horblock模塊來源于HorNet[29],其結合了ViT(vision transformer)和CNN的優點提出遞歸門控卷積(recursive gated convolutions),通過遞歸設計,執行高效、可擴展和平移的高階空間信息交互。圖4b、4c展示了Horblock模塊及遞歸門控卷積(gConv)的結構,遞歸門控卷積由標準卷積、逐元素乘法和線性投影層組成,具有類似于自注意力的自適應混合功能。

C3HB模塊的運行流程如下:

1)輸入的初始特征信息會分配到2條分支中;

2)將輸入特征信息的通道數減半,一部分特征信息通過分支1的CBS模塊進行特征提取,另一部分通過分支2的Horblock模塊和CBS模塊進行特征提取;

3)2條分支輸出的特征信息使用Concat操作深度連接;

4)最后通過一個CBS模塊進行特征增強,使得輸出C3HB模塊的特征信息大小與輸入C3HB模塊的大小相同。

相較于原始YOLOv5模型,引入C3HB模塊增強了網絡學習能力,以輕量級的方式減少了計算瓶頸和內存成本。改進后的模型增強了提取圖像中花朵細節的能力,通過學習更準確的花朵特征,以期實現對圖像中粘連、重疊的獼猴桃花朵有效檢測。

注:n為某一特征和其周邊特征相互作用的階數;C為每一階的通道維度數。

1.2.2 CCA模塊

棚架栽培模式下生長的獼猴桃花朵露天無遮蔽,圖像背景中包含光線直射、陰影、枝葉、天空等復雜背景,影響模型對花朵的檢測精度。為進一步提升模型提取復雜背景下花朵特征的能力,本研究在YOLOv5s的預測層引入交叉注意力模塊對模型進行改進,以期進一步適應自然環境下對獼猴桃花朵的快速檢測。

交叉注意力(CCA)模塊用于獲取全局上下文信息。該模塊可以捕獲每個像素在水平和垂直方向上的上下文信息,基于非局部注意力模塊,利用兩次注意力加權,并用多個稀疏注意力圖代替單個密集注意力圖,節省計算資源的消耗[30]。CCA模塊結構如圖5所示。

注:H為局部特征圖;Q、K、V分別為H經降維后生成的特征圖;A為Q和K經Affinity和Softmax運算后生成的注意力圖;為H經CCA運算后生成的新特征圖。

其處理流程如下[28]:

1)將局部特征圖輸入交叉注意力模塊,該模塊首先應用2個1×1的卷積層進行降維,生成2個特征圖和;

2)通過Affinity和Softmax運算進一步生成注意力圖;

Affinity運算式如下:

3)將輸入第三個1×1的卷積層中進行降維,生成特征圖,將其與2)中生成的注意力圖進行Aggregation運算;

Aggregation運算式如下:

1.3 試驗環境

本文使用Pycharm對YOLOv5s網絡模型進行構建與改進,試驗與訓練所用操作系統為Windows10,處理器為Intel Xeon E5-1650 v4,3.6 GMz,內存32 G,顯卡為Nvidia GeForce RTX 3060Ti,顯存8 G,編程語言為Python3.7。

1.4 評價指標

本文采用5個指標用于評價獼猴桃花朵檢測模型,分別為精確率(precision,)、召回率(recall,)、均值平均精度(mean average precision,mAP)、模型大小和檢測速度,并采用交并比(intersection over union,IoU)用于準確度的評價。、、mAP和IoU的具體計算方法可見參考文獻[31-33]。

1.5 模型訓練

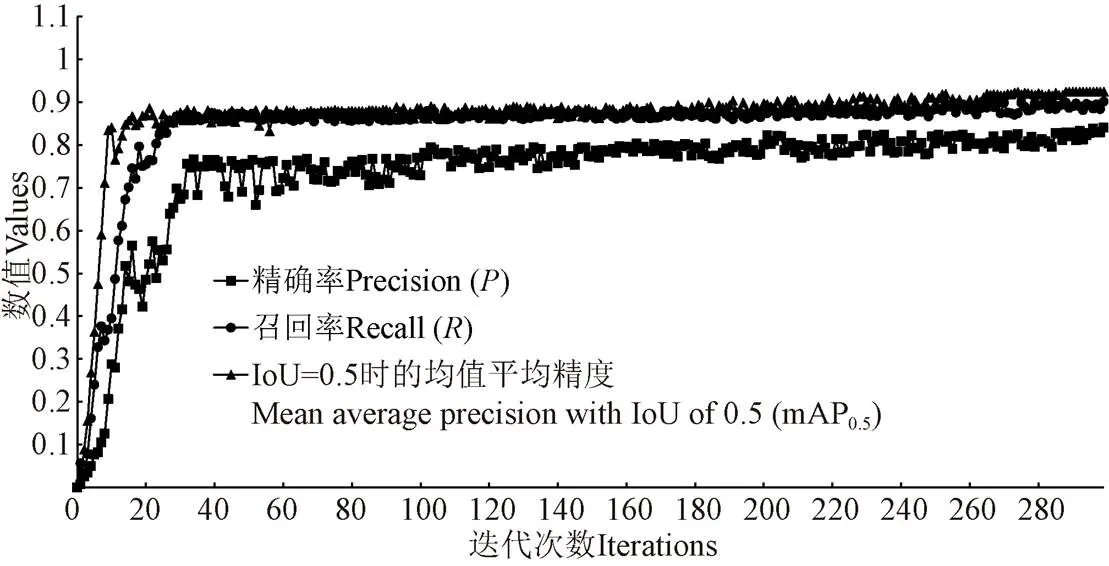

改進獼猴桃花朵檢測模型共訓練300輪次,訓練初期模型值、值、mAP0.5(IoU=0.5)值增長較快,此時模型學習效率高、損失值快速收斂;迭代至250次左右時,、、mAP0.5趨于穩定,損失值收斂至0.024左右;300次迭代后,模型的值為83.42%,值為90%,mAP0.5為92.39%。圖6為模型訓練中值、值、mAP0.5值變化趨勢圖。

圖6 模型訓練中P、R、mAP0.5變化趨勢

2 結果與分析

2.1 不同改進方法和樣本處理方法的YOLOv5s模型性能對比

為了評價本文提出的YOLOv5s改進方法對獼猴桃花朵檢測的有效性,在其余結構保持不變的條件下對YOLOv5s原始模型進行不同改進(表2),并對訓練集樣本進行不同處理,之后進行訓練,訓練輪次為300,得到包括本文提出的改進模型在內的5種YOLOv5s改進模型。再利用測試集對上述5個模型的mAP0.5(IoU= 0.5)值和mAP0.5~0.95(IoU= 0.5~0.95)值進行評估。5種模型的性能對比如表2所示。

表2 5種改進方法和樣本處理方法的模型性能對比

注:Z(Zoom)表示加入樣本縮放處理,S(Segmentation)表示加入樣本切分處理,N(Negative Sample)表示加入負樣本,CB表示引入C3HB模塊,CA表示引入CCA模塊,F(Focal loss)表示引入焦點損失函數。

Note: Z (Zoom) indicates the addition of sample scaling, S (Segmentation) indicates the addition of sample slicing, N (Negative Sample) indicates the addition of negative sample, CB indicates the addition of C3HB module, CA indicates the addition of CCA module, and F (Focal loss) indicates the addition of focal loss function.

分析表2可知:改進模型YOLOv5s_S_N_CB_CA檢測獼猴桃花朵測試集的mAP0.5值和mAP0.5~0.95值分別為92.45%和75.14%,比其余改進模型YOLOv5s_Z1、YOLOv5s_Z2、YOLOv5s_S_N和YOLOv5s_S_N_CB_ CA_F的mAP0.5分別高出31.91、38.32、2.55、1.08個百分點,mAP0.5~0.95分別高出34.38、42.93、1.92、1.37個百分點。

結果表明,在對訓練集樣本進行切分處理,并加入負樣本后,可使改進模型檢測獼猴桃花朵時的mAP0.5和mAP0.5~0.95具有較大提升;當繼續引入C3HB模塊和CCA模塊后,引入后的改進模型檢測精度有了進一步提升;在前述改進的基礎上繼續引入焦點損失函數,則引入后的模型檢測精度會出現小幅下降。

分析出現以上結果的原因如下:

1)對原始樣本圖像進行切分處理,可以提高需檢測的獼猴桃花朵像素在切分后圖像像素中的占比,相較于縮放處理能夠避免圖像信息損失;加入負樣本訓練進一步增強了模型的學習能力,提高檢測精度。

2)在原始YOLOv5模型中引入C3HB模塊和CCA模塊后,模型特征提取能力增強,檢測精度進一步提升。

3)模型中引入Focal loss能夠均衡模型對數量不同的樣本的學習能力,但其易受噪聲影響,對標注精度要求高,若樣本中出現離群點(outliers)則會導致過擬合,使得檢測精度下降。

由此表明,本文提出的YOLOv5s_S_N_CB_CA模型,其改進方法對獼猴桃花朵具有較好的檢測精度,相較于其他改進模型具有一定優勢,表明了本研究所提模型改進方法的有效性。

2.2 不同目標檢測模型的性能對比

為了評價本文提出的YOLOv5s_S_N_CB_CA模型對獼猴桃花朵的檢測效果,選用原始YOLOv5s、YOLOv4[34]和SSD[35]與YOLOv5s_S_N_CB_CA進行性能對比,利用2.1節中樣本切分為640×640(像素)并加入負樣本的訓練集,分別對原始YOLOv5s模型、YOLOv4模型和SSD模型進行訓練,訓練輪次為300,之后利用測試集對上述4種已訓練完畢的檢測模型開展性能測試評估,4種檢測模型的性能比較如表3所示。

表3 4種目標檢測模型性能對比

分析表3測試結果可以得出:本文提出的改進模型YOLOv5s_S_N_CB_CA檢測獼猴桃花朵的精確率雖比YOLOv4和SSD分別低0.90和0.72個百分點,比YOLOv5s高2.36個百分點,但其值分別比YOLOv4和SSD高7.00和12.00個百分點,比YOLOv5s高2.00個百分點,mAP0.5分別比YOLOv5s、YOLOv4和SSD高2.55、9.95和13.64個百分點,其模型大小比YOLOv5s大5.80%,但分別比YOLOv4和SSD小93.37%和83.39%,檢測速度分別比YOLOv5s、YOLOv4和SSD快34.15%、144.62%和20.03%。

分析出現以上結果的原因如下:

1)本文模型在YOLOv5s基礎上引入了C3HB模塊和CCA模塊,增加了模型復雜程度,使得模型大小相較于YOLOv5s小幅增加,但檢測精確率、召回率、mAP0.5和檢測速度均有所提升。

2)本文模型基于YOLOv5s,相較于YOLOv4,其在Backbone和Neck加入了改進CSP結構,同時減少數據增強方式,并加入了自適應錨框等改進策略[34],使得其在不顯著降低檢測精確率的同時,提升召回率、mAP0.5和檢測速度,并大幅降低了模型大小。

3)YOLO系列網絡模型與SSD網絡模型在結構有上較大區別,其中YOLO的Backbone采用的Darknet53比SSD采用的VGG具有更強的特征提取能力。此外,SSD中加入了YOLO沒有的先驗框[35]。在整體綜合性能上兩者較為接近,而加入本文所提改進后使得改進后的YOLOv5s在召回率、mAP0.5和檢測速度上均優于SSD。

結果表明,本文提出的改進模型YOLOv5s_S_N_CB_CA在綜合性能上相較于其他目標檢測模型具有一定優勢,能夠實現獼猴桃花朵的準確、快速檢測,且模型輕量,有利于遷移應用,可為獼猴桃自動化授粉裝備的發展提供一定的技術支持。

2.3 不同天氣和不同時段下的檢測效果對比

為了評價本文改進模型YOLOv5s_S_N_CB_CA對不同天氣和不同時段光照強度的適應性,使用測試集中按不同天氣情況和晴天不同時段分類的獼猴桃花朵圖像對YOLOv5s_S_N_CB_CA模型和原始YOLOv5s模型進行測試,表4為不同天氣和晴天不同時段下兩種模型對獼猴桃花朵的檢測效果。

表4 不同天氣和晴天不同時段下2種目標檢測模型性能對比

1)YOLOv5s_S_N_CB_CA對晴天、陰天下的獼猴桃花朵檢測效果如圖7a~7b所示。由表4可知,YOLOv5s_ S_N_CB_CA檢測晴天、陰天天氣下的獼猴桃花朵的值分別為85.17%、83.88%,分別比YOLOv5s高出2.51、2.49個百分點;值分別為90%、89%,分別比YOLOv5s高出2.00、1.00個百分點;mAP0.5值分別為91.96%、91.15%,分別比YOLOv5s高出2.55、2.25個百分點。結果表明,在晴天和陰天兩種天氣下,本文改進模型YOLOv5s_S_N_CB_CA均可以識別出獼猴桃花朵,且精度較高。

2)YOLOv5s_S_N_CB_CA對晴天不同時段下的獼猴桃花朵檢測效果如圖7c~7d所示。由表4可知,YOLOv5s_S_N_CB_CA檢測晴天9:00-11:00和15:00-17:00時段下獼猴桃花朵的值分別為84.47%、84.79%,分別比YOLOv5s高出2.17、2.24個百分點;值分別為89%、89%,分別比YOLOv5s高出1.00、2.00個百分點;mAP0.5值分別為92.11%、91.10%,分別比YOLOv5s高出2.20、1.32個百分點。結果表明,對于晴天9:00-11:00和15:00-17:00兩種時段下的光照強度,本文改進模型YOLOv5s_S_N_CB_CA均可以識別出獼猴桃花朵,且精度較高。

圖7 不同天氣、晴天不同時段的檢測效果圖

2.4 檢測效果評價

為評價本文改進模型YOLOv5s_S_N_CB_CA檢測獼猴桃花朵的效果,將訓練好的模型通過310幅測試集圖像進行檢測精度驗證。結果表明,YOLOv5s_S_N_CB_CA檢測獼猴桃花朵的值為85.21%,值為90%,mAP0.5值為92.45%,模型大小為14.6 MB,檢測速度為35.47幀/s。

檢測實例如圖8a~8c所示,圖中每個獼猴桃花苞、獼猴桃花及已自然授粉花朵均可被準確識別。其中,花和花苞檢測置信度的平均值在0.90以上,已自然授花朵檢測置信度的平均值在0.80以上,表明該模型可以有效檢測出獼猴桃花苞、獼猴桃花及已自然授粉花朵,且置信度較高。此外,對于在更復雜場景中所采集的圖像,如廣域視場范圍內3類花朵共存、花朵間重疊遮擋和花朵密集分布的情況,本文改進模型YOLOv5s_S_N_CB_CA均可實現有效檢測(圖8d~8f)。

2.5 漏檢與誤檢分析

在利用本文所提模型YOLOv5s_S_N_C3HB_CCA對驗證集圖像中的獼猴桃花朵進行檢測時,仍會出現如圖9所示的漏檢和誤檢情況,由圖可以看出:部分獼猴桃花和花苞被漏檢(圖9a、9b中藍圈所示),同時也存在葉片被誤檢為花苞(圖9c中藍圈所示)和花苞被誤檢為花(圖9d中藍圈所示)等情況。分析出現漏檢和被誤檢的可能原因如下:

1)YOLOv5s_S_N_C3HB_CCA模型對于形狀較規則且分布較稀疏的獼猴桃花朵檢測效果較好,但自然環境下的獼猴桃花朵生長較為密集且呈簇狀分布,花朵間易出現相互重疊或遮擋等情況。如圖9a、9b中藍圈所示,當遮擋或重疊現象較為嚴重時,處于上層的獼猴桃花朵會遮擋住下層的獼猴桃花朵的大部分特征,導致圖像中上層獼猴桃花朵特征明顯,而下層獼猴桃花朵特征難以表征。模型在處理此類情況時難以提取下層花朵特征,導致檢測時出現僅上層花朵成功檢出,而下層花朵無法檢出的情況,造成漏檢。

2)自然環境下所采集的獼猴桃花朵圖像,其成像質量受天氣和光照強度等因素影響較大,光線分布不均與遮擋情況的存在,引起圖像中某些花朵的局部區域光線較暗,與葉片所處的背景對比度較低,導致模型對花朵特征的辨別與提取存在一定困難。如圖9c中藍圈所示,由于棚架下葉片對光線的遮擋,光照強度較低,致使獼猴桃花苞局部區域與面積較小的葉片呈現出近似的特征,導致模型在處理此類情況時,誤將面積較小的葉片識別為獼猴桃花苞,造成誤檢。

注:圖中方框內為檢測出的獼猴桃花朵。藍色方框內為獼猴桃花苞;粉色方框內為獼猴桃花;紅色方框內為已授粉的花朵。

注:9a中左側藍圈內為漏檢的獼猴桃花,右側藍圈內為漏檢的花苞;9b中藍圈內為漏檢的獼猴桃花;9c中藍圈內為被誤檢為花苞的葉片;9d中藍圈內為被誤檢為獼猴桃花的花苞。

3)獼猴桃花苞在特定生長時期內,會出現大部分花瓣包裹花蕊而個別花瓣展開的情況,或是花瓣略微展開,僅暴露一小部分花蕊的情況,此時獼猴桃花苞會呈現出與開放的獼猴桃花近似的特征,如圖9d中藍圈所示。但此類情況下花瓣尚未完全展開,花蕊并未充分暴露出,尚不滿足授粉條件,故本文中將此類情況下的獼猴桃花朵歸類為花苞,以符合人工授粉要求,避免授粉失敗。但由于此類情況下的花苞存在與花近似的特征,導致模型在處理此類情況時,誤將此類獼猴桃花苞識別為獼猴桃花,造成誤檢。

3 結 論

本文基于YOLOv5s構建了改進獼猴桃花朵檢測模型YOLOv5s_S_N_CB_CA,實現了對自然環境下獼猴桃花朵的快速準確檢測。主要結論如下:

1)本文基于YOLOv5s提出了改進模型YOLOv5s_S_N_CB_CA,其檢測獼猴桃花、花苞和已自然授粉花朵的平均精確率(precision,)為85.21%,召回率(recall,)為90%,在backbone中引入C3HB模塊、在prediction中引入CCA模塊后,交并比為0.5時的均值平均精度(mean average precision with IoU of 0.5,mAP0.5)達到92.45%,模型大小為14.6 MB,檢測速度為35.47 幀/s。通過改進實現了對自然環境下獼猴桃花朵的準確、快速檢測。通過,提出了改進模型YOLOv5s_S_N_CB_CA,

2)本文將YOLOv5s_S_N_CB_CA與其他4種基于YOLOv5s的改進模型、原始YOLOv5s、YOLOv4和SSD 的性能進行對比,結果表明YOLOv5s_S_N_CB_CA在檢測精度、檢測速度和模型大小上均優于其他對比模型,說明其對獼猴桃花朵具有較好的檢測效果。此外,檢測不同天氣和晴天不同時段下的獼猴桃花朵時,YOLOv5s_S_N_CB_CA都能達到91%以上的mAP0.5值,說明其具有較好的魯棒性。

本文提出YOLOv5s_S_N_CB_CA模型對于生長過于密集和遮擋嚴重的花朵、低光照強度下和特定生長期下的花苞存在部分漏檢和誤檢的情況。后續將繼續探索新的改進方案,進一步優化復雜情況下對獼猴桃花朵的檢測效果。

[1] 歐陽芳,王麗娜,閆卓,等. 中國農業生態系統昆蟲授粉功能量與服務價值評估[J]. 生態學報,2019,39(1):131-145. OUYANG Fang, WANG Lina, YAN Zhuo, et al. Evaluation of insect pollination and service value in China's agricultural ecosystems[J]. Acta Ecologica Sinica, 2019, 39(1): 131-145. (in Chinese with English abstract)

[2] 張立微,張紅玉. 傳粉昆蟲生態作用研究進展[J]. 江蘇農業科學,2015,43(7):9-13. ZHANG Liwei, ZHANG Hongyu. Progress in the study of the ecological role of pollinators[J]. Jiangsu Agricultural Sciences, 2015, 43(7): 9-13. (in Chinese with English abstract)

[3] BUTCHER C L, RUBIN B Y, ANDERSON S L, et al. Pollen dispersal patterns differ among sites for a wind‐pollinated species and an insect‐pollinated species[J]. American Journal of Botany, 2020, 107(11): 1504-1517.

[4] BIESMEIJER J C, ROBERTS S P M, REEMER M, et al. Parallel declines in pollinators and insect-pollinated plants in Britain and the Netherlands[J]. Science, 2006, 313(5785): 351-354.

[5] DECOURTYE A, ALAUX C, LE Conte Y, et al. Toward the protection of bees and pollination under global change: Present and future perspectives in a challenging applied science[J]. Current opinion in insect science, 2019, 35: 123-131.

[6] 劉浩洲. 基于信息感知的獼猴桃噴霧授粉方法研究[D]. 楊凌:西北農林科技大學,2019. LIU Haozhou. Kiwifruit Spray Pollination Method Based on Information Perception[D]. Yangling: Northwest A&F University, 2019. (in Chinese with English abstract)

[7] SáNCHEZ-ESTRADA A, CUEVAS J. Pollination strategies to improve fruit set in orchards of ‘Manzanillo’ olive in a nontraditional producing country, Mexico[J]. HortTechnology, 2019, 29(3): 258-264.

[8] CHECHETKA S A, YU Y, TANGE M, et al. Materially engineered artificial pollinators[J]. Chem, 2017, 2(2): 224-239.

[9] LI K, ZHAI L, PAN H, et al. Identification of the operating position and orientation of a robotic kiwifruit pollinator[J]. Biosystems Engineering, 2022, 222: 29-44.

[10] LI K, HUO Y, LIU Y, et al. Design of a lightweight robotic arm for kiwifruit pollination[J]. Computers and Electronics in Agriculture, 2022, 198: 107114.

[11] 樊湘鵬,許燕,周建平,等. 基于遷移學習和改進CNN的葡萄葉部病害檢測系統[J]. 農業工程學報,2021,37(6):151-159. FAN Xiangpeng, XU Yan, ZHOU Jianping, et al. Detection system for grape leaf diseases based on transfer learning and updated CNN[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(6): 151-159. (in Chinese with English abstract)

[12] 寧健,馬淼,柴立臣,等. 深度學習的目標檢測算法綜述[J]. 信息記錄材料,2022,23(10):1-4. NING Jian, MA Miao, CHAI Lichen, et al. A survey of deep learning object detection algorithms[J]. Information Recording Materials, 2022, 23(10): 1-4. (in Chinese with English abstract)

[13] FARJON G, KRIKEB O, HILLEL A B, et al. Detection and counting of flowers on apple trees for better chemical thinning decisions[J]. Precision Agriculture, 2020, 21(3): 503-521.

[14] 劉浩洲,陳禮鵬,穆龍濤,等. 基于K-means聚類的獼猴桃花朵識別方法[J]. 農機化研究,2020,42(2):22-26. LIU Haozhou, CHEN Lipeng, MU Longtao, et al. A recognition method of kiwifruit flowers based on K-means clustering[J]. Acta Automatica Sinica, 2020, 42(2): 22-26. (in Chinese with English abstract)

[15] 林君宇,李奕萱,鄭聰尉,等. 應用卷積神經網絡識別花卉及其病癥[J]. 小型微型計算機系統,2019,40(6):1330-1335. LIN Junyu, LI Yixuan, ZHENG Congwei, et al. Classifying flowers and their diseases by using convolutional neural network[J]. Journal of Chinese Computer Systems. (in Chinese with English abstract)

[16] WILLIAMS H, NEJATI M, HUSSEIN S, et al. Autonomous pollination of individual kiwifruit flowers: Toward a robotic kiwifruit pollinator[J]. Journal of Field Robotics, 2020, 37(2): 246-262.

[17] XIA X, XU C, NAN B. Inception-v3 for flower classification[C]//2017 2nd international conference on image, vision and computing (ICIVC). Chengdu: IEEE, 2017: 783-787.

[18] SUN K, WANG X, LIU S, et al. Apple, peach, and pear flower detection using semantic segmentation network and shape constraint level set[J]. Computers and Electronics in Agriculture, 2021, 185: 106150.

[19] 尚鈺瑩,張倩如,宋懷波. 基于YOLOv5s的深度學習在自然場景蘋果花朵檢測中的應用[J]. 農業工程學報,2022,38(9):222-229. SHANG Yuying, ZHANG Qianru, SONG Huaibo. Application of deep learning based on YOLOv5s to apple flower detection in natural scenes[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(9): 222-229. (in Chinese with English abstract)

[20] 孫豐剛,王云露,蘭鵬,等. 基于改進YOLOv5s和遷移學習的蘋果果實病害識別方法[J]. 農業工程學報,2022,38(11):171-179. SUN Fenggang, WANG Yunlu, LAN Peng, et al. Identification of apple fruit diseases using improved YOLOv5s and transfer learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(11): 171-179. (in Chinese with English abstract)

[21] YAO J, QI J, ZHANG J, et al. A real-time detection algorithm for Kiwifruit defects based on YOLOv5[J]. Electronics, 2021, 10(14): 1711.

[22] MALTA A, MENDES M, FARINHA T. Augmented reality maintenance assistant using YOLOv5[J]. Applied Sciences, 2021, 11(11): 4758.

[23] QI J, LIU X, LIU K, et al. An improved YOLOv5 model based on visual attention mechanism: Application to recognition of tomato virus disease[J]. Computers and Electronics in Agriculture, 2022, 194(7): 178-201.

[24] 林清平,張麒麟,肖蕾. 采用改進YOLOv5網絡的遙感圖像目標識別方法[J]. 空軍預警學院學報,2021,35(2):117-120. LIN Qingping, ZHANG Qilin, XIAO Lei. Method of remote sensing image target recognition based on improved YOLOv5 network[J]. Journal of Air Force Early Warning Academy, 2021, 35(2): 117-120. (in Chinese with English abstract)

[25] 楊曉玲,江偉欣,袁浩然. 基于YOLOv5的交通標志識別檢測[J]. 信息技術與信息化,2021(4):28-30. YANG Xiaoling, JIANG Weixin, YUAN Haoran. Traffic sign recognition and detection based on YOLOv5[J]. Information Technology and Informatization, 2021(4): 28-30. (in Chinese with English abstract)

[26] LIU Y, LU B H, PENG J, et al. Research on the use of YOLOv5 object detection algorithm in mask wearing recognition[J]. World Scientific Research Journal, 2020, 6(11): 276-284.

[27] AN Q, WANG K, LI Z, et al. Real-Time Monitoring method of strawberry fruit growth state based on YOLO improved model[J]. IEEE Access, 2022, 10: 124363-124372.

[28] HUANG Z, WANG X, HUANG L, et al. Ccnet: Criss-cross attention for semantic segmentation[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. Seoul, Korea: IEEE, 2019: 603-612.

[29] RAO Y, ZHAO W, TANG Y, et al. Hornet: Efficient high-order spatial interactions with recursive gated convolutions[J]. Advances in Neural Information Processing Systems, 2022, 35: 10353-10366.

[30] 戚小莎,曾靜,吉根林. 雙交叉注意力自編碼器改進視頻異常檢測[J]. 南京師大學報(自然科學版),2023,46(1):110-119. QI Xiaosha, ZENG Jing, JI Genlin. Improved video anomaly detection with dual criss-cross attention auto encoder[J]. Journal of Nanjing Normal University(Natural Science Edition), 2023, 46(1): 110-119. (in Chinese with English abstract)

[31] REDMON J, DIVVALA S, GIRSHICK R, et al. You only look once: Unified, real-time object detection[C]// Computer Vision and Pattern Recognition. Las Vegas, NV, USA: IEEE, 2016: 779-788.

[32] REDMON J, FARHADI A. YOLO9000: Better, faster, stronger[C]// Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE, 2017: 6517-6525.

[33] JIANG B, LUO R, MAO J, et al. Acquisition of Localization Confidence for Accurate Object Detection[C]//Computer Vision–ECCV 2018. Cham, Switzerland: Springer International Publishing, 2018: 816-832.

[34] ALEXEY B, WANG C, LIAO H. YOLOv4: Optimal speed and accuracy of object detection[J/OL]. (2020-04-23)[2023-01-05]. https: //www. researchgate. net/publication/340883401.

[35] LIU W, DRAGOMIR A, DUMITRU E, et al. SSD: Single shot multibox detector[C]// Computer Vision–ECCV 2016. Cham, Switzerland: Springer International Publishing, 2016: 21-37.

Detecting kiwi flowers in natural environments using an improved YOLOv5s

GONG Weixin, YANG Zhen, LI Kai, HAO Wei, HE Zhi, DING Xinting, CUI Yongjie※

(1.,,712100,; 2.,,712100,; 3.,712100,)

Artificial pollination can be essential to improve the fruit quality in kiwifruit production. An efficient detection of kiwifruit flowers is one of the key technologies in the automatic pollination machinery. In this study, an improved YOLOv5s model (YOLOv5s_S_N_CB_CA) was proposed to rapidly and accurately detect the kiwifruit flowers. The C3HB module and criss-cross attention (CCA) were added into the YOLOv5s. The sample slicing was combined to add the negative sample processing, in order to enhance the feature extraction of the model for the kiwifruit flowers, particularly for the detection accuracy and detection speed of the model. A total of 1032 images of kiwifruit flowers were collected from a trellised kiwifruit orchard grown in a natural environment, including 779 images on sunny days and 253 images on cloudy days. Two periods of light conditions under sunny days were considered, including 726 images of kiwifruit flowers under the 9:00-11:00 and 378 images of kiwifruit flowers under the 15:00-17:00. Two occlusion cases were selected, with 726 images of kiwi flowers with occlusion and 306 images of kiwi flowers without occlusion. The captured images of kiwifruit flowers were classified into three categories, including kiwifruit buds, kiwifruit flowers, and pollinated kiwifruit flowers. Three targets were labelled separately, and then sent to the improved YOLOv5s model for training. A total of 300 iterations of training were implemented for the improved model. The results showed that the improved model shared the detection accuracy of 85.21%, the recall of 90%, the mean average precision (mAP) of 92.45% at an intersection over union (IoU) ratio of 0.5, a model size of 14.6 MB, and a detection speed of 35.47 frames/s. Compared with the four improved YOLOv5s models with only sample scaling or two resolutions, sample slicing, and adding negative samples, the C3HB-CCA module and focal loss function, the mAP0.5were improved 31.91, 38.32, 2.55, and 1.08 percentage points, respectively, while the mean average accuracy at IoU of 0.5-0.95 ( mAP0.5-0.95) by 34.38, 42.93, 1.92, and 1.37 percentage points, respectively. The improved model increased the recall by 2.00, 7.00, and 12.00 percentage points, compared with the original, YOLOv4, and SSD model, respectively, while the mAP0.5was improved by 2.55, 9.95, 13.64 percentage points, and 34.15%, 144.62%, and 20.03% improvement in the detection speed, respectively. The original and improved models were then used to detect the kiwifruit flowers under different weather light intensities, or under different light intensities at the different times of the day on sunny days. The results showed that the improved model had 85.17% and 83.88% accuracy, 90% and 89% recall, and 91.96% and 91.15% mAP0.5for the detection of the kiwifruit flowers under sunny and cloudy skies, respectively. The improved model shared 84.47% and 84.79% accuracy, 89% and 89% recall, and 92.11% and 92.10% mAP0.5for the detection of kiwifruit flowers in 9:00-11:00 and 15:00-17:00 on sunny day, respectively. The better performance was achieved in the improved model, compared with the original. Therefore, the improved YOLOv5s-based detection model was achieved in the rapid and accurate detection of kiwifruit flowers with the high robustness while maintaining lightweight. The finding can also provide the technical support to develop the automated pollination equipment for kiwifruit.

image processing; model; target detection; kiwi flowers; improved YOLOv5s; natural environments

10.11975/j.issn.1002-6819.202301031

S24;TP391.4

A

1002-6819(2023)-06-0177-09

龔惟新,楊珍,李凱,等. 基于改進YOLOv5s的自然環境下獼猴桃花朵檢測方法[J]. 農業工程學報,2023,39(6):177-185.doi:10.11975/j.issn.1002-6819.202301031 http://www.tcsae.org

GONG Weixin, YANG Zhen, LI Kai, et al. Detecting kiwi flowers in natural environments using an improved YOLOv5s[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2023, 39(6): 177-185. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.202301031 http://www.tcsae.org

2023-01-07

2023-02-07

國家自然科學基金項目(31971805);國家重點研發計劃項目(2019YFD1002401);陜西省重點研發計劃項目(2019ZDLNY02-04)

龔惟新,研究方向為智能化檢測與控制。Email:gwx919@nwafu.edu.cn

崔永杰,博士,教授,博士生導師,研究方向為現代農業裝備與技術。Email:cuiyongjie@nwsuaf.edu.cn