基于旋轉框的輕量高效安全帶檢測算法研究

宋長明,梁朝陽,肖 露,宋 蒙,彩 朔

(中原工學院理學院,河南 鄭州 450007)

0 引言(Introduction)

基于道路監(jiān)控的汽車駕駛員安全帶檢測,是智慧交通建設中不可或缺的一環(huán),規(guī)勸駕駛人員養(yǎng)成佩戴安全帶的良好駕駛習慣,保障駕駛人員人身安全,是交通管理部門不可推卸的責任。現有的安全帶檢測算法研究中,部分學者使用機器學習的方式,人為地選取某些特征作為安全帶檢測識別標志。例如,謝騰等[1]選取方向盤與安全帶構成的空間特征作為安全帶圖像特征,周彬[2]選取安全帶邊緣直線特征作為安全帶圖像特征。這些方法對圖片質量要求過高,并且算法使用中對門限閾值的設定受主觀因素干擾較大,缺乏魯棒性。隨著深度學習被越來越多地應用在圖像識別領域,在交通安全監(jiān)控檢測方向利用卷積神經網絡進行安全帶檢測也成為新的發(fā)展方向[3]。付春芬[4]首先根據經驗閾值粗定位車窗位置,其次利用積分投影定位車窗,最后利用卷積神經網絡對車窗位置圖片樣本進行訓練檢測。吳天舒[5]先使用YOLO目標檢測方法定位駕駛員位置,再用語義分割網絡檢測安全帶。王甄延[6]提出一種改進的YOLOv3車輛檢測算法、前擋風玻璃定位檢測算法和安全帶檢測算法,實現了對乘車人員與駕駛人員位置、駕駛員及乘車人員是否佩戴安全帶的檢測。這些使用深度學習的安全帶檢測算法,都采用了分兩步或三步的策略,通過先檢測車、車窗或者駕駛員位置,再通過目標檢測網絡或圖像分割網絡檢測安全帶,不能進行端到端的訓練檢測,會消耗大量算力資源,并且由于采用的都是水平框檢測安全帶,會導致模型將目標框中大量非目標特征學習進來,出現嚴重的特征不對齊問題。

本文所構建的輕量高效的端到端的旋轉框安全帶檢測算法,使用旋轉框對齊傾斜安全帶的特征區(qū)域,很好地改善了特征不對齊的問題;結合輕量化主干網絡,降低了模型參數量和算力消耗,提升了模型推理速度;構建了注意力特征融合模塊(AFFM),增強了安全帶特征表達,提升了模型檢測精度。實驗結果表明,本文算法的各項指標都達到較高水平。

1 相關工作(Related work)

1.1 旋轉框檢測算法

普通的目標檢測算法,使用的是水平錨框,包含較多背景區(qū)域,如圖1(a)所示,這會導致最終分類置信度與定位精度之間存在較大偏差。因此,降低錨框中背景區(qū)域的占比,可以有效改善特征不對齊的問題,更好的解決方案是使用旋轉的錨框,如圖1(b)所示。近年來,旋轉的錨框在交通檢測領域和遙感檢測領域已經有了長足的發(fā)展,如旋轉的區(qū)域候選網絡RRPN,基于區(qū)域候選網絡RPN(Region Proposal Net work)架構引入旋轉候選框實現任意方向的場景文本檢測[7]。基于旋轉的錨框得到旋轉的感興趣區(qū)域RoI(Region of Interest),然后提取相應特征。區(qū)別于RRPN 設置很多旋轉錨框,RoI Transfor m是在RPN階段通過全連接從水平錨框學習得到旋轉RoI,基于旋轉RoI提取特征,然后進行定位和分類,這種方式大大提高了基于旋轉框的檢測精度[8]。為了解決小型、雜亂的旋轉目標帶來的檢測問題,YANG 等[9]在Faster RCNN 的通用對象檢測框架上構建了一種旋轉框目標檢測方法。XU等[10]提出了一種稱為頂點滑動的旋轉框檢測方式,它先檢測水平框,再通過學習回歸水平框上的4個頂點滑動偏移量得到旋轉框。XIE等[11]提出了Oriented RCNN旋轉框目標檢測算法,首先使用旋轉的RPN,以低計算成本的方式生成高質量的旋轉候選框,其次通過旋轉RoI對其提取固定尺寸大小的特征,最后將這些特征作為旋轉檢測頭的輸入,執(zhí)行分類和回歸任務。

1.2 注意力機制和特征融合網絡

目前,解決目標檢測中物體的尺度變化問題有兩種方法。一種是直接在不同尺度的圖像特征上識別目標,并使用非最大抑制組合預測結果[12];另一種是融合卷積神經網絡從不同層次圖像中提取的不同尺度的特征用于近似多尺度圖像特征,獲得高分辨率的語義特征,從而提升預測效果[13]。近年來,注意力機制被廣泛應用在目標檢測和圖像分割等解決計算機視覺相關問題的網絡設計上。注意力機制網絡中壓縮和激勵網絡(Squeeze and Excitation Net works,SENet)將全局空間信息擠壓到通道權重信息中,捕獲通道相關性[14]。卷積注意力模塊(Convolutional Block Attention Module,CBAM),可以在通道和空間維度上添加注意力機制,獲得空間和通道上的重要特征[15]。

2 旋轉框安全帶檢測算法(Rotate frame seat belt detection algorithm)

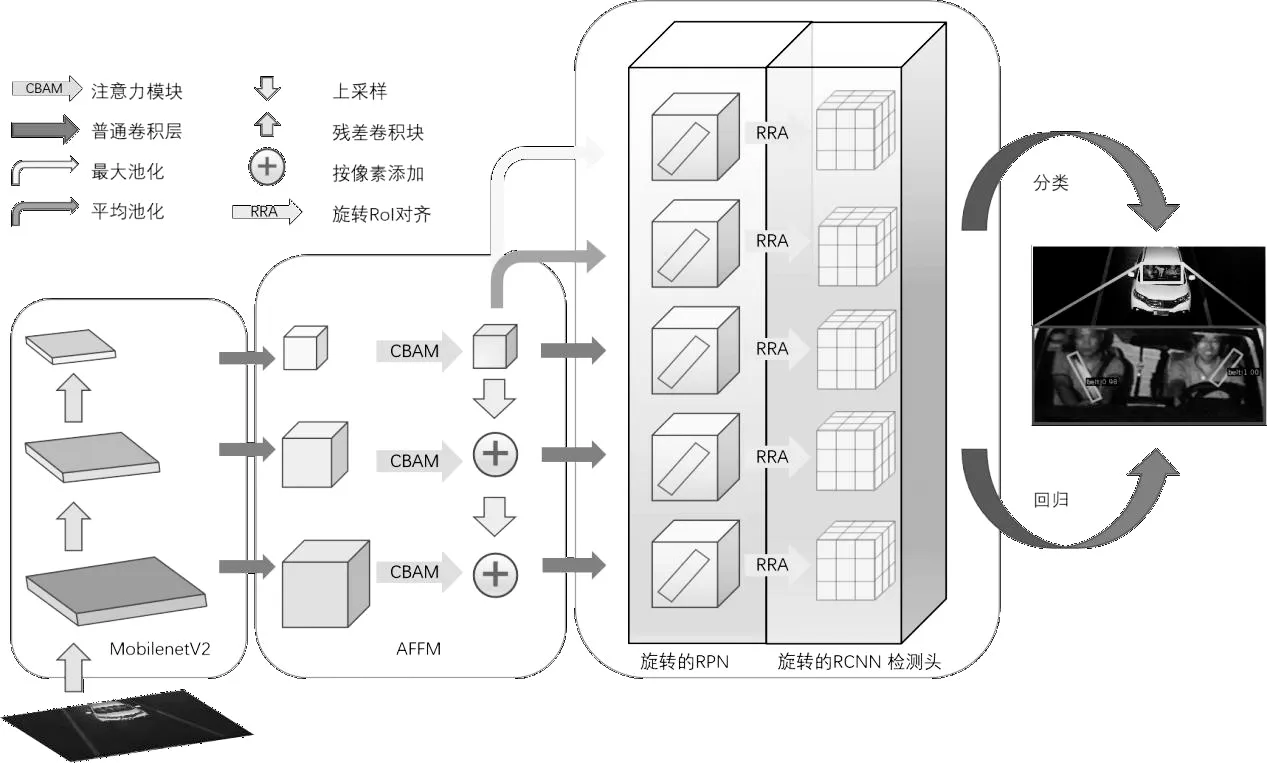

本文針對安全帶檢測問題,引入旋轉框目標檢測算法Oriented RCNN,提出了AFFM,結合Mobilenet V2主干特征提取網絡,構建了一種輕量高效的端到端的旋轉框安全帶檢測算法[16]。基于旋轉框的安全帶檢測算法網絡結構如圖2所示,左側是Mobilenet V2主干網絡,用于提取圖像不同層次的特征;中間部分是AFFM,結合注意力機制融合不同尺度之間的特征;右側部分是旋轉的RPN 模塊和旋轉的RCNN 檢測頭模塊。

圖2 基于旋轉框的安全帶檢測算法網絡結構圖Fig.2 Net work structure diagram of seat belt detection algorithm based on rotated frame

2.1 注意力特征融合模塊

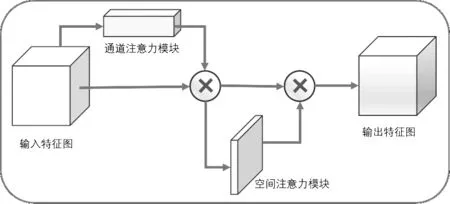

針對安全帶這一較小目標,普通的特征融合方式容易丟失特征,本文在金字塔特征融合網絡FPN的基礎上,結合CBAM卷積注意力模塊,提出了一種針對小目標特征融合的注意力特征融合模塊。它的主要作用是在空間位置上和特征通道上,增強目標的特征表達,從而達到提高檢測精度的目的。其中,CBAM 卷積注意力模塊結構如圖3所示,輸入的特征圖首先經過通道注意力模塊,其次將得到的通道注意力特征圖與輸入的特征圖相乘,給不同通道施加注意力權重;以同樣的方式再輸入空間注意力模塊,最終得到被賦予了空間和通道注意力權重的特征圖。

圖3 卷積注意力模塊結構圖Fig.3 Structure diagram of convolutional attention module

2.2 Oriented RCNN旋轉框目標檢測

兩階段的旋轉目標檢測算法Oriented RCNN,由旋轉的RPN和旋轉的RCNN檢測頭構成。首先通過旋轉的RPN 生成高質量旋轉候選框,其次通過旋轉RoI對齊提取固定大小尺寸的特征,最后將這些特征作為旋轉的RCNN檢測頭的輸入,執(zhí)行分類和回歸任務。

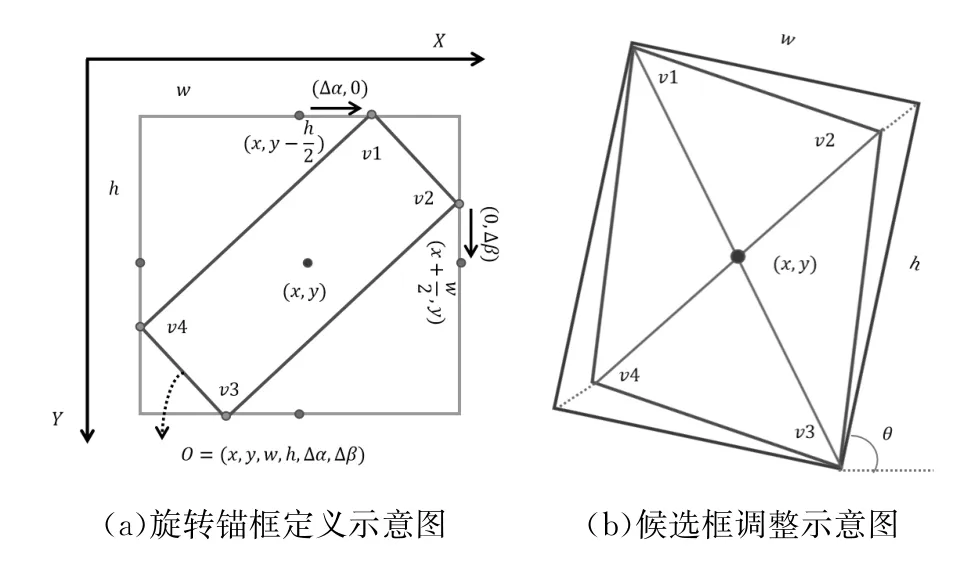

旋轉的RPN是在RPN網絡上構建的,拓展了RPN 回歸分支的輸出維度,由原來的4個變?yōu)?個。如圖4(a)所示,對于每個位置的錨框,旋轉的RPN 輸出為(x,y,w,h,Δα,Δβ),其中(x,y)為旋轉候選框的中心坐標,w和h表示旋轉候選框的寬和高。Δα和Δβ表示旋轉候選框外接矩形頂邊和右邊的偏移量。

圖4 旋轉框定義和候選框調整Fig.4 Rotate frame definition and proposal frame adjustment

旋轉的RCNN 檢測頭首先進行候選框調整操作,如圖4(b) 所示,將上述提到的旋轉候選框的頂點坐標集V={v1,v2,v3,v4}由平行四邊形轉換為矩形,將平行四邊形較長的對角線作為矩形的對角線。然后對所有調整后的旋轉候選框進行旋轉RoI對齊操作,將得到的特征圖作為旋轉檢測頭的輸入,執(zhí)行分類和回歸任務。

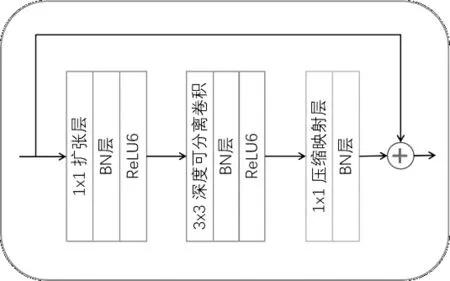

2.3 Mobilenet V2主干特征提取網絡

Mobilenet是為了將復雜的網絡能夠應用在移動端和資源受限情境下的輕量級神經網絡的解決方案。在Mobilenet中提出的方案主要是深度可分離卷積和兩個超參數,即寬度縮放因子、分辨率縮放因子。如圖5所示,在Mobilenet V2的網絡設計中,除了繼續(xù)使用深度可分離卷積結構,還使用了擴張層和壓縮映射層。擴張層是使用1×1卷積將低維空間映射到高維空間,即擴大通道數,壓縮映射層也是使用1×1卷積,它的目的是希望把高維特征映射到低維空間,即減小通道數,其中殘差連接是在輸入和輸出的部分進行連接。

圖5 殘差卷積模塊結構圖Fig.5 Structure diagram of residual convolutional module

3 實驗與結果分析(Experiments and results analysis)

3.1 數據集

本數據集包含557張道路監(jiān)控畫面,劃分為訓練集281張、驗證集184張、測試集92張。每張圖片的像素大小為1 600×1 264。數據集為DOTA格式。

3.2 實驗平臺及模型參數

實驗使用的實驗設備操作系統為64位的Windows 11,CPU選用英特爾(R)酷睿(TM)i5-12400F,GPU 選用英偉達Ge Force GTX1080TI 11 GB,CUDA版本為11.3,所有模型均使用基于Py Torch的MMrotate旋轉框目標檢測框架。輸入圖片尺寸為1 024×1 024,Batch_size設置為2,Epoch設置為72,學習率為0.005,權重衰減參數設置為0.000 1,動量設置為0.9,使用隨機梯度下降優(yōu)化算法SGD。

3.3 評價指標

通常用真實結果的正反例和預測結果的正反例,作為評價指標的評判基準,其中TP是被模型預測為正類的正樣本,即真正例。TN是被模型預測為負類的負樣本,即真反例。FP是被模型預測為正類的負樣本,即假正例。FN是被模型預測為負類的正樣本,即假反例。

準確率(Precision)反映了被分類器判定的正例中真正的正例樣本的比重,如公式(1)所示,在目標檢測場景中,無法全面衡量模型效果。查全率(Recall)反映了被正確判定的正例占總的正例的比重,如公式(2)所示。平均精度(AP)是查準率曲線查全率曲線與坐標軸所圍成的面積,表示查準率與查全率的關系,是目標檢測中較為常用的評價指標,AP值越高,模型效果越好。本文采用Recall和AP作為模型評價指標。

3.4 實驗結果及對比分析

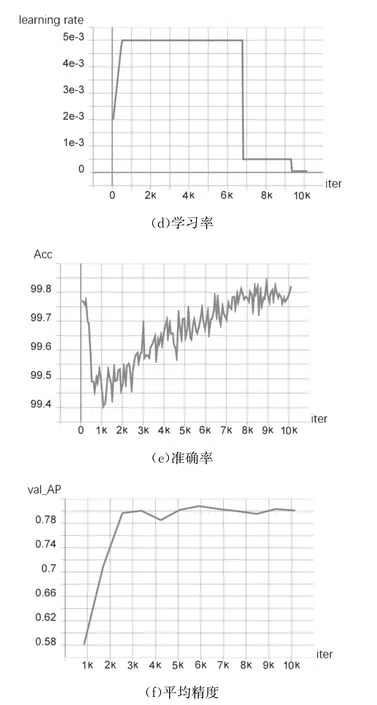

模型訓練過程中,隨著迭代次數的增加,參數變化如圖6所示,總的損失函數逐步降低,學習率不斷調整,準確度逐漸上升,驗證集平均精度逐漸上升,并趨于穩(wěn)定。以上數據表明模型已經收斂到較好的效果。

圖6 模型訓練過程中各指標變化曲線圖Fig.6 Change plot of each indicator during model training

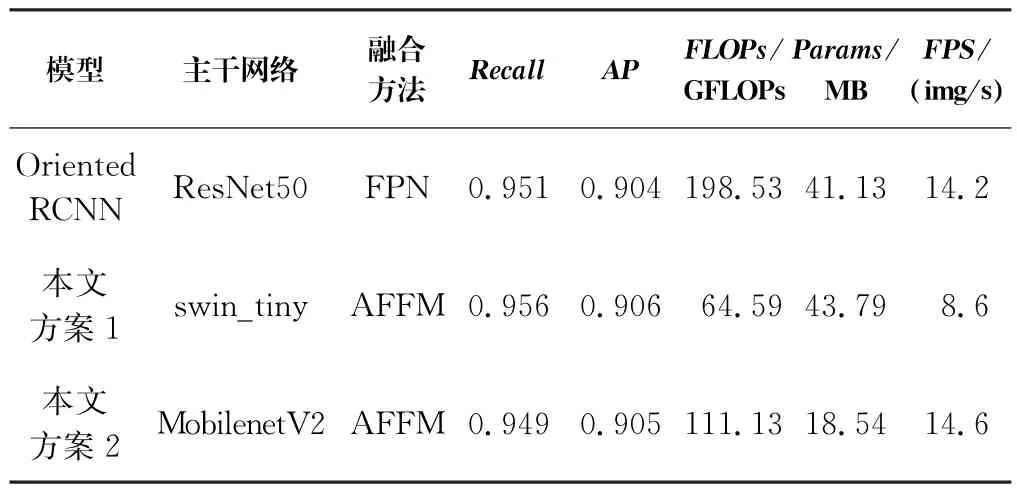

本文所構建的旋轉框目標檢測算法與其他旋轉框算法對比實驗效果如表1所示,本文使用測試數據集和訓練驗證數據集作為檢驗數據集,實驗結果表明,所建立模型在查全率(Recall)和平均精度(AP)上均達到了較高水平。

表1 實驗數據效果對比表Tab.1 Comparison of experimental data

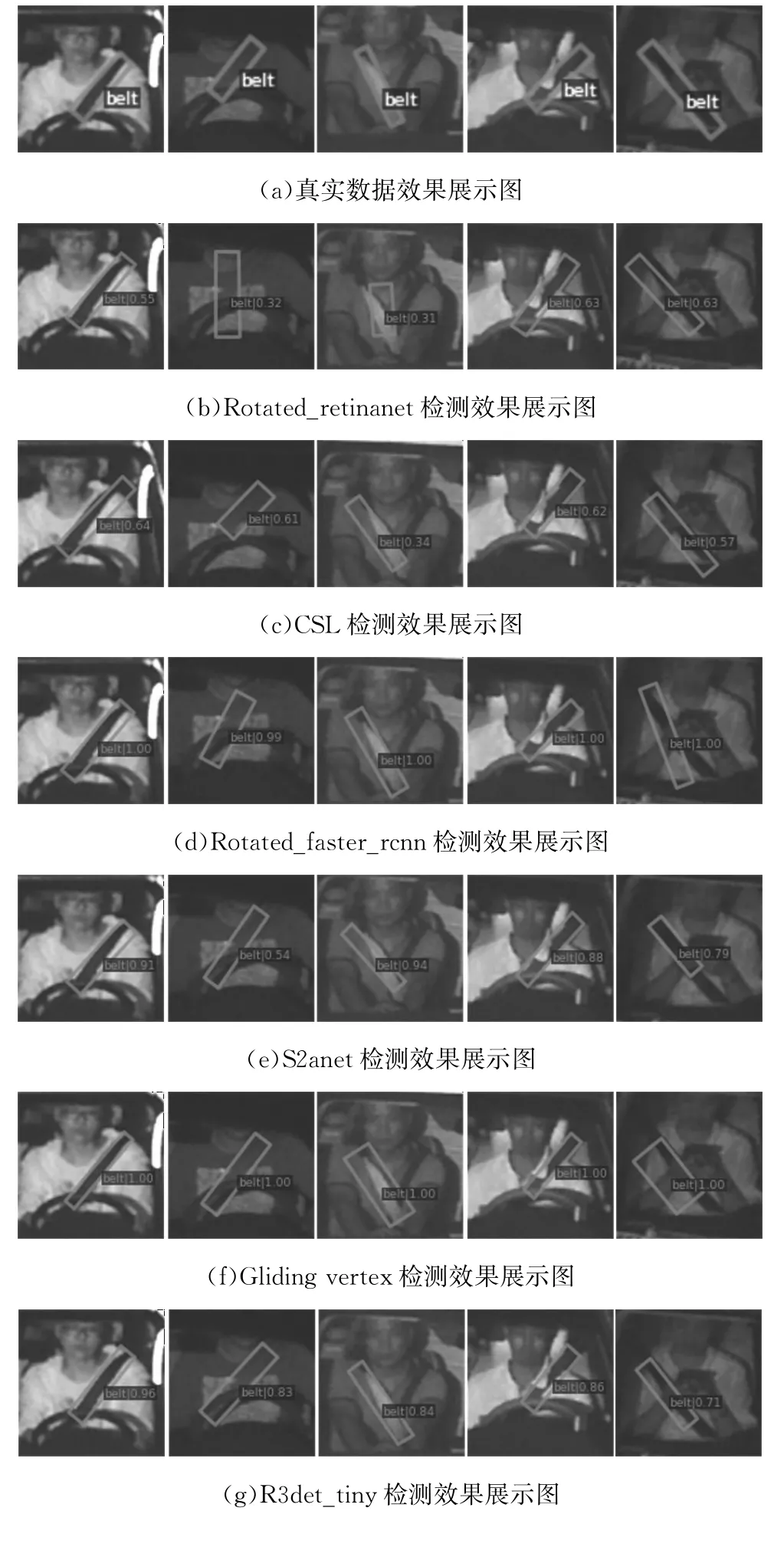

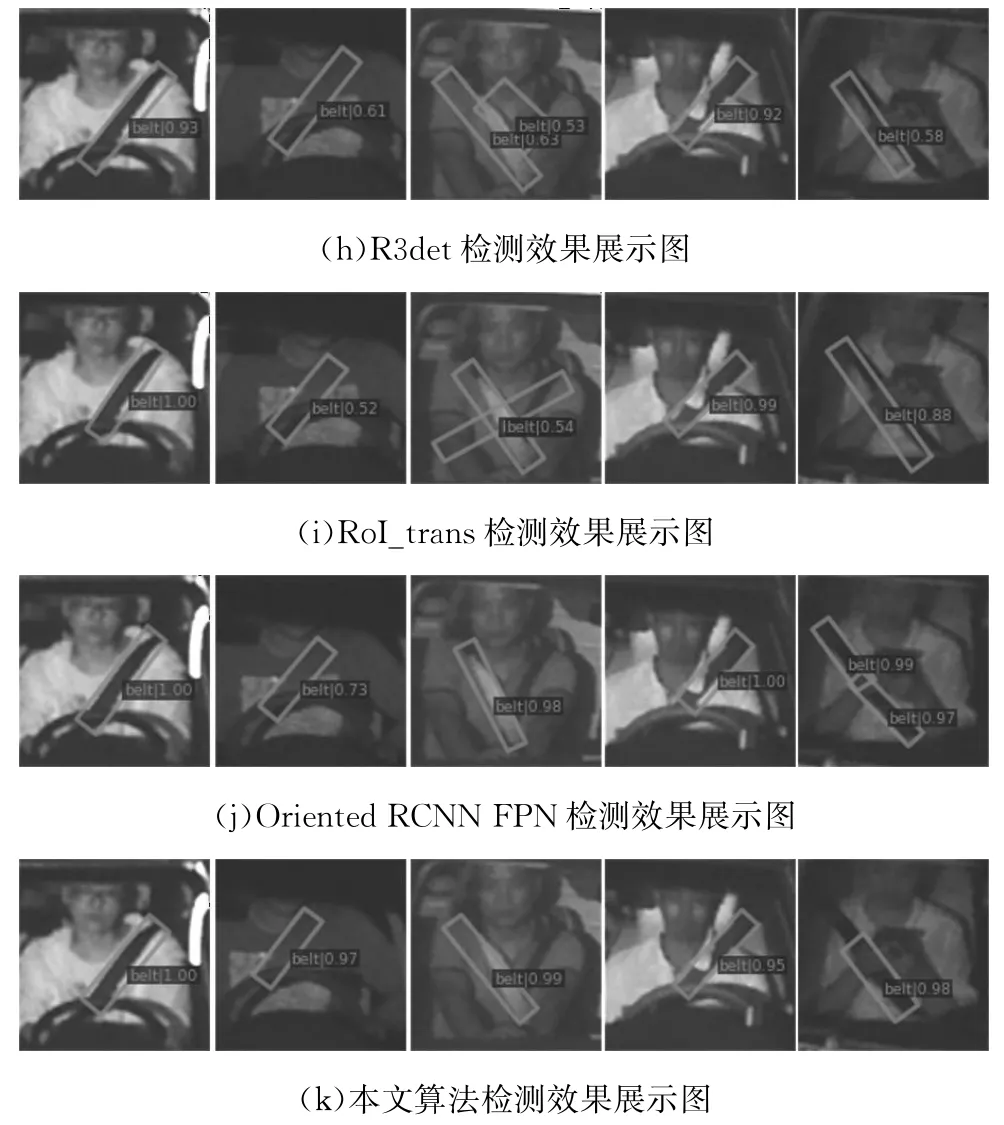

各個算法實驗對比效果圖如圖7所示,左起第一張樣例有高光反射區(qū)域,左起第二張樣例較為昏暗,大部分對比算法均表現不佳;左起第三、第四及第五張樣例分別是左肩條形陰影區(qū)域干擾、衣領遮擋和手勢遮擋,部分對比算法均受到一定影響,錨框位置不準確,以及置信度不高。而本文算法在上述樣例中均表現良好,不僅錨框的位置較為接近真實框,而且置信度也達到較高水平。

圖7 算法實驗效果展示Fig.7 Display of the experimental effect of each algorithm

本文所構建的算法與Oriented RCNN 算法實驗效果對比如表2所示。本文構建的算法是基于Oriented RCNN的改進,第一種改進方案是采用swin_tiny作為主干特征提取網絡,使用本文提出的AFFM 作為特征融合模塊,第一種方案在保證Recall和AP的情況下,降低了算力消耗(FLOPs)和模型參數量(Params),不足之處是受限于swin_tiny網絡的復雜性,檢測推理速度(FPS)大打折扣。第二種方案是改用Mobilenet V2作為主干特征提取網絡,該方案在保證查全率(Recall)、平均精度(AP)以及檢測推理速度(FPS)的情況下,降低了算力消耗和參數量。

表2 本文方法與Oriented RCNN算法對比Tab.2 Comparison of the proposed algorithm with Oriented RCNN

4 結論(Conclusion)

本文針對道路監(jiān)控圖像的安全帶檢測問題,構建了一種輕量、高效的端到端的旋轉框安全帶檢測算法,引入旋轉框,較好地改善了安全帶檢測特征不對齊的問題;提出AFFM,較好地增強了安全帶這一小目標的特征融合;結合Mobilenet V2輕量化主干網絡,既降低了參數量和所需算力,又提高了模型檢測推理速度。經實驗驗證,本文構建的基于旋轉框的輕量高效的端到端安全帶檢測算法,在訓練驗證數據集上,查全率(Recall)達到0.949,平均精度(AP)達到0.905,參數量(Params)僅需要18.54 MB,檢測推理速度(FPS)達到每秒14.6 張圖片,滿足實際的檢測應用需求,具有一定的市場潛力。