基于BERT-BiLSTM-CRF模型的開(kāi)關(guān)柜設(shè)備運(yùn)維實(shí)體抽取方法研究

路士杰龐先海董 馳顧朝敏鄭寶良

(1.國(guó)網(wǎng)河北能源技術(shù)服務(wù)有限公司,河北 石家莊 050400;2.國(guó)網(wǎng)河北省電力有限公司電力科學(xué)研究院,河北 石家莊 050021;3.科暢電氣有限公司,河北 保定 072558)

0 引言

開(kāi)關(guān)柜作為一種電氣設(shè)備,能夠開(kāi)合、控制和保護(hù)用電設(shè)備,在電力系統(tǒng)發(fā)電、輸電、配電和電能轉(zhuǎn)換的過(guò)程中扮演著重要的角色。開(kāi)關(guān)柜檢修過(guò)程復(fù)雜,缺少在線監(jiān)測(cè)系統(tǒng),往往需要人工手持設(shè)備檢測(cè),效率低下且智能化程度低。倘若變電站運(yùn)維人員對(duì)開(kāi)關(guān)柜設(shè)備缺少技術(shù)性把握,維護(hù)和管理的經(jīng)驗(yàn)不夠豐富,在設(shè)備出現(xiàn)問(wèn)題時(shí)沒(méi)有及時(shí)處理,會(huì)導(dǎo)致危害的擴(kuò)大,因此需要采用更為方便智能的運(yùn)維手段來(lái)提高變電站開(kāi)關(guān)柜設(shè)備的運(yùn)維效率[1-2]。

隨著電網(wǎng)規(guī)模的不斷擴(kuò)大,電力系統(tǒng)的知識(shí)量呈現(xiàn)爆炸式增長(zhǎng)。為了有效抽取、管理和利用海量知識(shí),需要將更高效快速的技術(shù)引入電力領(lǐng)域。命名實(shí)體識(shí)別(Named Entity Recognition,NER)又稱實(shí)體抽取,是指識(shí)別文本中具有特定含義的專有名詞,一般分為通用和特定兩大類(lèi)[3-4]。文獻(xiàn)[5]為提升對(duì)電力系統(tǒng)故障文本的分析處理速度,提出了一種基于預(yù)訓(xùn)練與多任務(wù)學(xué)習(xí)的電力故障文本信息自動(dòng)抽取模型;文獻(xiàn)[6]闡述了電力領(lǐng)域知識(shí)的中文專業(yè)詞典和實(shí)體抽取的實(shí)現(xiàn)分析方法;文獻(xiàn)[7]闡明了將實(shí)體抽取應(yīng)用于電網(wǎng)調(diào)度領(lǐng)域的解決思路和關(guān)鍵技術(shù)。但是,以上研究,大部分對(duì)實(shí)體抽取技術(shù)在電力系統(tǒng)中的應(yīng)用尚處于理論分析階段,并沒(méi)有將實(shí)體抽取技術(shù)運(yùn)用于具體的電氣設(shè)備中[811]。

針對(duì)現(xiàn)有研究的不足,本文將針對(duì)實(shí)體抽取技術(shù),采用多種深度學(xué)習(xí)模型,對(duì)開(kāi)關(guān)柜設(shè)備運(yùn)維進(jìn)行實(shí)體抽取,分析不同模型的抽取準(zhǔn)確度。

1 知識(shí)圖譜實(shí)體抽取算法

1.1 基于BERT 的預(yù)訓(xùn)練模型

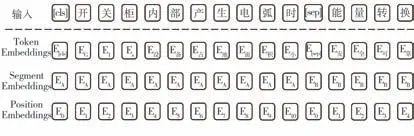

BERT 模型主要由雙向Transformer的encoder結(jié)構(gòu)組成,利用Mask 預(yù)訓(xùn)練任務(wù)學(xué)習(xí)token的上下文語(yǔ)義信息,并利用下一句預(yù)測(cè)任務(wù)學(xué)習(xí)句子順序特征信息。BERT 預(yù)訓(xùn)練模型結(jié)構(gòu)如圖1 所示。BERT 模型對(duì)輸入的句子進(jìn)行處理,加入分隔符,如“開(kāi)關(guān)柜內(nèi)部產(chǎn)生電弧時(shí),能量轉(zhuǎn)換”將被BERT 層轉(zhuǎn)化為“[CLS]開(kāi)關(guān)柜內(nèi)部產(chǎn)生電弧時(shí),[SEP]能量轉(zhuǎn)換”,其中[CLS]作為第一個(gè)句子的開(kāi)頭,放在首位,而[SEP]標(biāo)志則用來(lái)區(qū)分前后兩個(gè)輸入的句子。然后再將其轉(zhuǎn)化為3個(gè)向量:Token Embeddings、Segment Embeddings和Position Embeddings。Token Embeddings是將輸入的字劃分為一組有限的公共子詞單元,即注意分隔符的位置;Segment Embeddings用于區(qū)別兩個(gè)句子,給予兩個(gè)句子不同的標(biāo)記;Position Embeddings是對(duì)一個(gè)句子內(nèi)各個(gè)字的位置順序進(jìn)行編碼[12-13]。處理示意如圖2所示。然后,再將處理后的向量輸入至下一層中。

圖2 BERT層輸入轉(zhuǎn)化為向量示意

1.2 基于BERT-BiLSTM-CRF 模型的實(shí)體抽取模型

1.2.1 BiLSTM 神經(jīng)網(wǎng)絡(luò)

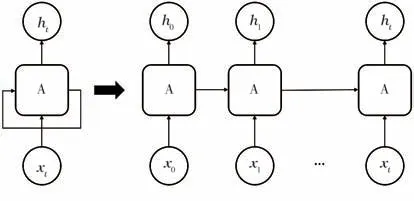

知識(shí)圖譜的實(shí)體抽取是典型的文本序列標(biāo)注,循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Network,RNN)是隨著時(shí)間的推移,可以重復(fù)發(fā)生的特殊神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),它可以模擬人類(lèi)學(xué)習(xí)的記憶特性。如圖3所示,可以將RNN 網(wǎng)絡(luò)以時(shí)間序列展開(kāi)成一條鏈狀網(wǎng)絡(luò)。箭頭右邊的網(wǎng)絡(luò)中,x0為初始時(shí)刻RNN 網(wǎng)絡(luò)的輸入,h0為輸出,A 為隱藏層,其中保存著初始時(shí)刻的網(wǎng)絡(luò)神經(jīng)元的狀態(tài),即下一隱藏層的狀態(tài)還包含著上一隱藏層的狀態(tài),并以此類(lèi)推至t時(shí)刻。

圖3 RNN的環(huán)形結(jié)構(gòu)及其展開(kāi)示意

雖然RNN 網(wǎng)絡(luò)可以有效地解決序列標(biāo)注任務(wù)問(wèn)題,但其并不能很好地處理長(zhǎng)距離依賴問(wèn)題,而長(zhǎng)短期記憶網(wǎng)絡(luò)(Long Short-Term Memory,LSTM)作為一種時(shí)間循環(huán)神經(jīng)網(wǎng)絡(luò),引入了門(mén)限制機(jī)制,可以有效地對(duì)歷史信息進(jìn)行過(guò)濾,解決該問(wèn)題。

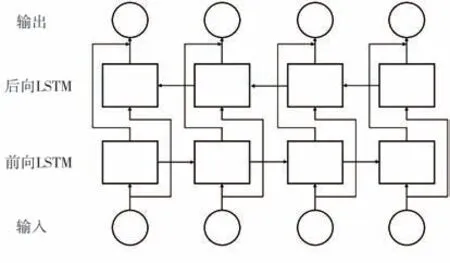

在雙向長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)(Bidirectional Long Short-Term Memory,BiLSTM)模型中,采用了前向和后向兩個(gè)LSTM 層,分別收集對(duì)象文本的上下文信息,兩者連接著同一個(gè)輸出層,如圖4所示。

圖4 BiLSTM 模型結(jié)構(gòu)

BiLSTM 模型可以兼顧上下文信息,自動(dòng)提取句子特征,獲得較RNN 網(wǎng)絡(luò)更好的結(jié)果[1415]。

1.2.2 BiLSTM-CRF模型架構(gòu)

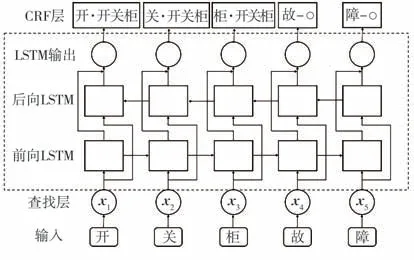

BiLSTM-CRF模型是由雙向LSTM 和條件隨機(jī)場(chǎng)CRF組成的模型,是命名實(shí)體抽取任務(wù)中常用的模型,其模型結(jié)構(gòu)可分為輸入層、隱含層和標(biāo)注層,如圖5所示。

圖5 BiLSTM-CRF模型結(jié)構(gòu)

輸入層由“輸入”和“查找層”組成。首先將輸入的每個(gè)句子分解成每個(gè)字詞,再使用Word2Vec訓(xùn)練模型將每個(gè)字詞映射為每個(gè)向量。使用Word2Vec方法可以將文本的分布式表示與字詞間的含義聯(lián)系起來(lái),消除詞語(yǔ)鴻溝現(xiàn)象,且很多工作[16]表明使用預(yù)先訓(xùn)練好的詞向量較隨機(jī)嵌入方法能使神經(jīng)網(wǎng)絡(luò)的收斂速度更快,模型的準(zhǔn)確度和召回度都能有較大的提升。

BiLSTM 網(wǎng)絡(luò)作為隱含層,自動(dòng)識(shí)別獲取句子特征。經(jīng)查找層對(duì)文本數(shù)據(jù)的處理,文本將轉(zhuǎn)化為字向量序列(x1,x2,…,x n)并輸入到BiLSTM 網(wǎng)絡(luò)中。其中,輸入向量的順序序列將作為前向LSTM層的輸入,而輸入向量的逆序序列將作為后向LSTM 層的輸入。在對(duì)語(yǔ)義信息進(jìn)行建模并提取文本特征表達(dá)后,將前向和后向LSTM 層的輸出進(jìn)行拼接,作為隱含層的輸出[17]。

條件隨機(jī)場(chǎng)(Conditional Random Fields,CRF)層作為標(biāo)注層,進(jìn)行語(yǔ)句序列標(biāo)注。CRF是概率無(wú)向圖模型,它解決了長(zhǎng)期依賴和標(biāo)注偏置問(wèn)題[18],其路徑得分公式如下

式中:X為輸入的序列,X=(x1,x2,…,x n);Y為將要輸出的標(biāo)簽序列,Y={y1,y2,…,y n};A i,j為概率轉(zhuǎn)移矩陣中第i個(gè)標(biāo)簽轉(zhuǎn)移到第j個(gè)標(biāo)簽的概率;P i,j為X被標(biāo)記為第j個(gè)標(biāo)簽的概率;輸入的序列是X=(x1,x2,…,x n)經(jīng)隱含層處理后輸出概率矩陣P n×k,其中k是標(biāo)簽的個(gè)數(shù)(本文k=4)。使用動(dòng)態(tài)規(guī)劃算法找出得分最高的路徑y(tǒng)*作為最優(yōu)路徑進(jìn)行序列標(biāo)注。

經(jīng)過(guò)標(biāo)注層后,BiLSTM-CRF 將直接輸出實(shí)體預(yù)測(cè)標(biāo)簽。

1.2.3 BERT-BiLSTM-CRF模型架構(gòu)

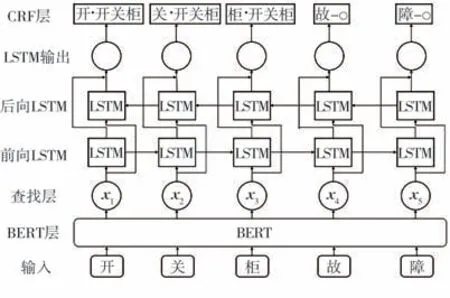

BiLSTM-CRF 模型使用了Word2Vec 的方法進(jìn)行了詞嵌入操作,但這種操作文本序列的解析是靜態(tài)的。而對(duì)于BERT-Bi LSTM-CRF 模型,在BiLSTM-CRF 模型前加入BERT 層。BERT層對(duì)輸入數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練處理,可以通過(guò)無(wú)監(jiān)督方式學(xué)習(xí),保存深層的特征信息,從而具有更好的泛化能力。結(jié)合了BERT 模型的預(yù)訓(xùn)練優(yōu)勢(shì),使得BERT-BiLSTM-CRF模型理論上進(jìn)行實(shí)體抽取將得到更為準(zhǔn)確的結(jié)果,BERT-BiLSTM-CRF模型結(jié)構(gòu)如圖6所示[19-21]。

圖6 BERT-BiLSTM-CRF模型結(jié)構(gòu)

1.3 實(shí)驗(yàn)方法與流程

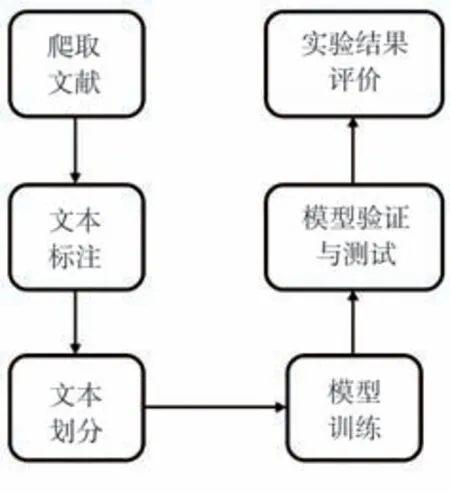

本實(shí)驗(yàn)選擇知網(wǎng)文獻(xiàn)作為語(yǔ)料庫(kù),使用BERT-BiLSTM-CRF 模型對(duì)開(kāi)關(guān)柜設(shè)備運(yùn)維進(jìn)行實(shí)體抽取,并與隱馬爾可夫模型(Hidden Markov Model,HMM)和BiLSTM-CRF模型的抽取結(jié)果進(jìn)行對(duì)比,實(shí)驗(yàn)流程如圖7所示。

圖7 實(shí)驗(yàn)流程

首先在知網(wǎng)上爬取開(kāi)關(guān)柜設(shè)備運(yùn)維相關(guān)文獻(xiàn),然后對(duì)爬取的文本采用“BIOES”文本標(biāo)注方法進(jìn)行標(biāo)注,接著將文本劃分為訓(xùn)練集、驗(yàn)證集和測(cè)試集。語(yǔ)料庫(kù)處理完畢后,先使用訓(xùn)練集對(duì)實(shí)體抽取模型進(jìn)行訓(xùn)練,再使用驗(yàn)證集對(duì)訓(xùn)練結(jié)果進(jìn)行驗(yàn)證,驗(yàn)證無(wú)誤后使用測(cè)試集對(duì)模型進(jìn)行測(cè)試,并計(jì)算相關(guān)評(píng)價(jià)指標(biāo)對(duì)實(shí)驗(yàn)結(jié)果進(jìn)行評(píng)估與比較。

2 實(shí)驗(yàn)結(jié)果

2.1 識(shí)別實(shí)體設(shè)置與評(píng)價(jià)指標(biāo)

2.1.1 語(yǔ)料庫(kù)的獲取與識(shí)別實(shí)體設(shè)置

采用爬蟲(chóng)程序,輸入搜索關(guān)鍵詞“電力”、“開(kāi)關(guān)柜”、“運(yùn)維”后,在知網(wǎng)上爬取文獻(xiàn)。

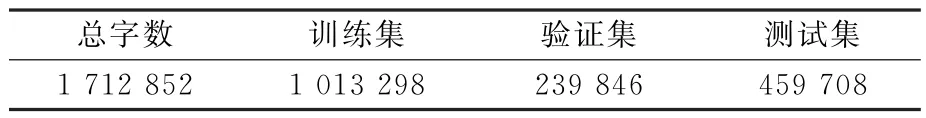

實(shí)驗(yàn)采取層次抽樣的方法構(gòu)建了訓(xùn)練集、驗(yàn)證集和測(cè)試集,數(shù)據(jù)劃分情況如表1所示。

表1 訓(xùn)練集、驗(yàn)證集、測(cè)試集字?jǐn)?shù)設(shè)置 個(gè)

在標(biāo)注數(shù)據(jù)集中設(shè)置了4種實(shí)體類(lèi)型,分別是:開(kāi)關(guān)柜、BJ、GZ、YW。開(kāi)關(guān)柜是指開(kāi)關(guān)柜設(shè)備,如“開(kāi)關(guān)柜”、“開(kāi)關(guān)柜設(shè)備”;BJ是指開(kāi)關(guān)柜的故障部件,如“主控開(kāi)關(guān)”、“分控開(kāi)關(guān)”、“儀表”等;GZ是指開(kāi)關(guān)柜發(fā)生的故障類(lèi)型;YW 是指開(kāi)關(guān)柜發(fā)生故障后對(duì)應(yīng)的變電站運(yùn)維方案。

2.1.2 評(píng)價(jià)指標(biāo)

使用準(zhǔn)確率(Accuracy)、精確率(Precision)、召回率(Recall)和綜合評(píng)價(jià)(F-Measure)作為評(píng)價(jià)指標(biāo)。各指標(biāo)計(jì)算公式如下:

式中:T P為正確預(yù)測(cè)需要關(guān)注的實(shí)體數(shù);T N為正確預(yù)測(cè)不需要關(guān)注的實(shí)體數(shù);F N為錯(cuò)誤預(yù)測(cè)需要關(guān)注的實(shí)體(漏報(bào))的數(shù);F P為錯(cuò)誤預(yù)測(cè)不需要關(guān)注的實(shí)體(誤報(bào))的數(shù)。

F分?jǐn)?shù)是統(tǒng)計(jì)學(xué)中用來(lái)衡量二分類(lèi)模型精確度的一種指標(biāo),他同時(shí)兼顧了精確率和召回率,可以看做是精確率和召回率的一種調(diào)和平均,表示為

式中:α為加權(quán)系數(shù),其值≥0。

本文使用了F1作為評(píng)價(jià)指標(biāo),于是取α=1,有

2.2 實(shí)驗(yàn)環(huán)境與結(jié)果分析

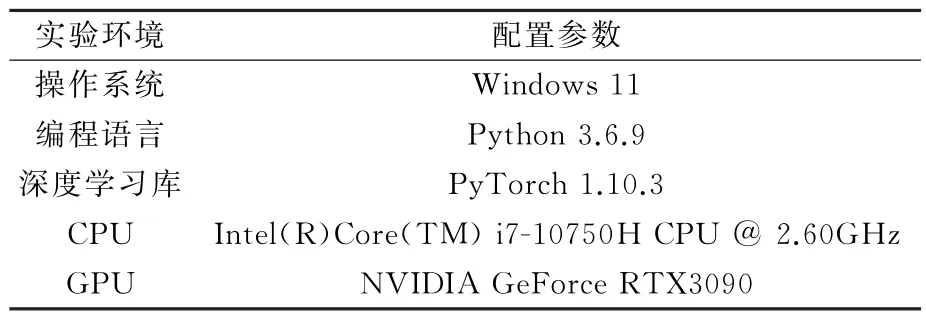

本文實(shí)驗(yàn)是基于Py Torch進(jìn)行搭建的,環(huán)境配置見(jiàn)表2。

表2 實(shí)驗(yàn)環(huán)境配置

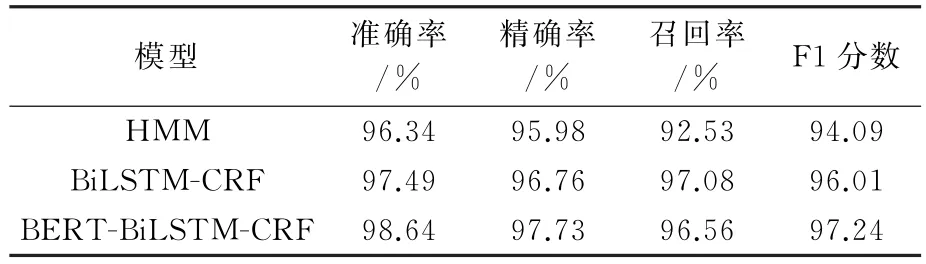

不同模型下的實(shí)驗(yàn)結(jié)果如表3所示。

表3 各模型實(shí)驗(yàn)結(jié)果

由表3可以看到,采用BERT-BiLSTM-CRF模型進(jìn)行實(shí)體抽取的效果最好,F1 分?jǐn)?shù)可以達(dá)到97.24,BiLSTM-CRF模型效果又優(yōu)于HMM 模型。

根據(jù)HMM 模型結(jié)構(gòu)和實(shí)驗(yàn)結(jié)果分析得到,在HMM 模型中,對(duì)文本序列標(biāo)注的識(shí)別判斷依賴于他本身的狀態(tài)和文本序列對(duì)象,但是文本序列的標(biāo)注不僅僅與待觀察的文本序列對(duì)象有關(guān),還與觀察序列的長(zhǎng)度、上下文相關(guān)。對(duì)于Bi LSTM-CRF模型,其模型中的BiLSTM 網(wǎng)絡(luò)中存在前向LSTM 與后向LSTM 層,用于識(shí)別待觀察文本序列的上下文,以更準(zhǔn)確地進(jìn)行預(yù)測(cè),因此其實(shí)驗(yàn)得到的F1分?jǐn)?shù)要高于HMM 模型。

BiLSTM-CRF模型在獲取詞向量時(shí)采用的是embedding層的訓(xùn)練,方式比較簡(jiǎn)單,而B(niǎo)ERT-BiLSTM-CRF模型則綜合了BERT 模型的優(yōu)點(diǎn),即具有很強(qiáng)的動(dòng)態(tài)詞向量獲取能力,能獲取更好的詞向量用于模型的訓(xùn)練和預(yù)測(cè)[22-24],所以BERT-BiLSTM-CRF模型的實(shí)驗(yàn)結(jié)果F1分?jǐn)?shù)最高。

3 結(jié)論

針對(duì)變電站開(kāi)關(guān)柜運(yùn)維對(duì)人員的技術(shù)性要求較高,而且維護(hù)管理難度較其他變電主設(shè)備難度更大的問(wèn)題[25-27],本文結(jié)合3種不同模型,使用深度學(xué)習(xí)方法,對(duì)開(kāi)關(guān)柜運(yùn)維進(jìn)行了實(shí)體抽取,主要結(jié)論如下。

1)BiLSTM 網(wǎng)絡(luò)能夠關(guān)注待識(shí)別序列上下文含義,BERT 網(wǎng)絡(luò)能夠?qū)斎朐~向量進(jìn)行預(yù)訓(xùn)練處理,而B(niǎo)ERT-Bi LSTM-CRF模型結(jié)合了以上網(wǎng)絡(luò)的優(yōu)勢(shì),可以有效提高實(shí)體抽取的準(zhǔn)確率,其F1分?jǐn)?shù)要分別高于BiLSTM-CRF和HMM 模型1.23和3.15。

2)使用實(shí)體抽取技術(shù)可以從信息量龐大的互聯(lián)網(wǎng)快速提取需要的最新變電站開(kāi)關(guān)柜運(yùn)維方案,并有較高的抽取準(zhǔn)確度,三種模型的抽取準(zhǔn)確度均在96%以上。

3)實(shí)體抽取所具有的強(qiáng)大的數(shù)據(jù)挖掘能力,使其在電力領(lǐng)域具有廣闊的發(fā)展空間和應(yīng)用前景。