面向溫室移動機器人的無監督視覺里程估計方法

吳雄偉 ,周云成 ,劉峻渟 ,劉忠穎 ,王昌遠

(沈陽農業大學信息與電氣工程學院,沈陽 110866)

0 引 言

實時定位是溫室移動機器人[1]實現導航,進而開展自主作業的關鍵。溫室場景類似于室內環境,狹小擁擠,且植株行及金屬棚架結構遮擋電磁信號,大田智能農機常用的衛星定位技術[2]難以在其內部進行有效工作。用導軌、道路[3]、壟溝、作物行[4]等特殊環境構型引導定位機器人,是常用的解決方案。然而鋪設導軌會增加溫室建設成本,用特定算法提取植株行等作為導航線的方法[4-6],雖然能有效引導機器人作業,但導航線必須連續才能滿足全局環境下的移動定位需求。LONG等[7]通過擴展卡爾曼濾波和自適應蒙特卡羅定位算法,集成超寬帶、慣性測量單元和激光雷達等多種傳感器,構建了溫室機器人室內定位系統。多傳感集成的方案可取得較高定位精度,但也會增加機器人開發成本。近年來,隨著計算機視覺技術的進步,直接應用相機采集圖像和視覺算法,通過連續跟蹤機器人相對于出發點的位置及姿態(位姿)變化,實現移動定位的相關研究取得了一定進展[8-13]。相機價格低廉,如果能在算法上取得突破,該類技術可作為一種有效的室內定位方案。

視覺里程估計是同步定位與地圖構建(simultaneous localizationand mapping, SLAM)系統的核心,后者使機器人能夠依賴視覺傳感器完成自主導航[14-17],而前者的里程估計精度則直接決定了導航定位性能。目前,視覺里程估計的經典核心算法主要分為基于特征點提取與匹配的方法[8-11],和基于光度誤差優化的直接法[12-13]兩大類。董蕊芳等[14]應用一種特征點法,融合多模態環境信息,實現了基于先驗地圖的機器人定位。在溫室中,植株及建筑結構是主要場景物,其所成圖像顏色、紋理通常較單一,描述圖像局部特征的高可分特征描述子設計困難,同時該類方法只能得到特征點的稀疏深度(目標遠近)值[8],對于相對狹窄局促的溫室環境來說,難以滿足移動機器人的避障需求。直接法則建立在光度不變假設上,可獲取場景稠密深度值,但該類方法需要逐幀優化求解圖像深度及位姿變化,對計算資源要求高,且溫室內光環境復雜,幀間圖像可能會違反光度不變假設,使算法求解不穩定。

得益于生物神經網絡在與環境交互過程中的持續學習能力,生物視覺系統在各種復雜條件下仍能進行良好的空間定位與深度感知。受此啟發,深度學習技術逐漸被用于視覺里程估計任務上。ZHOU等[18]首先基于深度卷積神經網絡(deep convolution neural network, DCNN),用無監督學習方法,聯合訓練深度和位姿估計網絡模型,實現了基于連續圖像的視覺里程估計,GODARD等[19-20]對模型進行了持續改進。周云成等[21]通過進一步在聯合模型中引入時序一致性約束,探討了其在溫室移動機器人位姿跟蹤方面的性能。該類方法應用DCNN的學習能力,可從大量圖像樣本中學習場景結構先驗,克服了經典方法存在的一些不足。但由于位姿估計網絡在推理過程中,直接用相鄰幀圖像作為輸入預測幀間位姿變化,缺少必要的幾何監督,因此此類方法一直受到尺度不確定性的困擾[22],與特征法[8-11]相比,位姿估計偏差較大,定位精度不高。ZHAO等[22-23]將深度網絡和光流網絡結合在一起進行無監督聯合訓練,用光流建立的像素匹配關系來解決尺度不確定性問題,但該方法針對的是單目相機,只能獲取工作場景的相對深度及位置變化,難以進一步應用于機器人的導航路徑規劃等任務上,且在推理應用中需要同時計算兩個神經網絡,資源需求量大。

鑒于溫室移動機器人自主工作中,對絕對尺度視覺里程信息的實際需求,和現有深度學習位姿估計模型存在的尺度不確定問題,本文以雙目相機作為傳感器,提出一種基于無監督光流的視覺里程估計方法,用雙目圖像間光流計算場景稠密絕對深度,用相鄰幀間可靠光流結合場景深度計算幀間位姿變換。構建約束光流模型的局部幾何一致性條件,提高光流和位姿估計精度。并在種植番茄的溫室場景中開展試驗,驗證方法的有效性。

1 基于無監督光流的視覺里程估計方法

1.1 技術框架

在溫室移動機器人攜帶雙目相機所采集并經立體校正的連續視頻中,設t-1、t為相鄰幀圖像采集時刻,用I1、I2、I3分別表示t-1時刻左目圖像和t時刻左、右目圖像。設空間點P在I1、I2、I3上的投影點2D坐標分別為p1、p2、p3(互為匹配點),如雙目相機內、外參矩陣K(含焦距f)、T(含基線距離b)已知,根據雙目視覺原理,由p2、p3水平x坐標差值(視差d),可得P在t時刻左目相機坐標系下的深度值Z2=fb/d,進而可得其3D坐標P2=[X2,Y2,Z2]T=K-1Z2h(p2),h(·)為齊次坐標轉換。此時P2、p1構成一組3D-2D匹配,基于多組匹配,用n點透視(perspective-n-point,PnP)算法[24]可解算出I2至I1的位姿變換矩陣T21,即幀間位姿變換Tt→t-1。繼而可知機器人相對于出發點的位姿變化Tt=ΠtTt→t-1,連續的Tt則構成了機器人運動軌跡,即視覺里程估計可轉化為在圖像間尋找匹配點問題。

本文通過構建基于深度學習的無監督光流模型,建立圖像間像素級稠密匹配,以克服傳統基于特征點匹配的視覺里程估計方法只能獲取稀疏深度值的問題。首先用經過訓練的光流估計網絡(FlowNet),預測I1、I2間的前后向光流(圖像間像素運動,即匹配點間的坐標差異)場。將雙目圖像間視差視為一種特殊光流,即進一步用FlowNet預測I2、I3間的雙向光流場,其中在前向光流場W23中,表示像素在x方向運動的平面W23[:1]可視為該視差。由W23[:1]可得I2對應的稠密深度圖D2,進而可恢復出I2各像素的點云3D坐標。進一步基于預測光流場,通過前后向光流一致性檢查[25-29],選擇I1、I2、I3間的可靠匹配點集,構成多組3D-2D匹配,并用PnP算法求解幀間位姿變換矩陣T21。該方法的整體技術框架如圖1,其在跟蹤機器人位姿變化的同時,可獲得前進方向溫室場景的稠密三維結構信息,為避障等其他應用提供了可能。

圖1 基于光流的視覺里程估計框架圖Fig.1 Framework diagram of visual odometer based on optical flow

1.2 無監督光流模型

光流估計是圖1技術框架的基礎。溫室場景及種植作物復雜多變,光流估計模型的普適性決定了本文方法的可用性。無監督光流模型[25-29]的學習過程只需用相鄰圖像作為訓練樣本,無需光流真值作為標簽,本文用該類模型建立像素匹配,以持續支持在線學習、終身學習,適應不同類型的溫室場景。為便于后續問題討論,首先對無監督光流模型的基本思想做說明。設Wij=Φ(Ii,Ij;θ)為用深度神經網絡構建的映射,以相鄰圖像Ii、Ij作為輸入,預測前向光流場Wij,其中θ為Φ的可學習參數。根據Wij建立的像素匹配關系,有pi+Wij(pi) =pj,pi(位于Ii上)、pj(位于Ij上)為基于Wij建立的匹配點,通過從Ij上采樣,可重構視圖。與Ii在非遮擋區域應表觀一致,用函數度量二者的差異(光度損失),以為優化目標,用大量相鄰圖像作為樣本,可實現Φ的無監督訓練。

式中α1=0.01、α2=0.05[26]。

用遮擋估計結果Mij,為重新定義前向重構光度損失,如式(2)所示。

式中ψ采用魯棒性懲罰函數形式,其定義為,其中q=0.4、ε=0.01[27],并用Mij(pi)排除遮擋區域。按生成Mij的相同過程,為Ij生成后向遮擋掩碼Mji并定義后向光度損失?p,ji。進而以argmin(?p,ij+?p,ji)為優化目標,實現Φ的無監督訓練,并用完成訓練的Φ預測圖像間光流。

1.3 光流估計網絡結構優化

PWC-Net[31]是一種為有監督光流模型設計的神經網絡,但其在無監督光流估計中也得到了廣泛的應用[26-28]。本文以PWC-Net為基礎,并參考近期無監督光流估計的相關研究進展[28-29],對其結構做進一步優化調整后,作為映射Φ(光流估計網絡)。該網絡用DCNN分別提取相鄰圖像Ii、Ij的多層級特征圖,構成6層特征金字塔(圖2a)。基于各層級特征,用光流估計模塊(flow estimation module, FEM)分別預測各層級光流場,l表示層號。FEM首先對l+1級光流場進行上采樣,生成上采樣光流場,基于該光流場,通過雙線性插值在Ij的當前層特征圖上采樣重構出,用和Ii的當前層特征圖計算代價體[31],將代價體、、和作為一個稠密卷積網絡的輸入,做光流估計,輸出當前層級光流場。用FEM逐級預測各層級光流場,直至,然后對其上采樣,生成與輸入圖像同尺寸的最終光流場Wij。

圖2 深度神經網絡結構Fig.2 The structure of deep neural network

與有監督光流模型不同,無監督模型要預測雙向光流來估計遮擋,計算量大。因此,為減少計算量,損失函數通常只設置在最終光流場上[25-28],但這也使層級光流場缺少直接監督信號。JONSCHKOWSKI等[28]研究發現,由于缺少直接監督,PWC-Net的高層級特征圖激活值普遍趨近于0,這將影響網絡對層級光流的預測。本文用特征歸一化來處理該問題,具體方法為:對各層級特征圖和,用(V-μ)/σ進行歸一化,V及μ、σ分別表示特征圖及其均值與標準差。該處理可改變特征圖的激活值分布,緩解激活值趨近于0的問題。PWC-Net的FEM只在第2層級中,用環境網絡[31]對所預測的光流場進行精化。本文的FEM(圖2b)則在每一層級中均采用環境網絡精化光流,提升最終光流場Wij的預測精度,并用優化調整后的網絡作為本文光流估計網絡Φ。

1.4 局部幾何一致性約束的提出

Φ的光流場預測精度,直接影響視覺里程估計性能。為提高Φ的訓練效果,提升光流預測精度,本文根據局部圖像I1、I2、I3所具有的幾何特性,在argmin(?p,ij+?p,ji)目標基礎上,進一步提出并構建3種局部幾何一致性約束,以監督Φ的訓練過程。為此,在訓練中除用Φ預測I1、I2和I2、I3的雙向光流場外,還用其估計I3、I1間的雙向光流,共產生6個局部光流場(圖3),并相應生成對應的遮擋掩碼。

1.4.1 對極幾何約束

對于由Wij(圖3中任一光流場)建立的匹配點對pi、pj,根據對極幾何,pi在Ij上的對應極線向量為lj=Fijh(pi) = [a,b,c]T,Fij為Ii至Ij的基礎矩陣。pj應該在極線lj上,如不在,則其離lj的距離可用式(3)計算。

將距離超過閾值(本文設為0.1)的點,標記為外點,生成外點標記掩碼,當時,,否則。此時可用式(4)計算外點距極線的平均距離。

式中?d,ij可稱為極線距離損失,以其最小化作為Φ的優化目標之一,可使Wij中的外點逐步成為內點。

1.4.2 匹配點選擇與基礎矩陣求解

式(3)的計算需要基礎矩陣Fij。假設Φ在訓練過程中預測的Wij含有精確匹配(內點),只要從中篩選出這些點,即可用8點法[32]通過隨機采樣一致性(random sample consensus, RANSAC)循環求解Fij。精確匹配點對的雙向光流應大小相同,方向相反,即具有一致性。首先定義式(5)來衡量匹配點對的光流一致性。

1.4.3 位姿變換矩陣求解與投影一致性約束

首先用Φ預測的視差W23[:1]計算得到I2的深度圖D2,進而恢復I2像素的點云3D坐標。然后按求解基礎矩陣的相同策略,基于一致性得分平面,從W23中選擇I2到I3的精確匹配點集,進一步基于,從W21中選擇I2到I1的精確匹配點集,用2個點集的交集,選擇3D點云坐標和在I1中的2D匹配點,構建3D-2D匹配關系。由該關系,可用PnP算法[24]在RANSAC循環中求解I2至I1的幀間位姿變換矩陣T21。

在計算出D2和T21的前提下,根據多視幾何原理,I2上的點p2在I1上的投影點可由式(6)計算得到[19]。

式中?e1為I2到I1的投影一致性損失,如果I2至I1的幀間位姿變換矩陣T21是精確的,則該損失值主要受W23和W21的精度影響。同理,由D2和相機的外參矩陣T,進一步計算I2到I3的投影一致性損失?e3,并令?e=?e1+?e3。以argmin?e為Φ的另一訓練目標,會間接使光流場W23、W21具有一致性。

1.4.4 光流場一致性約束

在3幅局部圖像中,像素在I2、I1間的運動(光流),等價于先從I2運動到I3,再從I3運動到I1,因此理論上光流場W21、W23和W31應滿足W21(p2)=W23(p2) +W31(p3),即這3個光流場應具有一致性,用懲罰函數ψ來度量等式兩側的差異,如式(8)所示。

式中?u2為光流一致性損失,M2(p2)=M21(p2)M23(p2),即式(8)只考慮在I1、I2、I3上均可見像素的光流一致性。同理,光流場W12、W13和W32也應具有一致性,按式(8)相同方式計算一致性損失?u1,并令?u=?u1+?u2。以argmin?u作為Φ的訓練目標,會使其預測的多個局部光流場具有一致性。

通過所選擇的內點集計算基礎矩陣和位姿變換矩陣,在對極幾何和投影一致性約束下,Φ在訓練過程中預測的光流場外點,將在多步學習中逐步成為內點,并在光流場一致性約束下,使該過程在6個局部光流場間傳遞。

1.5 金字塔層間知識自蒸餾的應用

在Φ預測的多層級光流(圖2a)中,理論上最終光流場Wij應具有最高精度。為進一步解決網絡訓練中,層級光流缺少監督的問題,本文用最終光流場監督其他層級光流的預測。

知識蒸餾[33]是一種支持預測能力遷移的深度學習方法。本文借鑒其思想,將最終光流場蒸餾到其他層級光流上,稱為金字塔層間知識自蒸餾。傳統知識蒸餾方法通常用于網絡間的知識遷移,金字塔層間知識自蒸餾則在同一個網絡Φ內的不同層間遷移知識。具體方法為,以Wij作為偽標簽,定義式(9)所示的金字塔層間知識自蒸餾損失,以該損失最小化為Φ的學習目標之一,實現層間知識遷移。

式中↓表示下采樣,用于將Wij和Mij下采樣到與的空間尺度相一致。Wij在下采樣過程中需要將光流值縮小為原值的1/2l,同時用Mij將遮擋區域從知識遷移中排除。相對于將多種優化目標組成的損失函數直接設置在層級光流場上,層間知識遷移能以較小的計算代價,將最高分辨率和精度的最終光流場蒸餾到層級光流場上,而層級光流場精度的提高可能會通過FEM模塊的逐級傳遞,進一步提高最終光流場的精度。

1.6 總損失函數定義與光流網絡訓練

1.6.1 總損失函數定義

組合6個局部光流場(圖3)對應的光度損失、3種局部幾何一致性損失和金字塔層間知識自蒸餾損失,同時為提高網絡Φ訓練的魯棒性,引入基于邊緣感知的光流場平滑損失?s,ij[34]和對光度變化不敏感的census損失?c,ij[25]。將各項損失按線性組合后,定義總損失函數?,見式(10)。

式中λs等表示線性組合系數,分別設置為λs=0.05[34]、λc=1[25]、λt=0.01[29]、λd=0.1、λe=0.01[23]、λu=0.01[27]。最終以argmin?為優化目標,訓練網絡Φ。

1.6.2 網絡訓練方法

基于PyTorch[35],編程實現本文光流模型,用大量圖像樣本對網絡Φ進行優化訓練。用小批量隨機梯度下降法更新網絡參數θ,每小批含2個樣本(由I1、I2、I3構成),學習率設為5×10-5。網絡的輸入圖像尺寸設置為512×320像素。將網絡的訓練分為2個階段,第1階段在不包含局部幾何一致性約束的情況下進行15代(epoch)迭代優化,第2階段包含該約束后再進行多代訓練,直至模型損失值收斂到穩定狀態時為止。

1.7 評估指標

用多種評估指標評價本文方法的視覺里程估計性能。用估計光流和光流真實值間的端點誤差(endpoint error,EPE)和錯誤率F1[29]來度量光流估計精度,2種指標值均越低,表明精度越高。

用視覺里程估計值和機器人真實運動軌跡,來計算相對位姿誤差(relative pose error, RPE)和絕對軌跡誤差(absolute trajectory error, ATE)[36],衡量本文方法的位姿跟蹤精度。RPE在局部范圍內(設為1 m)[36]衡量誤差,其包含相對位移誤差(relative translation error, RTE)和相對姿態誤差(relative rotation error, RRE)兩部分。ATE則在整個運動軌跡內衡量誤差。在計算RTE、RRE和ATE時,分別采用均方根誤差(root mean square error,RMSE)和平均絕對誤差(mean absolute error, MAE)2種方式,各指標值均越低,表示位姿跟蹤越精確。

用像素p的估計深度與真實深度zp的平均相對誤差(mean relative error, Rel)、平方相對誤差(squared relative error, Sq Rel)、RMSE和lg化RMSE(RMSE1g),以及閾值限定精度[19]來衡量本文方法的深度估計性能,誤差越低、閾值限定精度越高表示性能越好。閾值限定精度指滿足δ < ωτ的像素所占的比例,其中ω=1.25、τ∈{1,2,3}[19],δ通過式(11)計算。

2 試驗系統及數據集構建

2.1 試驗系統

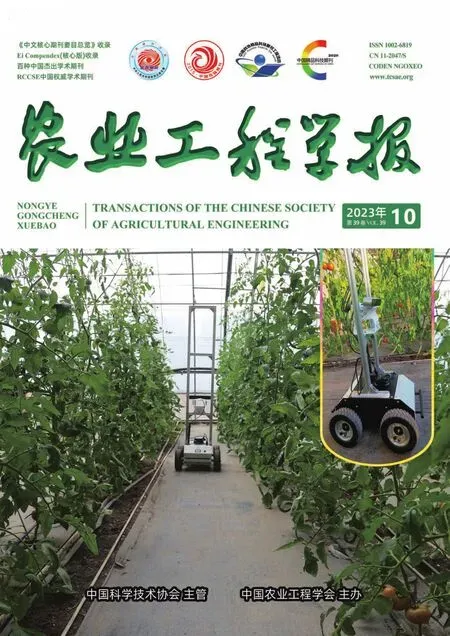

用輪式移動機器人(速度0~0.8 m/s,可定速行進)作為底盤載具(圖4),開展數據采集及驗證試驗。該設備采用Nvidia Jetson AGX Xavier作為控制主機,運行Ubuntu 18.04和ROS系統,可遠程遙控行進。視覺傳感器采用Stereolabs ZED 2k雙目相機,水平前視安裝于底盤上部的托架上,離地高度約1.2 m,并通過USB串口接入控制主機。相機單目分辨率為1 920×1 080像素,采樣頻率為15幀/s,配套軟件工具提供了焦距、主點坐標和雙目基線距離等參數,由這些參數可得相機內、外參數矩陣K、T。

圖4 輪式移動機器人及試驗場景Fig.4 Wheeled mobile robot and test scenario

本文光流模型在預先完成訓練和測試后,再部署于移動機器人上,用于視覺里程估計。在配置有Intel Xeon E5-2 630 v4處理器,Nvidia Tesla K80計算卡,128 GB內存,Windows Server 2019 R2操作系統的計算機上進行光流模型的訓練和測試。

2.2 溫室雙目視頻數據采集

于2022年10—11月,在沈陽農業大學教學科研基地,某種植番茄的遼沈IV型節能日光溫室內,開展雙目視頻數據采集。此階段番茄處于坐果期,植株吊蔓生長,株高1.5~2.2 m,株距約0.3 m,行距約1.2 m。在晴朗天氣的10:00—16:00采集數據,通過遙控,使機器人在株行間和其他行走通道上行進,并通過雙目相機采集視頻。將采集的長視頻分割成小序列,每序列含200幀雙目圖像,共500個小序列。隨機選擇400個序列作為訓練集,用于光流模型訓練,其余100個用作測試集。

2.3 光流真實值獲取

針對測試集,進行圖像間光流真實值獲取。SIFT算子對光照變化、旋轉、縮放等具有魯棒性,對測試集的每個序列,用該算子提取I1、I2、I3的特征點,用k近鄰算法匹配各圖像間特征點,通過比率測試和交叉過濾初步濾除誤匹配,通過在RANSAC循環中求解基礎矩陣并應用對極幾何約束,進一步刪除外點,最后用人工逐幀走查方式去除剩余的誤匹配,用余下正確匹配點的坐標計算圖像間稀疏光流,并將其作為光流真實值,共獲取8.52×107個真實值。用測試集及其光流真實值評估本文光流模型的光流估計精度。

3 結果與分析

3.1 無監督光流模型的有效性分析

無監督光流模型的光流預測精度直接決定基于圖1技術框架的視覺里程估計性能。為提高光流預測效果,本文在現有方法[25-29]基礎上,構建了局部幾何一致性約束,并優化調整了光流估計網絡等,首先通過試驗,分析各處理的有效性。

3.1.1 損失項的有效性分析

光度損失和光流場平滑損失最小化一直是無監督光流模型的主要優化目標,以此為基準,在網絡Φ相同的前提下,通過逐步啟用總損失函數?的其他損失項,構建了6種網絡損失模型,分別命名為I、II、III、IV、V、VI,各模型對應的損失項線性組合系數設置如表1,其中模型I的損失項構成同文獻[34],II的構成同文獻[25]。用溫室雙目視頻訓練集訓練各模型,進而用測試集及其光流真實值評估各模型對應網絡的光流估計精度,每個試驗重復3次,結果如表1。

表1 不同網絡損失模型的無監督光流估計精度Table 1 Unsupervised optical flow estimation accuracy for different network loss models

表1數據表明,各損失項對提高光流估計精度均是有效的。模型I只含光度和光流場平滑損失,II在其基礎上增加了census損失,該處理使4項光流端點誤差EPE和錯誤率F1顯著下降(P<0.05),表明census損失在該任務中是有效的。census損失通過比較重構圖像與目標圖像的census特征,可克服光度變化對損失度量的影響,使模型訓練更具魯棒性。III在II基礎上增加了金字塔層間知識自蒸餾損失,該損失項使各項誤差均顯著降低(P<0.05),其中相鄰幀間光流的EPE降低11.76%,雙目圖像間光流的EPE和F1分別降低11.45%和1.76個百分點。最終光流具有最高分辨率,這有利于光度損失發揮監督作用,獲得精度更高的光流場,再將此光流場蒸餾到中高層光流上,相當于間接將含多種約束的無監督損失函數作用于中高層上,提高了中高層光流的估計效果,進而促進了依賴中高層光流的最終光流場精度的提高。

IV、V、VI在III的基礎上逐步引入3種局部幾何一致性約束損失項,結果表明,整體上各項誤差逐漸降低。IV和III相比,6項EPE和F1指標均顯著下降(P<0.05),表明對極幾何約束可顯著提高模型性能。V在IV基礎上增加了投影一致性約束,該處理使前者的2項F1相比后者顯著下降(P<0.05),其余指標有所下降,表明該約束對提高光流估計精度也是有效的。VI和V相比,6項EPE和F1指標均顯著下降(P<0.05),表明光流一致性約束能有效降低預測誤差。同時比較VI和III,前者的EPE下降8.89%,的EPE和F1分別下降8.96%和1.23個百分點,進一步表明局部幾何一致性約束對提高模型光流預測精度是有作用的。局部幾何一致性約束使Φ在訓練過程中,應用當前估計的部分可靠光流值,計算圖像間的幾何關系,并進一步應用該幾何關系約束模型,使其估計的外點逐漸成為內點,從而在整體上提高了模型的光流預測精度。總體上,本文構建并引入的多個損失項均能有效提高無監督光流估計性能。

3.1.2 網絡結構有效性分析

進一步分析本文光流估計網絡的優化調整對光流預測的作用。以PWC-Net為基準,對其使用特征歸一化處理后,構成網絡Φ0,進一步在各層級FEM中使用環境網絡精化層級光流,則構成本文網絡Φ,各網絡均采用模型VI的損失函數。用溫室雙目視頻數據集訓練并測試各網絡光流估計性能,同時測試各網絡計算速度,結果如表2。

表2 不同網絡結構的無監督光流估計精度Table 2 Unsupervised optical flow estimation accuracy for different network structures

由表2可知,網絡結構對模型性能影響顯著。Φ0在PWC-Net基礎上對金字塔層級特征進行歸一化處理,該處理使6項EPE和F1指標均顯著降低(P<0.05),其中的EPE降低了12.50%,的EPE和F1分別降低了7.25%和0.99個百分點,歸一化處理使Φ0的計算速度下降了1.28%,但光流估計精度有較大提升,表明特征歸一化對提高模型性能具有顯著作用。由于特征歸一化可改善高層特征圖激活值分布,較好地避免了激活值偏低對FEM預測高層光流場的影響,從而通過提高高層光流場的預測效果,進而提高了最終光流場的預測精度。Φ在Φ0基礎上,使用環境網絡精化金字塔各層級光流,該處理使各項誤差顯著下降(P<0.05),其中雙目圖像間光流EPE下降4.69%。用擴張卷積構建的環境網絡有效擴大了卷積感受野,這使其可以在更大尺度上應用環境信息來精化光流運動,進而提高了光流估計效果。在各層級FEM中運行環境網絡,需執行大量的計算,因此與Φ0相比,Φ的計算速度下降了14.24%,在應用中,可根據實時性和精度的平衡,決定是否啟用精化過程。總體上,本文對網絡結構的優化調整,對提高模型光流預測性能是有效的。按文獻[31]方法對Φ估計的部分局部光流場進行可視化,結果如圖5。

圖5 局部光流場示例Fig.5 Examples of local optical flow field

從圖5b、5c可以看出,光流模型估計出了相鄰幀圖像上不同像素的光流變化。由于雙目圖像間光流只是像素在水平方向上的運動,因此光流場W23和W32的顏色值應是單一的,圖5 d和5e的結果與此相符,即本文模型是可以同時用于估計幀間光流和雙目圖像間光流的。

3.2 溫室移動機器人視覺里程跟蹤試驗驗證

3.2.1 視覺里程跟蹤試驗驗證方法

用完成訓練和測試的光流估計網絡Φ(模型VI)作為FlowNet,基于ROS,編程實現圖1框架所示視覺里程估計系統,并部署在輪式移動機器人上,框架中的各步計算均實現為ROS節點。系統除完成計算外,也將運行過程中的跟蹤計算結果(深度圖、幀間位姿變換矩陣等)連同雙目視頻幀,以文件形式存儲于系統中。于雙目視頻數據集采集所在溫室相鄰的日光溫室內,開展視覺里程跟蹤驗證試驗。兩個溫室種植作物相同、管理模式相似。機器人采用遙控方式行進,行進中,系統持續在線跟蹤機器人運動軌跡。每次跟蹤,機器人分別以0.2、0.4、0.6和0.8 m/s不同的速度勻速前進,共跟蹤了20條軌跡,每個速度分別對應5條軌跡,軌跡長度為15~70 m不等。每次跟蹤后,從機器人系統中下載跟蹤結果及對應連續視頻幀。對連續視頻幀做進一步處理,用2.3節方法獲取圖像間稀疏光流真實值,進而用1.1節方法計算稀疏深度真值和機器人位姿變換。該處理在文獻[21]移動距離和角度變換已知的測試集上的相對誤差均低于0.17%,因此可將其獲取的位姿變換作為真實值,用于分析本文方法的視覺里程跟蹤性能。

3.2.2 與現有方法的比較

為驗證本文方法的性能,首先和現有的一些優秀基準方法進行比較,具體包括UpFlow[29]、Monodepth2[19]和ORB-SLAM3[8],其中UpFlow是一種在交通數據集上取得優異性能的無監督光流模型,Monodepth2是一種基于無監督學習的深度和位姿聯合估計模型,ORB-SLAM3是一種新近提出的用稀疏特征點實現視覺里程跟蹤的SLAM系統方法。用溫室雙目視頻訓練集,分別訓練UpFlow和Monodepth2,并按圖1技術框架實現基于Up-Flow的視覺里程估計系統,用該系統、Monodepth2模型和ORB-SLAM3方法分別以離線方式,對視覺里程跟蹤試驗后下載的各軌跡連續視頻幀進行視覺里程估計。由于移動機器人的計算資源無法滿足同時運行多種方法,所以采用離線方式,以保證不同方法估計的是相同的機器人運動軌跡。用稀疏深度真值和機器人真實運動軌跡,對本文在線跟蹤結果及其他3種方法的離線估計結果進行誤差分析,結果如表3和表4。

表3 不同方法的位姿跟蹤性能比較Table 3 Accuracy comparison of different methods on pose tracking

表4 不同方法的深度估計性能比較Table 4 Accuracy comparison of different methods on depth estimation

由表3數據可知,不同方法的位姿跟蹤性能差異顯著(P<0.05)。在UpFlow、Monodepth2和本文方法在內的3種基于無監督學習的方法中,本文方法具有最高的跟蹤精度,其在6項誤差指標上均顯著低于其他2種方法。就相對位移誤差RTE指標而言,與UpFlow相比,本文方法的均方根誤差RMSE和平均絕對誤差MAE 2種統計結果分別降低9.52%和9.80%,與Monodepth2相比,則分別降低43.0%和43.21%。相對于Monodepth2,基于無監督光流的UpFlow和本文方法具有更好的位姿跟蹤性能。Monodepth2的位姿估計網絡在聯合訓練時,會受深度估計網絡的約束,但在推理時僅有相鄰幀作為輸入,受尺度不確定性影響,幀間位姿變換估計往往精度較低。基于光流的位姿變換估計,則應用由雙目和相鄰幀間可靠光流構建的3D-2D匹配關系,求解幀間位姿變換,其在訓練和應用中持續受到幾何約束,無尺度不確定性問題,因此具有更高的位姿跟蹤性能。對比本文方法和ORB-SLAM3,后者各項誤差均顯著低于前者(P<0.05),但兩者各項誤差無數量級差異,另外本文方法能應用估計光流計算場景稠密深度和三維點云,進而可得場景三維結構,這是后者所不具備的。

由表4可知,UpFlow和本文方法在各項深度估計誤差上均顯著低于Monodepth2(P<0.05)。由于Monodepth2的位姿估計網絡受尺度不確定性影響,在聯合訓練中,該影響將會傳遞給深度估計網絡,降低了其深度預測性能。本文方法的深度估計相對誤差Rel為5.28%,與Monodepth2和UpFlow相比,分別降低2.90和0.99個百分點。ORBSLAM3只能提取、匹配稀疏特征點,無法與本文方法獲取的稀疏深度真值相對應,因此未能評估其深度估計性能。對比本文方法和UpFlow,前者在3項深度估計誤差和1項閾值限定精度上顯著優于后者(P<0.05),其他3項指標無顯著差異,表明前者具有更高的深度估計精度。本文構建了局部幾何一致性約束,優化調整了網絡結構等,有效提升了模型光流預測效果,進而提高了基于光流的位姿跟蹤及深度估計精度。總體上,本文方法能夠跟蹤機器人運動軌跡并估計場景深度,且具有較高的性能。

3.2.3 運動速度對機器人位姿跟蹤性能的影響

機器人運動速度會影響幀間光流大小和相機成像質量,為分析運動速度對位姿跟蹤性能的影響,進一步比較本文方法對前文視覺里程跟蹤試驗中,不同速度下機器人運動軌跡的跟蹤精度,結果如表5。

表5 不同運動速度下的位姿跟蹤性能Table 5 Pose tracking performance under different motion speeds

表5數據表明,機器人運動速度對本文方法位姿跟蹤性能具有顯著影響(P<0.05)。在運動速度為0.2 m/s(記為慢速)時,跟蹤性能相對較低,為0.4 m/s時,性能有所提高,為0.6 m/s時,本文方法具有最小的跟蹤誤差,為0.8 m/s(記為快速)時,各項誤差迅速升高,跟蹤性能變差。機器人運動速度決定相鄰幀間的位姿變化大小,慢速運動時位姿變化小,快速時變化大。由于幀間光流估計存在著一定誤差,該誤差對基于光流匹配的微小幀間位姿變換矩陣的解算精度影響較大,對較大位姿變換矩陣的求解則影響較小。當機器人快速行進時,容易造成圖像運動模糊和抖動,且幀間光流迅速變大,增加了模型光流預測難度[37],從而使基于光流的位姿跟蹤性能下降。就試驗而言,本文方法在機器人以0.6 m/s速度運動時,具有最好的位姿跟蹤性能。

3.2.4 分辨率對位姿跟蹤性能的影響

本文光流模型在訓練時,采用512×320像素的固定大小圖像作為輸入。在機器人視覺里程跟蹤試驗中,系統也將視頻圖像調整為該分辨率后輸入模型。進一步采用本文方法,改變光流模型的輸入圖像分辨率,以離線方式對視覺里程跟蹤試驗后下載的各軌跡連續視頻幀進行視覺里程估計,用于明確模型對不同分辨率輸入圖像的適應性,并分析分辨率對位姿跟蹤性能的影響,結果如表6。

表6 不同輸入圖像分辨率的位姿跟蹤性能Table 6 Performance of pose tracking with different input image resolutions

表6數據表明,用固定分辨率圖像訓練光流模型,在推理時改變分辨率,基于該模型的視覺里程估計系統仍能有效跟蹤機器人運動軌跡,說明本文方法對分辨率變化具有魯棒性。隨著分辨率增大,位姿跟蹤各項誤差逐漸下降。當分辨率增加時,圖像保留了更多的局部細節信息,利于模型提升光流估計精度,進而提高系統的位姿跟蹤性能。同時,相同的光流誤差對高分辨率圖像間的位姿變換矩陣求解的影響也小于低分辨率圖像。當圖像分辨率為832×512像素時(限于計算設備存儲約束,未能對更高分辨率進行分析),本文方法在1 m范圍內產生的RTE絕對誤差均值MAE不高于0.036 m(3.6 cm),相對姿態誤差RRE的MAE不高于0.023 rad(1.3°),與448×256像素分辨率相比,圖像接近放大2倍,這2項誤差則分別下降33.33%和25.81%。圖像分辨率對位姿跟蹤性能具有顯著影響,分辨率越大,跟蹤精度越高。

3.2.5 軌跡跟蹤與深度估計圖示

用832×512像素分辨率圖像作為光流模型輸入,用本文方法,對部分視覺里程跟蹤試驗中不同速度下的機器人運動軌跡進行離線跟蹤,結果如圖6。

圖6 不同行進速度下的軌跡跟蹤示例Fig.6 Examples of trajectory tracking at different motion speed

由圖6可以看出,本文方法可有效跟蹤機器人的運動軌跡。圖中各條跟蹤軌跡與對應的真實軌跡在初始段吻合程度均較好,隨著跟蹤距離延長,也會逐漸出現偏離現象。

從圖中可以看出,不同株行間的局部跟蹤軌跡與真實軌跡的長度吻合程度較好,即局部軌跡誤差較小,表6的指標值也說明了這一點,但隨著誤差累計,特別是姿態誤差的累計,跟蹤軌跡與真實軌跡之間的偏離逐漸增大。在機器人沿道路直行時,在15 m行進范圍內,不同速度下跟蹤軌跡與真實軌跡的一致性均較好。圖6也表明,運動速度對軌跡的跟蹤精度產生了較大的影響,在0.2 、0.8 m/s速度下,均較快地產生了軌跡偏離。

進一步選取視覺里程跟蹤試驗中,1條速度為0.6 m/s的視頻序列,從中截取2段機器人在某株行間行進的小序列,其中一段由北向南行進,此時機器人逆光前行,另一段由南向北,即順光行進。用本文方法以離線方式跟蹤2個小序列的軌跡,基于視差W23[:1]計算各幀左目圖像深度,進而恢復各幀點云,基于,保留其中得分為前20%的點云,并通過各幀相對于首幀的位姿變換矩陣Tt,將點云坐標變換到首幀對應的左目相機坐標系(設為世界坐標系)下,同時將跟蹤軌跡點投影到首幀圖像上,可視化結果如圖7。

圖7 局部區域內的視覺里程估計Fig.7 Examples of visual odometry application in local ground

由圖7可以看出,在逆光和順光條件下,小序列首幀圖像對應的深度圖,很好地反應了場景的景深變化,也清晰地刻畫出了株行間的通道。由各幀深度圖恢復的點云,在變換到世界坐標系下后,很好地反應了株行間局部區域的三維結構。通道地面和順光條件下所見溫室后保溫墻對應的點云分布平滑,兩側植株點云結構清晰,通道空間內未見其他雜點,這表明將本文方法估計的深度信息用于機器人避障、環境地圖構建[16]等也是可行的。從圖中也可以看出,在局部區域范圍內,跟蹤軌跡與真實軌跡的吻合度較高,在機器人行進中,相機的左右擺動,在跟蹤軌跡上也有較好的體現。與順光條件相比,逆光條件下的相機成像質量相對較差,圖像模糊,但本文方法仍能較好的跟蹤機器人運動軌跡并恢復場景三維結構,表明該方法具有一定的魯棒性和光環境適應性,本文可為溫室移動機器人視覺系統設計提供一定參考。

4 結 論

本文提出一種面向溫室移動機器人的無監督視覺里程估計方法,并在種植作物為番茄的日光溫室場景中開展了試驗驗證,主要結論如下:

1)所構建的局部幾何一致性約束能有效提高無監督光流模型精度,幀間和雙目圖像間光流端點誤差EPE分別下降8.89%和8.96%。金字塔層間知識自蒸餾損失可顯著降低光流估計誤差,幀間和雙目圖像間光流EPE分別降低11.76%和11.45%。

2)對光流估計網絡的層級特征圖進行歸一化處理,使網絡計算速度下降1.28%,但光流估計誤差也顯著降低,其中幀間和雙目圖像間EPE分別降低12.50%和7.25%。

3)實際視覺里程跟蹤試驗結果表明,與基于UpFlow光流模型的視覺里程估計相比,本文方法相對位移的均方根誤差和平均絕對誤差分別降低9.52%和9.80%,與Monodepth2相比,則分別降低43.0%和43.21%,與ORB-SLAM3相比,本文方法的位姿跟蹤精度相對較低,但優勢在于能夠恢復場景稠密深度,這為機器人避障提供了可能。本文方法的深度估計相對誤差為5.28%,顯著優于比較方法。

4)位姿跟蹤精度受機器人運動速度影響,在0.2 、0.8 m/s下的位姿跟蹤性能顯著低于0.4~0.6 m/s速度下的性能。隨著輸入圖像分辨率的增加,位姿跟蹤精度逐漸提高,當分辨率為832×512像素時,該方法在1 m范圍內跟蹤的相對位移MAE不高于3.6 cm,相對姿態MAE不高于1.3°。

該研究可為溫室移動機器人視覺系統設計提供技術參考。