基于自適應特征感知的輕量化人體姿態估計

毋寧, 王鵬, 李曉艷, 呂志剛, 孫夢宇

(1.西安工業大學 兵器科學與技術學院, 陜西 西安 710021;2.西安工業大學 發展規劃處, 陜西 西安 710021;3.西安工業大學 電子信息工程學院, 陜西 西安 710021;4.西安工業大學 光電工程學院, 陜西 西安 710021)

1 引言

隨著計算機視覺領域的不斷發展,人體姿態估計逐漸進入人們視野。人體姿態估計主要是對圖片或視頻中的人體骨骼關鍵點進行精確定位識別[1-2]。目前人體姿態估計算法已被廣泛應用到人機交互、動作識別、3D姿態研究、智能武器、智能視頻監控等眾多領域[3-6]。但隨著人體姿態估計算法檢測精度的提升,模型復雜度也在劇增,造成模型參數量和計算量的大幅增加,導致現有的人體姿態估計算法難以滿足實際應用中對檢測效率的需求。低內存和低計算能力下的姿態估計問題不僅具有挑戰性,目前還很少受到研究界的關注[7-10],因此進行人體姿態估計模型的輕量化研究十分必要。在確保模型檢測精度的同時,降低網絡模型的體積與運算量、提高檢測速率變得刻不容緩。

基于深度學習的人體姿態估計可分為兩種:一種是自下向上框架,其直接定位人體骨骼關鍵點,再通過聚類等方法將關鍵點匹配到相應的人[11-12];另一種是自頂向下框架,先對人體進行檢測,再通過直接回歸或熱圖回歸的方法對關鍵點進行定位識別[13]。Fang[14]等人提出基于自上向下框架的多人姿態估計網絡(Regional Multi-Person Pose Estimation,RMPE),結合對稱空間變換網絡有效提高了關鍵點檢測效果,但其存在網絡復雜度高、算法運行時間長的問題。Chen[15]等人提出的級聯金字塔網絡(Cascaded Pyramid Network,CPN)采用在線難例挖掘有效緩解了困難關鍵點定位問題,但仍存在精度低、時耗長的缺點。Sun[16]等人提出深度高分辨率網絡(High Resolution Network,HRNet),高分辨率網絡有效改善了關鍵點定位精度,但在網絡中始終保持高分辨率極大增加了網絡負荷,導致模型參數量急劇增加。Cheng[17]等人融入多尺度模塊改善高分辨率網絡的多尺度特征提取能力,但更加深了模型的復雜度。Yu[18]等人提出輕量級高分辨率網絡(Lite-High Resolution Network,Lite-HRNet),引入條件信道加權單元取代昂貴的點態卷積,并結合通道混洗有效減少了網絡的復雜度,但也造成了精度的極大損失。

針對人體姿態估計模型在準確度與速度之間難以平衡的問題[19],本文展開了人體姿態估計算法的輕量化研究,主要從卷積模塊輕量化、注意力機制輕量化及損失函數3個角度進行改進,使模型在保證檢測精度的同時減少了網絡參數量與運算量,壓縮了模型體積,從而改善了實際應用中人體姿態估計模型的檢測效率。實驗結果證明,最終得到的輕量級人體姿態估計模型有效提高了多人復雜場景下的關鍵點檢測性能,實現了人體姿態估計模型的輕量化。

2 RMPE算法原理

圖1是一種經典多人姿態估計網絡RMPE(Regional Multi-person Pose Estimation)的結構圖,主要由人體檢測、空間變換網絡(Spatial transformation network,STN)、姿態估計網絡SPPE、空間反變換網絡(Spatial de-transform network,SDTN)以及姿態非極大值抑制Pose-NMS 5部分組成。RMPE算法先通過目標檢測算法進行人體檢測,然后將檢測到的人體送入姿態估計網絡SPPE中,對每一個人的關鍵點分析定位,再通過姿態非極大值抑制對冗余的人體檢測結果進行消除,得到最終的人體姿態估計檢測結果。

圖1 多人姿態估計網絡RMPEFig.1 Multi-person pose estimation network RMPE

RMPE網絡為自頂向下的多人姿態估計網絡,其在追求高精度關鍵點檢測的同時會涉及大量的運算量,加深了模型復雜度,且隨著輸入圖片中人數的增多,關鍵點的數量也在成倍增加,導致檢測效率大幅降低,實際應用效果差。故如何在保證模型檢測精度的同時,有效減少網絡的參數量和計算量,提高人體姿態估計網絡的檢測效率十分必要。為了提升人體姿態估計算法在實際應用中的檢測效率,本文將對RMPE算法展開輕量化研究。

3 本文算法

3.1 改進的RMPE-tiny網絡結構

RMPE網絡作為多人姿態估計模型具有較好的檢測效果,但在實際應用中由于網絡較復雜、參數量多,導致模型龐大,檢測速率慢。本文為降低多人姿態估計網絡RMPE的復雜度,提高模型的實時檢測效率,改進并得到了如圖2所示的輕量化人體姿態估計模型RMPE-tiny。

本文算法首先針對模型參數量大的情況,結合Ghost卷積[20]構建G-Bottleneck模塊,實現特征提取網絡的輕量化重構,所構建的G-Bottleneck模塊如圖2所示。其次由于特征提取網絡參數量減少會導致網絡缺少部分特征信息,因此融合了多個改進的輕量級自適應特征感知注意力機制Sa-ECA,增強通道間的信息交流以得到更豐富的語義信息。最后采用指數平方損失函數Huber Loss[21]來優化損失回歸,加速模型收斂,提升模型對異常點的檢測效果。

最終通過改進得到了一個輕量級、高精度、強魯棒性的輕量級人體姿態估計模型RMPE-tiny,可以有效降低網絡參數量,壓縮模型體積,充分融合通道間交互信息并增強人體關鍵點的定位效果,顯著提高了人體姿態估計模型檢測效率,實現了人體姿態估計網絡的輕量化。

3.2 基于Ghost模塊的特征提取網絡重構

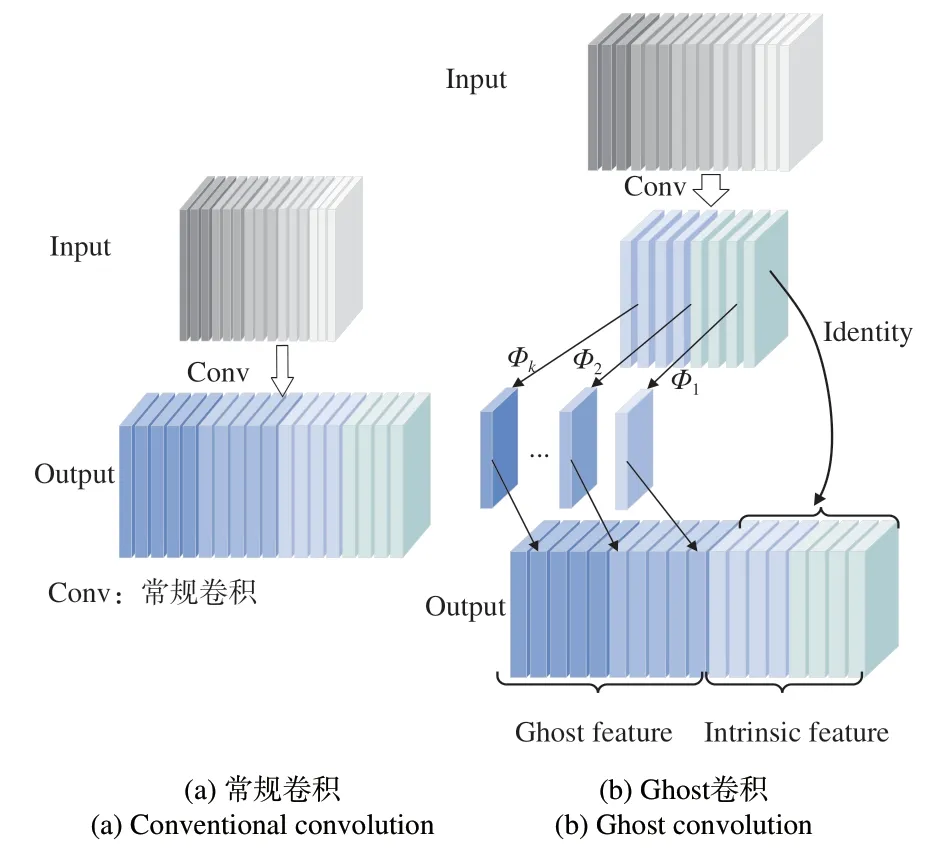

為降低多人姿態估計RMPE網絡的復雜度,本文首先進行了基于Ghost模塊的特征提取網絡輕量化重構。RMPE姿態估計模型采用Resnet50骨干網絡進行特征提取,該網絡在提高性能的同時也帶來了更多的計算量。由于卷積神經網絡的語義信息中包含眾多冗余特征,普通卷積操作含浪費大量的參數量和算力來提取冗余特征,限制了模型的運行效率,而Ghost卷積采用廉價線性操作映射生成冗余特征,極大地減少了卷積運算。故本文結合Ghost卷積,構建了輕量級特征提取模塊G-Bottleneck,以減少提取冗余特征造成的算力浪費。

在進行常規卷積運算時,當輸入數據為X∈Rc×h×w,則會產生n個特征映射,常規卷積運算公式如式(1)所示:

式中:Y∈Rh'×w'×n表示n個通道的輸出特征映射,h和w為輸入圖像高和寬;*表示卷積運算,f∈Rc×k×k×n為該層卷積核,c為輸入通道數,k×k為卷積濾波器f的核大小,b為偏置項。故常規卷積運算所需計算量為n·h'·w'·c·k·k,其中h'和w'分別為輸出圖像的高和寬。由于濾波器的數量n和通道數c通常非常大,故模型的浮點運算量通常非常高。

對比圖3(a)常規卷積和圖3(b)Ghost卷積可以發現,通過常規卷積直接提取全部特征時,生成的全部特征圖中往往包含眾多冗余特征,使用常規卷積直接生成這些冗余特征會造成極大算力浪費;Ghost卷積則通過線性映射提取冗余信息,避免了采用常規卷積提取冗余特征帶來的大量算力浪費。Ghost卷積首先通過少量常規卷積生成內在特征,再通過廉價線性變化φ生成冗余特征Ghost feature來增強特征,增加信道,用恒等映射Identity生成內在特征Intrinsic feature,線性變化和恒等映射并行,最終融合得到豐富的輸出特征。廉價線性操作的計算公式如式(2)所示:

圖3 常規卷積和Ghost卷積Fig.3 Conventional convolution and Ghost convolution

式中:?i=1,…,m,j=1,…,s,yi'是Y'中的第i個固有特征映射,φ是生成第j個Ghost特征yij的第j個線性操作,yi'可以有一個或多個Ghost特征映射,最后一個φi,s保留固有特征映射內的自身映射。利用公式(2)可獲得n=m·s個特征映射作為Ghost模塊的輸出,線性操作φ在每個信道上的計算成本遠小于普通卷積。

Ghost卷積模塊包含恒等映射與線性操作,線性操作卷積核大小是d×d,Ghost卷積一般采用相同大小的線性操作。理論上,Ghost卷積改進常規卷積的模型壓縮比Rs如公式(3)所示:

當卷積核與大小相似時,這種理想情況的模型壓縮比Rc如式(4)所示。

3.3 輕量級自適應特征感知注意力機制

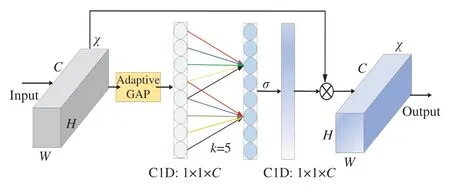

為增強人體姿態估計網絡的跨通道信息交互,有效融合局部與全局信息,本文改進了高效注意力模塊(Efficient Channel Attention,ECA)[22],得到了輕量級自適應特征感知模塊(Sa-ECA)。通過在人體姿態估計網絡中融入多個Sa-ECA模塊,實現了更加高效的語義信息提取與交互。RMPE網絡使用注意力機制(Squeeze and Excitation,SE)[23]增強語義信息提取,但SE模塊采用涉及降維操作的全連接層FC捕獲所有通道間的交互信息,造成了信息的極大損失,并極大增加了網絡負荷。而ECA注意力機制雖可減少網絡負荷,但其通過設定固定卷積核來聚合特征信息,導致該操作不能有效地結合語義信息實現特征聚合。本文采用自適應全局平均池化來完成特征聚合,實現特征信息的有效聚合,改進后的輕量級自適應特征感知模塊Sa-ECA可使模型在參數量減少的情況下實現通道信息的有效獲取。

輕量級自適應特征感知模塊Sa-ECA如圖4所示,圖中卷積塊的輸入為χ∈RW×H×C,其中W、H和C分別為輸入的寬度、高度和通道尺寸。自適應注意力機制將高分辨率特征與卷積后特征融合,保證了特征信息的有效融合。自適應全局平均池化(Adaptive Global Average Pooling,Adaptive GAP)不涉及降維操作可有效獲得聚合特征,使通道和權重之間直接聯系,避免了降維帶來的信息損失,保證了信息的有效獲取。

圖4 輕量級自適應特征感知模塊Fig.4 Lightweight adaptive feature perception module

自適應全局平均池化通過對每個輸出通道的所有像素計算平均值,根據輸入參數自適應地調節控制輸出大小,學習自適應和可判別性的特征圖以匯總特征,同時丟棄無用信息特征,極大地保留目標的大量細節。通過快速一維卷積C1D實現通道間信息交互,捕獲跨通道交互信息,如公式(5)所示:

式中:k為自適應卷積核的大小,表示局部跨通道交互的范圍,是由通道數C的映射自適應地確定的;σ是Sigmoid函數;C1D是一維卷積,即1×k的卷積,它只涉及k個參數,可有效減少注意力機制帶來的大量參數。

3.4 損失函數

為加快輕量化之后模型訓練的收斂速度,本文對訓練所采用的損失函數進行改進。原算法采用平方損失函數(Mean Square Loss,MSE Loss)訓練網絡,雖梯度會隨損失值接近最小值時不斷減小,但其對離群點兼容性不夠好,降低了模型魯棒性。本文結合指數平方損失函數Huber Loss訓練模型,該損失函數圍繞訓練中的最小值減小梯度并降低網絡對異常點懲罰程度,同時可加快模型收斂,相比于平方損失函數有更好的魯棒性。Huber Loss可更好地擬合數據分布,Huber損失函數公式如(6)所示:

式中:yi和f(xi)分別表示第i個樣本的真實值及其對應的預測值,δ為超參數。從定義可以看出Huber Loss處處可導。當預測誤差大于δ時,采用均方絕對誤差損失函數(Mean Absolute Loss,MAE Loss);當預測值誤差小于δ時,則采用MSE Loss。

采用MAE損失訓練網絡時,其梯度始終很大,不利于模型學習,而且在使用梯度下降訓練模型時易忽略較小值;而采用MSE訓練網絡時,梯度會隨損失值接近最小值時不斷減小,但其對離群點的兼容性不夠好。Huber Loss同時包含MAE Loss與MSE Loss兩者的優點,對于異常點有較好的擬合效果,可有效避免梯度爆炸的問題。隨著訓練誤差的減小,梯度也在減小,這可加快收斂速度,使模型較快收斂到最小值。最終本文結合Huber Loss損失函數進行訓練,加快了模型的收斂速度,提高了模型的魯棒性。

4 實驗與結果

4.1 實驗環境及數據集

本文使用Pytorch深度學習框架來實現人體姿態估計算法,實驗操作系統為Ubuntu16.04,顯卡為NVIDIA Quadro M6000。在本實驗中選用Adam優化器對模型進行優化,訓練批量Batch size為32,學習率(LR)為1e-3,訓練周期為200 epoch。所有實驗均在以上環境中進行。

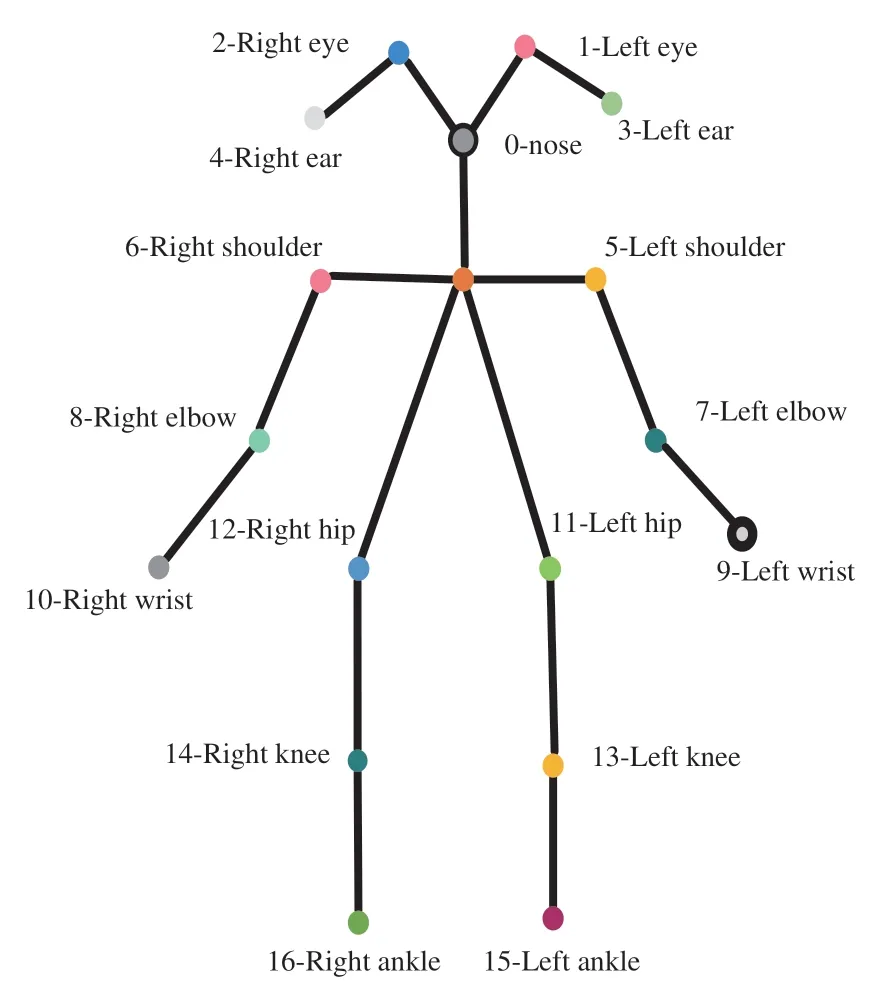

本文使用MSCOCO 2017數據集驗證模型的有效性,該數據集共定義17個人體關鍵點,其具體表示如圖5所示。按需將其劃分為訓練集、驗證集及測試集,其中64 115張訓練集圖片作為訓練樣本,5 000張驗證集作為驗證樣本。

圖5 人體關鍵點示意圖Fig.5 Schematic diagram of key points of the human body

4.2 評估指標

本文采用COCO數據集的主要評估指標AP、AP50、AP75、APM、APL來評估模型的精度。其中AP表示在10個OKS閾值(OKS=0.50,0.55,0.60,…,0.95)處的平均精度,AP50表示OKS=0.50時的檢測精度,AP75表示OKS=0.75時的檢測精度,APM表示中等物體的檢測精度,APL表示大型物體的檢測精度。OKS(Object Keypoint Similarity)表示關鍵點相似度,其值在(0,1)之間分布,OKS的值越接近1則預測結果越好,OKS計算公式如式(7)所示:

式中:di表示每個預測關鍵點與真實關鍵點之間的歐幾里得距離,vi表示關鍵點可視,s表示物體尺度,ki表示控制衰減常數。

對模型輕量化程度評價時,通常選取的評價指標是參數量(Params)、浮點運算數(GFLOPs)及模型大小。參數量是指網絡模型中需要訓練的參數總量,直接決定模型的大小。浮點運算數是網絡實際運行過程中計算量的大小,即算力,其用來衡量算法或模型的復雜度,計算公式如式(8)所示:

式中:K為卷積核,H、W為輸入圖像的高與寬,輸入通道數是Cin,輸出通道數是Cout。文中所用GFLOPs指10億次浮點運算數,其中1GFLOPs=109FLOPs。

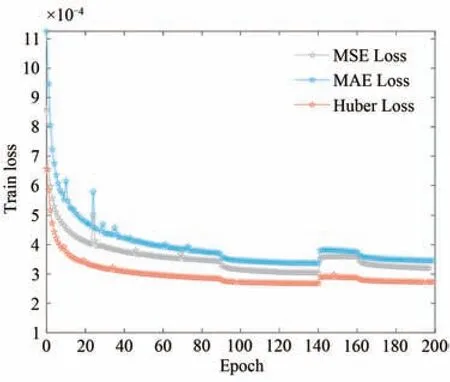

4.3 模型訓練損失對比分析

模型訓練損失曲線對比如圖6所示。使用MAE Loss訓練模型時,損失曲線變化如藍色曲線所示,可以看出損失曲線收斂慢,損失值較高。使用MSE Loss訓練時,損失曲線變化如灰色曲線所示,可以看出模型收斂速度相對較慢,損失值最終收斂在3.5e-4左右,對異常值的處理效果不佳。結合Huber Loss訓練模型時,損失變化如紅色曲線所示,該損失曲線相對較平滑,訓練過程中對異常值的處理優于使用其他兩者訓練時的效果。使用Huber Loss訓練時,模型在訓練到約160批次開始收斂,收斂速度較快,收斂后的曲線較平穩,最終損失值收斂在3.1e-4左右。

圖6 網絡訓練損失對比Fig.6 Comparison of network training losses

損失函數是評價模型的預測值與真實值之間的不一致程度,損失函數越小,模型的魯棒性越好。合適的損失函數會加快模型的收斂速度,提高模型的檢測精度。可以看出,改進模型損失函數,結合Huber Loss訓練模型可加快模型收斂,模型收斂值更優,而且該損失函數對異常值的處理效果更好,增強了模型的魯棒性。

4.4 實驗結果及分析

為驗證算法的有效性,本文主要從模型的參數量、算力以及檢測精度等方面對模型進行對比分析。不同人體姿態估計方法性能對比如表1所示。CPN模型采用堆疊金字塔進行多人姿態估計,檢測精度低,這是其對深層語義信息的提取不夠充分導致的;SimpleBaseline-101[24]模型簡單的反卷積結構使精度提升至71.4%,但同時由于網絡較深也造成了模型參數量劇增;HRNet網絡始終保持高分辨率使檢測精度可達73.4%,但始終保持高分辨率造成了模型體積高達116.2 MB;HigherHRNet為改善多尺度場景檢測效果導致模型算力劇增。從對比實驗結果可以看出,本文提出的RMPE-tiny模型相比于基準模型RMPE,參數量減少了約56.1%;算力減少了約32.0%;模型體積壓縮至72.1 MB,減少了約57.0%;模型檢測精度為72.8%,提升了約0.5%。故可以得出,本文改進后的模型檢測效率更高。

表1 不同人體姿態估計方法的性能對比Tab.1 Performance comparison of different human posture estimation methods

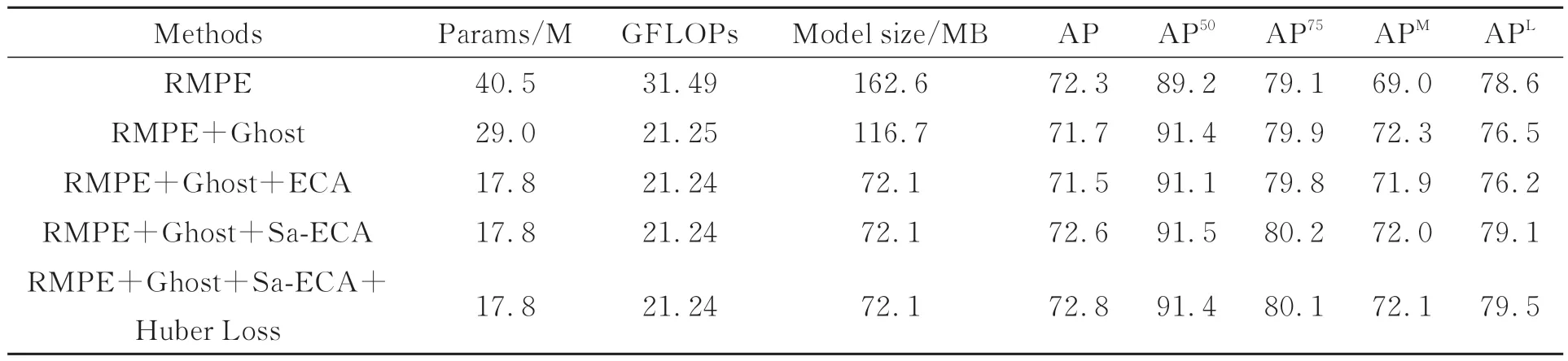

4.5 消融實驗

表2為改進的人體姿態估計算法的消融實驗對比分析,主要對比分析了本文所做各個改進的實驗結果。實驗結果表明,進行基于Ghost模塊的特征提取網絡輕量化重構后,模型參數量由原來的40.5 M下降至29.0 M,與RMPE網絡相比減少了約25.0%,算力減少了約32.5%,模型體積減少了約28.1%。可以看出,Ghost卷積可顯著降低網絡的參數和運算量,但會導致精度AP有所損失。當采用輕量級注意力模塊ECA恢復精度時,模型參數量明顯下降,但模型AP值降至71.5%,檢測精度有所降低,模型性能有所損失。為進一步恢復損失精度,本文融入多個改進的輕量級自適應特征感知模塊Sa-ECA,此時模型體積減少為原來的約57.0%,檢測精度提升為72.6%。故Sa-ECA模塊可使網絡充分獲取關鍵點語義信息,在降低網絡參數量的同時增強模型檢測精度,性能更好。最后改進訓練損失函數,結合Huber Loss訓練模型時檢測精度提高了約0.2%,進一步增強了模型的魯棒性。最終通過本文優化改進得到了一個體積小、精度高、魯棒性強的人體姿態估計模型。

表2 消融實驗的對比分析Tab.2 Comparative analysis of ablation experiments

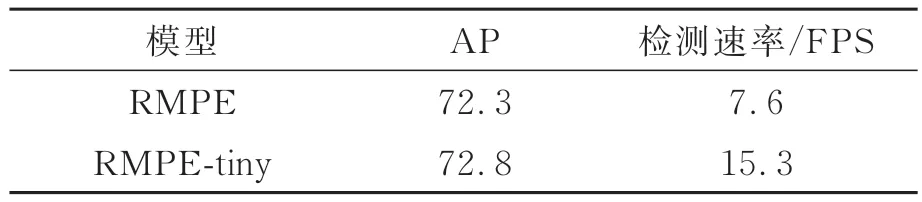

表3為本文改進前后的模型性能對比。從表3可以看出,對RMPE多人姿態估計網絡進行一系列輕量化改進后,本文模型RMPE-tiny與基準模型RMPE相比,模型檢測精度提升約0.5%,模型檢測速率提高了約2.1倍。本文改進后的模型在顯著壓縮模型體積、減少運算量的同時,有效改善了模型的檢測速率,提升了人體姿態估計模型的檢測效率。

表3 模型性能對比Tab.3 Model performance comparison

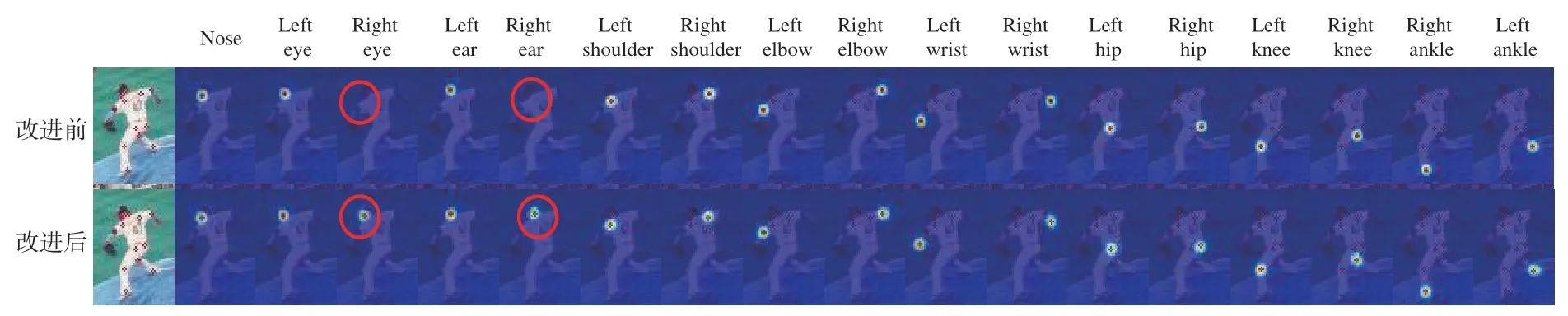

4.6 關鍵點熱圖可視化分析

圖7為模型改進前后的關鍵點定位熱圖可視化分析。從圖7可以看出,注意力機制改進前后的關鍵點檢測效果有著顯著區別。熱圖是對COCO數據集中定義的17個人體關鍵點進行預測的中間過程展示。由于關鍵點為細粒度的像素級目標,故關鍵點熱圖的范圍相對較小。使用注意力機制ECA時,不能很好地檢測到Right ear和Right eye,檢測結果存在一定誤差。這是因為ECA模塊聚合通道間的交互信息具有一定的局限性,導致關鍵點定位效果不理想。

圖7 熱圖可視化分析Fig.7 Heatmap visualization analysis

本文改進后的算法RMPE-tiny通過融入輕量級自適應特征感知模塊Sa-ECA來實現通道信息有效聚合。Sa-ECA模塊只涉及少量參數,通過自適應全局平均池化更加有效地獲取與聚合局部跨通道交互信息,模型檢測效率更高。從圖7可以看出,融入輕量級自適應特征感知模塊的檢測效果更為理想,它能從特征圖中獲取更加充分的關鍵點信息。Sa-ECA模塊在提升模型檢測精度的同時,降低了模型參數量,壓縮了模型體積,故本文有效地實現關鍵點熱圖定位。

4.7 可視化結果

本文方法的可視化效果如圖8所示。圖8(a)為遮擋檢測結果,是針對不同遮擋情況下的檢測結果。當人體某一關節被物體或自身遮擋時,本文模型可獲取充分的上下文語義信息完成關鍵點位置判斷,從而定位到遮擋關節的大致邏輯位置。圖8(b)為復雜姿態檢測效果。當人體做出復雜動作時,關鍵點極易發生多尺度變化。當場景中人體相對較小時,本文模型依舊可精確定位。圖8(c)為多人場景檢測效果。當輸入圖像中的人數較多時,會存在各種遮擋場景及多尺度情況,本文模型依舊可在此類情況下進行高效檢測,準確定位到多人場景下的人體關鍵點,實現高效的人體關鍵點定位。圖8(d)為本文算法模型在實際拍攝場景下的檢測結果。當背景復雜且人物較小有遮擋時,由于本文模型有著較好的泛化能力與魯棒性,依舊可進行高效的關鍵點檢測。因此,從可視化結果可以得出,本文提出的RMPE-tiny算法具有較強的魯棒性且泛化能力更優。該算法在顯著降低網絡復雜度的同時,依舊可以保持較好的關鍵點檢測效果。

圖8 可視化結果Fig.8 Visualization results

5 結論

本文針對一般多人姿態估計算法存在的參數量多、計算量大、檢測速率低,模型檢測速度與檢測精度之間難以平衡的問題,提出了一種改進的輕量級多人姿態估計算法RMPE-tiny。該算法首先結合Ghost模塊輕量化重構特征提取網絡,壓縮模型體積;其次融合自適應特征感知模塊Sa-ECA,在增強檢測精度的同時降低模型復雜度;最后結合Huber Loss損失函數加快模型收斂,進一步提高模型魯棒性。實驗結果表明,本文算法RMPE-tiny的檢測效果優于原算法RMPE,改進后模型的檢測精度可達約72.8%,模型的參數量為17.8 M,模型體積為72.1 MB,檢測速率可達約15.3 FPS,模型的輕量化程度達約57.0%。輕量級人體姿態估計算法RMPE-tiny以更少的參數和計算成本達到了更優的檢測效果,有效改善了人體姿態估計模型在多人復雜場景中的檢測性能,提升了模型的檢測精度與檢測速率,實現了高效的人體姿態估計。