基于通信的協作型多智能體強化學習算法綜述

田 琪,吳 飛

浙江大學計算機科學與技術學院,杭州 310000

0 引言

令智能體擁有類似人類的行為決策能力一直是人工智能研究人員追求的終極目標之一,近年來深度強化學習技術的快速發展使得這個目標成為可能,例如2017年5月,基于深度強化學習技術訓練的AlphaGo[1]智能體在中國烏鎮圍棋峰會上擊敗了排名世界第一的世界圍棋冠軍柯潔,這預示著單智能體在特定決策任務上已經擁有超越人類的能力。自從AlphaGo出現后,激發了深度強化學習社區的研究熱潮,其中一個重要的研究方向就是協作型多智能體強化學習[2](Cooperative Multi-Agent Reinforc-ement Learning,CMARL)技術。不同于AlphaGo這種單智能體決策模型,協作型多智能體強化學習旨在為多個智能體訓練其對應的策略模型,從而使得這些智能體能夠合作以完成一個共同的目標任務。

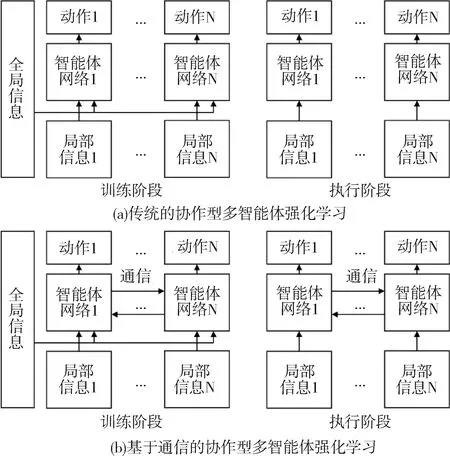

傳統的協作型多智能體強化學習在訓練階段允許訪問環境的全局信息和每個智能體的局部信息,但在執行階段只允許每個智能體根據自身的局部觀測執行下一步的動作,如圖1(a)所示。這顯然不是最優的方式,因為在多智能體環境中每個智能體的決策不僅僅與自身觀測有關,還與其他智能體有關。為了緩解這個問題,如圖1(b)所示,在傳統的協作型多智能體強化學習的基礎上,近期許多研究者指出如果允許多個智能體在訓練和執行期間相互交換信息,那么每個智能體就能更好地執行下一步的動作,這種學習范式被稱為基于通信的多智能體強化學習算法。

圖1 傳統/基于通信的多智能體強化學習訓練/執行階段

本文將針對這種通信類的算法進行綜述。即首先介紹基于通信的協作型多智能體強化學習技術基礎,然后列舉出這個領域中具有代表性的工作,包括傳統的通信算法、受限帶寬下的通信算法,接著說明基于通信的協作型多智能體強化學習技術在航天領域的應用,最后對本文的內容進行總結。

1 通信機制

1.1 問題定義

基于通信的協作型多智能體強化學習由去中心化的部分可觀察馬爾可夫決策過程[3](Decentralized Partially Observable Markov Decision Process,Dec-POMDP)擴展而來,它可以被定義為一個元組〈N,S,A,T,R,O,M,Ω,γ〉,其中N表示智能體的數量、S表示環境的全局狀態空間、A={ai}i=1,2,…,N表示動作集合、T(s′|s,a):S×A→S表示狀態轉移函數、a=[a1,a2,…,aN]表示聯合動作空間、R={ri}i=1,2,…,N:S×A→N表示一組獎勵函數,在某些設置下可以是1個共享獎勵、O={oi}i=1,2,…,N表示所有智能體的局部觀測集合、Ω(s,i):→Oi是決定智能體i局部觀測的觀測函數、γ表示折扣因子、M={mi}i=1,2,…,N表示消息空間,其中mi表示智能體i發送的消息,它通常通過神經網絡編碼局部觀測oi獲得。每個智能體都會收到由其他智能體發送消息m-i=[m1,…,mi-1,mi+1,…,mN]以做出更好的決策,最終的目標是最大化獎勵函數。

1.2 訓練框架

目前基于通信的協作型多智能體強化學習主要使用Q-學習[4]風格的訓練框架和演員家-評論家[5]的訓練框架。Q-學習風格的訓練框架將智能體網絡建模為Q函數Qi(oi,ai,m-i),典型的訓練方法是QMIX[6],該方法的損失函數如下:

(1)

其中:Qtot表示混合網絡,(·)-表示目標網絡,(·)′表示下一個時刻的變量。這種智能體的建模方式主要處理離散動作空間的問題。

演員家-評論家的訓練框架將智能體網絡建模為策略πi(ai|oi,m-i),典型的訓練方法是MAPPO[7],該方法中具有參數θi的每個策略πi的更新策略梯度如下:

(2)

2 深度強化學習算法

基于通信的協作型多智能體強化學習的重點是如何處理智能體之間傳遞的消息。具體來說,對于智能體i,其接收的消息可以被表示為m-i=[m1,…,mi-1,mi+1,…,mN],這些來自其他智能體的消息mj(?j≠i)應該通過怎樣的交流模塊進行聚合是基于通信的協作型多智能體強化學習算法關注的重點,當m-i聚合完成后,代入到式(1)或式(2)的訓練框架中即可完成多智能體系統的訓練。目前已經涌現了許多基于通信的協作型多智能體強化學習算法的文獻,本文將這些文獻分為傳統通信方法和受限帶寬通信方法2類,前者的目的是希望多智能體系統在加入通信模塊后可以最大化提升系統的整體性能,后者是希望通信模塊在增益系統性能的同時盡量占用更少的通信帶寬,從而壓縮冗余的通信消息。下面本文將依次介紹這2類算法。

2.1 傳統通信方法

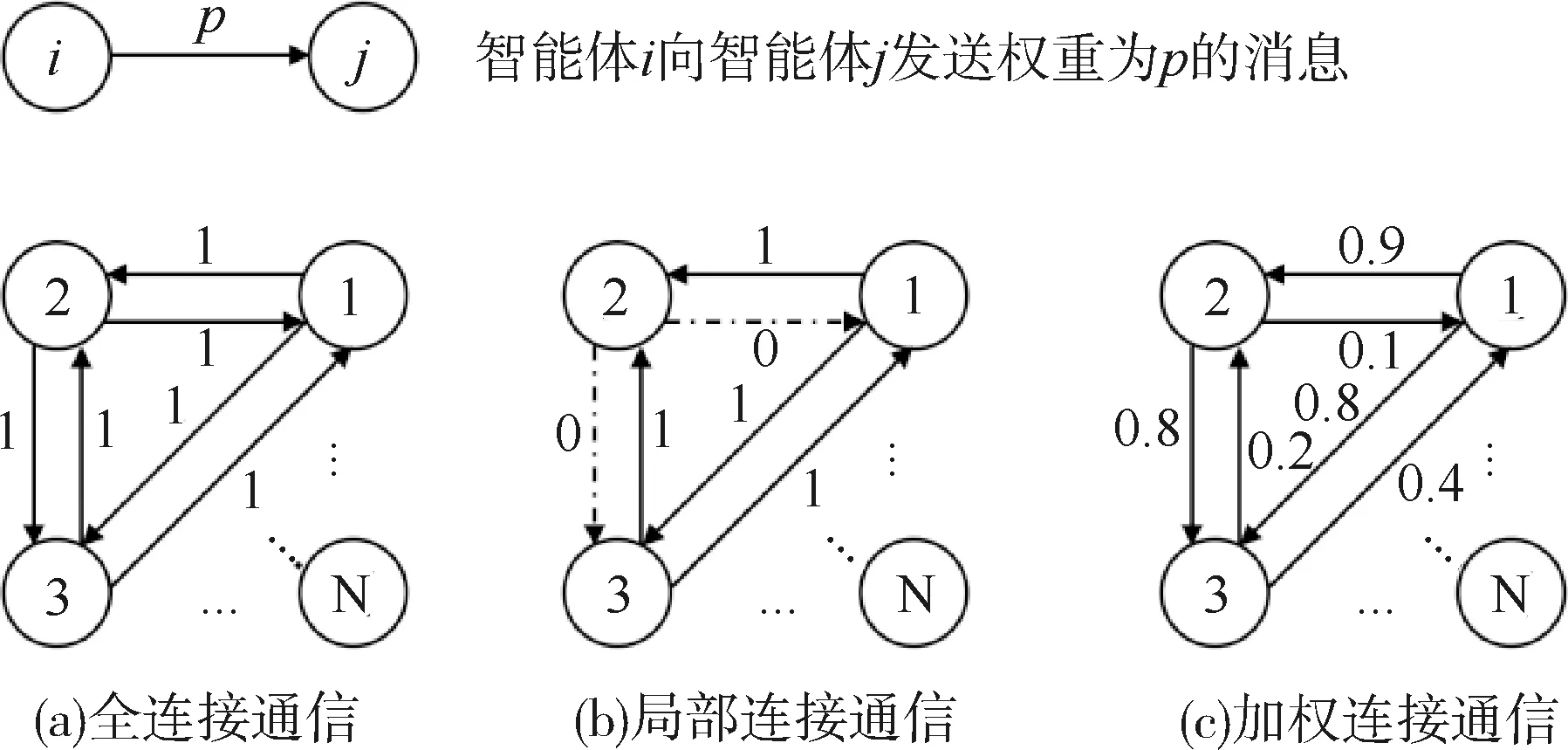

傳統通信方法旨在通過交流模塊幫助多智能體能夠更好地完成一個合作任務,如圖2所示,其可以分為全連接通信、局部連接通信和加權連接通信3種類別。全連接通信是指每個智能體會接收來自其他智能體傳輸的所有消息,如圖2(a)。局部連接通信是指每個智能體只會接收部分智能體傳來的信息,因為并非所有消息都對自身決策有用,過多的冗余消息反而會成為噪聲,對決策產生負面影響,如圖2(b)。加權連接通信是每個智能體按重要性權重采納其他智能體傳來的消息,而不是完全接受或者完全否定,是一種更合理的方式,如圖2(c)。下面介紹這3類傳統通信方法的代表方法。

圖2 傳統通信方法的分類

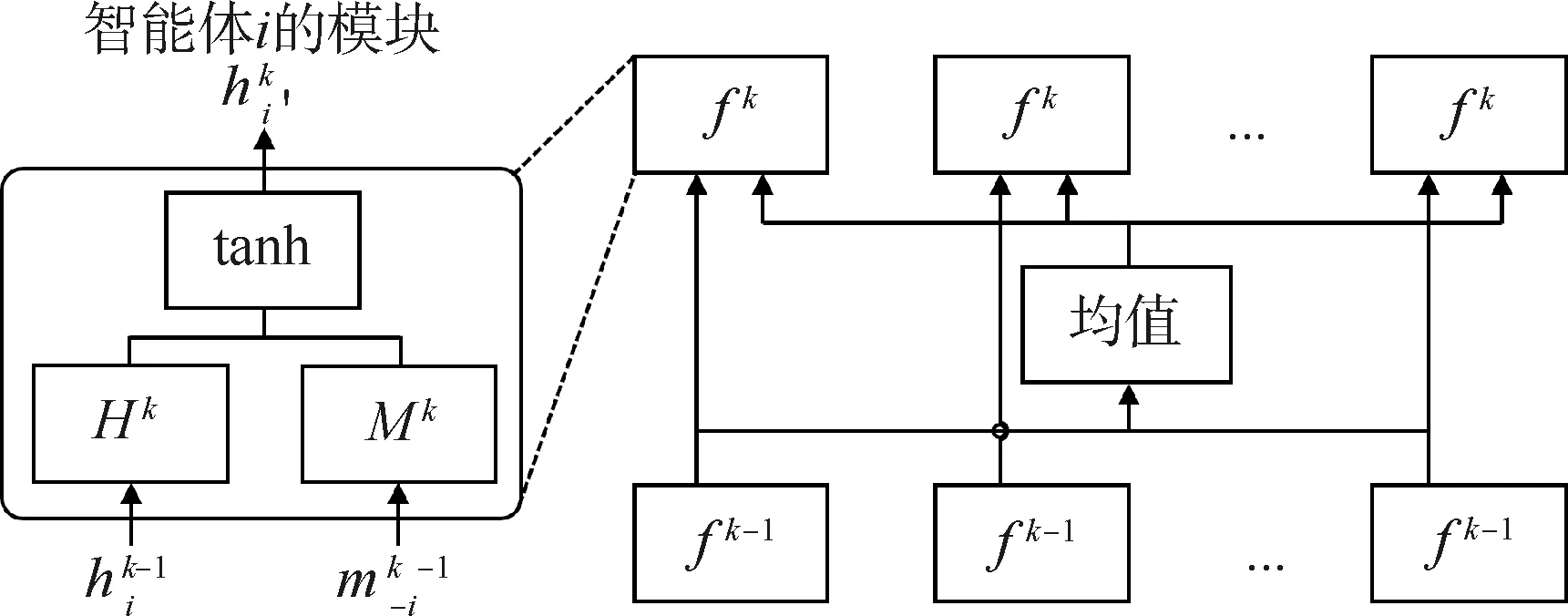

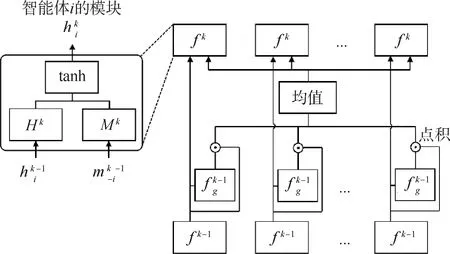

對于全連接通信,CommNet[8]是其典型代表,也是該領域最早的工作之一,后續的許多工作都是基于該方案的改進。

圖3 CommNet的消息聚合機制

(3)

對于局部連接通信,IC3 Net[10]是典型代表。如圖4所示,該方法的總體訓練框架和CommNet非常相似,主要的不同是每個智能體在第k輪交流時都會學習一個神經網絡fgk,該神經網絡將智能體上一層的輸出數據作為輸入,并從0或者1中預測一個值,如果結果為0表示對應智能體的信息不參與聚合,如果結果為1表示對應智能體的信息參與聚合。它就像一個門控開關一樣,因此被稱為基于門機制的神經網絡。

圖4 IC3 Net的消息聚合機制

(4)

表1 傳統通信方法的總結

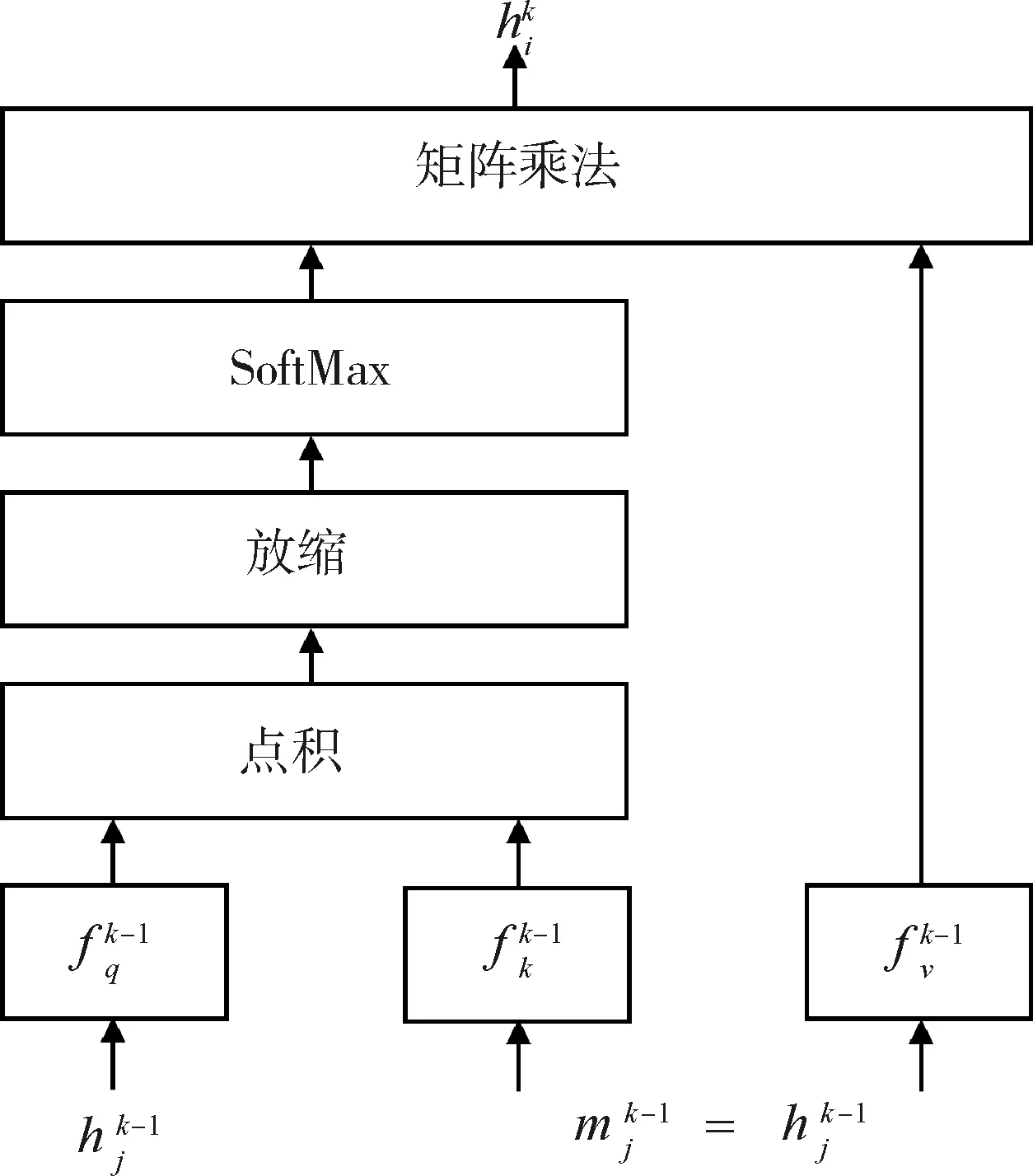

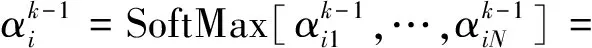

對于加權連接通信,TarMAC[15]是其典型的代表,它主要是將自然語言處理領域中的注意力機制引入到多智能體交流模塊中。

圖5 TarMAC的消息聚合機制

(5)

(6)

(7)

這種基于注意力的方法也啟發了后續一系列工作,如DGN[16],SymbC[17],它們具體的建模方式與TarMAC略有不同。實際上局部連接通信和加權連接通信并不矛盾,一些工作將它們的思想融合,實現了更優的性能,比如G2A[18],MAGIC[19],MAIC[20]。表1簡單總結了傳統通信方法,其中類型A/B/C分別表示全/局部/加權連接通信。

2.2 受限帶寬通信

傳統通信方法不限制通信帶寬,只要對多智能體系統有利的消息都允許進行傳遞,然而在現實場景中如果通信占用太多的帶寬,將消耗大量的資源,因此以受限帶寬下的多智能體交流為主題的研究方向逐漸受到研究者的重視。這一研究領域的關鍵是如何對通信消息進行壓縮,為了將這部分的工作放在一種統一的視角下討論,可以將多智能體交流看作交流圖上的信息流動,其中圖的節點就是每個智能體需要傳遞的消息,圖的邊是信息流動的方向,那么交流圖的信息壓縮可以被分為結構壓縮和節點壓縮。結構壓縮是指每個智能體應該盡可能少地和它們智能體交流,節點壓縮是指當確定兩個智能體需要交流時,傳輸的信息也應該是簡潔的。

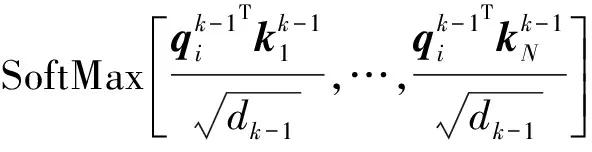

對于結構壓縮類的工作,GACML[21]是典型代表。

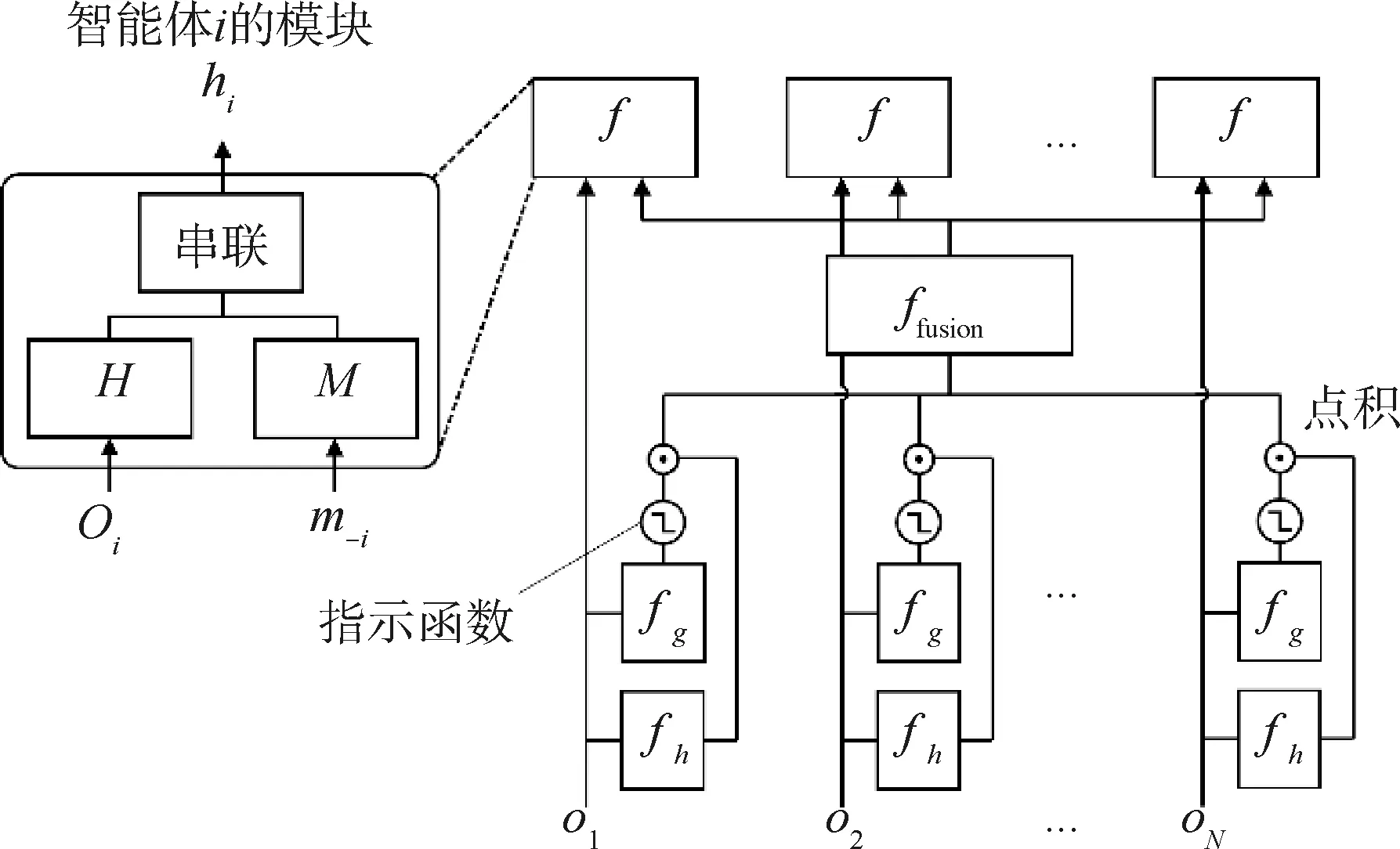

如圖6所示,GACML與圖4中的IC3 Net非常相似,對于智能體i,其輸出hi可以表示為:

圖6 GACML的消息聚合機制

(8)

GACML與IC3 Net主要有如下幾點區別:1) 由于帶寬受限,GACML只考慮單輪通信而不像IC3 Net那樣建模為多輪通信。2) 消除了IC3 Net中f函數的tanh激活單元。3) 消息融合方式從IC3 Net中簡單求均值變為一個融合網絡ffusion。4) 門控單元函數的學習不再是與智能體策略網絡聯合訓練,而是建模為二分類的監督學習,其標簽可以表示為:

(9)

(10)

對于節點壓縮類的工作,IMAC[24]是典型代表。它的主要思想是利用信息瓶頸理論[25]構建如下有約束的優化問題:

LMARLs.t.MI(oi;mi)≤Ic

(11)

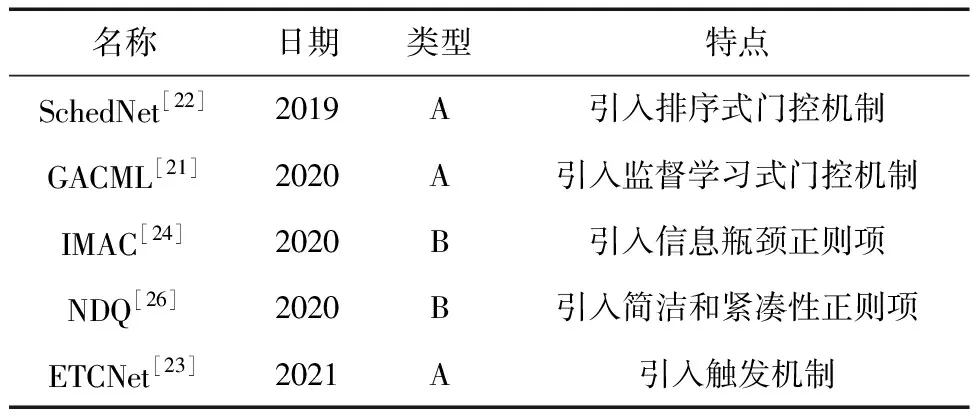

其中:優化目標是原始的多智能體強化學習損失函數LMARL,它可以被實例化為式(1)或式(2)、MI(·;·)表示互信息、Ic表示約束的信息項、s.t.表示在優化過程中局部觀測oi和消息表征mi的互信息應該限制到信息量Ic以下。從總體上看,該式子的含義是希望消息表征mi在滿足多智能體任務的前提下,盡可能地壓縮消息表征mi的信息量,從而減少消息對帶寬的占用。為了求解這個問題,需要用拉格朗日方程將這個帶約束的優化問題轉換為無約束優化問題,然而即使進行了這樣的轉換,損失函數中的互信息項依然難以優化,因此研究者通過變分推理獲得了互信息項的變分上界,使整個損失可以實現端到端的優化。后續提出的NDQ[26]借鑒了上述思想,并設計了2個互信息項以同時約束消息表征的簡潔性和緊湊性。表2簡單總結了所有受限帶寬的通信方法,其中類型A/B分別屬于結構壓縮/節點壓縮類型的文獻。

表2 受限帶寬通信方法的總結

3 在航天領域的應用

基于通信的多智能體強化學習在合作型的衛星群控制領域擁有廣闊的應用前景,比如美國太空探索技術公司SpaceX近期提出了一種名為“星鏈”的項目,該項目計劃2019~2024年間在太空搭建由約1.2萬顆衛星組成的“星鏈”網絡提供互聯網服務,其中1584顆將部署在地球上空550 km處的近地軌道,并從2020年開始工作。在這個場景下,每個“星鏈”衛星可以看作為一個智能體,為了使衛星群盡可能多地有效覆蓋地球表面,需要精密控制衛星群的行動軌跡;另一方面,避免不同衛星間的碰撞也是非常重要的環節,而交流機制可以很好地使每個智能體理解其他智能體下一步可能的動作,從而優化多個衛星的群體運行軌跡。

4 結論

首先介紹了基于通信的協作型多智能體強化學習與傳統協作型多智能體深度強化學習的區別,然后詳細說明了多智能體強化學習中的通信機制,接著對常見的基于通信的協作型多智能體深度強化學習算法進行了分類和介紹,指出這類算法在航天領域的應用前景,最后對文章進行總結。