基于軟閾值函數的深度學習磁信號去噪算法

李 楊,田 斌,楊 超

(武漢工程大學電氣信息學院,湖北 武漢 430205)

0 引言

磁信號傳感器已經被廣泛應用到航空航天、交通運輸、工業生產等領域中[1]。磁信號自身信號微弱且易受外界干擾的影響,導致傳感器測量的信號信噪比低且噪聲呈非線性與非高斯性。實測磁信號的該特性對后續信號的處理造成負面的影響,甚至進一步可能導致檢測與測量任務的失敗[2]。因此,高效的實測磁信號去噪算法成為現今磁信號檢測與測量技術研究中的熱點問題[2]。

當前常用的信號去噪算法可分為傳統信號去噪算法和基于深度學習的信號去噪方法兩類。文獻[3]提出了一種將高斯尺度小波變換混合模型和貝葉斯估計相結合的分數階小波域模型來處理實測地震信號,實驗結果表明該方法可以有效地抑制地震信號中的隨機噪聲。文獻[4]針對傳統經驗模態分解方法會產生目標信息失真這一問題,提出了一種改進經驗模態分解方法來解決這個問題,改進后的經驗模態分解方法取得了良好的效果。文獻[5]分析了復雜的噪聲結構和微弱信號特征,提出了一種模型約束下的在線字典學習去噪方法,該方法可以在高噪聲背景下有效地提取出微弱信號。上述方法雖然都取得了良好的實驗結果,但是存在泛用性差和需要人工設置的參數量多的問題,這些參數的質量會影響最終算法的效果,且對于不同的數據類型最優參數都不同。

因深度學習算法的發展,自適應去噪算法研究成為當前此類研究的熱點。如文獻[6]提出了模糊C均值深度信念網絡FCMDBN模型結構,使用該模型處理心電信號發現該模型具有較高的適應性。文獻[7]使用長短時記憶(long short-term memory, LSTM)神經網絡來處理地電場數據,可以有效地處理地電場數據。文獻[8]提出了一種將遞增卷積和遞減卷積相結合的神經網絡模型,利用該模型對含有高噪聲的信號進行去噪,發現該模型可以有效地去除噪聲,并獲得更高的峰值信噪比和結構相似度。文獻[9]提出了一種基于雙向LSTM神經網絡來抑制信號中的噪聲,在非平穩噪聲環境中,該算法可以獲得較好的特征提取效果。

上述方法雖然都在信號去噪領域中取得了成功,但是這些方法都使用了ReLU[10]激活函數,ReLU激活函數會將特征圖中小于0的部分全部濾除。磁信號傳感器探測到的信號是矢量,具有方向信息,使用ReLU激活函數就會導致特征丟失,得到的去噪信號信噪比低。在某些無法得知信號中噪聲分布的情況下,使用傳統信號處理算法,就需要對探測環境進行仿真,來得到純凈信號的理論值,而實際探測到的信號值往往與理論值不一致,因此在這種情況下人工設置的參數也不一定能得到正確的純凈信號。為解決上述問題,提出一種可用于磁信號去噪的激活函數APSTF。

1 理論知識

1.1 傳統軟閾值函數

軟閾值函數是信號去噪算法的重要組成部分[11-12],該函數能提高均方誤差信號的收斂速度,解決含已知分布噪聲的信號去噪問題。然而,在含分布未知噪聲的情況下,則需要模擬不含噪聲的理想信號為去噪算法提供參考。此類方法費時費力且效果不佳。深度學習提供了一個新的方法可以較好地解決此問題,神經網絡可以通過梯度下降算法來自動學習如何選取合適的閾值。由于軟閾值函數可以和神經網絡結構融合,形成APSTF,該函數可以抑制數據中的噪聲,并將數據中的有用信息提取出來,重建高質量的特征。軟閾值函數的定義如下:

(1)

式(1)中,x是輸入特征圖,y是輸出特征圖,τ是閾值。利用軟閾值函數來替代ReLU作為神經網絡的激活函數,可以保證磁信號特征不會丟失,并可以有效地對其進行去噪處理。由式(1)可知,軟閾值函數的導數不是0就是1,這可以有效地防止梯度消失,和ReLU具有類似的功能。

1.2 深度學習相關知識

卷積層是神經網絡中不可或缺的一部分,與全連接層不同的是卷積層需要訓練的參數量更少,可以有效地避免過擬合。卷積操作是卷積核與輸入特征圖的逐點相乘之和,再加上一個偏置項,其表達式為

(2)

式(2)中,xi是第i個通道的輸入特征圖,yj是第j個通道的輸出特征圖,k是卷積核,b是偏置項,Mj是通道數的集合。

ReLU激活函數被廣泛使用,因為它可以有效地防止梯度消失。ReLU激活函數的導數不是0就是1,當在層與層之間傳播時,這種特性使特征圖的數值范圍不被改變,使得神經網絡模型易于訓練。ReLU激活函數公式為

y=max(0,x)。

(3)

全局平均池化(global average pooling, GAP)是一種將每個通道特征圖變為一個平均值的操作。GAP可以減少輸出層的參數,避免模型遇到過擬合問題。

MSE損失函數被廣泛應用在回歸問題中,其數學表達式為

(4)

式(4)中,n代表輸入數據的長度,i代表當前數據的索引。

2 基于APSTF的深度學習去噪算法

2.1 自適應參數軟閾值函數及其實現

對噪聲和傳統信號處理算法進行研究,發現大部分噪聲都是近0的,且軟閾值函數作為傳統信號處理算法的核心可以有效地對信號進行去噪。受此啟發,本文提出了一種可用于磁信號去噪的激活函數APSTF。

在傳統的信號處理算法中,人工設置合適的閾值是沒有通適性方法的。為了解決這個問題,本文將ECA模塊和軟閾值函數進行了結合,形成了APSTF。

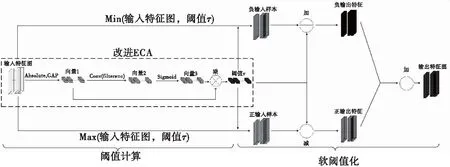

本文實驗將APSTF作為激活函數,插入到神經網絡框架中,閾值不需要人工設置,神經網絡會根據不同的輸入數據,自動地設置不同的閾值,達到最優的特征提取效果。APSTF網絡結構如圖1所示。

圖1 APSTF網絡結構

本文使用的改進ECA模塊和原始ECA模塊不同的是原始ECA模塊將輸入特征圖和經過Sigmoid激活函數的輸出進行元素級乘法來得到輸出特征圖,而APSTF中的改進ECA模塊令卷積的輸出和經過Sigmoid激活函數的輸出進行元素級乘法來得到軟閾值τ。在改進ECA模塊中,GAP將輸入特征壓縮為全是正數的一維向量,然后將一維向量送入卷積層去獲得一組放縮系數,在卷積層后面使用Sigmoid激活函數,將卷積層得到的結果壓縮到0到1之間,確保這組放縮系數不會太大,若放縮系數過大,會使得最后得到的閾值τ過大,這樣就會將特征圖中所有特征過濾掉,但是噪聲通常是近0的,因此需要使用Sigmoid激活函數來壓縮放縮系數的值,使得閾值τ處于合理的范圍之內。Sigmoid激活函數的數學表達式為

(5)

式(5)中,z是卷積層輸出的特征,α是對應于特征圖中每個通道的放縮系數。在得到放縮系數α后,α乘平均值|x|來得到閾值。閾值τ的數學表達式為

τ=α×average|xi,j,c|,

(6)

式(6)中,i是特征圖x的行索引,j是特征圖x的列索引,c是特征圖的通道索引。通過式(6)可知,閾值τ處于一個合適的大小,不會將特征圖中所有的信息都置為0。在得到閾值后,將輸入特征圖分為正樣本特征圖和負樣本特征圖,正樣本特征圖是輸入特征圖中大于閾值τ的部分,負樣本特征圖是輸入特征圖中小于閾值-τ的部分,它們的數學表達式為

ypos=max(x,τ),

(7)

yneg=min(x,-τ),

(8)

式中,ypos是正樣本特征圖,yneg是負樣本特征圖。在得到正、負樣本特征圖后,讓正樣本減去閾值τ負樣本加上τ,它們的數學表達式為

y1=ypos-τ,

(9)

y2=yneg+τ,

(10)

式中,y1和y2分別是正樣本特征圖和負樣本特征圖經過軟閾值化后的輸出。得到處理后的正負樣本特征圖后,將這兩個樣本特征圖進行數值相加,就可以得到最終的輸出特征圖,數學表達式為

y=y1+y2,

(11)

式(11)中,y是最終的輸出特征圖。以上過程就是特征圖被軟閾值化的整個過程。

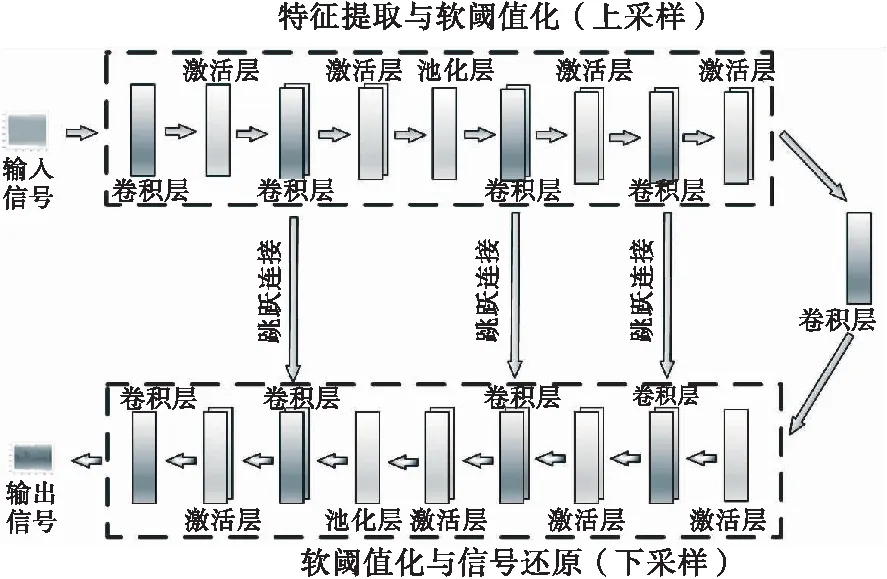

2.2 深度學習去噪算法

圖2為本文使用的U-Net網絡結構。U-Net有編碼(下采樣)和解碼(上采樣)兩個過程,初始輸入為1×1 024的一維信號,在編碼過程中使用1×3大小的卷積核,使用了1×2大小卷積核的最大池化層對輸入信號進行降維解碼處理。在每一個卷積層后都使用APSTF作為激活函數。在解碼過程中,使用上采樣操作對輸入特征圖進行解碼處理。網絡接收到的特征圖經過上采樣層后將特征圖的尺寸大小翻倍,同時與編碼過程中輸出的特征圖進行合并,最終在網絡結構的最后一層解碼出處理過后的一維信號,大小仍為1×1 024。使用的U-Net與原始U-Net網絡結構總體一致,只是使用的激活函數不同。

圖2 U-Net網絡結構

3 實驗及結果分析

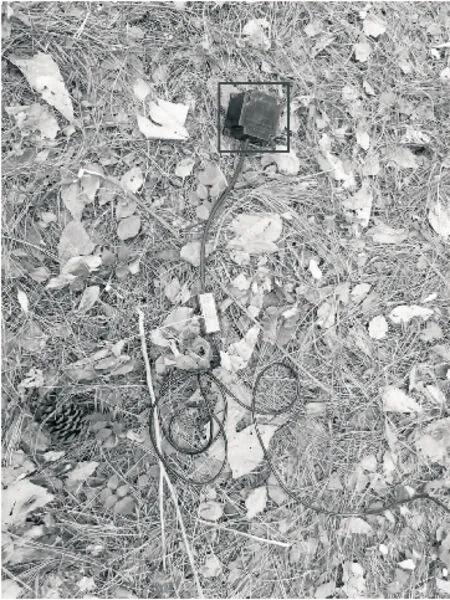

3.1 數據集建立及超參數選取

圖3所示的是實驗使用的三軸感應式傳感器,傳感器探頭被黑框標出。由于該傳感器具有硬件濾波電路,探測值近似于純凈信號,因此直接將其作為神經網絡的訓練標簽數據,對探測數據加入不同程度的高斯白噪聲(-5~5 dB)作為神經網絡的訓練數據。

圖3 磁數據采集系統

本文實驗選用U-Net神經網絡作為基礎網絡,網絡內部參數與原始U-Net保持一致,在訓練模型時,采用了10折交叉驗證法,該方法是將訓練數據集平均劃分為10份,其中9份用于訓練,1份用于驗證,每訓練完成1個epoch后,都會更新驗證集中的數據。

在訓練模型最初的40個epoch中,初始學習率為10-3,在隨后的40個epoch中,學習率為10-4,在最后的20個epoch中,學習率為10-5,這么做的目的是為了讓模型在訓練的后期可以找到最優參數。

為了防止神經網絡在訓練過程中出現過擬合現象,在網絡結構中加入了L2正則化參數、早停技術和學習率自降低技術。L2參數可以將神經網絡中的權重值壓縮到近0值,降低神經網絡中參數的變化幅度。本文實驗將L2參數設置為10-5;學習率自降低技術是當模型在訓練幾個回合后,模型性能基本不變,這時就降低學習率來讓模型進一步學習;早停技術是當模型在訓練幾個回合后,性能基本不變,就停止模型進一步訓練。在本文實驗中,設置了連續3個訓練回合loss不下降就讓學習率降低0.1,如從0.1自動更改為0.01,連續訓練10輪數據,loss不下降就讓模型早停,防止模型的訓練不充分和過擬合。

3.2 實驗結果分析

建立了訓練數據信噪比從-5~5 dB的10個訓練數據集和與之對應的測試集。實驗首先用訓練數據信噪比為-5 dB的數據集訓練神經網絡,然后在與之對應的測試集上驗證了APSTF的有效性,最后將10個訓練數據集做成一個綜合數據集,利用綜合訓練集訓練神經網絡,在綜合測試集上進一步驗證了APSTF的有效性。原始數據和加噪后的數據見圖4。

圖4 純凈信號和噪聲信號

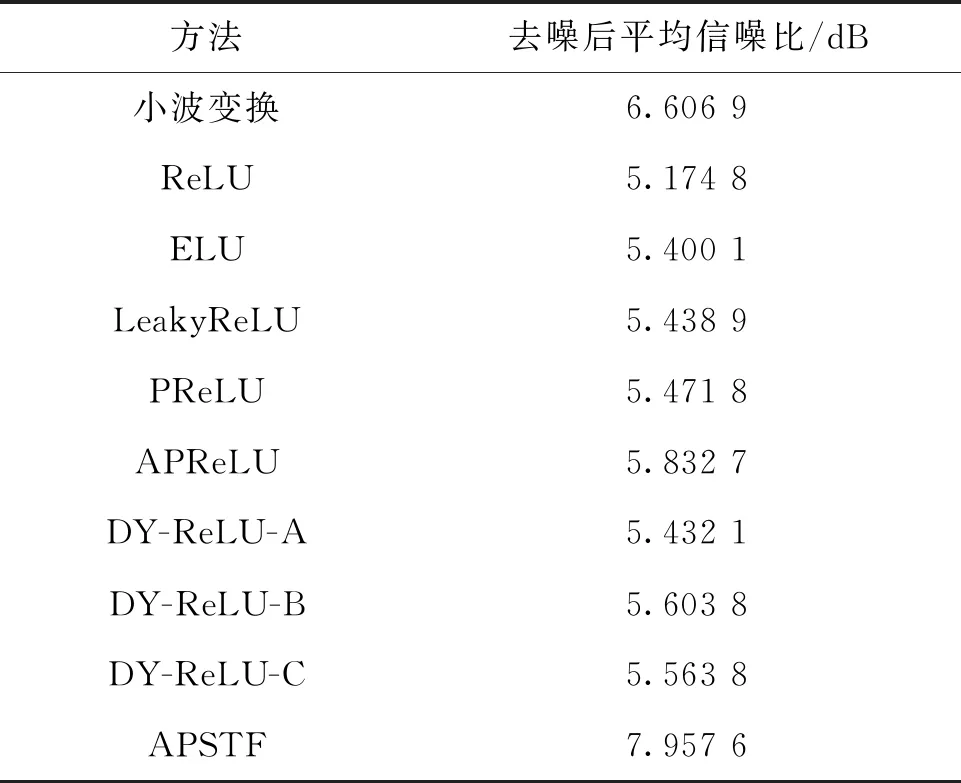

本文實驗首先用信噪比為-5 dB的訓練集作為神經網絡的訓練數據,且用與之對應的驗證集分別驗證了ReLU[10]、ELU[13]、LeakyReLU[14]、PReLU[15]、APReLU[16]、DY-ReLU-A、DY-ReLU-B、DY-ReLU-C[17]和APSTF的性能,具體性能指標如表1所示。

表1 訓練數據信噪比為-5 dB時不同激活函數的性能

由表1可知,使用了APSTF的U-Net去噪效果最好,去噪后信號的平均信噪比比其他方法分別高了2.654 7、2.532 5、2.529 4、2.4、1.985 7、2.500 9、2.353 1、2.455 2 dB;訓練誤差分別低了0.047、0.020、0.029、0.022、0.026、0.033、0.025、0.036;GPU延遲分別高了25、124、117、121、22、128、123、95 ms;參數量分別多了2.88倍、2.88倍、2.88倍、1.96倍、2.51倍、2.62倍、1.94倍、1.94倍。其中GPU延遲指的是神經網絡在訓練和預測時,處理一批數據使用的時間。

為了說明本文方法的有效性,使用一組信噪比為-5 dB的信號分別輸入到APSTF和ReLU中,將這兩個神經網絡倒數第二層的第一個通道得到的特征進行可視化,輸出特征圖如圖5所示。

圖5 APSTF和ReLU輸出特征圖

由圖5細節圖可知,使用了ReLU的U-Net得到的輸出特征會將小于0的部分都置為0,只保留大于0的特征,使用了APSTF的U-Net不僅可以保留負值特征,還會將噪聲從信號中剔除出去,提取到的特征值與純凈信號值非常接近,這也為最后一層卷積還原純凈信號提供了堅實的基礎。

為了進一步驗證本文方法的有效性,用綜合訓練集作為神經網絡的訓練數據,在綜合測試集上分別驗證了小波變換、ReLU、ELU、LeakyReLU、PReLU、APReLU、DY-ReLU-A、DY-ReLU-B、DY-ReLU-C和APSTF的性能,具體性能指標如表2所示。

表2 不同方法在綜合測試集上的性能

小波變換是信號處理中常用的算法,該算法可以達到較好的去噪效果,因此本文將小波去噪算法得到的結果作為基線。由表2可知,除了本文提出的APSTF,其他方法得到的結果均比基線低,進一步驗證了APSTF的有效性。

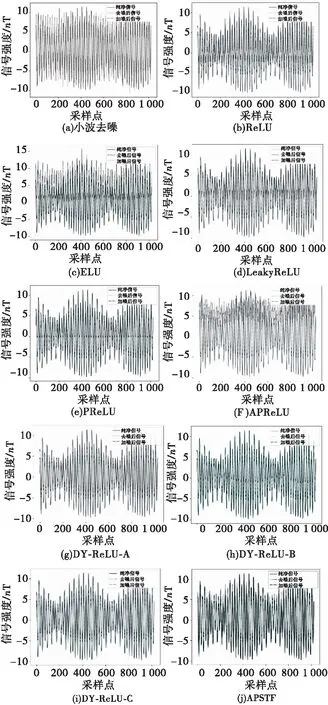

使用不同的方法對同一組信號進行去噪,得到去噪后的結果見圖6。

圖6 不同方法輸出信號圖

由圖6(a)可知,由小波去噪算法得到的還原信號的大部分值都在純凈信號和噪聲信號之間,這說明了去噪算法的有效性,但是少部分值要高于純凈信號,這部分值沒有還原得很好,造成了一些還原信號信噪比的損失。圖6(b)、(d)和(e)得到的還原信號較為相似,還原信號大于0部分的值幾乎都在純凈信號和含噪信號之間,去噪效果良好,但是ReLU和LeakyReLU基本把負值特征全部過濾掉了,因此在負值信號上的還原很差,造成了還原信號信噪比的損失,若將LeakyReLU中的α參數增大,可能會將噪聲包含進來,造成信噪比的損失。圖6(c)得到的還原信號是比較差的,它將負值特征全部過濾掉,且在正值信號的還原上也比純凈信號的值高,這說明它過度地還原信號,反而為還原信號中加入了一些噪聲。圖6(f)在這組信號的還原上是最差的,為信號加入了很多噪聲,導致去噪后信號的值要遠高于純凈信號值。圖6(g)得到的還原信號值在大于0部分的值都處于純凈信號和含噪信號之間,在小于0的部分,雖然有一定的去噪效果,但這仍比小波去噪的效果要差。圖6(h)和(i)得到的還原信號值是比較差的,去噪信號值要小于純凈信號值。而使用了APSTF激活函數的U-Net得到的去噪后信號的值在純凈信號和噪聲信號值之間,且與純凈信號值非常接近,完美地還原了純凈信號。

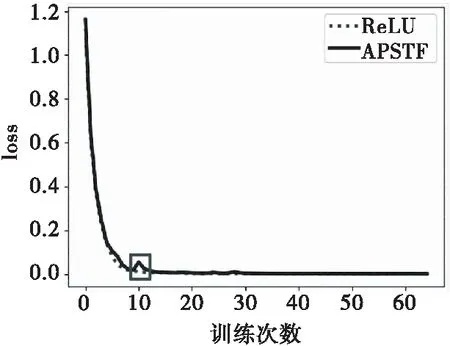

為了說明本文方法的訓練難易程度,將ReLU的訓練過程和本文方法的訓練過程進行對比,訓練時loss對比圖見圖7,驗證時loss對比圖見圖8。

圖7 訓練不同方法時的loss曲線

圖8 驗證不同方法時的loss曲線

由圖7可知,在訓練時,使用ReLU的U-Net訓練了65個回合后停止了訓練,即此時模型已收斂,使用了APSTF的U-Net訓練了66個回合后停止訓練,在第10個回合的訓練時,loss值出現了跳變,在跳變后loss繼續降低,下降的總體趨勢與ReLU一致。

由圖8可知,在驗證時,使用了APSTF的U-Net在第17訓練回合結束后,在驗證集上的loss出現了跳變,而后驗證集loss持續降低,降低趨勢與ReLU一致。

雖然本文提出的APSTF會使神經網絡的參數量增多,但是通過早停和學習率自降低這兩種輔助訓練技術,可以使神經網絡正常訓練,且獲得較好的性能。

4 結論

本文提出的APSTF可以提升神經網絡在高噪聲特征圖中學習特征的能力,從而達到更好的去噪效果。該方法利用ECA模塊來自動地選取閾值τ,通過梯度下降算法訓練神經網絡,使閾值τ逐漸向最優值收斂。該方法不僅適用于含已知分布噪聲的信號去噪問題,還適用于分布未知噪聲的信號去噪問題,且無需將不含噪聲的理想信號作為參考信號,就可以得到最好的去噪效果。但是該方法仍然存在參數量大、單步訓練時間長的問題。若是將該方法應用在圖像識別任務中,會使模型的參數量成倍增加,這會引發過擬合現象。在未來的研究中,會考慮將深度可分離卷積融入到APSTF中,提出一種輕量級的APSTF方法,并為其設計一個合理的神經網絡模型。