基于混合注意力機制和云數據平臺的蝗蟲識別系統研究

李軍馬行穆春陽王夢雪劉寶成李亞東

(1. 北方民族大學電氣信息工程學院,寧夏銀川 750021;2. 北方民族大學寧夏智能信息與大數據處理重點實驗室,寧夏銀川 750021;3. 北方民族大學機電工程學院,寧夏銀川 750021)

蝗災、旱災、澇災曾并稱為三大自然災害,一直是中國農業防治的重點對象。 但在自然環境下,蝗蟲目標小,同時受光照、遮擋等因素干擾,識別難度大。 因此,在現代農林業領域做到及時且準確的蝗蟲監測意義重大[1]。

近年來,隨著深度學習的發展,神經網絡已經被廣泛應用在害蟲識別領域。 例如張博等[2]將空間金字塔池化和YOLOv3 卷積神經網絡相結合,實現了實際場景下20 類害蟲的識別,且識別精度達到88.07%。 許德剛等[3]提出了一種改進的Faster RCNN 糧蟲目標檢測方法,在自制數據集下實現了89.42%的精確度,為糧食存儲安全提供了蟲害監測新思路。 楊紅云等[4]提出的基于遷移學習和卷積神經網絡相結合的水稻害蟲識別方法,使用VGG16 模型,實現了稻飛虱等5 種水稻害蟲的識別。 甘雨等[5]通過改進EfficientNet模型實現作物害蟲識別,在公開的大規模作物害蟲數據集IP102 上實現了69.45%的識別率。 上述研究成果表明利用神經網絡能夠為害蟲識別提供解決方法。

在蝗蟲識別方面,近些年也取得了一些研究進展。 2017年劉欣[6]提出了基于無人機遙感平臺的蝗蟲災害監測方法,該方法采用無人機遙感技術進行圖像拍攝,然后將圖像回傳處理,對于大面積蟲害識別具有較強的圖像分析能力,但是對于小區域以及林地深處蟲情無法兼顧,而且采用遠端服務器進行圖像處理,延遲高。 2020年張文霞[7]利用基于二值圖像的區域性識別算法和快速卷積神經網絡Faster RCNN 對蝗蟲圖像進行檢測與識別,結果表明,在自制數據集下,模型的平均識別精度達到84%;但是在光線環境較弱和背景復雜的情況下,模型的特征提取能力會明顯下降。 2021年李林等[8]以SSD 模型為基礎,提出了一種K-SSD-F 蝗蟲視頻目標檢測算法,通過采用KNN 算法提取蝗蟲視頻前后幀的時空特征來分析目標,平均精度達到88.94%,但該模型只針對東亞飛蝗,對于國內出現范圍較廣的中華稻蝗等蝗蟲類未做研究,同時該方法未解決蝗蟲識別過程中的實時蟲情數據留存問題。

針對以上問題,本研究以飛蝗、稻蝗、竹蝗、沙蝗等農林業蝗蟲為研究對象,結合當下嵌入式設備的發展情況,以輕量化的一階段卷積神經網絡YOLOv4-tiny 為基礎,提出了一種基于混合注意力機制CBAM[9]、七牛云數據平臺的蝗蟲目標識別模型,然后利用Jetson Xavier NX 開發板的推理加速能力,將改進后的模型移植到開發板中,設計了一套小型蝗蟲識別系統。

1 材料與方法

1.1 數據來源

數據集獲取時充分考慮國內蝗蟲蟲情,選取對農林業危害較大、出現頻率高、繁殖率高的飛蝗、稻蝗、竹蝗、沙蝗等,其中飛蝗主要是東亞飛蝗和亞洲飛蝗,稻蝗為中華稻蝗。 圖像獲取途徑一是通過多時期、多角度、自然環境下的周邊果園、農田實地相機采集;二是通過網絡搜索獲取相關蝗蟲圖片。 數據集像素從564×348 到4032×3024不等,共2 344 張圖片。 數據集示例圖片如圖1所示。

1.2 圖像標注與增強

對獲取到的蝗蟲數據集,采用labelImg 軟件手動標簽的方式進行圖像標注。 同時,為了增強模型的泛化能力,通過對原蝗蟲圖片進行亮度調整、鏡像翻轉、平面旋轉、添加高斯噪聲等一些常規預處理來擴充數據集,最終得到25 860 張蝗蟲圖像。 數據集圖像增強處理如圖2 所示。

圖2 數據集圖像增強處理示例

1.3 模型選擇

在深度學習領域,目標檢測算法有單階段和雙階段之分,雙階段算法模型大、精度高,但速度慢,例如R-CNN[10]、Fast R-CNN[11]、Faster RCNN[12];而一階段算法巧妙地將目標檢測問題轉化為了回歸問題,可以直接完成端到端的預測,精度高、速度快,SSD[13]、YOLO[14]便是一階段算法的優秀代表[15]。

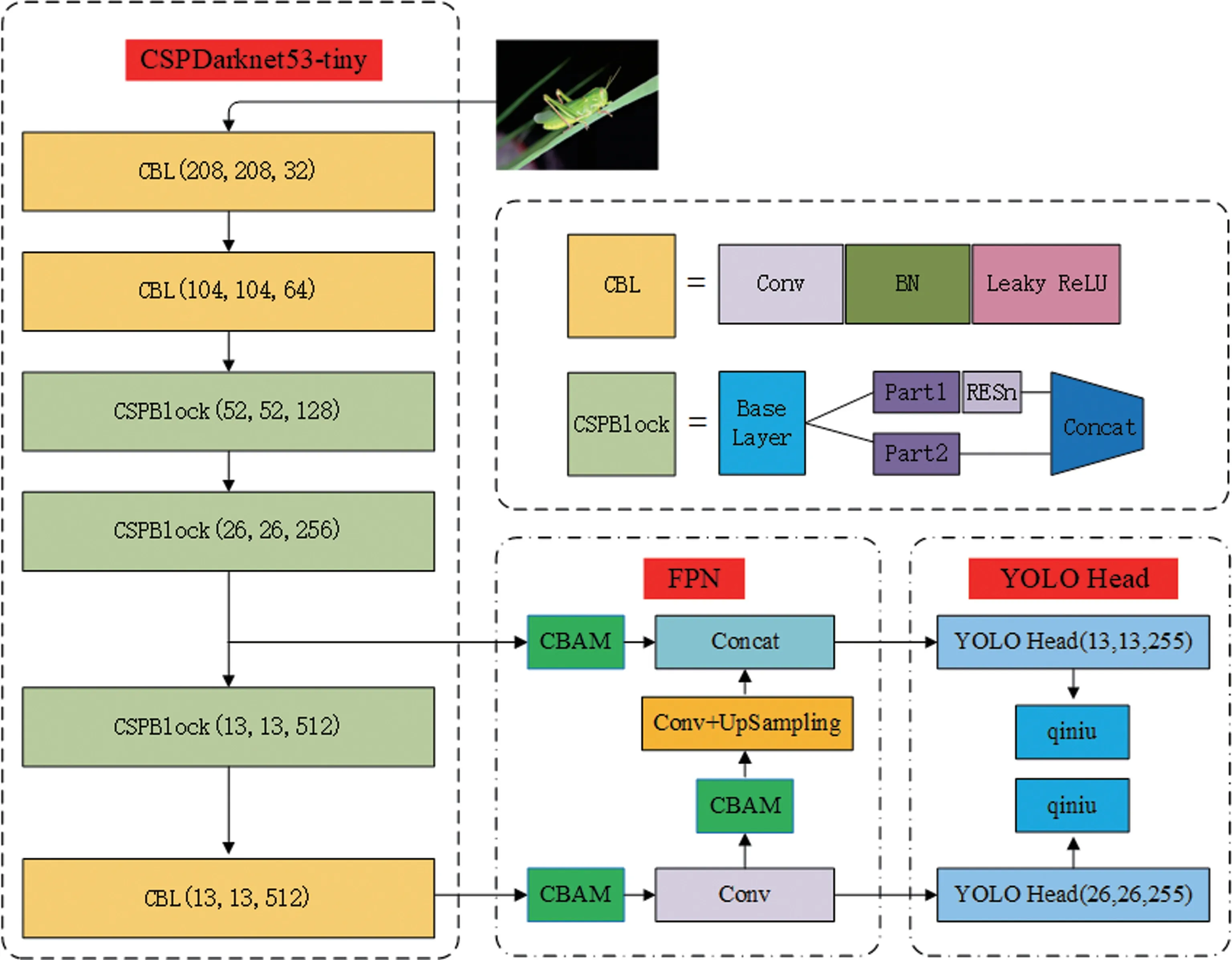

隨著嵌入式設備的發展,越來越多的場景開始將神經網絡部署到移動端,以此來提升工作效率。 在這種情況下,兼顧精度與速度的輕量級神經網絡不斷被提出。 2020年6月25日,Alexey Bochkovskiy 在發布YOLOv4 兩個月后,正式推出YOLOv4-tiny[16]。 YOLOv4-tiny 作為YOLOv4 的輕量化版本,在盡可能保障模型精度的前提下做了參數刪減。 YOLOv4-tiny 網絡主要由3 部分構成,分別是主干特征提取網絡CSPDarknet53-tiny、加強特征提取網絡(feature pyramid network,FPN)和檢測頭YOLO Head。 CSPDarknet53-tiny主要用于前期特征提取,包括卷積層(Conv)、批量標準化層(BN)、激活函數層(Leaky ReLU)和3個CSPBlock 模塊。 網絡首先對輸入進來的圖像(416×416 像素)進行兩次步長為2 的卷積操作,經過CSPDarknet53-tiny 主干特征提取網絡后,一共可以獲得13×13 和26×26 的兩個有效特征層;FPN 結構將主干網絡得到的有效特征層進行卷積加上采樣操作來進行特征融合,獲得兩個具有更高語義信息的有效特征層;之后YOLO Head 對這兩個具有更高級語義信息的特征層進行結果預測,形成13×13 和26×26 的兩個目標預測尺度,最終得到蝗蟲目標的置信度及位置信息。

1.4 模型改進

1.4.1 增加注意力機制在自然環境下,蝗蟲目標大小不一,出現的背景也較復雜,并有大量物體遮擋,在這種情況下神經網絡對每張圖片的關注點就會分散。 為了提升模型的細節特征提取能力,加強神經網絡在不同背景下對檢測目標的重視程度,使神經網絡將更多注意力放到所給信息的重點區域,同時兼顧模型的速度,本研究分別在YOLOv4-tiny 的加強特征提取網絡輸入位置和第一次卷積結果輸出位置添加混合注意力機制CBAM,讓神經網絡在通道和空間上分別獲取更多的特征信息,有效提升模型在復雜背景下的識別精度[17]。 改進方式如圖3 所示。

圖3 改進的YOLOv4-tiny 網絡結構

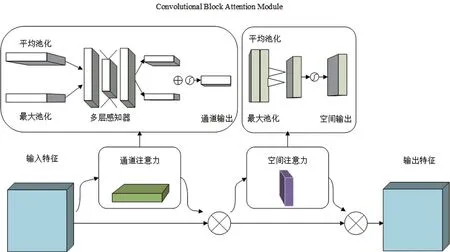

CBAM 是一種混合注意力機制,包括通道注意力機制和空間注意力機制。 首先通道注意力機制利用平均池化和最大池化對輸入進來的有效特征層進行特征信息聚合操作,并送到共享網絡,之后再壓縮輸入特征圖的空間維數,逐元素求和并合并,最后經過Sigmoid 激活函數后生成通道注意力特征圖;然后空間注意力模塊利用平均池化和最大池化對通道特征圖進行高和寬的壓縮,再進行Concat 操作,之后經過7×7 的卷積操作將特征圖維度降為1,最后經過Sigmoid 激活函數后生成空間注意力特征圖。 通過CBAM 模塊,神經網絡不僅提升了在復雜背景下對重點區域的關注,也加強了對有效色素點的關注。 CBAM 注意力機制模塊結構如圖4 所示。 CBAM 注意力機制的公式如下:

圖4 CBAM 注意力機制結構

式中:MC(F )代表通道注意力機制操作;Ms(F )代表空間注意力機制操作;σ 表示Sigmoid 激活函數;F 表示輸入特征圖;F1表示經過通道注意力機制后的輸出特征圖;f7×7表示7×7 的卷積操作[18]。

1.4.2 嵌入云數據平臺蝗蟲害的治理需要前期就掌握蟲情數據,但已有的大多研究只是對模型進行各種改進以提升模型精度,并未對模型實際應用過程中的數據問題進行引申研究或者提出解決方案。 針對該問題,本研究以七牛云數據平臺為基礎,通過對YOLOv4-tiny 預測模塊進行修改,在模型的YOLO Head 部分嵌入七牛云數據平臺軟件包,使模型能夠在實時目標檢測中實現蟲情數據的即時云端上傳,并通過個人注冊的合法域名,實現蝗蟲蟲情的實時數據留存與下載解析,這可為農林業及時監測或治理蟲害提供數據支撐。 基于七牛云數據平臺改進的蝗蟲識別模型結構如圖3 所示,七牛云服務器用戶界面如圖5 所示。

圖5 七牛云服務器平臺界面

1.5 模型訓練

將25 860 張蝗蟲圖像按照9∶1 的比例劃分為訓練集與測試集,使用PyTorch 框架搭建模型,利用實驗室戴爾服務器進行模型訓練。 服務器主要配置為:Inter(R) Xeon(R) Gold 6246 CPU @3.30 GHz 12 核24 線程(雙處理器),190 GB RAM;Tesla P40 GPU,96 GB 內存。 軟件操作系統為Ubuntu18.04,CUDA 版本為10.0,CUDNN 版本7.1,Python 版本3.7,PyTorch 版本1.2。 模型訓練輸入圖像尺寸為416×416,訓練過程使用Adam 優化和更新權重參數。 具體訓練參數如表1 所示。

表1 模型訓練參數

1.6 模型評估

模型訓練完成后在自制數據集下采用精確率(Precision)、平均精度均值(mean average Precision,mAP)、召回率(Recall)、F1 值(F1-score)、每秒幀率(frame per second,FPS)、模型大小(model size)6個指標來評估模型性能。 其中,FPS 越高,代表模型的檢測速度越快[19];F1 值是精確率與召回率的調和平均(harmonic mean),是一個同時考慮精確率與召回率的評價指標[20],F1 值越大且越接近1 代表模型的綜合性能越好。 精確率、召回率、F1 值的計算公式如下:

式中,TP 為正樣本中檢測正確的樣本數目,FP 為負樣本中錯檢為正樣本的數目,FN 為正樣本中漏檢或錯檢為負樣本的樣本數目。

2 結果與分析

2.1 消融試驗結果分析

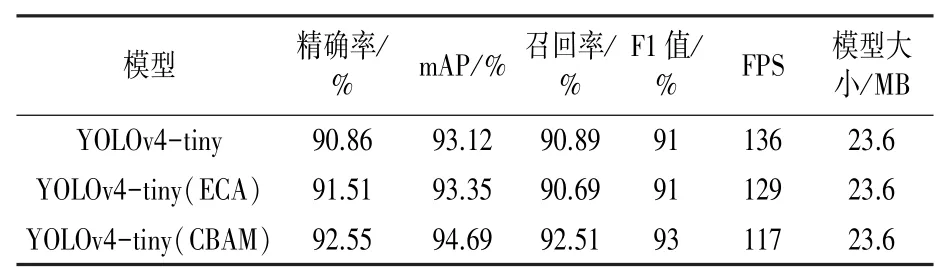

為了驗證改進后的模型性能,首先在自制數據集下設計了消融試驗,結果如表2 所示。 其中YOLOv4-tiny(ECA)表示使用了ECA(efficient channel attention)[21]通道注意力機制,YOLOv4-tiny(CBAM)表示使用了CBAM 混合注意力機制。可知,在使用注意力機制的情況下,模型的綜合性能得到了提升。 在只使用ECA 通道注意力機制的情況下,模型的精確率達到了91.51%,mAP 達到了93.35%。 在使用CBAM 混合注意力機制的情況下,模型的精確率、mAP、召回率、F1 值與原網絡相比均有明顯提升,分別提升1.69、1.57、1.62、2個百分點;同時相較于YOLOv4 -tiny(ECA)性能也有一定提升,模型大小維持不變。說明使用注意力機制能夠有效提升模型的性能,且使用混合注意力機制的效果要優于單一的通道注意力機制。

表2 消融試驗結果

2.2 對比試驗結果分析

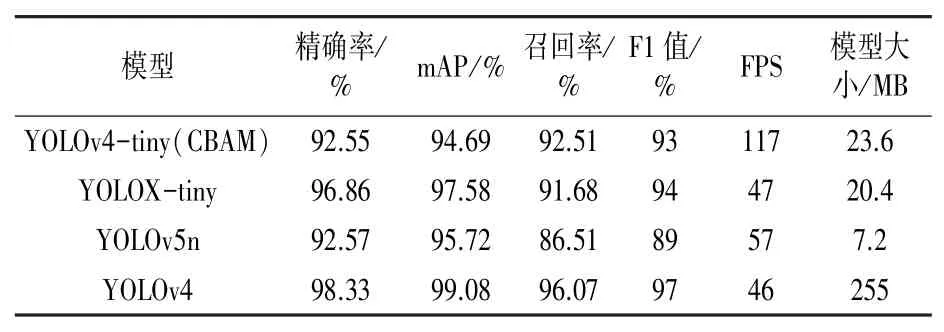

為了更加客觀地評價模型的性能,再次在自制數據集下進行對比試驗,結果如表3 所示。 其中YOLOX-tiny 表示YOLOX 的輕量級網絡,YOLOv5n 表示YOLOv5 的輕量級網絡。 可知,YOLOX-tiny 和YOLOv5n 作為兩種較新的輕量級網絡,模型的mAP 分別達到了97.58%和95.72%,性能優良,但檢測速度分別只有47FPS 和57FPS,相較于YOLOv4-tiny(CBAM)的117FPS 差距明顯。 同時通過與 YOLOv4 網絡對比, 發現YOLOv4-tiny 作為簡化版的YOLOv4,其模型的精度和速度更均衡,考慮到模型后期需要部署到嵌入式設備,所以選擇YOLOv4-tiny(CBAM)是更好的方案。

表3 對比試驗結果

2.3 模型識別效果可視化

最后為了更加全面地評價改進模型的性能,使用不同環境下、不同數量的蝗蟲目標進行識別試驗,識別效果如圖6 所示。 可知,在復雜環境下的單目標識別試驗中,各個模型均能順利識別出目標,說明模型在自制數據集下提取了豐富的特征信息。 在自然環境下的雙目標識別試驗中,所有模型也均能正確識別出目標,但YOLOv4-tiny(CBAM)模型預測框更小,更接近蝗蟲目標的真實體態。 在自然環境下多目標識別試驗中,YOLOv4-tiny 模型出現了漏檢情況,而其他模型均能實現4個目標的識別。 綜上可得,YOLOv4-tiny(CBAM)模型的綜合性能更加均衡,更適合后續的部署應用。

2.4 模型應用與測試

將改進并訓練好的蝗蟲識別模型移植到NVIDIA 的Jetson Xavier NX 開發板中,利用Jetson Xavier NX 開發板作為模型的應用載體,借助TensorRT 加速模型,搭建設計了一種便攜式蝗蟲識別裝置,如圖7 所示。 考慮加入的云數據平臺,采用華為E5576 隨身WIFI 裝置作為數據提供模塊,實現野外環境的數據服務功能。 相機部分采用索尼IMX219 模塊CSI(有效像素800W)和海康U14a 便攜式USB2K 鏡頭(有效像素400W)。

圖7 便攜式蝗蟲識別裝置實物圖

系統工作流程如圖8 所示。 通過CSI 或USB2K 攝像頭獲取圖像信息,利用Jetson Xavier NX 內嵌改進并訓練好的模型進行蝗蟲識別,使用云數據平臺進行蝗蟲目標實時數據云端上傳與存儲,最后通過七牛云賬號在線查看識別結果。數據格式中包括識別時間等信息,方便用戶及時掌握蟲情數據,進行有效防治[22]。

為了測試設計的蝗蟲識別系統的識別效果,進行相關自然環境下的檢測試驗。 首先采用多角度、多體態、不同背景下的靜態蝗蟲目標數據進行識別測試,結果(圖9)顯示,搭建設計的蝗蟲識別系統能夠實現不同狀態下的蟲情識別,具有一定的針對性。 其次,為了驗證模型及識別系統的實時動態識別效果,進行自然環境下模型的目標視頻實時識別測試,實時識別效果及云平臺實時數據分別如圖10 和圖11 所示。 可見,在不同的自然背景下,針對蝗蟲目標數量不一、角度和光線不同等情況,系統均能夠有效識別出目標,且實時檢測速度達到28FPS。 綜上可見,本研究設計的小型蝗蟲識別系統在自然環境下具有較強的蝗蟲識別能力;而嵌入在模型預測模塊中的七牛云數據平臺,實現了即時蟲情識別數據的云端存儲功能,大大提升了模型的可利用性,解決了以往蟲情數據掌握不及時的問題,能夠為現代農林業蝗蟲識別提供新思路。

圖9 靜態目標識別效果

圖10 視頻實時識別效果

圖11 蝗蟲蟲情識別云數據后臺示例圖

3 討論與結論

通過對前人在蝗蟲識別領域研究的分析,本研究提出了一種基于YOLOv4-tiny 網絡改進的蝗蟲目標識別模型,大小為23.6 MB。 首先,該模型使用輕量型的混合注意力機制CBAM 提升模型性能,彌補了過去蝗蟲識別算法精度低、實時性差的缺點,提升了模型在復雜環境下的小目標特征提取能力,模型的平均精度可達到94.69%,召回率達到92.51%,F1 值達到93%,單張圖片識別速度達到117FPS,在嵌入式開發板上的實時檢測速度達到28FPS,模型性能優良。 其次,針對實際應用場景,在模型的預測模塊引入了七牛云數據平臺,借助個人域名,實現了模型對蝗蟲蟲情實時識別的云端數據存儲與解析,提升了模型的應用價值,方便研究者實時掌握蟲情數據。 最后,針對現代農林業蝗蟲監測裝置較大且多是采用氣味或燈光誘捕害蟲的思路,本研究借助高性能的嵌入式設備Jetson Xavier NX 搭載改進的模型,設計了一種小型的蝗蟲識別裝置。 通過試驗驗證,該系統在不同自然背景及光線強度下均取得了非常好的識別效果,具有較強的蝗蟲目標識別能力。 本研究提出的方法可為農林業蝗蟲識別提供新的技術參考。

另外,本研究用提取到的蝗蟲共同特征信息作為研究基礎,自建了一套有25 860 張圖像的蝗蟲數據集。 但本研究未進行分類目標預測,將在今后的研究中繼續完善模型的分類識別功能,以實現蝗蟲目標精細化識別。