嵌入注意力的Gabor CNN快速人臉表情識別方法

南亞會,華慶一,劉繼華

(1.西北大學 信息科學與技術學院,陜西 西安 710127;2.呂梁學院 計算機科學與技術系,山西 呂梁 033001)

0 引言

人臉表情識別(Facial Expression Recognition,FER)是面部相關的研究中較為復雜的任務。通過分析、識別人臉生物特征來反映一個人的情緒狀態,在人機交互、機器智能、醫療、虛擬現實等領域有重要作用。

目前為止學術界、工業界對該問題進行了許多研究。人臉表情識別一直是計算機視覺和人機交互領域的熱點問題,表情識別的目的是基于人臉圖像識別人類的驚訝、悲傷、恐懼等情感狀態,使機器能感知、理解人類情感,從而更好地與人類交流互動。

近幾年,具有強大特征學習能力的深度學習技術得到了迅速發展,已被廣泛應用于面部相關問題研究,例如人臉檢測、人臉識別、表情、年齡和性別識別等。其中,卷積神經網絡(Convolutional Neural Network,CNN)使表情識別準確率得到了大幅提升,但CNN 最大的缺點是忽略了不同特征間的相對位置,無法從圖像中識別姿態、紋理和位置變化。同時,池化操作會丟失部分信息,因此需要更多訓練數據對損失進行補償。此外,CNN 無法學習特征間的關系,傾向于記憶數據而非理解數據,基于CNN 的特征提取僅屬于數據驅動技術。

雖然,CNN 強大的特征學習能力為FER 發展作出了貢獻,但仍有一些問題尚待解決。例如,CNN 需要足夠多的數據來訓練模型,避免模型發生過擬合現象,但現有面部表情數據庫不足以訓練具備深度結構的神經網絡,并且實際場景中夾雜著光照、姿態、遮擋等干擾因素,需要模型具有更好的類內差異能力和有效的表情差異表征。同時,在面部相關問題中需要分辨面部特征的細微差別,例如嘴角、眼角變化幅度、皺紋的深淺等。研究表明,面部情緒的變化與嘴、眼睛、眉毛和鼻子區域等區域密切相關,但普通CNN 無法較好地檢測、定義面部特征位置關系的差異。為了增強CNN 對方向和尺度變化的適應能力,Luan 等[1]使用傳統手工制作的Gabor 小波[2]調制可學習的卷積濾波器,以減少可學習網絡參數數量,增強學習特征對方向和尺度變化的魯棒性。由于Gabor 濾波器和哺乳動物視覺系統中簡單細胞的接受頻譜非常相似,具有檢測紋理、邊緣和方向的能力,且Gabor 濾波器與CNN 低層卷積作用類似,因此在分類任務中準確率較高[3]。

人臉感興趣區域(Region of Interest,ROI)是視覺內容豐富的區域。Gabor 濾波器既能表征人臉的空間頻率結構,又能有效捕獲人臉ROI 特征,因此廣泛應用于FER 任務。Gabor 方向濾波器(Convolutional Gabor orientation Filter,GoF)[1]結合了Gabor 濾波器與傳統卷積濾波器的優點,在捕獲輸出特征圖中的空間定位、方向選擇性、空間頻率選擇性等視覺特性方面優于傳統卷積核,可有效提取人臉ROI 的特征,因此使用GoF 的深度卷積網絡相較于傳統CNN 更適合FER。

綜上,本文提出用于FER 任務的輕量級注意力的Gabor 卷積網絡(Gabor Convolutional Network,GCN)。其中,GoF 為CNN 的基本元素,在卷積濾波器上即可實現,易于集成到任何深度架構中。帶有注意力機制的GoF 卷積神經網絡被稱為AGCN,可學習更健壯的特征表示,對具有空間轉換的圖像優勢明顯。此外,由于GoF 由一組可學習的卷積濾波器組成,因此AGCN 模型更緊湊、易于訓練。分析表明,GoF 在提取面部ROI 特征方面相較于傳統濾波器更有效,因此在研究不同深度(層數)、寬度(卷積層中的單元數)和卷積核尺寸的AGCN 體系結構后,設計了一個最優AGCN 模型。同時,將最優AGCN 模型與CNN 架構的AlexNet[4]、VGGNet[5]、ResNet[6]和CapsNet[7]比較發現,所提模型識別精度較好,參數量、空間資源最少。在FERPlus[8]和RAF-DB[9]數據集上的實驗表明,所提方案優于目前較先進的FER 方法。

1 相關工作

1.1 Gabor濾波器

Gabor 小波使用復函數作為信息理論應用中傅里葉變換的基礎,標準差的乘積在時域和頻域均最小。Gabor 濾波器[10]是一種有效的圖像表示學習特征提取器,可從圖像中提取不變的信息。Gabor 函數基于特定頻率和方向的正弦波,表征圖像的空間頻率信息。二維Gabor 濾波器為正弦波調制的高斯核函數,由虛部和實部組成。實部可描述為:

式中:x'=xcosθ+ysinθ;y'=-xsinθ+ycosθ;λ 表示Gabor 濾波核的實部波長;θ表示Gabor 函數的平行條紋的法線方向,有效值為0°~360°的實數;φ表示相位偏移,有效值為-180°~180°,0°、180°的方程與原點對稱,-90°、90°的方程分別于原點成中心對稱,是兩項直角坐標系中的余弦函數;γ表示空間縱橫比,即Gabor 濾波器的橢圓度;σ表示Gabor過濾器中實用的高斯函數標準差。

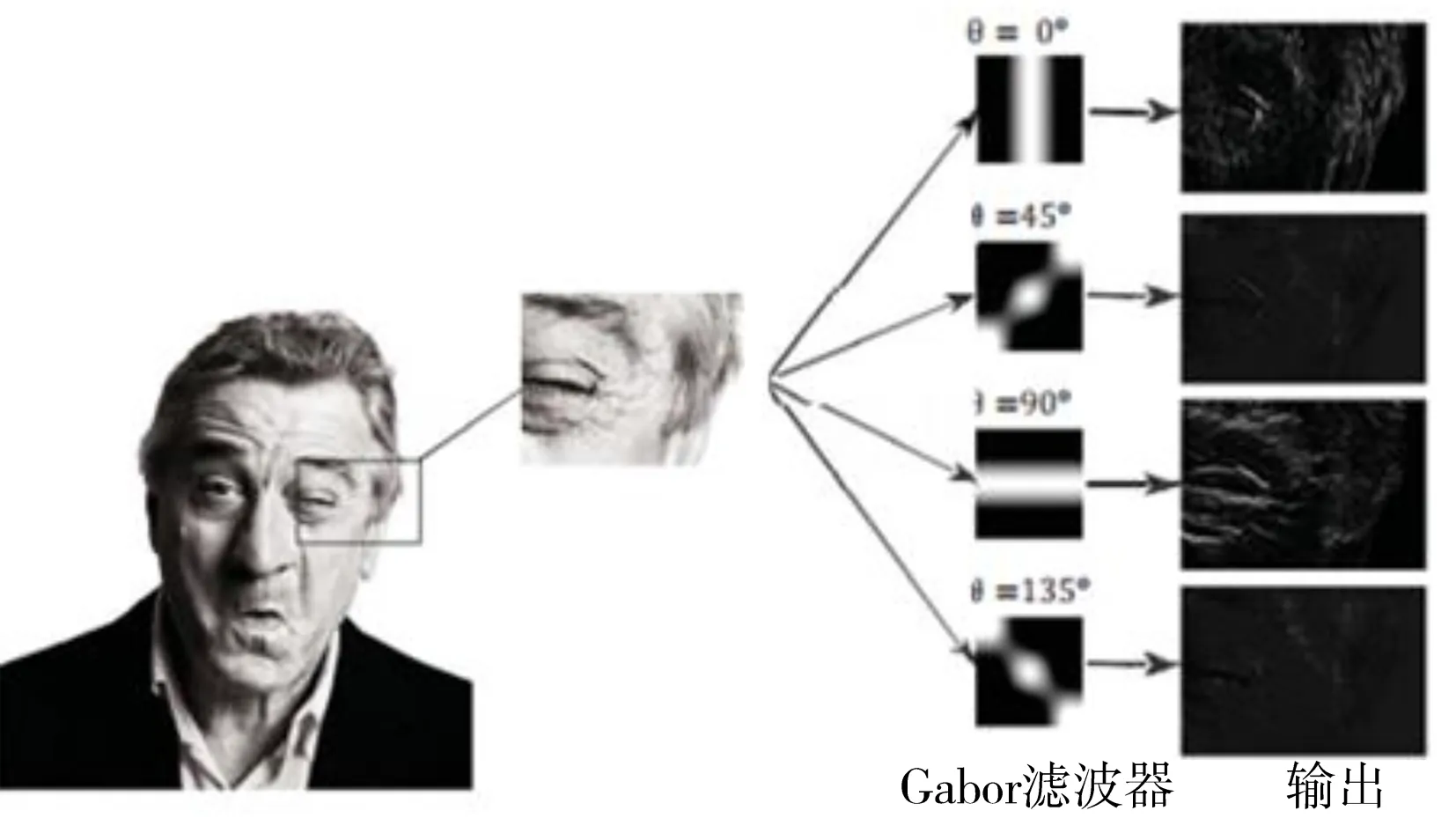

圖1 為Gabor 濾波器對人臉圖像提取特征的示例,表明Gabor濾波器能較好地尋找與給定θ相對應的紋理,Hosseini 等[11]研究表明,使用Gabor 濾波特征作為輸入能提升CNN 的性能。Ou 等[12]利用經典的8 個方向與4 個尺度的Gabor 濾波識別人臉表情,盡管Gabor 小波可處理圖像的尺度和方向變換,但結構較淺,在大規模數據集的分類任務或復雜任務中表現不佳。

Fig.1 Gabor filter banks extracting facial image features圖1 Gabor濾波器組提取人臉圖像特征

為此,許多研究者試圖結合Gabor 小波與深度卷積神經網絡進行圖像表示學習。Meng 等[13,14]使用不同尺度和方向參數的Gabor 濾波器提取表情局部有用特征,將提取的特征作為數據訓練CNN 用于人臉表情識別。Verma等[15]首先基于Viola-Jones 檢測算法檢測整幅圖像中的人臉圖像,然后利用Gabor 濾波器在空間域中提取人臉特征,以捕獲所有方向的整個頻譜,接下來利用Gabor 濾波器提取有意義的面部特征,最后將提取的人臉圖像Gabor 特征作為人工神經網絡分類器的輸入,對人臉表情進行分類。綜上,大部分工作均將Gabor 特征或結合提取的Gabor 特征和原始圖像作為CNN 輸入來訓練模型。

Luan 等[1]實現了Gabor 卷積神經網絡,在每個卷積層中通過不同方向、尺度的Gabor 濾波器調制卷積濾波器,生成卷積Gabor 方向濾波器,賦予卷積濾波器額外的能力以捕獲輸出特征圖中的空間定位、方向選擇性、空間頻率選擇性等視覺屬性。Jiang 等[16]提出由4 個Gabor 卷積層和兩個全連接組成的輕量Gabor 卷積網絡用于FER 任務,在FER2013、FERPlus 和RAF-DB 數據集上的實驗表明,所提方法具有良好的識別精度和較低的計算成本。

Hosseini 等[17]提出結合人臉的Gabor 濾波響應與原始人臉圖像作為CNN 輸入,增強了人臉的褶皺特征,在卷積層早期階段就能發現面部特征,從而提升了表情識別的整體性能。同時,采用膠囊網絡思想捕獲面部特征間的關系,被證明對物體的旋轉具有魯棒性。結果表明,該算法相較于普通CNN、膠囊網絡性能更優,將Gabor濾波特征作為膠囊網絡的輸入能提升表情識別的整體性能。

1.2 Gabor方向濾波器

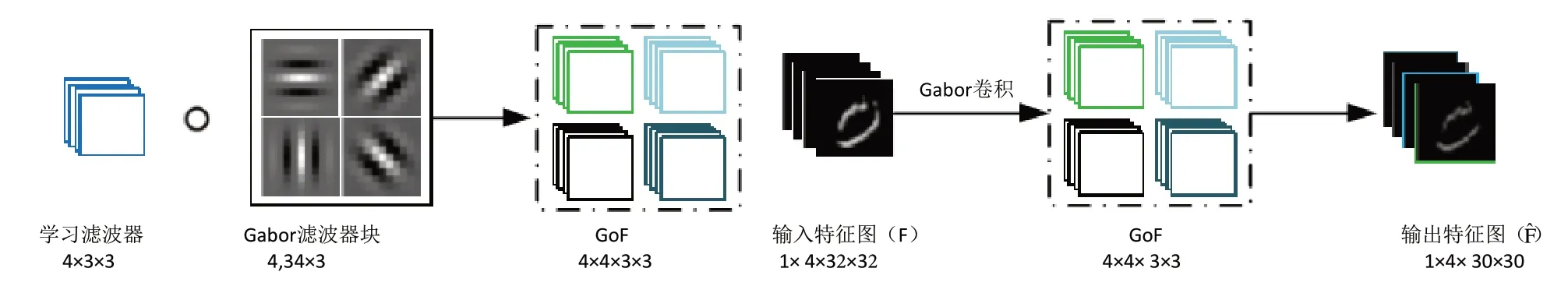

Gabor 濾波器具有U 方向和V 尺度,能將方向信息編碼到學習濾波器中,將尺度信息嵌入不同層中,將可操縱特性融入到Gabor 卷積網絡中,以捕獲輸入圖片的方向和尺度信息,從而增強相應的卷積特征。標準CNN 中的卷積濾波器在經過Gabor 濾波器調制前,通過反向傳播算法進行學習,稱為學習濾波器。假設一個學習濾波器的大小為N×W×W,其中W×W為2D 濾波器大小(N 個通道)。為了實現方便,選擇N為U用于調制該學習濾波器的Gabor 濾波器的方向數,在已知濾波器上使用U個Gabor 濾波器為給定尺度進行濾波,計算如式(2)所示,具體流程如圖2 所示。其中,左半部分為GoF 的調制過程;右半部分展示了一個4 通道GCN 卷積的例子,在GoF 中為了實現方便,通道數設為Gabor方向數U。

Fig.2 Filter modulation process and examples圖2 濾波器調制流程與示例

傳統CNN 卷積核的基本單位是K×K大小的二維濾波器,而Gabor 卷積神經網絡的基本單位是GoF,通常定義為[1]:

第v個尺度定義為:

式中:G(u,v)表示一組K×K的Gabor 核(實部)[10];1≤u≤U、1≤v≤V分別表示方向和頻率;Ci,o為一個U×K×K大小的學習濾波器;?表示G(u,v)、Ci,o每個2D 濾波器間的點乘運算(即也為U×K×K),因此第i個GoF 的實際上是一個U×U×K×K的濾波器。

相較于傳統CNN 中H×W特征圖的不同之處在于,GCN 特征圖F 為U×H×W。因此,F 與一個GoF間的Gabor卷積運算描述為:

式中:*表示標準的3D 卷積操作。

在Gabor 卷積神經網絡中,Gabor 濾波器是調制學習的卷積濾波器。具體地,將CNN 的基本元素卷積濾波器改為GoF,以加強Gabor 濾波器對每個卷積層的影響。因此,在深度卷積神經網絡中集成Gabor 濾波器,能增強深度特征對方向和尺度變化的抵抗力。

在每個卷積層中,卷積濾波器由不同方向和尺度的Gabor 濾波器調制產生卷積Gabor 方向濾波器(Gabor Orientation Filter,GOF),賦予了卷積濾波器額外的能力,以捕獲輸出特征圖的空間定位、方向選擇性、空間頻率選擇性等視覺屬性。

1.3 CBAM注意力卷積模塊

CBAM 注意力機制[18]由通道注意力機制(channel)和空間注意力機制(spatial)組成。傳統基于卷積神經網絡的注意力機制傾向于關注、分析通道域,局限于考慮特征圖通道間的作用關系。CBAM 從通道和空間兩個作用域出發,引入空間注意力和通道注意力兩個分析維度,組成了從通道到空間的順序注意力結構。其中,空間注意力可使神經網絡更關注圖像中對分類起決定作用的像素區域,忽略無關緊要的區域;通道注意力則用于處理特征圖通道的分配關系,對兩個維度進行注意力分配以增強注意力機制對模型性能的提升效果。

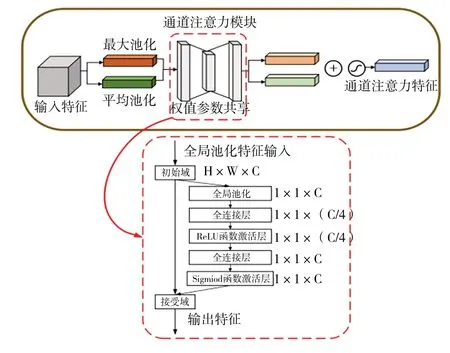

1.3.1 通道注意力機制模塊

圖3 為CBAM 中的通道注意力機制模塊。首先,將輸入特征圖分別輸入全局最大池化和全局平均池化,基于兩個維度壓縮特征映射,獲得兩張不同維度的特征描述,池化后的特征圖共用一個多層感知器網絡。然后,通過一個全連接層減少通道數,再通過另一個全連接恢復通道數,將兩張特征圖在通道維度進行堆疊,經過sigmoid 激活函數將特征圖每個通道的權重歸一化到0~1。最后,將歸一化后的權重和輸入特征圖相乘。

Fig.3 Channel attention mechanism module in CBAM圖3 CBAM中的通道注意力機制模塊

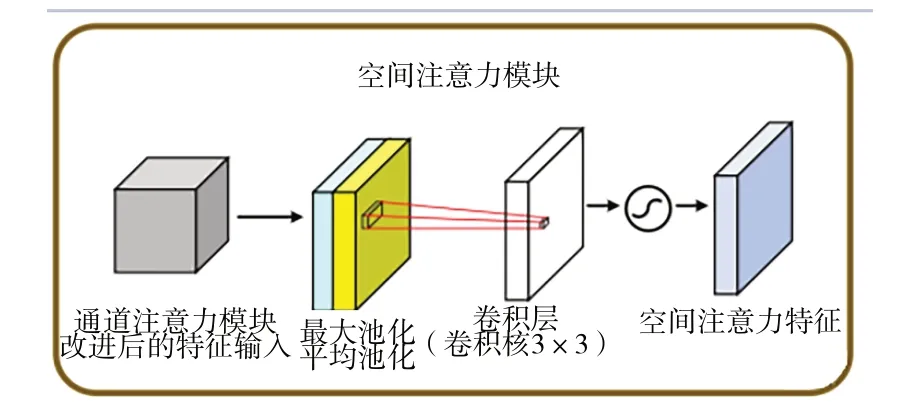

1.3.2 空間注意力機制模塊

圖4 為CBAM 中的空間注意力機制模塊,主要對通道注意力機制的輸出特征圖進行空間域的處理。首先對輸入特征圖在通道維度下進行最大池化和平均池化,將池化后的兩張特征圖在通道維度進行堆疊。然后,使用7×7 或3×3、1×1 大小的卷積核融合通道信息,使特征圖的維度由[b,2,h,w]轉化為[b,1,h,w]。最后,將卷積后的結果經過sigmoid 函數對特征圖的空間權重進行歸一化,再將輸入特征圖和權重相乘。

在瞬態短路工況,阻尼系統的負荷能力按考慮,對應額定容量相間不對稱突然短路的最高溫升和溫度值分別為72.2 K和125.2 ℃;單相對地不對稱突然短路的最高溫升和溫度值分別為65.7 K和118.7 ℃。

Fig.4 Spatial attention mechanism module in CBAM圖4 CBAM中的空間注意力機制模塊

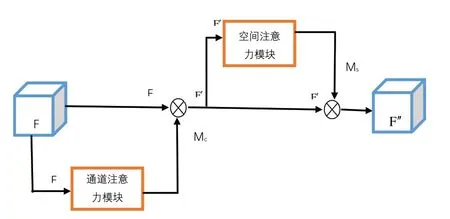

1.3.3 CBAM注意力機制

圖5 為CBAM 注意力模塊總體流程。首先將輸入特征圖經過通道注意力機制;然后將通道權重和輸入特征圖相乘后輸入空間注意力機制;最后將歸一化后的空間權重和空間注意力機制的輸入特征圖相乘,得到最終加權后的特征圖。

Fig.5 CBAM attention module圖5 CBAM注意力模塊

2 基于CBAM的Gabor卷積神經網絡模型

Gabor 卷積網絡使用Gabor 定向濾波器(GoF)的深度卷積神經網絡。其中,GoF 為一種可操縱的濾波器,通過Gabor 濾波器組操縱學習到的卷積濾波器生成增強后的特征映射,使用Gabor 卷積的GCN 網絡可學習更少的濾波器參數,且注意力模塊既不會增加較多參數,還能增強局部特征的提取能力。

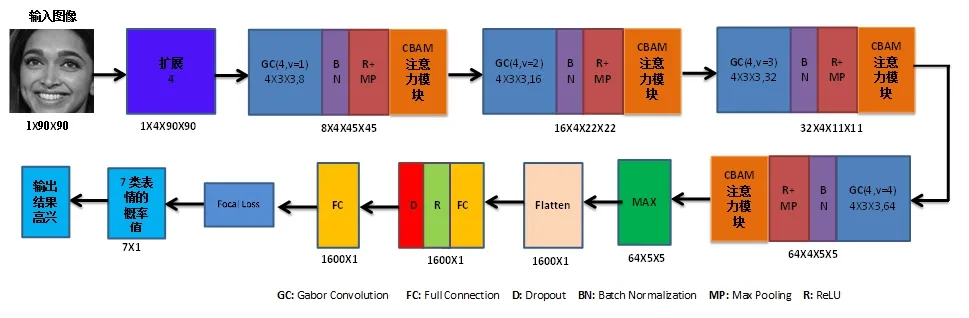

本文模型結構如圖6 所示,由4 個Gabor 卷積層、4 個CBAM 注意力模塊和兩個全連接層組成。其中,Gabor 濾波器包含45°、90°、135°、180°方向,即U=4;在Gabor 卷積層中“4×3×3,8”表示8 個Gabor 方向濾波器,其學習濾波器的大小為4×3×3,且尺度值V在不同深度處不同;Max 操作選擇每個特征映射的最大通道(每個特征映射包括u個通道);flatten 操作將64×5×5 特征轉換為1 600×1 的向量,在所提AGCN 模型中激活函數為ReLU,最大池化核大小為2×2,dropout為0.5。

Fig.6 AGCN model architecture圖6 AGCN模型架構

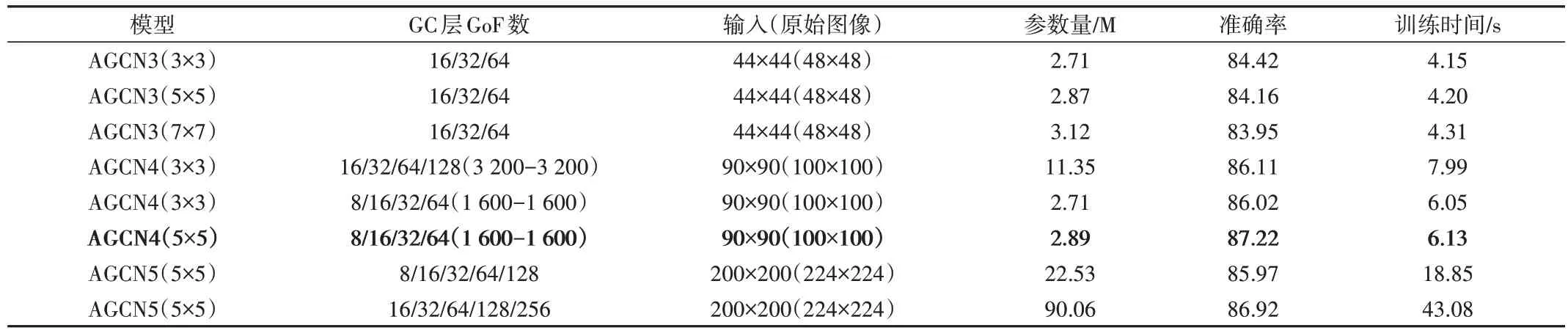

在RAF-DB 數據集上測試的AGCN 模型結果如表1 所示。其中,AGCN4(5×5)為本文模型,由圖2 可見其他模型也具有類似結構,即串聯GC 層、注意力模塊和2 個FC 層(第一個FC 層的輸出為1 600×1 的向量)。例如,AGCN4(5×5)_8 有4 個GC 層,每個GC 層中的GoF 數量分別為8、16、32、64,輸入數據從100×100 灰度圖片中隨機裁剪90×90 的圖片。AGCN3(3×3)、AGCN3(5×5)、AGCN3(7×7)模型層數和GoF 數量不變,增大卷積核大小既增加了模型參數量,還會降低準確率。

Table 1 Performance comparison of 8 AGCN models on RAF-DB datasets表1 8種AGCN模型在RAF-DB數據集上的性能比較

AGCN3 系列模型相較于AGCN4 系列模型速度更快,但精度至少降低1.6%。AGCN4 相較于AGCN5 在精度和運行效率方面更優,以此證明了不能簡單通過增加Gabor卷積層和注意力模塊來提升性能。

因此,本文綜合考慮模型的識別精度和計算復雜度,采用AGCN4(5×5)模型進行后續實驗。

3 實驗與結果分析

3.1 實驗準備

實驗數據集為兩個基準表情數據集FERPlus[8]和RAF-DB[9]。其中,FERPlus 數據集屬于FER2013 數據集的擴展,標注了10 個標簽,主要關注由多數投票選出的高興、生氣、悲傷、驚訝、恐懼、厭惡和平常表情圖片;RAF-DB數據集是一個大規模面部表情數據集,包含3 萬張面部圖片,由40 名訓練有素的人類編碼員標注了基本或復合表情。為了便于計算,本文只使用了含有基本表情的圖片,其中12 271 張用于訓練,1 225 張用于驗證,3 068 張用于測試。在圖像預處理環節從大小為100×100 的灰度輸入圖片中,隨機裁剪出一張90×90 圖片,所有圖片進行歸一化處理。為了防止模型發生過擬合,提升模型泛化能力,將圖片在-10°~10°間隨機旋轉,并以50%的概率隨機水平翻轉進行數據增強。在訓練與測試環節,使用Adam 優化器對模型進行端到端訓練,每批次64 個樣本,動量系數衰減值為0.9,共訓練200 個epoch,學習率每25 次衰減50%,學習率初始值為0.001。

本文采用10-crop 方法來識別測試圖片,首先將一張測試圖片裁剪為10 張90×90 大小,然后將其分類為這10張裁剪圖像平均得分最高的類別。

3.2 實驗結果

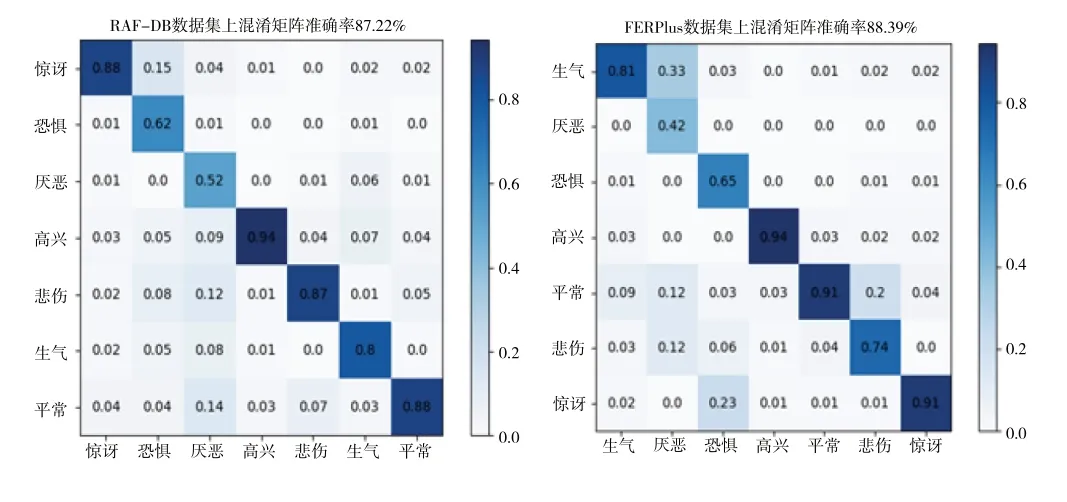

本文模型在RAF-DB 和FERPlus 數據集上的混淆矩陣如圖7 所示。由此可見,高興表情的識別率最高,厭惡表情的識別率最低。

Fig.7 Confusion matrix圖7 混淆矩陣

在RAF-DB 數據集上,驚訝表情容易誤識別為平常或高興,恐懼表情容易誤識別為驚訝、悲傷、高興或生氣,厭惡表情容易誤識別悲傷、平常、高興或驚訝,高興表情容易誤識別為平常,悲傷表情容易誤識別為平常或高興,生氣表情容易誤識別為高興或恐懼,平常表情容易誤識別為悲傷或高興。在FERPlus 數據集上,生氣表情容易誤識別為平常、高興或悲傷,厭惡表情容易誤識別為生氣、平常和悲傷,恐懼表情容易誤識別為驚訝或悲傷,高興表情容易誤識別為平常,平常表情容易誤識別為悲傷或高興,悲傷表情容易誤識別為平常,驚訝表情容易誤識別為平常。

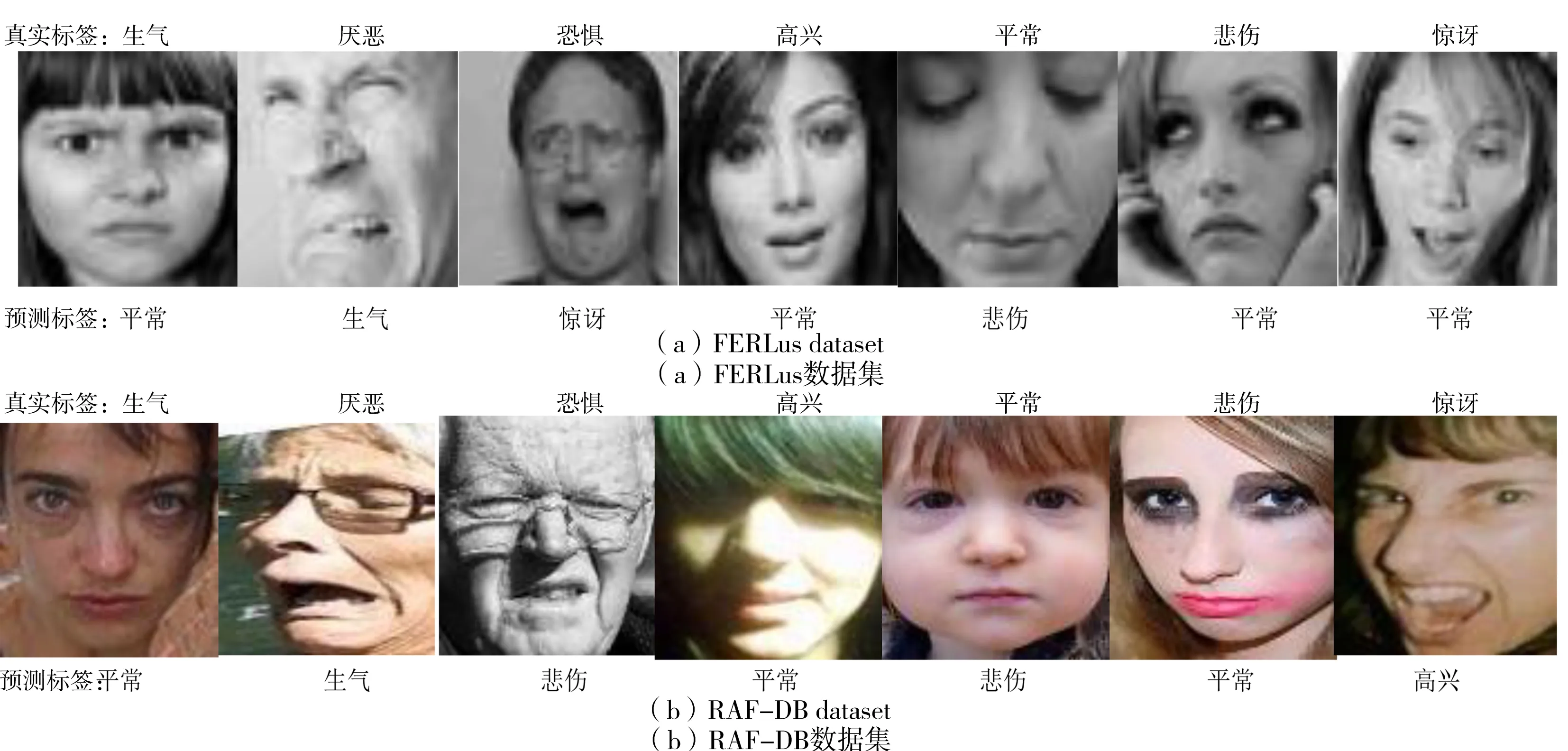

圖8 為誤識別的表情圖片,一部分誤識別是因為遮擋、光照、模糊等客觀因素所導致。由此可見,當數據集搜集、標注等不一致時,每個數據集所呈現的誤識別現象并不統一,但高興表情均容易被誤識別為平常,原因是高興表情和平常表情在日常生活中最為常見,有些人在高興的時候臉部表現十分明顯,然而有些人與平常表情的差異 不大。

Fig.8 Examples of misidentification on two datasets圖8 兩個數據集上誤識別樣例

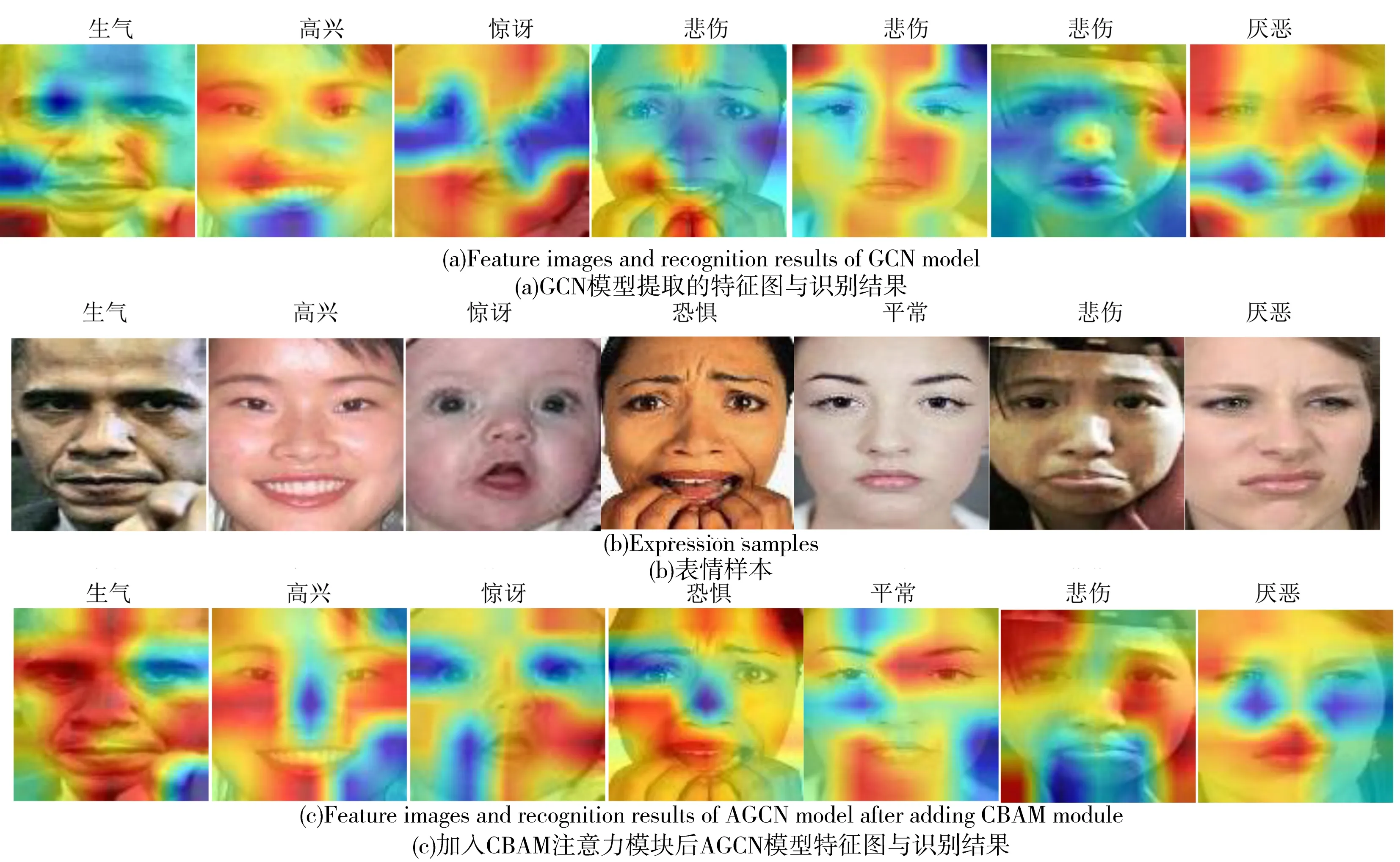

圖9 為與本文架構相同的GCN 和AGCN 模型提取的特征熱力圖。由此可見,AGCN 模型提取的特征注意力較為集中,使得大部分表情關鍵區域局部特征的提取能力得到了提升;GCN 模型提取特征分散,例如平常表情關注眼睛和嘴巴區域變化,該模型只提取嘴巴區域的特征,因此容易產生分類錯誤。

Fig.9 Model characteristic heat map圖9 模型特征熱力圖

3.3 比較實驗

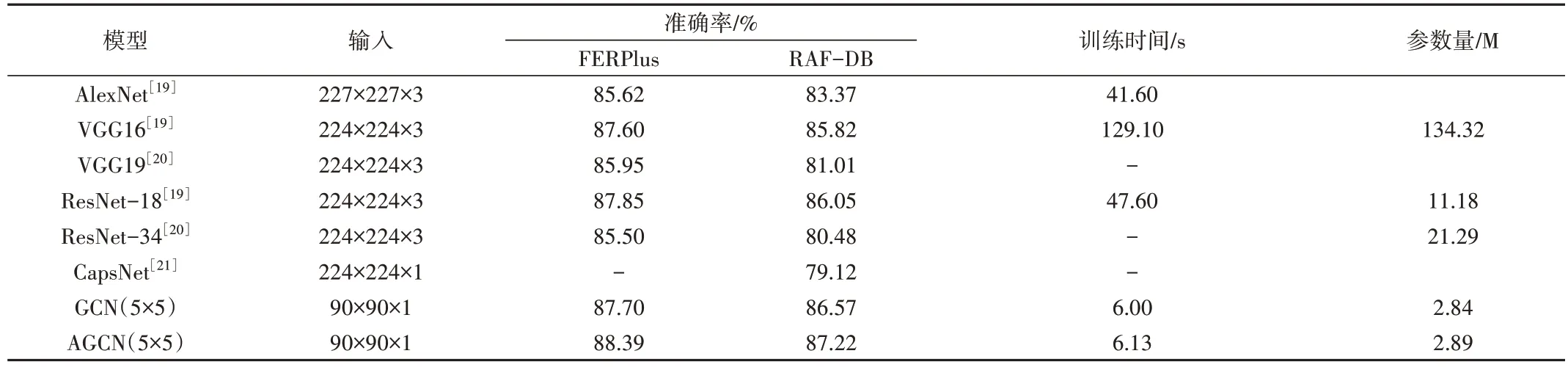

將本文AGCN 模型與AlexNet[19],VGG16[19]、VGG19[20]、ResNet-18[19]、ResNet-34[20]和CapsNet[21]這些在FER 中廣泛使用的知名CNN 架構進行比較,結果如表2所示。由此可知,本文模型在RAF-DB、FERPlus 數據集上識別精度最優,AlexNet、CapsNet 模型相較于其他模型明顯較差。在精度方面,AGCN 模型相較于傳統VGG16、ResNet-18 模型的性能更高,在RAF-DB 數據集上使用一個epoch 來評估模型的計算復雜度發現,AGCN 模型的訓練時間6.13 s,分別為AlexNet、VGG16、ResNet18 的1/7、1/21、1/8。

Table 2 Comparison of some well-known CNN architectures表2 一些知名的CNN架構比較

綜上,本文模型相較于FER 領域一些高效的CNN 架構而言,具有更好的識別精度,所需計算資源和內存成本更少。

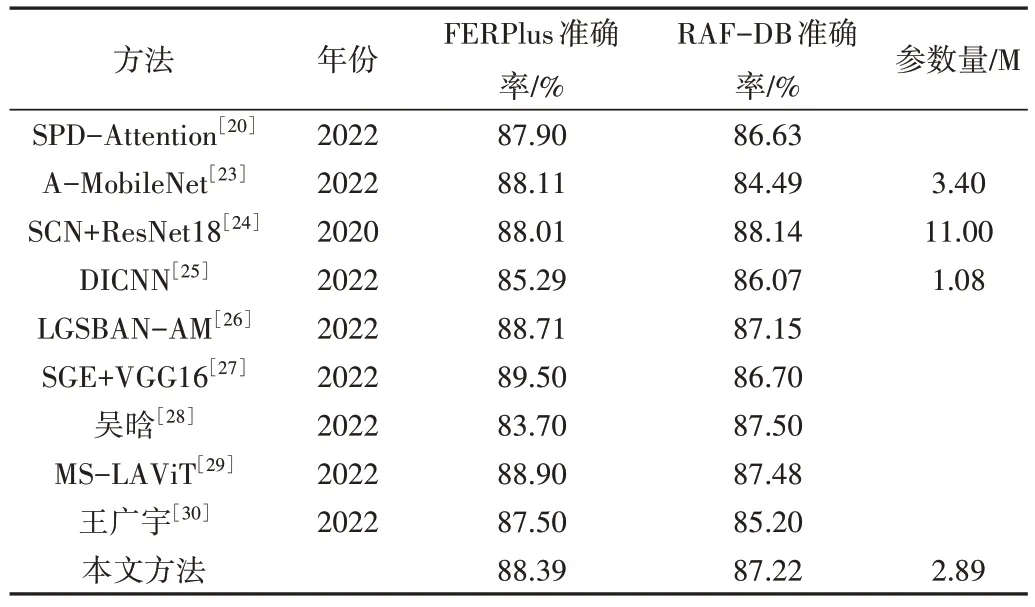

3.4 FER性能比較

為了使模型達到最優精度,許多方法在大型數據集上進行預訓練。為此,本文模型在focal loss 損失的監督下,在AffectNet 數據集[22]上進行預訓練,具體結果如表3 所示。本文模型的識別率分別為88.39%、87.22%,SPD-Attention 局部流行注意力網絡架構[20]通過流行注意力模塊,對原始圖片和n張局部裁剪圖片的聯合特征向量提取的分類特征進行表情預測,整體識別率為87.9%和86.63%,但模型相當復雜,不利于實際使用。

Table 3 Performance evaluation on the FERPlus and RAF-DB datasets表3 FERPlus和RAF-DB數據集上的性能評估

A-MobileNet[23]為基于輕量級MobileNet V1 的注意力模型,模型深度為27 層,參數量為3.4 M,在FERPlus、RAF-DB 數據集上分別達到88.11%、84.49% 識別率。SCN+ResNet18[24]為了抑制表情數據集中不確定性,提出一種簡單、有效的自治愈網絡,在RAF-DB 數據集上識別率相較于本文方法提升了0.92%,模型參數量為11 M。DICNN[25]為雙集成卷積神經網絡,參數量較少速度快,可在移動端部署,但識別精度相對較低。孫冠[26]為了緩解注意力網絡對重點局部區域關注不充分的問題提出滑動窗口塊,設計了由ResNet-50網絡提取特征圖+注意力模塊的滑動塊注意力網絡+注意力模塊的全局注意力網絡組成的LGSBAN-AM 模型,該模型相較于本文方法效果幾乎相當,但基于ResNet-50 網絡的參數非常多且不易訓練。黃苑琴[27]提出在VGG16 模型中加入SGE 注意力模塊以增強特征提取能力,在FERPlus 數據集上達到了89.5%的識別率,但在RAF-DB 數據集上僅為86.7%。吳晗[28]提出在ResNet-18 網絡中引入通道注意力模塊+空間注意力模塊+區域特征編碼模塊識別表情,但在FERPlus 數據集的準確率相較于本文方法降低了4.69%。趙爽[29]提出融合多尺寸的局部注意視覺Transformer 表情識別方法MS-LAViT,識別效果相較于本文方法在FERPlus、RAF-DB 數據集上分別提升0.51%、0.26%,但訓練ViT 模型需要大量的訓練數據和算力。王廣宇[30]提出改進殘差網絡Y-Net 表情識別方法,相較于本文方法在FERPlus、RAF-DB 數據集上的精確度分別降低1.89%和2.02%。

綜上,本文所提AGCN 模型不僅結構簡單,而且在識別率、參數量和消費算力等方面較為均衡,在FERPlus、RAF-DB 自然環境數據集上的識別精度優于大多數最新的FER 方法,原因在于情緒識別與某些識別任務不同,主要依賴面部ROI 信息。例如,對于人臉識別而言,整個面部信息相較于局部特征更重要,GOF 刻畫局部紋理的特征非常有利,CBAM 注意力模塊可在通道和空間層集中提取更為顯著的特征,因此AGCN 模型能有效提取面部表情且所需計算資源非常少。同時,本模型仍屬于一種CNN,因此能與任何應用于FER 領域的傳統CNN 的技術相結合。

4 結語

由于面部表情變化主要集中在眼睛、眉毛、嘴巴和鼻子等局部區域,Gabor 濾波器特別適用于局部紋理,Gabor核與傳統卷積濾波器調制的GoF 在捕獲面部ROI 特征方面非常有效。因此,本文在使用GoF 的深度CNN 基礎上引入注意力模塊,提出一個僅為6 層結構的輕量級AGCN模型。

實驗表明,本文所提模型相較于AlexNet、VGG16、VGG19、ResNet-18、ResNet-34 和CapsNet 這些在FER 中廣泛使用的知名CNN 架構而言,識別性能更好且所需計算資源更少。