基于流形學習的句向量優化

吳明月,周棟,趙文玉,屈薇

基于流形學習的句向量優化

吳明月1,2,周棟1*,趙文玉1,2,屈薇1,2

(1.湖南科技大學 計算機科學與工程學院,湖南 湘潭 411201; 2.服務計算與軟件服務新技術湖南省重點實驗室(湖南科技大學),湖南 湘潭 411201)( ? 通信作者電子郵箱dongzhou1979@hotmail.com)

句向量是自然語言處理的核心技術之一,影響著自然語言處理系統的質量和性能。然而,已有的方法無法高效推理句與句之間的全局語義關系,致使句子在歐氏空間中的語義相似性度量仍存在一定問題。為解決該問題,從句子的局部幾何結構入手,提出一種基于流形學習的句向量優化方法。該方法利用局部線性嵌入(LLE)對句子及其語義相似句子進行兩次加權局部線性組合,這樣不僅保持了句子之間的局部幾何信息,而且有助于推理全局幾何信息,進而使句子在歐氏空間中的語義相似性更貼近人類真實語義。在7個文本語義相似度任務上的實驗結果表明,所提方法的斯皮爾曼相關系數(SRCC)平均值相較于基于對比學習的方法SimCSE(Simple Contrastive learning of Sentence Embeddings)提升了1.21個百分點。此外,將所提方法運用于主流預訓練模型上的結果表明,相較于原始預訓練模型,所提方法優化后模型的SRCC平均值提升了3.32~7.70個百分點。

流形學習;預訓練模型;對比學習;句向量;自然語言處理;局部線性嵌入

0 引言

在網絡文本呈指數增長的互聯網時代,需要處理大規模的無標簽文本,同時更準更快地給用戶提供感興趣的相關內容。其中,句向量(sentence embedding)[1]是一個重要的研究方向,挖掘句與句之間的語義關系(如語義相似度、語義相關性等)對數據挖掘[2-3]、多模態[4-5]、信息檢索[6-7]等領域意義重大[8]。

傳統的句向量生成方法[9-12]因存在數據稀疏、未考慮上下文語境信息和無法高效處理大數據等缺陷[13],已經無法滿足目前的應用需求。為解決上述問題,研究者們提出了基于預訓練語言模型(Pre-trained Language Model, PLM)。其中,以BERT(Bidirectional Encoder Representation from Transformers)[14]為代表的預訓練研究取得了重大的進展,使用BERT模型預訓練的句向量可以處理很多的自然語言工作,如分類、聚類、機器翻譯等[15]。然而,BERT所生成的句向量仍面臨著以下問題:1)語義信息不充分,指BERT直接取[CLS]特征值作為句向量,會丟失部分語義信息;2)在文本語義相似度(Semantic Textual Similarity, STS)任務上性能差,指句向量無法精準表征句子之間的語義信息[15-19]。

流形學習(manifold learning)[20]旨在獲取非線性數據的內在本質結構,是一種從高維數據中獲取低維流形的方法,可以從現象中尋找事物的本質特性。在圖像領域中,流形學習已經被證實能夠觀測圖像數據中的內在本質規律,有效解決語義鴻溝問題。與圖像數據類似,文本數據中也存在天然的低維流形結構,如果低維流形無法觀測,則句向量不僅難以理解文本中潛在的語義特征,而且難以進一步推理句與句之間的全局語義關系。因此,本文提出了一種基于流形學習的句向量優化方法,該方法可以通過流形學習獲取語義特征在低維流形中的本質分布特性,幫助句向量更好地推理句與句之間的全局語義關系。

1 相關工作

1.1 基于BERT的句向量生成及其優化方法

為解決BERT生成的句向量在文本相似度任務上性能差這一問題,研究者提出了一系列的句向量生成和優化方法。相關方法大致分為兩類[19]:有監督方法和無監督方法。

有監督方法旨在利用句子之間更為細粒化的關系,如蘊涵、因果、轉折等語義關系,推理更高層次的語義特征。文獻[17]中提出一種基于孿生網絡的方法SBERT(Sentence BERT),該方法利用孿生網絡和三胞胎網絡的結構,設置相同的兩路模型分別編碼句子,以兩個編碼向量的相似度最小為目標進一步推理句向量。有監督方法,通常只適合特定的任務,并不具備良好的遷移性能。

無監督方法又可分為基于空間映射[15-16]的方法和基于對比學習[18-19]的方法等。空間映射的方法旨在建模某種重映射關系,把原始向量空間映射到一個均勻、光滑的新空間中,提升句向量的性能。常用的重映射方法有高斯變換[15]和線性變換[16]的方法,其中:高斯變換的方法在推理時需耗費額外的計算開銷,導致該方法性能受限;而線性變換的方法雖然在一定程度上解決了時間開銷的問題,卻難以推理句與句之間的全局語義關系,導致句向量在語義相似性度量上仍存在一定誤差。基于對比學習的方法通常以數據增強的方式構建正樣本,在句向量領域中,較為經典的方法主要有兩種:一種是文獻[19]方法,該方法通過模型不同的Dropout,分別對同一句子抽取兩次不同特征,構建對比學習的正樣本對;另一種是文獻[18]方法,該方法通過在模型的池化層上加以微小擾動的方式,構建兩個語義相似的句向量,作為正樣本對。但是,對比學習的方法更偏向于建模句與句之間局部的語義關系,始終無法顯式地建模全局句與句之間語義關系。

1.2 流形學習在文本領域中的應用

流形學習旨在獲取非線性分布數據的內在結構。在文本領域,向量的高維表示會導致數據樣本更復雜,使得文本向量無法直接觀測數據內在本質的分布。為解決該問題,文獻[20]中提出基于流形的詞向量優化方法,并論證流形學習是詞向量相似性度量恢復的有效范式之一。此后,相關研究基本都以此方法為理論依據,并集中于以下兩個領域:1)在詞向量領域,利用局部線性嵌入(Locally Linear Embedding, LLE)[21-22]、局部切空間對齊[23]等流形學習方法建模詞向量空間的重映射,優化了詞與詞在歐氏空間中的相似性度量;2)在句向量領域,首先利用句向量(Sent2Vec)模型[24]生成初始的句向量,其次使用局部保持投影(Locality Preserving Projection, LPP)[25]的流形學習方法建模句向量空間的重映射,提升了句向量在特定任務上的性能。

上述研究主要針對詞與詞級別的語義關系,而本文擬解決的關鍵問題是句與句之間的全局語義關系。為了方便討論,假設句子間的相似程度可以用數值衡量,該值為0~1的實數,值越高表示句子越相似。在極端情況下,值越接近為1,則視為兩者語義基本一致;反之,值越接近0,則視為語義相反。由上述易知,當句子1為“orient,be positioned”、句子2為“be opposite”時,兩句之間的真實語義相似度應為0.50左右;然而,通過現有的句向量模型計算的相似度為0.83,高估了句與句之間的語義相似度。

針對上述問題,文獻[20]中提出一種基于流形學習的詞向量優化方法,認為在局部上,將詞與詞的歐氏距離作為詞與詞之間的語義相似程度可以真實反映詞之間的語義相似程度;然而在全局上,直接將詞與詞之間歐氏距離作為詞與詞之間的語義相似程度并不符合人類的真實評估。受到文獻[20]啟發,本文進一步詳細定義了句與句的語義關系,認為句關系也可分為兩類:一類是局部關系,指句與句之間語義信息相近時,直接計算句之間的距離度量,表征它們的語義相似程度是合理的;另一類是全局關系,指句與句之間語義信息相反時,則需要通過建立句與句之間的局部鄰接關系,以精準推理句與句的全局語義關系。不同于詞級別的優化,句子的語義特征抽取難度更高,句與句之間語義關系表征也更復雜多變。因此,文獻[20]方法不能直接應用于句與句之間語義關系,主要存在以下問題:1)特征抽取句時,句向量容易丟失句子語義信息;2)難以挖掘句與句之間的局部關系,即已知某個句子在歐氏空間的位置時,難以高效地挖掘該句子與它語義相鄰的句子集合;3)在歐氏空間中,已知句子的局部鄰接關系,較難推理句與句之間的全局關系,更好地表征句與句之間的語義關系。為解決上述3個問題,本文提出了一種基于流形學習的句向量優化方法。

本文的主要工作為:

1)利用預訓練模型并結合池化,按照單詞組成句子的層次結構或利用最先進的句向量生成模型對句子編碼,解決句向量丟失部分語義信息的問題。

2)提出一種基于詞頻信息的句頻采樣方法,該方法可以高效地獲取任意句子的相鄰句子集。

3)利用局部線性嵌入(LLE)對句子與它語義相似句子進行兩次加權局部線性組合,在保持句子之間的局部關系的同時,能根據句子之間的局部鄰接關系進一步推理句與句之間的全局語義關系。

2 本文方法

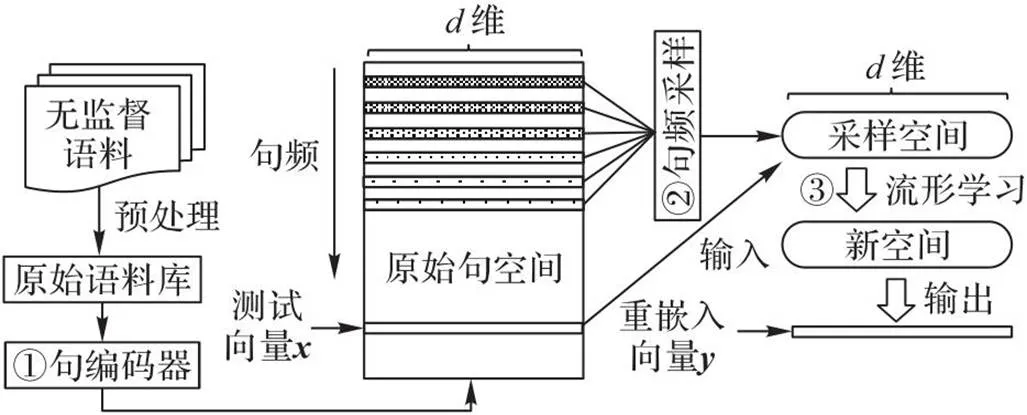

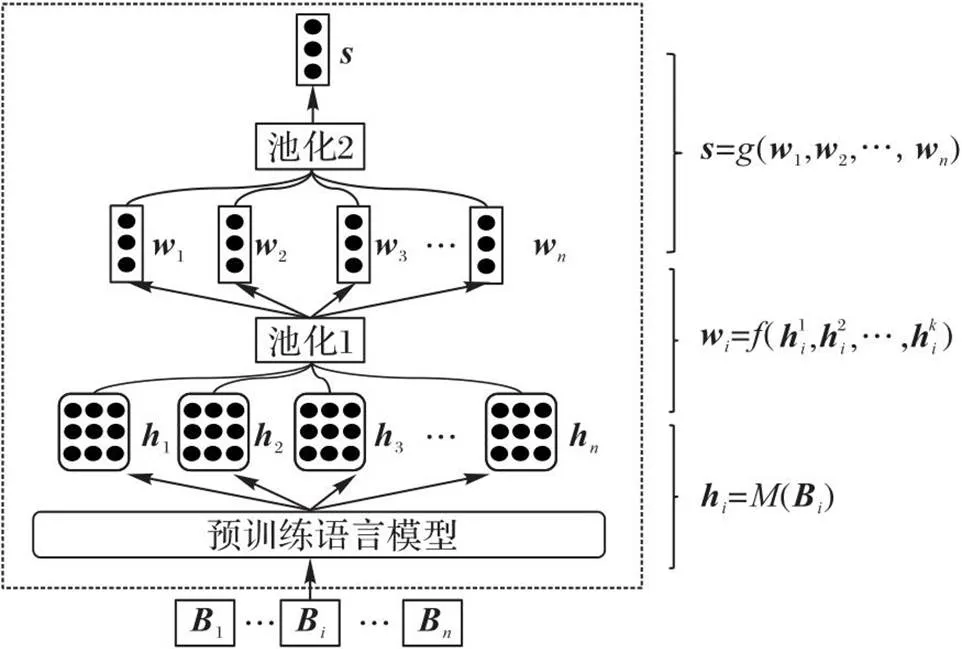

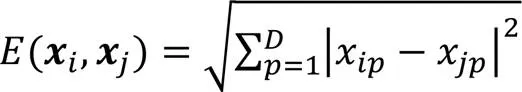

本文方法共包含編碼層、采樣層和重映射層這3個模塊,結構如圖1所示。編碼層包含一種文本向量化的表示方法。首先,利用已經訓練好的預訓練模型初步提取上下文相關的語義特征,獲取上下文相關的詞表示;其次,結合池化1融合模型不同層之間的語義特征,生成動態詞向量;最后,利用池化2挖掘詞與詞之間的互信息,生成上下文相關的句向量。采樣層包含一種基于詞頻信息的句頻采樣方法。該模塊結合詞袋假設的思想,把句頻信息定義為詞頻信息的線性組合,通過句頻信息高效挖掘句與句之間的局部關系。重映射層包含一種基于局部線性嵌入的語義特征再抽取方法,利用LLE對測試句子與它語義相鄰的句子進行兩次加權局部線性組合,在保持句子局部鄰接關系的同時,進一步推理句與句之間的全局語義關系。

圖1 基于流形學習的句向量優化方法

2.1 編碼層

2.1.1詞表示

文本表示是自然語言處理的基礎工作之一,其中將句表示成固定長度的向量,稱之為句向量,又叫句嵌入。句向量大幅提高了神經網絡處理文本數據的能力。以Transformer作為主干的一類預訓練模型不僅能從大規模的語料數據中充分挖掘潛在的語義特征,還可以很容易地遷移到其他任務上,具有良好的推廣性能。針對句子語義的信息抽取,本文使用了基于Transformer的預訓練模型(如BERT、GPT-2(Generative Pre-trained Transformer 2)等)初步提取的特征,生成上下文相關的詞表示。

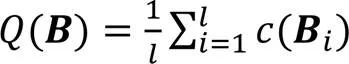

假設預訓練模型由層Transformer作為特征提取器。將句子輸入已經訓練好的模型中,便可推理具有上下文相關的詞表示,計算如式(1)所示:

2.1.2池化

傳統方法通常直接取預訓練模型的[CLS]標記作為句向量,然而該取法在語義表征上仍存在一些問題,導致句向量語義信息表征不充分,而且難以捕捉句與句之間的全局語義關系,影響了句向量的表征能力,制約了句向量的發展。為了解決上述問題,本文引入池化提升句向量表征能力,引入池化后,句向量不僅能捕捉詞與詞之間的互信息,還能抽取上下文模型中不同層之間的語義特征[26]。其中,比較具有代表性的池化為平均池化,它能抽取詞向量中每個維度的平均值,使得句向量融合所有詞的互信息,語義特征更突出。

具體地,池化分為兩步。首先,利用池化1融合模型不同層之間的語義特征,生成動態詞向量;其次,使用池化2挖掘詞與詞之間的互信息,生成上下文相關的句向量。兩個步驟分別如式(2)~(3)所示:

2.1.3句編碼器

本文的句編碼器如圖2所示。

圖2 編碼層圖

首先,利用預訓練模型,生成上下文相關的詞向量表示;其次,結合池化1,抽取上下文相關模型中不同層之間的語義特征,生成動態詞向量;最后,結合池化2,按照單詞組成句子的層次結構,生成上下文相關的句向量。算法1為句子編碼的迭代過程。

算法1 基于預訓練的句編碼器方法。

輸入 無監督語料庫;

輸出 原始句向量空間。

Repeat

預處理句子

根據式(1)計算詞表示

根據式(2)計算動態詞向量

根據式(3)計算句向量

Until無監督語料庫中的句子已全部編碼

2.2 采樣層

在大規模語料庫中,精確尋找某個句子以及與它語義相鄰的個近鄰句子非常困難:不僅需要計算該句子和其他所有句子的語義相似程度,還需要按相似程度排序,才能找出個近鄰句子。以前的方法主要通過隨機采樣解決這一問題,但隨機采樣的方法始終無法精準采集與測試句子語義相鄰的句子集,反而容易采集一些語義信息生僻的句子,引入噪聲,導致流形學習難以推理句與句的全局關系。

為解決上述問題,本文提出了一種基于詞頻信息的句頻采樣方法,可以實現在大規模語料庫中,高效地采集某句子以及與它語義相鄰的句子集合。該方法的主要思想為如果某句子對中兩者都包含同樣的詞,則表示兩者語義相似的程度越高。基于此假設,本文認為當某句子包含多個高頻詞時,則該句子與其他句子語義相鄰的可能性也會有所提高;此外,本文從詞頻角度出發,設計了一個評價指標,記為句頻信息,該指標能在某種程度上反映某句子與其他句子語義相鄰的概率。由上述分析可知,某個句子的句頻信息越高,則該句子與其他句子語義相鄰的可能性越大。

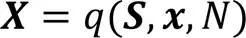

句頻采樣的主要過程為:首先,計算語料庫中所有句子的句頻信息,如式(4)所示;其次,利用句頻信息生成降序排列的句向量空間;最后,結合候選參數,隨機選取個句子得到采樣空間,作為流形學習的局部鄰域候選集。

2.3 重映射層

與圖像數據類似,文本數據在歐氏空間中也存在天然的流形結構。為了更好地挖掘文本數據中的低維流形,本文提出一種基于局部線性嵌入的特征抽取方法,在保持文本數據局部關系的基礎上,進一步推理句之間的全局語義關系。

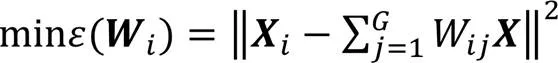

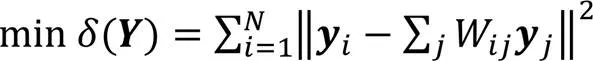

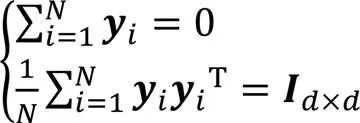

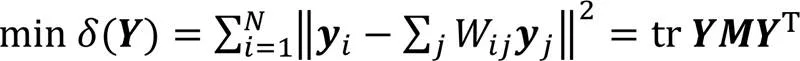

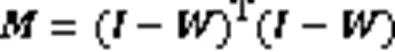

局部線性嵌入的主要思想為:采集的高維數據樣本點都可以利用局部鄰域的點線性表示。在保持局部鄰域權值不變情況下,可以通過最小化重構誤差在低維空間中重新構造原來的數據點。重映射模塊的主要實現步驟如下。

s.t. 式(9)

其中:tr代表矩陣的跡;代表一個稀疏矩陣。

綜上所述,利用局部線性嵌入推理句與句之間全局關系的整個過程可以歸納為:

2.4 基于流形學習的句向量優化方法

本文方法的具體迭代過程如算法2所示。

算法2 基于流形學習的句向量優化方法。

輸入 句向量空間,測試句向量,近鄰參數,采樣參數;

輸出 流形學習后的新向量。

初始化 詞頻信息表。

Repeat

根據式(5)計算候選集

根據式(6)計算個近鄰句子

根據式(7)保持句子的局部鄰接關系

根據式(8)推理句子的全局關系

根據式(10)計算重映射后的句向量

Until任務中的測試句子已全部重映射

3 實驗與結果分析

3.1 數據集

本文在維基百科爬取了新聞、教育和科技等多個領域的文本數據,共1 100 000條句子,制作了無監督語料庫。

根據文獻[27],本文選擇了7個國際通用的文本相似度任務數據集用于評估本文方法。這個系列的公開數據集是目前語義文本相似度領域最為常用的公開數據集。數據集中任務的標簽分數是通過眾包技術所得,最終的標簽得分是統計10個人的平均分數所得,每個人的評分等級為1~5,評分等級越高,表示兩者的語義相似度或語義相關性越高。任務樣本標簽值,又稱為語義相似度或語義相關性,是取值為[0,5]的實數。具體介紹如下:

1)SICK-R(Sentences Involving Compositional Knowledge Relevance)。該評測任務包含了句與句之間更高層次的語義關系,如蘊含、矛盾和中性多種語義關系,共包含9 927個句子對。

2)STS-B(Semantic Textual Similarity Benchmark)。該任務是國際公開數據集,也是最新SemEval Task之一,共包含3 210個句子對。提供了跨語言的文本相似度任務評估,如英語、土耳其語和西班牙語等。

3)STS12~STS16(Semantic Textual Similarity 2012—2016)。該類評測任務包含了句與句之間的基本語義關系,如句與句之間的語義相似關系。

3.2 評價指標

3.3 對比基線

本文的對比基線如下:

1)句向量生成模型。包括USE_TF(Universal Sentence Encoder for English)[28]、Skip_Thoughts[10]、InferSent_FastText[29]、SBERT(Sentence-BERT)[17]、SimCSE(Simple Contrastive learning of Sentence Embeddings)[19]和ConSERT(Contrastive framework for self-supervised SEntence Representation Transfer)[18]。

2)句向量優化模型。包括Glove_WR(Glove Weighed Removal)[9]、BERT_flow[15]和BERT_whitening[16]。

本文采用的主流預訓練模型[30]如下:

GPT-2(版本為gpt2-base),維度為768,是一種單向自回歸的語言模型的預訓練技術。

BERT(版本為bert-base-uncased),維度為768,是基于Transformer編碼器的降噪自編碼語言模型,Transformer的編碼器負責接收文本作為輸入,不負責預測。

Roberta(版本為roberta-base),維度為768,是一種精調的BERT模型。

XLNET(版本為xlnet-base-cased),維度為768,是一種排列語言模型,主要采用了PLM、雙流自注意力機制和改進的Transformer特征提取器。

BART(版本為bart-base),維度為768,是一種結構由序列到序列(Sequence to Sequence, Seq2Seq)組成的預訓練模型,Seq2Seq的注意力機制是建立在編碼器的最后輸出上,獲得更全面完整的全局整合信息。

T5(Text-to-Text Transfer Transformer)(版本為t5-base),維度為768,是一種探索遷移學習邊界的模型,它的核心思想是對自然語言處理任務建模,將所有預訓練任務構造成異步的Seq2Seq模型。T5多任務主要有完形填空、去噪自編碼等預訓練任務。

3.4 實驗設置

本文方法根據編碼層的設置不同,大致可分為兩類:

1)SimMSE。編碼層使用最先進的句向量生成模型SimCSE,詳細實驗設置參考文獻[19]中的基本設置。

2)Model_MFL。Model代表3.3節中的6個主流預訓練模型,MFL代表本文方法,編號(1)表示該模型使用頂層池化,編號(2)表示該模型使用加權池化,編號(3)表示該模型使用平均池化。

采樣層均設置為句頻采樣,采樣范圍為[1,10 000],隨機參數的取值范圍為[2 500,3 500]。重映射層設置為局部線性嵌入作為流形學習的方法,近鄰參數的范圍為[300,1 024]。

本文所有的實驗均使用SRCC評估,對比實驗主要分為以下兩個部分:

1)為了驗證本文方法(SimMSE)可以優化最新句向量生成模型SimCSE。本文在SimCSE的基礎上生成初始的句向量,再利用局部線性嵌入進一步優化,并與其他句向量優化方法如Glove_WR、BERT_flow和BERT_whitening對比。

2)為了驗證本文方法的可推廣性,本文在其他的主流預訓練模型上進行了可推廣性實驗。

3.5 對比實驗結果與分析

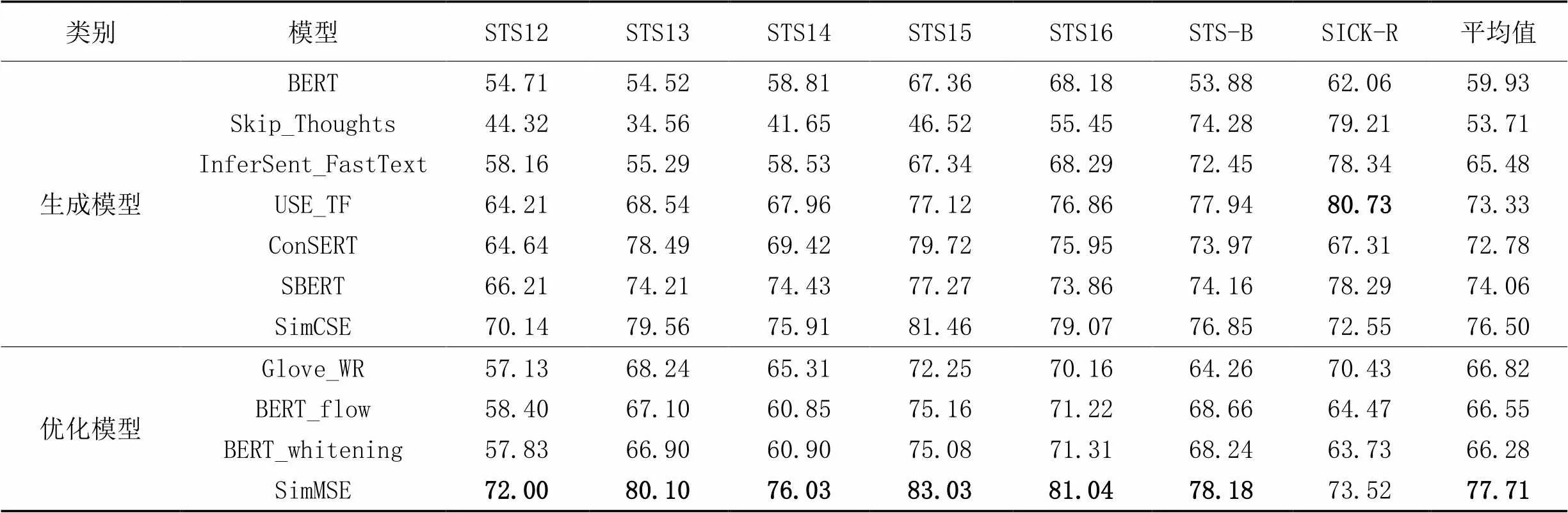

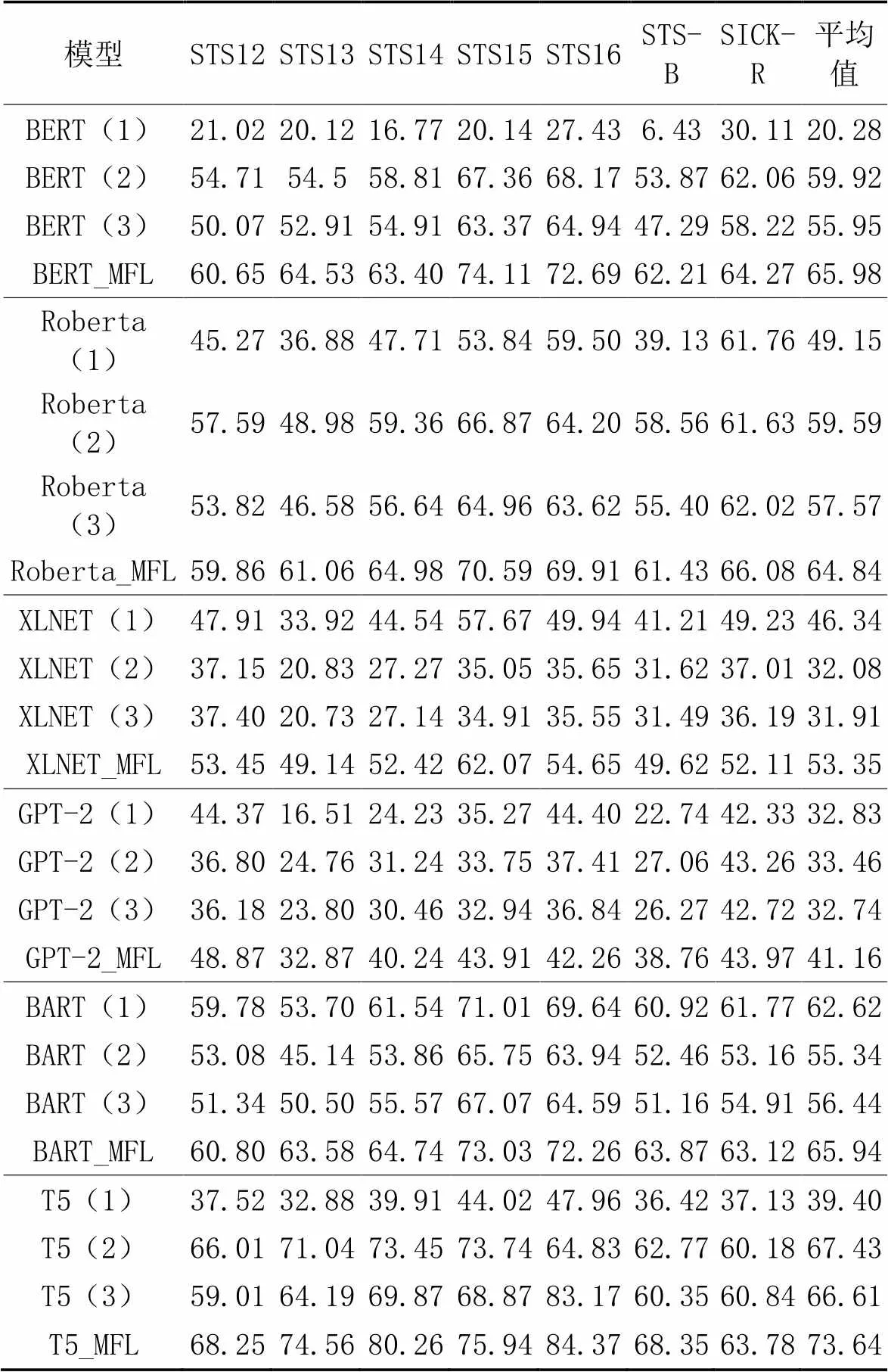

表1~2列出了不同方法在7個測試任務數據集上的性能,其中:表1主要對比了句向量生成模型和句向量優化模型;表2展示了本文方法在其他主流預訓練模型上的推廣性實驗結果,并與原始預訓練模型結合池化的方法進行對比。實驗結果表明,本文方法在保持句與句局部關系的情況下,可以進一步推理句與句之間的全局語義關系,提升句向量的性能。

表1 句向量優化模型的實驗結果對比 單位:%

表2 主流預訓練模型的實驗結果對比 單位:%

根據表1,可以得出以下結論:

1)本文的句向量優化方法可以優化歐氏空間中句與句之間的語義相似關系。在SICK-R、STS12-16和STS-B任務上,相較于次優的SimCSE,SimMSE的SRCC平均值提升了1.21個百分點,表明流形學習可以優化句與句之間的基本語義關系,修正句與句之間在歐氏空間中的語義相似度。

2)本文的句向量優化方法無法更高效地捕捉句與句之間更高層次的語義信息,如蘊涵、因果、轉折等語義關系。SimMSE在SICK-R任務上,雖然優于Glove_WR、BERT_flow等大部分句向量優化模型,但性能比USE_TF、SBERT等4個句向量生成模型差。不同于句與句之間的基本語義關系,更高層次的語義關系通常需要結合監督信號才能取得更優的性能。

表2列出了本文方法在主流預訓練模型上的優化效果,由表2結果可以得出以下結論:

1)本文方法具有極高的可推廣性。相較于原始的預訓練模型,經過本文方法優化后的BERT_MFL、Roberta_MFL等方法的性能有顯著提升。

2)池化和句與句之間語義關系推理有著密切的關系,且在不同預訓練模型呈現較大的差異。在大部分預訓練模型上,相較于其他池化,加權池化取得了良好的性能,如BERT(2)、Roberta(2)等模型;頂層池化只在BART(1)和XLNET(1)上取得了優勢,在其他預訓練模型上效果不佳;平均池化則表現得更為均衡,在BERT(3)和Roberta(3)中,性能介于加權池化和頂層池化。

3)模型自身的預訓練任務對句與句之間語義關系推理有著決定性的作用。經過本文方法優化后,基于T5優化后的句向量模型T5_MFL取得了最優的性能;而基于GPT-2優化后的句向量模型GPT-2_MFL性能依舊極差。表明相較于其他預訓練任務而言,基于完形填空和去噪自編碼等預訓練任務更利于句向量理解句與句之間的語義關系。

4)本文方法對預訓練模型的優化效果與預訓練任務有關,且在不同預訓練任務上呈現較大差異。相較于原始的預訓練模型XLNET,XLNET_MFL的SRCC平均值至少提升了7.01個百分點;相較于原始的預訓練模型GPT-2,GPT-2_MFL的SRCC平均值至少提升了7.70個百分點;而相較于原始的預訓練模型BART,BART_MFL平均值至少提升了3.32個百分點,提升較少。這一現象表明,本文方法對隨機排列的預訓練任務所生成的句向量優化效果較為顯著,而對BART一類的預訓練模型而言優化效果并不明顯。

3.6 消融實驗

本文的消融實驗主要分為兩部分:

1)驗證單層的有效性。實驗設置遵循單一控制變量法,分別驗證采樣層和重映射層的有效性。

2)驗證各層部件的組合性能。實驗設置編碼層固定,采樣層和重映射層可變,分析采樣層和重映射層的組合性能。

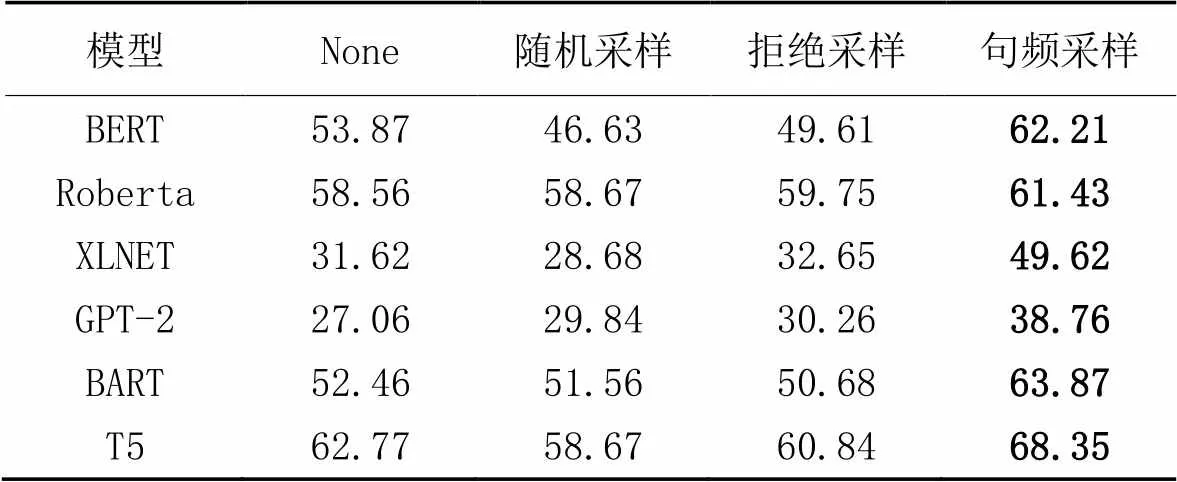

3.6.1采樣層的有效性分析

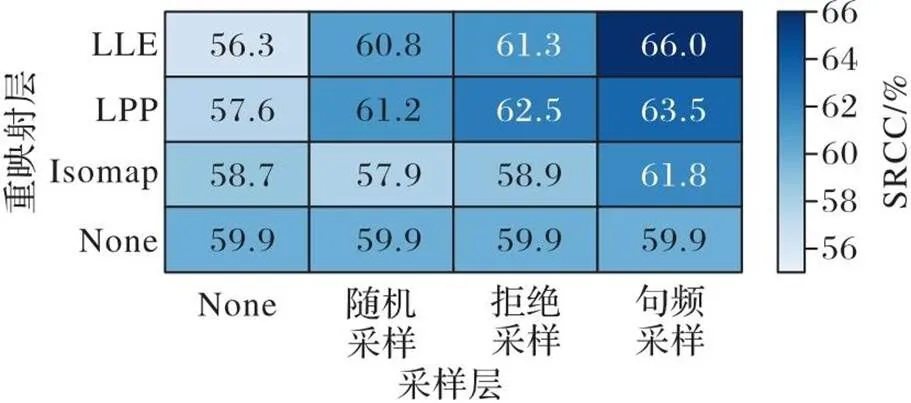

本節實驗設置如下:編碼層分別使用BERT、Roberta、XLNET、GPT-2、BART和T5等模型編碼;采樣層分別設置為None(表示不進行任何采樣操作)、隨機采樣、拒絕采樣和句頻采樣;在重映射層,均設置為局部線性嵌入。評測任務為STS-B,評價指標為SRCC。

表3列出了不同采樣方法在STS-B測試任務上的性能結果。從表3可以看出,相較于其他的采樣方法,本文設計的句頻采樣能夠采樣、測試句子語義相鄰的句子集合,并且在多個主流的預訓練模型上都得到了有效的驗證。

表3 不同采樣方法在STS-B測試任務上的性能對比 單位:%

采樣層的目標是更高效地挖掘句與句之間的局部鄰接關系,即給定一個測試句子,盡可能在最短的時間內找出與它語義相鄰的句子集合。然而,隨機采樣雖然速度很快,但是難以采集與測試句子語義相近的句子集,反而容易采集一些語義信息生僻的句子,給后續的重映射層引入了一定的噪聲,增加了模型推理的難度,導致模型性能下降。

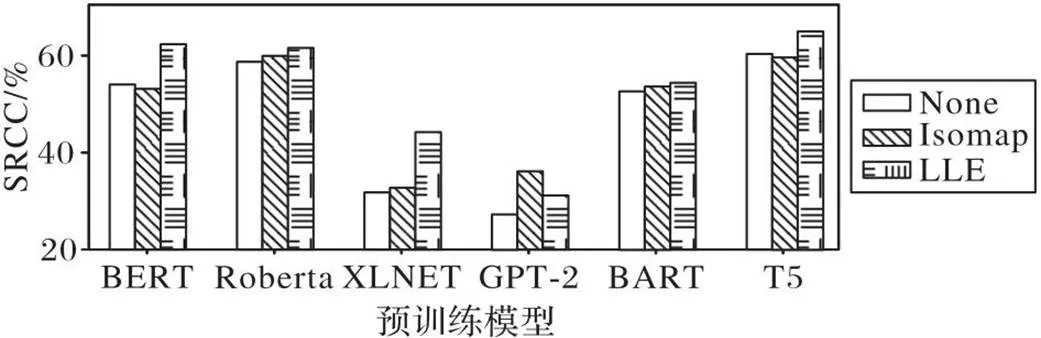

3.6.2重映射的有效性分析

本節實驗設置如下:編碼層分別使用BERT、Roberta、XLNET、GPT-2、BART和T5等模型對無監督語料庫編碼,采樣層均設置為句頻采樣,重映射層包括無重映射層None、等度量映射(Isometric mapping,Isomap)[31]和局部線性嵌入(LLE)。評測任務為STS-B,評價指標為SRCC。

圖3展示了流形學習在STS-B測試任務上的性能。實驗結果表明,在多個主流的預訓練模型上,相較于其他流形學習方法,LLE建模句向量的重映射都取得了較佳的性能。

圖3 不同流形學習方法在STS-B測試任務上性能對比

一方面,由圖3可知,除GPT-2以外,相較于Isomap,LLE的性能更為優異;另一方面,從算法的機理分析可得,在相同樣本數的前提下,LLE的時間復雜度遠低于Isomap,因此LLE更高效。其次,Isomap受近鄰范圍的影響較大,近鄰范圍太寬和太窄,都不利于推理句與句之間的全局關系;而LLE受近鄰范圍的影響較小,在很多情況下,依舊可以對樣本映射,故LLE適用范圍更廣。

綜上所述,利用LLE建模句向量的重映射更具優勢。

3.6.3模型部件組合分析

本節的實驗設置如下:

編碼層設置BERT模型作為句子編碼器;采樣層分別設置為None(表示不進行任何采樣操作)、隨機采樣、拒絕采樣和句頻采樣。重映射層分別設置為None(表示不進行流形學習)、Isomap、LPP和LLE。評測任務為STS-B、STS2012~STS2016和SICK-R,評價指標為SRCC。

圖4列出了組合方法在7個測試任務上的SRCC平均值結果。實驗結果表明,采樣層設置為句頻采樣、重映射層設置為LLE的組合方法效果最佳。

圖4 采樣層與重映射層的組合性能結果

由圖4可以看出:

1)采樣層和重映射層是相輔相成的,兩者缺一不可。如果不設置采樣層,而直接進行流形學習建模句向量的重映射,句向量的性能不但沒有得到優化,反而有所下降。

2)高效采樣方法能提升句向量的優化效果。前期使用越高效的采樣方案,后期越有助于流形學習推理句與句之間的全局關系。

3)流形學習方法結合不同采樣方案的性能差距較明顯。例如,Isomap方法結合句頻采樣有利于句向量的優化,呈現積極作用;而Isomap方法結合隨機采樣不利于句向量的優化,呈現消極作用。

綜合以上實驗結果和分析可以得到如下結論:

1)相較于其他預訓練模型,句向量生成模型BART和T5更利于句子在歐氏空間中的語義相似性度量。

2)利用句頻信息,不僅可以高效地挖掘句子及其語義相鄰的句子集合,還可以幫助后續的流形學習,更好地推理句與句之間的全局語義關系。

3)采用句頻采樣結合局部線性嵌入的組合方法得到的句向量優化效果最佳。

4 結語

本文主要研究當前主流預訓練模型所生成句向量,并提出一種基于流形學習的句向量優化方法。首先,在預訓練模型基礎上結合池化,按照單詞組成句子的層次結構編碼句子,形成原始句空間;其次,利用句頻采樣得到語義較豐富的采樣空間;最后,利用局部線性嵌入構建原始空間到新空間的重映射,推理句與句在全局上的語義關系。在7個國際通用的文本語義相似度任務上的實驗結果表明,相較于基線方法,本文方法的性能提升明顯;此外,將本文方法運用到6種主流的預訓練模型上,也取得了優異的性能。

未來的研究工作中,將從以下3個方面展開:1)設計更高效的采樣方案,挖掘更優質的采樣空間,提升采樣效率;2)研究更高效的流形學習方法,建模句與句之間的全局關系3)嘗試將流形學習運用于句向量相關的下游任務,如文本分類、情感分析和文本摘要等任務,提升句向量在下游任務中的遷移性能。

[1] 趙京勝,宋夢雪,高祥,等. 自然語言處理中的文本表示研究[J]. 軟件學報, 2022, 33(1): 102-128.(ZHAO J S, SONG M X, GAO X, et al. Research on text representation in natural language processing[J]. Journal of Software, 2022, 33(1): 102-128.)

[2] RAJATH S, KUMAR A, AGARWAL M, et al. Data mining tool to help the scientific community develop answers to Covid-19 queries[C]// Proceedings of the 5th International Conference on Intelligent Computing in Data Sciences. Piscataway: IEEE, 2021: 1-5.

[3] SASTRE J, VAHID A H, McDONAGH C, et al. A text mining approach to discovering COVID-19 relevant factors[C]// Proceedings of the 2020 IEEE International Conference on Bioinformatics and Biomedicine. Piscataway: IEEE, 2020: 486-490.

[4] BOATENG G. Towards real-time multimodal emotion recognition among couples[C]// Proceedings of the 2020 International Conference on Multimodal Interaction. New York: ACM, 2020: 748-753.

[5] BOATENG G, KOWATSCH T. Speech emotion recognition among elderly individuals using multimodal fusion and transfer learning[C]// Companion Publication of the 2020 International Conference on Multimodal Interaction. New York: ACM, 2020: 12-16.

[6] ESTEVA A, KALE A, PAULUS R, et al. COVID-19 information retrieval with deep-learning based semantic search, question answering, and abstractive summarization[J]. npj Digital Medicine, 2021, 4: No.68.

[7] LIN J. A proposed conceptual framework for a representational approach to information retrieval[J]. ACM SIGIR Forum, 2021, 55(2): No.4.

[8] LI R, ZHAO X, MOENS M F. A brief overview of universal sentence representation methods: a linguistic view[J]. ACM Computing Surveys, 2023, 55(3): No.56.

[9] ARORA S, LIANG Y, MA T. A simple but tough-to-beat baseline for sentence embeddings[EB/OL]. (2022-07-22) [2022-07-20].https://openreview.net/pdf?id=SyK00v5xx.

[10] KIROS R, ZHU Y, SALAKHUTDINOV R, et al. Skip-thought vectors[C]// Proceedings of the 28th International Conference on Neural Information Processing Systems — Volume 2. Cambridge: MIT Press, 2015: 3294-3302.

[11] WIETING J, BANSAL M, GIMPEL K, et al. Towards universal paraphrastic sentence embeddings[EB/OL]. (2016-03-04) [2022-07-20].https://arxiv.org/pdf/1511.08198.pdf.

[12] ZHANG M, WU Y, LI W, et al. Learning universal sentence representations with mean-max attention autoencoder[C]// Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2018: 1532-1543.

[13] LIU Z Y, LIN Y K, SUN M S. Representation Learning for Natural Language Processing[M]. Berlin: Springer, 2020.

[14] DEVLIN J, CHANG M W, LEE K, et al. BERT: pre-training of deep bidirectional transformers for language understanding[C]// Proceedings of the 16th Annual Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers). Stroudsburg, PA: ACL, 2019: 4171-4186.

[15] LI B, ZHOU H, HE J, et al. On the sentence embeddings from pre-trained language models[C]// Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2020: 9119-9130.

[16] SU J, CAO J, LIU W, et al. Whitening sentence representations for better semantics and faster retrieval[EB/OL]. (2021-03-29) [2022-05-23].https://arxiv.org/pdf/2103.15316.pdf.

[17] REIMERS N, GUREVYCH I. Sentence-BERT: sentence embeddings using siamese BERT-networks[C]// Proceedings of the 2019 Conference on Empirical Methods in Natural Language Processing and the 9th International Joint Conference on Natural Language Processing. Stroudsburg, PA: ACL, 2019: 3982-3992.

[18] YAN Y, LI R, WANG S, et al. ConSERT: a contrastive framework for self-supervised sentence representation transfer[C]// Proceedings of the 59th Annual Meeting of the Association for Computational Linguistics and the 11th International Joint Conference on Natural Language Processing (Volume 1: Long Papers). Stroudsburg, PA: ACL, 2021: 5065-5075.

[19] GAO T, YAO X, CHEN D. SimCSE: simple contrastive learning of sentence embeddings[C]// Proceedings of the 2021 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2021: 6894-6910.

[20] HASHIMOTO T B, ALVAREZ-MELIS D, JAAKKOLA T S. Word embeddings as metric recovery in semantic spaces[J]. Transactions of the Association for Computational Linguistics, 2016, 4: 273-286.

[21] HASAN S, CURRY E. Word re-embedding via manifold dimensionality retention[C]// Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing, Stroudsburg, PA: ACL, 2017: 321-326.

[22] ZHAO D, WANG J, CHU Y, et al. Improving biomedical word representation with locally linear embedding[J]. Neurocomputing, 2021, 447: 172-182.

[23] ZHAO W, ZHOU D, LI L, et al. Manifold learning-based word representation refinement incorporating global and local information[C]// Proceedings of the 28th International Conference on Computational Linguistics. [S.l.]: International Committee on Computational Linguistics, 2020: 3401-3412.

[24] NASER MOGHADASI M, ZHUANG Y. Sent2Vec: a new sentence embedding representation with sentimental semantic[C]// Proceedings of the 2020 IEEE International Conference on Big Data. Piscataway: IEEE, 2020: 4672-4680.

[25] ZHAO D, WANG J, LIN H, et al. Sentence representation with manifold learning for biomedical texts[J]. Knowledge-Based Systems, 2021, 218: No.106869.

[26] BOMMASANI R, DAVIS K, CARDIE C. Interpreting pretrained contextualized representations via reductions to static embeddings[C]// Proceedings of the 58th Annual Meeting of the Association for Computational Linguistics. Stroudsburg, PA: ACL, 2020: 4758-4781.

[27] 韓程程,李磊,劉婷婷,等. 語義文本相似度計算方法[J]. 華東師范大學學報(自然科學版), 2020(5):95-112.(HAN C C, LI L, LIU T T, et al. Approaches for semantic textual similarity[J]. Journal of East China Normal University (Natural Science), 2020(5):95-112.)

[28] CER D, YANG Y, KONG S Y, et al. Universal sentence encoder for English[C]// Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing: System Demonstrations. Stroudsburg, PA: ACL, 2018: 169-174.

[29] CONNEAU A, KIELA D, SCHWENK H, et al. Supervised learning of universal sentence representations from natural language inference data[C]// Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing. Stroudsburg, PA: ACL, 2017: 670-680.

[30] 岳增營,葉霞,劉睿珩. 基于語言模型的預訓練技術研究綜述[J]. 中文信息學報, 2021, 35(9): 15-29.(YUE Z Y, YE X,LIU R H. A survey of language model based pre-training technology[J]. Journal of Chinese Information Processing, 2021, 35(9): 15-29.)

[31] ROWEIS S T, SAUL L K. Nonlinear dimensionality reduction by locally linear embedding[J]. Science, 2000, 290(5500): 2323-2326.

Sentence embedding optimization based on manifold learning

WU Mingyue1,2, ZHOU Dong1*, ZHAO Wenyu1,2, QU Wei1,2

(1,,411201,;2(),411201,)

As one of the core technologies of natural language processing, sentence embedding affects the quality and performance of natural language processing system. However, the existing methods are unable to infer the global semantic relationship between sentences efficiently, which leads to the fact that the semantic similarity measurement of sentences in Euclidean space still has some problems. To address the issue, a sentence embedding optimization method based on manifold learning was proposed. In the method, Local Linear Embedding (LLE) was used to perform double weighted local linear combinations to the sentences and their semantically similar sentences, thereby preserving the local geometric information between sentences and providing helps to the inference of the global geometric information. As a result, the semantic similarity of sentences in Euclidean space was closer to the real semantics of humans. Experimental results on seven text semantic similarity tasks show that the proposed method has the average Spearman’s Rank Correlation Coefficient, (SRCC) improved by 1.21 percentage points compared with the contrastive learning-based method SimCSE (Simple Contrastive learning of Sentence Embeddings). In addition, the proposed method was applied to mainstream pre-trained models. The results show that compared to the original pre-trained models, the models optimized by the proposed method have the average SRCC improved by 3.32 to 7.70 percentage points.

manifold learning; pre-trained model; contrastive learning; sentence embedding; natural language processing; Local Linear Embedding (LLE)

This work is partially supported by National Natural Science Foundation of China (61876062), Natural Science Foundation of Hunan Province (2022JJ30020), Scientific Research Project of Hunan Provincial Education Department (21A0319).

WU Mingyue, born in 1999, M. S. candidate. His research interests include natural language processing, deep learning.

ZHOU Dong, born in 1979, Ph. D., professor. His research interests include information retrieval, natural language processing.

ZHAO Wenyu, born in 1993, Ph. D. candidate. Her research interests include information retrieval, natural language processing.

QU Wei, born in 1991, M. S. candidate. Her research interests include source code summarization, natural language processing.

1001-9081(2023)10-3062-08

10.11772/j.issn.1001-9081.2022091449

2022?09?30;

2023?01?24;

國家自然科學基金資助項目(61876062);湖南省自然科學基金資助項目(2022JJ30020);湖南省教育廳科研項目(21A0319)。

吳明月(1999—),男,湖南婁底人,碩士研究生,CCF會員,主要研究方向:自然語言處理、深度學習; 周棟(1979—),男,湖南長沙人,教授,博士,CCF高級會員,主要研究方向:信息檢索、自然語言處理; 趙文玉(1993—),女,湖南衡陽人,博士研究生,CCF會員,主要研究方向:信息檢索、自然語言處理; 屈薇(1991—),女,湖南湘潭人,碩士研究生,CCF會員,主要研究方向:源代碼摘要、自然語言處理。

TP391.1

A

2023?02?01。