基于生成對抗網絡與多頭注意力的文本隱寫術*

黃 瑤,潘麗麗,熊思宇,蔣湘輝,馬俊勇

(中南林業科技大學計算機與信息工程學院,湖南 長沙 410004)

1 引言

香農將整個網絡空間的信息安全系統分為加密系統、隱私系統和隱藏系統。在保護信息安全的同時,加密系統和隱私系統也暴露了信息的存在性和重要性,這使得目標暴露給潛在的攻擊者,從而容易受到有針對性的攻擊。隱藏系統將秘密信息嵌入到特定的載體中,以確保信息安全。隱藏系統作為一種非常獨特的信息安全系統,在保障網絡空間安全方面發揮著重要作用。

在網絡空間中,有不同的載體可以用于信息隱藏,包括圖像[1,2]、音頻[3,4]、視頻[5,6]和文本[7-11]等,其中,文本作為人類交流最常用的一種載體,表達的信息非常豐富且使用頻率很高,很適合進行信息隱藏。因此,文本隱寫術的研究具有很高的實用價值。然而,由于文本的冗余信息量較少,隱藏文本中的信息具有一定的挑戰性。目前,文本隱寫術可以分為2種:基于文本修改的[9-11]隱寫術和基于文本生成的[7,8]隱寫術。基于文本修改的隱寫術主要是通過修改和替換不同粒度的文本內容來嵌入秘密信息,如采用同義詞替換來實現秘密信息嵌入,其特點是文字變化少,因此可以達到較高的隱蔽性。然而,由于文本信息的冗余度很小,基于文本修改的隱寫術難以達到很高的隱藏容量。基于文本生成的隱寫術可以根據秘密信息自動生成隱寫文本,具有更高的信息隱藏能力。然而,如何生成高質量的自然文本是基于生成的文本隱寫術面臨的一個關鍵問題。文獻[7]提出一種基于循環神經網絡的隱寫文本自動生成模型,首先從大量的正常文本中學習統計語言分布模型,然后生成符合這種統計模式的文本;在句子生成過程中,利用二叉樹對每個單詞的條件概率分布進行編碼,實現秘密信息隱藏,但該模型忽略了句子間的相關性,并且存在暴露偏差的問題,影響隱寫系統的安全性。

本文提出一種基于生成對抗網絡與多頭注意力的文本隱寫術TS-GANMA(Text Steganography based on Generative Adversarial Networks and Multi-head Attention)。在生成對抗網絡的對抗訓練中,多頭注意力得分參與計算獎勵,以優化文本生成器,解決隱寫過程中暴露偏差的問題,使生成的隱寫文本具有更好的隱蔽性。

2 相關工作

在早期階段,有些研究人員研究了基于規則的文本隱寫術。然而,這些方法遵循簡單的模式,難以保證生成的隱寫文本的語法正確性和語義流暢性。基于文本生成的隱寫術通常具有很高的隱藏容量,被認為是文本隱寫領域一個重要的研究方向。基于文本生成的隱寫術經歷了2個發展階段:基于馬爾可夫鏈的隱寫術和基于神經網絡的隱寫術。與基于文本修改的隱寫術不同,基于文本生成的隱寫術不需要預先給定載體,而是根據需要傳輸的秘密信息直接生成隱寫文本。基于馬爾可夫鏈的文本隱寫術主要利用馬爾可夫鏈的無記憶性和不變性對隨機過程建模,通過不同的狀態轉移映射成不同的秘密信息,實現秘密信息的隱藏[12,13]。然而,基于馬爾可夫鏈的隱寫術對長序列依賴不敏感,而這種不敏感會降低隱寫文本的生成質量。近年來隨著自然語言處理的發展,出現了越來越多的自動文本生成模型。基于神經網絡的文本隱寫術常用的語言模型有基于循環神經網絡RNN(Recurrent Neural Network)的生成模型[7]、基于變分自編碼器VAE(Variational Auto-Encoder)的生成模型[14]和基于Transformer的生成模型[15]等。Hochreiter等[16]提出的長短期記憶LSTM(Long Short-Term Memory)網絡可以很好地捕捉序列長期依賴。實驗表明LSTM隱寫術取得了更好的隱寫文本生成效果。Fang等[8]采用LSTM網絡作為語言模型,使用塊狀編碼對候選詞提前分塊,使得生成詞與秘密信息建立映射關系。

基于文本生成的隱寫術的性能很大程度取決于文本生成方法本身。生成自然、流暢、無偏見的文本是保證隱寫術安全性的前提。目前,大多數方法都使用最大似然估計MLE(Maximum Likelihood Estimation)訓練文本生成模型[7,17,18]。最大似然估計是一種常用的參數估計方法,其基本思想是在已知概率分布函數的情況下,通過觀測到的樣本數據,求解出該概率分布函數的未知參數的最優值。但是,這種訓練方法存在偏差暴露的問題,影響隱寫文本的生成質量。針對以上問題,本文提出了基于生成對抗網絡與多頭注意力的文本隱寫術TS-GANMA,在TS-GANMA對抗訓練中多頭注意力參與計算獎勵,將得到的獎勵信號用于更新生成器。通過該模型得到的文本生成器能夠生成高質量的隱寫文本。

3 TS-GANMA模型

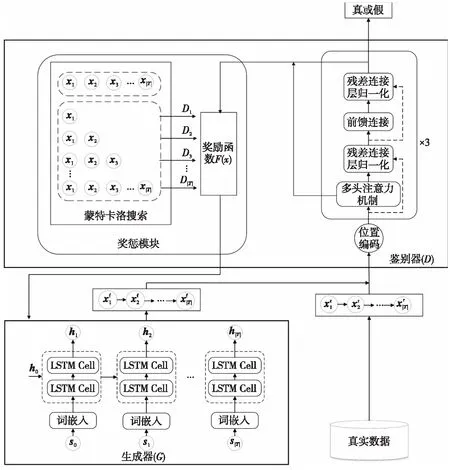

本節首先展示所提出的基于生成對抗網絡與多頭注意力的文本隱寫術TS-GANMA的總體結構。該方法包括1個基于雙層LSTM的生成器和1個基于Transformer的鑒別器;然后給出了生成器和鑒別器的詳細設計;最后介紹訓練過程中獎懲模塊和多頭注意力的作用。

3.1 總體結構

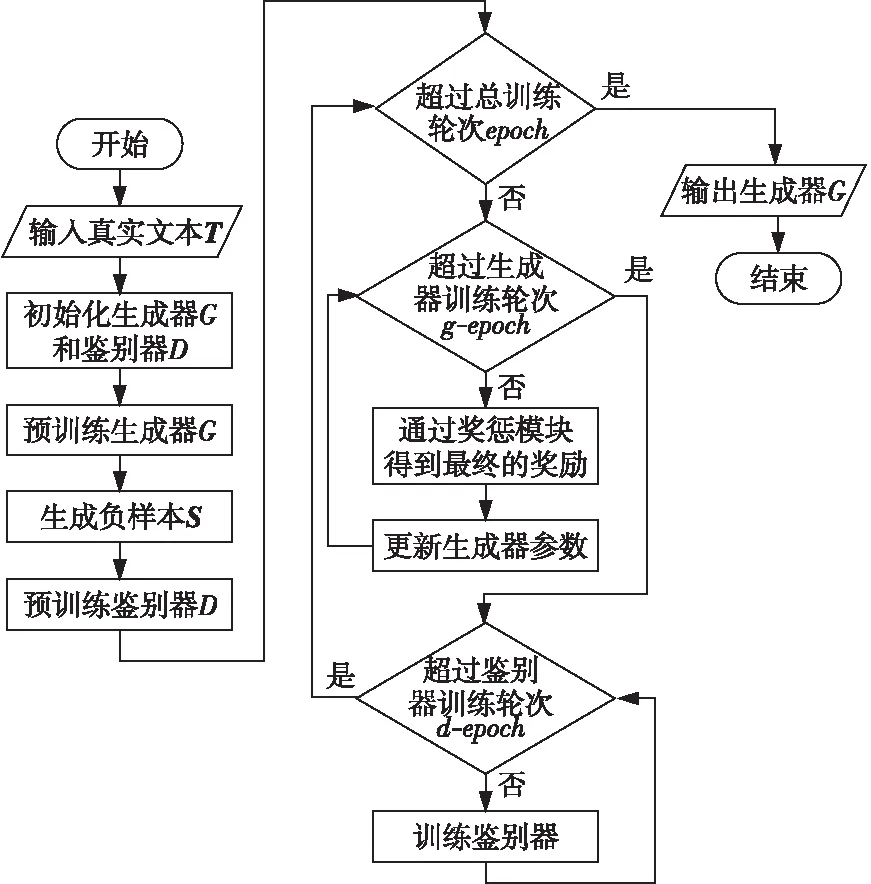

本文提出的基于生成對抗網絡的TS-GANMA結構主要包括1個生成器和1個鑒別器,如圖1所示。由于長短期記憶網絡(LSTM)對于時序信號具有較強的建模能力,本文選擇雙層LSTM作為生成器來增強整個網絡的建模能力。LSTM可以獲取每個時間步長的單詞概率,并將當前時間步長的輸出作為下一時間步長的輸入。訓練過程中,生成器生成大量生成文本,然后利用生成文本與真實文本對鑒別器進行訓練。因為Transformer具有強文本特征提取能力,本文使用基于Transformer的網絡作為鑒別器。在生成器訓練時預先設置訓練步數,通過生成器生成批量生成文本,再將生成文本送到鑒別器中,以獲得它們與真實文本的接近程度。然后使用分類概率和文本通過Transformer鑒別器得到的多頭注意力分數共同計算獎勵值,引導生成器繼續訓練。通過生成器和鑒別器對抗訓練,使兩者共同得到提升。算法1中給出了訓練的整個過程,圖2為算法1的流程圖。

Figure 1 Structure of TS-GANMA model

Figure 2 Flow chart of TS-GANMA model training

算法1TS-GANMA模型訓練

輸出:生成器G。

步驟1隨機初始化生成器G和鑒別器D;

步驟2輸入T,使用最大似然估計的方法預訓練生成器G;

步驟4輸入T和S,使用最小化交叉熵預訓練鑒別器D;

步驟5 forepochdo/*epoch表示訓練的總輪次*/

步驟6forg-epochdo/*g-epoch表示對抗學習時生成器訓練的輪次*/

步驟7將生成序列輸入到鑒別器D;

步驟8在每個時間步驟上,應用蒙特卡洛搜索抽樣,得到完整序列;

步驟9根據鑒別器D計算每個序列的對應的獎勵{D1,D2,D3,…,D|T|};

步驟10通過鑒別器D得到序列的多頭注意力得分和分類結果,輸入到獎懲模塊對獎勵再次更新,得到最終的獎勵;

步驟11根據最終的獎勵更新生成器G參數;

步驟12endfor

步驟13ford-epochdo/*d-epoch表示對抗學習時鑒別器訓練的輪次*/

步驟14使用當前的生成器G生成負樣本S和正樣本訓練鑒別器D;

步驟15endfor

步驟16endfor

步驟17returnG;

TS-GANMA運行模式如下:首先,通過生成對抗網絡訓練大量真實文本樣本,優化生成器;其次,利用訓練好的生成器自動生成文本,在生成過程中,通過對每個詞的條件概率分布進行編碼,嵌入秘密信息。

3.2 基于雙層LSTM的生成器

文本生成的結果可以建模為序列X=(x1,x2,…,xn)。本文主要利用LSTM對序列信號進行特征提取和建模,增加LSTM層以加強生成器對文本的序列信號的建模能力。生成器依次讀取序列的每個單詞,通過詞嵌入將單詞轉換為固定長度的單詞向量,并將其提供給雙層LSTM。對于LSTM層,輸入為當前t時刻單詞向量xt和t-1時刻的隱藏層狀態ht-1,輸出為Ot,基于雙層LSTM的生成器工作原理如式(1)所示:

(1)

其中,It表示輸入門,Ft表示遺忘門,Ot表示輸出門,Ct表示細胞狀態,ht表示隱藏狀態,W和b分別表示學習的權重和偏差;[·,·]表示矩陣連接,tanh(·)表示激活函數。

t時刻的輸出為ht和Ot,ht作為t+1時刻的隱藏狀態繼續參與下一個操作,Ot作為輸出發送到生成器的下一個全連接層。全連接層的Softmax可以將概率進行投影得到向量St=(St1,St2,…,Stq),其中,Stj(1≤j≤q,q表示訓練集文本中獨一無二單詞的數量)表示單詞uj出現在序列中t時刻位置的條件概率,具體如式(2)所示:

Stj=S(uj|u1,u2,…,uj-1)

(2)

TS-GANMA會以一定的概率抽樣結果或選擇概率最高的值作為文本序列的下一個元素,迭代完成整個文本序列的生成。

3.3 基于Transformer的鑒別器

鑒別器的主要作用是判斷輸入文本是真實的文本還是生成的文本。由于Transformer可以從不同的粒度提取文本的特征,本文采用Transformer的編碼器作為鑒別器,以增強網絡的鑒別能力。通過Transformer中的多頭注意力機制得到鑒別序列更豐富的文本數據特征,將得到的多頭注意力分數運用到后續的獎勵計算。鑒別器的輸入是由n個單詞組成的完整文本序列X=(x1,x2,…,xn),序列從生成器生成的文本或者真實文本中獲得。鑒別器的第1層為嵌入層,將序列中的每個單詞轉換為1個單詞向量,從而形成1個單詞向量矩陣x,然后將單詞向量矩陣x輸入到Transformer層,輸出通過全連接層和激活函數生成,最后可以得到正常文本的預測概率。鑒別器的損失函數如式(3)所示:

(3)

本文在鑒別器中加入了的Dropout機制,防止網絡過擬合。

3.4 獎懲模塊

生成對抗網絡是用來生成實值連續數據的,不能直接生成離散的標記序列。TS-GANMA模型通過損失梯度指導生成器參數進行“輕微變化”,使得生成的實值連續數據具有離散的效果,與真實數據的相似度更高。如果生成的數據是基于離散標記的,鑒別器的“輕微變化”指導就沒有意義。這是因為在有限的字典空間中可能沒有對應的標記表示這種“輕微變化”,不能使用損失函數直接更新生成網絡參數。因此,本文使用強化學習的方法,并使用獎勵作為生成網絡損失函數來更新生成網絡。目標函數定義如式(4)所示:

(4)

(5)

其中,F(·)表示獎懲函數,Z表示由鑒別器得到的分類概率,W表示多頭注意力得分權重。

生成器的訓練目的是最大化目標函數,使得鑒別器判別生成器生成的文本為真實文本。但是,鑒別器通常只能為一個完整的序列進行鑒別。因此,在獎懲函數計算中需要關注的是一個長期的累積獎勵,在每個時間步驟上,應用蒙特卡洛搜索抽樣未知的后續單詞。搜索過程如式(6)所示:

(6)

其中,x1:|T|表示搜索出的整個文本序列,cl表示當前序列的長度,N表示搜索的次數。

對于一個不完整的序列,本文選擇一個與生成器共享參數的網絡進行采樣搜索;通過采樣補充序列的后續部分,形成一個完整的序列,然后通過鑒別器進行鑒別得到分類概率。當前序列長度為cl時,鑒別器得到的分類概率的計算方法如式(7)所示:

(7)

其中,|T|表示完整序列的長度。

使用鑒別器估計的概率作為獎懲模塊的一個基本獎勵。通過鑒別器得到的一個基本獎勵輸入到獎勵函數中,并將多頭注意力的得分和序列分類結果輸入到獎勵函數,得到最終的獎勵。由于序列的長度會使得注意力得分過大或過小,通過數學縮放的方法,可以在不改變數據之間大小關系的情況下縮放數據。因此,本文采用數學縮放方法對多頭注意力得分進行縮放,得到的結果為多頭注意力得分權重W如式(8)所示:

(8)

其中,AS表示多頭注意力得分,down表示區間的大小,up表示區間的下限。

鑒別器得到的分類概率Z和多頭注意力得分權重W傳入到獎懲模塊,應用獎勵函數F(·)得到最終的獎勵,如式(9)所示:

(9)

其中,CR表示完整序列的分類概率。

最后得到的獎勵為最終獎勵,通過獎勵對生成器反饋進行參數更新。設置學習率為a,生成器的參數更新如式(10)所示:

θ←θ+a?θJ(θ)

(10)

目標函數的J(θ)梯度可以導出式(11):

?J(θ)=

(11)

4 實驗與結果分析

4.1 實驗設置

本文實驗基于TensorFlow和Python進行,使用NVIDIA?GeForce?GTXTM2070 GPU和CUDA10.0加快模型訓練。詞向量的維度設置為32,生成器的隱藏單元數目設置為32,學習率設置為0.001。本文選擇Adam優化器,Dropout設置為0.5。生成器的預訓練使用最大似然的方法訓練,訓練輪次為80,鑒別器預訓練輪次為80,對抗學習輪次為100。

本文使用Image COCO和EMNLP WAMT17文本數據集作為真實文本樣本。Image COCO是用于圖像字幕的文本數據集,本文去掉句子長度小于10的樣本,然后隨機選取10 000個樣本作為訓練數據。EMNLP WMT17是一個用于機器翻譯的文本數據集,本文選取其中的英語新聞數據,去除長度小于15的句子和低頻詞,并隨機選取10 000個樣本作為訓練數據。

4.2 評價指標

隱寫術的目的是隱藏信息,以保證重要信息的安全。因此,嵌入容量是一個隱寫系統的重要評估標準。嵌入容量用嵌入率來衡量,嵌入率定義為每個單詞可嵌入的秘密比特的平均數量,具體計算方法如式(12)所示:

(12)

其中,Num表示生成句子的數量,Kdi表示第di個句子嵌入的比特數,Ldi表示第di個句子的長度。

為了測試TS-GANMA模型的對抗學習對生成文本質量的提升效果,本文定義一個隨機初始化的LSTM網絡作為樣本生成器,模型訓練的目的是使生成器生成的樣本盡可能接近樣本生成器生成的樣本。本文采用似然損失作為衡量它們相似性的指標,具體計算方法如式(13)所示:

NLLoracle=

(13)

其中,Goracle(·)表示樣本生成器,Gθ(·)表示目標生成器。

BLUE評分作為評分標準來衡量生成文本和人工文本之間的相似程度[19]。BLUE分數越高說明生成文本與真實文本越相似。高階的n-gram用于衡量句子的流暢性,NN表示n-gram的階數,通常取2~5,具體計算方法如式(14)所示:

(14)

其中,BP(Brevity Penalty)表示過短懲罰,句子越短,BP越接近0;Wdn表示權重;Pdn表示n-gram的精度。

為了保證隱寫文本的隱蔽性,隱寫文本分布與真實數據分布的統計差異要更小。本文使用自然語言處理中的句子質量測試標準度量困惑度ppl(perplexity)作為評價指標,值越小表示生成的文本質量越高,具體計算方法如式(15)所示:

(15)

其中,Num表示生成句子的數量,pci(x1,x2,…,xn)ci表示第ci個句子中的單詞概率。

4.3 實驗結果分析

為了驗證TS-GANMA模型的有效性,本節從文本質量、嵌入率等方面將其與主流隱寫模型進行比較。本文隨機初始化LSTM網絡為Oracle,作為真實模型。通過Oracle生成10 000個長度為20的序列作為真實樣本,分別使用最大似然估計MLE訓練生成器Gα和使用基于TS-GANMA的方法訓練生成器Gβ,其中Gα和Gβ的網絡結構完全相同,兩者學習曲線如圖3所示。

Figure 3 TS-GANMA and MLE training loss

圖3前80個輪次兩者都是使用最大似然估計的方法訓練生成器,因此損失值很接近,穩定在9.85左右。從第81個輪次開始,TS-GANMA模型進行100個輪次的對抗訓練,損失值明顯減少,最終穩定在9.30左右。而MLE的方法損失還是保持在9.85左右。說明TS-GANMA模型能生成更符合Oracle樣本概率空間的序列,提高了生成文本的質量。

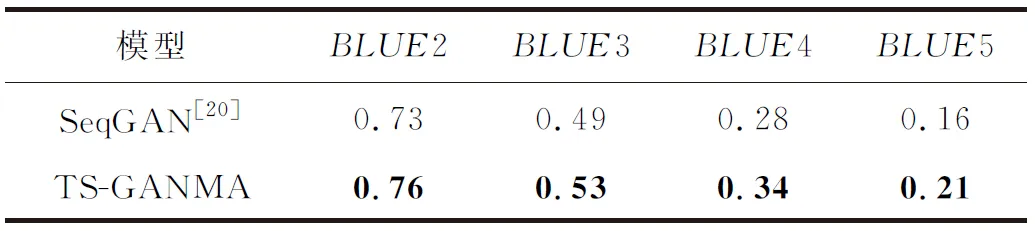

本文還在真實數據上測試TS-GANMA模型的性能,對比TS-GANMA模型與SeqGAN (Sequence Generative Adversarial Nets)模型[20]在Image COCO文本數據集上的BLUE分數,結果如表1所示。

Table 1 Comparison of BLUE fractions of different models

根據表1得知,TS-GANMA模型的BLUE2~BLUE5分數優于SeqGAN模型的。高階BLUE分數能體現整個文本的質量,TS-GANMA模型的BLUE4分數和BLUE5分數相較于SeqGAN分別提高了0.06和0.05,表明本文模型能夠提升生成文本的質量。TS-GANMA模型通過多頭注意力提取了更豐富的文本特征,并且將多頭注意力得分參與獎勵的計算,得到更利于生成器的反饋信息,優化文本生成器。因此,TS-GANMA模型生成的句子質量更高,更接近真實文本。

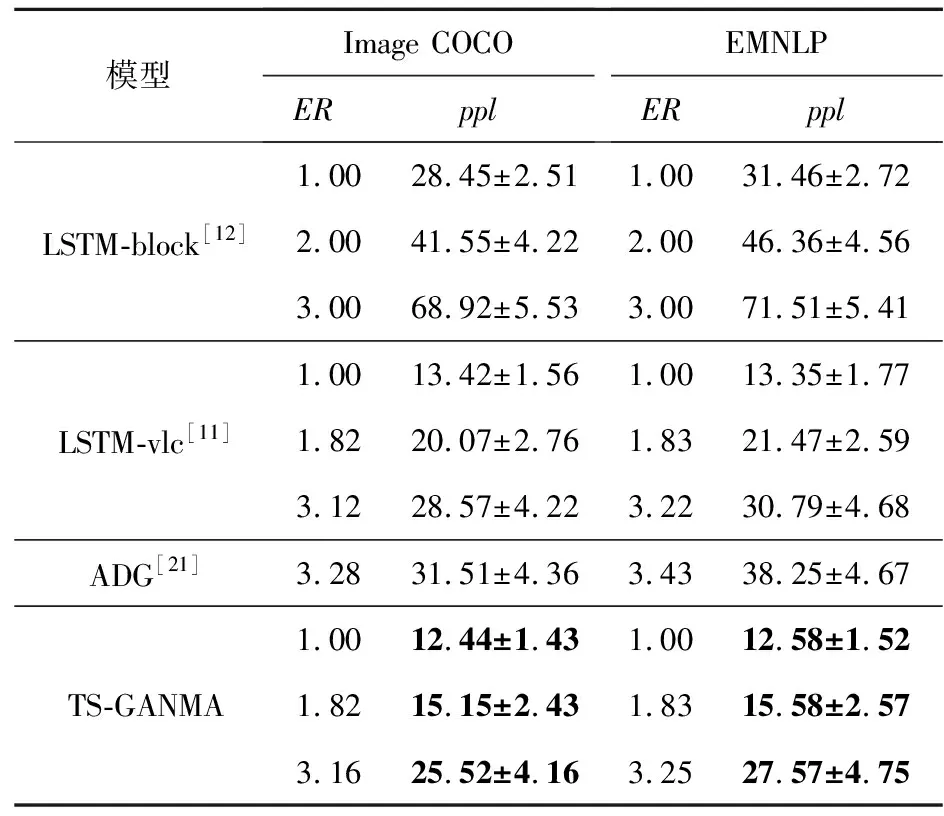

將本文提出的隱寫術TS-GANMA與主流隱寫術進行對比,包括LSTM-block[12]、LSTM-vlc[11]和ADG(Adaptive Dynamic Grouping)[21]。本文模型主要通過在生成文本的過程中對每個詞的條件概率分布進行編碼來實現信息隱藏。本文采用一種非定長編碼[7],首先對生成的候選詞的條件概率進行非定長編碼;然后根據秘密信息的二進制序列選擇對應的編碼候選詞,生成隱寫文本。基于每個文本數據集分別訓練生成器,使用每個生成器生成500個句子,通過隨機生成的0、1比特流指導生成不同嵌入率的隱寫文本。不同隱寫模型獲得的困惑度的均值和標準差如表2所示。在表2的ppl列中,當ER=1.82時,TS-GANMA隱寫術在數據集Image COCO上的均值和標準差分別為15.15和15.15±2.43。

Table 2 Mean and standard deviation of confusion degree of different steganographic models

由表2可知,對于每個文本數據集,隨著嵌入率ER的增加,困惑度均值逐漸增加,文本質量降低。因為嵌入的比特數增加會使得候選詞增加,影響詞的選擇,導致生成的詞不連貫。從實驗結果可知,在不同嵌入率下,TS-GANMA隱寫術的困惑度相比其它隱寫術的困惑度都低。在相同嵌入率,對比基于LSTM的經典隱寫術LSTM-block和LSTM-vlc,TS-GANMA的困惑度分別下降50%~60%和7%~10%;對比ADG,TS-GANMA的困惑度下降了20%左右。從表2可以發現,LSTM-block隱寫術的困惑度較高,這主要是因為該方法隱寫生成的文本不連貫。TS-GANMA隱寫術雖然與LSTM-vlc隱寫術采用了相同的編碼方法,但是TS-GANMA相比LSTM-vlc更進一步降低了隱寫文本的困惑度,這是因為TS-GANMA利用生成對抗網絡有效地解決了暴露偏差的問題。此外,TS-GANMA隱寫術利用多頭注意力得分參與獎勵計算,優化了文本生成模型,使得生成的文本分布更接近真實的文本分布,從而進一步提升了隱寫文本的質量。

5 結束語

本文提出了一種基于生成對抗網絡與多頭注意力的文本隱寫模型,該模型能夠自動生成高質量的隱寫文本。在對抗訓練過程中,將鑒別器得到的獎勵信息反饋給生成器,引導生成器生成與真實文本一致的文本,能夠解決文本隱寫過程中暴露偏差的問題。同時,本文將多頭注意力得分參與獎勵計算,得到的文本生成模型能夠生成高質量的隱寫文本。實驗表明,TS-GANMA模型可以進一步減少在最大似然估計訓練下已經收斂的生成器的損失,優化文本生成模型。通過對比主流隱寫模型生成的句子的困惑度,驗證了在不同隱寫嵌入率下生成隱寫文本時,TS-GANMA模型生成的隱寫文本更擬合真實文本的分布,可以保證隱寫任務的隱蔽性和安全性。