基于輕量化卷積神經網絡的蘋果表皮損傷分級研究

付夏暉 王菊霞 崔清亮 張燕青 王毅凡 陰妍

DOI:10.13925/j.cnki.gsxb.20230213

摘? ? 要:【目的】蘋果在銷售過程中,其表皮的損傷情況會直接影響果實的經濟價值。運用相機采集蘋果表皮的損傷圖像,對獲取到的圖像進行分類和數據預處理,基于遷移學習的方法對蘋果表皮損傷進行直接分級研究,為提高蘋果表皮損傷分級效率進而更好地指導蘋果采收后的分類售賣提供理論依據。【方法】首先對采集到的富士和丹霞兩個蘋果品種圖像進行對比度調整、旋轉、翻轉、添加噪聲等11種批量操作,將數據集擴充到9360張,同時對擴充后的樣本集統一調整為224×224像素。針對預處理好的數據集,選取5種20 MB以下的輕量化卷積神經網絡在相同超參數設置條件下進行初始化訓練、引入遷移學習訓練以及在遷移學習基礎上增加凍結網絡層權重3種方法進行訓練對比。【結果】5種網絡初始化訓練后的測試精度僅為56.32%~71.98%;基于遷移學習的MobileNet-v2模型最終訓練精度達99.04%,在輕量級卷積神經網絡中,比表現性能最差的EfficientNet-b0模型最終訓練精度高18.79%;在基于遷移學習的MobileNet-v2模型基礎上凍結不同模塊參數,得出模型選擇凍結至第1個卷積模塊到Bottleneck 3-1模塊時均可在縮短模型訓練時間的基礎上提高模型驗證精度,其中在凍結到Bottleneck 3-1模塊時比基于遷移學習的MobileNet-v2模型訓練時間縮短了29.32%,同時驗證精度提高了0.93%,測試精度提升了1.12個百分點達91.58%,檢測單張圖片所用平均時間為0.14 s,網絡大小為8.15 MB,可以滿足快速識別需求。【結論】基于遷移學習加凍結訓練的MobileNet-v2模型具有較好的魯棒性和分級性能,可為移動終端和嵌入式設備在蘋果損傷直接分級方面提供技術參考。

關鍵詞:蘋果表皮;損傷分級;輕量化;遷移學習;凍結訓練

中圖分類號:S661.1 文獻標志碼:A 文章編號:1009-9980(2023)10-2263-12

Research on apple epidermal damage grading based on lightweight convolutional neural network

FU Xiahui, WANG Juxia*, CUI Qingliang, ZHANG Yanqing, WANG Yifan, YIN Yan

(College of Agricultural Engineering, Shanxi Agricultural University, Taigu 030801, Shanxi, China)

Abstract: 【Objective】 In the process of apple selling, the damage of its epidermis will directly affect the economic value of the fruit. The presence and severity of apple surface damage directly affect the sales link, and customers often care about the epidermis damage when choosing apples. At present, most studies focus on apple size, color and appearance classification, and the use of high-end instruments to detect the damage inside the apple, while the study on the direct classification of surface damage is rare. The camera was used to collect apple epidermis damage images, classify and preprocess the acquired images, and conduct a direct classification on apple epidermis damage based on transfer learning method, which can provide a theoretical basis for improving the classification efficiency of apple epidermis damage and guiding the classification and apple sale after harvesting. 【Methods】 Firstly, the camera was used to collect the top, side and bottom images of Fuji and Danxia apples to form the first-stage data set. Then, 11 batch of operations, such as contrast adjustment, rotation, flip and noise addition, were carried out to expand the data set to 9360 pieces to form the second-stage data set. At the same time, the expanded sample set was uniformly adjusted to 224×224 pixels to form the final data set. According to the ratio of 7∶3∶3, the preprocessed data set was divided into training set, verification set and test set. Five lightweight convolutional neural networks less than 20 MB, MobileNet-v2, SqueezeNet, ShuffleNet, NASNet-Mobile and EfficientNet-b0, were selected for initial training, introduction of migration learning training and migration learning under the same super-parameter Settings On a Bottleneck basis, and three methods were added for detailed freezing network layer weights (the MobileNet-v2 network structure is specifically divided into 21 modules for freezing training, which contain 3 convolutional modules, 1 average pooling module, and 17 Bottleneck modules). 【Results】 The test accuracy of the five kinds of networks after initial training was only 56.32%-71.98%. The final training accuracy of MobileNet-v2 model based on transfer learning was 99.04%, 18.79% higher than that of the worst EfficientNet-b0 model among lightweight convolutional neural networks. After freezing different module parameters on the basis of the MobileNet-v2 model were based on transfer learning, it was concluded that models Bottleneck 3-1, when they select to freeze to the first convolutional module, can shorten model training time and improve model validation accuracy. When Bottleneck 3-1 module was frozen, the training time for Bottleneck 3-1 was shortened by 29.32% compared to MobileNet-v2 model based on transfer learning, the verification accuracy increased by 0.93%, and the test accuracy increased by 1.12 percentage points to 91.58%. The average time for detecting a single image was 0.14 s. The network size was 8.15 MB, which can meet the requirements of fast identification. The final training loss value of the MobileNet-v2 model based on transfer learning was less than 0.04, which was 0.5 lower than that of the worst performing EfficientNet-b0 model in lightweight convolutional neural networks. The test results showed the recall rate and precision rate of MobileNet-v2 confusion matrix diagram based on transfer learning and five kinds of lightweight convolutional neural networks were based on transfer learning in the test set. Among them, the MobileNet-v2 model based on transfer learning had the best performance, and the recall rate of 6 types of data in the test set ranged from 89.40% to 100%. The precision ranged from 53.52% to 99.78%. The Grad-CAM visualization comparison of the trained network showed that the SqueezeNet model based on transfer learning had the worst visualization effect and the lowest recognition accuracy. The visualization effect of NASNet-Mobile model based on transfer learning was poor. It can only display a large range of concern areas, and the recognition degree of some pictures was not high. The visualization effect of the MobileNet-v2 model based on transfer learning was obviously better than the previous two models, but the key areas identified by the model were different from the reality. A MobileNet-v2 model based on transfer learning tended to have the best visualization effect on a network that was Bottleneck 3-1 when it was frozen to a Bottleneck 3-1 module, and the key areas identified by the model had the highest compatibility with the actual situation. 【Conclusion】 In this study, five kinds of lightweight models with Bottleneck 3-1 were selected for initialization training and transfer learning training, and it was concluded that MobileNet-v2 model with transfer learning had the best effect. Then, the freezing strategy was used for hierarchical training. The verification accuracy reached 92.23% when Bottleneck 3-1 was frozen. The test accuracy was 91.58%, the average recognition time was 0.14 s, and the network size was 8.15 MB, which can provide technical reference for mobile terminals and embedded devices in the direct classification of apple fruit damage.

Key words: Apple epidermis; Damage classification; Lightweight; Transfer learning; Freezing training

蘋果作為人類膳食營養的重要來源之一,其含水量高,口感酸甜,具有促進食欲、降低心血管疾病及冠心病發病率等功效,深受大眾喜愛[1]。蘋果的品質直接決定著果實的價格和銷量,但蘋果在采摘、運輸、包裝和售賣等環節中會存在不同程度的擠壓、摩擦、碰撞,導致蘋果表皮發生不同程度的損傷[2]。損傷是影響蘋果品質的重要因素之一,蘋果表面損傷產生缺陷后,缺陷部位會加速腐爛,散發出更多的催熟激素,造成整批次蘋果品質的降低[3]。蘋果損傷的檢測方法,一方面常用人工的方法來辨別蘋果的損傷等級,使得分級穩定性較差且不明確[4];另一方面采用光譜儀器、紅外熱成像儀等高端設備對損傷進行檢測,檢測成本相對較高。因此,研發蘋果表皮快速、低成本、高精度的損傷直接分級檢測方法,為豐富蘋果表皮品質檢測方法提供技術參考,同時對減少商家損失、優化蘋果售賣品質等方面具有深遠的意義。

國內外學者在蘋果的損傷檢測和分級方面進行了大量研究,研究主要采用光譜儀器、紅外熱成像儀、磁共振分析儀等高端設備對蘋果的損傷進行檢測。在利用光譜儀器研究方面,沈宇等[5]和蔣金豹等[6]運用高光譜儀器分別基于特征波段和高光譜端元完成對蘋果表面的輕微損傷進行無損檢測,檢測正確率均在90%之上;Lu等[7]開發了一種基于液晶可調諧濾光片的多光譜成像系統用于蘋果損傷檢測,總體檢測誤差為11.7%~14.2%;Keresztes等[8]研發了一種基于HSI的短波紅外蘋果早期傷痕實時檢測系統,能夠同時檢測30個蘋果的早期損傷,識別準確率達到了98%;邵志明等[9]利用近紅外相機和閾值分割法對蘋果圖像進行分割和缺陷提取達到損傷檢測目標,對即時損傷和損傷0.5 h的判別準確率均超過90%;Fan等[10]提出了一種基于Yolo v4深度學習算法和近紅外圖像的蘋果缺陷檢測方法,在每秒檢測5個蘋果基礎上將平均檢測準確率提升至93.9%。在運用紅外熱成像儀研究方面,門洪等[11]借助紅外熱像儀采集蘋果的損傷樣本圖片,根據蘋果不同部位和損傷的溫差范圍研究其識別方法,其中輕微損傷和重度損傷分別在1.3~2.6 ℃和2.6~3.2 ℃之間;周其顯[12]針對蘋果熱力學圖像的不同區域溫度和降溫曲線兩方面特性進行分析,從傳熱學角度檢測蘋果的早期損傷,缺陷判別準確率為87.5%。在利用磁共振分析儀檢測蘋果表皮損傷方面,熊婷[13]運用低場核磁共振加權像和圖像偽彩色處理技術,結果表明,在重復時間為1500 ms、回波時間為200 ms時得到的T2加權像可正確檢測蘋果的表皮損傷。

近年來,神經網絡被大量研究者運用到農作物的智能識別當中。為提高北方日光溫室番茄產量預測結果,尹義志等[14]利用小波神經網絡預測溫室番茄產量,模型預測結果與實際產量平均相對誤差僅1.02%;針對番茄生產中作業背景復雜、枝葉遮擋、光照分布不均勻的問題,陳新等[15]將MobileNetV3模塊引入SSD(single shot multibox detector)算法中,相比原始SSD算法,番茄花果的平均識別率提高了7.9%;為提高蘋果損傷判別度,寧景苑等[16]通過自主搭建的弛豫光譜采集系統采集光譜信號,使用標準正態變量交換算法(standard normal variable transformation,SNV)優化光譜數據,基于反向傳播神經網絡算法構建蘋果損傷檢測模型對蘋果機械損傷進行檢測,準確率達91.48%;針對現有蘋果損傷檢測儀器價格高、體積大的問題,Ning等[17]提出基于松弛單波長激光和卷積神經網絡的富士蘋果損傷檢測方法,預測準確率達93%;為提高蘋果產品質量和生產效率,Ismail等[18]研究詞袋(bag-of-words,BOW)、空間金字塔匹配(spatial pyramid matching,SPM)和卷積神經網絡(convolutional neural networks,CNN)三種圖像識別方法用于蘋果表皮缺陷的識別和分級,基于支持向量機的空間金字塔匹配算法最優,識別準確率達98.15%。

消費者在購買蘋果時會著重挑選無傷和輕微損傷的蘋果,因而蘋果表皮的損傷情況會直接影響其售賣環節的經濟效益。目前針對蘋果的檢測和分級研究主要是采用高端昂貴儀器對蘋果的損傷進行檢測,對蘋果表皮損傷進行直接檢測分級的研究較少。鑒于上述研究,筆者在本研究中提出一種基于遷移學習的蘋果表皮損傷分級方法。首先使用相機采集蘋果表皮的早期損傷圖像,然后對獲取到的圖像進行分類和數據預處理,最后選擇輕量化的卷積神經網絡MobileNet-v2,運用遷移學習和凍結訓練技術訓練模型,完成蘋果表皮損傷分級,提升蘋果表皮損傷的分級效率,并為表皮損傷檢測方面的移動終端和嵌入式設備提供技術參考。

1 材料和方法

1.1 圖像采集

我國蘋果品種評價標準中的蘋果等級規格把果面缺陷分為3類:極輕微、輕微和有部分缺陷,而在歐盟的蘋果等級標準中進一步說明了果面輕微缺陷的指標:輕微瘀傷面積不超1 cm2,條狀缺陷不超2 cm,其他缺陷總面積不超1 cm2 [19]。筆者在本研究中以歐盟蘋果等級標準為基礎,極輕微缺陷代表無傷,有輕微缺陷代表輕傷,超過輕微缺陷標準代表重傷。

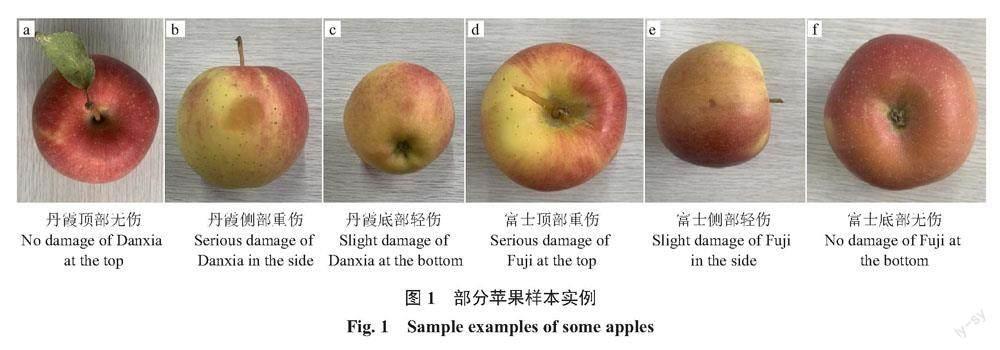

試驗蘋果全部來自于山西省農業科學院果樹研究所,選取丹霞和富士2個品種。圖像采集設備為iPhone Xs Max,考慮圖像多樣性,采集蘋果頂部、側部、底部3個方位圖像,分為丹霞無傷185張、丹霞輕傷131張、丹霞重傷121張、富士無傷164張、富士輕傷157張、富士重傷圖像22張,共780張,圖像分辨率為3024×3024像素,格式為png,2個品種蘋果部分樣本實例如圖1所示。

1.2 圖像預處理

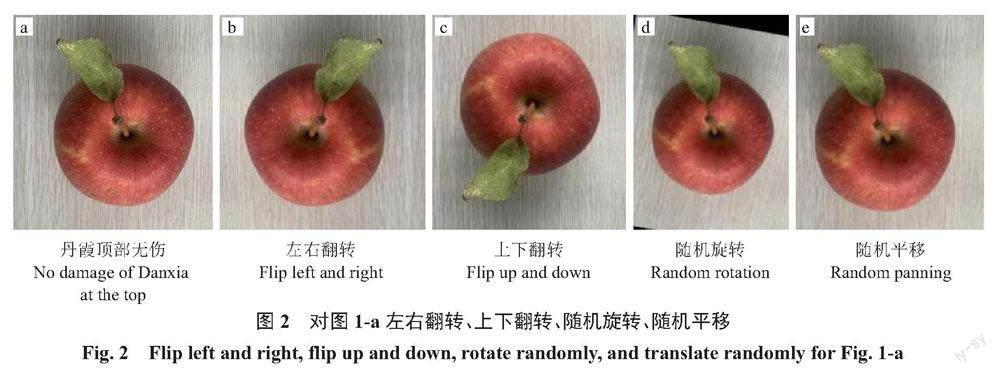

由于初始數據樣本量較少,為防止模型訓練發生過擬合,對初始采集的780張圖像統一進行左右翻轉、上下翻轉、隨機旋轉、隨機平移、調整對比度、加入高斯噪聲和椒鹽噪聲等操作將圖像擴充至9360張。

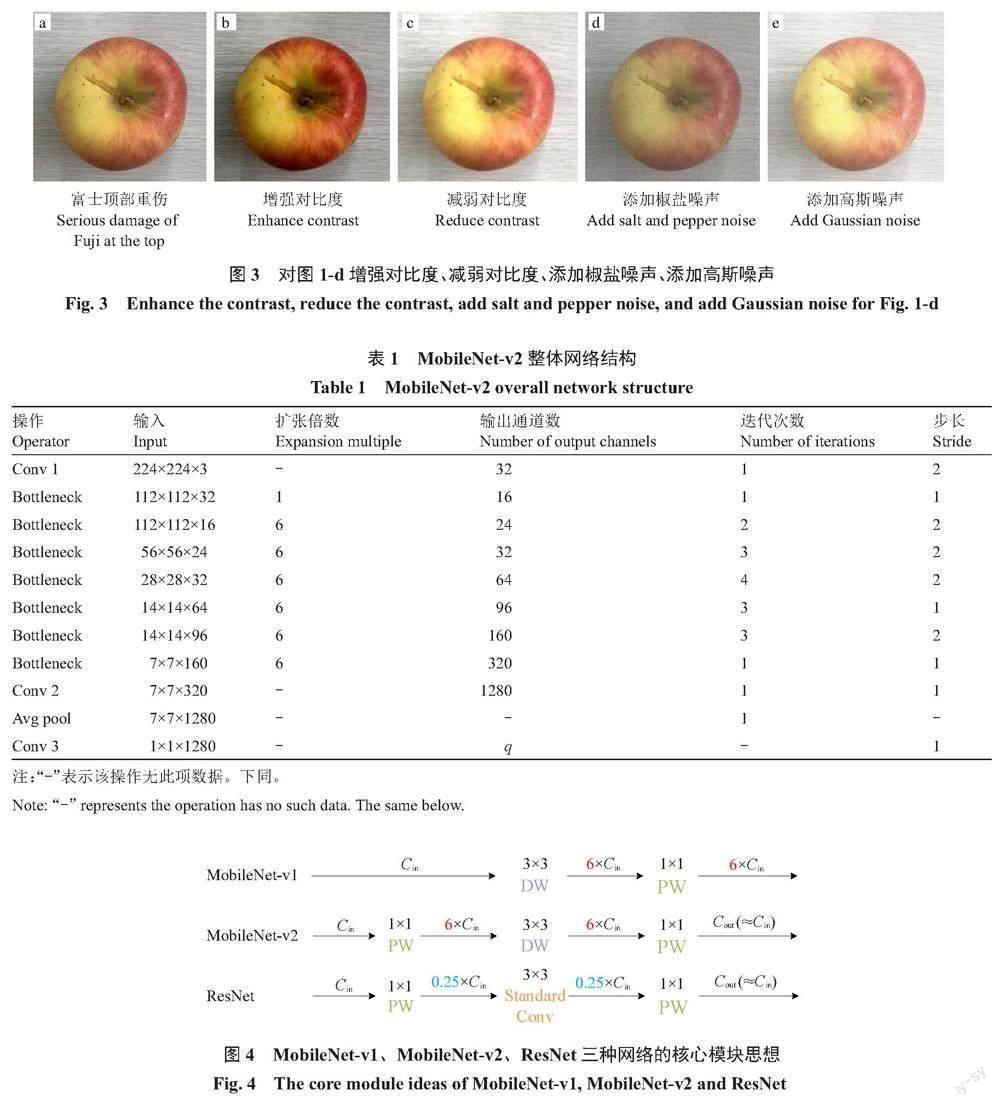

在總體樣本集中,適當增加驗證集和測試集的比例,使用自編函數批量隨機抽取圖像,將訓練集、驗證集和測試集劃分為7∶3∶3,使得驗證結果和測試結果更可靠,具體數量分別為5040幅、2160幅、2160幅。如圖2所示,對圖1-a丹霞頂部無傷圖像進行左右翻轉、上下翻轉、隨機旋轉、隨機平移4個操作;對圖1-d富士頂部重傷圖像增強對比度、減弱對比度、添加椒鹽噪聲、添加高斯噪聲,得到的圖像如圖3所示;同時為適應模型訓練,將擴充后的圖像樣本全部調整為224×224像素。

1.3 模型構建

1.3.1 MobileNet-v2整體網絡結構 MobileNet-v2網絡由標準卷積、全局平均池化以及大量的瓶頸結構構成[20](表1),其中q代表分類數,在本試驗中分類數為6。

1.3.2 倒殘差結構(瓶頸結構) 圖4為MobileNet-v1、MobileNet-v2以及ResNet三種網絡的核心模塊思想。由圖4可知,Cin為輸入通道數,Cout為輸出通道數,DW為深度卷積,PW為逐點卷積,Standard Conv為標準卷積。

MobileNet-v1網絡于2017年問世,其主要思想是采用深度可分離卷積(depthwise separable convolution)來縮減參數量和運算量,而在結構上沒有采用殘差思想[21]。ResNet模型的殘差結構,運用1×1的卷積核對輸入矩陣先降維再升維[22],但在MobileNet-v2模型中,采用與ResNet模型相反的倒殘差結構,先升維,提取特征后再降維。MobileNet-v2模型維度的波動類似瓶頸,所以其倒殘差結構也稱為瓶頸結構[23-24];MobileNet-v2倒殘差結構分為兩種形式(圖5),當輸入與輸出大小相同且步長為1時,將輸入與輸出通過一條殘差邊(shortcut)相連進行直接相加;當步長為2時不使用殘差邊連接。

1.3.3 遷移學習 通過遷移學習[25],在ImageNet數據集上訓練得到的預訓練網絡,確立目標任務為蘋果表皮損傷分級,使源領域的知識通過蘋果數據集和MobileNet-v2網絡得到重用,完成對蘋果表皮的損傷分級。在基于遷移學習的MobileNet-v2模型基礎上引入目標檢測任務中的凍結訓練策略[26],比較凍結不同網絡層參數在訓練后的效果。

1.3.4 評價指標 選擇識別準確率(accuracy)、精確率(precision)、召回率(recall)、損失值(loss)、訓練時間(training time)、識別時間(recognition time)以及網絡大小(network size)作為模型訓練結果的評價指標。

準確率A是指識別圖像結果中識別正確的數量占整體識別數量的比重,能夠直接表達模型的訓練效果[27];精確率P代表結果中對正樣本的預測準確程度;召回率R是以真實類為基礎,正樣本中被正確識別的比例[28]。其運算公式為:

A=[Tp+TnTp+Tn+Fp+Fn],? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ?(1)

P=[TpTp+Fp],? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? (2)

R=[TpTp+Fn]。? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? (3)

其中:Tp為正樣本被模型識別正確的數量;Tn為負樣本被模型識別正確的數量;Fp代表被模型預測為正樣本實際為負樣本的數量;Fn代表被模型預測為負樣本實際為正樣本的數量。

損失值L能夠表現出模型預測值與真實值之間的偏差情況,損失值小,表明模型的預測值與真實值之間相近,反之則相遠[29],其運算公式為:

L=-[1m][ilogefijefi]。? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? ? (4)

其中:i表示對應樣本;yi表示第i個樣本對應的標簽;j是求和變量;m是樣本總量;f為模型輸出函數。

訓練時間指模型訓練完成所需時間;識別時間具體表示檢測單張圖片平均所用時間;網絡大小為訓練完成后所得網絡占用的空間。

1.3.5 試驗環境 試驗所用計算機版本為Windows 10專業版;CPU為Intel酷睿i7-7700HQ,頻率為2.80 GHz;16 GB運行內存;系統類型為64位操作系統,基于x64的處理器;NVIDIA GeForce GTX 1050 Ti顯卡,4 GB顯存。模型訓練環境為MATLAB R2021b版本。

1.3.6 超參數設置 試驗統一超參數設置,網絡訓練采用帶動量的隨機梯度下降法(stochastic gradient descent with momentum,SGDM),動量因子(momentum)設為0.90;尺寸大小(batch size)設為16,使用L2正則化,正則化參數λ=0.000 5;遷移學習需要保留預訓練網絡中遷移層的權重,降低學習速率,可將初始學習速率(initial learning rate)設為較小的值0.000 1;考慮數據集體量較小以及進行遷移學習時所需的訓練輪數(epoch)相對較少,將訓練輪數設為20,同時采用每輪打亂一次的數據打亂策略;因訓練周期中每輪的迭代次數(iteration)為314,將驗證頻率(validation frequency)也設置為同樣大小,即每314次迭代驗證1次。

2 結果與分析

2.1 5種輕量級模型對比

為了使試驗結論更具有說服力,選擇具有代表性的適合于移動終端和嵌入式設備的MobileNet-v2、SqueezeNet、ShuffleNet、NASNet-Mobile及EfficientNet-b0共5種20 MB以下的輕量級模型,首先在相同超參數設置的條件下進行初始化訓練得出5種模型的測試精度在56.32%~71.98%之間,難以滿足分級需求,所以繼續利用遷移學習技術進行5種輕量級模型的訓練與驗證。

訓練精度曲線和訓練損失曲線分別如圖6、圖7所示。模型訓練精度曲線表達的是迭代次數和準確率之間的關系。由圖6可知MobileNet-v2、SqueezeNet、ShuffleNet及NASNet-Mobile模型的最終訓練精度均在90%以上,EfficientNet-b0模型訓練精度最低(80.25%);5種模型中,收斂速度最快、效果最好的是MobileNet-v2模型,在迭代第1837次時已經達到了90.01%的精度,最終訓練精度達到了99.04%。

損失曲線表達的是迭代次數和損失值之間的關系。由圖7可知,除EfficientNet-b0模型外,其余4種模型的最終訓練損失值均在0.50以下;其中收斂速度最快、效果最好的是MobileNet-v2模型,損失值在迭代第988次時已經降到了0.50以下,最終訓練損失值降到了0.04。

如圖8所示,基于遷移學習MobileNet-v2模型利用測試集得出的混淆矩陣,可以直觀地看出每一分類的識別情況以及各分級的召回率。表2、表3分別為基于遷移學習的5種網絡模型在各分類上的召回率、精確率的對比。根據上述試驗結論,可選擇精度和各分類召回率最高的基于遷移學習的MobileNet-v2模型繼續進行凍結訓練研究,進一步探究是否可以加快網絡訓練時間以及提升精度。

2.2 基于遷移學習的MobileNet-v2模型凍結訓練

表4為基于遷移學習的MobileNet-v2模型凍結訓練。具體展開MobileNet-v2網絡結構中的Bottleneck模塊,在基于遷移學習的MobileNet-v2模型基礎上凍結不同模塊參數。

不凍結任何參數權重的驗證精度為91.30%,訓練時間為7816 s。從表4中可以看出模型從淺層至深層凍結時,訓練時間和模型的驗證精度總體呈下降趨勢,凍結至Bottleneck 7時模型驗證精度已經低于70%,所以不再繼續凍結網絡的最后3層。同時從表4還可知,選擇凍結至第1個卷積模塊到Bottleneck 3-1模塊時均可在縮短模型訓練時間的基礎上提高模型驗證精度。在凍結第1個卷積層參數時比不凍結任何參數權重模型驗證精度提高了1.48%,訓練時間縮短了189 s。在凍結到Bottleneck 3-1模塊時比不凍結任何參數權重模型訓練時間縮短了29.32%,驗證準確度提高了0.93%。

如表5所示,分別是基于遷移學習和凍結至Bottleneck 3-1模塊后訓練的MobileNet-v2模型(MobileNet-v2*)、基于遷移學習的MobileNet-v2模型、基于遷移學習的NASNet-Mobile模型、基于遷移學習的ShuffleNet模型、基于遷移學習的SqueezeNet模型和基于遷移學習的EfficientNet-b0模型基于測試集在測試精度、識別時間、網絡大小三方面的對比,基于遷移學習的MobileNet-v2模型在凍結到Bottleneck 3-1模塊后訓練所得網絡測試精度最高,達91.58%,識別時間0.14 s,網絡大小8.15 MB,能夠在保證最高識別精度的前提下較好地適配于移動終端和嵌入式設備。

2.3 Grad-CAM可視化

Grad-CAM翻譯為梯度加權類激活映射(gradient-weighted class activation map),用于對神經網絡的輸出進行可視化,可直觀地展示出卷積神經網絡做出分類決策的重要部位[30-31]。選擇富士重傷側部原圖、添加高斯噪聲的富士輕傷側部圖、增強對比度的丹霞重傷頂部圖、添加椒鹽噪聲的丹霞無傷底部圖以及順時針旋轉30°的丹霞輕傷側部圖,使用Grad-CAM技術得出熱力圖的可視化展示,如圖9所示,從藍色到紅色顏色的加深代表模型對圖片區域關注度的增加。從圖9可以看出,基于遷移學習的SqueezeNet模型可視化效果最差,同時也驗證了該模型的識別精度最低;基于遷移學習的NASNet-Mobile模型可視化效果較差,只能顯示大范圍的關注區域,部分圖片識別度不高;基于遷移學習的MobileNet-v2模型可視化效果明顯優于前兩種模型,但模型識別的重點區域與實際有所偏差;基于遷移學習的MobileNet-v2模型在凍結到Bottleneck 3-1模塊后訓練所得網絡的可視化效果最優,模型識別圖片的重點區域與實際吻合度最高,可以直觀地顯示出該模型在識別蘋果表皮圖像時的穩定性與精確度。

3 討 論

眾所周知,蘋果的種質資源豐富,其果實的大小、硬度、表皮顏色等特征不盡相同,這將直接影響著蘋果表皮損傷識別的準確度;同時采集損傷圖片比較困難、識別難度較大是對蘋果表皮損傷研究較少的主要原因之一。目前,普遍使用光譜儀器、紅外熱成像儀等高端設備對蘋果損傷進行檢測和分級,成本相對較高且不適合大眾消費者使用;而使用普通相機采集蘋果表皮的損傷圖像進行分級的研究較少,普通相機采集圖像有成本低、硬件兼容性強、獲取圖片來源廣等優點,Ismail等[18]選取了5個品種共550張蘋果圖像進行試驗分析,雖然品種多樣,但數據量較少,容易發生訓練過擬合,且得出的模型泛化能力較弱。筆者在本研究中選取山西地區具有代表性的富士和丹霞2個蘋果品種,共采集780張圖像,并將初始數據集擴充到9360張;專注于卷積神經網絡的研究,使用較少品種、大量數據的思想防止模型訓練過擬合,同時提升了測試集和驗證集的比例,讓結果更貼近實際;在選取網絡上,挑選5個20 MB以下的輕量級卷積神經網絡進行試驗對比,目的是為針對移動端和嵌入式設備的研究者提供技術參考,從而推進蘋果商家的分類售賣;在模型的訓練上,使用遷移學習技術的同時增加凍結訓練策略,在縮短模型訓練時間的基礎上將驗證精度提升到了92.78%。其中,在凍結到Bottleneck 3-1模塊時比基于遷移學習的MobileNet-v2模型訓練時間縮短了29.32%,同時驗證精度提高了0.93%,測試精度為91.58%,能夠滿足基本的分級需求,具有較強的泛化能力。

在進一步的研究中,可增加蘋果的種類,擴大損傷部位采集的數據量,探尋輕量級卷積神經網絡的優化或對深度卷積神經網絡進行壓縮,提高識別的速度和壓縮網絡大小;探索目標檢測領域,對比優化目前流行的Yolo算法和Faster R-CNN算法,提高定位和分級效果。

4 結 論

筆者在本研究中選用5種20 MB以下的輕量化模型進行初始化訓練與遷移學習訓練對比,得出經過遷移學習的MobileNet-v2模型效果最優,隨后使用凍結策略進行分層訓練,其中在凍結到Bottleneck 3-1模塊時驗證精度達92.23%,測試精度為91.58%,平均識別時間為0.14 s,網絡大小為8.15 MB,為移動終端和嵌入式設備在蘋果損傷直接分級方面提供技術參考。

參考文獻References:

[1] 王皎,李赫宇,劉岱琳,宋新波,於洪建. 蘋果的營養成分及保健功效研究進展[J]. 食品研究與開發,2011,32(1):164-168.

WANG Jiao,LI Heyu,LIU Dailin,SONG Xinbo,YU Hongjian. Research progress of apple nutrition components and health function[J]. Food Research and Development,2011,32(1):164-168.

[2] 屠鵬,邊紅霞,石萍,黎虹,楊晰. 壓力損傷對蘋果貯藏期品質的影響[J]. 食品工業科技,2018,39(14):239-243.

TU Peng,BIAN Hongxia,SHI Ping,LI Hong,YANG Xi. Effect of pressure injury on the quality during storage period in apple[J]. Science and Technology of Food Industry,2018,39(14):239-243.

[3] 王艷穎,胡文忠,龐坤,朱蓓薇,范圣第. 機械損傷對富士蘋果生理生化變化的影響[J]. 食品與發酵工業,2007,33(7):58-62.

WANG Yanying,HU Wenzhong,PANG Kun,ZHU Beiwei,FAN Shengdi. Effect of mechanical damage on the physiology and biochemistry in Fuji apple[J]. Food and Fermentation Industries,2007,33(7):58-62.

[4] 趙康. 蘋果表面損傷光學檢測系統設計與實現[D]. 哈爾濱:黑龍江大學,2021.

ZHAO Kang. Design and implementation of optical detection system for apple surface damage[D]. Harbin:Heilongjiang University,2021.

[5] 沈宇,房勝,鄭紀業,王風云,張琛,李哲. 基于高光譜成像技術的富士蘋果輕微機械損傷檢測研究[J]. 山東農業科學,2020,52(2):144-150.

SHEN Yu,FANG Sheng,ZHENG Jiye,WANG Fengyun,ZHANG Chen,LI Zhe. Detection of slight mechanical damage of fuji apple fruits based on hyperspectral imaging technology[J]. Shandong Agricultural Sciences,2020,52(2):144-150.

[6] 蔣金豹,尤笛,汪國平,張政,門澤成. 蘋果輕微機械損傷高光譜圖像無損檢測[J]. 光譜學與光譜分析,2016,36(7):2224-2228.

JIANG Jinbao,YOU Di,WANG Guoping,ZHANG Zheng,MEN Zecheng. Study on the detection of slight mechanical injuries on apples with hyperspectral imaging[J]. Spectroscopy and Spectral Analysis,2016,36(7):2224-2228.

[7] LU Y Z,LU R F. Development of a multispectral structured illumination reflectance imaging (SIRI) system and its application to bruise detection of apples[J]. Transactions of the ASABE,2017,60(4):1379-1389.

[8] KERESZTES J C,GOODARZI M,SAEYS W. Real-time pixel based early apple bruise detection using short wave infrared hyperspectral imaging in combination with calibration and glare correction techniques[J]. Food Control,2016,66:215-226.

[9] 邵志明,王懷彬,董志城,原育慧,李軍會,趙龍蓮. 基于近紅外相機成像和閾值分割的蘋果早期損傷檢測[J]. 農業機械學報,2021,52(S1):134-139.

SHAO Zhiming,WANG Huaibin,DONG Zhicheng,YUAN Yuhui,LI Junhui,ZHAO Longlian. Early bruises detection method of apple surface based on near infrared camera imaging technology and image threshold segmentation method[J]. Transactions of the Chinese Society for Agricultural Machinery,2021,52(S1):134-139.

[10] FAN S X,LIANG X T,HUANG W Q,ZHANG V J,PANG Q,HE X,LI L J,ZHANG C. Real-time defects detection for apple sorting using NIR cameras with pruning-based YOLOV4 network[J]. Computers and Electronics in Agriculture,2022,193:106715.

[11] 門洪,陳鵬,鄒麗娜,朱斌. 基于主動熱紅外技術的蘋果損傷檢測[J]. 中國農機化學報,2013,34(6):220-224.

MEN Hong,CHEN Peng,ZOU Lina,ZHU Bin. Apples damage detection based on active thermal infrared technique[J]. Journal of Chinese Agricultural Mechanization,2013,34(6):220-224.

[12] 周其顯. 蘋果早期機械損傷的紅外熱成像檢測研究[D]. 南昌:華東交通大學,2011.

ZHOU Qixian. Research on infrared thermography technique for detecting early chanical damage in apples[D]. Nanchang:East China Jiaotong University,2011.

[13] 熊婷. 基于低場磁共振技術的果品無損檢測[D]. 杭州:中國計量學院,2014.

XIONG Ting. Nondestructive detection of fruit quality based on low-field magnetic resonance technology[D]. Hangzhou:China Jiliang University,2014.

[14] 尹義志,王永剛,張楠楠,劉宇航. 基于小波神經網絡的溫室番茄產量預測[J]. 中國瓜菜,2020,33(8):53-59.

YIN Yizhi,WANG Yonggang,ZHANG Nannan,LIU Yuhang. Study on tomato yield prediction in greenhouse based on wavelet neural network[J]. China Cucurbits and Vegetables,2020,33(8):53-59.

[15] 陳新,伍萍輝,祖紹穎,徐丹,張云鶴,董靜. 基于改進SSD輕量化神經網絡的番茄疏花疏果農事識別方法[J]. 中國瓜菜,2021,34(9):38-44.

CHEN Xin,WU Pinghui,ZU Shaoying,XU Dan,ZHANG Yunhe,DONG Jing. Study on identification method of thinning flower and fruit of tomato based on improved SSD lightweight neural network[J]. China Cucurbits and Vegetables,2021,34(9):38-44.

[16] 寧景苑,葉海芬,孫雨玘,熊思怡,梅正昊,蔣晨豪,黃科濤,張蘇婕,朱哲琛,李昱權,惠國華,易曉梅,郜園園,吳鵬. 一種基于弛豫動態光譜技術的蘋果損傷檢測方法研究[J]. 傳感技術學報,2022,35(8):1150-1156.

NING Jingyuan,YE Haifen,SUN Yuqi,XIONG Siyi,MEI Zhenghao,JIANG Chenhao,HUANG Ketao,ZHANG Sujie,ZHU Zhechen,LI Yuquan,HUI Guohua,YI Xiaomei,GAO Yuanyuan,WU Peng. Study of apple slight damage detecting method based on dynamic relaxation spectrum[J]. Chinese Journal of Sensors and Actuators,2022,35(8):1150-1156.

[17] NING J Y,YE H F,SUN Y Q,ZHANG J Y,MEI Z H,XIONG S Y,ZHANG S J,LI Y Q,HUI G H,YI X M,GAO Y Y,WU P. Study on apple damage detecting method based on relaxation single-wavelength laser and convolutional neural network[J]. Journal of Food Measurement and Characterization,2022,16(5):3321-3330.

[18] ISMAIL A,IDRIS M Y I,AYUB M N,POR L Y. Vision-based apple classification for smart manufacturing[J]. Sensors,2018,18(12):4353.

[19] 李泰,盧士軍,黃家章,陳磊,范協裕. 蘋果品質評價標準研究進展[J]. 中國農業科技導報,2021,23(11):121-130.

LI Tai,LU Shijun,HUANG Jiazhang,CHEN Lei,FAN Xieyu. Research progress of apple quality evaluation standards[J]. Journal of Agricultural Science and Technology,2021,23(11):121-130.

[20] 軒勃娜,李進,宋亞飛,馬澤煊. 基于改進MobileNetV2的惡意代碼分類方法[J]. 計算機應用,2023,43(7):2217-2225.

XUAN Bona,LI Jin,SONG Yafei,MA Zexuan. Malicious code classification method based on improved MobileNetV2[J]. Journal of Computer Applications,2023,43(7):2217-2225.

[21] HOWARD A G,ZHU M L,CHEN B,KALENICHENKO D,WANG W J,WEYAND T,ANDREETTO M,ADAM H. MobileNets:efficient convolutional neural networks for mobile vision applications[Z]. ArXiv,2017. DOI:10.48550/arXiv.1704.

04861.

[22] HE K M,ZHANG X Y,REN S Q,SUN J. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas,NV,USA:IEEE,2016:770-778.

[23] SANDLER M,HOWARD A,ZHU M L,ZHMOGINOV A,CHEN L C. MobileNetV2:inverted residuals and linear bottlenecks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City,UT,USA:IEEE,2018:4510-4520.

[24] 葛淑偉,張永茜,秦嘉欣,李雪,王曉. 基于優化SSD-MobileNetV2的煤礦井下錨孔檢測方法[J]. 采礦與巖層控制工程學報,2023,5(2):66-74.

GE Shuwei,ZHANG Yongqian,QIN Jiaxin,LI Xue,WANG Xiao. Rock bolt borehole detection method for underground coal mines based on optimized SSD-MobileNetV2[J]. Journal of Mining and Strata Control Engineering,2023,5(2):66-74.

[25] PAN S J,YANG Q. A survey on transfer learning[J]. IEEE Transactions on Knowledge and Data Engineering,2010,22(10):1345-1359.

[26] BROCK A,LIM T,RITCHIE J M,WESTON N. FreezeOut:accelerate training by progressively freezing layers[Z]. ArXiv,2017. DOI:10.48550/arXiv.1706.04983.

[27] 孔德宇. 基于Kinect骨骼時空特征的步態人物識別研究[D]. 南寧:廣西大學,2022.

KONG Deyu. Research on gait recognition based on kinect skeletal spatiotemporal features[D]. Nanning:Guangxi University,2022.

[28] 謝圣橋,宋健,湯修映,白陽. 基于遷移學習和殘差網絡的葡萄葉部病害識別[J]. 農機化研究,2023,45(8):18-23.

XIE Shengqiao,SONG Jian,TANG Xiuying,BAI Yang. Identification of grape leaf diseases based on transfer learning and residual networks[J]. Journal of Agricultural Mechanization Research,2023,45(8):18-23.

[29] 高博,陳琳,嚴迎建. 基于CNN-MGU的側信道攻擊研究[J]. 信息網絡安全,2022,22(8):55-63.

GAO Bo,CHEN Lin,YAN Yingjian. Research on side channel attack based on CNN-MGU[J]. Netinfo Security,2022,22(8):55-63.

[30] SELVARAJU R R,COGSWELL M,DAS A,VEDANTAM R,PARIKH D,BATRA D. Grad-CAM:Visual explanations from deep networks via gradient-based localization[C]. Italy:2017 IEEE International Conference on Computer Vision (ICCV),2017:618-626.

[31] PAPANDRIANOS N I,FELEKI A,MOUSTAKIDIS S,PAPAGEORGIOU E I,APOSTOLOPOULOS I D,APOSTOLOPOULOS D J. An explainable classification method of SPECT myocardial perfusion images in nuclear cardiology using deep learning and grad-CAM[J]. Applied Sciences,2022,12(15):7592.

收稿日期:2023-05-24 接受日期:2023-07-26

基金項目:國家自然科學基金項目(11802167);山西省重點研發計劃項目(202102020101012);山西省應用基礎研究項目(201901D211364)

作者簡介:付夏暉,男,在讀碩士研究生,主要從事機器學習、農產品加工及智能裝備研究。Tel:13294552666,E-mail:13294552666@163.com

通信作者 Author for correspondence. Tel:18634418916,E-mail:wangjuxia79@163.com