融合詞性與外部知識的方面級情感分析

谷雨影,高美鳳+

1.江南大學 輕工過程先進控制教育部重點實驗室,江蘇 無錫 214122

2.江南大學 物聯網工程學院,江蘇 無錫 214122

情感分析,也稱意見挖掘,是指對一段文本的感情進行分類。觀察微博、淘寶以及美團等一些平臺上的評論,大部分文本都體現出了用戶的情緒傾向,提取并分析其中的情緒數據,對其進行情感分類,可以更好地理解用戶行為。方面級情感分析是一種重要的細粒度情感分類,它的主要目的是識別句子中不同方面詞的情緒極性(積極、中性和消極)。例如,在“The battery is durable but the screen is small.”中,句子體現了評論者對商品兩方面的態度傾向,對“battery”的積極和“screen”的消極。細粒度的情感分析可以捕捉到與不同方面詞相關的意見詞,因此,方面級情感分析的研究具有深遠的應用價值。

早期的方面級情感分析研究方法基于情感詞典和傳統機器學習進行,Malouf等人[1]應用情感字典和支持向量機(support vector machine,SVM)進行情感分類。但是這些方法需要人工制定分類規則,并且需要投入高額的人工成本,得到的模型不僅效果和泛化能力不理想,而且隨著網絡時代的發展,已經不能滿足情感分類任務高標準的要求。因此近年來,方面級情感分析的研究方法轉向了深度學習模型,Kim[2]使用卷積神經網絡(convolutional neural network,CNN)模型捕捉文本的局部相關性;基于循環神經網絡(recurrent neural network,RNN)的模型可以捕獲序列之間的關系;Mnih等人[3]將注意力機制用在圖像分類任務中,使結合了注意力機制的神經網絡模型成為研究的熱點。隨后,Bahdanau等人[4]將注意力機制和RNN 結合,在自然語言處理領域內掀起了注意力機制和神經網絡結合應用的熱潮。Zhou 等人[5]結合句子層次的注意力來突破現有模型對局部特征和遠距離依賴特征提取能力的局限性。Lin等人[6]將語義信息引入深度記憶網絡,并將方面詞與上下文之間的距離信息融入注意力機制進行情感分類。Fan等 人[7]利 用BiLSTM(bidirectional long short-term memory)對語義信息進行建模,設計了一種多粒度注意力機制,以細粒度的方式學習方面詞和上下文之間的關系。Wu等人[8]使用殘余注意力機制解決了一般注意力機制容易丟失原始信息的問題,來更好地捕獲上下文面向方面術語的語義信息。對于一個句子,RNN模型對方面詞上下文的關注度不高,注意力機制可以使神經網絡模型更加關注上下文中的情感信息,忽略與方面詞無關的噪聲詞,從而提高模型分類的性能。然而,在需要捕捉復雜語句中的情感信息時,這些模型的表現還具有改進潛力。

外部知識[9-10]通常被用作在情感分析任務中增強情感特征表示的來源,Ren等人[11]利用情感詞典來捕獲句子中的情緒信息來計算注意力權重。Valle-Cruz等人[12]驗證與其他情感詞典對比,SenticNet能夠更好地捕捉詞語之間的相關性。SenticNet[13]是用于意見挖掘和情感分析的公開資源,它為每個概念提供了情感值。Ma等人[14]將常識知識融入LSTM(long shortterm memory)模型,通過利用通用知識提取目標級和句子級的情感特征,在兩個公開的數據集上表現出優秀的性能。然而,在包含多個方面詞的句子中,由于它們不能充分捕捉上下文詞與句子中各個方面詞之間的句法依賴關系,這些模型的應用仍然有限。

句法依賴分析可將長距離的方面詞與意見詞通過句法函數相關聯,從而加強詞語之間的聯系,而為了利用依賴關系圖信息,圖卷積神經網絡(graph convolutional network,GCN)[15]被應用來從依賴樹中學習句子的句法特征表示。Zhang 等人[16]在句子依賴樹的基礎上提出了圖卷積網絡模型,充分利用了上下文的句法信息和單詞間的依賴關系。Wang等人[17]通過依賴句法分析文本的自然語言語義特征,以此來融合方面詞和整體句子。Yu等人[18]提出多權重圖卷積網絡模型來避免注意力機制引起的不準確權重,上下文詞語與最終權重的結合突出顯示了方面詞,并有效保留了整體語義的有用信息。Xu 等人[19]使用異構圖定義句子和方面節點,并提出窗口機制和位置機制來分別學習句子和方面表達。Zhao等人[20]使用兩個聚合器捕獲遠距離依賴的特征,有效地提取上下文和方面序列的信息。然而,大部分研究人員更關注于深度神經網絡的改進[21-22],沒有專注于依賴關系圖的構建,從而忽略了其他細粒度信息(例如詞性信息和位置信息)和常識性知識信息,并且使基于深度學習的方面級情感分析模型越發復雜,參數過多的情況下模型訓練更易引發過擬合。

針對上述問題,本文提出了一種多融合簡化圖卷積神經網絡模型(multi-fusion simplifying graph convolutional network,MFSGC)。模型利用詞性進行信息篩選,對句法依賴樹進行剪枝處理,使模型更關注方面詞與意見詞,同時運用情感詞典來增強情感特征表示,它能夠充分利用句法依存信息,從而提高分類效果。并使用簡化圖卷積網絡(simplifying graph convolutional network,SGC)[23],提高基于圖卷積的方面級情感分析模型性能。本文貢獻如下:

(1)提出多融合鄰接矩陣算法,使用情感詞典增強情感詞的作用,并利用詞性對句法依賴樹進行剪枝處理,旨在提高對句法依賴樹信息的利用率。

(2)將簡化圖卷積網絡用于方面級情感分析任務中,通過消除GCN層間的非線性來使網絡更高效。

(3)對五個公開數據集進行了實驗,結果證明了本文模型的性能。

1 MFSGC模型

模型如圖1所示,由詞嵌入層、語義提取層、多融合鄰接矩陣算法層、圖卷積網絡層、掩碼機制層、注意力機制層和最終的情感分類層組成。在本文模型中,使用s={w1,w2,…,wτ,…,wτ+m,…,wn-1,wn}表示長度為n的輸入句子,即每個句子由一系列單詞wi組成,其中{w1,w2,…,wτ}和{wτ+m+1,…,wn-1,wn}分別為句子中的上下文詞,a={wτ+1,wτ+2,…,wτ+m}為給定句子中長度為m的方面詞。

1.1 詞嵌入層

對于給定的包含n個單詞的句子s,首先將每個單詞映射到一個低維向量空間,本文采用Glove預訓練詞典獲得詞嵌入矩陣。對于每一個輸入單詞wi,均由一個d維向量vi表示,詞向量在預訓練詞典中查找方式為:

通過式(1)得到每個單詞對應的詞向量vi,嵌入完成后的句子表示為V={v1,v2,…,vτ,…,vτ+m,…,vn-1,vn}。

1.2 語義提取層

循環神經網絡已經成功應用于自然語言處理領域內,然而,標準的RNN經常面臨梯度消失和梯度爆炸的問題。LSTM 是一種特殊的RNN,在每個時間步長上通過三種門控機制調整細胞狀態,更好地解決了長距離依賴性的問題。對于文本情感分類問題,序列后值和序列前值一樣會影響分類結果,本模型采用BiLSTM 構成語義提取層。BiLSTM 可以建立正向和反向的上下文依賴關系,與單向LSTM 相比,它可以同時通過前向傳播算法和后向傳播算法來學習更多的上下文信息。

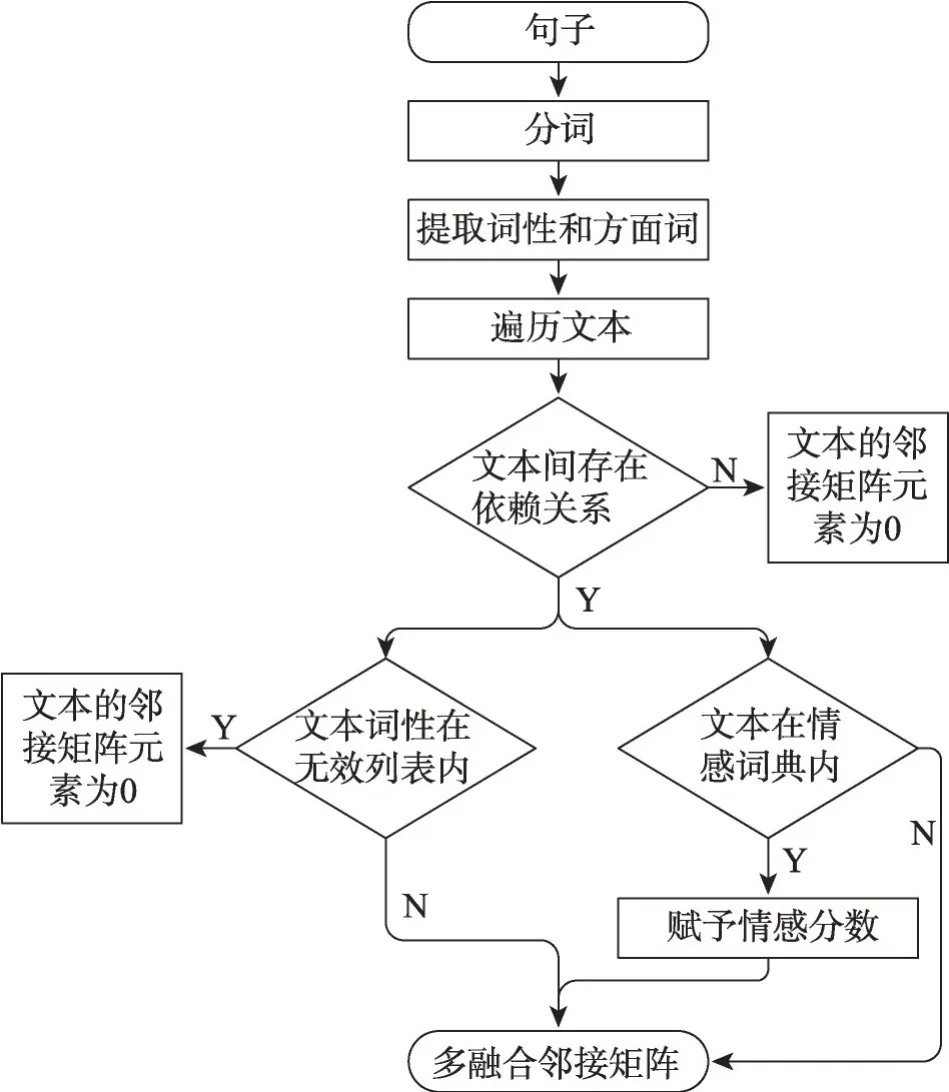

1.3 多融合鄰接矩陣

大部分基于圖卷積網絡的方面級情感分析對句法依賴樹上的信息利用較為低效,為充分利用句法依賴樹中包含的情感信息,受文獻[24]的啟發,本文提出多融合鄰接矩陣算法,使用情感詞典增強句子中的情感詞,參照Xiao 等人[25]的方法通過手動和模型選擇構建無效詞性組合來對原始依賴樹進行剪枝處理,去除與方面詞無關的文本帶來的噪聲,并加強方面詞與情感詞間的依賴性,使模型更關注于與方面詞相關的意見詞。多融合鄰接矩陣的構建過程如圖2 所示:首先,對于每一個輸入句子,對其分詞、提取詞性和方面詞;然后,使用SenticNet詞典賦予單詞情感分數以增強文本情感特征;最后,剪掉詞性在無效詞性列表中文本的依賴關系。

圖2 多融合鄰接矩陣流程圖Fig.2 Flowchart of multi-fusion adjacency matrix

1.3.1 情感詞典

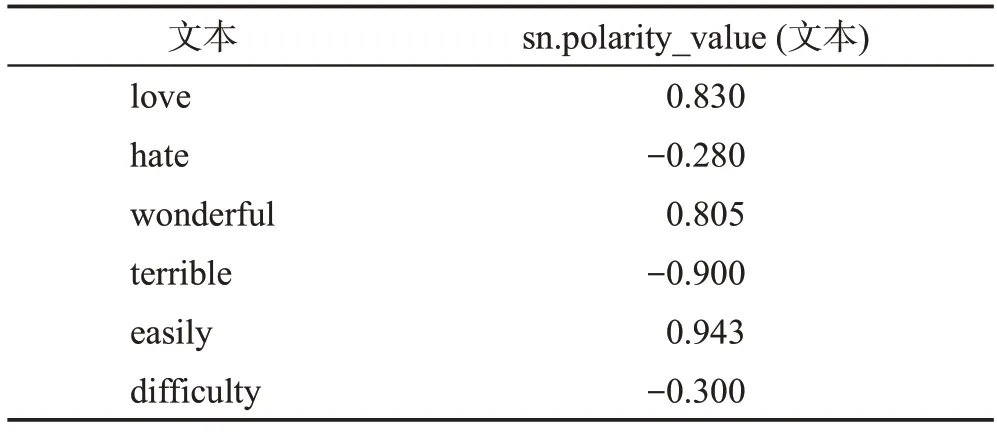

由于SenticNet 能很好地捕捉詞語之間的相關性,本文選擇它來增強文本情感特征。SenticNet 可以對句子中的每個詞語進行分析,計算它們的情感分數,其中sn.polarity_value(wi)∈[-1,1],對于積極的文本數據,其情感分數為正,而消極的文本數據,其情感分數為負值,表1列舉了幾個文本詞及其情感分數。

表1 文本情感分數示例Table 1 Example of text emotional score

參照文獻[24]的方法,將具有依賴關系的詞的情感分數相加,增強文本之間的情感特征表示,使模型更關注情感詞,可以充分利用上下文單詞間的潛在情感依賴性。運用SenticNet得到兩個單詞間的情感依賴強度Sij,為:

其中,wi、wj表示輸入句子中的單詞文本,sn.polarity_value(wi)和sn.polarity_value(wj)為SenticNet 計算得到的單詞情感分數。

1.3.2 剪枝句法依賴樹

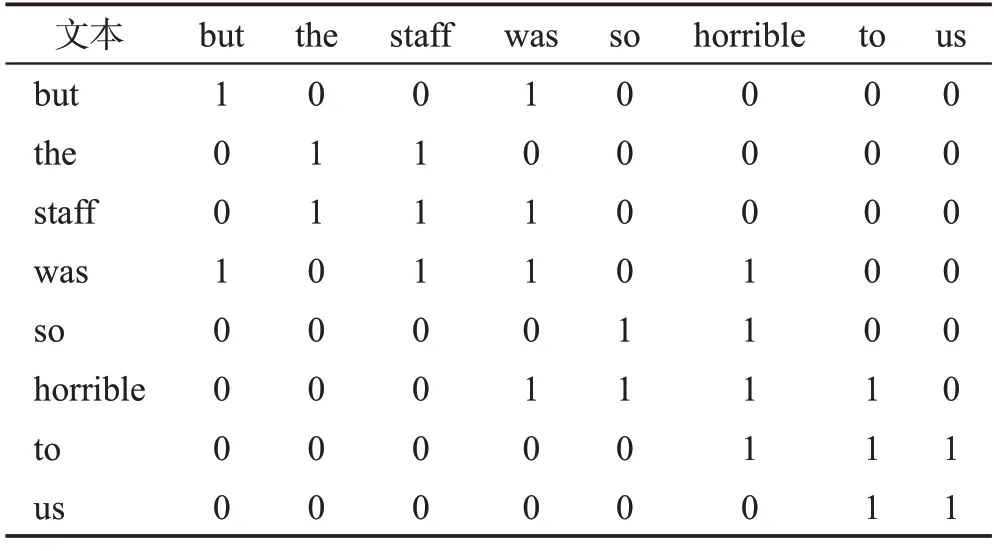

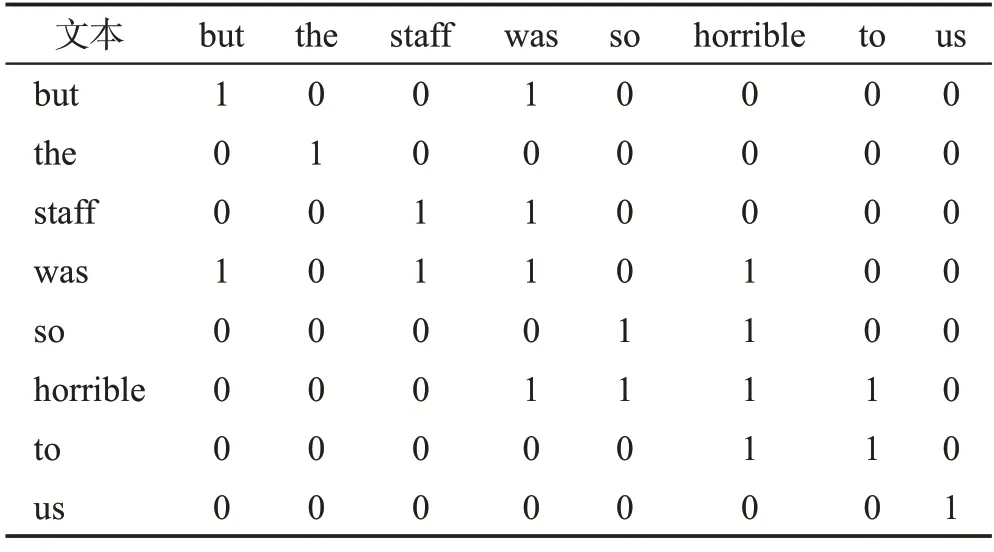

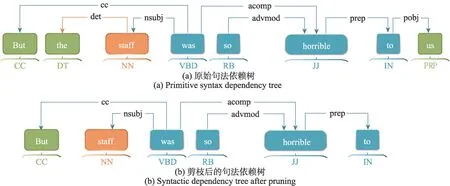

句子經過解析得到的句法依賴關系圖中通常包含一些不必要的依賴關系,例如句子“But the staff was so horrible to us”的關系圖為圖3(a),圖中存在文本“the”和“us”的依賴關系,但其不包含情感信息,對這些冗余的依賴關系進行剪枝處理可使模型更關注意見詞。參照文獻[25]的方法,提取得到輸入文本的詞性序列,結合語言學知識分析數據集文本,發現帶有情感色彩的文本詞性集中在名詞、形容詞、副詞和動詞上,先將其他種類的詞性視為無效詞性,在生成鄰接矩陣過程中刪除其中某一詞性單詞后,若情感分類準確率得到了提高,就將此詞性添加到列表B中,并在后續處理中剪掉此詞性文本的所有句法關系,即Pij=0。在上述句子中剪掉冗余的依賴關系后,得到句法依賴關系圖3(b),在剪枝后的關系圖中存在更少的依賴關系,一定程度上可以消除無效詞性文本帶來的噪音,對比鄰接矩陣表2 和表3 可知,剪枝后的鄰接矩陣更為稀疏,可以使模型更關注與方面詞相關的意見詞,從而提高模型的分類性能。圖3中,CC(coordinating conjunction)表示連接詞;DT(determiner)表示限定詞;NN(noun,singular or mass)表示常用名詞單數形式;VBD(verb,past tense)表示動詞過去式;RB(adverb)表示副詞;JJ(adjective)表示形容詞或序數詞;IN(preposition or subordinating conjunction)表示介詞或從屬連詞;PRP(personal pronoun)表示人稱代詞;nsubj(nominal subject)表示名詞性主語;advmod(adverbial modifier)表示狀語修飾語;acomp(adjectival complement)表示動詞的形容詞補語;prep(prepositional modifier)表示介詞修飾;pobj(object of a preposition)表示介詞的賓語。

表2 原始鄰接矩陣Table 2 Primitive adjacency matrix

表3 剪枝后鄰接矩陣Table 3 Adjacency matrix after pruning

圖3 句法依賴樹示例Fig.3 Syntax dependency tree example

1.3.3 多融合鄰接矩陣

對輸入句子解析得到原始句法依賴樹,若單詞間存在依賴關系,則Rij=1,否則Rij=0。為了增強上下文詞和方面詞間的情感依賴關系,若依賴關系中雙方分別為情感詞和方面詞,則令Cij=1,否則為0。最終句子的鄰接矩陣中元素Aij的計算方式為:

其中,Rij為基于原始句法圖的鄰接矩陣元素,Sij為經過情感詞典加強后的情感分數。Pij為剪枝后的句法依賴樹得到的鄰接矩陣元素。最后,向模型加入自循環約束[16],另每個節點都有指向自身的連接,即鄰接矩陣主對角線上的元素為非0值。

1.4 基于多融合鄰接矩陣算法的SGC

GCN 的靈感主要來自深度學習方法,因此可能會繼承不必要的復雜度和冗余計算,本文運用Felix等人[23]的SGC對基于圖卷積的方面級情感分類進行改進。SGC通過反復消除GCN層之間的非線性并將得到的函數折疊成一個線性變換來減少GCN的額外復雜度,減少計算量的同時更高效。為增強與方面詞相近的上下文詞的重要性,在輸入SGC層前,對文本進行位置編碼。

句子“sometimes I get good food and ok service”中,方面詞為“food”,另外可以觀察得到“good”包含的信息對預測方面詞“food”的情感極性更重要,因此使用位置權重層,第i個詞的位置權重qi的計算方式為:

其中,τ+1 和τ+m分別為方面詞的開始位置和結束位置,對語義提取層得到的隱藏狀態向量進行權重分配,為:

其中,ht為語義提取層得到的單詞隱藏狀態向量。

依賴關系樹轉換為鄰接矩陣圖,其節點表示給定句子中的單詞,將圖輸入到SGC層中,以學習單詞之間的依賴關系,得到第i個節點的第l層SGC的輸出為:

1.5 掩碼機制層

為突出方面詞的特征,對圖卷積網絡層的輸出進行遮掩,屏蔽非方面詞,并保持方面詞的向量不變[16]。掩碼權重mi計算方式為:

掩碼機制層的最終輸出HL-MASK為:

1.6 注意力機制層

運用基于檢索的注意力機制,從給定句子的隱藏狀態向量中檢索與方面詞情感極性相關的單詞[16],而從改進句法依賴樹構建的圖可以得出句子中單詞的情感依賴信息,按照每個上下文單詞的重要程度分配權重。注意力權重計算方式為:

其中,αt為得到的注意力權重,ht為上文中經過BiLSTM處理后得到的詞向量,最終的帶權特征向量r為:

1.7 情感分類層

將得到的表示輸入到一個全連接層,通過softmax分類器將向量映射到極性決策空間上進行分類,如下:

其中,Wp和bp是可訓練的權重矩陣和偏置項。

2 實驗

2.1 實驗數據

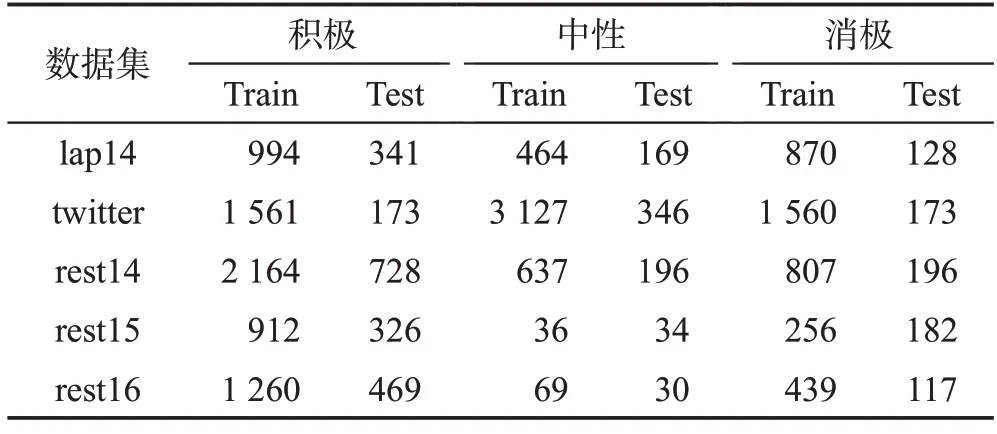

為了驗證模型有效性,本文使用Li等人[26]整理的Twitter短文本評論數據集,以及由SemEval官方發布的ASC 基準數據集,包 括SemEval-2014 Task 4[27]、SemEval-2015 Task 12[28]和SemEval-2016 Task 5[29]中的數據集。其中,使用SemEval-2014 中的Restaurant14 和Laptop14 數據集,SemEval-2015 中的Restaurant15數據集,SemEval-2016中的Restaurant16數據集。每個數據集中都包含一個訓練集和測試集,每個數據都是一個句子,包含評論文本、方面詞、與方面詞對應的情感標簽以及方面詞的起始位置。標簽包含積極、中性和消極的情感,訓練集和測試集以及標簽分布見表4。

表4 數據集Table 4 Dataset

2.2 實驗環境和參數配置

本文實驗使用Windows 10 64 位操作系統以及Intel Core i5-9400@2.90 GHz CPU。在實驗中,使用兩種詞嵌入方法,嵌入維度為300 的預訓練Glove 詞向量和嵌入維度768的Bert預訓練模型,參數設置如下,學習率設置為0.001,使用adam 優化器用于優化訓練參數,采用L2 正則化,正則化項系數設置為0.000 01,防止網絡過擬合以及加快網絡收斂,批訓練樣本設置為32。此外,本文模型除MFSGC-Bert外,均使用Glove詞向量進行文本表示。

2.3 損失函數

本文使用交叉熵損失函數對模型的參數進行優化和更新,如式(14)所示:

其中,λ是L2正則化的系數;C為情感極性標簽的數量,為3;D代表訓練樣本的數量;y為模型預測的極性類別;代表方面詞真實的極性類別。

2.4 對比模型

SVM[30]:以經典的支持向量機為基礎建立模型,將人工構造的特征和外部情感詞典融合進行分類。

LSTM[31]:以長短時記憶網絡為基礎建立模型用于方面級情感分類。

MemNet[32]:引入深度記憶網絡,在詞嵌入上使用多個注意力層來構建更高層次的語義信息。

IAN(interactive attention networks)[33]:使用兩個LSTM分別對方面詞和上下文建模,交互注意機制學習上下文詞與方面詞間的聯系。

AEN(attentional encoder network)[34]:采用基于注意的編碼建立目標和上下文詞之間的模型,在損失函數中加入標簽平滑正則化項來解決標簽不可靠性問題。

TranCaps[35]:使用轉移膠囊網絡將外部文檔級情感信息融入到方面級情感分類中。

AOA(attention-over-attention)[36]:學習方面詞與上下文的隱藏信息,并通過注意力機制關注句子中的重要部分。

ASGCN(aspect-specific graph convolutional networks)[16]:在句子依賴樹上運用圖卷積網絡,充分利用了句子的語法信息和單詞依存關系。

CDT(convolution over a dependency tree)[37]:將句子的依賴關系樹與圖神經網絡結合,學習方面特征表示。

TD-GAT(target-dependent graph attention network)[38]:使用多層圖注意網絡將情感特征從重要的鄰近詞傳遞到方面目標詞。

AEGCN(attention-enhanced graph convolutional network)[21]:引入多頭自我關注捕捉上下文語義信息,使用多頭交互注意力更好地結合語義和句法信息。

MHAGCN(multi-head attention mechanism and a graph convolutional network)[22]:設計分層多頭注意力機制,結合語義信息實現方面詞與上下文之間的交互。

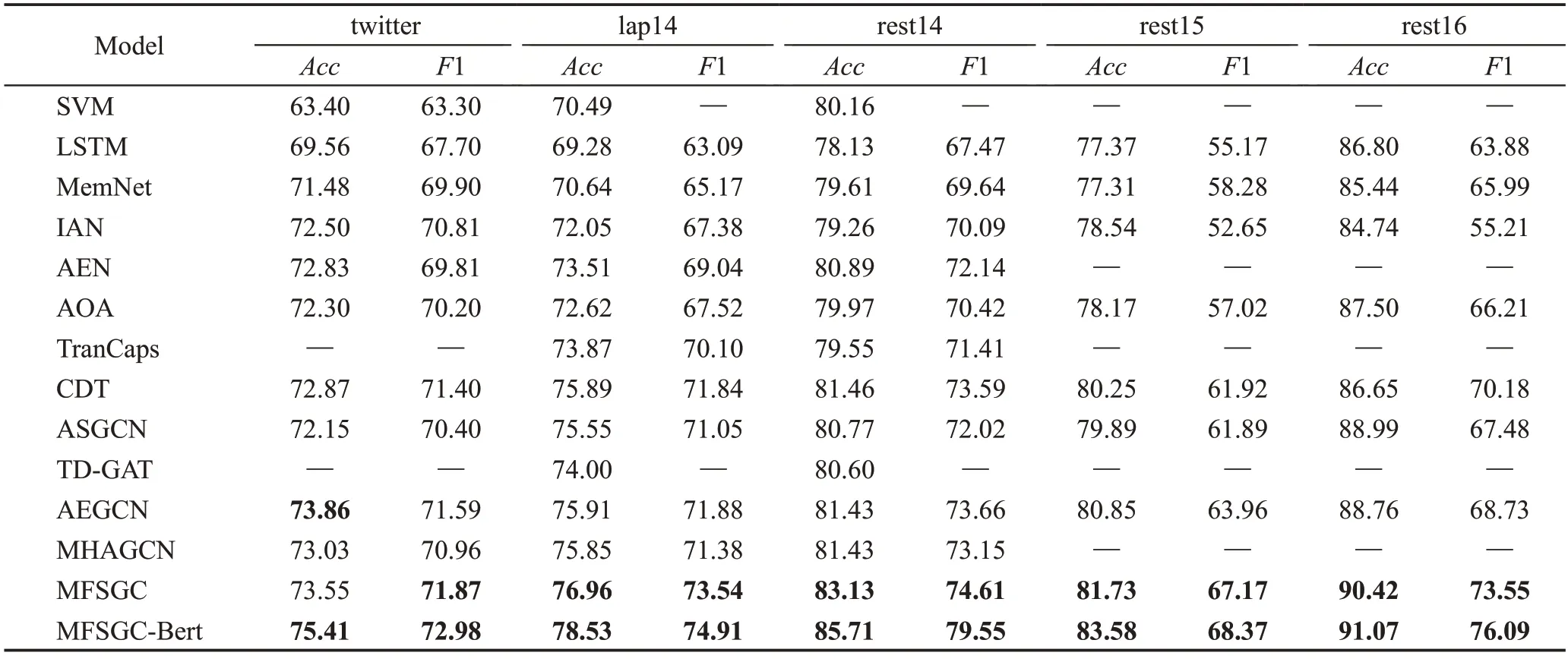

2.5 實驗結果與分析

如表5所示,本文提出的基于多融合鄰接矩陣的圖卷積神經網絡模型MFSGC在5個數據集上均取得了優秀的情感分類效果,與直接運用依賴樹中信息的ASGCN和CDT模型相比,所提出的模型在數據集中都取得了更高的準確率。在Twitter 數據集上,本文模型提升并不明顯,仔細對比這5 個數據集,可以發現Twitter上的評論更加口語化,句法信息較弱,而MFSGC 增強了情感詞信息,并修剪冗余的句法依賴樹,這也使模型一定程度上更關注句法信息,因此,相較于其他數據集,本文模型在Twitter 上的改善不是很突出。此外,本文實驗還采用了Bert預訓練模型進行文本表示,MFSGC-Bert 在5 個數據集上達到了最佳效果,主要是因為Bert模型解決了Glove模型的一詞多義問題。雖然使用Bert 預訓練模型取得了更明顯的提升效果,但其訓練耗時長,且網絡參數占用大量內存,預測較慢。

表5 實驗對比結果Table 5 Experimental comparison results 單位:%

2.6 消融實驗

2.6.1 多融合鄰接矩陣消融實驗

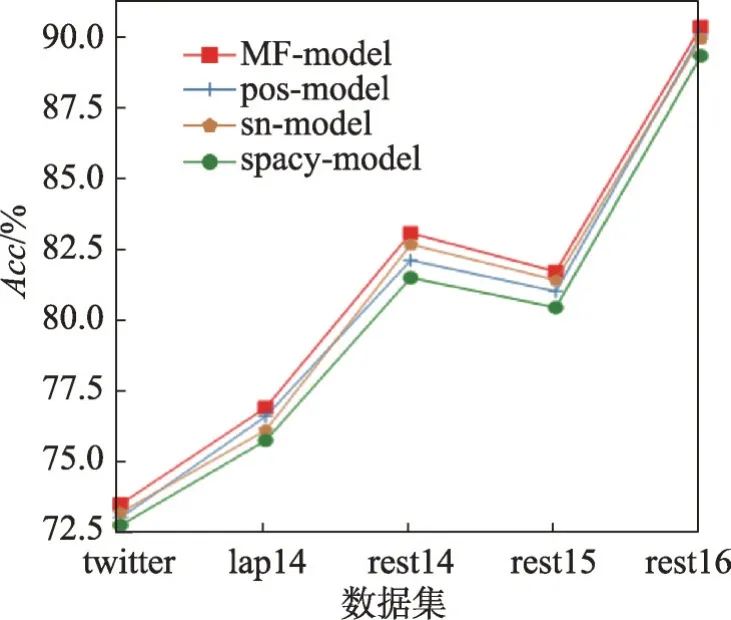

本文設計移除了多融合鄰接矩陣算法的模型(spacy-model)與應用了多融合鄰接矩陣算法的模型(MF-model)對比,來驗證多融合鄰接矩陣算法對分類的影響。在對比實驗中增加只修剪了句法依賴樹的模型(pos-model)和應用情感詞典與spacy 句法融合的模型(sn-model),來分別驗證這兩部分對分類的影響。結果如圖4、圖5 所示,可以明顯看出,修剪后的句法依賴樹和增強情感特征都有益于模型進行情感分析,多融合鄰接矩陣算法在5個數據集上的分類準確率也都有明顯的提高,并且rest15數據集上的F1有大幅提高,證明經過多融合鄰接矩陣算法得到的鄰接矩陣可以改善模型性能。

圖4 多融合對Acc 的影響Fig.4 Effect of multi-fusion on Acc

圖5 多融合對F1 的影響Fig.5 Effect of multi-fusion on F1

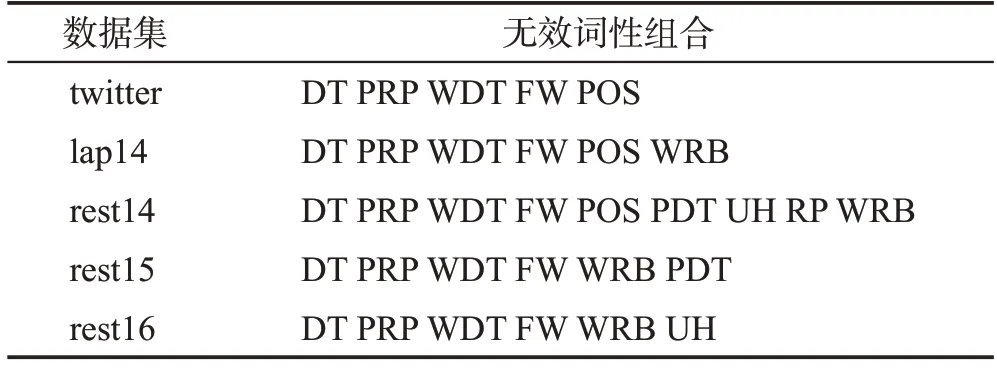

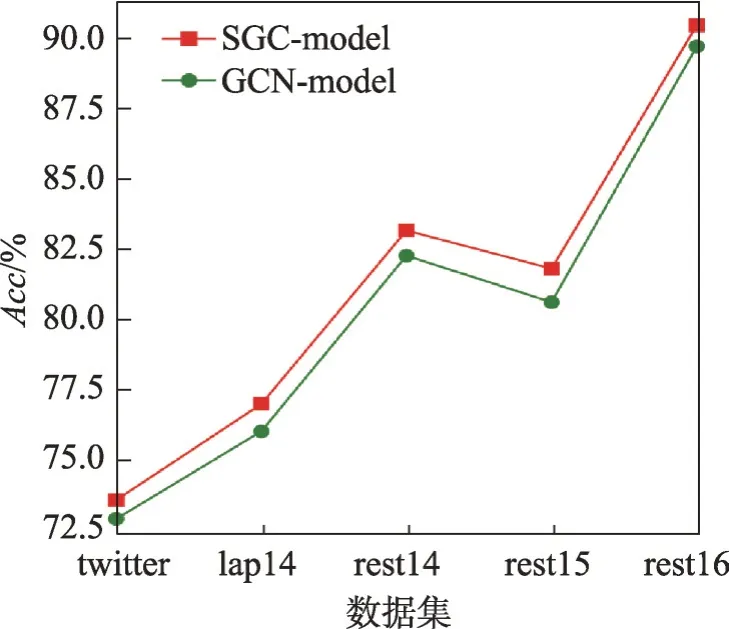

2.6.2 不同無效詞性組合分析

本文中,5個數據集的無效詞性組合如表6所示,人們評價的角度隨事物的不同而改變,在不同的背景中,一些本身并沒有感情色彩的詞放在特定的語境中可能會表現出情感傾向。在Twitter 平臺,WRB詞性大多數為how,包含情感信息,例如“Interesting!How to present like steve jobs”。但在餐廳和筆記本領域內,WRB 詞性大多數為when,例如“when we sat,we got great and fast service.”,很明顯,“when”對判斷方面詞“service”的情感極性不起作用。

表6 各個數據集的無效詞性組合Table 6 Invalid pos combination of each dataset

為更好地突出詞性的作用,使用上文中的posmodel 來對比不同的無效詞性在5 個數據集上的效果,在5 個數據集上的Acc如圖6 所示。從圖中可以明顯看出,模型只有利用數據集對應的無效詞性組合時才能達到最優性能,由于去掉了詞性對應文本的句法依賴關系,而其中存在與預測方面詞極性相關的情感信息,不匹配的組合對模型性能產生了反效果。

圖6 不同無效詞性組合的對比Fig.6 Comparison of different invalid pos combinations

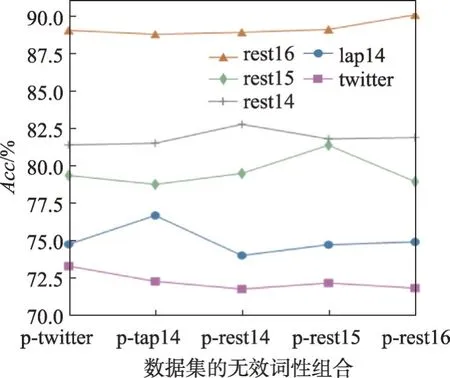

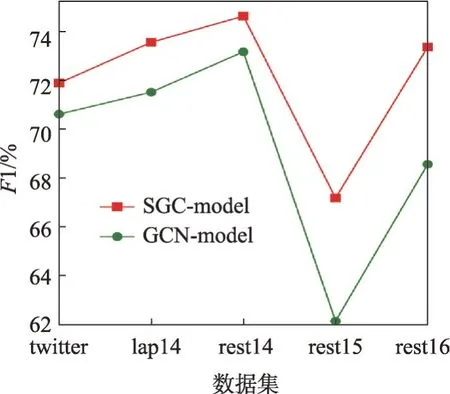

2.6.3 SGC-model與GCN-model對比

為驗證簡化圖卷積網絡相對于傳統GCN對于模型性能的改善,設計對比實驗,應用簡化圖卷積的模型(SGC-model)和應用傳統GCN 的模型(GCNmodel),其他層和參數與表5實驗一致。從圖7、圖8中可以看出,相較于傳統GCN,SGC取得了更高的準確率,并且在rest15和rest16數據集上F1有大幅提高。從表7 中可以看出,在twitter 數據集上,SGC 的訓練時間為GCN 的1/2,參數的減少降低了過擬合的情況,并減少了內存的使用,而這可能是性能提升的原因。

圖7 SGC-model與GCN-model的Acc 對比Fig.7 Acc comparison of SGC-model and GCN-model

圖8 SGC-model與GCN-model的F1 對比Fig.8 F1 comparison of SGC-model and GCN-model

2.6.4 SGC層數分析

為驗證SGC 層數對模型性能的影響,其他參數保持不變,將SGC層的數量從1增加到10。5個數據集上的Acc如圖9所示。從圖中可以明顯看出,SGC層數為2 時,模型達到最佳性能,之后隨著網絡深度的增加,性能逐漸降低。由于層數增加,模型的訓練變得困難并且更容易發生過擬合。

2.7 實例分析

為更直觀地表述本文模型的分類效果,取測試集中的實例來進行注意力可視化分析,如圖10所示,其中,顏色的深度表示一個單詞在句子中的重要性,顏色越深越重要。實例1“great food but the service was dreadful!”中有兩個方面詞,分別為“food”和“service”,對于“food”而言,模型指向“great”判斷其極性為積極,而對于“service”,模型則指向“dreadful”判斷其極性為消極,與真實極性一致。實例2“the food really isn’t very good and the service is terrible.”中方面詞為“food”和“service”,模型判斷其極性分別為消極和消極,與真實極性一致。從圖中可以看出,當文本中有多個方面詞時,模型可以正確指向對應的意見詞并給其相應的注意力權重,從而識別方面詞的情感極性。

圖10 實例分析Fig.10 Sample analysis

3 結束語

為充分利用句法信息和減少圖卷積網絡的復雜度,本文將外部知識和詞性與原始句法依賴樹融合,并使用簡化圖卷積網絡,提出了一種基于多融合鄰接矩陣的方面級情感分析模型。去除無效詞性文本,減少了句法依賴樹的冗余信息,使模型更關注于方面詞與意見詞,在句法分析時加入外部知識,增強了情感詞的單詞依賴性,并加強了方面詞與情感詞間的聯系。實驗驗證了本文提出的基于多融合鄰接矩陣算法的模型可以充分利用上下文和方面詞間的句法信息,簡化圖卷積網絡也明顯提高了分類的性能。